Hvordan bygge en AI-chatbot: Komplett steg-for-steg guide

Lær hvordan du bygger en AI-chatbot fra bunnen av med vår omfattende guide. Oppdag de beste verktøyene, rammeverkene og steg-for-steg-prosessen for å lage intel...

Oppdag hvordan AI-chatboter behandler naturlig språk, forstår brukerintensjon og genererer intelligente svar. Lær om NLP, maskinlæring og chatbot-arkitektur med teknisk dybde.

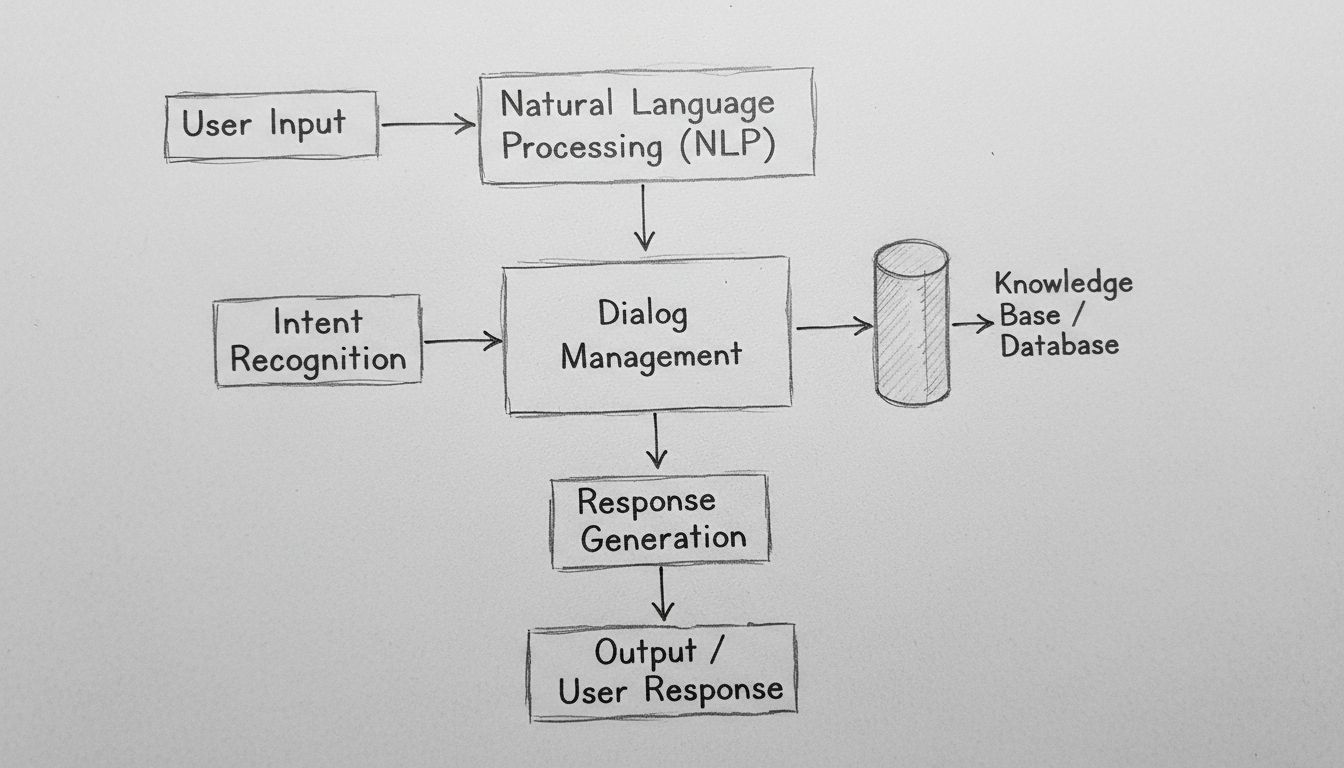

AI-chatboter fungerer ved å behandle naturlig språk-inndata gjennom NLP-algoritmer, gjenkjenne brukerintensjon, få tilgang til kunnskapsbaser og generere kontekstuelt relevante svar ved hjelp av maskinlæringsmodeller. Moderne chatboter kombinerer tokenisering, entitetsuttrekking, dialogstyring og nevrale nettverk for å simulere menneskelignende samtaler i stor skala.

AI-chatboter representerer en sofistikert sammensmelting av naturlig språkprosessering, maskinlæring og dialogstyringssystemer som samarbeider for å simulere menneskelig samtale. Når du samhandler med en moderne AI-chatbot, engasjerer du deg med et flerlags teknologisk system som behandler innputten din gjennom flere distinkte stadier før du mottar et svar. Arkitekturen bak disse systemene har utviklet seg dramatisk fra enkle regelbaserte beslutningstrær til komplekse nevrale nettverk som forstår kontekst, nyanser og til og med følelser. Å forstå hvordan disse systemene fungerer krever at man undersøker hver komponent i prosesskjeden og ser hvordan de samhandler for å skape sømløse samtaleopplevelser.

Reisen til enhver brukermelding gjennom en AI-chatbot starter med inndatabehandling, en kritisk fase som forvandler råtekst til strukturert data systemet kan analysere. Når du skriver en melding som “Jeg må tilbakestille passordet mitt”, forstår ikke chatboten umiddelbart intensjonen din – den må først dekomponere meldingen i håndterbare komponenter. Denne prosessen, kalt tokenisering, bryter opp setningen i enkeltord eller meningsfulle enheter kalt tokens. Systemet konverterer “Jeg må tilbakestille passordet mitt” til tokens: [“Jeg”, “må”, “tilbakestille”, “passordet”, “mitt”]. Dette tilsynelatende enkle steget er grunnleggende fordi det lar chatboten analysere hvert språkelement uavhengig, samtidig som den bevarer bevissthet om deres relasjoner i setningsstrukturen.

Etter tokenisering bruker systemet normalisering, som standardiserer teksten ved å gjøre alt til små bokstaver, fjerne tegnsetting og korrigere vanlige stavevarianter. Dette sikrer at “Tilbakestilling av passord”, “tilbakestilling av passord” og “tilbakestiling av passord” alle gjenkjennes som samme begrep. Chatboten fjerner også stoppord – vanlige ord som “og”, “er”, “til” og “på” som har minimal semantisk betydning. Ved å filtrere disse ut, fokuserer systemet datakraften på ordene som faktisk bærer mening. I tillegg utfører systemet ordklassemerking, der det identifiseres om hvert ord fungerer som substantiv, verb, adjektiv eller annen grammatisk kategori. Denne grammatiske forståelsen hjelper chatboten å kjenne igjen at “tilbakestille” er et handlingsverb i meldingen din, noe som er avgjørende for å bestemme hva du egentlig ønsker å oppnå.

Naturlig språkprosessering (NLP) utgjør det teknologiske fundamentet som gjør at chatboter kan forstå menneskelig språk på et semantisk nivå. NLP omfatter flere sammenkoblede teknikker som samarbeider for å trekke ut mening fra tekst. Navngitt entitetsgjenkjenning (NER) identifiserer spesifikke enheter i meldingen din – egennavn, datoer, steder, produktnavn og annen viktig informasjon. I eksempelet med tilbakestilling av passord vil NER identifisere “passord” som en systementitet relevant for chatbotens kunnskapsbase. Denne evnen blir enda kraftigere i komplekse scenarioer: hvis du skriver “Jeg vil bestille en flyreise fra Oslo til London 15. desember”, trekker NER ut avreisested, destinasjon og dato – alt kritisk for å oppfylle forespørselen din.

Sentimentanalyse er en annen viktig NLP-komponent, som lar chatboter oppdage den følelsesmessige tonen i meldingen din. En kunde som sier “Jeg har ventet i tre timer og har fortsatt ikke mottatt bestillingen min” uttrykker frustrasjon, noe chatboten bør gjenkjenne for å justere svar-tonen og prioritere saken. Moderne sentimentanalyse bruker maskinlæringsmodeller trent på tusenvis av eksempler for å klassifisere tekst som positiv, negativ eller nøytral, og i økende grad for å oppdage mer nyanserte følelser som frustrasjon, forvirring eller tilfredshet. Denne emosjonelle intelligensen gjør at chatboter kan svare med passende empati og hastverk, noe som gir betydelig bedre kundetilfredshet.

Etter å ha behandlet råteksten, må chatboten fastslå hva brukeren egentlig vil – deres intensjon. Intensjonsgjenkjenning er en av de mest kritiske funksjonene i chatbot-arkitekturen fordi den bygger bro mellom det brukere sier og det de ønsker å oppnå. Systemet bruker maskinlæringsklassifisatorer trent på tusenvis av eksempel-samtaler for å knytte brukerutsagn til forhåndsdefinerte intensjoner. For eksempel kan frasene “Jeg har glemt passordet mitt”, “Hvordan tilbakestiller jeg passordet?”, “Jeg får ikke logget inn” og “Kontoen min er låst” alle tilordnes samme “passord_tilbakestilling”-intensjon, selv om de er formulert forskjellig.

Samtidig utfører systemet entitetsuttrekking, der det identifiserer spesifikke datapunkter i brukerens melding som er relevante for å oppfylle forespørselen. Hvis en kunde sier “Jeg vil oppgradere til premium-abonnement”, trekker systemet ut to nøkkelenheter: handlingen (“oppgradere”) og målet (“premium-abonnement”). Disse uttrukne entitetene blir parametere som styrer chatbotens svargenerering. Avanserte chatboter bruker avhengighetsanalyse for å forstå de grammatiske relasjonene mellom ordene, og kjenner igjen hvilke substantiv som er subjekter, hvilke som er objekter, og hvordan de relaterer til verb og modifikatorer. Denne dypere syntaktiske forståelsen gjør chatboten i stand til å håndtere komplekse, flerdelte setninger og tvetydige formuleringer som ville forvirret enklere systemer.

Dialogstyring utgjør “hjernen” i chatboten, ansvarlig for å opprettholde samtalekonteksten og avgjøre passende svar. I motsetning til enkle oppslagssystemer, opprettholder sofistikerte dialogstyrere en samtaletilstand som sporer hva som har blitt diskutert, hvilken informasjon som er hentet inn, og hva brukerens nåværende mål er. Denne kontekstbevisstheten gjør det mulig med naturlige, flytende samtaler der chatboten husker tidligere utvekslinger og kan referere til dem på en hensiktsmessig måte. Hvis du spør “Hvordan er været i London?” og følger opp med “Hva med i morgen?”, forstår dialogstyreren at “i morgen” refererer til værmeldingen for London, ikke et annet sted.

Dialogstyreren implementerer kontektshåndtering ved å lagre relevant informasjon i et strukturert format gjennom samtalen. Dette kan inkludere brukerens kontoinformasjon, tidligere forespørsler, preferanser og gjeldende samtaletema. Avanserte systemer bruker tilstandsautomater eller hierarkiske oppgavenettverk for å modellere samtaleflyter, definere hvilke tilstander som kan nås fra andre, og hvilke overganger som er gyldige. For eksempel kan en kundeservice-chatbot ha tilstander for “hilsen”, “problemid”, “feilsøking”, “eskalering” og “løsning”. Dialogstyreren sikrer at samtalen utvikler seg logisk gjennom disse tilstandene i stedet for å hoppe tilfeldig mellom dem.

Moderne AI-chatboter genererer ikke svar bare fra treningsdataen – de får tilgang til kunnskapsbaser som inneholder aktuell, nøyaktig informasjon spesifikk for organisasjonen. Denne integrasjonen er avgjørende for å opprettholde nøyaktighet og relevans. Når en kunde spør “Hva er saldoen på kontoen min?”, må chatboten spørre det faktiske banksystemet for å hente gjeldende saldo i stedet for å generere et sannsynlig tall. Tilsvarende, når noen spør “Hva er åpningstidene deres?”, får chatboten tilgang til bedriftens informasjonsdatabase for å gi nøyaktige, oppdaterte åpningstider, ikke basert på potensielt foreldet treningsdata.

Hentingsforsterket generering (RAG) representerer en avansert tilnærming til kunnskapsintegrasjon som har blitt stadig viktigere i 2025. RAG-systemer henter først relevante dokumenter eller informasjon fra en kunnskapsbase basert på brukerens forespørsel, og bruker så denne innhentede informasjonen for å generere et kontekstuelt passende svar. Denne to-trinnsprosessen forbedrer nøyaktigheten dramatisk sammenlignet med rene genereringsmetoder. For eksempel, hvis en kunde spør om en spesifikk produktegenskap, henter RAG-systemet produktdokumentasjonen, trekker ut den relevante delen og genererer et svar basert på den faktiske dokumentasjonen i stedet for potensielt oppdiktet informasjon. Denne tilnærmingen har vist seg spesielt verdifull i bedriftsmiljøer der nøyaktighet og etterlevelse er avgjørende.

Etter å ha forstått brukerens intensjon og hentet nødvendig informasjon, må chatboten generere et passende svar. Svargenerering kan følge flere ulike tilnærminger, hver med sine fordeler og begrensninger. Malbasert generering bruker forhåndsdefinerte svarmaler med variabler som fylles inn med spesifikk informasjon. For eksempel kan en mal være “Bestillingen din #[ORDER_ID] blir levert [LEVERINGSDATO].” Denne metoden er svært pålitelig og forutsigbar, men begrenset i fleksibilitet og naturlighet.

Regelbasert generering bruker spesifikke språklige regler for å konstruere svar basert på den identifiserte intensjonen og uttrukne entitetene. Reglene kan spesifisere at for en “passord_tilbakestilling”-intensjon skal svaret inneholde en bekreftelsesmelding, en lenke til tilbakestillingssiden og instruksjoner for neste steg. Denne tilnærmingen gir mer fleksibilitet enn maler og opprettholder samtidig pålitelighet, selv om det krever omfattende regelutvikling for komplekse scenarioer.

Nevral nettverksbasert generering, drevet av store språkmodeller (LLM), representerer spydspissen innen svargenereringsteknologi. Disse systemene bruker dype læringsarkitekturer som Transformers for å generere nye, kontekstuelt passende svar som høres bemerkelsesverdig menneskelige ut. Moderne LLM-er er trent på milliarder av tekst-token, og lærer statistiske mønstre for hvordan språk fungerer og hvordan begreper henger sammen. Når de genererer et svar, forutsier disse modellene det mest sannsynlige neste ordet gitt alle tidligere ord, og gjentar denne prosessen for å bygge komplette setninger. Fordelen med nevrale genereringssystemer er fleksibilitet og naturlighet; ulempen er at de av og til kan “hallusinere” – generere tilsynelatende troverdig, men faktisk feil informasjon.

Maskinlæring er mekanismen som gjør at chatboter blir bedre over tid. I stedet for å være statiske systemer med faste regler, lærer moderne chatboter av hver interaksjon, og forbedrer gradvis forståelsen av språkmønstre og brukerintensjoner. Supervised learning innebærer å trene chatboten på merkede eksempler der mennesker har annotert korrekt intensjon og entiteter for tusenvis av brukermeldinger. Maskinlæringsalgoritmen lærer å kjenne igjen mønstre som skiller én intensjon fra en annen, og bygger gradvis en modell som kan klassifisere nye, usette meldinger med høy nøyaktighet.

Reinforcement learning lar chatboter optimalisere svarene sine basert på tilbakemelding fra brukere. Når en bruker gir uttrykk for tilfredshet med et svar (gjennom eksplisitt tilbakemelding eller implisitte signaler som å fortsette samtalen), forsterker systemet mønstrene som førte til det svaret. Omvendt, når brukere uttrykker misnøye eller forlater samtalen, lærer systemet å unngå lignende mønstre i fremtiden. Denne tilbakemeldingssløyfen skaper en positiv spiral der chatbotens ytelse stadig forbedres. Avanserte systemer implementerer human-in-the-loop learning, der menneskelige agenter går gjennom krevende samtaler og gir rettelser som systemet lærer av, noe som dramatisk akselererer forbedringen sammenlignet med rent automatisert læring.

Store språkmodeller (LLM) har fundamentalt endret chatbotenes muligheter siden 2023. Disse modellene, trent på hundrevis av milliarder teksttoken, utvikler en sofistikert forståelse av språk, kontekst og domenespesifikk kunnskap. Modeller som GPT-4, Claude og Gemini kan føre nyanserte samtaler, forstå komplekse instruksjoner og generere sammenhengende, kontekstuelt passende svar på tvers av ulike temaer. Styrken til LLM-er kommer fra deres transformer-arkitektur, som bruker oppmerksomhetsmekanismer for å forstå relasjoner mellom fjerne ord i en setning, slik at modellen kan holde på konteksten gjennom lange samtaler.

Men LLM-er har begrensninger som organisasjoner må adressere. De kan hallusinere – selvsikkert generere feilinformasjon som høres troverdig ut. De kan ha utfordringer med svært fersk informasjon som ikke er med i treningsdataen. De kan vise skjevheter som finnes i treningsdataen. For å takle disse begrensningene bruker organisasjoner i økende grad finjustering for å tilpasse generelle LLM-er til spesifikke domener, og prompt engineering for å styre modellene mot ønsket adferd. FlowHunts tilnærming til chatbotbygging utnytter disse avanserte modellene, samtidig som de gir rekkverk og kunnskapsintegrasjon for å sikre nøyaktighet og pålitelighet.

| Aspekt | Regelbaserte chatboter | AI-drevne chatboter | LLM-baserte chatboter |

|---|---|---|---|

| Teknologi | Beslutningstrær, mønstergjenkjenning | NLP, ML-algoritmer, intensjonsgjenkjenning | Store språkmodeller, transformers |

| Fleksibilitet | Begrenset til forhåndsdefinerte regler | Tilpasser seg variasjoner i formulering | Svært fleksibel, håndterer nye innspill |

| Nøyaktighet | Høy for definerte scenarioer | God med riktig opplæring | Utmerket, men krever rekkverk |

| Læring | Ingen læringsevne | Lærer av interaksjoner | Lærer av finjustering og tilbakemelding |

| Hallusinasjonsrisiko | Ingen | Minimal | Krever tiltak mot feilinformasjon |

| Implementeringstid | Rask | Moderat | Rask med plattformer som FlowHunt |

| Vedlikehold | Høyt (krever regeloppdatering) | Moderat | Moderat (modelloppdateringer, overvåking) |

| Kostnad | Lav | Moderat | Moderat til høy |

| Beste bruksområder | Enkle FAQ-er, grunnleggende ruting | Kundeservice, kvalifisering av leads | Kompleks resonnement, innholdsgenerering |

Moderne chatboter benytter Transformer-arkitektur, en nevrale nettverksdesign som revolusjonerte naturlig språkprosessering. Transformere bruker oppmerksomhetsmekanismer som gjør at modellen kan fokusere på relevante deler av innputten når hvert ord i utdataene genereres. Når den behandler “Banksjefen var bekymret for at elvebredden skulle rase ut”, hjelper oppmerksomhetsmekanismen modellen å forstå at det første “bank” viser til en finansinstitusjon, mens det andre viser til en elvebredd, basert på konteksten. Denne kontekstforståelsen er langt bedre enn tidligere tilnærminger som behandlet tekst sekvensielt uten slik bevissthet.

Multi-head attention utvider dette konseptet ved å la modellen fokusere på forskjellige aspekter av innputten samtidig. Ett oppmerksomhetshode kan fokusere på grammatiske relasjoner, et annet på semantiske forhold, og et tredje på diskursstruktur. Denne parallelle behandlingen av ulike språklige fenomener gjør det mulig for modellen å bygge rike, nyanserte meningsrepresentasjoner. Posisjonell koding i transformere gjør at modellen forstår ordrekkefølge, selv om alle ord behandles parallelt – en avgjørende evne for å forstå språk der rekkefølgen har betydning.

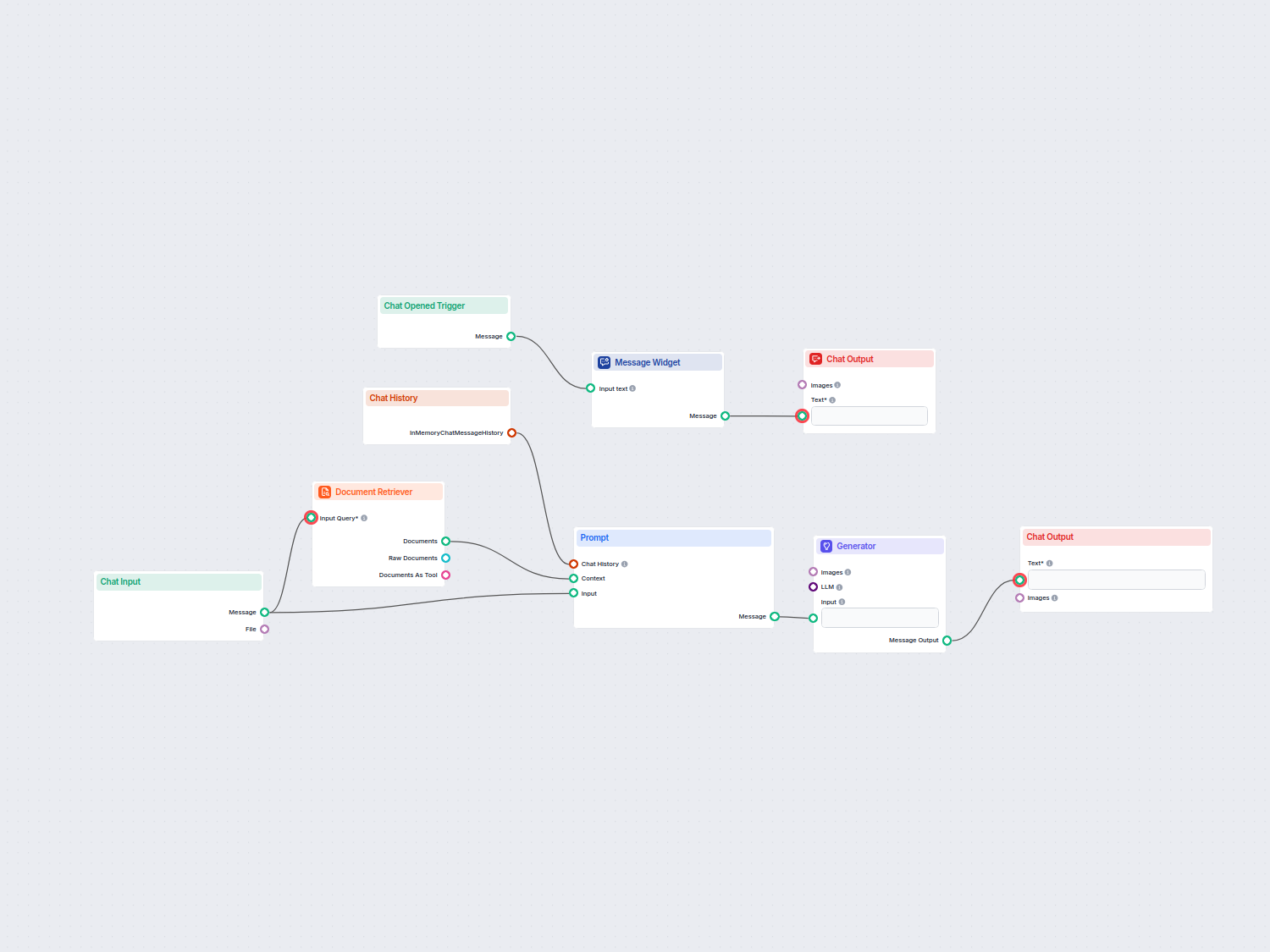

FlowHunt representerer en moderne tilnærming til chatbotutvikling som abstraherer vekk mye av den tekniske kompleksiteten, samtidig som den gir tilgang til kraftige AI-funksjoner. I stedet for at team må bygge chatbot-infrastrukturen fra bunnen, tilbyr FlowHunt en visuell byggeverktøy der ikke-tekniske brukere kan designe samtaleflyter ved å koble sammen komponenter som representerer ulike chatbotfunksjoner. Plattformen håndterer underliggende NLP, intensjonsgjenkjenning og svargenerering, slik at team kan fokusere på å designe samtaleopplevelsen og integrere med forretningssystemene.

FlowHunts Kunnskapskilder-funksjon gir chatboter tilgang til sanntidsinformasjon fra dokumenter, nettsider og databaser, og implementerer RAG-prinsipper for å sikre nøyaktighet. Plattformens AI-agenter gjør det mulig å bygge autonome systemer som kan utføre handlinger utover samtale – oppdatere databaser, sende e-post, booke avtaler eller utløse arbeidsflyter. Dette er et betydelig fremskritt sammenlignet med tradisjonelle chatboter som kun gir informasjon; FlowHunt-drevne systemer kan faktisk utføre oppgaver på vegne av brukerne. Plattformens integrasjonsmuligheter kobler chatboter til CRM-systemer, helpdesk-programvare og forretningsapplikasjoner, slik at data flyter sømløst og handlinger utføres effektivt.

Effektiv utrulling av chatboter krever overvåking av nøkkelmetrikker som viser om systemet oppfyller forretningsmålene. Intensjonsgjenkjenningsnøyaktighet måler hvor stor andel av brukermeldinger som klassifiseres korrekt. Entitetsuttrekkingsnøyaktighet måler hvorvidt systemet korrekt identifiserer relevante datapunkter. Brukertilfredshets-score innhentet gjennom undersøkelser etter samtalen viser om brukerne fant samhandlingen nyttig. Fullføringsrate for samtaler måler hvor stor andel av samtalene som fører til at brukerens problem løses uten at det må eskaleres til et menneske.

Svartidslatens måler hvor raskt chatboten genererer svar – avgjørende for brukeropplevelsen siden forsinkelser på mer enn noen få sekunder reduserer tilfredsheten betydelig. Eskaleringrate viser hvor stor andel av samtalene som må overføres til menneskelige agenter, hvor lavere rate vanligvis indikerer bedre chatbotytelse. Kostnad per samtale måler den økonomiske effektiviteten ved å sammenligne AI-behandlingskostnaden med kostnaden for menneskelig håndtering. Organisasjoner bør etablere utgangsverdier før utrulling, og deretter kontinuerlig overvåke disse metrikker for å finne forbedringsmuligheter og sikre at chatboten fortsetter å levere verdi etter hvert som bruken utvikler seg.

Chatboter håndterer ofte sensitiv informasjon, inkludert personopplysninger, økonomiske data og konfidensielle forretningsdetaljer. Datakryptering sikrer at informasjon som sendes mellom bruker og chatbot er beskyttet mot avlytting. Autentiseringsmekanismer verifiserer at brukere er den de utgir seg for å være før de får tilgang til sensitiv informasjon. Tilgangskontroller sikrer at chatboter kun får tilgang til den spesifikke dataen de trenger for å utføre sin funksjon, i tråd med prinsippet om minste privilegium. Organisasjoner må implementere revisjonslogging for å ha oversikt over alle chatbot-interaksjoner for etterlevelse og sikkerhet.

Personvern innebygd i designet bør lede chatbotutviklingen, og sikre at innsamling av personopplysninger minimeres, datalagring begrenses til nødvendige perioder, og brukerne har innsyn i hvilke data som samles inn og hvordan de brukes. Overholdelse av regelverk som GDPR, CCPA og bransjespesifikke krav som HIPAA eller PCI-DSS er essensiell. Organisasjoner bør gjennomføre sikkerhetsvurderinger av chatbot-systemene for å avdekke sårbarheter og implementere nødvendige tiltak. Ansvaret for sikkerhet omfatter ikke bare chatbot-plattformen, men også kunnskapsbaser, integrasjoner og backend-systemer som chatboten får tilgang til.

Utviklingen av chatbot-teknologi akselererer fortsatt. Multimodale chatboter som kan behandle og generere tekst, tale, bilder og video samtidig representerer neste grense. I stedet for kun tekstinteraksjon, vil brukerne i økende grad samhandle med chatboter gjennom foretrukket kanal – tale for hender-frie situasjoner, bilder for visuelle produktspørsmål, video for komplekse demonstrasjoner. Emosjonell intelligens i chatboter vil utvikle seg utover enkel sentimentanalyse til nyansert forståelse av brukerens følelsestilstand og tilpassede emosjonelle svar. Chatboter vil gjenkjenne når brukere er frustrerte, forvirret eller fornøyde, og justere kommunikasjonen deretter.

Proaktiv assistanse er en annen fremvoksende egenskap der chatboter forutser brukerbehov før de eksplisitt etterspør hjelp. I stedet for å vente på spørsmål, vil chatboter identifisere mønstre som indikerer potensielle problemer og tilby hjelp proaktivt. Personalisering vil bli stadig mer sofistikert, med chatboter som tilpasser kommunikasjon, anbefalinger og assistanse basert på individuelle brukerpreferanser, historikk og kontekst. Integrasjon med autonome systemer vil gjøre det mulig for chatboter å samhandle med robotprosessautomatisering, IoT-enheter og andre automatiserte systemer for å utføre komplekse oppgaver som spenner over flere systemer og krever koordinering.

Å forstå hvordan AI-chatboter fungerer viser hvorfor de har blitt essensielle verktøy for virksomheter på tvers av bransjer. Den sofistikerte samhandlingen mellom naturlig språkprosessering, maskinlæring, dialogstyring og kunnskapsintegrasjon gjør chatboter i stand til å håndtere stadig mer komplekse oppgaver, samtidig som de bevarer naturlig, menneskelignende interaksjon. Organisasjoner som implementerer chatboter effektivt – med plattformer som FlowHunt som abstraherer teknisk kompleksitet samtidig som de beholder kraftige funksjoner – får betydelige konkurransefortrinn gjennom økt kundetilfredshet, reduserte driftskostnader og raskere responstid.

Teknologien utvikler seg raskt, med fremskritt innen store språkmodeller, multimodale egenskaper og autonome agenter som utvider mulighetene ytterligere. Organisasjoner bør se chatbotimplementering ikke som et engangsprosjekt, men som en kontinuerlig evne som forbedres over tid gjennom læring, optimalisering og videreutvikling. De mest vellykkede implementasjonene kombinerer kraftig AI-teknologi med gjennomtenkt samtaledesign, hensiktsmessige sikkerhetsmekanismer og integrasjon med forretningssystemer som gir chatboter muligheten til å utføre meningsfulle handlinger. Når vi går gjennom 2025 og videre, vil chatboter i økende grad bli det primære grensesnittet mellom kunder, ansatte og organisasjoner, noe som gjør investering i denne teknologien strategisk viktig for forretningssuksess.

Slutt å håndtere repeterende kundehenvendelser manuelt. FlowHunts kodefrie AI-chatbot-bygger lar deg lage intelligente, autonome chatboter som håndterer kundeservice, leadgenerering og support døgnet rundt. Rull ut på minutter, ikke uker.

Lær hvordan du bygger en AI-chatbot fra bunnen av med vår omfattende guide. Oppdag de beste verktøyene, rammeverkene og steg-for-steg-prosessen for å lage intel...

Lær hvordan du bygger en Discord AI-chatbot med trinnvise instruksjoner, API-integrasjonsmetoder, feilhåndtering, sikkerhetsrutiner og avanserte tilpasningsmuli...

AI chatbot-assistent drevet av OpenAI GPT-4o som automatisk søker og utnytter interne bedriftsdokumenter for å svare på brukerens spørsmål. Leverer kontekstsens...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.