Flyter

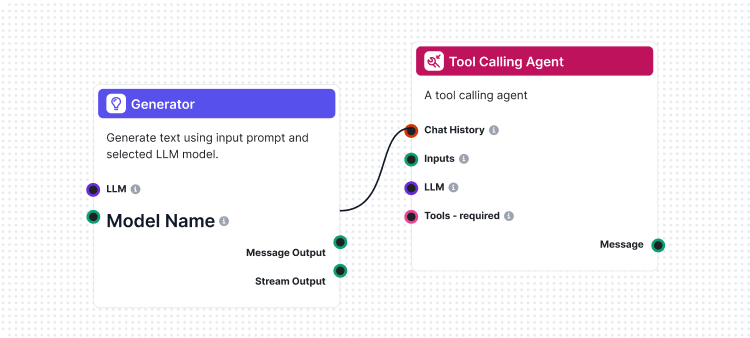

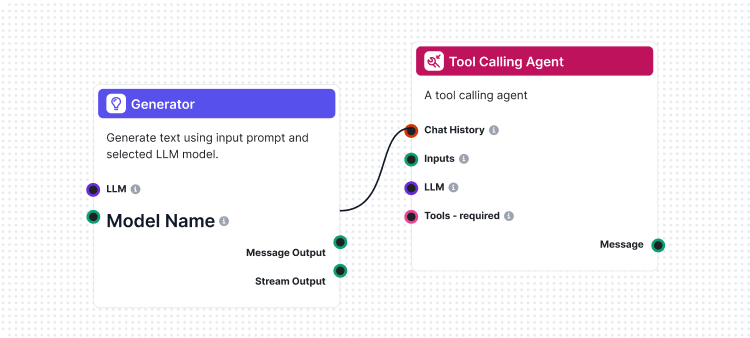

Flyter er hjernen bak alt i FlowHunt. Lær hvordan du bygger dem med en visuell no-code-bygger, fra å plassere den første komponenten til nettsideintegrasjon, ut...

Denne artikkelen forklarer hvordan du kobler FlowHunt til Langfuse for helhetlig observabilitet, sporer AI-arbeidsflytens ytelse, og bruker Langfuse-dashbord til å overvåke og optimalisere ditt FlowHunt-arbeidsområde.

Etter hvert som AI-arbeidsflytene dine i FlowHunt vokser, blir det kritisk å forstå hva som skjer bak kulissene. Spørsmål som “Hvorfor er denne arbeidsflyten treg?”, “Hvor mange tokens bruker jeg?” eller “Hvor oppstår feilene?” krever detaljert innsikt i systemet ditt.

Uten skikkelig observabilitet blir feilsøking av AI-arbeidsflyter som å fly i blinde — du ser resultatene, men ikke reisen dit. Tracing-verktøy som Langfuse løser dette ved å fange opp hvert steg i arbeidsflytens utførelse og gir deg dyp innsikt i ytelse, kostnader og oppførsel.

Denne artikkelen forklarer hvordan du sømløst kan koble FlowHunt til Langfuse, slik at du får fullstendig observabilitet på tvers av alle AI-arbeidsflytene dine. Du lærer å spore utførelsesbaner, overvåke token-bruk, identifisere flaskehalser og visualisere ytelsesdata — alt i ett sentralisert dashbord.

Etterpå vil du ha full oversikt over ditt FlowHunt-arbeidsområde, slik at du kan optimalisere arbeidsflyter, redusere kostnader og sikre pålitelighet.

Observabilitet handler om å instrumentere systemet ditt slik at du kan forstå dets indre tilstand gjennom ytre signaler — hovedsakelig traces, måleparametre og logger.

For FlowHunt-brukere som kjører AI-drevne arbeidsflyter, gir observabilitet innsikt i:

Uten observabilitet blir feilsøking reaktivt og tidkrevende. Med observabilitet får du proaktive innsikter som gir kontinuerlig optimalisering og rask feilhåndtering.

Langfuse er en åpen kildekode observabilitets- og analyseplattform spesielt bygget for LLM-applikasjoner. Den fanger detaljerte spor av AI-arbeidsflytens utførelse og gir utviklere og team innsikten de trenger for å feilsøke, overvåke og optimalisere AI-systemene sine.

Nøkkelfunksjoner i Langfuse inkluderer:

Ved å koble Langfuse til FlowHunt forvandler du rå utførelsesdata til handlingsrettet innsikt — du ser hva som fungerer, hva som ikke gjør det, og hvor du bør sette inn optimaliseringstiltak.

Ved å følge denne veiledningen vil du:

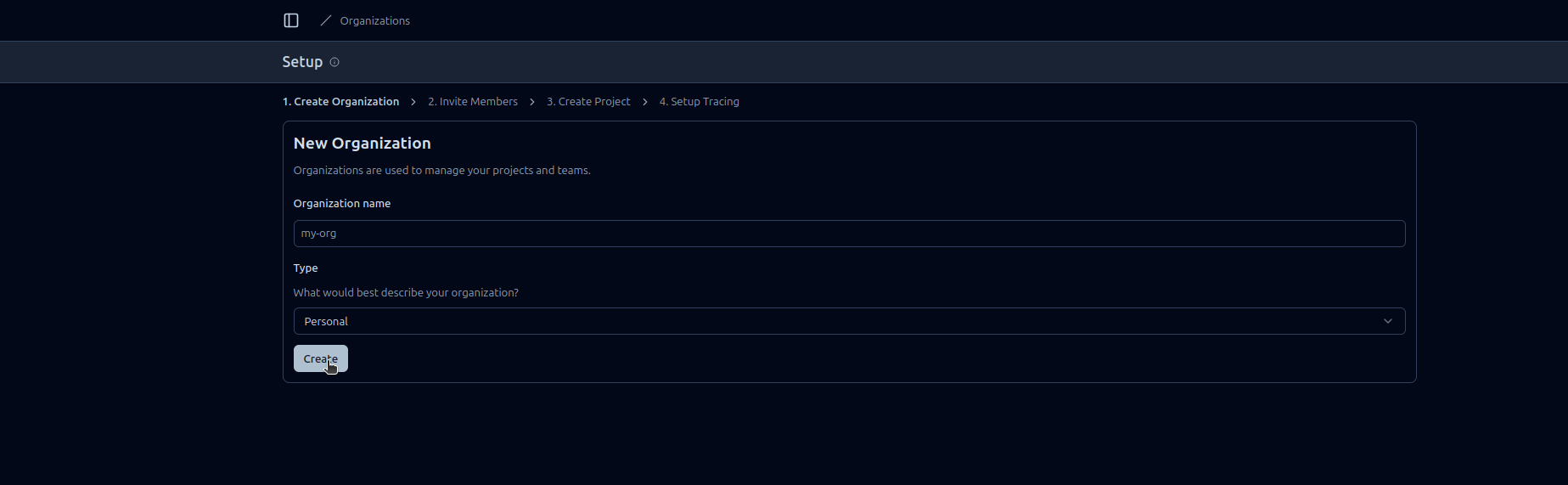

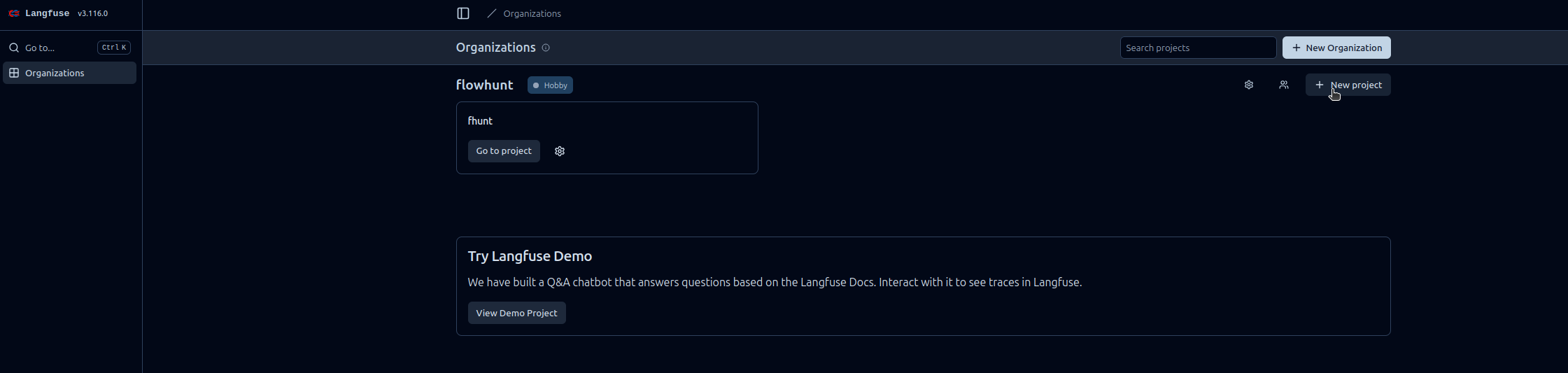

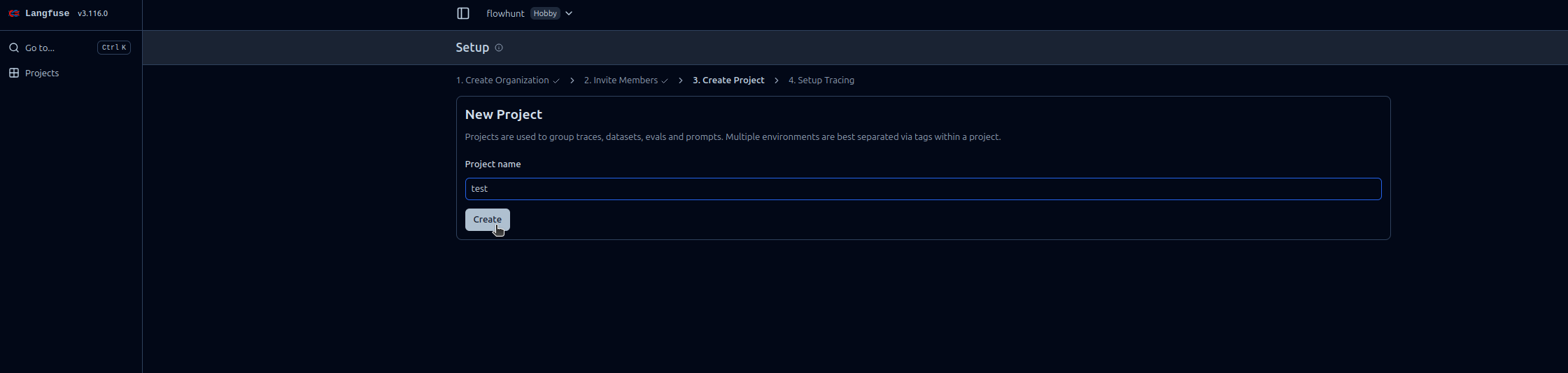

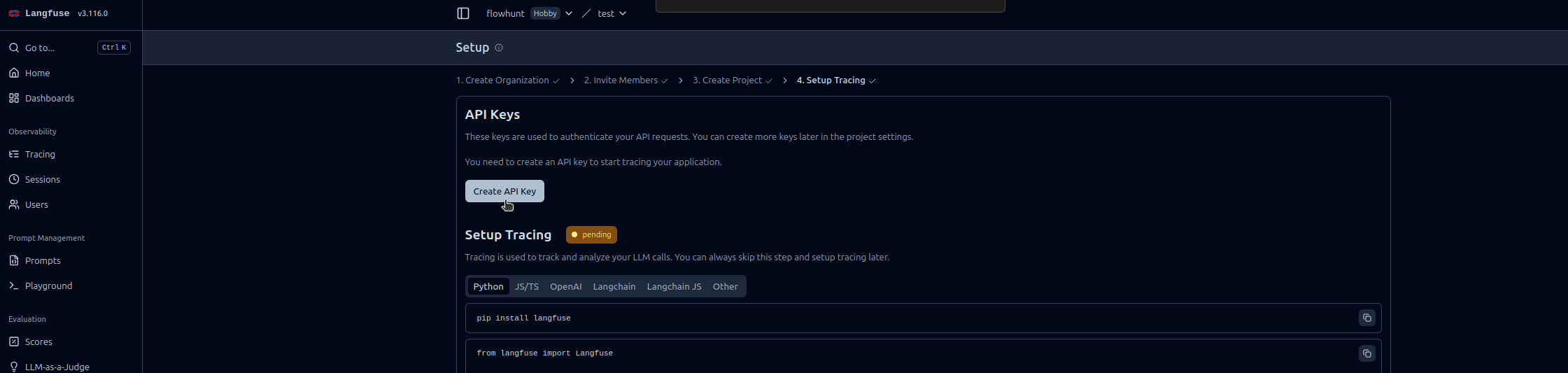

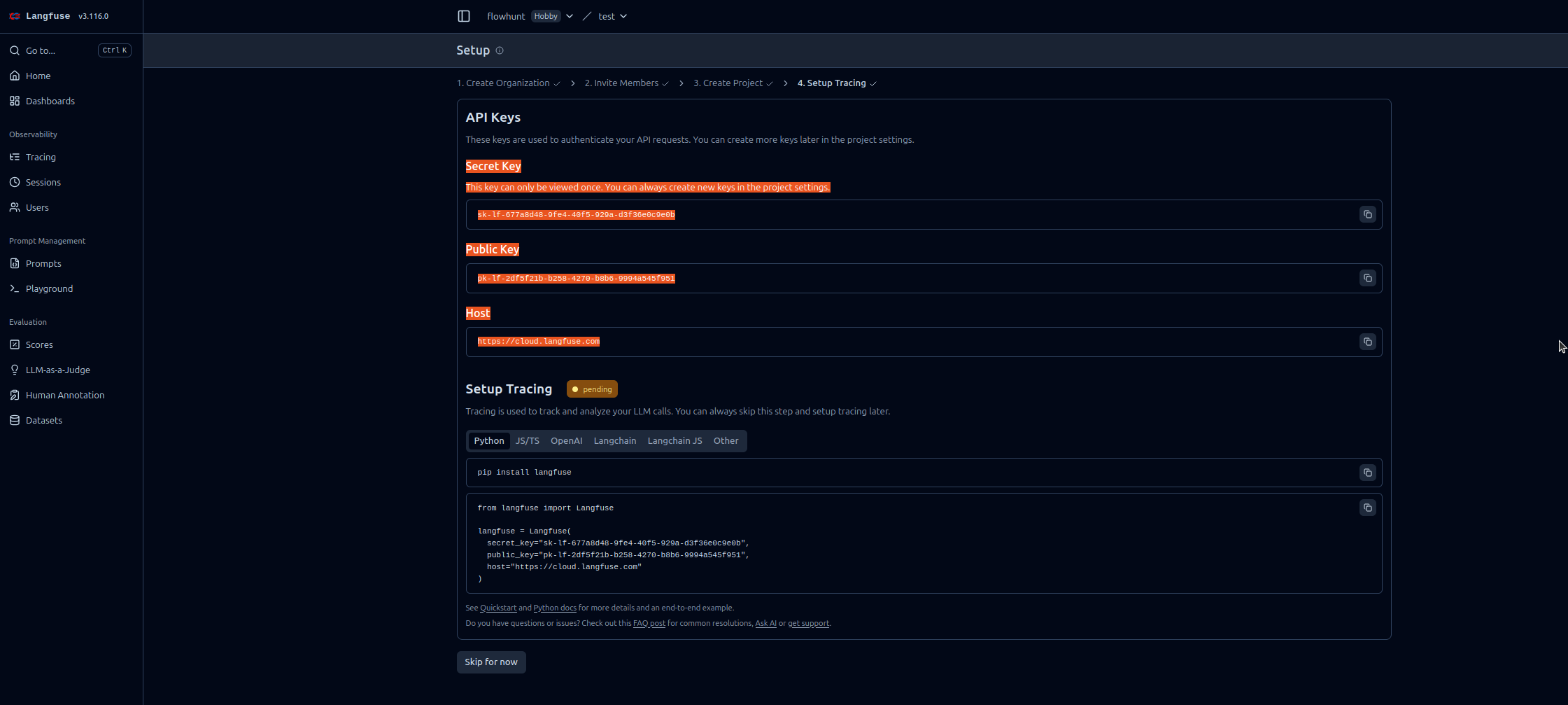

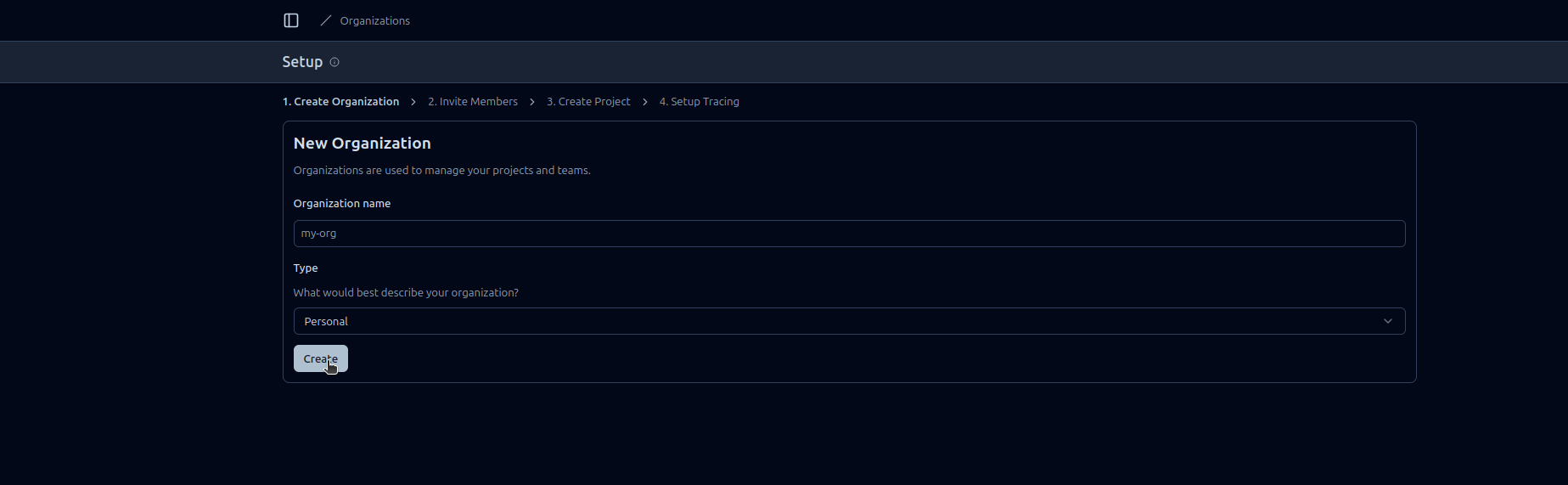

Følg disse trinnvise instruksjonene for å aktivere FlowHunt-observabilitet i Langfuse:

https://cloud.langfuse.com)

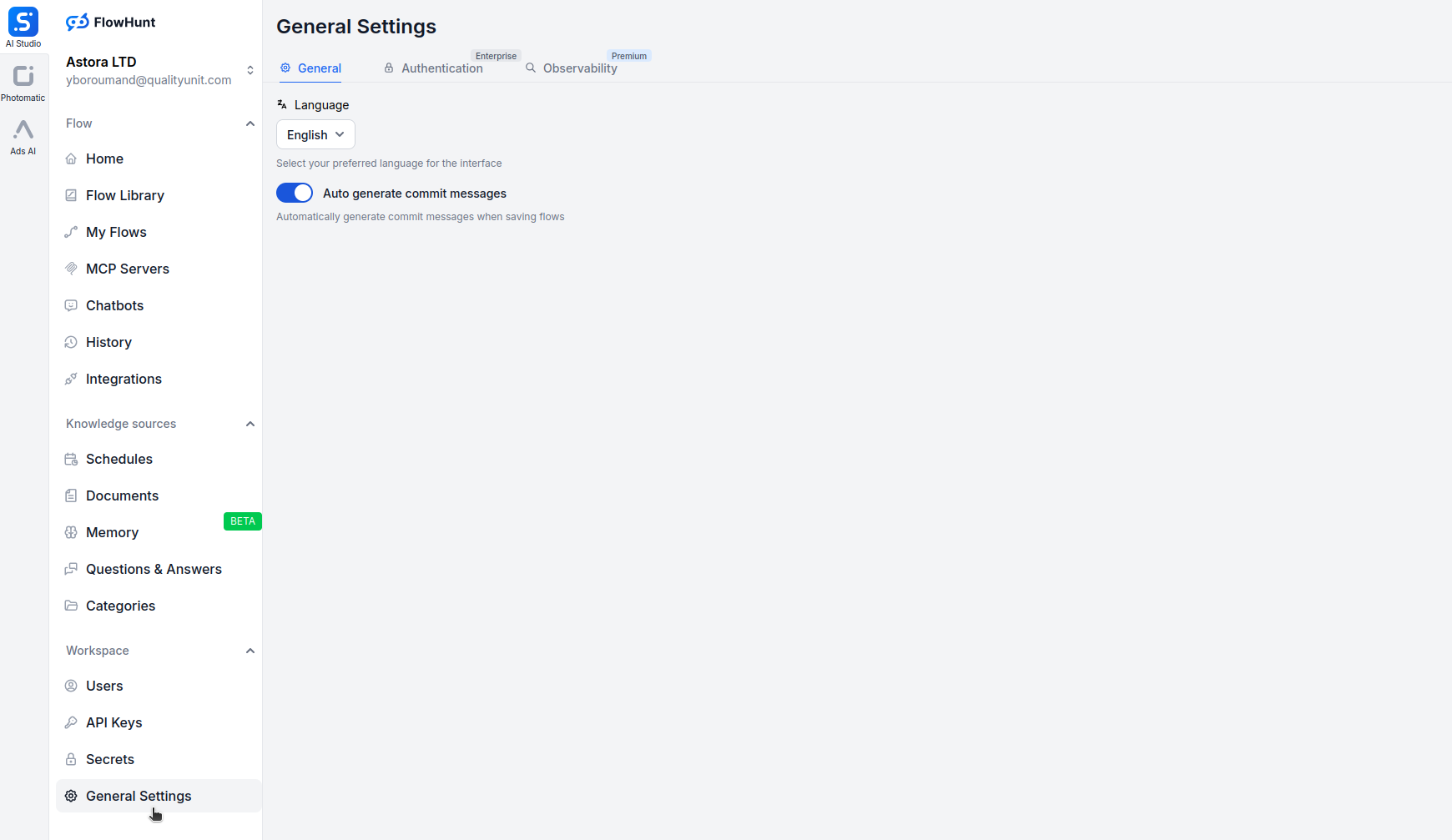

Åpne app.flowhunt.io i nettleseren din.

Gå til Generelle innstillinger (som regel via sidepanelet eller toppmenyen).

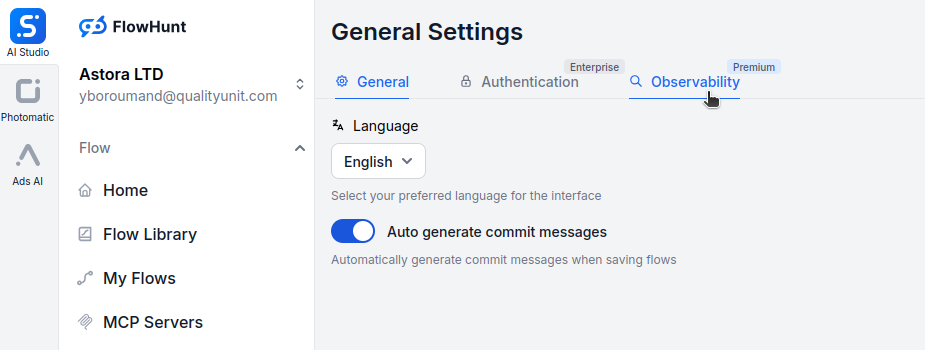

Bla ned og klikk på fanen Observabilitet.

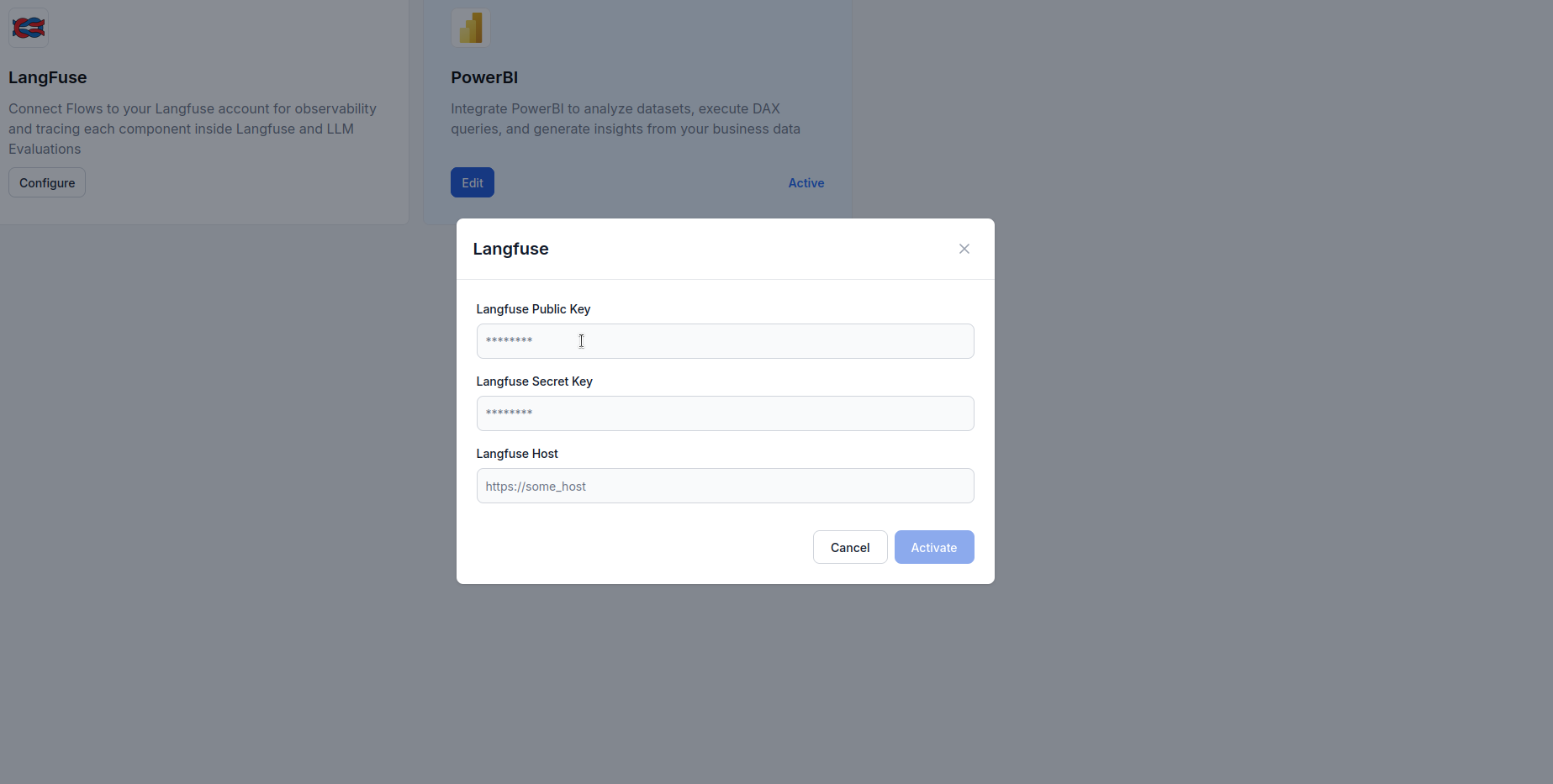

Finn boksen Langfuse og klikk Konfigurer.

https://cloud.langfuse.com)

Når FlowHunt er koblet til Langfuse, får du tilgang til kraftige visualiserings- og analysemuligheter. Her er noen eksempler på innsikt du kan generere:

Se en detaljert tidslinje for hver arbeidsflytkjøring, inkludert:

Dette hjelper deg å finne flaskehalser og forstå arbeidsflytens oppførsel i detalj.

Overvåk token-forbruk på tvers av arbeidsflyter:

Dette gjør det mulig å optimalisere kostnader ved å finne token-tunge operasjoner.

Følg nøkkelindikatorer for ytelse:

Disse målingene hjelper deg å overholde SLA-er og optimalisere brukeropplevelsen.

Avdekk og diagnostiser feil:

Dette gir raskere feilhåndtering og forbedrer påliteligheten.

For samtalebaserte AI-agenter kan du følge:

Dette hjelper deg å optimalisere agentens oppførsel og brukeropplevelse.

Sammenlign ytelse mellom ulike LLM-leverandører:

Dette gir grunnlag for modellvalg basert på faktiske bruksdata.

Å integrere FlowHunt med Langfuse forvandler AI-arbeidsflytene dine fra svarte bokser til transparente, optimaliserbare systemer. Med omfattende tracing får du innsyn i hvert utførelsessteg og kan ta datadrevne beslutninger om ytelse, kostnader og pålitelighet.

Langfuse-observabilitetsintegrasjonen gjør overvåkning sømløs — fra enkel API-nøkkeloppsett til rike, handlingsrettede dashbord som viser nøyaktig hvordan arbeidsflytene oppfører seg i produksjon.

Nå som ditt FlowHunt-arbeidsområde er koblet til Langfuse, har du grunnlaget for kontinuerlig forbedring: identifiser flaskehalser, optimaliser token-bruk, reduser ventetid og sørg for at AI-systemene dine gir maksimal verdi — med full trygghet.

Observabilitet i FlowHunt refererer til muligheten for å overvåke, spore og analysere hvordan AI-arbeidsflyter, agenter og automasjoner presterer i sanntid. Det hjelper brukere å oppdage flaskehalser, følge med på token-bruk, måle ventetid og ta datadrevne optimaliseringsbeslutninger.

Langfuse er en åpen kildekode LLM-ingeniørplattform laget for sporing, overvåking og analyse av AI-applikasjoner. Når den integreres med FlowHunt, gir den detaljerte innsikter i arbeidsflytutførelse, token-forbruk, modellprestasjon og feilsøking.

Nei, integrasjonen er enkel. Du trenger bare å opprette en Langfuse-konto, generere API-nøkler og lime dem inn i FlowHunt sine observabilitetsinnstillinger. Ingen koding er nødvendig.

Når de er koblet sammen, kan du spore utførelsesspor, token-bruk, modellkostnader, ventetidsmålinger, feilhastigheter, arbeidsflytprestasjon over tid, og detaljerte steg-for-steg-oversikter over AI-agentinteraksjoner.

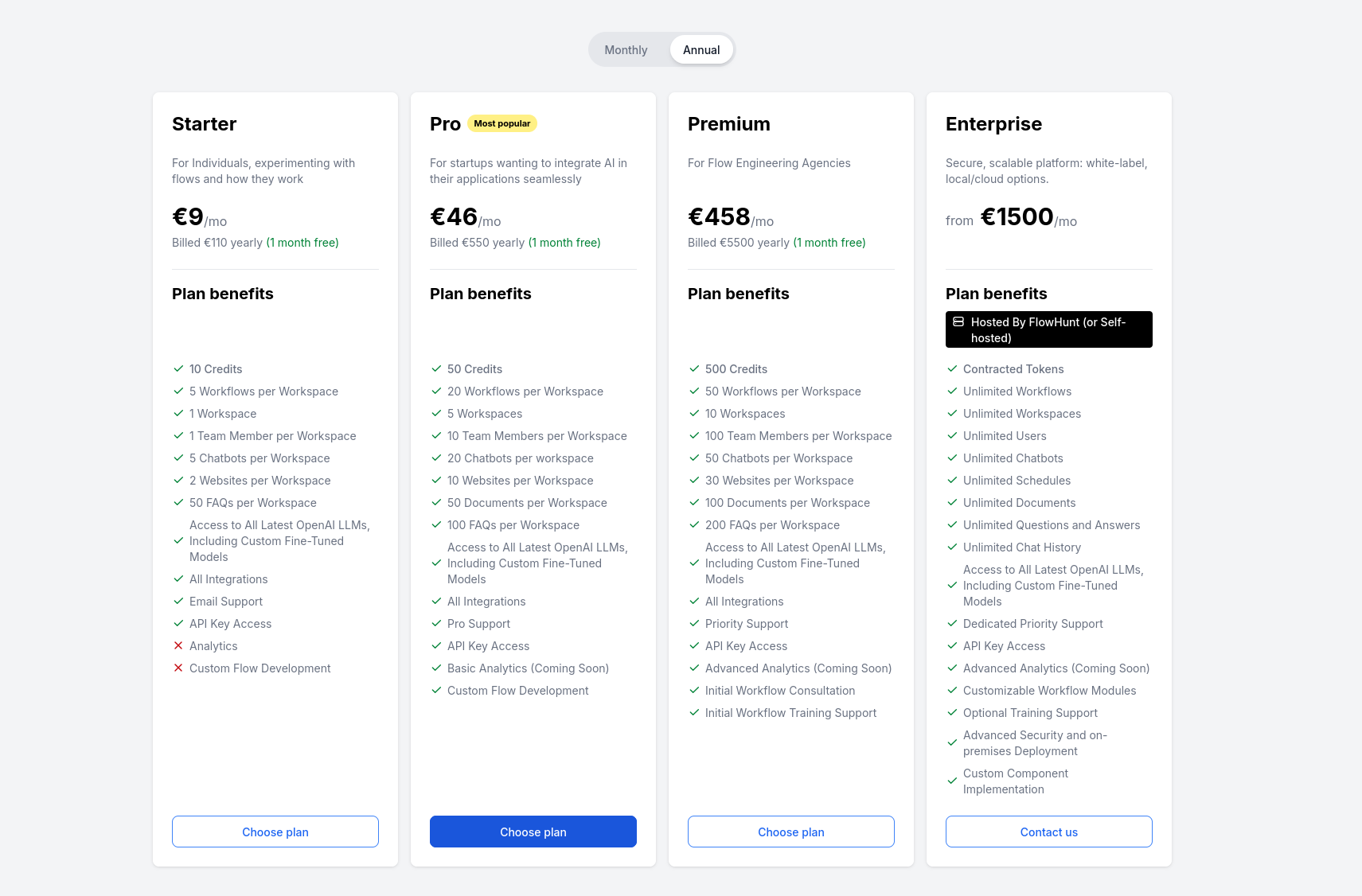

Langfuse tilbyr et gratis nivå som inkluderer grunnleggende tracing og observabilitetsfunksjoner. For større team og avansert analyse har Langfuse betalte planer med flere muligheter.

Flyter er hjernen bak alt i FlowHunt. Lær hvordan du bygger dem med en visuell no-code-bygger, fra å plassere den første komponenten til nettsideintegrasjon, ut...

Lær hvordan du integrerer FlowHunt med PowerBI, konfigurerer overvåkingsinnstillinger og visualiserer FlowHunt-arbeidsplassens måledata direkte i PowerBI-dashbo...

En omfattende guide til FlowHunts prising, inkludert hvordan kreditter og interaksjoner fungerer, hvordan kompleksitet påvirker kostnader, og hva som skjer med ...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.