py-mcp-mssql MCP Server

py-mcp-mssql MCP Server gir en sikker og effektiv bro for AI-agenter til å samhandle programmessig med Microsoft SQL Server-databaser via Model Context Protocol...

Aktiver sikker, automatisert og parallell Python-kodekjøring i AI-arbeidsflyter med FlowHunt sin pydanticpydantic-aimcp-run-python MCP Server.

FlowHunt gir et ekstra sikkerhetslag mellom dine interne systemer og AI-verktøy, og gir deg granulær kontroll over hvilke verktøy som er tilgjengelige fra dine MCP-servere. MCP-servere som er hostet i vår infrastruktur kan sømløst integreres med FlowHunts chatbot samt populære AI-plattformer som ChatGPT, Claude og forskjellige AI-editorer.

pydanticpydantic-aimcp-run-python MCP Server er designet for å fungere som en bro mellom AI-assistenter og Python-kodekjøringsmiljøer. Ved å tilby et sikkert og kontrollert grensesnitt for å kjøre Python-skript, muliggjør denne MCP-serveren at AI-klienter kan samhandle programmessig med Python-funksjoner, automatisere beregningsarbeidsflyter og hente resultater som del av større utviklingspipelines. Denne funksjonaliteten er spesielt verdifull for oppgaver som dynamisk kodeevaluering, rask prototyping eller integrering av Python-basert analyse i LLM-drevet automatisering. Serveren gir utviklere mulighet til å effektivisere koding, feilsøking og databehandling ved å koble AI-verktøyene sine mot live Python-kjøring—samtidig som klare sikkerhets- og driftsgrenser opprettholdes.

Ingen prompt-maler er nevnt i repository-filene eller dokumentasjonen.

Ingen spesifikke ressursprimitiver er nevnt i tilgjengelig repository-innhold.

functions-navnerommet finnes, men ingen eksplisitte verktøy er definert i henhold til repo-innholdet.functions-navnerommet og kan kjøres parallelt. Nyttig for å fordele arbeidsmengder eller batchprosessering i MCP-kontekst.multi_tool_use.parallel-funksjonen for å kjøre flere Python-funksjoner samtidig og optimalisere arbeidsflyter som drar nytte av parallellisme.mcpServers-seksjonen:{

"mcpServers": {

"pydanticpydantic-aimcp-run-python": {

"command": "npx",

"args": [

"@pydanticpydantic-aimcp-run-python@latest",

"start"

]

}

}

}

{

"mcpServers": {

"pydanticpydantic-aimcp-run-python": {

"command": "npx",

"args": [

"@pydanticpydantic-aimcp-run-python@latest",

"start"

]

}

}

}

{

"mcpServers": {

"pydanticpydantic-aimcp-run-python": {

"command": "npx",

"args": [

"@pydanticpydantic-aimcp-run-python@latest",

"start"

]

}

}

}

{

"mcpServers": {

"pydanticpydantic-aimcp-run-python": {

"command": "npx",

"args": [

"@pydanticpydantic-aimcp-run-python@latest",

"start"

]

}

}

}

For sikkerhetens skyld, definer API-nøkler og hemmeligheter i miljøvariabler, ikke direkte i konfigurasjonsfiler. Referer til dem via env-feltet og send dem ved behov i inputs-seksjonen. Eksempel:

{

"mcpServers": {

"pydanticpydantic-aimcp-run-python": {

"command": "npx",

"args": [

"@pydanticpydantic-aimcp-run-python@latest",

"start"

],

"env": {

"PYTHON_API_KEY": "${PYTHON_API_KEY}"

},

"inputs": {

"api_key": "${PYTHON_API_KEY}"

}

}

}

}

Bruk av MCP i FlowHunt

For å integrere MCP-servere i din FlowHunt-arbeidsflyt, start med å legge til MCP-komponenten i flyten din og koble den til AI-agenten:

Klikk på MCP-komponenten for å åpne konfigurasjonspanelet. I system-MCP-konfigurasjonsseksjonen, sett inn MCP-serverdetaljene dine med dette JSON-formatet:

{

"pydanticpydantic-aimcp-run-python": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Når det er konfigurert, kan AI-agenten nå bruke denne MCP-en som et verktøy med tilgang til alle funksjonene og mulighetene. Husk å endre “pydanticpydantic-aimcp-run-python” til det faktiske navnet på din MCP-server og bytte ut URL-en med din egen MCP-server-URL.

| Seksjon | Tilgjengelig | Detaljer/Notater |

|---|---|---|

| Oversikt | ✅ | |

| Liste over prompt-maler | ⛔ | Ingen prompt-maler funnet |

| Liste over ressurser | ⛔ | Ingen ressursprimitiver funnet |

| Liste over verktøy | ✅ | multi_tool_use.parallel og functions-navnerom; ingen eksplisitt definert |

| Sikring av API-nøkler | ✅ | Eksempel gitt i oppsettseksjonen |

| Sampling-støtte (mindre viktig i evaluering) | ⛔ | Ikke nevnt |

Basert på tilgjengelig informasjon tilbyr denne MCP-serveren grunnleggende Python-kjøring og parallell verktøyorkestrering, men mangler prompt-maler, ressursprimitiver og eksplisitt sampling- eller roots-støtte. De viktigste styrkene er enkel integrasjon og klare sikkerhetsanbefalinger. Forbedringer kan være å legge til flere verktøy, prompt-maler og dokumentasjon på avanserte MCP-funksjoner.

Denne MCP-serveren er funksjonelt nyttig for Python-kodekjøring og parallellisme, men mangelen på prompts, ressurser og eksplisitt avanserte MCP-funksjoner gjør den mer til en grunnleggende integrasjon. Kodebasen er minimal, og dokumentasjonen på nyanserte egenskaper er begrenset.

| Har en LISENS | ⛔ (Ikke funnet i repo-roten for dette delprosjektet) |

|---|---|

| Har minst ett verktøy | ✅ (multi_tool_use.parallel) |

| Antall Forks | (Sjekk på GitHub-repo) |

| Antall Stjerner | (Sjekk på GitHub-repo) |

Totalt vil jeg gi denne MCP-serveren 4/10 for grunnleggende nytte men begrenset funksjonssett og dokumentasjon.

Den tilbyr et sikkert grensesnitt for å kjøre Python-skript og funksjoner fra AI-agenter, som muliggjør automatisering, live kodeevaluering og parallell kjøring i AI-drevne arbeidsflyter.

Den støtter dynamisk Python-kjøring og inkluderer et parallellutførelsesverktøy (multi_tool_use.parallel) for å kjøre flere Python-funksjoner samtidig.

Lagre sensitive nøkler i miljøvariabler og referer til dem i 'env'- og 'inputs'-seksjonene i MCP-serverkonfigurasjonen din, i stedet for å hardkode dem i konfigurasjonsfiler.

Bruksområder inkluderer AI-drevet Python-skripting, automatisert dataanalyse, parallell oppgaveutførelse, integrasjon med CI/CD-pipelines og en kode-sandkasse for utdanning eller eksperimentering.

Ingen prompt-maler eller spesifikke ressursprimitiver er definert for denne MCP Server.

Legg til MCP-komponenten i flyten din, åpne konfigurasjonen og sett inn serverdetaljene ved å bruke det oppgitte JSON-formatet. Sørg for at server-URL og navn samsvarer med din distribusjon.

Effektiviser AI-automatiseringen din med sikker Python-kodekjøring, parallell oppgaveorkestrering og enkel integrasjon. Opplev live Python-skripting i dine flyter!

py-mcp-mssql MCP Server gir en sikker og effektiv bro for AI-agenter til å samhandle programmessig med Microsoft SQL Server-databaser via Model Context Protocol...

CodeLogic MCP Server kobler FlowHunt og AI-programmeringsassistenter til CodeLogic sin detaljerte programvareavhengighetsdata, og muliggjør avansert kodeanalyse...

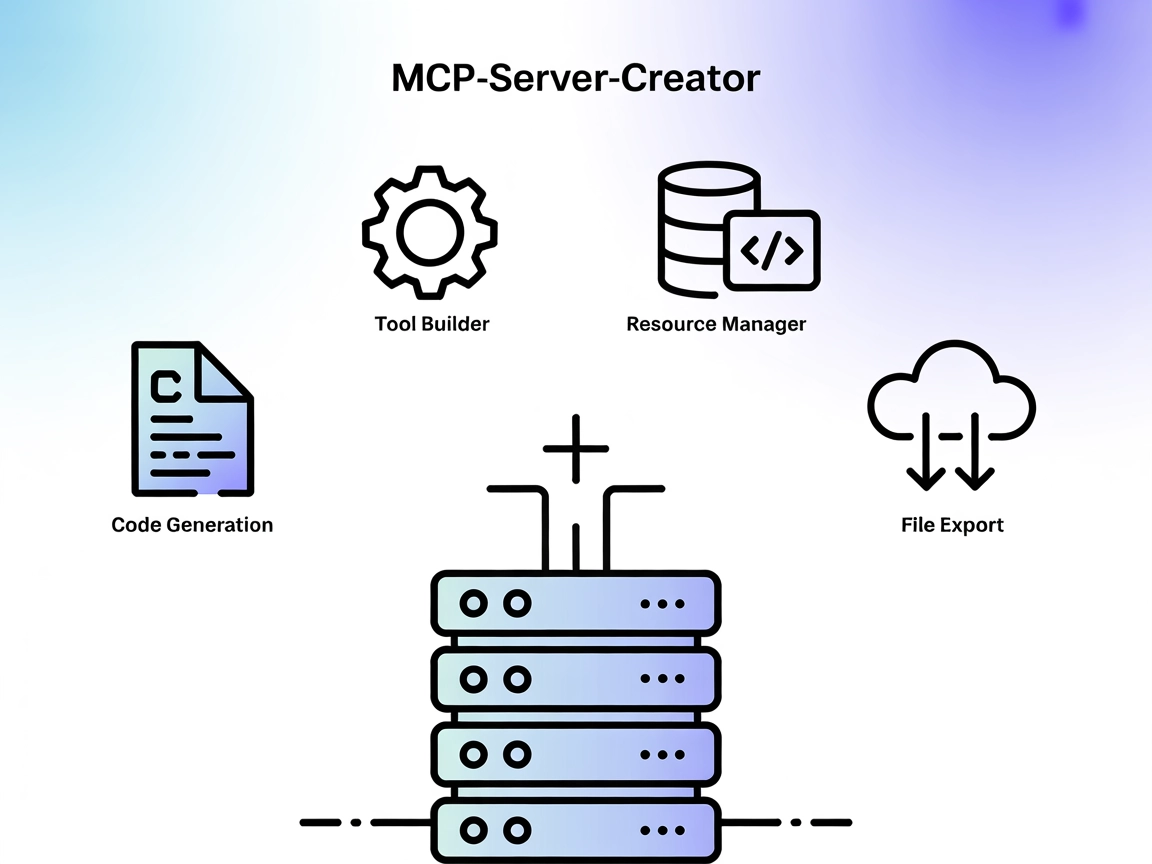

MCP-Server-Creator er en meta-server som muliggjør rask opprettelse og konfigurasjon av nye Model Context Protocol (MCP)-servere. Med dynamisk kodegenerering, v...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.