Model bazowy

Model bazowy AI to wielkoskalowy model uczenia maszynowego trenowany na ogromnych ilościach danych, który można dostosować do szerokiej gamy zadań. Modele bazow...

Kompleksowy przewodnik po bezpiecznej integracji platform AI z bazą danych przy użyciu bram API, szyfrowania, kontroli dostępu i strategii monitorowania.

Kluczowe praktyki bezpieczeństwa przy udostępnianiu baz danych AI:

Bezpieczne udostępnianie bazy danych oznacza umożliwienie systemom AI dostępu do wymaganych danych przy zachowaniu ścisłej kontroli nad tym, jakie dane są udostępniane, kto (lub co) uzyskuje dostęp, kiedy dostęp jest realizowany oraz jak dostęp ten jest monitorowany i rejestrowany. Zasadniczo różni się to od prostego otwarcia bazy na internet lub przekazania platformom AI bezpośrednich poświadczeń do bazy.

Mówiąc o udostępnianiu bazy AI, opisujemy świadomą decyzję architektoniczną o stworzeniu kontrolowanego interfejsu między Twoimi danymi a zewnętrznymi systemami AI. Interfejs ten działa jak punkt kontrolny bezpieczeństwa, wymuszając uwierzytelnianie, autoryzację, szyfrowanie i logowanie audytowe na każdym etapie. Celem jest stworzenie tzw. “pojedynczego punktu kontroli”—scentralizowanego miejsca, gdzie cały dostęp można monitorować, kontrolować i weryfikować.

Wyzwanie polega na tym, że platformy AI często wymagają szerokiego dostępu do różnorodnych zestawów danych, by działać efektywnie. Model uczenia maszynowego może potrzebować analizy wzorców zachowań klientów, historii transakcji i informacji o produktach jednocześnie. System generatywny AI może wyszukiwać w wielu tabelach, by odpowiedzieć na złożone pytania. Jednak udzielenie takiego dostępu bez odpowiednich zabezpieczeń naraża organizację na wycieki danych, naruszenie zgodności i zagrożenia wewnętrzne.

Biznesowe uzasadnienie dla bezpiecznego udostępniania baz AI jest silne. Organizacje, które skutecznie integrują AI z infrastrukturą danych, zyskują znaczącą przewagę konkurencyjną: szybsze podejmowanie decyzji, automatyczne wnioski, lepszą obsługę klienta i wyższą efektywność operacyjną. Ryzyka są jednak równie wysokie.

Wyciek danych wynikający z nieodpowiednio zabezpieczonych baz staje się coraz częstszy i kosztowny. Średni koszt naruszenia danych w 2024 roku przekroczył 4,45 mln USD, a incydenty związane z bazami stanowią znaczną część tych strat. Gdy wyciek obejmuje dane osobowe objęte regulacjami jak RODO czy CCPA, szkody finansowe i reputacyjne rosną dramatycznie. Poza kosztami bezpośrednimi, organizacje doświadczają zakłóceń operacyjnych, utraty zaufania klientów i potencjalnej odpowiedzialności prawnej.

Wyzwanie rośnie, gdy w grę wchodzą systemy AI. Modele AI mogą przypadkowo zapamiętywać czułe dane treningowe, które można odzyskać przez ataki prompt injection lub techniki ekstrakcji modelu. Agenci AI z dostępem do bazy mogą zostać zmanipulowani przez spreparowane prompt’y do wykonania niezamierzonych zapytań lub ujawnienia poufnych informacji. Te nowe wektory ataku wymagają podejść wykraczających poza tradycyjną ochronę baz.

Dodatkowo regulacje dotyczące AI szybko się zaostrzają. Organy ochrony danych na całym świecie wydają wytyczne, jak należy postępować z danymi osobowymi w systemach AI. Zgodność z RODO, CCPA, HIPAA i nowymi przepisami AI wymaga wykazania wdrożenia odpowiednich zabezpieczeń jeszcze przed udostępnieniem jakichkolwiek danych platformom AI.

Przed wdrożeniem strategii udostępniania bazy AI musisz dokładnie poznać swoją infrastrukturę bezpieczeństwa i krajobraz danych. Ocena powinna odpowiedzieć na kilka kluczowych pytań:

Jakie dane rzeczywiście posiadasz? Przeprowadź inwentaryzację i klasyfikację danych. Skategoryzuj dane według poziomu wrażliwości: publiczne, wewnętrzne, poufne, zastrzeżone. Zidentyfikuj dane zawierające informacje osobowe (PII), karty płatnicze (PCI), dane zdrowotne (PHI) lub inne regulowane typy danych. Ta klasyfikacja stanowi podstawę dalszych decyzji.

Jakie masz obecnie zabezpieczenia? Udokumentuj istniejące środki ochrony bazy: mechanizmy uwierzytelniania, status szyfrowania (w tranzycie i spoczynku), segmentację sieci, procedury backupu i odtwarzania, możliwości logowania audytowego. Wskaż luki, gdzie brakuje zabezpieczeń lub są one przestarzałe.

Jakie masz obowiązki prawne? Przejrzyj obowiązujące regulacje branżowe i lokalne. Przetwarzając dane osobowe, najpewniej musisz być zgodny z RODO. W branży medycznej obowiązują wymogi HIPAA. Instytucje finansowe muszą uwzględnić PCI-DSS. Zrozumienie tych wymagań kształtuje architekturę bezpieczeństwa.

Jaki jest Twój apetyt na ryzyko? Różne organizacje mają różną tolerancję ryzyka. Placówka medyczna z danymi pacjentów akceptuje mniej ryzyka niż SaaS analizujący zanonimizowane metryki. Tolerancja ryzyka powinna wpływać na restrykcyjność kontroli dostępu.

Najważniejsza decyzja architektoniczna: nigdy nie udostępniaj bazy bezpośrednio platformom AI. Zamiast tego wdroż bezpieczną bramę API pomiędzy bazą a systemami zewnętrznymi. Brama staje się centralnym punktem kontroli dla całego dostępu do bazy.

Brama API spełnia kilka kluczowych funkcji. Po pierwsze, zapewnia warstwę abstrakcji oddzielającą platformę AI od schematu bazy. Jeśli struktura bazy się zmienia, aktualizujesz tylko API, nie każdą platformę osobno. Po drugie, umożliwia wdrożenie spójnych polityk bezpieczeństwa dla wszystkich żądań. Po trzecie, tworzy scentralizowane miejsce monitoringu, logowania i alertowania o podejrzanych działaniach.

Wybierając lub budując bramę API, szukaj rozwiązań obsługujących identity-aware proxy (IAP). Brama IAP uwierzytelnia każde żądanie przed dotarciem do bazy, zapewniając, że tylko autoryzowane systemy mają dostęp. Powinna wspierać różnorodne mechanizmy uwierzytelniania: OAuth 2.0, tokeny JWT, wzajemny TLS (mTLS), klucze API. Brama powinna także wymuszać ograniczanie liczby żądań i walidować zapytania, blokując nieprawidłowe lub podejrzane żądania.

Popularne opcje to rozwiązania chmurowe jak AWS API Gateway z integracją IAM, Identity-Aware Proxy Google Cloud, Azure API Management czy wyspecjalizowane systemy jak Hoop lub DreamFactory. Każde ma swoje zalety, lecz wszystkie opierają się na kontrolowanej warstwie dostępowej.

Po wdrożeniu bramy API kolejną warstwą są silne mechanizmy uwierzytelniania i autoryzacji. Te dwa pojęcia są często mylone, lecz mają odmienne cele: uwierzytelnianie potwierdza tożsamość żądającego, autoryzacja określa, do czego dana jednostka ma dostęp.

Dla użytkowników korzystających z systemów AI z dostępem do bazy wdrażaj uwierzytelnianie wieloskładnikowe (MFA). Łączy ono coś, co znasz (hasło), coś, co masz (telefon lub token sprzętowy) i coś, czym jesteś (dane biometryczne). MFA znacząco zmniejsza ryzyko przejęcia konta, które jest częstym źródłem naruszeń danych.

Dla systemów AI i kont serwisowych stosuj silne, automatycznie rotowane poświadczenia. Nigdy nie hardkoduj poświadczeń w kodzie czy plikach konfiguracyjnych. Używaj zmiennych środowiskowych, menedżerów tajemnic (np. HashiCorp Vault, AWS Secrets Manager, Azure Key Vault) lub natywnych chmurowych systemów rotacji poświadczeń.

Stosuj uwierzytelnianie certyfikatowe, gdzie to możliwe. Wzajemne TLS (mTLS), gdzie zarówno klient, jak i serwer uwierzytelniają się certyfikatami, daje większe bezpieczeństwo niż hasła. Każda platforma AI lub usługa otrzymuje unikalny certyfikat wymagany do dostępu do bramy API.

Najczęściej stosowanym modelem jest kontrola dostępu oparta na rolach (RBAC). Definiujesz role (np. “AI_Analytics_Reader” lub “ML_Training_Agent”) i przypisujesz im uprawnienia. Każdemu systemowi AI przypisujesz role, które determinują możliwe akcje. RBAC jest prosty do wdrożenia i zrozumienia.

Kontrola oparta na atrybutach (ABAC) jest bardziej zaawansowana i elastyczna. Zamiast ról, tworzysz polityki w oparciu o atrybuty żądania: dział użytkownika, poziom klasyfikacji danych, porę dnia, lokalizację geograficzną, cel dostępu i inne. ABAC pozwala na bardziej szczegółową kontrolę, lecz wymaga przemyślanego projektowania polityk.

Stosuj zasadę najmniejszych uprawnień: nadaj systemowi AI tylko minimalne konieczne uprawnienia. Jeśli system AI potrzebuje tylko odczytu nazw klientów i e-maili, nie dawaj mu dostępu do płatności czy numerów PESEL. Jeśli wystarczy odczyt, nie przydzielaj praw do zapisu czy usuwania.

Nawet przy silnym uwierzytelnianiu i autoryzacji należy zabezpieczyć same dane. Służą temu dwie strategie: szyfrowanie i maskowanie danych.

Szyfrowanie w tranzycie chroni dane przemieszczające się między bazą a platformą AI. Stosuj TLS 1.2 lub nowszy dla wszystkich połączeń. Gwarantuje to, że nawet przechwycony ruch jest nieczytelny bez kluczy szyfrujących. Większość nowoczesnych bram API i baz danych obsługuje TLS domyślnie, lecz warto to sprawdzić i poprawnie skonfigurować.

Szyfrowanie w spoczynku zabezpiecza dane w bazie. Nawet jeśli napastnik uzyska dostęp do plików bazy lub backupów, nie odczyta danych bez kluczy. Współczesne bazy oferują transparentne szyfrowanie danych (TDE) lub podobne funkcje. Włącz je i dbaj o bezpieczne zarządzanie kluczami.

Zarządzanie kluczami jest krytyczne. Nigdy nie przechowuj kluczy razem z zaszyfrowanymi danymi. Używaj dedykowanego systemu zarządzania kluczami (KMS), który oddziela dostęp do kluczy od bazy. Regularnie rotuj klucze—przynajmniej raz w roku, częściej dla bardzo wrażliwych danych. Stosuj wersjonowanie kluczy, by stare klucze były dostępne do odszyfrowania danych historycznych.

Maskowanie danych polega na zastępowaniu wrażliwych wartości danymi zamazanymi lub syntetycznymi. Przykładowo, numer PESEL klienta można zamaskować jako “XXX-XX-1234”, pokazując tylko cztery ostatnie cyfry. Numer karty płatniczej zamaskować jako “--****-4567”. Dzięki temu systemy AI pracują na danych o tej samej strukturze, lecz bez ujawniania wartości wrażliwych.

Dynamiczne maskowanie danych stosuje reguły maskowania w czasie wykonywania zapytań, w zależności od roli użytkownika i wrażliwości danych. Pracownik obsługi klienta zobaczy pełne dane, a system analityczny AI tylko zamaskowane. To bardziej elastyczne niż maskowanie statyczne, bo umożliwia różne reguły dla różnych użytkowników.

Stosuj maskowanie na poziomie kolumn dla najbardziej wrażliwych danych. Zidentyfikuj kolumny z danymi osobowymi, płatniczymi, zdrowotnymi i wdrażaj na nich reguły maskowania. Wiele baz obsługuje to natywnie lub można wdrożyć w warstwie API.

Przyjrzyjmy się praktycznemu zastosowaniu RBAC. Wyobraź sobie bazę z informacjami o klientach, historią transakcji i danymi o produktach. Chcesz udostępnić bazę trzem systemom AI: silnikowi rekomendacji, systemowi wykrywania oszustw i platformie analitycznej.

| System AI | Wymagany dostęp | Zalecana rola | Konkretnie uprawnienia |

|---|---|---|---|

| Silnik rekomendacji | Profile klientów, historia zakupów | AI_RECOMMENDATIONS_READER | SELECT na tabelach customers, orders, products; brak dostępu do płatności i danych kontaktowych |

| System wykrywania oszustw | Szczegóły transakcji, historia klientów | AI_FRAUD_DETECTOR | SELECT na transactions, customers, accounts; dostęp do płatności bez danych kontaktowych |

| Platforma analityczna | Zagregowane dane klientów | AI_ANALYTICS_READER | SELECT tylko na widokach zagregowanych; brak dostępu do pojedynczych rekordów i szczegółów transakcji |

Każda rola ma konkretne uprawnienia ograniczające dostęp i możliwe operacje. Silnik rekomendacji nie widzi płatności, bo ich nie potrzebuje. System wykrywania oszustw widzi transakcje, ale nie ma e-maili klientów. Platforma analityczna ogląda tylko dane zagregowane, nie pojedyncze rekordy.

Dzięki temu, nawet jeśli jeden system AI zostanie przejęty, atakujący uzyskuje dostęp tylko do danych niezbędnych temu systemowi. Ogranicza to skalę zagrożenia.

Nawet przy silnych zabezpieczeniach konieczne jest wykrywanie i reagowanie na incydenty. Służy temu kompleksowy monitoring, szczegółowy audyt i automatyczne wykrywanie zagrożeń.

Włącz szczegółowe logowanie audytu dla całego dostępu do bazy. Każde zapytanie systemu AI powinno być rejestrowane, w tym:

Przechowuj logi audytu w bezpiecznej, niezmiennej lokalizacji, oddzielonej od bazy. Dostawcy chmurowi oferują usługi zarządzania logami (AWS CloudTrail, Google Cloud Logging, Azure Monitor). Przechowuj logi minimum rok, dla bardzo wrażliwych danych dłużej.

Wdroż monitoring wykrywający podejrzane wzorce zapytań do bazy. Ustaw alerty na:

Nowoczesne narzędzia monitorujące potrafią automatycznie analizować i wykrywać anomalie. Narzędzia jak Imperva, Satori i inne wykorzystują AI do wykrywania zagrożeń i alertowania o odchyleniach od normy.

Opracuj plan reakcji na incydenty dotyczące bezpieczeństwa baz z udziałem AI. Plan powinien obejmować:

Dla firm z dużymi, różnorodnymi zbiorami danych warto rozważyć segmentację, by ograniczyć ekspozycję. Można to zrobić na kilka sposobów:

Segmentacja sieciowa: Umieść bazę na osobnym segmencie sieci z ograniczonym dostępem. Tylko brama API może łączyć się z bazą bezpośrednio. Platformy AI mają dostęp tylko przez bramę, nigdy bezpośredni.

Segmentacja baz danych: Jeśli baza zawiera dane wrażliwe i niewrażliwe, przechowuj je w osobnych bazach. Dzięki temu, jeśli system AI potrzebuje tylko danych niewrażliwych, dostaje dostęp tylko do tej bazy.

Sharding danych: Dla bardzo dużych zbiorów podziel dane na mniejsze części (shardy) według kryteriów (np. ID klienta, region). Systemy AI uzyskują dostęp tylko do wybranych shardów.

Dane syntetyczne: Do testów i rozwoju używaj danych syntetycznych, które odzwierciedlają strukturę i rozkład prawdziwych danych, ale nie są wrażliwe. Pozwala to trenować i testować AI bez udostępniania realnych danych.

Udostępnianie bazy platformom AI niesie poważne konsekwencje prawne. Różne regulacje nakładają różne wymagania:

RODO (General Data Protection Regulation): Jeśli przetwarzasz dane osobowe mieszkańców UE, musisz:

CCPA (California Consumer Privacy Act): Przetwarzając dane mieszkańców Kalifornii, musisz:

HIPAA (Health Insurance Portability and Accountability Act): Obejmuje dane zdrowotne i wymaga:

Standardy branżowe: W zależności od branży mogą obowiązywać:

Przed udostępnieniem danych AI przeprowadź ocenę zgodności i sprawdź, które regulacje Cię obowiązują i jakie wymagania nakładają.

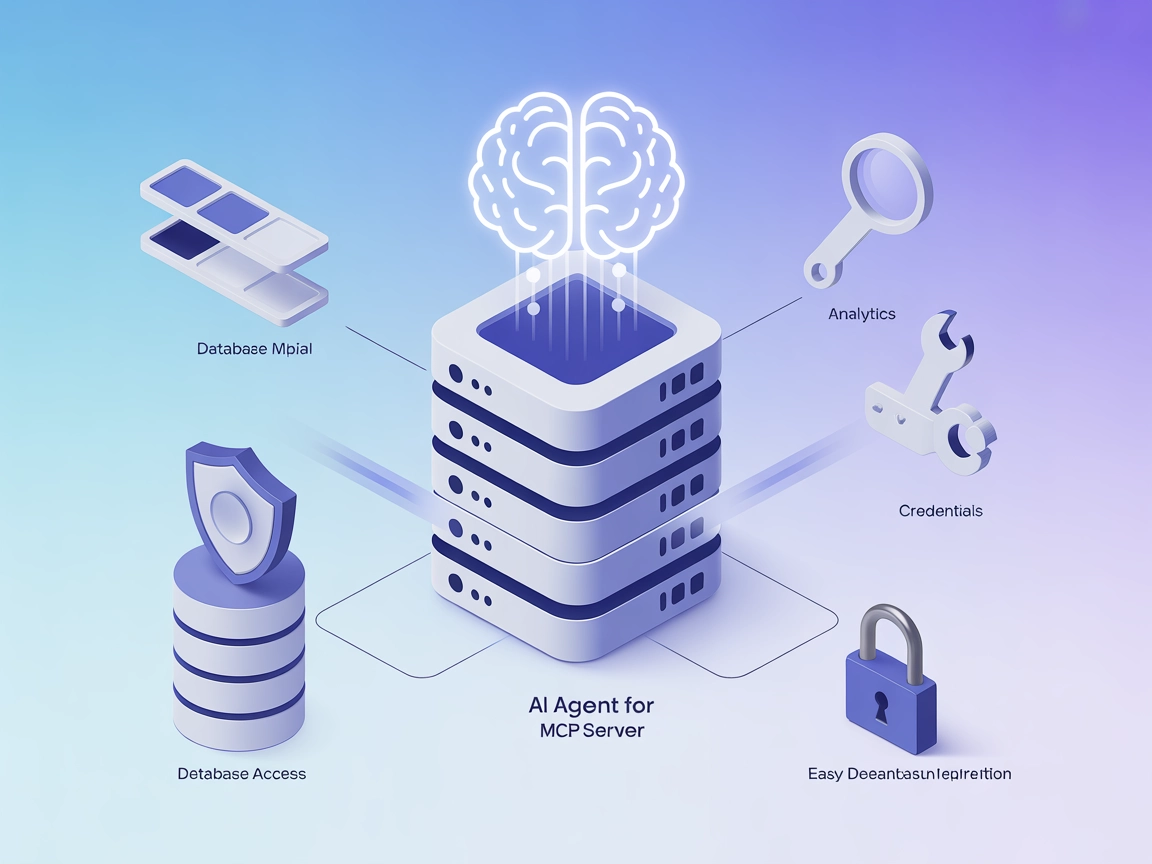

Zarządzanie bezpiecznym dostępem AI do baz danych wymaga koordynacji wielu systemów i egzekwowania spójnych polityk w całej organizacji. Tu nieocenione stają się platformy automatyzacji przepływów jak FlowHunt.

FlowHunt umożliwia budowę automatycznych przepływów bezpiecznie integrujących AI z infrastrukturą baz danych. Zamiast ręcznego zarządzania kluczami API, monitorowania dostępu i koordynacji zespołów, FlowHunt oferuje zunifikowaną platformę dla:

Orkiestracji przepływów: Definiuj złożone przepływy obejmujące zapytania do bazy, przetwarzanie AI i transformacje danych. FlowHunt zarządza kolejnością i bezpieczeństwem każdego kroku.

Integracji kontroli dostępu: FlowHunt integruje się z systemami zarządzania tożsamością, automatycznie egzekwując RBAC i zasadę najmniejszych uprawnień w całym przepływie AI.

Audytu i zgodności: FlowHunt prowadzi szczegółowe logi audytu wszystkich przepływów, w tym jakie dane, kiedy i przez kogo były dostępne. Logi wspierają zgodność z RODO, CCPA, HIPAA i innymi regulacjami.

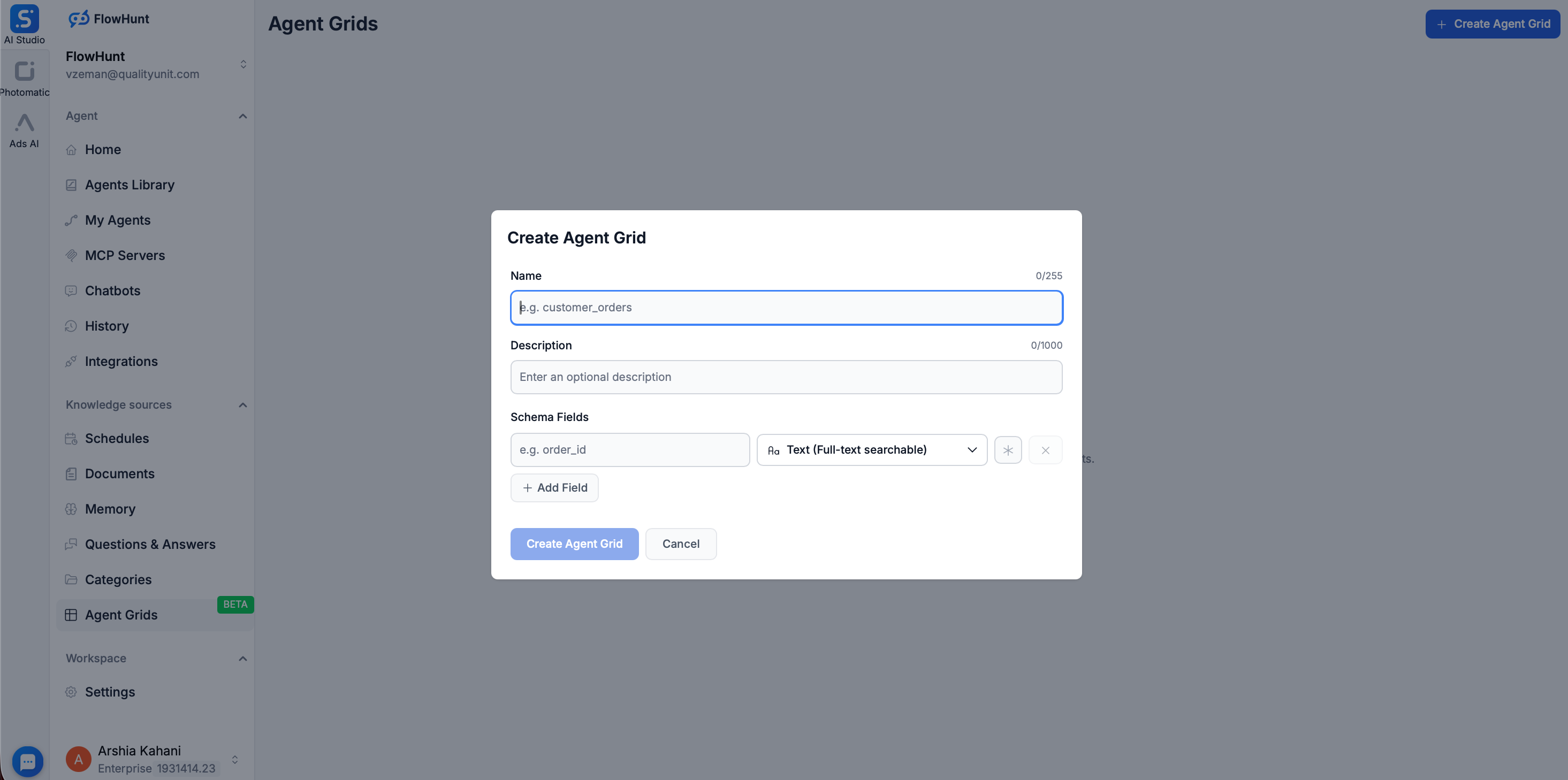

Dla organizacji poszukujących dodatkowej izolacji między modelami AI a bazami produkcyjnymi, FlowHunt oferuje funkcję Grid. Grid pozwala stworzyć przeszukiwalną bazę po prostu przez załadowanie plików np. CSV.

Po załadowaniu CSV do Grid, FlowHunt używa Elasticsearch do indeksowania danych, zmieniając statyczny plik w dynamiczne, szybkie Źródło Wiedzy. To podejście daje istotne korzyści bezpieczeństwa:

Korzystając z Grid i orkiestracji FlowHunt, redukujesz złożoność utrzymania kontroli bezpieczeństwa i zapewniasz spójność polityk w całej organizacji.

Wdrażanie bezpiecznego udostępniania bazy AI to proces wieloetapowy. Oto praktyczny plan działania:

Krok 1: Oceń stan obecny

Krok 2: Zaprojektuj architekturę

Krok 3: Wdróż kluczowe zabezpieczenia

Krok 4: Wdróż ochronę danych

Krok 5: Wdróż monitoring i audyt

Krok 6: Testuj i waliduj

Krok 7: Utrzymuj i doskonal

Wdrażając bezpieczne udostępnianie bazy, unikaj tych błędów:

Bezpośrednie udostępnienie bazy: Nigdy nie udostępniaj bazy bezpośrednio internetowi czy AI bez bramy API. To największe ryzyko.

Zbyt szerokie uprawnienia: Nadawanie AI uprawnień szerszych niż wymagane łamie zasadę najmniejszych uprawnień. Zacznij od minimum, rozszerzaj tylko jeśli to konieczne.

Brak pełnego szyfrowania: Szyfrowanie tylko w tranzycie lub tylko w spoczynku zostawia dane podatne na atak. Szyfruj oba aspekty.

Słabe zarządzanie poświadczeniami: Hardkodowanie, trzymanie w repozytoriach, brak rotacji poświadczeń to poważne ryzyko.

Niewystarczający monitoring: Nawet dobre zabezpieczenia bez monitoringu nie dadzą Ci wiedzy o naruszeniach.

Ignorowanie zgodności: Pomijanie wymogów prawnych do czasu incydentu jest kosztowne. Buduj zgodność od początku.

Niewystarczające testy: Wdrażanie zabezpieczeń bez testów oznacza, że mogą nie zadziałać w krytycznej chwili.

Wraz z rozwojem AI pojawiają się nowe wektory ataku. Dwa szczególnie niepokojące to prompt injection i ekstrakcja modelu.

Prompt injection: Atakujący przygotowuje prompt, który zmusza AI do wykonania niezamierzonych działań, np. pominięcia kontroli dostępu i zwrócenia danych, do których nie powinien mieć dostępu. Obrona:

Ekstrakcja modelu: Atakujący stara się wydobyć informacje o danych treningowych lub strukturze modelu AI. Obrona:

Bezpieczne udostępnianie bazy danych platformom AI jest nie tylko możliwe, ale i coraz bardziej konieczne dla organizacji chcących korzystać z możliwości AI przy ochronie najcenniejszych zasobów. Kluczem jest warstwowe podejście łączące silne uwierzytelnianie i autoryzację, szyfrowanie, maskowanie danych, kompleksowy monitoring i regularne testowanie.

Zacznij od podstaw: nigdy nie udostępniaj bazy bezpośrednio, zawsze korzystaj z bramy API, wdrażaj silne uwierzytelnianie i autoryzację oraz szyfruj dane. Następnie dodaj maskowanie, monitoring i kontroli zgodności dostosowane do profilu ryzyka i regulacji.

Pamiętaj, że bezpieczeństwo to nie jednorazowe wdrożenie, ale ciągły proces. Regularnie przeglądaj zabezpieczenia, testuj podatności, monitoruj zagrożenia i aktualizuj podejście wraz z pojawieniem się nowych ryzyk. Traktując bezpieczeństwo bazy jako priorytet ciągły, a nie formalność, możesz bezpiecznie korzystać z AI i chronić dane oraz reputację swojej organizacji.

Experience how FlowHunt automates your AI content and SEO workflows — from research and content generation to publishing and analytics — all in one place.

Tak, jest to bezpieczne, jeśli wdrożysz odpowiednie środki bezpieczeństwa, takie jak bramy API, szyfrowanie, kontrolę dostępu opartą na rolach oraz kompleksowe monitorowanie. Kluczowe jest stosowanie bezpiecznej warstwy pośredniej, a nie bezpośrednie udostępnianie bazy danych.

Stosuj silne, rotowane poświadczenia z wieloskładnikowym uwierzytelnianiem (MFA) dla użytkowników i kont serwisowych. Wdrażaj OAuth, tokeny JWT lub klucze API z rygorystycznym ograniczaniem liczby żądań i białą listą adresów IP dla agentów AI.

Wdroż maskowanie danych, szyfrowanie na poziomie kolumn, kontrolę dostępu opartą na rolach (RBAC) oraz oddziel produkcyjne dane od danych do uczenia AI. Używaj dynamicznego maskowania danych, aby ukryć wrażliwe pola w wynikach zapytań i utrzymuj niezmienne ścieżki audytu.

W zależności od typu danych rozważ RODO, CCPA, HIPAA i inne odpowiednie regulacje. Zapewnij właściwą klasyfikację danych, polityki retencji i mechanizmy zgody przed udostępnieniem jakichkolwiek danych osobowych lub wrażliwych.

Arshia jest Inżynierką Przepływów Pracy AI w FlowHunt. Z wykształceniem informatycznym i pasją do sztucznej inteligencji, specjalizuje się w tworzeniu wydajnych przepływów pracy, które integrują narzędzia AI z codziennymi zadaniami, zwiększając produktywność i kreatywność.

Usprawnij przepływy danych wspierane przez AI, zachowując bezpieczeństwo i zgodność na poziomie korporacyjnym.

Model bazowy AI to wielkoskalowy model uczenia maszynowego trenowany na ogromnych ilościach danych, który można dostosować do szerokiej gamy zadań. Modele bazow...

Zintegruj FlowHunt z OceanBase za pomocą OceanBase MCP Server, aby umożliwić bezpieczną, opartą na AI automatyzację baz danych, analitykę i eksplorację. Pozwól ...

Integruj FlowHunt z dowolną bazą danych kompatybilną z JDBC, korzystając z JDBC Model Context Protocol (MCP) Server. Bezproblemowo łącz LLM-y z bazami danych ta...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.