Zaawansowani Agenci AI: Jak sprawić, by agenci AI skutecznie planowali

Dowiedz się, jak agenci AI wykorzystują planowanie do pokonywania ograniczeń okna kontekstu i poprawy realizacji zadań. Poznaj implementację LangGraph, automaty...

Poznaj 12 czynników budowania solidnych, skalowalnych agentów AI: od konwersji języka naturalnego i własności promptów, po współpracę z ludźmi i projektowanie bezstanowe. Twórz gotowe do produkcji systemy AI dostarczające realną wartość biznesową.

Zanim przejdziemy do czynników, wyjaśnijmy, co rozumiemy przez „agentów AI”. U podstaw są to systemy, które potrafią interpretować polecenia w języku naturalnym, podejmować decyzje w oparciu o kontekst i wykonywać określone działania przez narzędzia lub API — zachowując przy tym spójne, ciągłe interakcje.

Najpotężniejsi agenci łączą zdolności rozumowania modeli językowych z niezawodnością deterministycznego kodu. Osiągnięcie tej równowagi wymaga jednak przemyślanych decyzji projektowych — i właśnie temu służą opisane dalej czynniki.

Umiejętność przekształcania poleceń w języku naturalnym w ustrukturyzowane wywołania narzędzi to sedno funkcjonalności agenta. Pozwala to agentowi zamienić proste polecenie, np. „utwórz link płatności na 750$ dla Terri na lutowe spotkanie AI Tinkerers”, w poprawnie sformatowane wywołanie API.

{

"function": {

"name": "create_payment_link",

"parameters": {

"amount": 750,

"customer": "cust_128934ddasf9",

"product": "prod_8675309",

"price": "prc_09874329fds",

"quantity": 1,

"memo": "Hey Jeff - see below for the payment link for the February AI Tinkerers meetup"

}

}

}

Kluczem do niezawodnego działania jest wykorzystanie deterministycznego kodu do obsługi ustrukturyzowanego wyjścia z modelu językowego. Zawsze waliduj dane wysyłane do API przed wykonaniem, aby unikać błędów, i upewnij się, że Twój LLM zwraca spójne formaty JSON, które można łatwo sparsować.

Twoje prompty to interfejs między aplikacją a modelem językowym — traktuj je jak kod najwyższej klasy. Chociaż frameworki, które abstrakcyjnie zarządzają promptami, mogą wydawać się wygodne, często ukrywają, jak instrukcje są przekazywane do LLM, utrudniając lub uniemożliwiając precyzyjne dostrajanie.

Zamiast tego, zachowaj pełną kontrolę, pisząc prompty wprost:

function DetermineNextStep(thread: string) -> DoneForNow | ListGitTags | DeployBackend | DeployFrontend | RequestMoreInformation {

prompt #"

{{ _.role("system") }}

You are a helpful assistant that manages deployments for frontend and backend systems.

...

{{ _.role("user") }}

{{ thread }}

What should the next step be?

"#

}

Takie podejście daje kilka korzyści:

Okno kontekstu to wejście dla LLM, obejmujące prompty, historię rozmowy i dane zewnętrzne. Optymalizacja tego okna poprawia wydajność i efektywność użycia tokenów.

Wyjdź poza standardowe formaty wiadomości, stosując własne struktury maksymalizujące gęstość informacji:

<slack_message>

From: @alex

Channel: #deployments

Text: Can you deploy the backend?

</slack_message>

<list_git_tags>

intent: "list_git_tags"

</list_git_tags>

<list_git_tags_result>

tags:

- name: "v1.2.3"

commit: "abc123"

date: "2024-03-15T10:00:00Z"

</list_git_tags_result>

Takie podejście zapewnia:

U podstaw narzędzia to po prostu wyjścia JSON z LLM, które wyzwalają deterministyczne działania w Twoim kodzie. Tworzy to wyraźny podział między podejmowaniem decyzji przez AI a logiką wykonawczą.

Jasno zdefiniuj schematy narzędzi:

class CreateIssue {

intent: "create_issue";

issue: {

title: string;

description: string;

team_id: string;

assignee_id: string;

};

}

class SearchIssues {

intent: "search_issues";

query: string;

what_youre_looking_for: string;

}

Następnie zbuduj niezawodne parsowanie wyjść JSON z LLM, wykorzystaj deterministyczny kod do realizacji działań i przekazuj wyniki z powrotem do kontekstu dla iteracyjnej pracy agenta.

Wiele frameworków agentów oddziela stan wykonania (np. aktualny etap procesu) od stanu biznesowego (np. historia wywołań narzędzi i ich wyników). To wprowadza niepotrzebną złożoność.

Zamiast tego przechowuj cały stan bezpośrednio w oknie kontekstu, wyciągając wnioski o stanie wykonania z sekwencji zdarzeń:

<deploy_backend>

intent: "deploy_backend"

tag: "v1.2.3"

environment: "production"

</deploy_backend>

<error>

error running deploy_backend: Failed to connect to deployment service

</error>

To ujednolicone podejście zapewnia:

Agenci produkcyjni muszą integrować się bezproblemowo z systemami zewnętrznymi, pauzować przy długotrwałych zadaniach i wznawiać działanie po wywołaniu webhooków lub innych zdarzeń.

Implementuj API umożliwiające uruchamianie, pauzowanie i wznawianie agentów, z solidnym przechowywaniem stanu między operacjami. Pozwala to na:

Agenci AI często potrzebują wkładu człowieka przy decyzjach o dużym znaczeniu lub w niejasnych sytuacjach. Wykorzystanie ustrukturyzowanych wywołań narzędzi czyni tę interakcję płynną:

class RequestHumanInput {

intent: "request_human_input";

question: string;

context: string;

options: {

urgency: "low" | "medium" | "high";

format: "free_text" | "yes_no" | "multiple_choice";

choices: string[];

};

}

To podejście zapewnia jasną specyfikację typu i pilności interakcji, obsługuje wkład wielu użytkowników i doskonale współpracuje z API przy budowie trwałych przepływów pracy.

Własny przepływ sterowania umożliwia pauzowanie w celu uzyskania akceptacji człowieka, cache’owanie wyników czy wdrożenie ograniczeń — dopasowując zachowanie agenta do Twoich potrzeb:

async function handleNextStep(thread: Thread) {

while (true) {

const nextStep = await determineNextStep(threadToPrompt(thread));

if (nextStep.intent === 'request_clarification') {

await sendMessageToHuman(nextStep);

await db.saveThread(thread);

break;

} else if (nextStep.intent === 'fetch_open_issues') {

const issues = await linearClient.issues();

thread.events.push({ type: 'fetch_open_issues_result', data: issues });

continue;

}

}

}

Zyskujesz w ten sposób:

Włączenie błędów bezpośrednio do okna kontekstu pozwala agentom AI uczyć się na niepowodzeniach i dostosowywać swoje działania:

try {

const result = await handleNextStep(thread, nextStep);

thread.events.push({ type: `${nextStep.intent}_result`, data: result });

} catch (e) {

thread.events.push({ type: 'error', data: formatError(e) });

}

Aby to działało skutecznie:

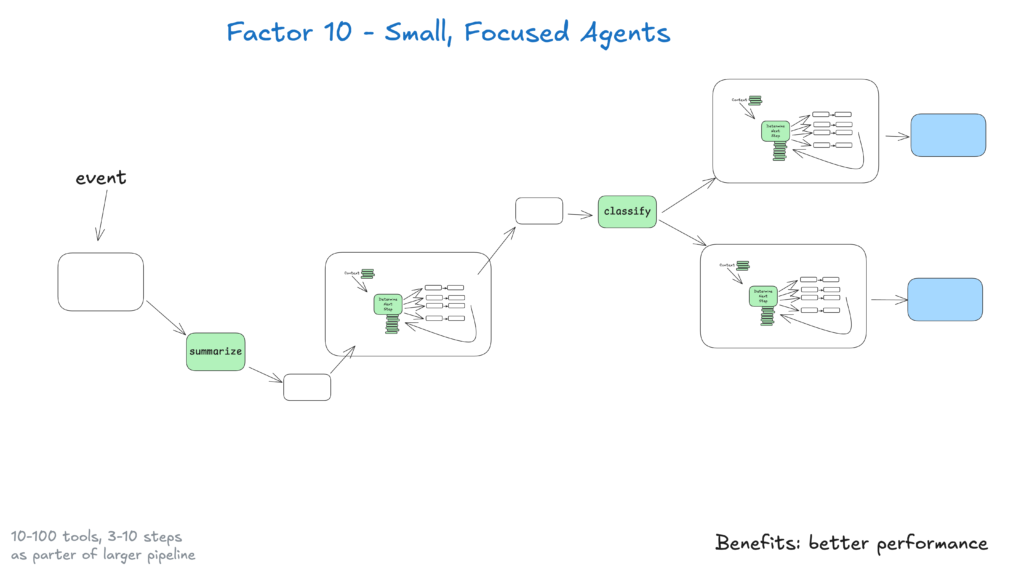

Mali agenci obsługujący 3–20 kroków utrzymują okna kontekstu na rozsądnym poziomie, poprawiając wydajność i niezawodność LLM. Takie podejście zapewnia:

Wraz z rozwojem LLM tacy mali agenci mogą stopniowo rozszerzać zakres działania bez utraty jakości, zapewniając długofalową skalowalność.

Uczyń swoich agentów dostępnymi dzięki wyzwalaniu ich z Slacka, e-maila czy systemów zdarzeniowych — docierając do użytkowników tam, gdzie już pracują.

Implementuj API uruchamiające agentów z różnych kanałów i odpowiadające przez te same media. Dzięki temu:

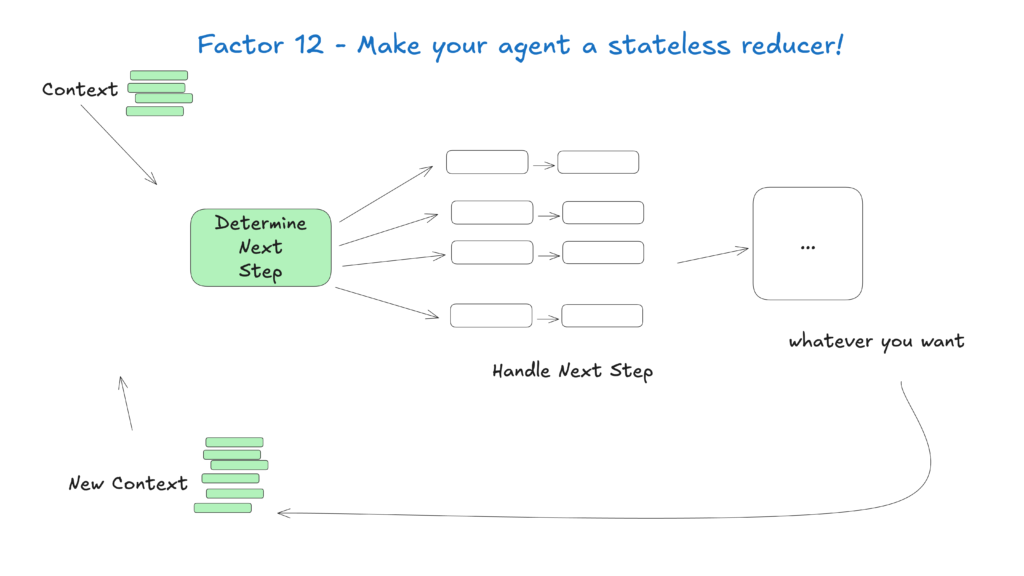

Traktowanie agentów jako bezstanowych funkcji, które przekształcają wejściowy kontekst w wyjściowe działania, upraszcza zarządzanie stanem, czyniąc ich przewidywalnymi i łatwymi do debugowania.

To podejście traktuje agentów jak czyste funkcje bez wewnętrznego stanu, zapewniając:

Dziedzina agentów AI rozwija się niezwykle dynamicznie, ale opisane tu podstawowe zasady pozostaną aktualne nawet wraz z postępem modeli bazowych. Zaczynając od małych, wyspecjalizowanych agentów pracujących zgodnie z tymi praktykami, możesz tworzyć systemy dostarczające wartość już dziś i gotowe na przyszłe innowacje.

Pamiętaj, że najskuteczniejsi agenci AI łączą zdolności rozumowania modeli językowych z niezawodnością deterministycznego kodu — a te 12 czynników pozwala osiągnąć tę równowagę.

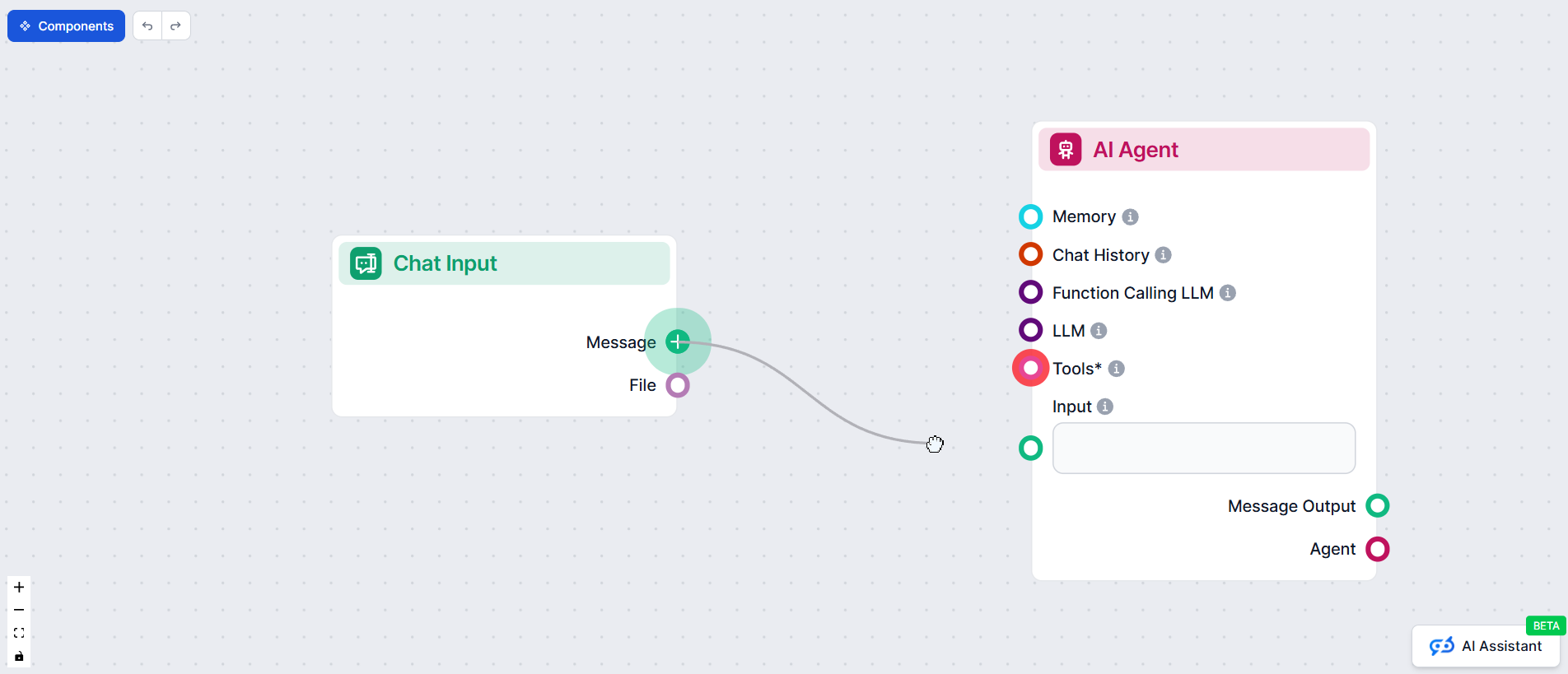

W FlowHunt wcieliliśmy te zasady w praktykę, tworząc własnego agenta AI, który automatycznie buduje automatyzacje workflow dla naszych klientów. Oto, jak zastosowaliśmy metodologię 12 czynników, by stworzyć niezawodny, gotowy do produkcji system

Metodologia 12-czynnikowego Agenta AI to zestaw najlepszych praktyk inspirowanych modelem 12-czynnikowej aplikacji, zaprojektowanych, by pomóc deweloperom budować solidnych, łatwych w utrzymaniu i skalowalnych agentów AI, którzy niezawodnie działają w środowiskach produkcyjnych.

Zarządzanie kontekstem zapewnia, że agenci AI utrzymują istotną historię rozmów, promptów i stanów, optymalizując wydajność, ograniczając zużycie tokenów i poprawiając dokładność podejmowanych decyzji.

Agenci AI FlowHunt strukturyzują wywołania narzędzi w taki sposób, by w razie potrzeby prosić o wkład człowieka, umożliwiając płynną współpracę, zatwierdzanie i trwałe przepływy pracy w złożonych lub kluczowych scenariuszach.

Bezstanowi agenci AI są przewidywalni, łatwiejsi w debugowaniu i prostsi do skalowania, ponieważ przekształcają wejściowy kontekst w wyjściowe działania, nie utrzymując ukrytego wewnętrznego stanu.

Arshia jest Inżynierką Przepływów Pracy AI w FlowHunt. Z wykształceniem informatycznym i pasją do sztucznej inteligencji, specjalizuje się w tworzeniu wydajnych przepływów pracy, które integrują narzędzia AI z codziennymi zadaniami, zwiększając produktywność i kreatywność.

Gotowy, by stworzyć solidnych, gotowych do produkcji agentów AI? Poznaj narzędzia FlowHunt i przekonaj się, jak metodologia 12 czynników może odmienić Twoją automatyzację.

Dowiedz się, jak agenci AI wykorzystują planowanie do pokonywania ograniczeń okna kontekstu i poprawy realizacji zadań. Poznaj implementację LangGraph, automaty...

Kompleksowy przewodnik po najlepszych platformach do budowy agentów AI w 2025 roku, obejmujący FlowHunt.io, OpenAI oraz Google Cloud. Poznaj szczegółowe recenzj...

Poznaj cztery kluczowe cechy definiujące deep agents: narzędzia planowania, subagentów, systemy plików i szczegółowe promptowania systemowe. Dowiedz się, jak no...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.