Prosty serwer Loki MCP

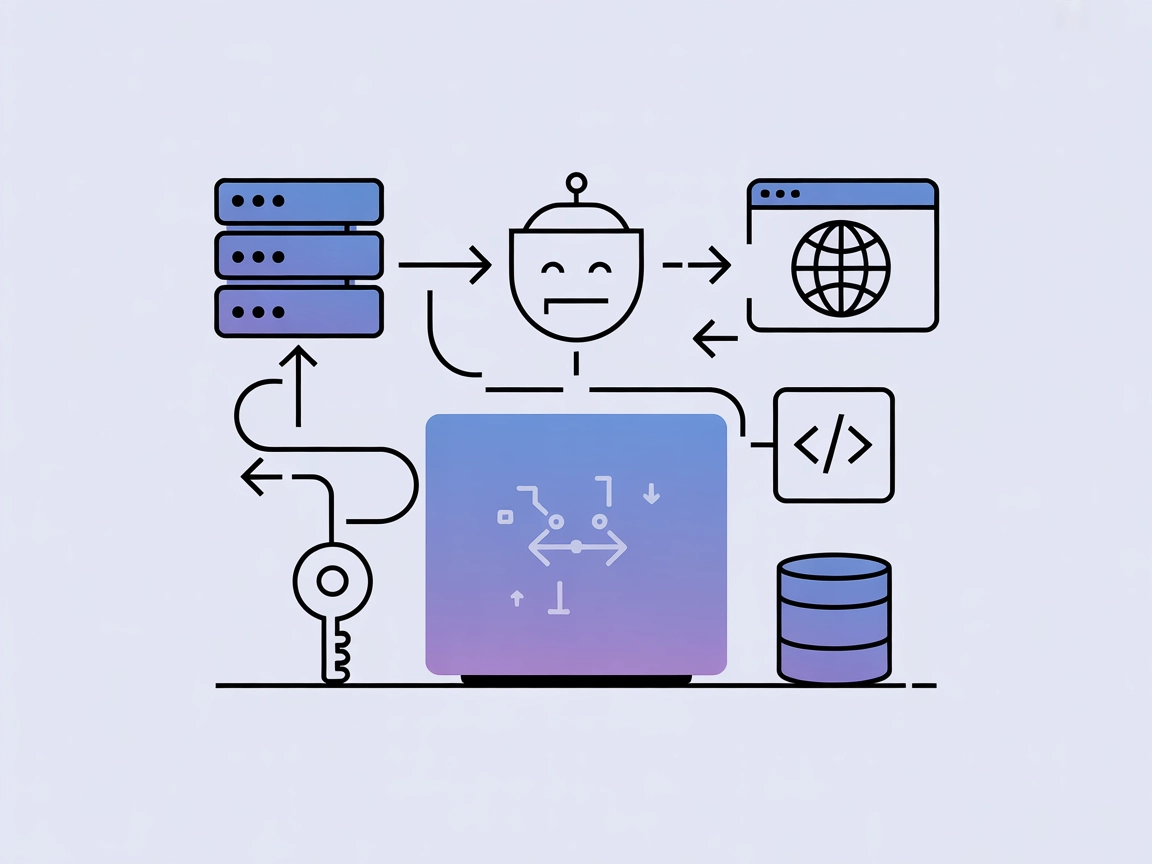

Prosty serwer Loki MCP integruje zapytania do logów Grafana Loki z przepływami AI za pomocą Model Context Protocol. Umożliwia agentom AI analizę, filtrowanie i ...

Zintegruj zapytania do logów Grafana Loki w swoich przepływach AI za pomocą serwera Loki MCP, uzyskując wgląd w czasie rzeczywistym, monitorowanie i automatyzację operacyjną.

FlowHunt zapewnia dodatkową warstwę bezpieczeństwa między Twoimi systemami wewnętrznymi a narzędziami AI, dając Ci szczegółową kontrolę nad tym, które narzędzia są dostępne z Twoich serwerów MCP. Serwery MCP hostowane w naszej infrastrukturze można bezproblemowo zintegrować z chatbotem FlowHunt oraz popularnymi platformami AI, takimi jak ChatGPT, Claude i różne edytory AI.

Loki MCP Server to implementacja Model Context Protocol (MCP) w języku Go, zaprojektowana do integracji z Grafana Loki, systemem agregacji logów. Służy jako pomost między asystentami AI a zewnętrznymi źródłami danych logów, umożliwiając AI zapytania i interakcję ze strumieniami logów przechowywanymi w Loki. Dzięki udostępnieniu możliwości zapytań Loki przez protokół MCP, deweloperzy i klienci AI mogą wzbogacić swoje przepływy pracy — takie jak wyszukiwanie, filtrowanie czy analiza logów — bezpośrednio przez standardowe interfejsy obsługiwane przez LLM. Umożliwia to zadania takie jak analiza logów w czasie rzeczywistym, rozwiązywanie problemów i tworzenie pulpitów, zapewniając płynny dostęp do danych operacyjnych dla lepszej obserwowalności i automatyzacji.

Brak udokumentowanych szablonów promptów w repozytorium.

W repozytorium nie opisano jawnie zasobów MCP.

query: zapytanie LogQLurl: adres URL serwera Loki (domyślnie z LOKI_URL env lub http://localhost:3100)start: czas początkowy zapytania (domyślnie: 1 godzina temu)end: czas końcowy zapytania (domyślnie: teraz)limit: maksymalna liczba zwracanych wpisów (domyślnie: 100)Zainstaluj Go 1.16 lub nowszy.

Zbuduj serwer:go build -o loki-mcp-server ./cmd/server

Edytuj konfigurację Windsurf, aby dodać serwer MCP.

Dodaj serwer Loki MCP za pomocą fragmentu JSON (dostosuj według potrzeb):

{

"mcpServers": {

"loki-mcp": {

"command": "./loki-mcp-server",

"args": []

}

}

}

Zapisz konfigurację i zrestartuj Windsurf.

Zweryfikuj, czy serwer działa i jest dostępny.

Zabezpieczenie kluczy API (przykład przez zmienne środowiskowe):

{

"mcpServers": {

"loki-mcp": {

"command": "./loki-mcp-server",

"env": {

"LOKI_URL": "https://your-loki-server.example"

}

}

}

}

Zainstaluj Go 1.16 lub nowszy.

Zbuduj serwer jak wyżej.

Otwórz plik konfiguracyjny MCP Claude’a.

Dodaj serwer Loki MCP:

{

"mcpServers": {

"loki-mcp": {

"command": "./loki-mcp-server",

"args": []

}

}

}

Zapisz/zrestartuj Claude’a.

Potwierdź poprawność konfiguracji.

Zabezpieczenie kluczy API:

{

"mcpServers": {

"loki-mcp": {

"command": "./loki-mcp-server",

"env": {

"LOKI_URL": "https://your-loki-server.example"

}

}

}

}

Upewnij się, że Go 1.16+ jest zainstalowany.

Zbuduj serwer Loki MCP.

Edytuj konfigurację Cursor.

Dodaj wpis serwera Loki MCP:

{

"mcpServers": {

"loki-mcp": {

"command": "./loki-mcp-server",

"args": []

}

}

}

Zapisz i zrestartuj Cursor.

Zweryfikuj integrację.

Użycie zmiennych środowiskowych:

{

"mcpServers": {

"loki-mcp": {

"command": "./loki-mcp-server",

"env": {

"LOKI_URL": "https://your-loki-server.example"

}

}

}

}

Zainstaluj Go >=1.16.

Zbuduj za pomocą:go build -o loki-mcp-server ./cmd/server

Zlokalizuj konfigurację serwera MCP Cline.

Dodaj serwer Loki MCP:

{

"mcpServers": {

"loki-mcp": {

"command": "./loki-mcp-server",

"args": []

}

}

}

Zapisz i zrestartuj Cline.

Przetestuj konfigurację.

Zabezpiecz klucze API przez env:

{

"mcpServers": {

"loki-mcp": {

"command": "./loki-mcp-server",

"env": {

"LOKI_URL": "https://your-loki-server.example"

}

}

}

}

Użycie MCP w FlowHunt

Aby zintegrować serwery MCP z przepływem FlowHunt, zacznij od dodania komponentu MCP do swojego przepływu i połączenia go z agentem AI:

Kliknij komponent MCP, aby otworzyć panel konfiguracji. W sekcji konfiguracji systemowej MCP wstaw dane swojego serwera MCP w poniższym formacie JSON:

{

"loki-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Po skonfigurowaniu agent AI może korzystać z tego MCP jako narzędzia, mając dostęp do wszystkich jego funkcji i możliwości. Pamiętaj, aby zmienić "loki-mcp" na faktyczną nazwę twojego serwera MCP oraz podmienić adres URL na własny.

| Sekcja | Dostępność | Szczegóły/Uwagi |

|---|---|---|

| Przegląd | ✅ | Podsumowanie dostępne w README.md |

| Lista promptów | ⛔ | Brak udokumentowanych szablonów promptów |

| Lista zasobów | ⛔ | Brak jawnych zasobów MCP |

| Lista narzędzi | ✅ | Narzędzie loki_query opisane w README.md |

| Zabezpieczenie kluczy API | ✅ | Używa zmiennej środowiskowej LOKI_URL |

| Wsparcie dla sampling (mniej istotne) | ⛔ | Brak informacji o wsparciu dla sampling |

Na podstawie powyższych tabel, Loki MCP Server oferuje czytelny przegląd i funkcjonalne narzędzie do zapytań o logi, ale brakuje udokumentowanych promptów, zasobów oraz zaawansowanych funkcji MCP jak sampling czy roots. Dokumentacja jest minimalna, a instalacja skierowana do deweloperów.

Loki MCP Server jest skupiony i funkcjonalny w integracji LLM z zapytaniami do logów Grafana Loki, ale jest minimalistyczny i brakuje mu szerokiego wsparcia dla funkcji MCP oraz dokumentacji. W skali ocen zasługuje na 4/10: spełnia swoje podstawowe zadanie, ale nie jest kompletnym, dopracowanym ani bogato udokumentowanym serwerem MCP.

| Ma LICENSE? | ⛔ |

|---|---|

| Jest przynajmniej jedno narzędzie | ✅ |

| Liczba forków | 1 |

| Liczba gwiazdek | 5 |

Loki MCP Server to serwis oparty na Go, który łączy asystentów AI z Grafana Loki, umożliwiając zapytania i analizę danych logów przez Model Context Protocol (MCP). Umożliwia zaawansowane monitorowanie logów, rozwiązywanie problemów oraz automatyzację pulpitów w ramach przepływów AI.

Udostępnia narzędzie `loki_query`, pozwalające użytkownikom na zapytania do logów w Grafana Loki przy użyciu LogQL, z obsługą parametrów takich jak zapytanie, zakres czasu i limit wyników.

Kluczowe zastosowania to eksploracja danych logów, automatyczne monitorowanie logów, operacyjne pulpity oparte na AI oraz analiza przyczyn źródłowych — wszystko bezpośrednio z przepływów AI.

Ustaw poufne informacje, takie jak adres URL serwera Loki, przez zmienne środowiskowe, np.: `LOKI_URL=https://your-loki-server.example` w konfiguracji serwera MCP.

Nie, obecnie nie obsługuje szablonów promptów, sampling czy zaawansowanych funkcji MCP — jego funkcjonalność skupia się na zapytaniach i analizie logów przez jedno narzędzie.

Dodaj komponent MCP do swojego przepływu FlowHunt, podaj szczegóły połączenia Loki MCP w formacie JSON i połącz go z agentem AI. Umożliwia to bezpośrednie zapytania i analizę logów z przepływów AI.

Połącz AI i dane logów. Wdróż Loki MCP Server, aby zasilić zaawansowaną analizę i monitorowanie logów w swoich przepływach FlowHunt.

Prosty serwer Loki MCP integruje zapytania do logów Grafana Loki z przepływami AI za pomocą Model Context Protocol. Umożliwia agentom AI analizę, filtrowanie i ...

Logfire MCP Server łączy asystentów AI i LLM-y z danymi telemetrycznymi przez OpenTelemetry, umożliwiając zapytania w czasie rzeczywistym, monitorowanie wyjątkó...

AgentQL MCP Server integruje zaawansowane wyciąganie danych z sieci do przepływów pracy AI, umożliwiając płynne pozyskiwanie ustrukturyzowanych danych ze stron ...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.