Serwer MCP Proxy

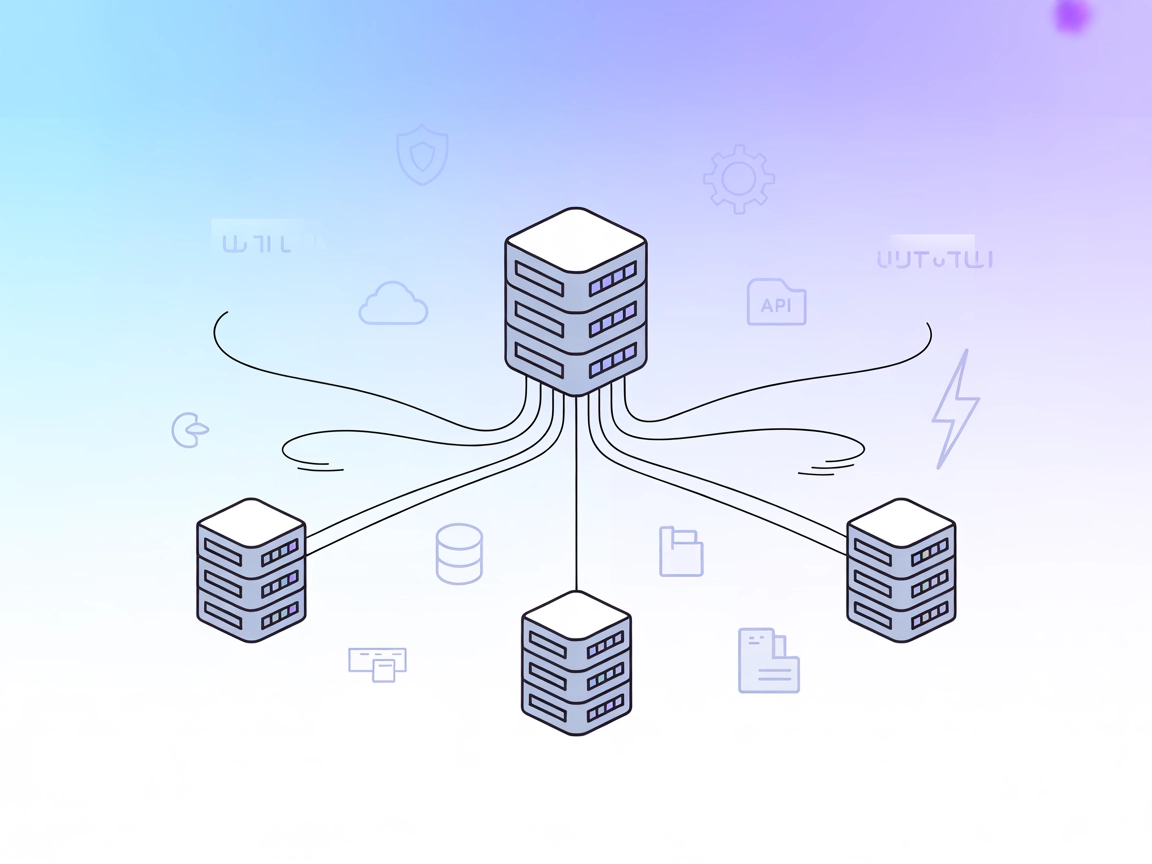

Serwer MCP Proxy agreguje wiele serwerów zasobów MCP w jeden serwer HTTP, usprawniając połączenia dla asystentów AI i deweloperów. Umożliwia zunifikowany dostęp...

Połącz asystentów AI z narzędziami i systemami opartymi na różnych protokołach transportowych MCP za pomocą serwera mcp-proxy MCP dla FlowHunt.

FlowHunt zapewnia dodatkową warstwę bezpieczeństwa między Twoimi systemami wewnętrznymi a narzędziami AI, dając Ci szczegółową kontrolę nad tym, które narzędzia są dostępne z Twoich serwerów MCP. Serwery MCP hostowane w naszej infrastrukturze można bezproblemowo zintegrować z chatbotem FlowHunt oraz popularnymi platformami AI, takimi jak ChatGPT, Claude i różne edytory AI.

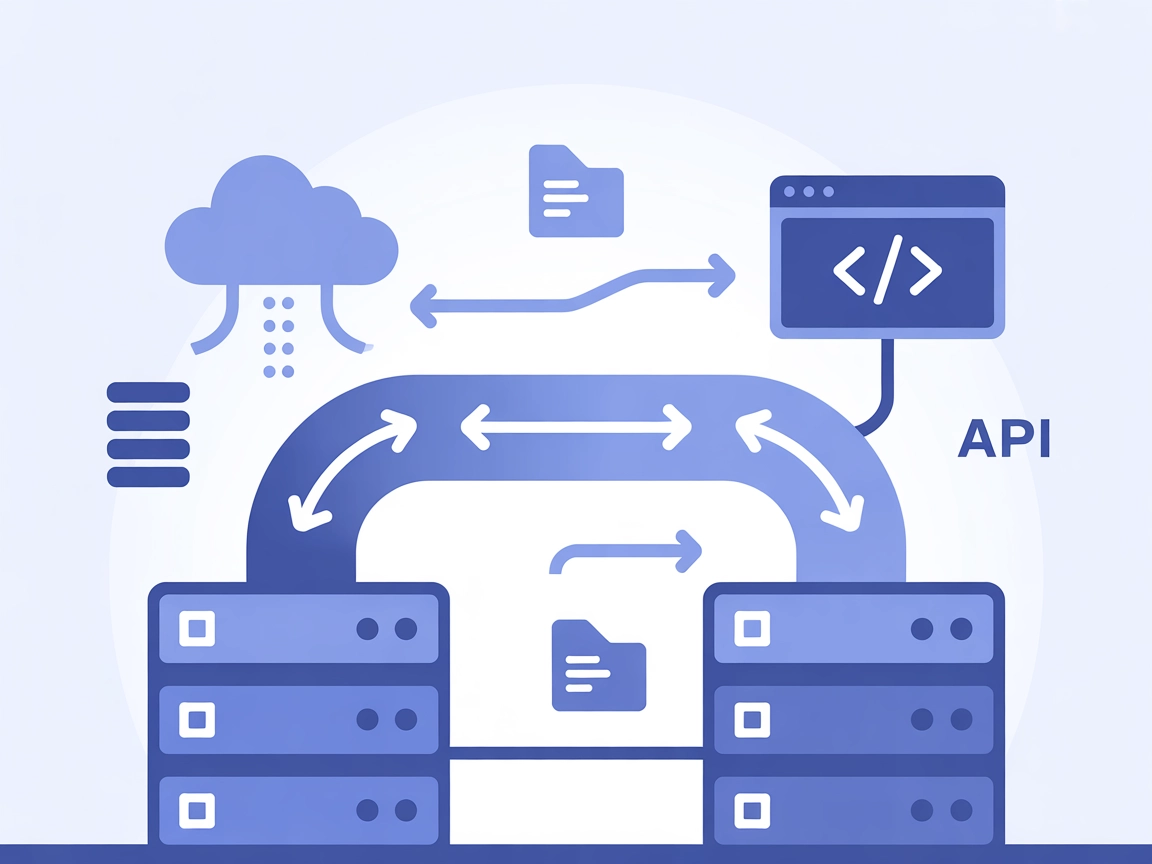

mcp-proxy Serwer MCP działa jako most pomiędzy transportami Streamable HTTP i stdio MCP, umożliwiając płynną komunikację między asystentami AI a różnymi typami serwerów lub klientów Model Context Protocol (MCP). Jego główną funkcją jest tłumaczenie pomiędzy tymi dwoma szeroko stosowanymi protokołami transportowymi, dzięki czemu narzędzia, zasoby i workflowy stworzone dla jednego protokołu mogą być dostępne przez drugi – bez modyfikacji. Usprawnia to procesy rozwojowe, pozwalając asystentom AI na interakcję z zewnętrznymi źródłami danych, API lub usługami, które korzystają z różnych mechanizmów transportowych, umożliwiając m.in. zapytania do baz danych, zarządzanie plikami czy obsługę API w różnych systemach.

W repozytorium nie wymieniono żadnych szablonów promptów.

W dokumentacji repozytorium ani w kodzie nie opisano żadnych wyraźnych zasobów MCP.

W dokumentacji repozytorium ani w widocznym kodzie nie zdefiniowano żadnych narzędzi (np. brak wyraźnych funkcji, narzędzi czy server.py z definicjami narzędzi).

mcp-proxy lub zainstaluj przez PyPI, jeśli jest dostępne.{

"mcpServers": {

"mcp-proxy": {

"command": "mcp-proxy",

"args": []

}

}

}

{

"mcpServers": {

"mcp-proxy": {

"command": "mcp-proxy",

"args": []

}

}

}

{

"mcpServers": {

"mcp-proxy": {

"command": "mcp-proxy",

"args": []

}

}

}

{

"mcpServers": {

"mcp-proxy": {

"command": "mcp-proxy",

"args": []

}

}

}

Zabezpieczanie kluczy API

Możesz zabezpieczyć zmienne środowiskowe (np. klucze API) korzystając z env w konfiguracji:

{

"mcpServers": {

"mcp-proxy": {

"command": "mcp-proxy",

"args": [],

"env": {

"API_KEY": "${API_KEY}"

},

"inputs": {

"api_key": "${API_KEY}"

}

}

}

}

Korzystanie z MCP w FlowHunt

Aby zintegrować serwery MCP w swoim workflowie FlowHunt, zacznij od dodania komponentu MCP do swojego flow i połącz go z agentem AI:

Kliknij komponent MCP, aby otworzyć panel konfiguracji. W sekcji systemowej konfiguracji MCP wklej szczegóły serwera MCP w tym formacie JSON:

{

"mcp-proxy": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Po konfiguracji agent AI może używać tego MCP jako narzędzia, uzyskując dostęp do wszystkich jego funkcji i możliwości. Pamiętaj, aby zmienić “mcp-proxy” na faktyczną nazwę Twojego serwera MCP i podać własny adres URL serwera MCP.

| Sekcja | Dostępność | Szczegóły/Uwagi |

|---|---|---|

| Podsumowanie | ✅ | |

| Lista promptów | ⛔ | Brak znalezionych |

| Lista zasobów | ⛔ | Brak znalezionych |

| Lista narzędzi | ⛔ | Brak zdefiniowanych narzędzi |

| Zabezpieczanie kluczy API | ✅ | Przez env w konfiguracji |

| Sampling Support (mniej istotne w ocenie) | ⛔ | Brak wzmianki |

| Roots Support | ⛔ | Brak wzmianki |

Na podstawie powyższego, mcp-proxy jest wysoce wyspecjalizowanym rozwiązaniem do tłumaczenia protokołów, ale nie dostarcza narzędzi, promptów ani zasobów w standardzie. Jego wartość leży w integracji i łączności, a nie w bezpośrednich funkcjach LLM.

mcp-proxy to kluczowe narzędzie do mostkowania protokołów transportowych MCP, niezwykle cenne tam, gdzie niedopasowanie protokołów ogranicza interoperacyjność narzędzi AI/LLM. Nie dostarcza jednak bezpośrednich rozszerzeń LLM, takich jak zasoby, prompty czy narzędzia. W swoim docelowym zastosowaniu to solidny, dobrze wspierany projekt. Ocena: 6/10 jako ogólna użyteczność MCP, 9/10, jeśli potrzebujesz mostkowania protokołów.

| Ma LICENSE | ✅ (MIT) |

|---|---|

| Ma przynajmniej jedno narzędzie | ⛔ |

| Liczba forków | 128 |

| Liczba gwiazdek | 1.1k |

Serwer mcp-proxy MCP łączy Streamable HTTP i stdio MCP transports, umożliwiając płynną komunikację między asystentami AI a różnymi serwerami lub klientami MCP. Pozwala to na współpracę workflowów i narzędzi opartych o różne protokoły bez konieczności ich modyfikacji.

mcp-proxy jest idealny do łączenia różnych protokołów MCP, integracji systemów legacy z nowoczesnymi platformami AI, zwiększania łączności workflowów AI oraz wsparcia międzyplatformowego rozwoju i testowania.

Nie, mcp-proxy koncentruje się wyłącznie na tłumaczeniu protokołów i nie zawiera wbudowanych narzędzi, szablonów promptów ani zasobów. Jego wartość leży w umożliwieniu interoperacyjności i integracji.

Możesz użyć zmiennych środowiskowych w konfiguracji serwera MCP, aby zabezpieczyć klucze API. Na przykład użyj bloku 'env' i odwołaj się do zmiennych w konfiguracji JSON.

Dodaj komponent MCP do swojego flow w FlowHunt, a następnie skonfiguruj serwer mcp-proxy MCP w systemowej konfiguracji MCP przy użyciu odpowiedniego fragmentu JSON. Dzięki temu Twój agent AI zyska dostęp do wszystkich możliwości udostępnianych przez połączone protokoły MCP.

Zlikwiduj luki w swoim workflowie AI i zapewnij płynną interoperacyjność protokołów dzięki mcp-proxy. Integruj systemy legacy i natychmiast poszerz zasięg swojego AI.

Serwer MCP Proxy agreguje wiele serwerów zasobów MCP w jeden serwer HTTP, usprawniając połączenia dla asystentów AI i deweloperów. Umożliwia zunifikowany dostęp...

Serwer Model Context Protocol (MCP) łączy asystentów AI z zewnętrznymi źródłami danych, API i usługami, umożliwiając płynną integrację złożonych przepływów prac...

Serwer ModelContextProtocol (MCP) działa jako most między agentami AI a zewnętrznymi źródłami danych, API i usługami, umożliwiając użytkownikom FlowHunt budowan...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.