Integracja serwera ModelContextProtocol (MCP)

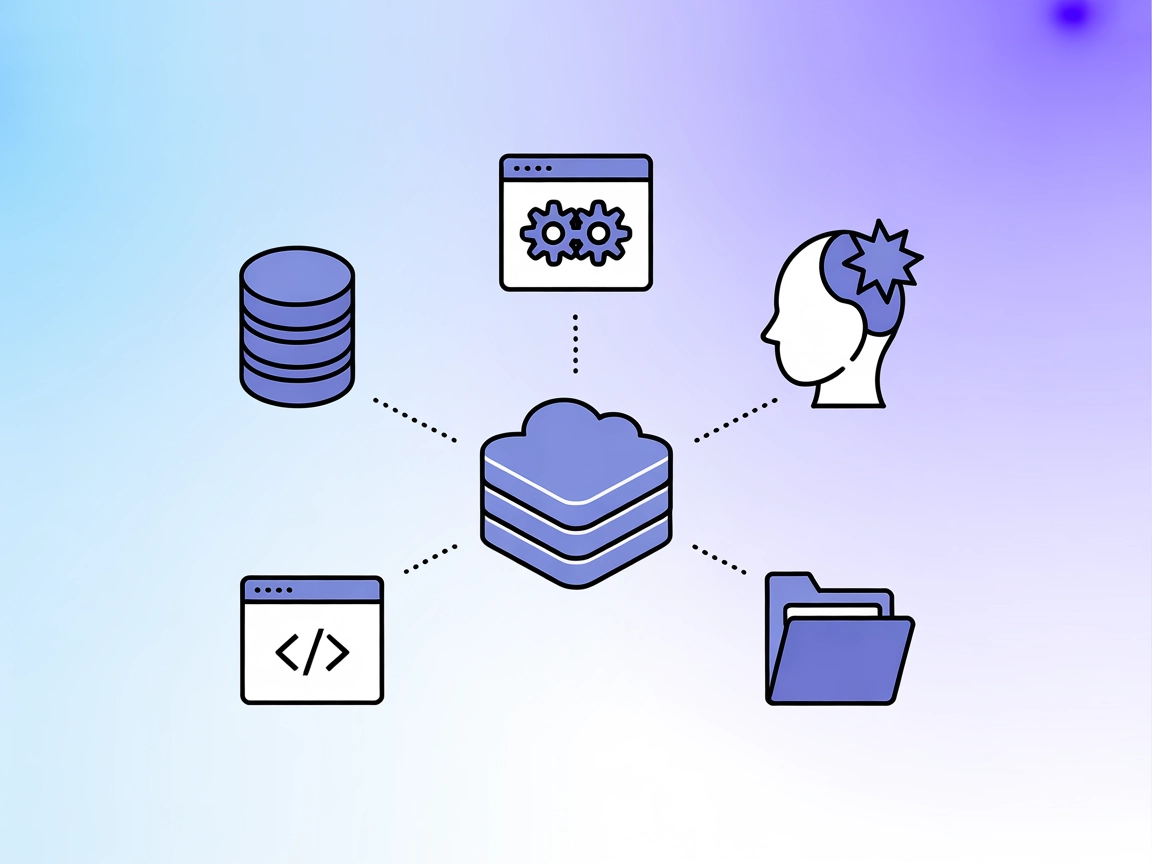

Serwer ModelContextProtocol (MCP) działa jako most między agentami AI a zewnętrznymi źródłami danych, API i usługami, umożliwiając użytkownikom FlowHunt budowan...

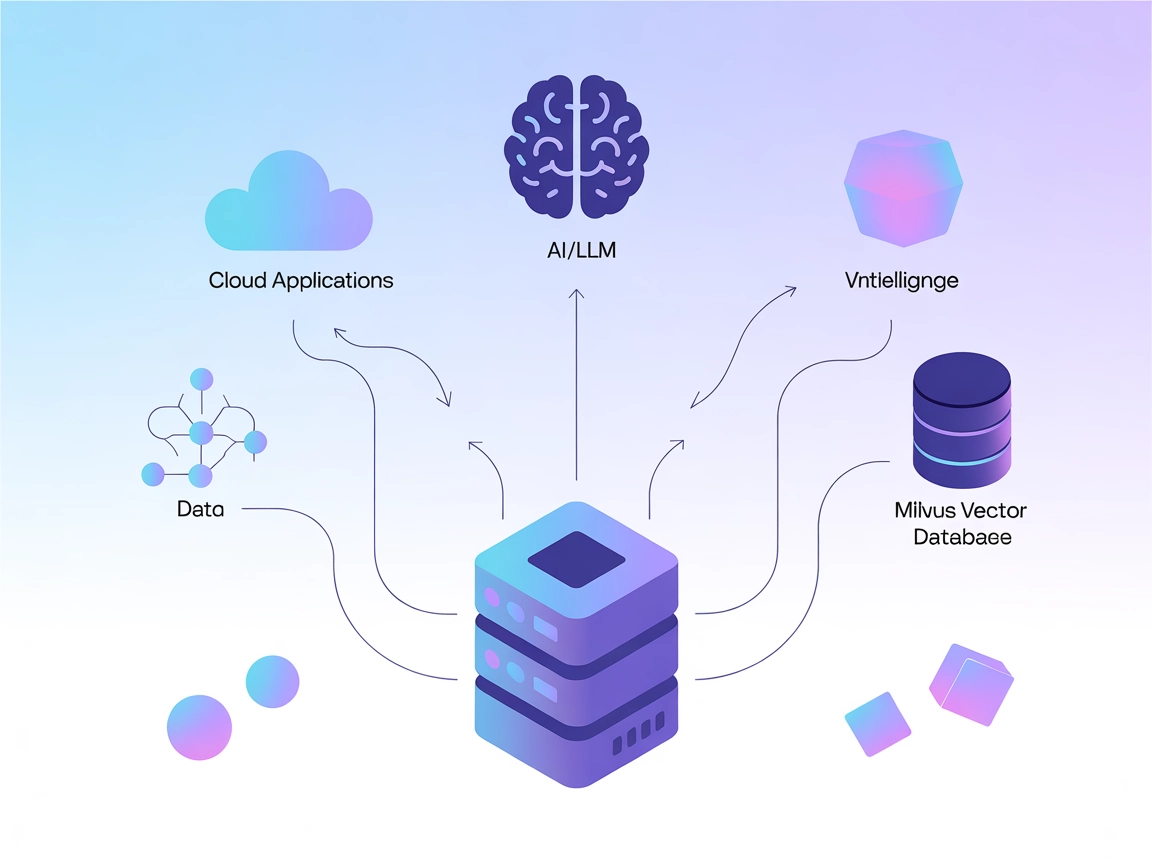

Połącz LLM-y i agentów AI z Milvus, aby uzyskać potężne wyszukiwanie wektorowe, kontekstową pamięć oraz rekomendacje oparte na danych bezpośrednio w swoich przepływach FlowHunt.

FlowHunt zapewnia dodatkową warstwę bezpieczeństwa między Twoimi systemami wewnętrznymi a narzędziami AI, dając Ci szczegółową kontrolę nad tym, które narzędzia są dostępne z Twoich serwerów MCP. Serwery MCP hostowane w naszej infrastrukturze można bezproblemowo zintegrować z chatbotem FlowHunt oraz popularnymi platformami AI, takimi jak ChatGPT, Claude i różne edytory AI.

Serwer Milvus MCP (Model Context Protocol) łączy asystentów AI oraz aplikacje oparte na LLM z bazą wektorową Milvus. Umożliwia to płynną interakcję modeli językowych z wielkoskalowymi danymi wektorowymi, zapewniając standaryzowany sposób dostępu, zapytań i zarządzania Milvus z poziomu przepływów AI. Dzięki Milvus MCP Server deweloperzy mogą integrować wyszukiwanie, pobieranie i zarządzanie danymi opartymi o Milvus bezpośrednio w agentach AI, IDE lub interfejsach czatu. Serwer obsługuje wiele trybów komunikacji (stdio oraz Server-Sent Events), dzięki czemu pasuje do różnych scenariuszy wdrożeniowych i środowisk developerskich. Łącząc LLM-y z Milvus, znacząco zwiększa możliwości systemów AI w operacjach kontekstowych na danych o wysokiej wymiarowości, odblokowując bogatsze i bardziej inteligentne doświadczenia zasilane LLM.

W repozytorium nie ma informacji o szablonach promptów.

W dostępnej dokumentacji ani kodzie nie opisano jawnej listy zasobów Model Context Protocol.

W dostępnej dokumentacji i plikach kodu, w tym server.py, nie udokumentowano jawnej listy narzędzi ani nazw funkcji.

git clone https://github.com/zilliztech/mcp-server-milvus.gituv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Zabezpieczanie kluczy API:

Jeśli serwer wymaga poufnych danych, użyj zmiennych środowiskowych:

{

"env": {

"MILVUS_URI": "http://localhost:19530"

},

"inputs": {}

}

{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Zabezpiecz dane logowania za pomocą zmiennych środowiskowych jak wyżej.

uv.uv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Zabezpieczanie kluczy API:

Użyj zmiennych środowiskowych jak powyżej.

uv.{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Zmienna środowiskowa:

{

"env": {

"MILVUS_URI": "http://localhost:19530"

}

}

Użycie MCP w FlowHunt

Aby zintegrować serwery MCP w swoim przepływie FlowHunt, rozpocznij od dodania komponentu MCP do przepływu i połączenia go z agentem AI:

Kliknij komponent MCP, aby otworzyć panel konfiguracji. W sekcji konfiguracji systemu MCP wklej dane serwera MCP w tym formacie JSON:

{

"milvus-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Po skonfigurowaniu agent AI może korzystać z tego MCP jako narzędzia, uzyskując dostęp do wszystkich jego funkcji i możliwości. Pamiętaj o zmianie “milvus-mcp” na faktyczną nazwę swojego serwera MCP oraz podmianie adresu URL na własny.

| Sekcja | Dostępność | Szczegóły/Uwagi |

|---|---|---|

| Przegląd | ✅ | |

| Lista promptów | ⛔ | Brak udokumentowanych szablonów promptów |

| Lista zasobów | ⛔ | Brak jawnej listy zasobów MCP |

| Lista narzędzi | ⛔ | Brak jawnych narzędzi w dostępnych plikach |

| Zabezpieczanie kluczy API | ✅ | Użycie zmiennych środowiskowych, opisane w przykładach konfiguracji |

| Sampling Support (mniej istotne w ocenie) | ⛔ | Nie wspomniano |

Wsparcie dla “roots”: Nie wspomniano

Wsparcie dla sampling: Nie wspomniano

Serwer Milvus MCP to praktyczny i skoncentrowany most łączący LLM-y z Milvus, z jasnymi przewodnikami konfiguracji dla popularnych narzędzi developerskich. Niemniej jednak, dokumentacja jest uboga w szczegóły dotyczące zasobów MCP, promptów oraz działających API narzędzi, co ogranicza łatwość odkrywania „out-of-the-box”. Nadal jednak to solidna podstawa pod integracje AI oparte na bazach wektorowych.

| Czy ma LICENCJĘ | ✅ (Apache-2.0) |

|---|---|

| Ma przynajmniej jedno narzędzie | ⛔ |

| Liczba Forków | 32 |

| Liczba Gwiazdek | 139 |

Ogólnie: 4/10

Serwer jest użyteczny w swoim niszowym zastosowaniu, ale znacznie zyskałby na bardziej szczegółowej dokumentacji dotyczącej zasobów, szablonów promptów i API narzędzi, co ułatwiłoby interoperacyjność oraz obsługę.

Serwer Milvus MCP łączy asystentów AI i aplikacje LLM z bazą wektorową Milvus, umożliwiając płynne wyszukiwanie wektorowe, kontekstową pamięć oraz zarządzanie danymi dla zaawansowanych przepływów AI.

Kluczowe zastosowania to wyszukiwanie wektorowe, zarządzanie embeddingami, kontekstowa pamięć chatbotów, rekomendacje oparte na AI oraz analiza danych w czasie rzeczywistym z wykorzystaniem Milvus w FlowHunt.

Aby przechowywać poufne dane połączenia, skorzystaj ze zmiennych środowiskowych (np. MILVUS_URI), zgodnie z instrukcjami w przewodnikach dla poszczególnych klientów.

Nie udokumentowano żadnych szablonów promptów ani API narzędzi. Serwer koncentruje się na dostarczaniu mostu do operacji wektorowych i zarządzania embeddingami.

To solidna podstawa do łączenia LLM-ów z bazami wektorowymi, z jasnymi instrukcjami instalacji, ale skorzystałby z bardziej rozbudowanej dokumentacji dotyczącej promptów i API narzędzi dla łatwiejszego odkrywania i integracji.

Rozszerz możliwości swoich agentów AI o płynny dostęp do baz wektorowych – uzyskaj inteligentniejsze wyszukiwanie, rekomendacje i pamięć kontekstową. Zintegruj serwer Milvus MCP z FlowHunt już teraz!

Serwer ModelContextProtocol (MCP) działa jako most między agentami AI a zewnętrznymi źródłami danych, API i usługami, umożliwiając użytkownikom FlowHunt budowan...

Serwer Model Context Protocol (MCP) łączy asystentów AI z zewnętrznymi źródłami danych, API i usługami, umożliwiając płynną integrację złożonych przepływów prac...

Serwer Verodat MCP łączy asystentów AI z zaawansowanym zarządzaniem danymi Verodat, umożliwiając płynny dostęp do danych, automatyzację oraz integrację workflow...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.