Google Gemini 2.5 Flash: Revolução na Geração de Imagens por IA

Explore como o modelo de imagem Gemini 2.5 Flash do Google está transformando indústrias criativas com edição avançada de imagens, extração 3D, restauração de f...

Automação de IA

Explore a evolução técnica das plataformas de mídia generativa, desde os primeiros modelos de imagem até a geração moderna de vídeos, e como a otimização especializada de inferência se tornou um negócio de mais de US$ 100 milhões.

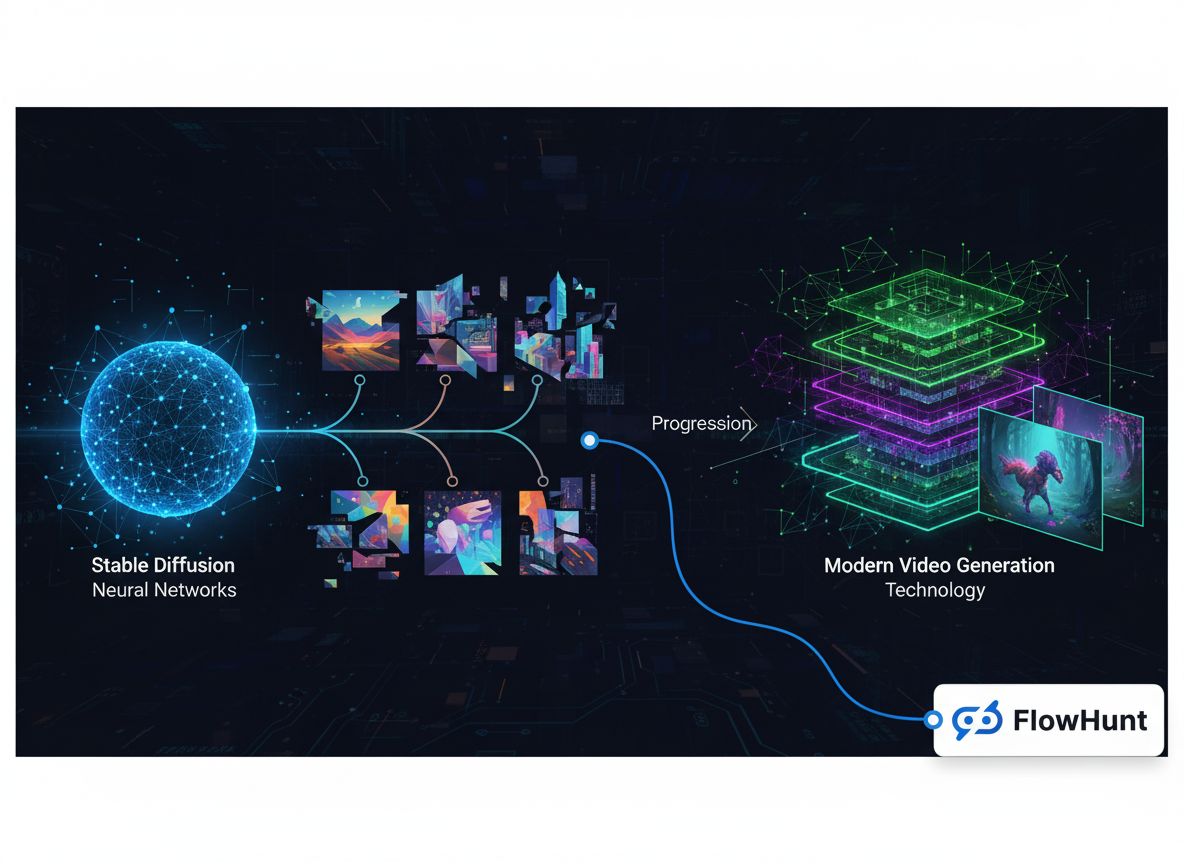

O cenário da mídia generativa passou por uma transformação notável nos últimos anos, evoluindo de projetos experimentais de pesquisa para um mercado de infraestrutura de bilhões de dólares. O que começou como modelos especializados de geração de imagens expandiu-se para um ecossistema abrangente, englobando síntese de imagens, criação de vídeos, geração de áudio e sofisticadas capacidades de edição. Esta história técnica explora como empresas como a FAL construíram um negócio de mais de US$ 100 milhões em receita ao reconhecer uma lacuna crítica no mercado: desenvolvedores precisavam de infraestrutura de inferência otimizada e escalável, projetada especificamente para modelos de mídia generativa, não apenas orquestração genérica de GPU ou hospedagem de modelos de linguagem. A jornada do Stable Diffusion 1.5 até modelos modernos de vídeo como o Veo3 revela lições importantes sobre posicionamento de mercado, especialização técnica e os requisitos de infraestrutura que permitem que aplicações de IA escalem de protótipos de pesquisa para sistemas de produção atendendo milhões de desenvolvedores.

Mídia generativa representa uma categoria fundamentalmente diferente de inteligência artificial em comparação com os grandes modelos de linguagem que têm dominado as manchetes recentes. Enquanto modelos de linguagem processam texto e geram respostas com base em padrões aprendidos, sistemas de mídia generativa criam conteúdo visual e de áudio — imagens, vídeos, músicas e efeitos sonoros — a partir de descrições em texto, imagens existentes ou outros tipos de entrada. Essa distinção vai além da semântica; ela reflete diferenças profundas nos requisitos técnicos, dinâmicas de mercado e oportunidades de negócios. Modelos de mídia generativa operam sob restrições computacionais distintas, exigem técnicas de otimização especializadas e atendem casos de uso que a infraestrutura de modelos de linguagem tradicionais não consegue lidar de forma eficiente. A ascensão da mídia generativa criou uma categoria totalmente nova de empresas de infraestrutura focadas especificamente na otimização de inferência desses modelos, permitindo que desenvolvedores integrem sofisticadas capacidades de geração de imagem e vídeo em suas aplicações sem precisar gerenciar implantações complexas de GPU ou lidar com uso ineficiente de recursos.

Os requisitos técnicos para inferência de mídia generativa diferem significativamente dos de modelos de linguagem. Modelos de geração de imagem como Stable Diffusion e Flux operam por meio de processos de difusão iterativos que exigem gerenciamento cuidadoso de memória, otimização precisa de tempo e processamento eficiente em lote. A geração de vídeo adiciona outra camada de complexidade, exigindo consistência temporal, sincronização de áudio e recursos computacionais substancialmente maiores. Esses requisitos não podem ser atendidos de forma eficiente por plataformas genéricas de orquestração de GPU ou serviços de inferência de modelos de linguagem. Em vez disso, demandam infraestrutura especializada, construída do zero para lidar com as características únicas dos modelos de difusão, geração autorregressiva de imagens e síntese de vídeo. Empresas que reconheceram essa lacuna cedo — e investiram na construção de infraestrutura dedicada — se posicionaram para captar uma fatia significativa do mercado à medida que a adoção da mídia generativa acelerou em diversos setores.

A decisão de se especializar em mídia generativa, ao invés de seguir o caminho aparentemente mais óbvio de hospedagem de modelos de linguagem, representa uma das escolhas estratégicas mais consequentes na recente história da infraestrutura de IA. Quando os fundadores da FAL avaliaram suas opções por volta de 2022-2023, enfrentaram um ponto crítico: expandir o runtime Python para uma plataforma de inferência de modelos de linguagem de propósito geral, ou apostar fortemente no espaço emergente de mídia generativa? A resposta revela percepções importantes sobre a dinâmica de mercado, posicionamento competitivo e a importância de escolher batalhas onde se pode vencer. Hospedar modelos de linguagem, embora atraente devido à enorme atenção e financiamento que os envolvia, apresentava um cenário competitivo impossível. A OpenAI já havia estabelecido o GPT como modelo dominante, com uma grande base de usuários e receita. A Anthropic estava desenvolvendo o Claude com amplo suporte e talento técnico. Google, Microsoft e outros gigantes estavam investindo bilhões em suas próprias infraestruturas de modelos de linguagem. Para uma startup, competir nesse espaço significaria desafiar diretamente empresas com recursos muito superiores, posições consolidadas no mercado e a capacidade de oferecer acesso a modelos até mesmo a preço de custo ou prejuízo, se isso servisse aos seus interesses estratégicos mais amplos.

O mercado de mídia generativa, por outro lado, apresentava uma dinâmica competitiva fundamentalmente diferente. Quando o Stable Diffusion 1.5 foi lançado em 2022, criou uma necessidade imediata de infraestrutura de inferência otimizada, mas nenhum player estabelecido havia surgido para dominar esse espaço. O modelo era open-source, permitindo que qualquer pessoa o baixasse e executasse, mas a maioria dos desenvolvedores não tinha a expertise ou os recursos para otimizá-lo de forma eficiente. Isso criou a oportunidade perfeita para o surgimento de uma empresa de infraestrutura especializada. A FAL percebeu que os desenvolvedores queriam usar esses modelos, mas não desejavam gerenciar a complexidade de implantação de GPU, otimização de modelo e escalabilidade. Ao focar exclusivamente em mídia generativa, a FAL pôde se tornar referência nesse domínio específico, construir relações profundas com criadores de modelos e desenvolvedores, e se estabelecer como a plataforma preferida para inferência de mídia generativa. Essa estratégia de especialização mostrou-se extremamente bem-sucedida, permitindo à FAL crescer de um ponto de inflexão para uma empresa que atende 2 milhões de desenvolvedores e hospeda mais de 350 modelos, com receita superior a US$ 100 milhões ao ano.

A base técnica das plataformas modernas de mídia generativa repousa sobre otimizações sofisticadas de inferência, que vão muito além de simplesmente rodar modelos em GPUs. Quando desenvolvedores começaram a usar o Stable Diffusion 1.5, muitos tentaram implantá-lo por conta própria usando infraestrutura genérica de nuvem ou GPUs locais. Essa abordagem revelou ineficiências críticas: os modelos não eram otimizados para o hardware específico, havia desperdício de memória por batching ineficiente e as taxas de utilização eram baixas, pois cada workload era isolada. Um desenvolvedor podia usar apenas 20-30% da capacidade de sua GPU, pagando por 100% dela. Esse desperdício criou uma oportunidade para uma plataforma que pudesse agregar demanda de vários usuários, otimizar a inferência para configurações específicas de hardware e alcançar taxas de utilização muito mais altas por meio de batching e agendamento inteligentes. A abordagem da FAL envolveu a construção de kernels CUDA personalizados — código de GPU de baixo nível otimizado para operações específicas dentro dos modelos generativos — que podiam melhorar drasticamente o desempenho em relação a implementações genéricas.

O desafio de infraestrutura vai além da simples otimização de performance. Modelos de mídia generativa possuem características únicas que exigem tratamento especializado. Modelos de difusão, que alimentam a maioria dos sistemas de geração de imagem, funcionam por meio de um processo iterativo onde o modelo refina gradualmente o ruído aleatório até formar imagens coerentes em muitos passos. Cada etapa exige gerenciamento cuidadoso de memória para evitar estouro da GPU, e o processo deve ser rápido o suficiente para aplicações interativas. A geração de vídeo adiciona dimensões temporais, exigindo que os modelos mantenham consistência ao longo dos frames, gerando conteúdo de alta qualidade em 24 ou 30 quadros por segundo. Modelos de áudio têm suas próprias exigências, incluindo capacidade de processamento em tempo real para alguns casos e alta fidelidade para outros. Uma plataforma que atenda a todas essas modalidades precisa desenvolver expertise profunda em cada domínio, compreendendo oportunidades e restrições específicas de otimização para cada tipo de modelo. É justamente essa especialização que faz as empresas de infraestrutura de mídia generativa tão valiosas — elas acumulam conhecimento e técnicas de otimização que desenvolvedores individuais não conseguem replicar com facilidade.

A história da mídia generativa pode ser rastreada pela evolução dos modelos de geração de imagem, cada um representando um ponto de inflexão significativo no desenvolvimento do mercado. O Stable Diffusion 1.5, lançado em 2022, foi o catalisador que transformou a mídia generativa de uma curiosidade acadêmica em uma ferramenta prática para desenvolvedores. O modelo era open-source, relativamente eficiente em comparação com modelos de difusão anteriores e produzia imagens de qualidade razoável para várias aplicações. Para a FAL, o Stable Diffusion 1.5 representou o momento em que reconheceram a oportunidade de pivotar toda a empresa. Passaram a oferecer uma versão otimizada, pronta para API, que os desenvolvedores podiam consumir sem precisar gerenciar infraestrutura de GPU. A resposta foi esmagadora — os desenvolvedores perceberam imediatamente o valor de não lidar com a complexidade de implantação, e o Stable Diffusion 1.5 se tornou o primeiro grande motor de receita da FAL. Além do modelo base, o ecossistema de fine-tuning ao redor do Stable Diffusion 1.5 explodiu. Desenvolvedores criaram LoRAs (Low-Rank Adaptations) — modificações leves que personalizam o modelo base para casos de uso específicos, como estilos de arte, rostos de pessoas ou objetos únicos. Esse ecossistema criou um ciclo virtuoso: quanto mais opções de fine-tuning, mais valiosa a plataforma, atraindo mais desenvolvedores e criando mais oportunidades de personalização.

O Stable Diffusion 2.1, lançado como sucessor do modelo original, serviu como um alerta sobre a importância da qualidade dos modelos no mercado de mídia generativa. Apesar de ser tecnicamente mais avançado em alguns aspectos, o SD 2.1 foi amplamente percebido como um retrocesso em qualidade de imagem, especialmente para rostos humanos e cenas complexas. O modelo não ganhou tração significativa e muitos desenvolvedores continuaram usando a versão 1.5. Essa experiência ensinou uma lição importante: no mercado de mídia generativa, a qualidade importa mais que a sofisticação técnica. Os usuários se importam com o resultado que podem criar, não com a arquitetura ou metodologia de treinamento. O Stable Diffusion XL (SDXL), lançado em 2023, representou um salto genuíno em qualidade e capacidade. O SDXL podia gerar imagens de resolução maior, com mais detalhes e renderização de texto mais precisa. Para a FAL, o SDXL foi transformador — foi o primeiro modelo a gerar US$ 1 milhão em receita para a plataforma. O sucesso do modelo acelerou ainda mais o ecossistema de fine-tuning, com desenvolvedores criando milhares de LoRAs para personalizar o SDXL para aplicações específicas. O êxito do SDXL demonstrou que havia demanda comercial substancial por geração de imagens de alta qualidade, validando a decisão da FAL de se especializar nesse mercado.

O lançamento dos modelos Flux pela Black Forest Labs em 2024 marcou outro ponto de inflexão crítico. O Flux representou a primeira geração de modelos que podiam ser genuinamente descritos como “comercialmente utilizáveis” e “prontos para empresas”. A qualidade era substancialmente superior aos modelos anteriores, a velocidade de geração era adequada para aplicações de produção e os resultados eram consistentes o suficiente para que empresas pudessem construir produtos em cima deles. Para a FAL, o Flux foi transformador: a receita da plataforma saltou de US$ 2 milhões para US$ 10 milhões no primeiro mês após o lançamento do Flux, e depois para US$ 20 milhões no mês seguinte. Esse crescimento explosivo refletiu a demanda reprimida por geração de imagens de alta qualidade que pudesse ser utilizada de forma confiável em aplicações comerciais. O Flux foi lançado em múltiplas versões — Schnell (uma versão rápida e destilada), Dev (com qualidade superior e licença não comercial) e Pro (requerendo colaboração para hospedagem) — cada uma atendendo diferentes casos de uso e faixas de preço. O sucesso do Flux também demonstrou que o mercado de mídia generativa amadureceu ao ponto de empresas estarem dispostas a investir significativamente em capacidades de geração de imagem, não apenas experimentando a tecnologia.

Enquanto a geração de imagens capturou muita atenção e receita, o surgimento de modelos práticos de geração de vídeo representou uma oportunidade de mercado totalmente nova. Os primeiros modelos de texto para vídeo, como o Sora da OpenAI, mostraram o que era possível em teoria, mas não estavam amplamente disponíveis ou produziam resultados interessantes apenas do ponto de vista da pesquisa, não sendo úteis na prática para a maioria das aplicações. Os vídeos eram frequentemente sem som, apresentavam inconsistências temporais e careciam do acabamento necessário para uso profissional. Isso mudou drasticamente com o lançamento de modelos como o Veo3 do Google DeepMind, que representou um verdadeiro avanço em qualidade de geração de vídeo. O Veo3 podia gerar vídeos com áudio sincronizado, temporização e ritmo corretos, sincronização labial precisa para falar, e qualidade visual próxima de padrões profissionais. O modelo era caro de rodar — substancialmente mais intensivo computacionalmente do que a geração de imagens — mas a qualidade justificava o custo para muitas aplicações.

O impacto da geração de vídeo de alta qualidade no negócio da FAL foi substancial. A geração de vídeo criou uma nova fonte de receita e atraiu um tipo diferente de cliente. Enquanto a geração de imagem era utilizada principalmente por desenvolvedores individuais, designers e pequenas equipes criativas, a geração de vídeo atraiu grandes empresas interessadas em criar conteúdo publicitário, vídeos de marketing e outras aplicações profissionais. A FAL fez parceria com vários provedores de modelos de vídeo, incluindo o One da Alibaba, Kling da Kuaishou, entre outros, para oferecer um conjunto abrangente de opções de geração de vídeo. O crescimento da receita da plataforma acelerou ainda mais à medida que o vídeo se tornou uma parte cada vez mais significativa do uso total. Os desafios técnicos da geração de vídeo também impulsionaram inovações na infraestrutura da FAL — os modelos de vídeo exigem estratégias diferentes de otimização em relação aos de imagem, demandando novos kernels personalizados e abordagens arquiteturais. O sucesso da geração de vídeo também validou a estratégia da FAL de construir uma plataforma capaz de atender múltiplas modalidades. Em vez de se especializar apenas em geração de imagens, a FAL construiu uma infraestrutura flexível o suficiente para acomodar modelos de imagem, vídeo e áudio, posicionando-se como a plataforma abrangente de mídia generativa.

À medida que a mídia generativa se torna cada vez mais central para a criação de conteúdo e desenvolvimento de aplicações, plataformas como o FlowHunt surgem para ajudar desenvolvedores e equipes a gerenciar a complexidade de integrar essas capacidades aos seus fluxos de trabalho. O FlowHunt reconhece que, embora plataformas como a FAL tenham resolvido o desafio de infraestrutura para rodar modelos de mídia generativa de forma eficiente, desenvolvedores ainda enfrentam desafios significativos para orquestrar esses modelos dentro de fluxos de trabalho maiores. Uma aplicação típica de mídia generativa pode envolver múltiplos passos: receber o pedido do usuário, processar e validar a entrada, chamar um ou mais modelos generativos, pós-processar os resultados, armazenar saídas e gerenciar análises. O FlowHunt oferece ferramentas para automatizar e otimizar esses fluxos, permitindo que desenvolvedores foquem na lógica da aplicação em vez de na gestão da infraestrutura. Ao integrar com plataformas como a FAL, o FlowHunt permite que desenvolvedores construam aplicações sofisticadas de mídia generativa sem precisar gerenciar a complexidade subjacente de servir, otimizar e escalar modelos.

A abordagem do FlowHunt para fluxos de mídia generativa enfatiza automação, confiabilidade e observabilidade. A plataforma permite que desenvolvedores definam fluxos de trabalho que encadeiam múltiplas operações de mídia generativa, tratem erros de forma elegante e ofereçam visibilidade sobre o que acontece em cada etapa. Por exemplo, um fluxo de criação de conteúdo pode envolver gerar múltiplas variações de imagem, selecionar a melhor com base em métricas de qualidade, aplicar efeitos de pós-processamento e, então, publicar o resultado. O FlowHunt permite definir todo esse fluxo declarativamente, com lógica automática de retentativa, tratamento de erros e monitoramento. Essa camada de abstração é especialmente valiosa para equipes que desenvolvem aplicações em produção e precisam gerar conteúdo em escala de forma confiável. Ao cuidar da orquestração e gestão de fluxos, o FlowHunt permite que desenvolvedores foquem na lógica criativa e de negócios de suas aplicações, enquanto a plataforma lida com a complexidade técnica de coordenar múltiplas operações de mídia generativa.

O impressionante crescimento do negócio da FAL e a qualidade de seu serviço são construídos sobre uma base de otimização técnica sofisticada que a maioria dos usuários nunca vê. A plataforma desenvolveu mais de 100 kernels CUDA personalizados — códigos especializados de GPU escritos na linguagem CUDA da NVIDIA — que otimizam operações específicas dentro dos modelos de mídia generativa. Esses kernels representam milhares de horas de engenharia focadas em extrair o máximo desempenho do hardware de GPU. A motivação para esse nível de otimização é direta: cada milissegundo de redução de latência se traduz em melhor experiência do usuário e menores custos de infraestrutura. Um modelo que gera uma imagem 20% mais rápido permite que a mesma GPU atenda 20% mais usuários, melhorando diretamente a economia da plataforma. O desafio de escrever kernels personalizados é substancial. Programar em CUDA requer compreensão profunda da arquitetura de GPU, hierarquias de memória e princípios de computação paralela. Não é algo que se aprende rapidamente ou se aplica genericamente — cada kernel precisa ser ajustado cuidadosamente para operações e configurações de hardware específicas.

O processo de otimização começa com o profiling — entender onde o tempo realmente está sendo gasto na execução do modelo. Muitos desenvolvedores assumem que as operações mais intensivas computacionalmente são os gargalos, mas o profiling frequentemente revela surpresas. Às vezes, o gargalo está no movimento de dados entre a memória da GPU e as unidades de computação, não no processamento em si. Outras vezes, é o overhead de lançar muitas operações pequenas em vez de agrupá-las. Os engenheiros da FAL fazem profiling extensivo dos modelos, identificam os gargalos reais e então escrevem kernels personalizados para solucioná-los. Por exemplo, podem criar um kernel que funde múltiplas operações, reduzindo o tráfego de memória e o overhead de lançamento. Ou podem criar um kernel otimizado especificamente para as dimensões e tipos de dados usados em determinado modelo. Esse nível de otimização só se justifica economicamente se você estiver atendendo milhões de usuários — o investimento em desenvolvimento de kernels personalizados se paga com eficiência aprimorada e redução dos custos de infraestrutura.

Além da otimização de kernels individuais, a FAL investiu em melhorias arquiteturais na forma como os modelos são servidos. A plataforma utiliza técnicas como quantização de modelos (redução da precisão dos pesos para consumir menos memória e processamento), batching dinâmico (agrupar requisições para melhorar a utilização da GPU) e priorização de requisições (garantir que chamadas sensíveis à latência tenham prioridade sobre as orientadas a throughput). Essas técnicas exigem implementação cuidadosa para manter a qualidade enquanto melhoram a eficiência. Quantização, por exemplo, pode reduzir o tamanho do modelo e melhorar a velocidade, mas se feita de forma inadequada pode degradar a qualidade do resultado. Os engenheiros da FAL desenvolveram estratégias sofisticadas de quantização que mantêm a qualidade enquanto alcançam ganhos significativos de eficiência. O batching dinâmico exige a previsão de quanto tempo cada requisição levará e o agrupamento para maximizar a utilização da GPU sem introduzir latência excessiva. Essas melhorias arquiteturais, combinadas com a otimização de kernels, permitem que a FAL alcance taxas de utilização e desempenho impossíveis com infraestrutura genérica.

O mercado de mídia generativa evoluiu rapidamente, com novos modelos e capacidades surgindo constantemente. Compreender a dinâmica competitiva e a estrutura do mercado é essencial para entender por que plataformas especializadas como a FAL se tornaram tão valiosas. O mercado pode ser dividido em vários segmentos: geração de imagem, geração de vídeo, geração de áudio e ferramentas de edição/manipulação. Em cada segmento, múltiplos modelos competem em qualidade, velocidade, custo e capacidades específicas. Para geração de imagem, o mercado inclui variantes do Stable Diffusion, modelos Flux, Gemini Image do Google e vários outros modelos especializados para usos específicos como geração de logos ou síntese de rostos humanos. Na geração de vídeo, o cenário inclui Veo3, One da Alibaba, Kling da Kuaishou e outros. Essa diversidade de modelos cria tanto oportunidades quanto desafios para as plataformas de infraestrutura. A oportunidade é que nenhum modelo domina todos os casos de uso — diferentes modelos são melhores para diferentes tarefas, então uma plataforma capaz de servir múltiplos modelos se torna mais valiosa. O desafio é que suportar muitos modelos exige grande esforço de engenharia para otimizar cada um deles.

A estratégia da FAL tem sido curar uma seleção de modelos que, em conjunto, cobrem os casos de uso mais importantes mantendo altos padrões de qualidade. Em vez de adicionar todo modelo lançado, a FAL avalia cuidadosamente novos modelos e só os integra se oferecem capacidades únicas ou qualidade significativamente melhor que as opções existentes. Essa abordagem traz vários benefícios. Primeiro, garante que a seleção de modelos da plataforma seja de alta qualidade e útil, ao invés de sobrecarregar o usuário com opções medianas. Segundo, permite que a FAL concentre esforços de otimização nos modelos que realmente serão usados, em vez de diluir recursos. Terceiro, cria um ciclo virtuoso em que a reputação da plataforma por qualidade atrai tanto usuários quanto criadores de modelos. Criadores querem seus modelos na FAL porque sabem que os usuários valorizam qualidade. Usuários querem usar a FAL porque sabem que os modelos disponíveis são selecionados e bem otimizados. Esse ciclo positivo tem sido crucial para o sucesso da plataforma.

O cenário competitivo inclui outras plataformas de infraestrutura para mídia generativa, bem como a concorrência direta dos próprios criadores de modelos, que podem oferecer hospedagem própria. Alguns criadores, como a Stability AI, oferecem suas próprias APIs de inferência. Outros, como a Black Forest Labs com o Flux, preferem parcerias com plataformas como a FAL, em vez de construir infraestrutura própria. A decisão de fazer parceria ou construir é estratégica — criar infraestrutura exige muitos recursos de engenharia e expertise operacional, enquanto a parceria permite focar no desenvolvimento do modelo. Para a maioria dos criadores, a parceria com plataformas especializadas como a FAL faz mais sentido do que construir infraestrutura própria. Essa dinâmica criou um ecossistema saudável onde criadores focam em pesquisa e desenvolvimento, enquanto as plataformas de infraestrutura cuidam da otimização e escalabilidade.

Compreender o modelo de negócios e as métricas da FAL fornece insights sobre como empresas de infraestrutura de mídia generativa criam valor e escalam. A FAL opera com um modelo de precificação por uso, onde os clientes pagam conforme o número de chamadas à API e os recursos computacionais consumidos. Esse modelo alinha bem os incentivos — clientes pagam mais quando usam mais, e a receita da FAL cresce à medida que a plataforma se torna mais valiosa e amplamente utilizada. Os números de crescimento da plataforma impressionam: 2 milhões de desenvolvedores, mais de 350 modelos disponíveis e mais de US$ 100 milhões em receita anual. Esses números representam escala substancial, mas também refletem o estágio inicial do mercado de mídia generativa. A penetração entre usuários potenciais ainda é relativamente baixa e muitos casos de uso permanecem inexplorados. O crescimento da receita tem acelerado, especialmente com a introdução das capacidades de geração de vídeo. A receita saltou de US$ 2 milhões para US$ 10 milhões no primeiro mês após o lançamento do Flux, demonstrando o impacto de modelos de alta qualidade na receita das plataformas de infraestrutura.

As métricas de negócio também revelam percepções importantes sobre a dinâmica do mercado. O fato de a FAL ter alcançado mais de US$ 100 milhões em receita anual atendendo 2 milhões de desenvolvedores sugere que a receita média por usuário é relativamente modesta — talvez US$ 50-100 por ano. Isso reflete o fato de que muitos usuários estão apenas experimentando mídia generativa ou usando em pequena escala. No entanto, a distribuição provavelmente é altamente assimétrica, com poucos usuários de grande porte gerando a maior parte da receita. Esses usuários geralmente são empresas que integram capacidades generativas em seus produtos ou serviços. À medida que o mercado amadurece e mais empresas integram mídia generativa em suas operações principais, a receita média por usuário provavelmente aumentará substancialmente. A trajetória de crescimento da plataforma sugere que a infraestrutura de mídia generativa ainda está nos estágios iniciais de uma curva de crescimento de longo prazo, com ampla oportunidade pela frente.

Uma das evoluções mais importantes no mercado de mídia generativa foi o surgimento de capacidades de fine-tuning e personalização que permitem aos usuários adaptar modelos para casos de uso específicos. Fine-tuning envolve pegar um modelo pré-treinado e treiná-lo mais com dados de domínio específico para melhorar o desempenho em tarefas particulares. Para geração de imagem, isso ocorre principalmente na forma de LoRAs (Low-Rank Adaptations), que são modificações leves que personalizam o modelo base sem exigir re-treinamento completo. Um designer pode criar uma LoRA que ensina o modelo a gerar imagens em um estilo artístico específico. Um fotógrafo pode criar uma LoRA que capture sua estética particular. Uma empresa pode criar uma LoRA para gerar imagens de seus produtos em contextos específicos. O ecossistema de LoRAs tornou-se parte fundamental do mercado de mídia generativa, com milhares de opções disponíveis para modelos populares como o Stable Diffusion e o SDXL.

O surgimento do fine-tuning tem importantes implicações para plataformas de infraestrutura como a FAL. Suportar fine-tuning exige capacidades adicionais além de simplesmente servir modelos base. A plataforma precisa oferecer ferramentas para usuários criarem e gerenciarem LoRAs, armazená-las de forma eficiente e servi-las junto com os modelos base. Também precisa lidar com os desafios técnicos de combinar modelos base com LoRAs no momento da inferência, garantindo que a combinação produza resultados de alta qualidade sem latência exagerada. A FAL investiu bastante nessas capacidades, reconhecendo que a personalização é parte chave do valor para muitos usuários. O suporte ao fine-tuning tem sido fator significativo para o sucesso da plataforma, permitindo personalização para necessidades específicas enquanto mantém os benefícios de otimização e escalabilidade. À medida que o mercado amadurece, o fine-tuning e a personalização tendem a se tornar ainda mais importantes, com empresas investindo em modelos customizados para seus próprios casos de uso.

Olhando para frente, o mercado de infraestrutura de mídia generativa deve continuar evoluindo rapidamente. Várias tendências devem moldar o futuro do setor. Primeiro, os modelos continuarão melhorando em qualidade e capacidade, habilitando novos casos de uso e atraindo mais usuários. A geração de vídeo ainda está em estágio inicial e, à medida que os modelos evoluem, deve se tornar tão ubíqua quanto a geração de imagens. Geração de áudio e criação musical despontam como novas fronteiras, com modelos como o PlayHD e outros mostrando potencial. Segundo, o mercado provavelmente se consolidará em torno de um número menor de modelos e plataformas dominantes, assim como o mercado de geração de imagens se consolidou em torno do Stable Diffusion e Flux. Essa consolidação cria oportunidades para plataformas especializadas se tornarem ainda mais valiosas, à medida que otimizam para os modelos dominantes. Terceiro, haverá integração crescente das capacidades de mídia generativa em aplicações e fluxos de trabalho tradicionais. Em vez de ser uma capacidade isolada, a mídia generativa será incorporada em ferramentas de design, sistemas de gestão de conteúdo e outros aplicativos usados diariamente por criadores.

Os requisitos de infraestrutura também continuarão evoluindo. À medida que modelos ficam maiores e mais capazes, exigirão mais recursos computacionais, impulsionando a demanda por otimização de inferência ainda mais eficiente. O surgimento de novos aceleradores de hardware além das GPUs — como chips de IA especializados — trará novos desafios e oportunidades de otimização. Plataformas capazes de servir modelos eficientemente em hardware diverso terão vantagem significativa. O mercado também verá foco crescente em confiabilidade, latência e otimização de custos, à medida que a mídia generativa se torna central para operações de negócios. Os primeiros usuários toleravam falhas ocasionais ou alta latência, mas, à medida que a tecnologia se torna crítica para processos de negócios, haverá demanda por maior confiabilidade e menor latência. Isso impulsionará investimentos contínuos em otimização de infraestrutura e engenharia de confiabilidade.

A história técnica da mídia generativa revela um mercado que evoluiu de pesquisa experimental para uma oportunidade de infraestrutura de bilhões de dólares em poucos anos. A jornada do Stable Diffusion 1.5 até modelos modernos de geração de vídeo demonstra como a rápida inovação em modelos de IA cria oportunidades para plataformas de infraestrutura especializadas. O sucesso da FAL ao construir um negócio de mais de US$ 100 milhões focando exclusivamente em infraestrutura de mídia generativa — em vez de competir no saturado mercado de modelos de linguagem — ilustra a importância de posicionamento estratégico de mercado e especialização técnica. O investimento da plataforma em otimização de kernels CUDA personalizados, suporte a múltiplas modalidades e curadoria de modelos de alta qualidade criou um serviço valioso do qual milhões de desenvolvedores dependem. À medida que a mídia generativa continua evoluindo e se tornando central na criação de conteúdo e desenvolvimento de aplicações, as plataformas de infraestrutura que atendem esse mercado serão cada vez mais importantes. A combinação de modelos em evolução, ampliação de casos de uso e adoção crescente por empresas sugere que a infraestrutura de mídia generativa ainda está nos estágios iniciais de uma trajetória de crescimento de longo prazo, com ampla oportunidade à frente para plataformas que ofereçam serviços confiáveis, eficientes e inovadores a seus usuários.

{{ cta-dark-panel heading=“Impulsione Seu Fluxo de Trabalho com FlowHunt” description=“Experimente como o FlowHunt automatiza seus fluxos de conteúdo e SEO com IA — do levantamento e geração de conteúdo à publicação e análise — tudo em um só lugar.” ctaPrimaryText=“Agende uma Demonstração” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“Experimente FlowHunt Grátis” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217” }}

Mídia generativa refere-se a sistemas de IA que criam imagens, vídeos e conteúdos de áudio. Ao contrário dos modelos de linguagem, que competem com motores de busca e grandes empresas de tecnologia, a mídia generativa representa um novo segmento de mercado com requisitos técnicos únicos para otimização de inferência e escalabilidade multi-inquilino.

A FAL reconheceu que a hospedagem de modelos de linguagem exigiria competir contra OpenAI, Anthropic e Google — empresas com enormes recursos. Mídia generativa era um nicho de rápido crescimento sem concorrentes estabelecidos, permitindo à FAL definir o mercado e se tornar líder em otimização de inferência para modelos de imagem, vídeo e áudio.

O Stable Diffusion 1.5 foi o primeiro grande ponto de inflexão da FAL. Ele demonstrou que desenvolvedores precisavam de inferência otimizada e pronta para API, em vez de gerenciar suas próprias implantações. Essa percepção levou a FAL a pivotar de um runtime Python genérico para uma plataforma especializada em mídia generativa.

Os modelos Flux, lançados pela Black Forest Labs, foram os primeiros a atingir qualidade 'comercialmente utilizável e pronta para empresas'. Eles elevaram a receita da FAL de US$ 2 milhões para US$ 10 milhões no primeiro mês, depois para US$ 20 milhões no mês seguinte, estabelecendo a mídia generativa como um mercado comercial viável.

A FAL desenvolveu mais de 100 kernels CUDA personalizados para otimizar o desempenho de inferência para diferentes modelos. Esses kernels permitem tempos de geração mais rápidos, melhor utilização de GPU e escalabilidade multi-inquilino — fatores críticos para atender 2 milhões de desenvolvedores e mais de 350 modelos com eficiência.

A geração de vídeo, especialmente com modelos como o Veo3, criou um segmento totalmente novo no mercado. Os primeiros modelos de texto para vídeo produziam conteúdos de baixa qualidade e sem som. Modelos modernos, com áudio, sincronização labial e temporização adequados, tornaram a geração de vídeo comercialmente viável e abriram novos casos de uso em publicidade e criação de conteúdo.

Arshia é Engenheira de Fluxos de Trabalho de IA na FlowHunt. Com formação em ciência da computação e paixão por IA, ela se especializa em criar fluxos de trabalho eficientes que integram ferramentas de IA em tarefas do dia a dia, aumentando a produtividade e a criatividade.

Descubra como o FlowHunt simplifica a geração de conteúdo por IA, desde a seleção do modelo até a implantação e otimização.

Explore como o modelo de imagem Gemini 2.5 Flash do Google está transformando indústrias criativas com edição avançada de imagens, extração 3D, restauração de f...

Explore como o aprendizado por reforço e o fine-tuning se tornaram a abordagem dominante para otimizar modelos de IA, desde a destilação do GPT-4 até a ascensão...

Explore as capacidades revolucionárias do Sora 2 na geração de vídeos com IA, desde recriação realista de personagens até simulação de física, e descubra como e...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.