Como um Modelo com 7 Milhões de Parâmetros Está Superando Modelos de IA de Fronteira

Descubra como um pequeno modelo com 7 milhões de parâmetros supera Gemini, DeepSeek e Claude usando raciocínio recursivo e supervisão profunda. Conheça a aborda...

Automação de IA

Uma análise aprofundada do modelo de raciocínio EXAONE Deep 32B da LG testado contra o DeepSeek R1 e o QwQ da Alibaba, examinando alegações de desempenho superior e as reais capacidades de raciocínio.

O cenário dos modelos de raciocínio em inteligência artificial tornou-se cada vez mais competitivo, com diversas organizações reivindicando avanços em tarefas complexas de raciocínio matemático e lógico. O recente lançamento do EXAONE Deep da LG, um modelo de raciocínio com 32 bilhões de parâmetros, gerou grande atenção ao afirmar superar concorrentes estabelecidos como o DeepSeek R1. No entanto, testes em cenários reais revelam um quadro mais sutil do que sugerem as alegações de marketing. Este artigo fornece uma análise aprofundada do desempenho real do EXAONE Deep em comparação com outros modelos líderes em raciocínio, examinando o abismo entre benchmarks anunciados e a funcionalidade prática. Por meio de testes práticos e comparações detalhadas, exploraremos o que esses modelos realmente conseguem fazer, como lidam com tarefas de raciocínio complexas e o que isso significa para organizações que consideram essas ferramentas para uso em produção.

O surgimento de modelos de raciocínio representa uma mudança fundamental na forma como a inteligência artificial aborda a resolução de problemas complexos. Diferente dos modelos de linguagem tradicionais, que geram respostas em uma única passagem, modelos de raciocínio empregam uma técnica chamada decodificação em tempo de teste, que aloca recursos computacionais significativos durante a inferência para pensar nos problemas passo a passo. Essa abordagem espelha o raciocínio humano, no qual muitas vezes precisamos analisar diferentes ângulos antes de chegar a uma solução. O conceito ganhou destaque com o modelo o1 da OpenAI e, desde então, foi adotado por diversas organizações, incluindo DeepSeek, Alibaba e agora a LG. Esses modelos geram o que é chamado de sequência de tokens de “pensamento” ou “raciocínio” que normalmente os usuários não veem no resultado final, mas que representa o processo interno de deliberação do modelo. Os tokens de pensamento são cruciais porque permitem que o modelo explore diferentes caminhos de solução, identifique erros e refine sua abordagem antes de chegar à resposta final. Isso é especialmente valioso para problemas matemáticos, tarefas de raciocínio lógico e cenários complexos de múltiplas etapas, nos quais uma única passagem poderia ignorar detalhes importantes ou levar a conclusões incorretas.

Para organizações que implementam sistemas de IA, os modelos de raciocínio representam um avanço significativo em confiabilidade e precisão para tarefas complexas. Modelos de linguagem tradicionais frequentemente têm dificuldades com problemas matemáticos de múltiplas etapas, dedução lógica e cenários que exigem análise cuidadosa de restrições e condições. Os modelos de raciocínio abordam essas limitações ao mostrar explicitamente seu raciocínio, o que também fornece transparência sobre como o modelo chegou à sua conclusão. Essa transparência é especialmente importante em ambientes empresariais, onde decisões baseadas em recomendações de IA precisam ser auditáveis e explicáveis. A desvantagem, no entanto, é o custo computacional e a latência. Como os modelos de raciocínio geram muitos tokens de pensamento antes de apresentar uma resposta final, eles exigem mais processamento e demoram mais para responder em comparação aos modelos de linguagem padrão. Isso torna a escolha do modelo algo crítico — as organizações precisam entender não apenas as pontuações em benchmarks, mas o desempenho real em seus casos de uso específicos. A proliferação de modelos de raciocínio de diferentes fornecedores, cada um alegando desempenho superior, torna essenciais os testes e comparações independentes para decisões informadas sobre implantação.

A entrada da LG no espaço dos modelos de raciocínio com o EXAONE Deep gerou considerável interesse, especialmente devido à significativa capacidade de pesquisa da empresa e ao tamanho relativamente modesto do modelo, com 32 bilhões de parâmetros. Os materiais de marketing da LG apresentaram resultados de benchmarks impressionantes, alegando que o EXAONE Deep alcançou 90% de acerto na competição AIME (American Invitational Mathematics Examination) com apenas 64 tentativas, e 95% nos problemas do MATH-500. Esses números, se verdadeiros, representariam um desempenho competitivo ou superior ao DeepSeek R1 e ao QwQ da Alibaba. A empresa também lançou várias versões do modelo em diferentes tamanhos, incluindo uma variante de 2,4 bilhões de parâmetros projetada para uso como modelo rascunho em decodificação especulativa — técnica que usa modelos menores para prever tokens que os modelos maiores irão gerar, potencialmente acelerando a inferência. No entanto, ao ser submetido a testes práticos em problemas padrão de raciocínio, o EXAONE Deep apresentou comportamentos preocupantes que contradizem as alegações dos benchmarks. O modelo demonstrou tendência a entrar em ciclos de pensamento prolongados sem chegar a conclusões lógicas, gerando milhares de tokens que pareciam repetitivos ou sem sentido em vez de representar raciocínio produtivo. Esse comportamento sugere possíveis problemas no treinamento do modelo, na metodologia de avaliação dos benchmarks ou na forma como ele lida com certos tipos de prompts.

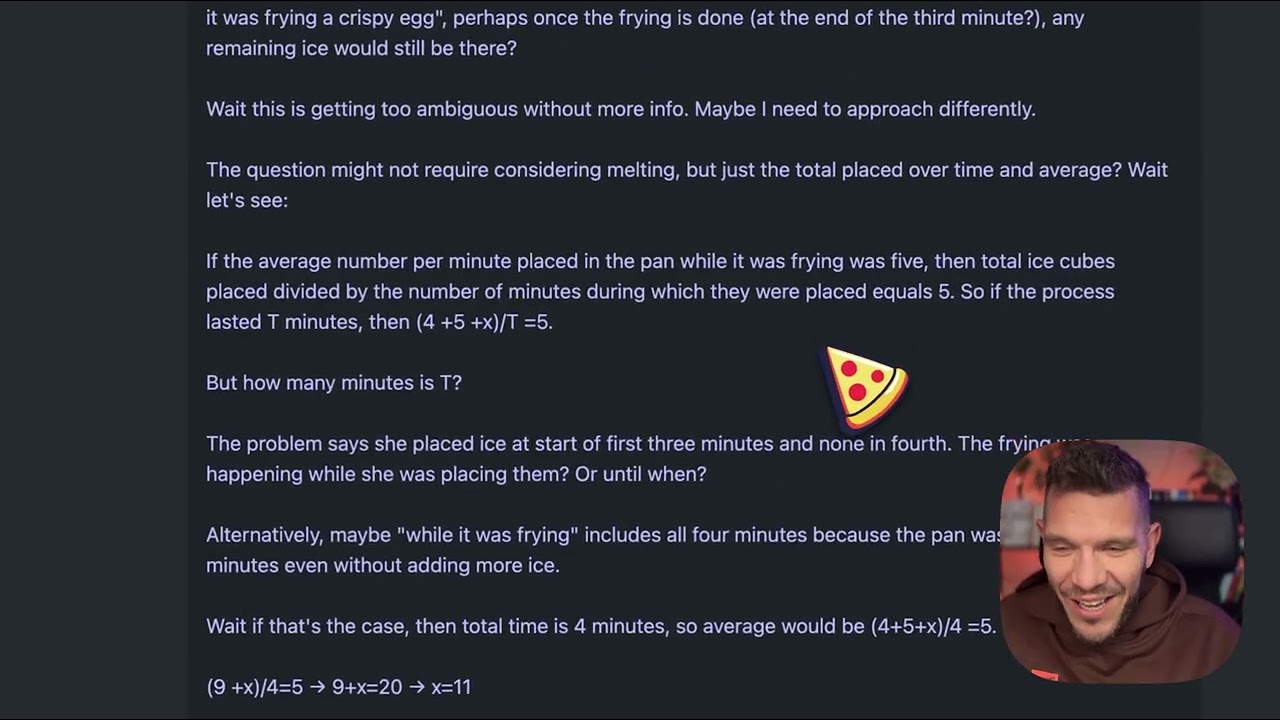

Para entender as diferenças práticas entre modelos de raciocínio, considere um problema aparentemente simples que se tornou um teste padrão de qualidade: “Beth coloca alguns cubos de gelo inteiros em uma panela. Após um minuto, há 20 cubos de gelo. Após dois minutos, há 10 cubos de gelo. Após três minutos, há 0 cubos de gelo. Quantos cubos de gelo inteiros podem ser encontrados na panela ao final do terceiro minuto?” A resposta correta é zero, pois a pergunta pede explicitamente sobre cubos de gelo inteiros ao final do terceiro minuto, e o enunciado diz que há zero neste ponto. No entanto, esse problema é projetado para confundir modelos que superanalisam ou se perdem na narrativa do derretimento dos cubos de gelo. Alguns modelos podem deduzir que o gelo derrete ao longo do tempo e tentar calcular taxas de derretimento, desviando-se da resposta direta. Quando o EXAONE Deep foi testado nesse problema, ele gerou aproximadamente 5.000 tokens de pensamento sem chegar a uma conclusão coerente. O processo de raciocínio do modelo parecia sair do controle, com o texto gerado tornando-se cada vez mais incoerente e falhando em demonstrar uma resolução lógica do problema. Os tokens gerados incluíam fragmentos que não formavam pensamentos completos, e o modelo nunca articulou claramente um caminho de raciocínio ou resposta final. Esse desempenho contrasta fortemente com o que se espera: um modelo de raciocínio deveria reconhecer a pegadinha, trabalhar a lógica de forma clara e chegar rapidamente à resposta correta.

Quando o mesmo problema do cubo de gelo foi testado nos modelos DeepSeek R1 e QwQ da Alibaba, ambos apresentaram desempenho significativamente melhor. O DeepSeek R1 gerou um processo claro de raciocínio, analisou o problema de forma metódica e chegou à resposta correta: zero. O raciocínio do modelo foi transparente e lógico, mostrando como considerou o problema, reconheceu a pegadinha e chegou à resposta certa. O QwQ também demonstrou desempenho forte, embora também tenha gerado um processo de pensamento longo. Curiosamente, o QwQ inicialmente considerou se os cubos de gelo levariam tempo para derreter e se a questão era de física ou matemática, mas acabou chegando à resposta correta. A diferença principal foi que ambos os modelos apresentaram raciocínio coerente ao longo do processo, mesmo ao explorar diferentes ângulos. Demonstraram a habilidade de reconhecer quando tinham informações suficientes para responder e de se comprometer com uma resposta final. O EXAONE Deep, em contraste, nunca chegou a esse ponto. O modelo continuou gerando tokens sem propósito aparente, nunca se decidindo por uma resposta ou demonstrando progressão lógica clara. Isso sugere problemas fundamentais em como o modelo lida com tarefas de raciocínio, apesar das impressionantes alegações de benchmark.

Um aspecto técnico interessante do lançamento do EXAONE Deep é a inclusão de múltiplos tamanhos de modelos projetados para trabalhar juntos por meio da decodificação especulativa. A versão de 2,4 bilhões de parâmetros pode atuar como modelo rascunho, prevendo tokens que o modelo principal de 32 bilhões de parâmetros irá gerar. Quando as previsões do rascunho coincidem com a geração do modelo principal, o sistema pode pular o cálculo do modelo principal e usar a predição do rascunho, acelerando, assim, a inferência. Essa é uma técnica sofisticada de otimização que pode reduzir significativamente a latência e os requisitos computacionais. Nos testes, a implementação de decodificação especulativa mostrou tokens verdes indicando predições de rascunho bem-sucedidas, sugerindo que a técnica funcionava como esperado. Contudo, essa otimização não resolve o problema fundamental da qualidade do raciocínio do modelo principal. Inferência mais rápida de raciocínio ruim ainda é raciocínio ruim. A presença desse recurso de otimização também levanta dúvidas sobre se os resultados dos benchmarks da LG foram obtidos usando configurações ou técnicas que não se traduzem bem para padrões reais de uso.

Para organizações que enfrentam dificuldades em avaliar e comparar múltiplos modelos de IA, o FlowHunt oferece uma plataforma abrangente de automação que simplifica o processo de testes e benchmarking. Em vez de executar testes manualmente em diferentes modelos e comparar resultados, o FlowHunt permite que equipes configurem fluxos de trabalho automatizados que avaliam sistematicamente o desempenho dos modelos em múltiplas dimensões. Isso é especialmente valioso ao comparar modelos de raciocínio, cujo desempenho pode variar significativamente conforme o tipo de problema, a complexidade e a formulação específica do prompt. As capacidades de automação do FlowHunt permitem testar modelos em conjuntos padronizados de problemas, acompanhar métricas de desempenho ao longo do tempo e gerar relatórios comparativos detalhados. A plataforma pode se integrar a múltiplos provedores de modelos e APIs, tornando possível avaliar modelos de diferentes fornecedores em um único fluxo unificado. Para equipes que consideram a implantação de modelos de raciocínio como EXAONE Deep, DeepSeek R1 ou QwQ, o FlowHunt oferece a infraestrutura para decisões baseadas em dados reais, não apenas em alegações de fornecedores. A capacidade de automatizar tarefas repetitivas de teste também libera recursos de engenharia para focar em integração e otimização, em vez de benchmarking manual.

O abismo entre o desempenho alegado do EXAONE Deep e seu comportamento real nos testes destaca uma lição crítica para adoção de IA: benchmarks de fornecedores devem sempre ser verificados por meio de testes independentes. Os resultados de benchmarks podem ser influenciados por vários fatores, incluindo o conjunto de testes utilizado, a metodologia de avaliação, a configuração de hardware e os parâmetros de inferência do modelo. Um modelo pode ter bom desempenho em um benchmark específico, mas apresentar dificuldades com outros tipos de problemas ou cenários reais. Por isso, organizações como a Weights & Biases e pesquisadores independentes desempenham papel fundamental no ecossistema de IA — fornecem testes e análises imparciais que ajudam a comunidade a entender o que os modelos realmente conseguem fazer. Ao avaliar modelos de raciocínio para implantação em produção, as organizações devem realizar seus próprios testes em conjuntos de problemas representativos de seu domínio específico. Um modelo que se destaca em raciocínio matemático pode ter dificuldades com dedução lógica ou geração de código. O problema do cubo de gelo, embora aparentemente simples, serve como teste diagnóstico útil porque revela se um modelo é capaz de lidar com perguntas pegadinha e evitar superanálise. Modelos que falham nesses problemas tendem a apresentar dificuldades em tarefas de raciocínio mais complexas também.

Os ciclos de pensamento prolongados observados nos testes do EXAONE Deep podem ter várias causas potenciais. Uma possibilidade é que o processo de treinamento do modelo não tenha ensinado adequadamente quando parar de pensar e se comprometer com uma resposta. Modelos de raciocínio exigem calibragem cuidadosa durante o treinamento para equilibrar os benefícios do pensamento estendido com os riscos de superanálise e geração de tokens improdutivos. Se o treinamento não incluiu exemplos suficientes de quando parar, o modelo pode simplesmente gerar tokens até atingir o limite máximo. Outra possibilidade é que o modelo tenha problemas no processamento dos prompts, principalmente em como interpreta certos tipos de perguntas ou instruções. Alguns modelos são sensíveis à formulação específica do prompt e podem se comportar de forma diferente dependendo de como a questão é redigida. O fato de o EXAONE Deep ter gerado sequências incoerentes de tokens sugere que o modelo pode estar entrando em um estado em que gera tokens sem conteúdo semântico significativo, o que pode indicar problemas nos mecanismos de atenção do modelo ou na lógica de predição de tokens. Uma terceira possibilidade é que a metodologia de avaliação dos benchmarks tenha usado configurações ou estratégias de prompting diferentes das utilizadas nos testes reais, levando a um grande abismo de desempenho entre os resultados relatados e os reais.

Os problemas de desempenho observados com o EXAONE Deep têm implicações mais amplas para o mercado de modelos de raciocínio. À medida que mais organizações lançam modelos desse tipo, o mercado corre o risco de ficar saturado com modelos que apresentam alegações impressionantes nos benchmarks, mas desempenho questionável no mundo real. Isso cria um ambiente desafiador para organizações que buscam selecionar modelos para uso em produção. A solução é dar mais ênfase a testes independentes, metodologias de avaliação padronizadas e transparência quanto às limitações dos modelos. O espaço dos modelos de raciocínio se beneficiaria de padrões industriais para avaliação e comparação, semelhante ao que ocorreu com outros benchmarks de IA. Além disso, as organizações devem ser cautelosas em relação a modelos que alegam superar significativamente concorrentes já estabelecidos, especialmente quando a diferença de desempenho parece inconsistente com a arquitetura ou abordagem de treinamento do modelo. DeepSeek R1 e QwQ demonstraram desempenho consistente em múltiplos cenários de teste, o que traz confiança em suas capacidades. O desempenho inconsistente do EXAONE Deep — alegações excelentes nos benchmarks, mas resultados ruins no mundo real — sugere problemas tanto no próprio modelo quanto na forma como os benchmarks foram conduzidos.

Descubra como o FlowHunt automatiza seus fluxos de conteúdo em IA e SEO — da pesquisa e geração de conteúdo à publicação e análise — tudo em um só lugar.

Organizações que consideram a implantação de modelos de raciocínio devem seguir um processo estruturado de avaliação. Primeiro, estabeleça um conjunto de testes representativo, incluindo problemas do seu domínio ou caso de uso específico. Benchmarks genéricos podem não refletir como o modelo irá se sair nos seus problemas reais. Segundo, teste múltiplos modelos nos mesmos problemas para permitir comparação direta. Isso exige padronizar o ambiente de teste, incluindo hardware, parâmetros de inferência e formulação de prompts. Terceiro, avalie não apenas a precisão, mas também métricas de eficiência como latência e geração de tokens. Um modelo que gera respostas corretas, mas exige 10.000 tokens de pensamento, pode não ser prático para uso em produção se você precisa de respostas em tempo real. Quarto, examine o processo de raciocínio do modelo, não apenas a resposta final. Um modelo que chega à resposta correta por meio de raciocínio falho pode falhar em problemas similares com outros parâmetros. Quinto, teste casos limite e perguntas pegadinha para entender como o modelo lida com cenários projetados para confundi-lo. Por fim, considere o custo total de propriedade, incluindo não apenas licenças ou custos de API do modelo, mas também os recursos computacionais necessários para a inferência e o esforço de engenharia para integração.

O tamanho de 32 bilhões de parâmetros do EXAONE Deep é notavelmente menor do que alguns modelos concorrentes de raciocínio, o que levanta dúvidas sobre se os problemas do modelo são resultado de capacidade insuficiente. No entanto, o tamanho do modelo sozinho não determina a capacidade de raciocínio. O QwQ, que também opera em uma faixa semelhante de parâmetros, demonstra desempenho forte em raciocínio. Isso sugere que os problemas do EXAONE Deep estão mais relacionados à metodologia de treinamento, ao design da arquitetura ou à configuração de inferência do que a limitações fundamentais de tamanho. A inclusão do modelo rascunho de 2,4 bilhões de parâmetros no lançamento do EXAONE Deep mostra que a LG está pensando em eficiência, o que é louvável. Contudo, ganhos de eficiência só são valiosos se o modelo principal produzir resultados corretos. Uma resposta errada rápida é pior do que uma resposta certa mais lenta na maioria dos cenários de produção. O mercado de modelos de raciocínio provavelmente seguirá enfatizando eficiência à medida que organizações busquem implantar esses modelos em escala, mas essa otimização não pode comprometer a qualidade do raciocínio.

O espaço dos modelos de raciocínio ainda está em estágio inicial, e podemos esperar uma evolução significativa nos próximos meses e anos. À medida que mais organizações lançam modelos e mais testes independentes são realizados, o mercado provavelmente se consolidará em torno de modelos que demonstram desempenho consistente e confiável. Organizações como DeepSeek e Alibaba já estabeleceram credibilidade por meio de desempenho consistente, enquanto novos participantes, como a LG, precisarão resolver os problemas observados nos testes para obter aceitação no mercado. Podemos esperar também inovações contínuas em como esses modelos são treinados e avaliados. A abordagem atual de gerar extensos tokens de pensamento é eficaz, mas computacionalmente cara. Modelos futuros podem desenvolver mecanismos de raciocínio mais eficientes, atingindo precisão semelhante com menos tokens. Além disso, veremos maior especialização, com modelos otimizados para domínios específicos, como matemática, geração de código ou raciocínio lógico. A integração de modelos de raciocínio com outras técnicas de IA, como geração aumentada por recuperação ou uso de ferramentas, também expandirá suas capacidades e aplicações.

O EXAONE Deep da LG representa uma entrada ambiciosa no mercado de modelos de raciocínio, mas os testes práticos revelam lacunas significativas entre o desempenho anunciado e sua capacidade real. Enquanto os resultados dos benchmarks sugerem desempenho competitivo com DeepSeek R1 e QwQ da Alibaba, testes práticos em problemas padrão de raciocínio mostram que o EXAONE Deep tem dificuldades com tarefas básicas, gerando tokens em excesso sem chegar a conclusões coerentes. DeepSeek R1 e QwQ demonstraram desempenho superior nos mesmos problemas, chegando a respostas corretas por meio de processos de raciocínio claros e lógicos. Para organizações que avaliam modelos de raciocínio para implantação em produção, esta análise reforça a importância crítica de testes e verificações independentes. Benchmarks de fornecedores devem ser tratados como pontos de partida, e não como medidas definitivas da capacidade do modelo. O mercado de modelos de raciocínio se beneficiará de maior transparência, metodologias de avaliação padronizadas e contínuos testes independentes pela comunidade de pesquisa. À medida que a tecnologia amadurece, organizações que investirem em processos rigorosos de avaliação e comparação de modelos estarão mais bem posicionadas para selecionar e implantar modelos de raciocínio que realmente agreguem valor para seus casos de uso específicos.

O EXAONE Deep é um modelo de raciocínio com 32 bilhões de parâmetros desenvolvido pela LG, que utiliza decodificação em tempo de teste para resolver problemas complexos. Diferente dos modelos de linguagem padrão, ele aloca recursos computacionais durante a inferência para pensar nos problemas passo a passo, semelhante aos modelos DeepSeek R1 e QwQ da Alibaba.

Em testes práticos em tarefas de raciocínio, como o problema do cubo de gelo, o EXAONE Deep mostrou problemas significativos de superanálise e geração excessiva de tokens sem chegar a conclusões lógicas. DeepSeek R1 e QwQ tiveram desempenho melhor, chegando a respostas corretas de forma mais eficiente.

Decodificação em tempo de teste é uma técnica em que modelos de IA alocam mais recursos computacionais durante a inferência para raciocinar sobre problemas complexos. Isso permite que os modelos mostrem seu processo de pensamento e cheguem a respostas mais precisas, embora exija calibragem cuidadosa para evitar superanálise.

O FlowHunt automatiza o fluxo de trabalho de testes, comparação e avaliação de múltiplos modelos de IA, permitindo que equipes façam benchmarks sistemáticos de desempenho, acompanhem métricas e tomem decisões baseadas em dados sobre quais modelos implantar para cada caso de uso.

Arshia é Engenheira de Fluxos de Trabalho de IA na FlowHunt. Com formação em ciência da computação e paixão por IA, ela se especializa em criar fluxos de trabalho eficientes que integram ferramentas de IA em tarefas do dia a dia, aumentando a produtividade e a criatividade.

Use o FlowHunt para simplificar seus fluxos de testes, comparação e acompanhamento de desempenho de modelos de IA com automação inteligente.

Descubra como um pequeno modelo com 7 milhões de parâmetros supera Gemini, DeepSeek e Claude usando raciocínio recursivo e supervisão profunda. Conheça a aborda...

A avaliação comparativa de modelos de IA é a avaliação e comparação sistemática de modelos de inteligência artificial usando conjuntos de dados, tarefas e métri...

Descubra por que o Gemini 3 Flash do Google está revolucionando a IA com desempenho superior, custos menores e velocidades mais rápidas — superando até mesmo o ...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.