Por que a Liderança em IA é Mais Importante do que Nunca

Descubra por que a liderança em IA é essencial para o sucesso organizacional, como líderes fortes impulsionam a transformação com IA e como o Workshop de Lidera...

Automação de IA

O Guia de Riscos e Controles de IA da KPMG oferece às organizações uma abordagem estruturada e ética para gerenciar riscos de IA, apoiando a implantação responsável e a conformidade com padrões globais.

Esse primeiro dado pode ser do ano passado, mas não poderia ser mais relevante atualmente. Segundo o KPMG’s 2024 U.S. CEO Outlook, impressionantes 68% dos CEOs identificaram a IA como prioridade máxima de investimento. Eles contam com a tecnologia para aumentar a eficiência, aprimorar a qualificação da equipe e impulsionar a inovação em suas organizações.

Isso representa uma grande demonstração de confiança na IA — mas também levanta uma questão importante: com tanto em jogo, como as organizações podem garantir o uso responsável e ético da IA?

É aqui que entra o Guia de Riscos e Controles de IA da KPMG. Ele oferece um framework claro e prático para ajudar as empresas a aproveitarem o potencial da IA enquanto gerenciam os riscos reais que ela traz. No cenário atual, construir uma IA confiável não é apenas uma boa prática — é uma exigência do negócio.

A Inteligência Artificial (IA) está revolucionando setores, desbloqueando novos níveis de eficiência, inovação e competitividade. Porém, junto com essa transformação vem um conjunto distinto de riscos e desafios éticos que as organizações devem gerenciar cuidadosamente para manter a confiança e garantir o uso responsável. O Guia de Riscos e Controles de IA da KPMG foi criado para apoiar as organizações na navegação dessas complexidades, oferecendo uma abordagem prática, estruturada e orientada por valores para a governança da IA.

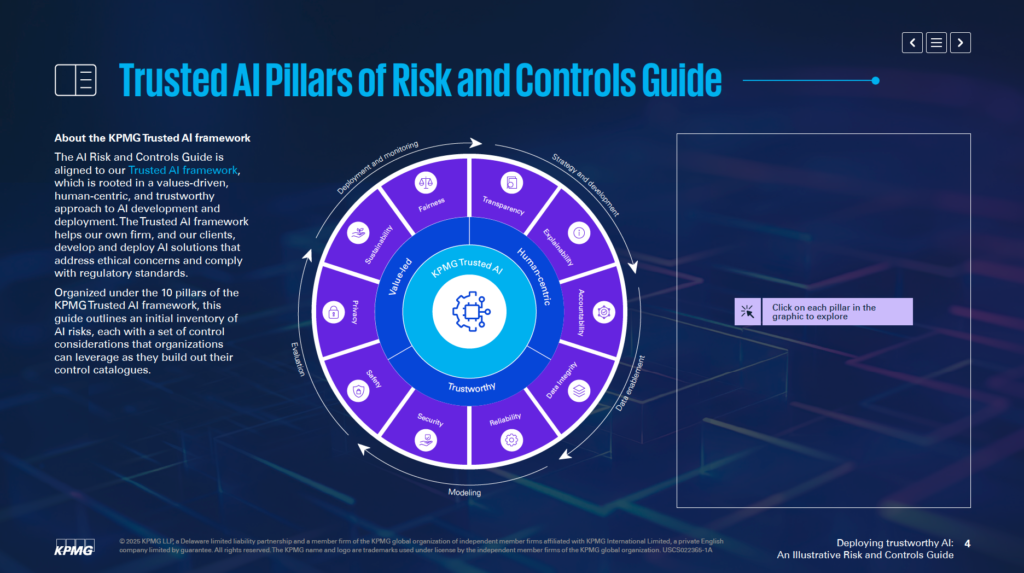

Alinhado ao Framework de IA Confiável da KPMG, este guia auxilia empresas a desenvolverem e implementarem soluções de IA que sejam éticas, centradas no ser humano e em conformidade com padrões regulatórios globais. Ele está organizado em torno de 10 pilares fundamentais, cada um abordando um aspecto crítico da gestão de riscos de IA:

Ao focar nesses pilares, as organizações podem incorporar princípios éticos em todas as fases do ciclo de vida da IA — desde a estratégia e desenvolvimento até a implantação e monitoramento. Este guia não apenas aprimora a resiliência a riscos, mas também fomenta uma inovação sustentável, confiável e alinhada às expectativas da sociedade.

Se você é um profissional de riscos, líder executivo, cientista de dados ou consultor jurídico, este guia oferece ferramentas e insights essenciais para ajudá-lo a aproveitar o poder da IA de forma responsável.

O Guia de Riscos e Controles de IA da KPMG serve como um recurso especializado para ajudar organizações a gerenciar os riscos específicos relacionados à inteligência artificial (IA). Ele reconhece que, embora a IA ofereça grande potencial, suas complexidades e questões éticas exigem uma abordagem focada de gestão de riscos. O guia disponibiliza um framework estruturado para enfrentar esses desafios de maneira responsável e eficaz.

O guia não tem a intenção de substituir sistemas atuais, mas sim de complementar os processos de gestão de riscos já existentes. Seu principal objetivo é incorporar considerações específicas de IA nas estruturas de governança da organização, garantindo alinhamento com as práticas operacionais vigentes. Essa abordagem permite fortalecer as capacidades de gestão de riscos sem a necessidade de redesenhar completamente os frameworks.

O guia é baseado no framework de IA Confiável da KPMG, que promove uma abordagem orientada por valores e centrada no ser humano para a IA. Ele integra princípios de normas amplamente reconhecidas, incluindo ISO 42001, o Framework de Gestão de Riscos de IA do NIST e a Lei de IA da União Europeia. Isso garante que o guia seja prático e alinhado às melhores práticas globais e exigências regulatórias para governança de IA.

O guia oferece insights práticos e exemplos que ajudam a abordar riscos relacionados à IA. Ele incentiva as organizações a adaptar esses exemplos ao seu contexto, considerando fatores como desenvolvimento próprio ou por fornecedores, além dos tipos de dados e técnicas utilizadas. Essa adaptabilidade garante que o guia permaneça relevante para diferentes setores e aplicações de IA.

O foco do guia é permitir que as organizações implementem tecnologias de IA de maneira segura, ética e transparente. Ao abordar os aspectos técnicos, operacionais e éticos dos riscos de IA, ele ajuda a construir confiança entre as partes interessadas enquanto potencializa as capacidades transformadoras da IA.

O guia atua como um recurso para garantir que os sistemas de IA estejam alinhados com os objetivos do negócio, ao mesmo tempo em que mitigam riscos potenciais. Ele apoia a inovação de forma que priorize responsabilidade e prestação de contas.

O Guia de Governança de IA da KPMG é destinado a profissionais que gerenciam a implementação de IA e garantem seu uso seguro, ético e eficaz. Ele se aplica a equipes de diversas áreas dentro das organizações, incluindo:

Executivos de alto escalão, como CEOs, CIOs e CTOs, encontrarão no guia um apoio para tratar a IA como prioridade estratégica. De acordo com o KPMG’s 2024 US CEO Outlook, 68% dos CEOs consideram a IA uma área-chave de investimento. O guia permite alinhar estratégias de IA aos objetivos organizacionais, abordando os riscos associados.

Engenheiros de software, cientistas de dados e outros responsáveis pela criação e implantação de soluções de IA podem usar o guia para incorporar princípios éticos e controles robustos diretamente em seus sistemas. O foco está em adaptar práticas de gestão de riscos à arquitetura e aos fluxos de dados específicos dos modelos de IA.

O guia é adaptável para empresas que desenvolvem sistemas de IA internamente, adquirem de fornecedores ou utilizam conjuntos de dados proprietários. Ele é especialmente relevante para setores como finanças, saúde e tecnologia, onde aplicações avançadas de IA e dados sensíveis são críticos.

Implantar IA sem um framework claro de governança pode levar a riscos financeiros, regulatórios e de reputação. O guia da KPMG trabalha em conjunto com processos já existentes para fornecer uma abordagem estruturada e ética à gestão de IA. Ele promove responsabilidade, transparência e práticas éticas, ajudando organizações a usarem a IA de forma responsável e a liberar seu potencial.

As organizações devem começar vinculando riscos específicos de IA à sua taxonomia de riscos atual. Uma taxonomia de riscos é uma estrutura usada para identificar, organizar e abordar vulnerabilidades potenciais. Como a IA traz desafios únicos, taxonomias tradicionais precisam ser expandidas para incluir fatores específicos da tecnologia, como precisão do fluxo de dados, lógica dos algoritmos e confiabilidade das fontes de dados. Assim, os riscos de IA passam a integrar os esforços mais amplos de gestão de riscos da organização, em vez de serem tratados separadamente.

O guia destaca a necessidade de avaliar todo o ciclo de vida dos sistemas de IA. É importante examinar de onde os dados vêm, como transitam pelos processos e a lógica fundamental do modelo de IA. Essa visão abrangente ajuda a identificar vulnerabilidades durante o desenvolvimento e uso dos sistemas.

Os sistemas de IA diferem conforme o objetivo, métodos de desenvolvimento e tipo de dados utilizados. Se um modelo é desenvolvido internamente ou obtido de terceiros, isso influencia os riscos envolvidos. Do mesmo modo, o tipo de dado — proprietário, público ou sensível — e as técnicas empregadas exigem estratégias personalizadas de gestão de riscos.

O guia sugere adaptar medidas de controle às necessidades específicas de cada sistema de IA. Por exemplo, quem utiliza dados proprietários pode precisar de controles de acesso mais rigorosos. Já o uso de sistemas de IA de fornecedores pode exigir avaliações aprofundadas de riscos de terceiros. Com controles personalizados, é possível enfrentar de modo mais eficaz os desafios próprios de cada sistema de IA.

O guia recomenda a incorporação de práticas de gestão de riscos em todas as etapas do ciclo de vida da IA. Isso inclui planejar riscos na fase de design, estabelecer monitoramento robusto durante a implantação e atualizar avaliações de risco conforme o sistema evolui. Ao abordar riscos em cada etapa, você reduz vulnerabilidades e garante que seus sistemas de IA sejam éticos e confiáveis.

Dar o primeiro passo vinculando riscos de IA à taxonomia de riscos existente e personalizando controles conforme as necessidades estabelece uma base sólida para uma IA confiável. Esses esforços permitem identificar, avaliar e gerenciar riscos de forma sistemática, criando um framework robusto de governança de IA.

O Framework de IA Confiável da KPMG se baseia em dez pilares-chave que abordam os desafios éticos, técnicos e operacionais da inteligência artificial. Esses pilares orientam organizações no design, desenvolvimento e implantação responsáveis de sistemas de IA, garantindo confiança e responsabilidade em todo o ciclo de vida.

Supervisão e responsabilidade humanas devem estar presentes em todas as etapas do ciclo de vida da IA. Isso significa definir claramente quem é responsável pela gestão dos riscos, garantir conformidade com leis e regulamentos e manter a capacidade de intervir, reverter ou corrigir decisões da IA se necessário.

Sistemas de IA devem buscar reduzir ou eliminar vieses que possam afetar negativamente indivíduos, comunidades ou grupos. Isso inclui analisar os dados para garantir que representem diferentes populações, aplicar medidas de justiça no desenvolvimento e monitorar continuamente os resultados para promover tratamento equitativo.

Transparência exige compartilhar abertamente como os sistemas de IA funcionam e por que tomam determinadas decisões. Isso inclui documentar limitações, resultados de desempenho e métodos de teste. Usuários devem ser notificados ao terem seus dados coletados, conteúdos gerados por IA devem ser rotulados claramente e aplicações sensíveis, como categorização biométrica, precisam informar os usuários de forma transparente.

Sistemas de IA devem fornecer razões compreensíveis para suas decisões. Para isso, as organizações devem documentar conjuntos de dados, algoritmos e métricas de desempenho em detalhes, permitindo que as partes interessadas analisem e reproduzam resultados de forma eficaz.

A qualidade e confiabilidade dos dados durante todo o ciclo de vida — coleta, rotulagem, armazenamento e análise — são essenciais. Devem existir controles para riscos como corrupção ou viés dos dados. Verificações regulares de qualidade e testes de regressão durante atualizações mantêm a precisão e confiabilidade dos sistemas.

Soluções de IA devem obedecer às leis de privacidade e proteção de dados. As organizações precisam lidar adequadamente com solicitações de titulares, realizar avaliações de impacto de privacidade e utilizar métodos avançados, como privacidade diferencial, para equilibrar usabilidade dos dados e proteção da privacidade.

Sistemas de IA devem apresentar desempenho consistente de acordo com o propósito e precisão exigida. Isso requer testes abrangentes, mecanismos de detecção de anomalias e ciclos contínuos de feedback para validar as saídas do sistema.

Medidas de segurança operacional protegem sistemas de IA contra danos a pessoas, empresas ou propriedades. Incluem o design de failsafes, monitoramento de problemas como envenenamento de dados ou ataques por prompt injection e alinhamento dos sistemas com padrões éticos e operacionais.

Práticas de segurança robustas são necessárias para proteger sistemas de IA contra ameaças e atividades maliciosas. As organizações devem realizar auditorias regulares, avaliações de vulnerabilidades e aplicar criptografia para proteger dados sensíveis.

Sistemas de IA devem ser projetados para minimizar o consumo de energia e apoiar metas ambientais. Considerações de sustentabilidade devem estar presentes desde o design, com monitoramento contínuo do uso de energia, eficiência e emissões ao longo do ciclo de vida.

Ao seguir esses dez pilares, as organizações podem criar sistemas de IA éticos, confiáveis e alinhados às expectativas sociais. Esse framework fornece uma estrutura clara para gerenciar desafios da IA promovendo inovação responsável.

A integridade dos dados é fundamental para garantir que sistemas de IA permaneçam precisos, justos e confiáveis. A má gestão dos dados pode levar a riscos como viés, imprecisão e resultados não confiáveis. Esses problemas enfraquecem a confiança nas saídas da IA e podem causar sérios impactos operacionais e reputacionais. O framework de IA Confiável da KPMG destaca a necessidade de manter dados de alta qualidade durante todo o ciclo de vida para garantir o funcionamento eficaz dos sistemas e o cumprimento de padrões éticos.

Sem uma governança de dados robusta, sistemas de IA podem produzir resultados falhos. Questões como dados incompletos, imprecisos ou irrelevantes levam a saídas enviesadas ou pouco confiáveis, aumentando riscos em diferentes aplicações.

Dados frequentemente transitam entre sistemas para atividades de treinamento, teste ou operação. Se essas transferências não forem bem gerenciadas, dados podem ser corrompidos, perdidos ou degradados, afetando o desempenho dos sistemas de IA.

Para aprimorar a governança de dados, as organizações podem:

Para minimizar riscos nas transferências, as organizações devem:

A adoção de sistemas de monitoramento contínuo ajuda a manter a integridade dos dados em todo o ciclo de vida da IA. Esses sistemas podem detectar problemas como alterações inesperadas na qualidade dos dados ou inconsistências no tratamento, permitindo ações corretivas rápidas.

Manter a integridade dos dados é essencial para implantar sistemas de IA confiáveis. Estabelecendo frameworks sólidos de governança, protegendo interações com dados e mantendo processos contínuos de validação, as organizações reduzem riscos e aumentam a confiabilidade das saídas da IA, cumprindo padrões éticos e operacionais e fortalecendo a confiança nas tecnologias de IA.

Gerenciar solicitações relacionadas ao acesso de titulares de dados é um grande desafio de privacidade em IA. As organizações devem garantir que as pessoas possam exercer seus direitos de acessar, corrigir ou excluir informações pessoais conforme leis como GDPR e CCPA. Se essas solicitações não forem bem tratadas, podem ocorrer violações regulatórias, perda de confiança dos consumidores e danos à reputação.

Para mitigar esse risco, as empresas devem criar programas para educar indivíduos sobre seus direitos ao interagir com IA. Os sistemas precisam estar preparados para processar essas solicitações de forma ágil e transparente. Também é fundamental manter registros detalhados de como essas demandas são tratadas, comprovando conformidade em auditorias.

Sistemas de IA frequentemente lidam com dados pessoais sensíveis, tornando-os alvos atrativos para ataques cibernéticos. Caso ocorra um vazamento, podem surgir multas regulatórias pesadas, danos à reputação e perda de confiança dos clientes.

Para combater isso, o framework de IA Confiável da KPMG sugere revisões éticas para sistemas que usam dados pessoais, assegurando o cumprimento das normas de privacidade. Auditorias regulares de proteção de dados e avaliações de impacto de privacidade (PIAs) também são necessárias, especialmente quando dados sensíveis são usados no treinamento de modelos. Métodos como privacidade diferencial, que insere ruído estatístico nos dados, ajudam a anonimizar as informações preservando a possibilidade de análise.

Sistemas de IA que não incluem salvaguardas de privacidade desde a origem podem gerar sérios problemas. Sem aplicar o princípio de privacidade by design, as organizações correm o risco de expor dados sensíveis ou descumprir exigências legais.

As empresas devem adotar medidas de privacidade já nas fases iniciais de desenvolvimento dos sistemas de IA. Isso inclui seguir as leis e regulamentos de proteção de dados por meio de práticas sólidas de gestão. Documentação clara sobre como os dados são coletados, usados e armazenados é fundamental. Também é necessário obter consentimento explícito dos usuários para coleta e processamento de dados, principalmente em áreas sensíveis como biometria.

Quando sistemas de IA não explicam claramente como os dados dos usuários são tratados, isso pode gerar desconfiança e questionamentos legais. Os usuários devem saber quando seus dados são coletados e como estão sendo utilizados

O Guia de Riscos e Controles de IA da KPMG é um framework prático desenvolvido para ajudar organizações a gerenciar os riscos únicos da IA, garantindo uma implantação responsável, ética e em conformidade da IA em diversos setores.

O guia é estruturado em dez pilares fundamentais: Responsabilidade, Justiça, Transparência, Explicabilidade, Integridade de Dados, Confiabilidade, Segurança, Segurança Operacional, Privacidade e Sustentabilidade—cada um abordando aspectos críticos da gestão de riscos de IA.

O guia é destinado a profissionais de riscos, equipes de conformidade, especialistas em cibersegurança, consultores jurídicos, executivos, desenvolvedores de IA, engenheiros e organizações de todos os portes que buscam gerenciar a IA de forma responsável.

Ele está alinhado com padrões globais como ISO 42001, Framework de Gestão de Riscos de IA do NIST e a Lei de IA da UE, ajudando organizações a integrar controles específicos de IA nos processos de governança existentes e atender aos requisitos regulatórios.

Ele sugere medidas como governança de dados robusta, privacidade desde a concepção, monitoramento contínuo, transparência nas decisões de IA, detecção de anomalias, ciclos de feedback e metas de sustentabilidade para reduzir riscos relacionados à IA.

Descubra como o Guia de Riscos e Controles de IA da KPMG pode ajudar sua organização a adotar inovação em IA garantindo uma implantação ética, segura e em conformidade.

Descubra por que a liderança em IA é essencial para o sucesso organizacional, como líderes fortes impulsionam a transformação com IA e como o Workshop de Lidera...

O uso indevido de IA no trabalho não é um problema dos funcionários—é uma crise de liderança. Explore por que os funcionários recorrem a ferramentas de IA em se...

Descubra as formas surpreendentes como as pessoas estão utilizando a IA em 2025: de terapia e organização da vida a encontrar propósito, a IA está deixando de s...