Servidor DeepSeek MCP

O Servidor DeepSeek MCP atua como um proxy seguro, conectando os avançados modelos de linguagem da DeepSeek a aplicativos compatíveis com MCP como Claude Deskto...

Automação de IA

Traga o raciocínio transparente e as saídas de cadeia de pensamento da Deepseek para seus assistentes compatíveis com MCP com suporte para implantações em nuvem e locais.

O FlowHunt fornece uma camada de segurança adicional entre seus sistemas internos e ferramentas de IA, dando-lhe controle granular sobre quais ferramentas são acessíveis a partir de seus servidores MCP. Os servidores MCP hospedados em nossa infraestrutura podem ser perfeitamente integrados com o chatbot do FlowHunt, bem como com plataformas de IA populares como ChatGPT, Claude e vários editores de IA.

O Deepseek Thinker MCP Server atua como um provedor Model Context Protocol (MCP), entregando conteúdo de raciocínio do modelo Deepseek para clientes de IA compatíveis com MCP, como o Claude Desktop. Ele permite que assistentes de IA acessem os processos de pensamento e saídas de raciocínio do Deepseek, seja por meio do serviço de API Deepseek ou de um servidor Ollama local. Ao integrar este servidor, desenvolvedores podem aprimorar seus fluxos de trabalho de IA com raciocínio focado, aproveitando capacidades de inferência em nuvem ou local. Este servidor é especialmente útil em cenários onde cadeias de raciocínio detalhadas ou saídas de cadeia de pensamento (CoT) são necessárias para informar tarefas de IA subsequentes, tornando-o valioso para desenvolvimento avançado, depuração e enriquecimento de agentes de IA.

Não há modelos de prompt explícitos mencionados no repositório ou na documentação.

Não há recursos MCP explícitos detalhados na documentação ou no código.

originPrompt (string) — O prompt original do usuário.windsurf_config.json).mcpServers:{

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Sua API Key>",

"BASE_URL": "<Seu Base URL>"

}

}

}

claude_desktop_config.json.{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Sua API Key>",

"BASE_URL": "<Seu Base URL>"

}

}

}

}

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Sua API Key>",

"BASE_URL": "<Seu Base URL>"

}

}

}

}

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Sua API Key>",

"BASE_URL": "<Seu Base URL>"

}

}

}

}

Para todas as plataformas, chaves de API e valores sensíveis de configuração devem ser fornecidos usando variáveis de ambiente na seção env. Exemplo:

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Sua API Key>",

"BASE_URL": "<Seu Base URL>"

}

}

}

}

Para modo local Ollama, defina USE_OLLAMA como "true" no objeto env:

"env": {

"USE_OLLAMA": "true"

}

Usando MCP no FlowHunt

Para integrar servidores MCP ao seu fluxo de trabalho no FlowHunt, comece adicionando o componente MCP ao seu fluxo e conectando-o ao seu agente de IA:

Clique no componente MCP para abrir o painel de configuração. Na seção de configuração MCP do sistema, insira os detalhes do seu servidor MCP usando este formato JSON:

{

"deepseek-thinker": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Depois de configurado, o agente de IA poderá usar este MCP como uma ferramenta, com acesso a todas as suas funções e capacidades. Lembre-se de trocar “deepseek-thinker” pelo nome real do seu servidor MCP e definir a URL correta.

| Seção | Disponibilidade | Detalhes/Notas |

|---|---|---|

| Visão Geral | ✅ | |

| Lista de Prompts | ⛔ | Nenhum modelo de prompt documentado |

| Lista de Recursos | ⛔ | Nenhum recurso MCP explícito encontrado |

| Lista de Ferramentas | ✅ | Ferramenta get-deepseek-thinker |

| Proteção de Chaves de API | ✅ | Variáveis de ambiente na configuração |

| Suporte a Sampling (menos importante) | ⛔ | Não mencionado |

Com base nas duas tabelas abaixo, o Deepseek Thinker MCP Server oferece uma ferramenta focada para integração de raciocínio, é fácil de configurar, mas carece de modelos de prompt detalhados e definições explícitas de recursos. O projeto é open source, possui um seguimento moderado e suporta manuseio seguro de credenciais. Ele recebe uma pontuação 6/10 para completude e utilidade geral como servidor MCP.

| Possui LICENSE | ⛔ (Nenhum arquivo LICENSE detectado) |

|---|---|

| Possui ao menos uma ferramenta | ✅ |

| Número de Forks | 12 |

| Número de Estrelas | 51 |

É um servidor Model Context Protocol que traz o raciocínio do modelo Deepseek para clientes de IA compatíveis com MCP, oferecendo saídas de cadeia de pensamento e pensamento transparente do modelo para fluxos de trabalho de IA avançados e depuração.

Ele oferece a ferramenta 'get-deepseek-thinker' para realizar raciocínio com o modelo Deepseek e retornar saídas estruturadas de raciocínio.

Sim, o Deepseek Thinker suporta inferência baseada em nuvem e local (Ollama). Defina a variável de ambiente 'USE_OLLAMA' como 'true' para o modo local.

As chaves de API e valores sensíveis devem ser armazenados na seção 'env' da configuração do seu servidor MCP como variáveis de ambiente e não hardcoded em arquivos fonte.

Os limites são determinados pelo modelo Deepseek ou API subjacente; ao excedê-los, as respostas podem ser truncadas ou causar erros, então ajuste sua configuração e entradas conforme necessário.

Não há modelos de prompt explícitos ou recursos MCP extras fornecidos como parte da documentação atual do Deepseek Thinker MCP Server.

Integre o Deepseek Thinker MCP Server para oferecer aos seus agentes de IA capacidades detalhadas de raciocínio e impulsionar fluxos de desenvolvimento.

O Servidor DeepSeek MCP atua como um proxy seguro, conectando os avançados modelos de linguagem da DeepSeek a aplicativos compatíveis com MCP como Claude Deskto...

O DeepSeek MCP Server integra os avançados modelos de linguagem da DeepSeek com aplicações compatíveis com MCP, oferecendo acesso seguro e anonimizado à API e p...

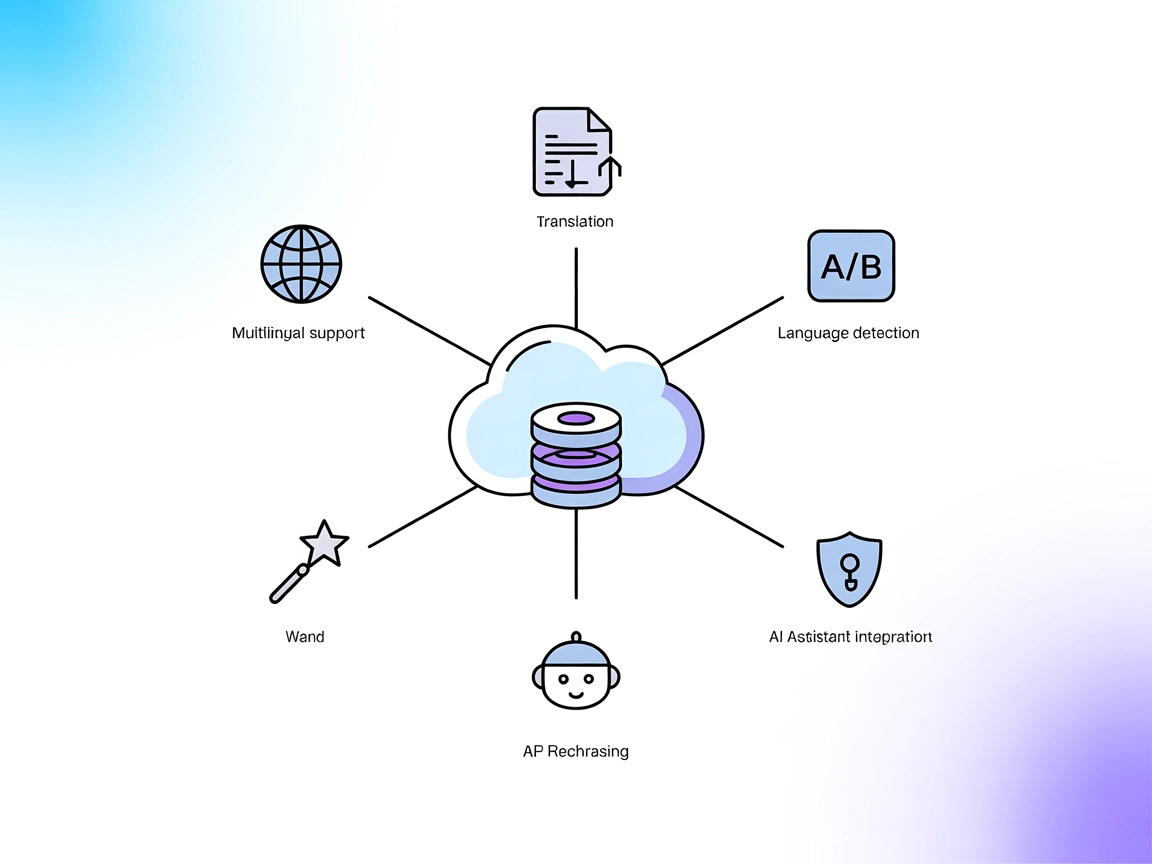

O DeepL MCP Server integra recursos avançados de tradução, reformulação e detecção de idioma aos fluxos de trabalho de IA via API DeepL. Ele potencializa o Flow...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.