Metaprompt

Un metaprompt în inteligența artificială este o instrucțiune la nivel înalt concepută pentru a genera sau îmbunătăți alte prompturi pentru modelele lingvistice ...

Stăpânește optimizarea prompturilor pentru AI, creând prompturi clare și bogate în context pentru a îmbunătăți calitatea rezultatelor, a reduce costurile și a scurta timpul de procesare. Explorează tehnici pentru fluxuri de lucru AI mai inteligente.

Optimizarea prompturilor înseamnă să rafinezi inputul pe care îl oferi unui model AI, astfel încât acesta să livreze răspunsuri cât mai precise și eficiente. Nu este vorba doar despre comunicare clară—prompturile optimizate reduc și consumul computațional, ducând la timpi de procesare mai rapizi și costuri mai mici. Indiferent dacă scrii întrebări pentru chatbot-uri de suport clienți sau generezi rapoarte complexe, modul în care structurezi și formulezi prompturile contează.

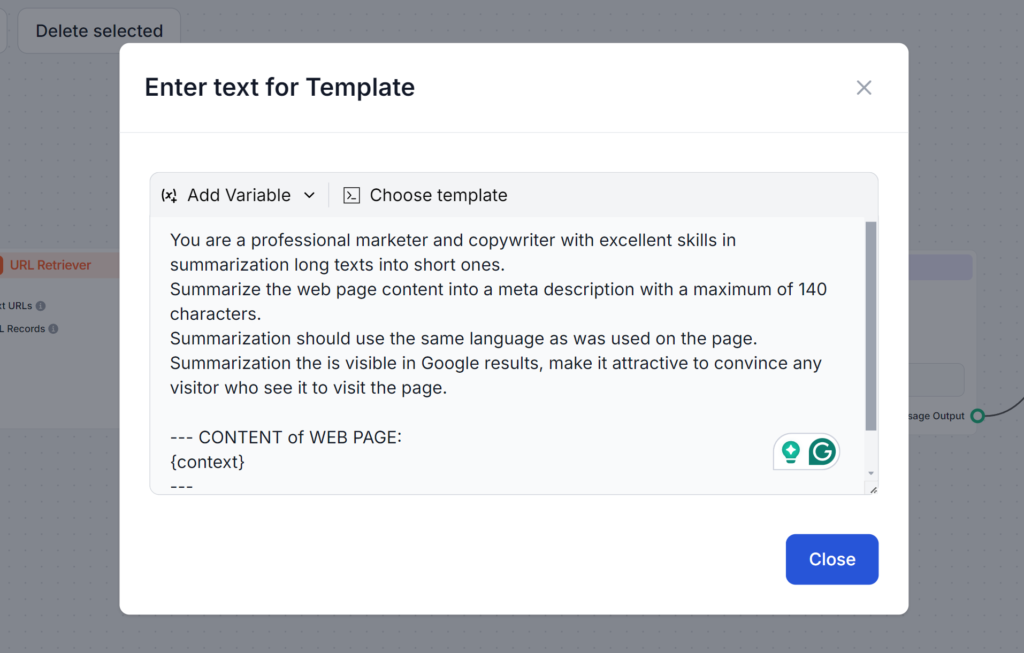

Ai încercat vreodată să ceri unui AI să scrie o meta descriere? Cel mai probabil, primul tău prompt a sunat cam așa:

Scrie-mi o meta descriere pentru subiectul optimizării prompturilor.

Acest prompt este greșit din mai multe motive. Dacă nu specifici lungimea de 140 de caractere cerută de Google, AI-ul va depăși această limită. Dacă totuși respectă lungimea, deseori va folosi un stil diferit sau va fi prea descriptiv și plictisitor pentru a atrage click-uri. În plus, fără să citească articolul tău, poate produce doar meta descrieri vagi.

Vezi promptul de mai jos. Este mai lung și folosește mai multe tehnici pe care le vom învăța în acest articol. Ce face bine acest prompt este că abordează toate posibilele probleme, asigurându-se că vei obține exact rezultatul dorit din prima încercare:

Tokenii sunt unitățile de bază ale textului pe care modelele AI le procesează. Modelele sparg textul în acești tokeni. Un singur token poate fi un cuvânt, mai multe cuvinte sau chiar o fracțiune de cuvânt. Mai mulți tokeni înseamnă, de obicei, răspunsuri mai lente și costuri de procesare mai mari. Așadar, înțelegerea modului în care funcționează tokenii este esențială pentru a crea prompturi mai bune, rentabile și rapide.

De ce contează tokenii:

De exemplu:

În promptul cu mulți tokeni, AI-ul trebuie să intre în detalii despre toate opțiunile posibile, pe când promptul scurt cere doar o prezentare generală. Văzând această prezentare, poți detalia ulterior în funcție de nevoie, ajungând la rezultatul dorit mai rapid și mai ieftin.

Crearea de prompturi eficiente necesită claritate, context și creativitate. Este recomandat să încerci diferite formate pentru a descoperi cele mai eficiente metode de a solicita AI-ului. Iată câteva tehnici esențiale:

Prompturile ambigue pot deruta modelul. Un prompt bine structurat asigură că AI-ul îți înțelege intenția.

Exemplu:

Includerea detaliilor relevante ajută AI-ul să genereze răspunsuri adaptate nevoilor tale.

Exemplu:

Adăugarea de exemple ghidează AI-ul în a înțelege formatul sau tonul dorit.

Exemplu:

Utilizarea șabloanelor standardizate pentru sarcini similare asigură consistență și economisește timp.

Exemplu de șablon pentru crearea de articole:

“Scrie un articol de [număr de cuvinte] despre [subiect], concentrându-te pe [detalii specifice]. Folosește un ton prietenos și include [cuvinte cheie].”

Mai multe strategii avansate te pot ajuta să îți duci prompturile la următorul nivel. Aceste tehnici merg dincolo de claritatea și structura de bază, permițându-ți să gestionezi sarcini complexe, să integrezi date dinamice și să adaptezi răspunsurile AI pentru domenii sau nevoi specifice. Iată o scurtă prezentare a fiecărei tehnici, cu exemple practice care să te ghideze.

Few-shot learning presupune să oferi câteva exemple în cadrul promptului pentru a ajuta AI-ul să înțeleagă modelul sau formatul dorit. Permite modelului să generalizeze eficient cu date minime, fiind ideal pentru sarcini noi sau necunoscute.

Pur și simplu oferă câteva exemple în prompt pentru a-i arăta modelului la ce te aștepți.

Exemplu de prompt:

Tradu următoarele fraze în franceză:

Înlanțuirea prompturilor presupune împărțirea sarcinilor complexe în pași mai mici și mai ușor de gestionat, care se succed logic. Această metodă permite AI-ului să abordeze probleme cu mai multe etape sistematic, asigurând claritate și precizie în rezultate.

Exemplu de prompt:

Recuperarea contextuală presupune integrarea de informații relevante și actualizate în prompt, fie prin referire la surse externe, fie prin sumarizarea unor date cheie. Astfel, oferi AI-ului acces la date corecte și recente pentru răspunsuri informate.

Exemplu:

“Folosind datele din acest raport [inserează link], rezumă principalele concluzii privind tendințele energiei regenerabile [trends.”]

Ajustarea cu embeddings personalizează modelul AI pentru sarcini sau domenii specifice folosind reprezentări specializate de date. Această personalizare îmbunătățește relevanța și acuratețea răspunsurilor în aplicații de nișă sau din industrie.

Gestionarea tokenilor îți permite să controlezi cât de rapid și eficient din punct de vedere al costurilor procesează AI-ul inputurile și outputurile. Reducând numărul de tokeni procesați, poți economisi costuri și obține răspunsuri mai rapide fără să sacrifici calitatea. Iată tehnici pentru o gestionare eficientă a tokenilor:

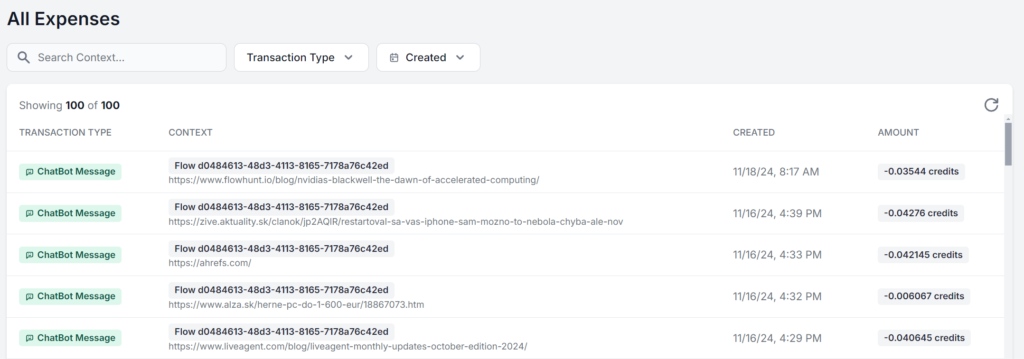

Optimizarea nu se oprește la scrierea unor prompturi mai bune. Monitorizează constant performanța și ajustează pe baza feedbackului primit. Această urmărire continuă permite rafinarea susținută, oferindu-ți șansa de a face modificări informate.

Concentrează-te pe aceste aspecte cheie:

Cea mai bună abordare este să lucrezi într-o interfață care îți permite să vezi și să analizezi exact utilizarea pentru fiecare prompt. Iată același flux de lucru AI FlowHunt rulat de 5 ori, cu schimbarea doar a materialului sursă. Diferența de cost este de doar câțiva cenți, dar pe măsură ce solicitările se adună, diferența devine rapid vizibilă:

Indiferent dacă vrei doar să profiți la maximum de limita gratuită a modelelor AI sau să-ți construiești o strategie AI la scară, optimizarea prompturilor este esențială pentru oricine folosește AI. Aceste tehnici îți permit să utilizezi AI eficient, să obții rezultate precise și să reduci costurile.

Pe măsură ce tehnologia AI avansează, importanța comunicării clare și optimizate cu modelele va crește. Începe să experimentezi aceste strategii chiar de azi, gratuit. FlowHunt îți permite să construiești cu diverse modele și capabilități AI într-un singur tablou de bord, pentru fluxuri de lucru optimizate și eficiente indiferent de sarcină. Încearcă perioada de probă gratuită de 14 zile !

Optimizarea prompturilor presupune rafinarea inputului pe care îl oferi unui model AI, astfel încât să livreze răspunsuri cât mai precise și eficiente. Prompturile optimizate reduc consumul computațional, ducând la timpi de procesare mai rapizi și costuri mai mici.

Numărul de tokeni influențează atât viteza, cât și costul rezultatelor AI. Mai puțini tokeni duc la răspunsuri mai rapide și costuri mai mici, iar prompturile concise ajută modelele să se concentreze pe detaliile relevante.

Tehnicile avansate includ few-shot learning, înlănțuirea prompturilor, recuperarea contextuală și ajustarea cu embeddings. Aceste metode ajută la rezolvarea sarcinilor complexe, integrarea datelor dinamice și adaptarea răspunsurilor la nevoi specifice.

Monitorizează acuratețea răspunsurilor, consumul de tokeni și timpii de procesare. Urmărirea regulată și iterarea pe baza feedbackului ajută la rafinarea prompturilor și menținerea eficienței.

FlowHunt oferă instrumente și un tablou de bord pentru a construi, testa și optimiza prompturi AI, permițându-ți să experimentezi cu diverse modele și strategii pentru fluxuri de lucru AI eficiente.

Maria este copywriter la FlowHunt. Pasionată de limbă și activă în comunități literare, ea știe foarte bine că inteligența artificială transformă modul în care scriem. În loc să se împotrivească, caută să ajute la definirea echilibrului perfect între fluxurile de lucru AI și valoarea de neînlocuit a creativității umane.

Începe să construiești fluxuri de lucru AI optimizate cu FlowHunt. Experimentează cu ingineria prompturilor și crește-ți productivitatea.

Un metaprompt în inteligența artificială este o instrucțiune la nivel înalt concepută pentru a genera sau îmbunătăți alte prompturi pentru modelele lingvistice ...

Stăpânește prompturile pentru chatbot AI cu ghidul nostru cuprinzător. Află despre cadrul CARE, tehnici de prompt engineering și cele mai bune practici pentru a...

Promptarea recursivă este o tehnică AI folosită cu modele lingvistice mari precum GPT-4, permițând utilizatorilor să rafineze iterativ rezultatele prin dialog r...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.