Ce este componenta LLM Meta AI?

Componenta LLM Meta AI conectează familia de modele Claude la Flow-ul tău. Deși Generatorii și Agenții sunt locul unde are loc magia, componentele LLM îți permit să controlezi modelul folosit. Toate componentele vin implicit cu ChatGPT-4. Poți conecta această componentă dacă dorești să schimbi modelul sau să ai mai mult control asupra acestuia.

Amintește-ți că conectarea unei componente LLM este opțională. Toate componentele care folosesc un LLM vin cu ChatGPT-4o ca implicit. Componentele LLM îți permit să schimbi modelul și să controlezi setările acestuia.

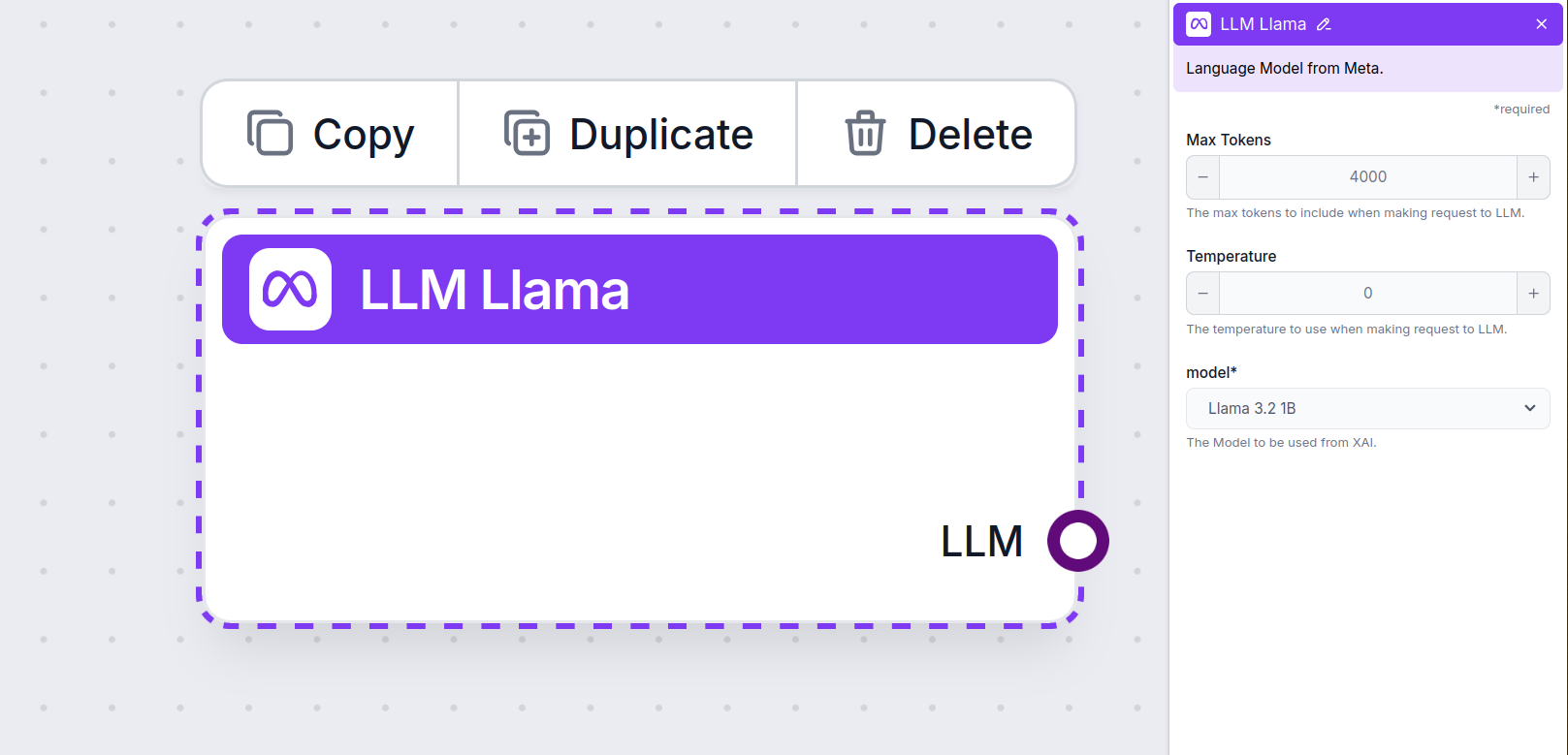

Setările componentei LLM Meta AI

Număr maxim de tokeni

Tokenii reprezintă unitățile individuale de text pe care modelul le procesează și generează. Utilizarea tokenilor variază în funcție de modele, iar un singur token poate fi orice, de la cuvinte sau sub-cuvinte, până la un singur caracter. Modelele sunt, de obicei, tarifate la milioane de tokeni.

Setarea pentru numărul maxim de tokeni limitează numărul total de tokeni care pot fi procesați într-o singură interacțiune sau cerere, asigurând că răspunsurile sunt generate în limite rezonabile. Limita implicită este de 4.000 de tokeni, dimensiunea optimă pentru rezumarea documentelor și a mai multor surse pentru a genera un răspuns.

Temperatura

Temperatura controlează variabilitatea răspunsurilor, variind de la 0 la 1.

O temperatură de 0.1 va face răspunsurile foarte la obiect, dar potențial repetitive și deficitare.

O temperatură ridicată de 1 permite maximă creativitate în răspunsuri, dar crește riscul de răspunsuri irelevante sau chiar halucinatorii.

De exemplu, temperatura recomandată pentru un bot de servicii clienți este între 0.2 și 0.5. Acest nivel ar trebui să mențină răspunsurile relevante și la subiect, permițând totodată o variație naturală a răspunsurilor.

Model

Aceasta este selecția modelului. Aici vei găsi toate modelele Meta AI acceptate. Suportăm modelele open-source Llama de la Meta, ușoare și eficiente. Aceste modele sunt proiectate pentru implementări eficiente pe dispozitive și la marginea rețelei:

- Llama 3.2 1B – Modelul 1B conține aproximativ 1,23 miliarde de parametri, cu o lungime a contextului de până la 128.000 de tokeni. Modelul este optimizat pentru sarcini precum rezumare, urmărire de instrucțiuni și rescriere, fiind potrivit pentru aplicații mobile și dispozitive embedded. Află mai multe despre acest model și modul său de funcționare în acest articol.

- Llama 3.2. 3B – Modelul 3B are aproximativ 3,21 miliarde de parametri și o lungime a contextului de până la 128.000 de tokeni. Descoperă cum gestionează acest model diverse sarcini.

Cum adaugi LLM Meta AI în Flow-ul tău

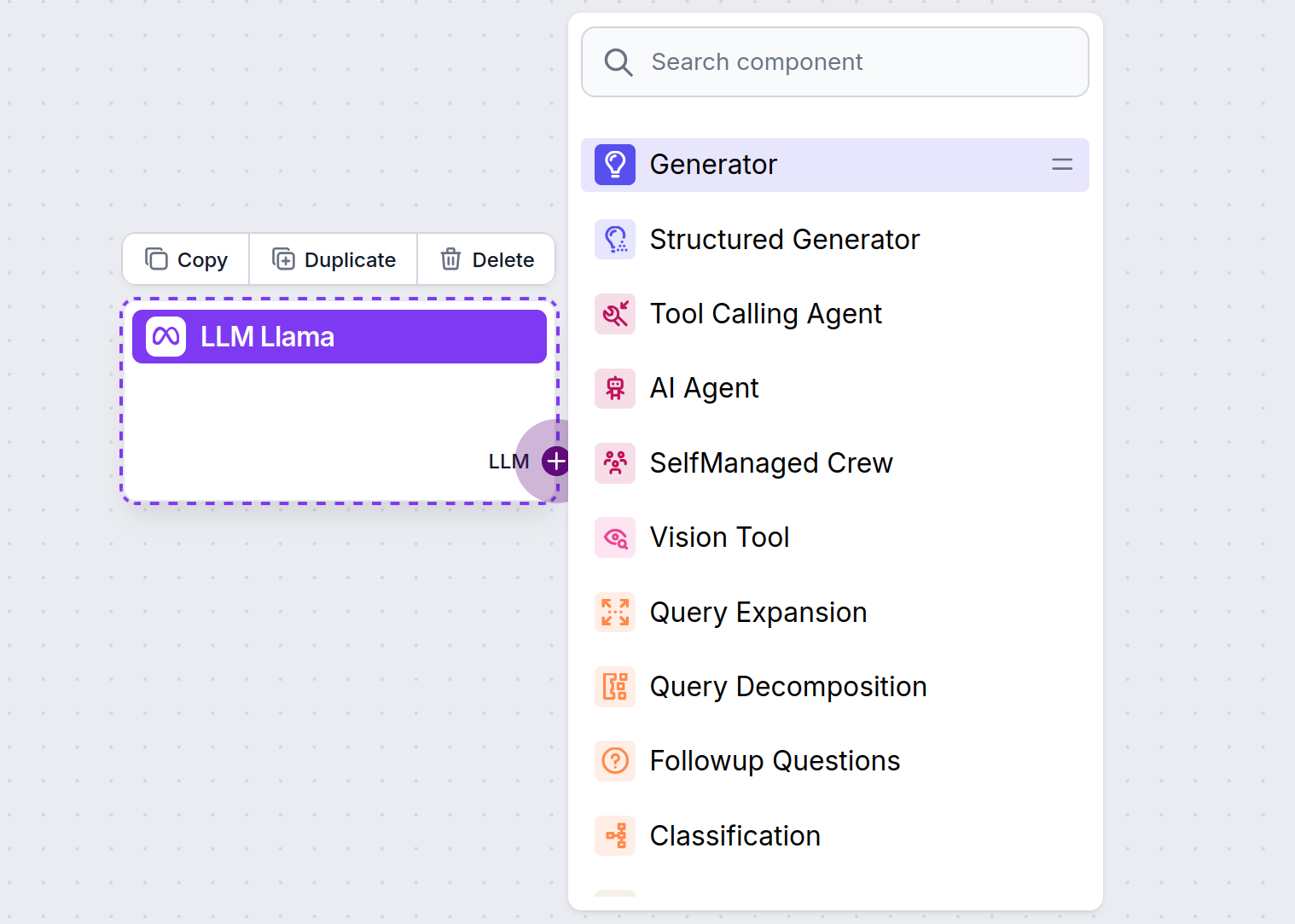

Vei observa că toate componentele LLM au doar un punct de ieșire (output handle). Input-ul nu trece prin componentă, deoarece aceasta reprezintă doar modelul, în timp ce generarea efectivă are loc în AI Agenți și Generatoare.

Punctul de ieșire LLM este întotdeauna mov. Punctul de input LLM se găsește pe orice componentă care folosește AI pentru a genera text sau a procesa date. Poți vedea opțiunile făcând clic pe punct:

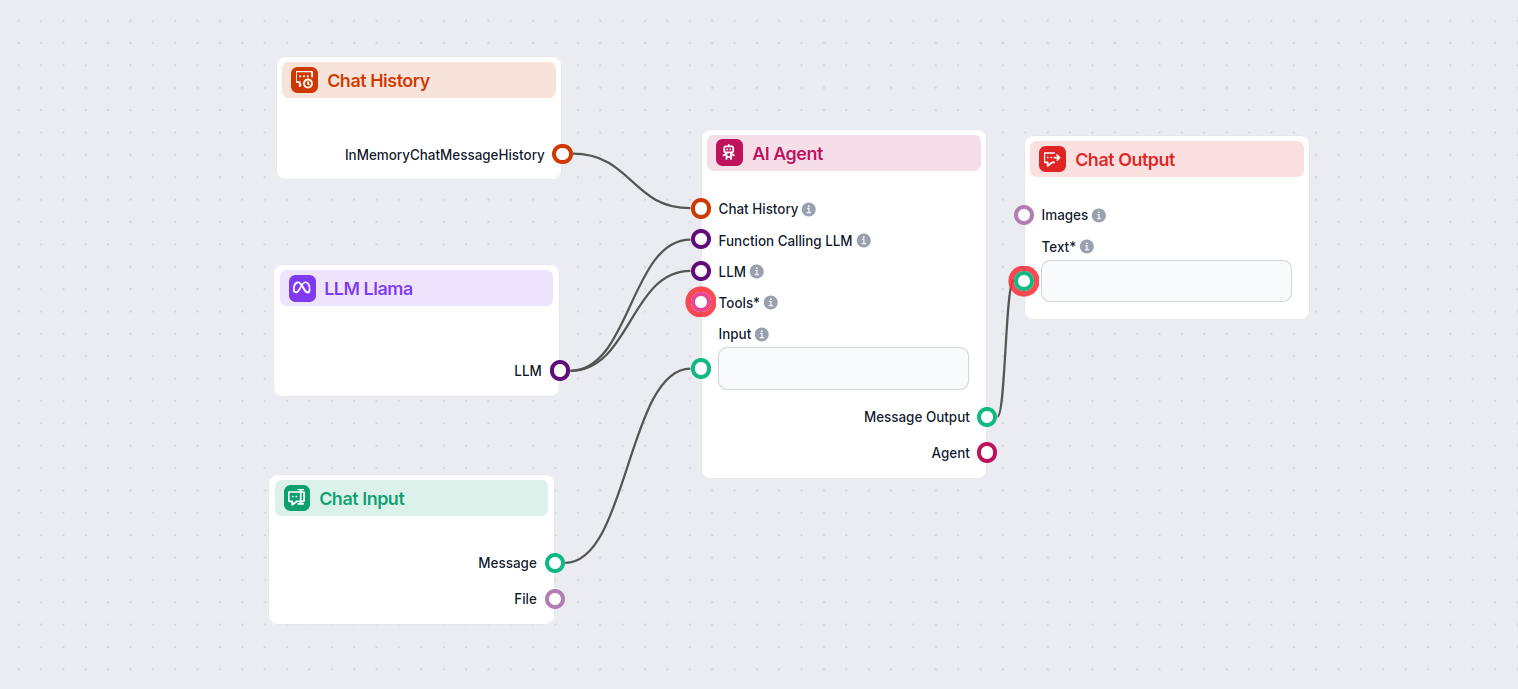

Aceasta îți permite să creezi tot felul de instrumente. Să vedem componenta în acțiune. Iată un Flow simplu de chatbot AI Agent care folosește Llama 3.2 1B de la Meta AI pentru a genera răspunsuri. Îl poți considera ca pe un chatbot Llama de bază.

Acest Flow simplu de Chatbot include:

- Input chat: Reprezintă mesajul pe care un utilizator îl trimite în chat.

- Istoric chat: Asigură că chatbot-ul își poate aminti și lua în considerare răspunsurile anterioare.

- Output chat: Reprezintă răspunsul final al chatbot-ului.

- AI Agent: Un agent AI autonom care generează răspunsuri.

- LLM Meta AI: Conexiunea la modelele de generare text de la Meta.