Integrare Zoom MCP Server

Zoom MCP Server permite gestionarea automată, bazată pe AI, a întâlnirilor Zoom în FlowHunt și alte platforme AI. Permite programarea, actualizarea, preluarea ș...

Conectează-ți agenții AI la infrastructura MLOps a ZenML folosind ZenML MCP Server pentru controlul pipeline-urilor în timp real, explorarea artefactelor și fluxuri ML optimizate.

FlowHunt oferă un strat suplimentar de securitate între sistemele dvs. interne și instrumentele AI, oferindu-vă control granular asupra instrumentelor care sunt accesibile de la serverele dvs. MCP. Serverele MCP găzduite în infrastructura noastră pot fi integrate fără probleme cu chatbotul FlowHunt, precum și cu platforme AI populare precum ChatGPT, Claude și diverși editori AI.

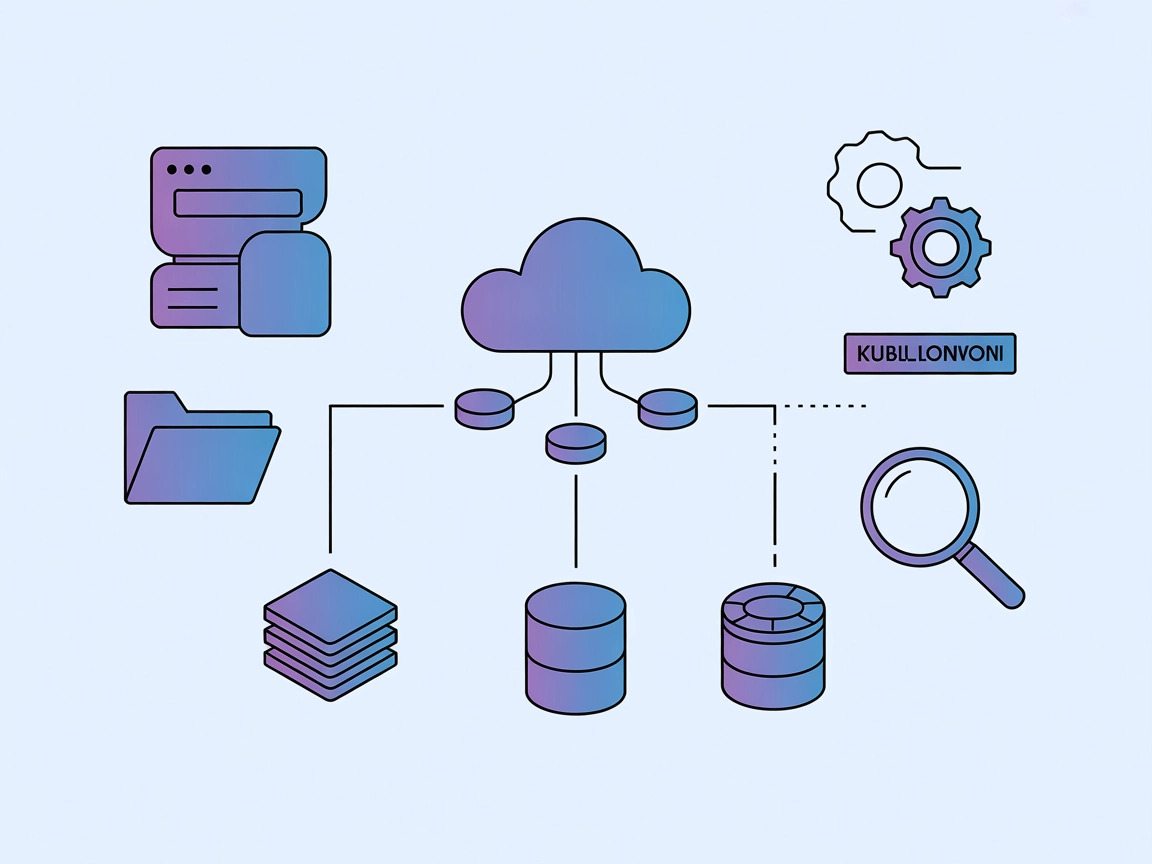

ZenML MCP Server este o implementare a Model Context Protocol (MCP) care acționează ca o punte între asistenții AI (precum Cursor, Claude Desktop și alții) și pipeline-urile tale ZenML MLOps și LLMOps. Prin expunerea API-ului ZenML prin standardul MCP, permite clienților AI să acceseze informații în timp real despre utilizatori, pipeline-uri, execuții, pași, servicii și multe altele dintr-un server ZenML. Această integrare permite dezvoltatorilor și fluxurilor AI să interogheze metadate, să declanșeze noi execuții de pipeline și să interacționeze direct cu funcțiile de orchestrare ale ZenML prin instrumente AI compatibile. ZenML MCP Server este deosebit de util pentru creșterea productivității, conectând asistenții bazați pe LLM la o infrastructură MLOps robustă și facilitând sarcinile din întreg ciclul de viață ML.

Nu am găsit informații despre șabloane de prompt în repository.

Nu au fost găsite instrucțiuni explicite pentru Windsurf; folosește configurarea generică MCP:

uv sunt instalate.{

"mcpServers": {

"zenml": {

"command": "/usr/local/bin/uv",

"args": ["run", "/path/to/zenml_server.py"],

"env": {

"LOGLEVEL": "INFO",

"NO_COLOR": "1",

"PYTHONUNBUFFERED": "1",

"PYTHONIOENCODING": "UTF-8",

"ZENML_STORE_URL": "https://your-zenml-server-goes-here.com",

"ZENML_STORE_API_KEY": "your-api-key-here"

}

}

}

}

Notă: Protejează cheile API prin setarea lor în secțiunea env ca în exemplul de mai sus.

{

"mcpServers": {

"zenml": {

"command": "/usr/local/bin/uv",

"args": ["run", "/path/to/zenml_server.py"],

"env": {

"LOGLEVEL": "INFO",

"NO_COLOR": "1",

"PYTHONUNBUFFERED": "1",

"PYTHONIOENCODING": "UTF-8",

"ZENML_STORE_URL": "https://your-zenml-server-goes-here.com",

"ZENML_STORE_API_KEY": "your-api-key-here"

}

}

}

}

Notă: Păstrează cheile API întotdeauna în siguranță, în variabilele de mediu, ca mai sus.

{

"mcpServers": {

"zenml": {

"command": "/usr/local/bin/uv",

"args": ["run", "/path/to/zenml_server.py"],

"env": {

"LOGLEVEL": "INFO",

"NO_COLOR": "1",

"PYTHONUNBUFFERED": "1",

"PYTHONIOENCODING": "UTF-8",

"ZENML_STORE_URL": "https://your-zenml-server-goes-here.com",

"ZENML_STORE_API_KEY": "your-api-key-here"

}

}

}

}

Notă: Cheile API trebuie setate prin variabile de mediu în secțiunea env pentru securitate.

Nu au fost găsite instrucțiuni explicite pentru Cline; folosește configurarea generică MCP:

{

"mcpServers": {

"zenml": {

"command": "/usr/local/bin/uv",

"args": ["run", "/path/to/zenml_server.py"],

"env": {

"LOGLEVEL": "INFO",

"NO_COLOR": "1",

"PYTHONUNBUFFERED": "1",

"PYTHONIOENCODING": "UTF-8",

"ZENML_STORE_URL": "https://your-zenml-server-goes-here.com",

"ZENML_STORE_API_KEY": "your-api-key-here"

}

}

}

}

Notă: Protejează cheile API în secțiunea env ca mai sus.

Securizarea Cheilor API:

Setează cheia API ZenML și URL-ul serverului în siguranță folosind variabile de mediu în secțiunea env din config, ca în exemplele JSON de mai sus.

Utilizarea MCP în FlowHunt

Pentru a integra serverele MCP în fluxul tău FlowHunt, începe prin a adăuga componenta MCP în flux și conecteaz-o la agentul AI:

Dă click pe componenta MCP pentru a deschide panoul de configurare. În secțiunea de configurare sistem MCP, inserează detaliile serverului MCP folosind acest format JSON:

{

"zenml": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Odată configurat, agentul AI va putea folosi acest MCP ca instrument cu acces la toate funcțiile și capabilitățile sale. Amintește-ți să schimbi „zenml” cu numele adevărat al serverului tău MCP și să înlocuiești URL-ul cu cel al serverului tău MCP.

| Secțiune | Disponibilitate | Detalii/Note |

|---|---|---|

| Prezentare generală | ✅ | |

| Listă de Prompts | ⛔ | Nu a fost găsită în repo |

| Listă de Resurse | ✅ | Acoperă resursele expuse de API-ul ZenML |

| Listă de Instrumente | ✅ | Declanșare pipeline, citire metadate etc. |

| Securizarea Cheilor API | ✅ | Exemplu de config oferit |

| Suport Sampling (mai puțin relevant la evaluare) | ⛔ | Nu este menționat |

Pe baza tabelelor de mai sus, serverul ZenML MCP oferă documentație amplă, instrucțiuni clare de instalare și expune o gamă largă de resurse și instrumente. Totuși, lipsesc documentația pentru șabloane de prompt și nu este menționat explicit sampling sau roots support. Repository-ul este activ, cu un număr permisiv de stele și fork-uri, dar unele funcții MCP avansate nu sunt acoperite.

| Are LICENSE | ⛔ (nu este afișat în fișierele disponibile) |

|---|---|

| Are cel puțin un instrument | ✅ |

| Număr de Fork-uri | 8 |

| Număr de Stele | 18 |

ZenML MCP Server realizează legătura dintre asistenții AI și pipeline-urile tale ZenML MLOps și LLMOps, expunând API-ul ZenML prin Model Context Protocol. Acest lucru permite instrumentelor AI să interogheze metadatele pipeline-urilor, să gestioneze execuțiile și să interacționeze direct cu infrastructura ZenML.

Oferă acces la utilizatori, stack-uri, pipeline-uri, execuții de pipeline, pași, servicii, componente stack, flavors, șabloane de rulare pipeline, programări, artefacte, conectori de servicii, cod pas și loguri. Permite de asemenea declanșarea de noi execuții de pipeline și citirea metadatelor din obiectele serverului ZenML.

Păstrează întotdeauna cheia API ZenML și URL-ul serverului în siguranță, folosind variabile de mediu în secțiunea `env` a configurației MCP, așa cum este prezentat în exemplele de configurare pentru fiecare client.

Cazurile tipice includ monitorizarea și controlul pipeline-urilor, declanșarea de noi execuții, explorarea resurselor și artefactelor, vizualizarea detaliilor stack-urilor și serviciilor și generarea de rapoarte automate prin intermediul asistenților AI.

Documentația despre șabloane de prompt și funcționalitatea sampling nu sunt disponibile în prezent în integrarea ZenML MCP Server.

Permite asistenților tăi AI să orchestreze, monitorizeze și să gestioneze instant pipeline-urile ML conectând FlowHunt la ZenML MCP Server.

Zoom MCP Server permite gestionarea automată, bazată pe AI, a întâlnirilor Zoom în FlowHunt și alte platforme AI. Permite programarea, actualizarea, preluarea ș...

Serverul MCP interactive-mcp permite fluxuri de lucru AI fără întreruperi, cu implicarea omului, făcând legătura între agenții AI, utilizatori și sisteme extern...

Kubernetes MCP Server creează o punte între asistenții AI și clusterele Kubernetes/OpenShift, permițând gestionarea programatică a resurselor, operarea podurilo...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.