Prompt (PromptTemplate-xAz1P)

Skapa en promptmall med dynamiska variabler ({input}, {human_input}, {context}, {chat_history}, {system_message}, {all_input_variables}).

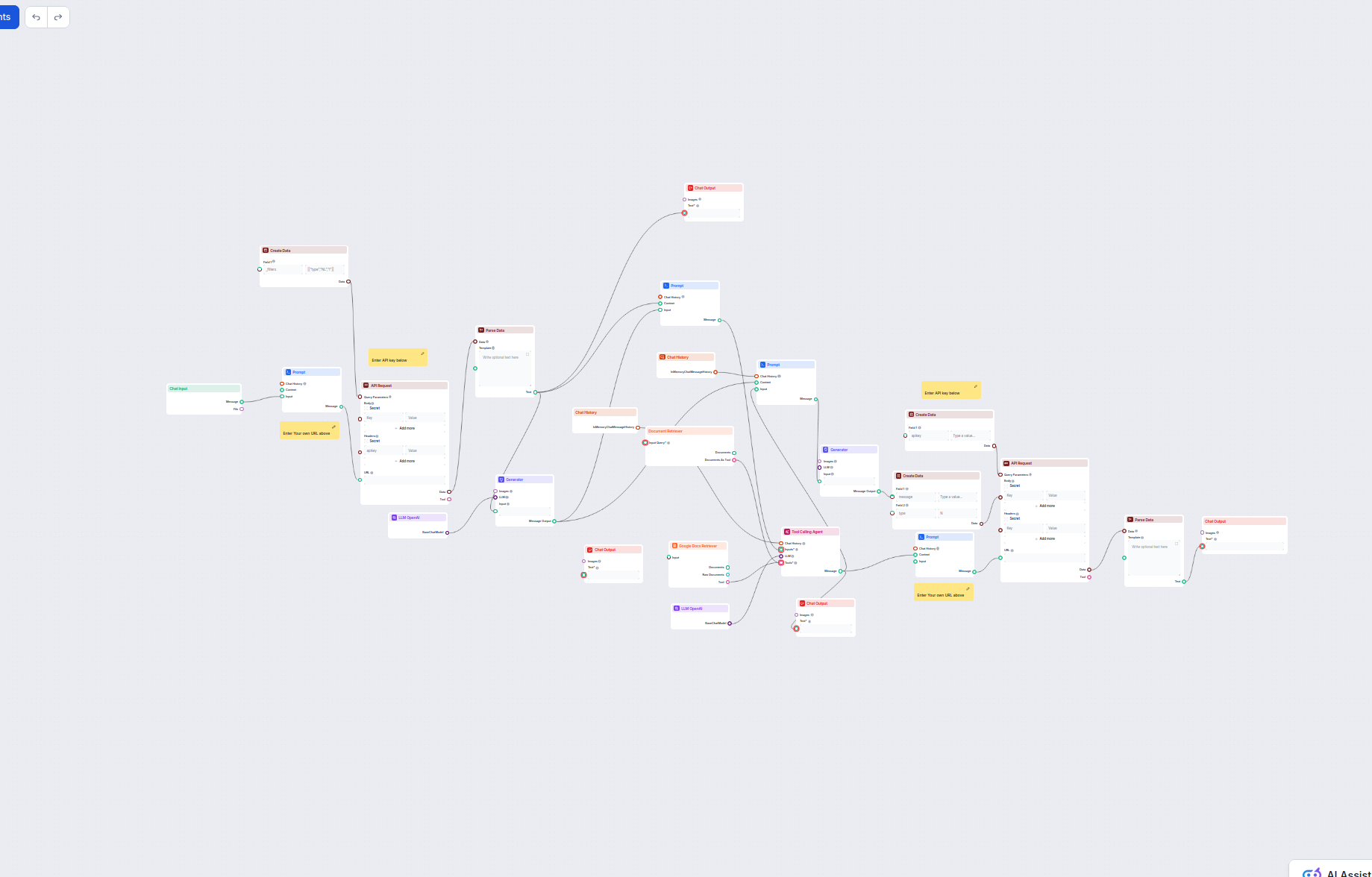

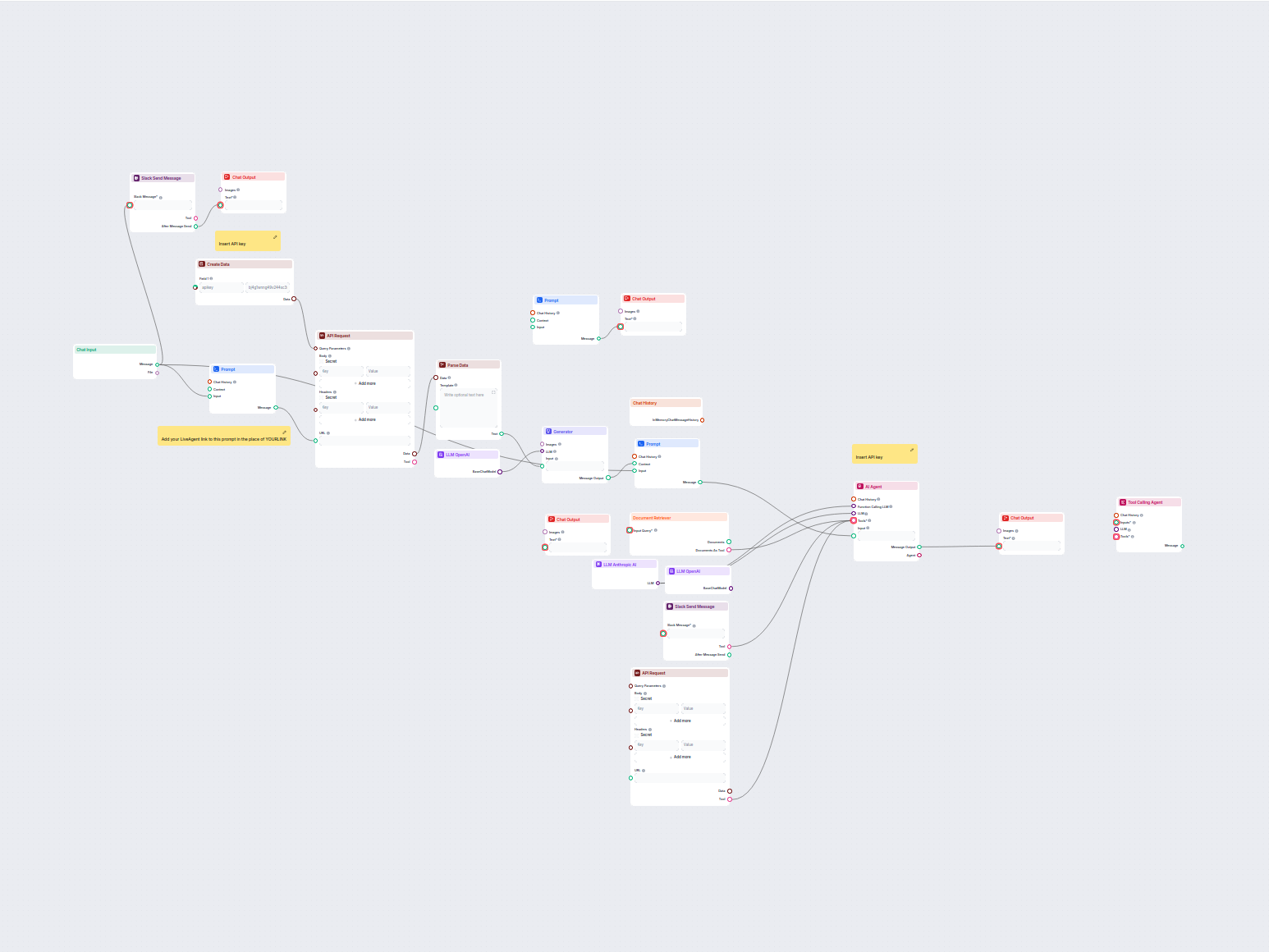

Detta AI-drivna arbetsflöde automatiserar kundsupport genom att kombinera intern kunskapsbas-sökning, hämtning av kunskap från Google Docs, API-integration och avancerad språkmodellering. Agenten svarar på slovakiska eller kundens språk, ger alltid uppdaterad information och kan eskalera till mänsklig support vid behov. Perfekt för företag som söker flerspråkig, automatiserad och kontextmedveten kundservice.

Flows

Skapa en promptmall med dynamiska variabler ({input}, {human_input}, {context}, {chat_history}, {system_message}, {all_input_variables}).

Skapa en promptmall med dynamiska variabler ({input}, {human_input}, {context}, {chat_history}, {system_message}, {all_input_variables}).

Skapa en promptmall med dynamiska variabler ({input}, {human_input}, {context}, {chat_history}, {system_message}, {all_input_variables}).

Skapa en promptmall med dynamiska variabler ({input}, {human_input}, {context}, {chat_history}, {system_message}, {all_input_variables}).

Generera text med inmatningsprompt och vald LLM-modell.

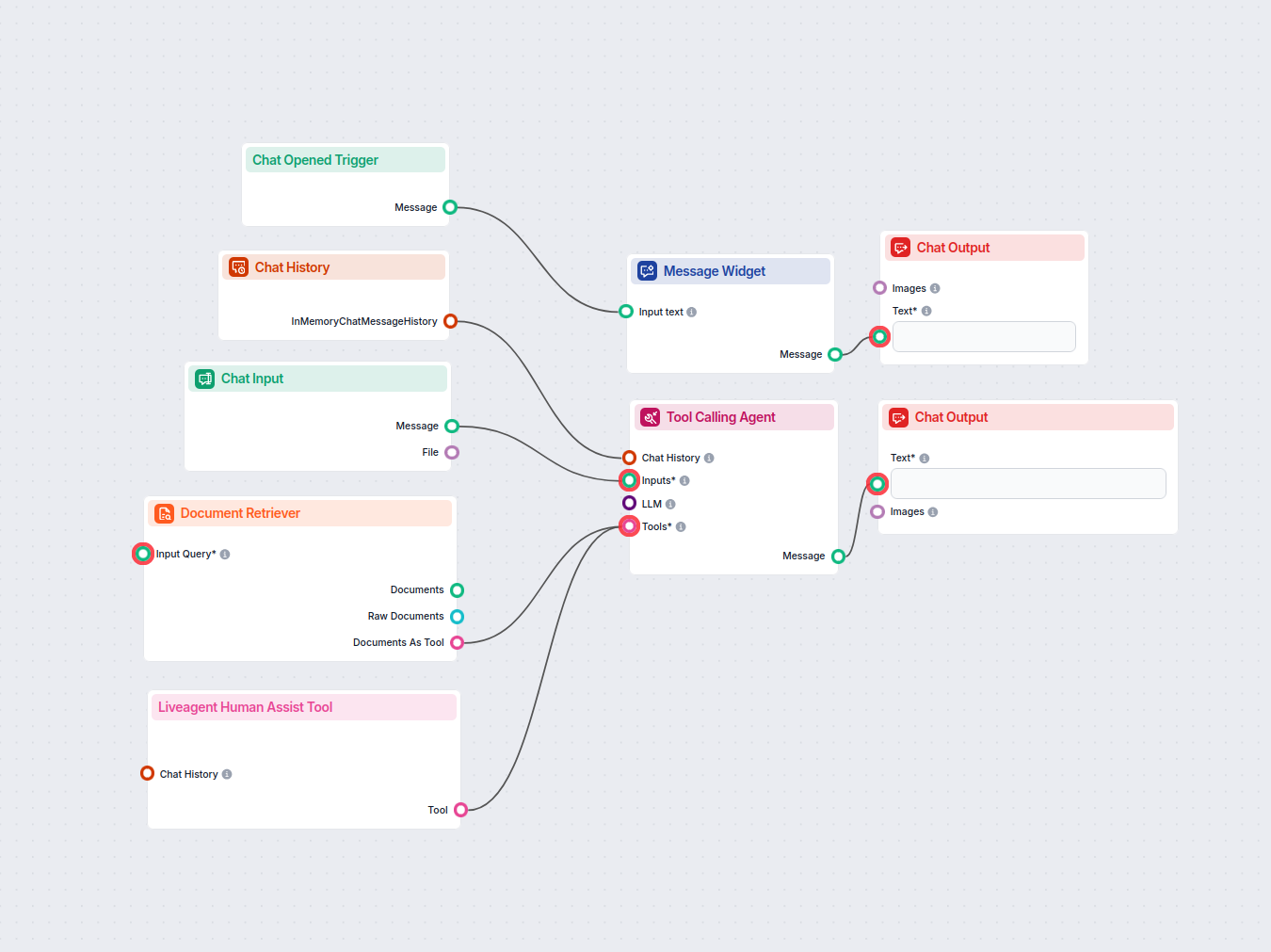

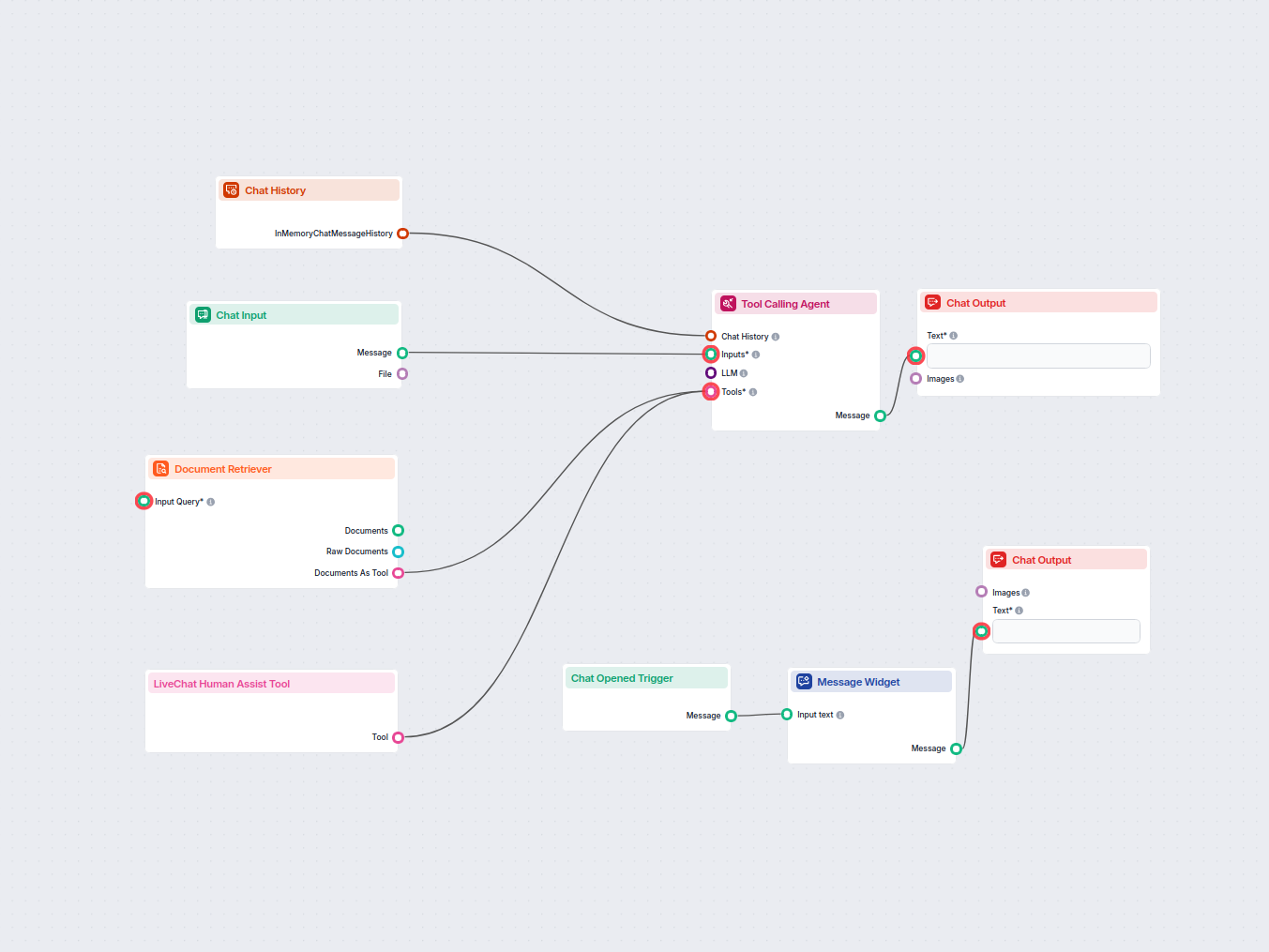

En verktygsanropande agent.

Nedan är en komplett lista över alla komponenter som används i detta flow för att uppnå dess funktionalitet. Komponenter är byggstenarna i varje AI Flow. De låter dig skapa komplexa interaktioner och automatisera uppgifter genom att koppla olika funktioner. Varje komponent tjänar ett specifikt syfte, som att hantera användarindata, bearbeta data eller integrera med externa tjänster.

Chatinmatningskomponenten i FlowHunt initierar användarinteraktioner genom att fånga upp meddelanden från Playground. Den fungerar som startpunkt för flöden och möjliggör att arbetsflödet kan bearbeta både text- och filbaserade indata.

Lär dig hur FlowHunts Prompt-komponent låter dig definiera din AI-bots roll och beteende, vilket säkerställer relevanta och personliga svar. Anpassa prompts och mallar för effektiva, kontextmedvetna chatbotflöden.

Komponenten Skapa Data gör det möjligt att dynamiskt generera strukturerade dataposter med ett anpassningsbart antal fält. Perfekt för arbetsflöden som kräver skapande av nya dataobjekt i realtid, och den stödjer flexibel fältkonfiguration samt sömlös integration med andra automationssteg.

Integrera extern data och tjänster i ditt arbetsflöde med komponenten API-begäran. Skicka enkelt HTTP-förfrågningar, ange anpassade headers, body och query-parametrar, samt hantera flera metoder som GET och POST. Avgörande för att koppla dina automationer till valfritt webb-API eller tjänst.

Komponenten Parsa Data omvandlar strukturerad data till vanlig text med hjälp av anpassningsbara mallar. Den möjliggör flexibel formatering och konvertering av datainmatningar för vidare användning i ditt arbetsflöde, vilket hjälper till att standardisera eller förbereda information för nedströmskomponenter.

Utforska Generator-komponenten i FlowHunt—kraftfull AI-driven textgenerering med din valda LLM-modell. Skapa enkelt dynamiska chatbot-svar genom att kombinera promptar, valfria systeminstruktioner och till och med bilder som indata, vilket gör den till ett kärnverktyg för att bygga intelligenta, konverserande arbetsflöden.

FlowHunt stöder dussintals textgenereringsmodeller, inklusive modeller från OpenAI. Så här använder du ChatGPT i dina AI-verktyg och chatbottar.

Chatthistorik-komponenten i FlowHunt gör det möjligt för chatbots att minnas tidigare meddelanden, vilket säkerställer sammanhängande konversationer och förbättrad kundupplevelse samtidigt som minnes- och tokenanvändning optimeras.

Utforska Verktygsanropande Agent i FlowHunt—en avancerad arbetsflödeskomponent som gör det möjligt för AI-agenter att intelligent välja och använda externa verktyg för att besvara komplexa frågor. Perfekt för att bygga smarta AI-lösningar som kräver dynamisk verktygsanvändning, iterativt resonemang och integration med flera resurser.

FlowHunts Dokumenthämtare förbättrar AI-noggrannheten genom att koppla generativa modeller till dina egna uppdaterade dokument och webbadresser, vilket säkerställer tillförlitliga och relevanta svar med Retrieval-Augmented Generation (RAG).

Integrera dina arbetsflöden med Google Docs med hjälp av Google Docs Retriever-komponenten—hämta enkelt dokumentinnehåll för användning i automationer, chattbottar eller kunskapsarbetsflöden. Perfekt för att få tillgång till, bearbeta och utnyttja dina Google Docs i FlowHunt-flöden.

Upptäck Chattutgång-komponenten i FlowHunt—slutför chatbottsvar med flexibla, flerdelade utdata. Oumbärlig för smidig avslutning av flöden och skapande av avancerade, interaktiva AI-chattbottar.

Flow-beskrivning

Detta arbetsflöde automatiserar processen att hämta kundmeddelanden från ett ärende- eller supportsystem, extrahera det senaste relevanta meddelandet, förstärka det med kontext och chatt-historik och sedan utnyttja avancerad AI (LLMs) i kombination med kunskapsverktyg för att generera professionella, flerspråkiga kundsupportssvar. Processen förbereder och skickar sedan dessa svar tillbaka till externa system, vilket gör det idealiskt för att skala och automatisera kundsupport, kunskapshämtning och extern API-integration.

https://arshiakahani.ladesk.com/api/v3/tickets/{input}/messages). Detta möjliggör flexibel hämtning baserat på inkommande användardata.| Komponent | Syfte |

|---|---|

| Chattinmatning | Tar emot användar-/kundmeddelanden |

| Promptmall | Bygger dynamiskt URL:er och meddelandeprompter |

| API-förfrågan | Hämtar ärendedata/meddelanden från externt system |

| Tolka data | Omvandlar strukturerad data till vanlig text |

| OpenAI LLM | Extraherar relevanta meddelanden, genererar eller översätter svar |

| Dokumenthämtare | Söker kunskapsbasen för relevant information |

| Google Docs-hämtare | Integrerar externa dokument som kunskap för agenten |

| Verktygsanropande agent | Central AI-supportagent—använder verktyg och chatt-historik |

| Skapa data | Paketerar svar och data för utgående API-förfrågningar |

| Chattutdata | Visar slutresultatet för slutanvändare eller system |

| Anteckningar | Ger operatörsguider (t.ex. var API-nycklar/URL:er matas in) |

Nedan visas en förenklad flödesschema-representation av huvudstegen:

Detta arbetsflöde utgör en robust grund för alla organisationer som vill automatisera och skala kundsupport, teknisk assistans eller informationsleveransflöden som kräver integration med externa API:er, kunskapsbaser och avancerade AI-svar.

Vi hjälper företag som ditt att utveckla smarta chatbotar, MCP-servrar, AI-verktyg eller andra typer av AI-automatisering för att ersätta människor i repetitiva uppgifter i din organisation.

Automatisera din kundsupport med en AI-chatbot som besvarar frågor med hjälp av din interna kunskapsbas och sömlöst kopplar användare till en mänsklig agent via...

Detta arbetsflöde automatiserar kundsupporten för ditt företag genom att integrera LiveAgent-konversationer, extrahera relevanta konversationsdata, generera sva...

Distribuera en AI-driven chattbot på din webbplats som använder din interna kunskapsbas för att besvara kundförfrågningar, och smidigt vidarebefordrar komplexa ...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.