Prompt

Promptmall för att bygga API-förfrågnings-URL med användarens inmatning.

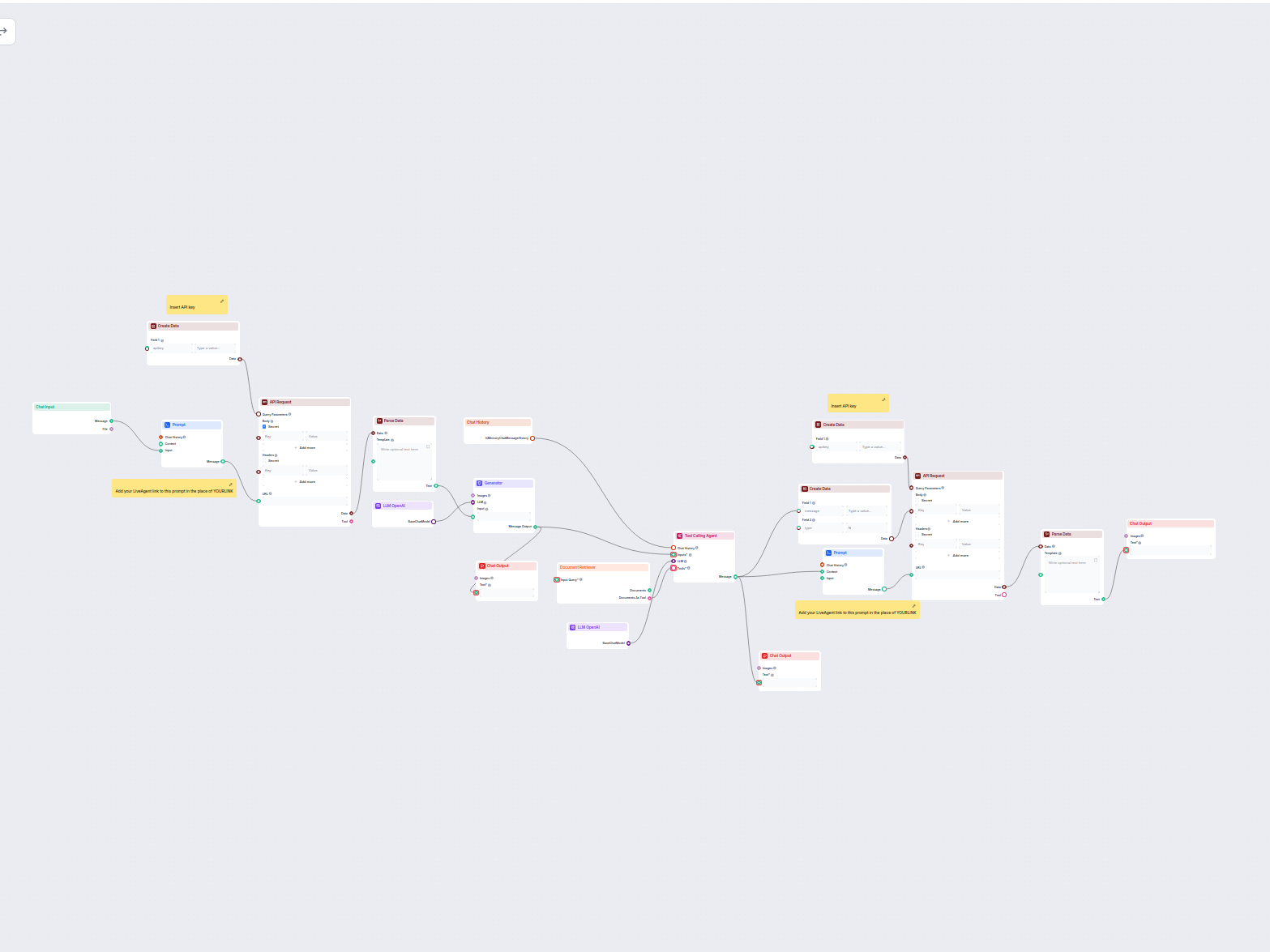

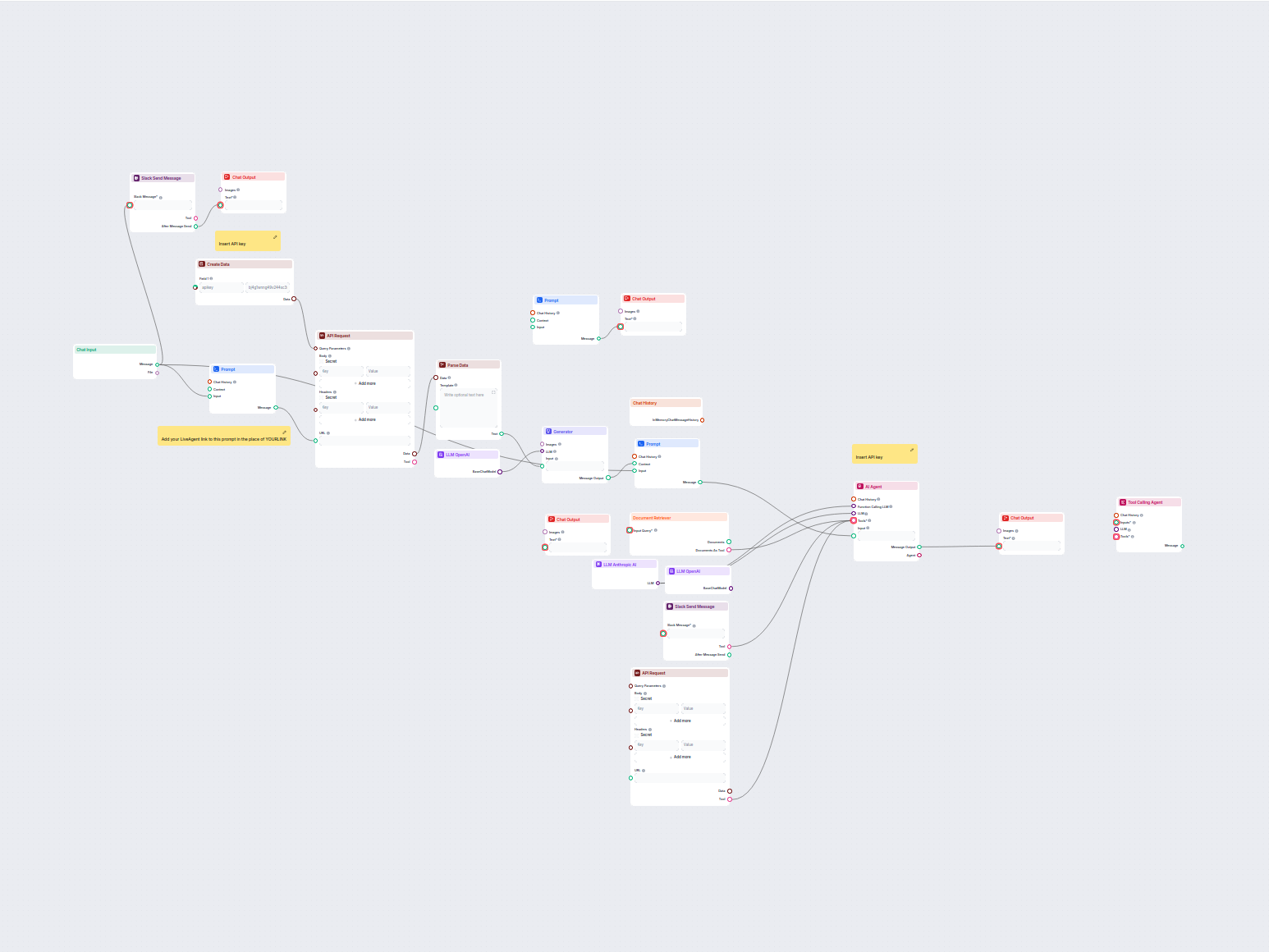

Detta AI-drivna arbetsflöde automatiserar kundtjänst genom att koppla användarfrågor till företagets kunskapskällor, externa API:er (såsom LiveAgent) och en språkmodell för professionella, vänliga och mycket relevanta svar. Flödet hämtar samtalshistorik, använder dokumentsökning och interagerar med externa system för att ge koncisa, strukturerade svar samt eskalerar till mänsklig support vid behov. Perfekt för företag som vill optimera support, produktrekommendationer och informationsleverans.

Flows

Promptmall för att bygga API-förfrågnings-URL med användarens inmatning.

Promptmall för att bygga API-förfrågnings-URL för samtalsmeddelanden.

Systemmeddelande-prompt för LLM att extrahera Preview-avsnittet/-en från indata.

Systemmeddelande-prompt för agenten att agera som kundtjänst- och shoppingassistent för *YOURCOMPANY* på slovakiska, med detaljerade instruktioner om beteende o...

Nedan är en komplett lista över alla komponenter som används i detta flow för att uppnå dess funktionalitet. Komponenter är byggstenarna i varje AI Flow. De låter dig skapa komplexa interaktioner och automatisera uppgifter genom att koppla olika funktioner. Varje komponent tjänar ett specifikt syfte, som att hantera användarindata, bearbeta data eller integrera med externa tjänster.

Chatinmatningskomponenten i FlowHunt initierar användarinteraktioner genom att fånga upp meddelanden från Playground. Den fungerar som startpunkt för flöden och möjliggör att arbetsflödet kan bearbeta både text- och filbaserade indata.

Lär dig hur FlowHunts Prompt-komponent låter dig definiera din AI-bots roll och beteende, vilket säkerställer relevanta och personliga svar. Anpassa prompts och mallar för effektiva, kontextmedvetna chatbotflöden.

Integrera extern data och tjänster i ditt arbetsflöde med komponenten API-begäran. Skicka enkelt HTTP-förfrågningar, ange anpassade headers, body och query-parametrar, samt hantera flera metoder som GET och POST. Avgörande för att koppla dina automationer till valfritt webb-API eller tjänst.

Komponenten Skapa Data gör det möjligt att dynamiskt generera strukturerade dataposter med ett anpassningsbart antal fält. Perfekt för arbetsflöden som kräver skapande av nya dataobjekt i realtid, och den stödjer flexibel fältkonfiguration samt sömlös integration med andra automationssteg.

Komponenten Parsa Data omvandlar strukturerad data till vanlig text med hjälp av anpassningsbara mallar. Den möjliggör flexibel formatering och konvertering av datainmatningar för vidare användning i ditt arbetsflöde, vilket hjälper till att standardisera eller förbereda information för nedströmskomponenter.

Utforska Generator-komponenten i FlowHunt—kraftfull AI-driven textgenerering med din valda LLM-modell. Skapa enkelt dynamiska chatbot-svar genom att kombinera promptar, valfria systeminstruktioner och till och med bilder som indata, vilket gör den till ett kärnverktyg för att bygga intelligenta, konverserande arbetsflöden.

FlowHunt stöder dussintals textgenereringsmodeller, inklusive modeller från OpenAI. Så här använder du ChatGPT i dina AI-verktyg och chatbottar.

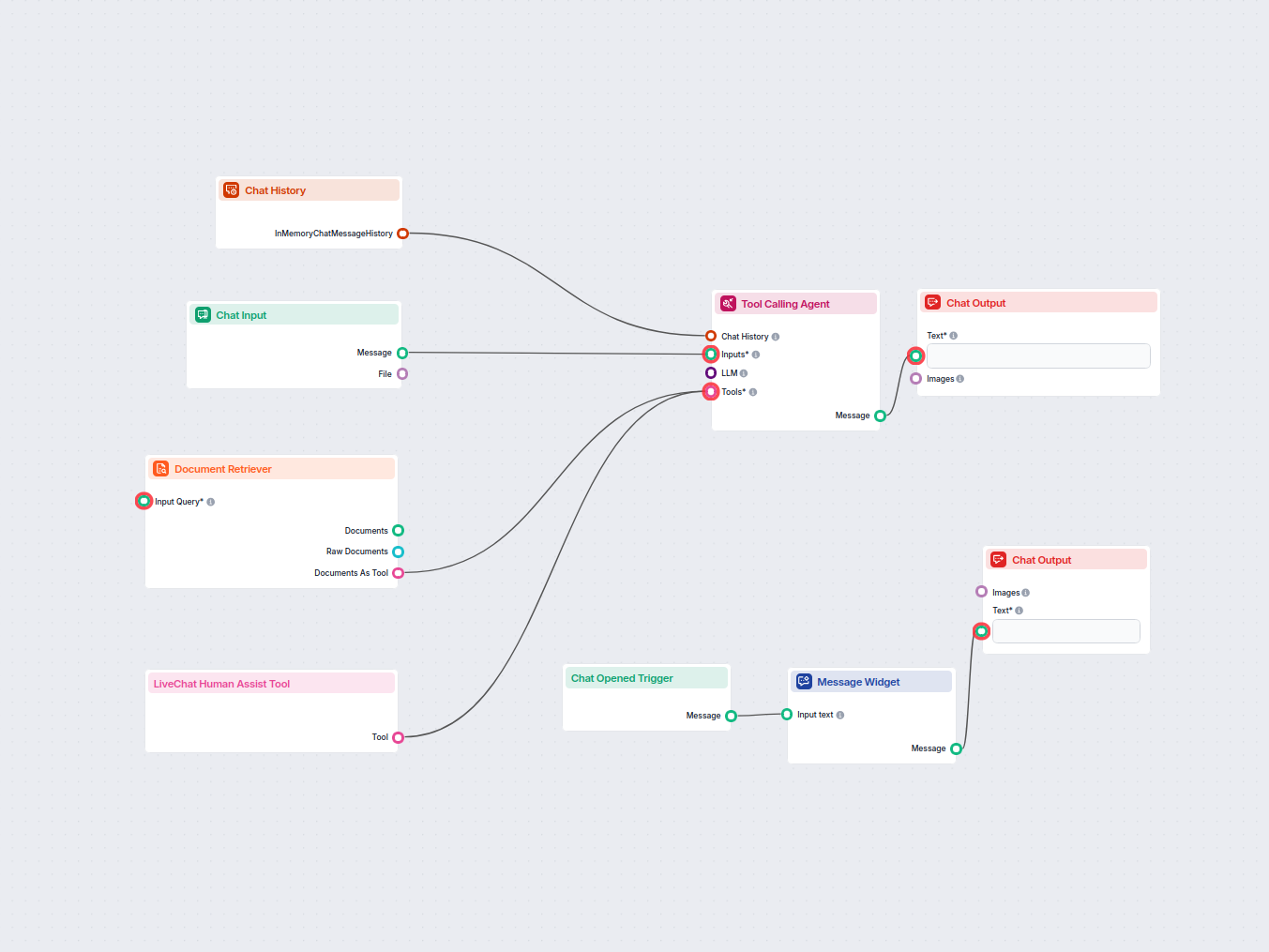

Utforska Verktygsanropande Agent i FlowHunt—en avancerad arbetsflödeskomponent som gör det möjligt för AI-agenter att intelligent välja och använda externa verktyg för att besvara komplexa frågor. Perfekt för att bygga smarta AI-lösningar som kräver dynamisk verktygsanvändning, iterativt resonemang och integration med flera resurser.

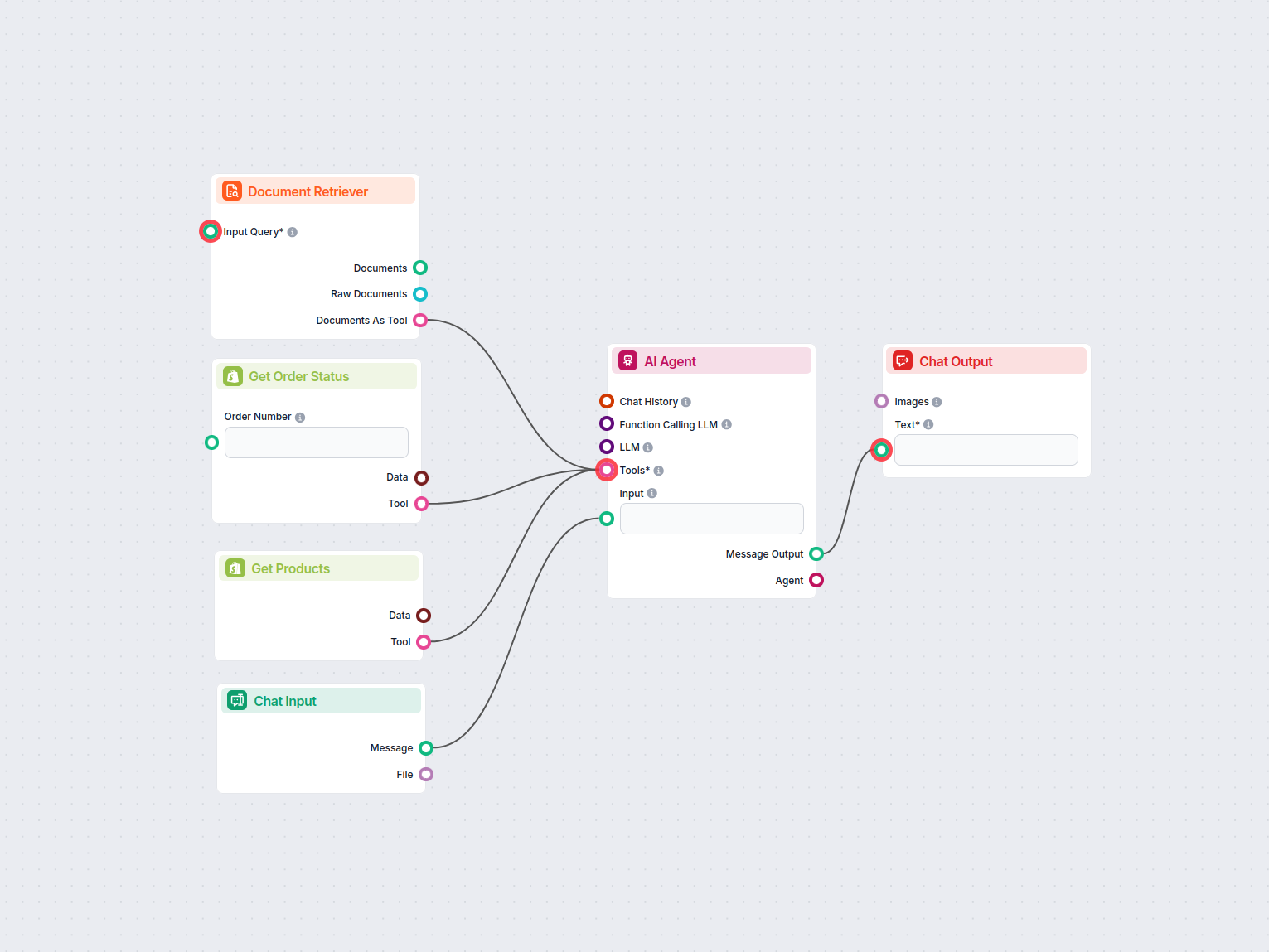

FlowHunts Dokumenthämtare förbättrar AI-noggrannheten genom att koppla generativa modeller till dina egna uppdaterade dokument och webbadresser, vilket säkerställer tillförlitliga och relevanta svar med Retrieval-Augmented Generation (RAG).

Chatthistorik-komponenten i FlowHunt gör det möjligt för chatbots att minnas tidigare meddelanden, vilket säkerställer sammanhängande konversationer och förbättrad kundupplevelse samtidigt som minnes- och tokenanvändning optimeras.

Upptäck Chattutgång-komponenten i FlowHunt—slutför chatbottsvar med flexibla, flerdelade utdata. Oumbärlig för smidig avslutning av flöden och skapande av avancerade, interaktiva AI-chattbottar.

Flow-beskrivning

Detta arbetsflöde är utformat för att automatisera, effektivisera och skala processen för kundsupport och produktrekommendation genom att använda API-integrationer, dokumentsökning, språkmodeller och dynamisk databehandling. Nedan följer en detaljerad genomgång av dess struktur, komponenter och den automation som tillhandahålls.

Huvudmålet med flödet är att fungera som en intelligent, automatiserad kundtjänst- och shoppingassistent för ett företag, med avancerad AI (OpenAI LLM:er), dynamisk promptkonstruktion, API-anrop och dokumentsökning. Det är utformat för att besvara kundfrågor, hämta relevant kunskap, rekommendera produkter och eskalera till mänskliga agenter vid behov – allt med en vänlig, professionell ton och strukturerad utdata.

Ett sådant arbetsflöde möjliggör skalbar och konsekvent kundinteraktion, minskar manuellt arbete och säkerställer högkvalitativa supportsvar även när efterfrågan ökar.

YOURLINK mot din faktiska domän).| Steg | Inmatning | Utmatning | Syfte |

|---|---|---|---|

| Chat Input | Användarmeddelande | Meddelande | Ingångspunkt för kundfrågor |

| Chat History | - | Chatt-historik | Tillhandahåller kontext för personliga svar |

| Prompt Templates | Användarinmatning, historik | API-URL:er (text) | Bygger dynamiskt URL:er för API-anrop |

| Create Data | - | Fråge-/body-data | Bygger nödvändig data för API-förfrågningar |

| API Request | URL, parametrar/body | API-svar | Hämtar eller skickar data till extern tjänst (t.ex. LiveAgent) |

| Parse Data | API-svar | Text | Konverterar strukturerad data till vanlig text för LLM/användare |

| LLM OpenAI | Prompt, parametrar | AI-genererad text | Genererar text, extraherar information |

| Generator | Text, modell | Bearbetad text | Extraherar specifik info (t.ex. “Preview”) från indata |

| Document Retriever | Fråga | Dokument/verktyg | Hittar relevant info i företagets kunskapsbas |

| Tool Calling Agent | Indata, verktyg, historik | Resonerat meddelande | Orkestrerar svar, verktygsanvändning, eskalering, formatering |

| Chat Output | Meddelande | - | Visar meddelande för användaren |

Detta arbetsflöde är en robust, modulär automation för AI-driven kundsupport och produktrekommendation. Det kombinerar chattinmatning, dynamisk API-integration, dokumentsökning och avancerade språkmodeller under en samordnad agent. Genom att automatisera repetitiva uppgifter och utnyttja AI för resonemang kan din supportverksamhet skala effektivt samtidigt som en hög servicenivå och personalisering bibehålls.

Vi hjälper företag som ditt att utveckla smarta chatbotar, MCP-servrar, AI-verktyg eller andra typer av AI-automatisering för att ersätta människor i repetitiva uppgifter i din organisation.

Detta arbetsflöde automatiserar kundsupporten för ditt företag genom att integrera LiveAgent-konversationer, extrahera relevanta konversationsdata, generera sva...

Distribuera en AI-driven chattbot på din webbplats som använder din interna kunskapsbas för att besvara kundförfrågningar, och smidigt vidarebefordrar komplexa ...

Ett arbetsflöde för en AI-driven kundtjänstagentsom kan besvara frågor om Shopify-produkter, hämta orderstatus och få tillgång till information från intern doku...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.