Vad står GPT för i ChatGPT? En komplett guide

Lär dig vad GPT står för i ChatGPT, hur Generative Pre-trained Transformers fungerar och varför de driver de mest avancerade AI-konversationerna idag.

Lär dig vad AI-chattbot GPT är, hur det fungerar och varför ChatGPT är den ledande generativa AI-lösningen. Upptäck transformerarkitektur, träningsmetoder och verkliga tillämpningar.

AI-chattbot GPT (Generative Pre-trained Transformer) är ett avancerat konversations-AI-system utvecklat av OpenAI som använder naturlig språkbehandling och djupinlärning för att generera människoliknande textresponser. ChatGPT, den mest populära GPT-baserade chattboten, kan förstå kontext, besvara frågor, skapa innehåll, skriva kod och utföra komplexa uppgifter genom dynamisk textgenerering istället för förprogrammerade svar.

Artificiella intelligens-chattbotar drivna av GPT-teknologi representerar ett av de största genombrotten inom naturlig språkbehandling och maskininlärning. GPT står för “Generative Pre-trained Transformer”, ett namn som sammanfattar de tre kärnkomponenterna i denna revolutionerande teknik. Termen “generativ” syftar på systemets förmåga att skapa ny, originell text istället för att bara hämta förskrivna svar från en databas. “Förtränad” innebär att modellen har tränats grundligt på massiva datamängder innan den används för specifika uppgifter. “Transformer” beskriver den underliggande neurala nätverksarkitekturen som gör det möjligt för systemet att bearbeta och förstå språk med en aldrig tidigare skådad sofistikering och noggrannhet.

ChatGPT, utvecklad av OpenAI och lanserad i november 2022, har blivit den mest igenkännbara implementationen av GPT-teknologi. Till skillnad från traditionella chattbotar som förlitar sig på stelbenta regelbaserade system eller enkel mönstermatchning, använder ChatGPT djupinlärning för att förstå nyanserna i mänskligt språk, bibehålla kontext genom konversationer och generera svar som känns naturliga och kontextuellt lämpliga. Systemet kan delta i dialog, svara på komplexa frågor, skriva olika former av textinnehåll, felsöka kod och assistera vid kreativa uppgifter—allt utan att vara uttryckligen programmerat för varje specifikt scenario. Denna mångsidighet kommer från transformerarkitekturens förmåga att bearbeta hela textsekvenser samtidigt istället för ord-för-ord, vilket gör att den kan fånga komplexa relationer och beroenden inom språket.

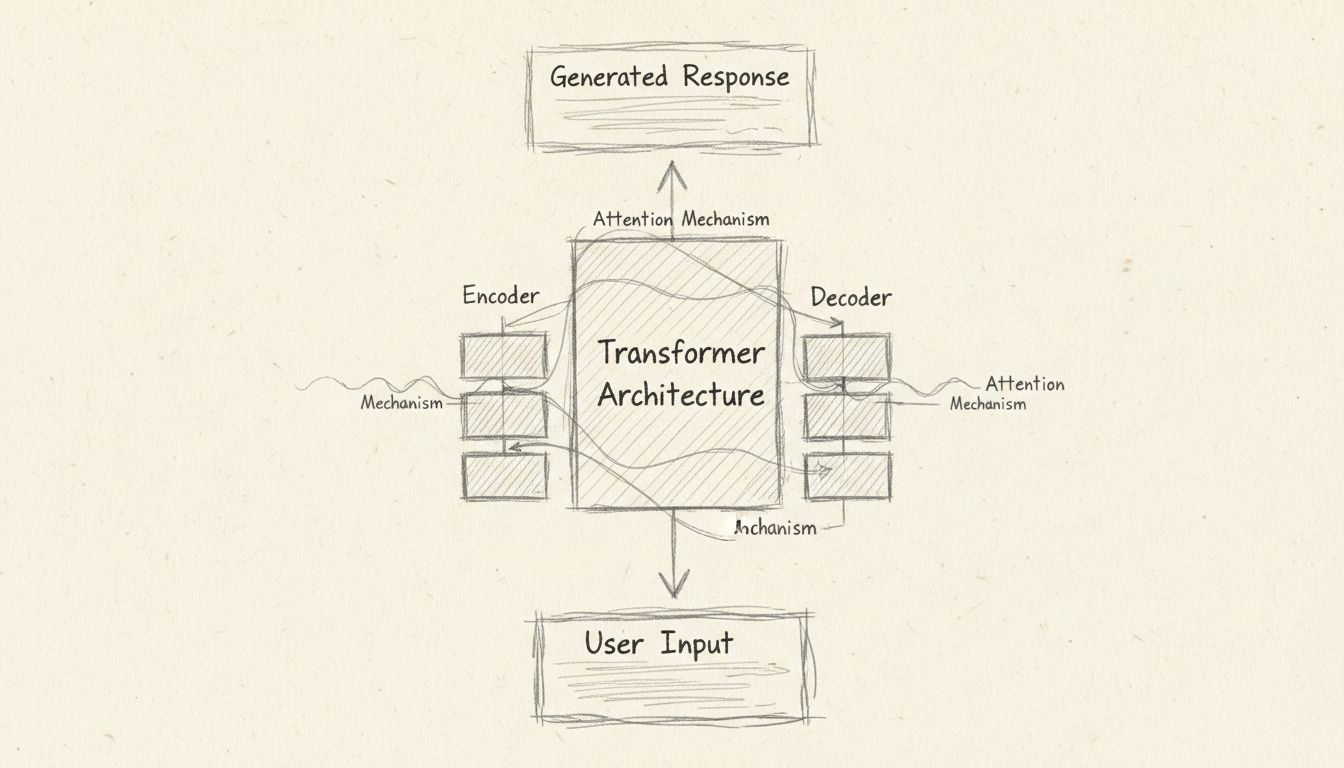

Transformerarkitekturen innebär ett grundläggande skifte i hur AI-system bearbetar språk. I sitt kärnutförande använder transformern en mekanism kallad “självuppmärksamhet” (self-attention) för att avgöra vilka delar av indatat som är mest relevanta vid genereringen av varje ord i utdata. Detta skiljer sig fundamentalt från tidigare metoder som rekurrenta neurala nätverk, vilka bearbetade text sekventiellt och hade svårt att bibehålla kontext över långa stycken. Transformerns parallella bearbetningskapacitet gör den mycket snabbare och effektivare, medan dess uppmärksamhetsmekanismer gör att den kan förstå komplexa relationer mellan ord som kan vara långt ifrån varandra i en mening.

Transformerarkitekturen består av två huvudkomponenter: encoder och decoder. Encodern bearbetar indatat och omvandlar det till matematiska representationer kallade inbäddningar (embeddings). Dessa inbäddningar är vektorer i ett högdimensionellt rum där ord med liknande betydelse placeras nära varandra. Encodern tilldelar vikter till varje ord som indikerar dess relevans och betydelse inom hela indatat. Positionsenkodare används också för att undvika tvetydighet—till exempel hjälper de systemet att förstå att “En hund jagar en katt” betyder något annat än “En katt jagar en hund”, även om samma ord förekommer i båda meningarna. Decodern tar sedan dessa kodade representationer och genererar utdata, ett ord i taget, med hjälp av samma självuppmärksamhetsmekanismer för att fokusera på de mest relevanta delarna av indatat när den avgör vad som ska genereras härnäst.

| Komponent | Funktion | Nyckelfördel |

|---|---|---|

| Encoder | Bearbetar indatat och skapar inbäddningar | Fångar semantisk betydelse och kontext |

| Decoder | Genererar utdata baserat på kodad input | Producerar sammanhängande, kontextuellt relevanta svar |

| Självuppmärksamhet | Avgör relevansen av olika delar i input | Möjliggör förståelse av långväga beroenden |

| Positionsenkodning | Spårar ordning och position i sekvensen | Bevarar grammatiskt struktur och betydelse |

| Inbäddningar | Matematiska representationer av ord | Möjliggör semantiska likhetsberäkningar |

Utvecklingen av GPT-modeller innefattar en sofistikerad flerstegs träningsprocess som förvandlar rå textdata till ett intelligent språksystem. GPT-3, som driver många av dagens ChatGPT-implementationer, tränades på över 175 miljarder parametrar med mer än 45 terabyte data från olika källor inklusive webtexter, Common Crawl, böcker och Wikipedia. Denna massiva skala av träningsdata är avgörande eftersom den exponerar modellen för den stora mångfalden i mänskligt språk, vilket gör att den kan förstå kontext, idiom, teknisk terminologi och kulturella referenser över nästan alla kunskapsområden.

Träningsprocessen börjar med oövervakad inlärning, där modellen lär sig att förutsäga nästa ord i en sekvens baserat på de ord som kommit före. Denna till synes enkla uppgift tvingar modellen att utveckla en djup förståelse för språkets struktur, grammatik, semantik och omvärldskunskap. Modellen lär sig att vissa ordkombinationer är mer sannolika än andra, att vissa begrepp hänger ihop och att språk följer mönster och regler. Efter denna initiala förträningsfas genomgår modellen finjustering genom en process som kallas Förstärkningsinlärning med mänsklig återkoppling (Reinforcement Learning from Human Feedback, RLHF). I denna fas ger mänskliga tränare exempelkonversationer och rankar olika svar utifrån kvalitet, hjälpsamhet och säkerhet. Dessa rankingar skapar belöningsmodeller som styr systemet mot att generera bättre svar. Denna återkopplingsslinga är avgörande för att anpassa modellens utdata till mänskliga värderingar och förväntningar, och minskar risken för att generera skadligt, partiskt eller nonsensartat innehåll.

Moderna AI-chattbotar som drivs av GPT-teknologi uppvisar anmärkningsvärd mångsidighet över många domäner och användningsområden. Inom kundservice kan dessa system hantera rutinfrågor, ge produktinformation, felsöka vanliga problem och eskalera komplexa ärenden till mänskliga agenter—allt medan de bibehåller en naturlig och hjälpsam ton. Inom utbildning fungerar AI-chattbotar som virtuella handledare, förklarar svåra begrepp på ett tillgängligt språk, besvarar elevfrågor och ger personligt anpassat stöd. Innehållsskapare använder GPT-drivna chattbotar för att brainstorma idéer, skriva artiklar och inlägg på sociala medier, anpassa texter för olika målgrupper och övervinna skrivkramp. Programutvecklare drar nytta av dessa system för att skriva kod, felsöka program, förklara programmeringskoncept och snabba upp utvecklingsflöden.

Förmågan att bearbeta och generera flera typer av innehåll sträcker sig bortom text. Avancerade GPT-implementationer kan analysera bilder, beskriva visuellt innehåll, besvara frågor om fotografier och till och med skapa bilder utifrån textbeskrivningar. Vissa system kan bearbeta ljudinmatning, vilket möjliggör röstbaserade interaktioner som känns som naturliga samtal. Dessa multimodala kapabiliteter gör AI-chattbotar alltmer användbara för tillgänglighet, och tillåter personer med olika förmågor att interagera med teknologin på det sätt som passar dem bäst. Systemen kan också söka på internet efter aktuell information, vilket säkerställer att svaren speglar de senaste händelserna och utvecklingarna istället för att enbart förlita sig på träningsdata som kan vara månader eller år gammal.

Även om ChatGPT har blivit den mest använda AI-chattboten finns det flera andra sofistikerade alternativ på marknaden, var och en med sina egna styrkor och egenskaper. ChatGPT är fortfarande det främsta valet för de flesta användare tack vare sin exceptionella förståelse av naturligt språk, breda kunskapsbas och kontinuerliga förbättringar genom regelbundna uppdateringar. Systemets förmåga att bibehålla kontext genom långa konversationer, förstå nyanserade önskemål och generera högkvalitativt innehåll över olika domäner gör det till den ledande lösningen för allmän AI-assistans.

Googles Gemini (tidigare Bard) erbjuder realtidssökning på internet, vilket gör det möjligt att ge aktuell information om senaste händelser, nyheter och utveckling. Denna fördel är särskilt värdefull för frågor som kräver uppdaterad information. Dock har Gemini kritiserats för tillfälliga felaktigheter och ojämn prestanda jämfört med ChatGPT. Microsofts Copilot, som drivs av GPT-4-teknologi, är djupt integrerad med Microsofts ekosystem, inklusive Bing-sökning, Office-appar och Windows, vilket är särskilt värdefullt för användare som redan investerat i Microsofts produkter. Anthropics Claude betonar säkerhet och konstitutionella AI-principer, med särskild styrka i att analysera långa dokument och bibehålla konsekvens vid komplexa resonemangsuppgifter. Perplexity AI fokuserar på källhänvisade svar med transparenta källor, vilket gör den värdefull för forskningsinriktade frågor.

| Chattbot | Styrkor | Bäst för |

|---|---|---|

| ChatGPT | Mångsidighet, naturligt språk, bred kunskap | Allmän AI-assistans |

| Google Gemini | Realtidssökning, aktuell information | Frågor om senaste nyheter och händelser |

| Microsoft Copilot | Microsoft-ekosystemintegration | Office- och Windows-användare |

| Claude | Analys av långa dokument, fokus på säkerhet | Komplexa analyser och resonemang |

| Perplexity AI | Källhänvisningar, sökförstärkta svar | Forskning och faktagranskning |

GPT-baserade chattbotar erbjuder betydande fördelar som har drivit på deras snabba spridning genom olika branscher och användningsområden. Systemen är mycket bra på att förstå kontext och hålla sammanhängande samtal över längre tidsperioder, vilket gör att användare kan ställa följdfrågor och bygga vidare på tidigare svar utan att behöva förklara sin situation på nytt. De kan generera innehåll i praktiskt taget vilken stil eller format som helst, från formellt affärsspråk till kreativ fiktion och teknisk dokumentation. Förmågan att bearbeta och svara på komplexa, flerdelade frågor visar på avancerad resonanskapacitet. Dessutom kan dessa system anpassas genom finjustering eller så kallad in-context learning, där användaren ger exempel i konversationen för att styra systemets beteende.

Men dagens GPT-system har också viktiga begränsningar som användare bör känna till. Systemen kan “hallucinera” och skapa troliga men helt påhittade fakta, siffror eller källhänvisningar. Även om detta problem har minskat med nyare modeller kvarstår det för applikationer där absolut exakthet krävs. GPT-modeller har ett kunskapsstopp—de kan inte komma åt information bortom sin träningsdata, även om vissa implementationer nu inkluderar internetsökning för att åtgärda denna begränsning. Systemen kan ha svårt med mycket nyliga händelser, specialiserad teknisk kunskap utanför sin träningsdata, eller uppgifter som kräver realtidsinformation. Dessutom kan GPT-modeller återge bias från sin träningsdata och därigenom generera svar som förstärker stereotyper eller orättvisa generaliseringar. Systemen har också svårt att verkligen förstå sarkasm, ironi eller starkt kontextberoende humor och kan ibland tolka bildligt språk bokstavligt. Slutligen, även om GPT-system kan skriva kod, kan de producera kod med subtila buggar eller säkerhetsbrister som kräver mänsklig granskning.

Även om fristående AI-chattbotar som ChatGPT är kraftfulla verktyg för enskilda användare behöver organisationer som vill integrera AI i sina affärsprocesser mer omfattande lösningar. FlowHunt representerar nästa steg i AI-automation och erbjuder en plattform där AI-chattbotar inte bara svarar på frågor—de agerar i hela ditt affärssystem. Till skillnad från ChatGPT, som fungerar isolerat, gör FlowHunt det möjligt att bygga intelligenta arbetsflöden som kopplar AI till tusentals affärsapplikationer, databaser och tjänster.

Med FlowHunt kan du skapa AI-drivna chattbotar som automatiskt uppdaterar ditt CRM när kunder lämnar information, genererar supportärenden från kundförfrågningar, berikar leadsdata från flera källor, skickar aviseringar till teammedlemmar och utför komplexa flerstegsprocesser utan mänsklig inblandning. Plattformen låter dig bygga anpassade AI-agenter som förstår dina specifika affärsprocesser, får tillgång till din egen data och fattar beslut i linje med organisationens mål. Till exempel kan du implementera en AI-chattbot som hanterar kundsupportärenden, automatiskt kategoriserar dem efter brådska, skapar ärenden i ditt supportsystem, söker i din kunskapsbas efter relevanta lösningar och formulerar personligt anpassade svar—allt på några sekunder. Denna nivå av integration förvandlar AI från ett produktivitetsverktyg till en strategisk tillgång som driver effektivitet, sänker kostnader och förbättrar kundupplevelser.

FlowHunts fördel över fristående chattbotar ligger i dess förmåga att orkestrera AI i hela din tekniska miljö. Istället för att manuellt kopiera information mellan system eller använda flera avskilda verktyg, skapar FlowHunt sömlösa arbetsflöden där AI fattar intelligenta beslut och vidtar åtgärder som får genomslag i hela organisationen. Plattformen stödjer integration mot CRM-system, marknadsföringsautomation, projektledning, kommunikationsplattformar, datalager och hundratals andra affärsappar. Detta helhetsgrepp på AI-automation gör det möjligt för organisationer att uppnå effektivitet och intelligensnivåer som fristående chattbotar helt enkelt inte kan matcha.

Utvecklingen inom AI-chattbotar och GPT-teknologi går snabbt framåt, med nya kapabiliteter och förbättringar som introduceras regelbundet. OpenAI har släppt allt mer avancerade modeller, från GPT-3 till GPT-4 och nu senast GPT-4o, som alla erbjuder förbättrad hastighet, noggrannhet, resonansförmåga och multimodal bearbetning. Trenden mot större modeller med fler parametrar fortsätter, men det finns också ett växande intresse för mer effektiva modeller som kan köras på mindre enheter eller med lägre beräkningskrav. Nya funktioner inkluderar bättre resonans vid komplexa flerstegsproblem, förbättrad förmåga att följa komplicerade instruktioner, ökad säkerhet och anpassning till mänskliga värderingar samt bättre hantering av undantagsfall och ovanliga scenarion.

Integrationen av AI-chattbotar i affärsprocesser förväntas accelerera, i takt med att fler organisationer inser värdet av AI-driven automation. Vi kan vänta oss mer sofistikerade AI-agenter som kan verka autonomt inom givna ramar, fatta beslut och vidta åtgärder utan ständig mänsklig övervakning. Kombinationen av AI-chattbotar med andra framväxande tekniker som kunskapsgrafer, vektordatabaser och retrieval-augmented generation kommer att möjliggöra system som kan få tillgång till och resonera över enorma mängder strukturerad och ostrukturerad data. När dessa tekniker mognar kommer gränsen mellan “chattbotar” och “affärsautomationssystem” att suddas ut, och AI blir en integrerad del av hur organisationer fungerar.

Att förstå vad AI-chattbotar och GPT-teknologi är, är avgörande för alla som vill använda dessa kraftfulla verktyg på ett effektivt sätt. ChatGPT och liknande system representerar ett verkligt genombrott inom artificiell intelligens, där maskiner kan förstå och generera mänskligt språk med imponerande sofistikering. Men valet mellan fristående chattbotar och omfattande AI-automationsplattformar som FlowHunt beror på dina specifika behov. För enskilda användare som söker en mångsidig AI-assistent för skrivande, programmering, forskning och kreativa uppgifter är ChatGPT ett utmärkt val. För organisationer som vill integrera AI i sina affärsprocesser, automatisera arbetsflöden och uppnå mätbara affärsresultat erbjuder FlowHunt den kompletta plattformen som behövs för att förvandla AI från ett produktivitetsverktyg till en strategisk konkurrensfördel.

FlowHunt är den ledande AI-automationsplattformen som hjälper dig att bygga, driftsätta och hantera intelligenta chattbotar och AI-arbetsflöden. Till skillnad från fristående chattbotar integrerar FlowHunt AI med hela ditt affärssystem och möjliggör sömlös automation över alla dina verktyg och processer.

Lär dig vad GPT står för i ChatGPT, hur Generative Pre-trained Transformers fungerar och varför de driver de mest avancerade AI-konversationerna idag.

Denna omfattande artikel förklarar vad 'GPT' betyder i ChatGPT, hur teknologin fungerar, dess utveckling och svarar på vanliga frågor om 'chat gpbt' för använda...

Utforska vad en GPT-chattbot är, hur chatbotgpt-teknologin fungerar, dess viktigaste fördelar, verkliga användningsområden och hur den skiljer sig från traditio...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.