DeepSeek MCP-server

DeepSeek MCP-server fungerar som en säker proxy som kopplar DeepSeeks avancerade språkmodeller till MCP-kompatibla applikationer som Claude Desktop eller FlowHu...

Ta Deepseeks transparenta resonemang och chain-of-thought AI-utdata till dina MCP-aktiverade assistenter med stöd för både moln- och lokal installation.

FlowHunt erbjuder ett extra säkerhetslager mellan dina interna system och AI-verktyg, vilket ger dig granulär kontroll över vilka verktyg som är tillgängliga från dina MCP-servrar. MCP-servrar som hostas i vår infrastruktur kan sömlöst integreras med FlowHunts chatbot samt populära AI-plattformar som ChatGPT, Claude och olika AI-redigerare.

Deepseek Thinker MCP-server fungerar som en Model Context Protocol (MCP)-leverantör och levererar Deepseek-modellens resonemangsinnehåll till MCP-aktiverade AI-klienter, såsom Claude Desktop. Den gör det möjligt för AI-assistenter att få tillgång till Deepseeks tankegångar och resonemangsutdata antingen via Deepseeks API-tjänst eller från en lokal Ollama-server. Genom att integrera denna server kan utvecklare stärka sina AI-arbetsflöden med fokuserat resonemang, med stöd för både moln- och lokal inferens. Servern är särskilt användbar i situationer där detaljerade resonemangskedjor eller chain-of-thought (CoT)-utdata behövs för att informera efterföljande AI-uppgifter, vilket gör den värdefull för avancerad utveckling, felsökning och AI-agentberikning.

Inga explicita prompt-mallar nämns i arkivet eller dokumentationen.

Inga explicita MCP-resurser beskrivs i dokumentationen eller kodbasen.

originPrompt (sträng) — Användarens ursprungliga prompt.windsurf_config.json).mcpServers:{

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

claude_desktop_config.json.{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

För alla plattformar bör API-nycklar och känsliga konfigurationsvärden anges med hjälp av miljövariabler i avsnittet env. Exempel:

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

För lokalt Ollama-läge, sätt USE_OLLAMA till "true" i env-objektet:

"env": {

"USE_OLLAMA": "true"

}

Använd MCP i FlowHunt

För att integrera MCP-servrar i ditt FlowHunt-arbetsflöde, börja med att lägga till MCP-komponenten till ditt flöde och koppla den till din AI-agent:

Klicka på MCP-komponenten för att öppna konfigurationspanelen. I avsnittet för systemets MCP-konfiguration, ange dina MCP-serveruppgifter med detta JSON-format:

{

"deepseek-thinker": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

När det är konfigurerat kan AI-agenten nu använda denna MCP som ett verktyg med tillgång till alla dess funktioner och kapaciteter. Kom ihåg att byta ut “deepseek-thinker” till ditt faktiska MCP-servernamn och ange korrekt URL.

| Avsnitt | Tillgänglighet | Detaljer/Noteringar |

|---|---|---|

| Översikt | ✅ | |

| Lista över promptar | ⛔ | Inga prompt-mallar dokumenterade |

| Lista över resurser | ⛔ | Inga explicita MCP-resurser funna |

| Lista över verktyg | ✅ | get-deepseek-thinker-verktyg |

| Skydda API-nycklar | ✅ | Miljövariabler i konfigurationen |

| Sampling-stöd (mindre viktigt vid utvärdering) | ⛔ | Ej omnämnt |

Baserat på de två tabellerna nedan erbjuder Deepseek Thinker MCP-server ett fokuserat verktyg för resonemangsintegration, är enkel att sätta upp men saknar detaljerade prompt-mallar och explicita resursdefinitioner. Projektet är öppen källkod, har ett måttligt antal följare och stödjer säker hantering av autentiseringsuppgifter. Den får 6/10 i total fullständighet och användbarhet som MCP-server.

| Har LICENSE-fil | ⛔ (Ingen LICENSE-fil upptäckt) |

|---|---|

| Har minst ett verktyg | ✅ |

| Antal forkar | 12 |

| Antal stjärnor | 51 |

Det är en Model Context Protocol-server som tillför Deepseek-modellens resonemang till MCP-aktiverade AI-klienter, och erbjuder chain-of-thought-utdata och transparent modellresonemang för avancerade AI-arbetsflöden och felsökning.

Den erbjuder verktyget 'get-deepseek-thinker' för att utföra resonemang med Deepseek-modellen och returnera strukturerade resonemangsutdata.

Ja, Deepseek Thinker stöder både molnbaserad och lokal (Ollama) inferens. Sätt miljövariabeln 'USE_OLLAMA' till 'true' för lokalt läge.

API-nycklar och känsliga värden ska lagras i avsnittet 'env' i din MCP-serverkonfiguration som miljövariabler, inte hårdkodade i källfiler.

Begränsningarna bestäms av den underliggande Deepseek-modellen eller API:et; att överskrida dem kan trunkera svar eller orsaka fel, så justera din konfiguration och indata därefter.

Inga explicita prompt-mallar eller extra MCP-resurser tillhandahålls som en del av den nuvarande dokumentationen för Deepseek Thinker MCP-server.

Integrera Deepseek Thinker MCP-server för att ge dina AI-agenter detaljerade resonemangsförmågor och förbättra utvecklingsarbetsflöden.

DeepSeek MCP-server fungerar som en säker proxy som kopplar DeepSeeks avancerade språkmodeller till MCP-kompatibla applikationer som Claude Desktop eller FlowHu...

DeepSeek MCP-server integrerar DeepSeek's avancerade språkmodeller med MCP-kompatibla applikationer, och erbjuder säker, anonymiserad API-åtkomst samt möjliggör...

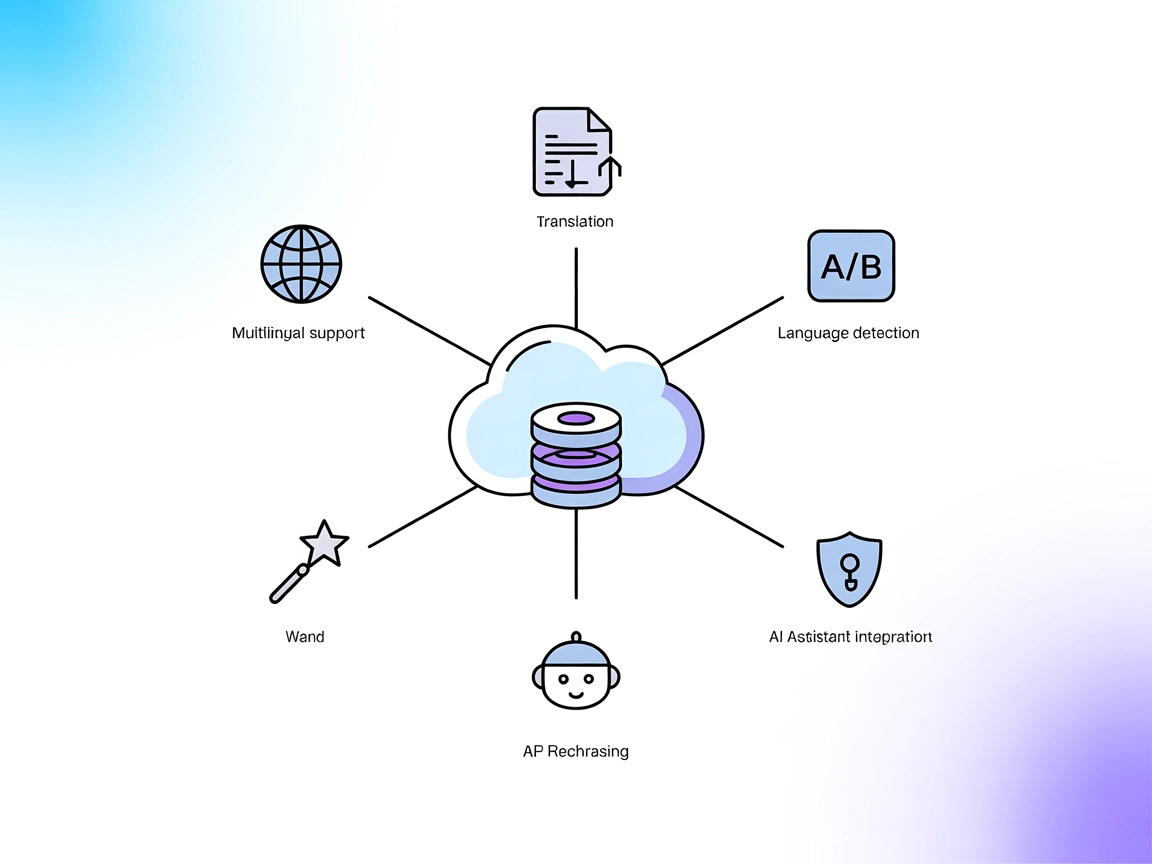

DeepL MCP-servern integrerar avancerad översättning, omformulering och språkdetektering i AI-arbetsflöden via DeepL API. Den ger FlowHunt och andra AI-assistent...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.