ModelContextProtocol (MCP) Server-integration

ModelContextProtocol (MCP) Server fungerar som en brygga mellan AI-agenter och externa datakällor, API:er och tjänster, vilket gör det möjligt för FlowHunt-anvä...

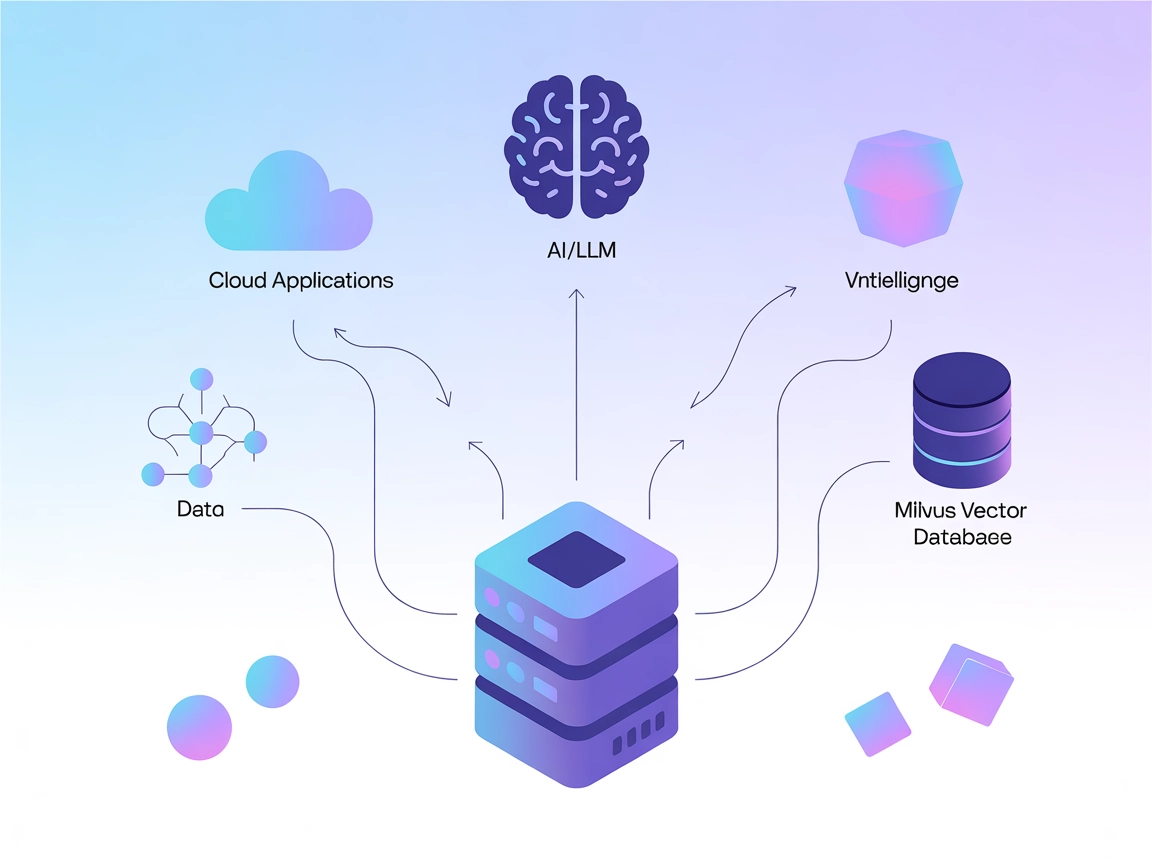

Koppla LLM:er och AI-agenter till Milvus för kraftfull vektorsökning, kontextminne och datadrivna rekommendationer direkt i dina FlowHunt-arbetsflöden.

FlowHunt erbjuder ett extra säkerhetslager mellan dina interna system och AI-verktyg, vilket ger dig granulär kontroll över vilka verktyg som är tillgängliga från dina MCP-servrar. MCP-servrar som hostas i vår infrastruktur kan sömlöst integreras med FlowHunts chatbot samt populära AI-plattformar som ChatGPT, Claude och olika AI-redigerare.

Milvus MCP (Model Context Protocol) Server kopplar samman AI-assistenter och LLM-baserade applikationer med Milvus-vektordatabasen. Detta möjliggör sömlös interaktion mellan språkmodeller och storskalig vektordata, och ger ett standardiserat sätt att komma åt, fråga och hantera Milvus direkt från AI-arbetsflöden. Med Milvus MCP Server kan utvecklare integrera Milvus-baserad sökning, hämtning och datahantering direkt i sina AI-agenter, IDE:er eller chattgränssnitt. Servern stödjer flera kommunikationslägen (stdio och Server-Sent Events), vilket gör att den passar olika distributionsscenarier och utvecklingsmiljöer. Genom att brygga LLM:er med Milvus förbättras AI-systemens förmåga att utföra kontextmedvetna operationer på högdimensionell data avsevärt, vilket låser upp rikare och mer intelligenta LLM-drivna upplevelser.

Ingen information om promptmallar finns i arkivet.

Ingen uttrycklig lista över Model Context Protocol “resurser” beskrivs i tillgänglig dokumentation eller kod.

Ingen uttrycklig verktygslista eller funktionsnamn är dokumenterade i tillgänglig dokumentation eller kodfiler, inklusive server.py.

git clone https://github.com/zilliztech/mcp-server-milvus.gituv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Säkra API-nycklar:

Om servern kräver känslig info, använd miljövariabler:

{

"env": {

"MILVUS_URI": "http://localhost:19530"

},

"inputs": {}

}

{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Säkra inloggningsuppgifter via miljövariabler enligt ovan.

uv.uv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Säkra API-nycklar:

Använd miljövariabler som ovan.

uv.{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Miljövariabler:

{

"env": {

"MILVUS_URI": "http://localhost:19530"

}

}

Använda MCP i FlowHunt

För att integrera MCP-servrar i ditt FlowHunt-arbetsflöde, börja med att lägga till MCP-komponenten i ditt flöde och koppla den till din AI-agent:

Klicka på MCP-komponenten för att öppna konfigurationspanelen. I systemets MCP-konfigurationssektion, fyll i dina MCP-serverdetaljer med detta JSON-format:

{

"milvus-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

När det är konfigurerat kan AI-agenten nu använda denna MCP som ett verktyg med tillgång till alla dess funktioner och kapaciteter. Kom ihåg att byta ut “milvus-mcp” mot det faktiska namnet på din MCP-server och ersätta URL:en med din egen MCP-server-URL.

| Sektion | Tillgänglighet | Detaljer/Noteringar |

|---|---|---|

| Översikt | ✅ | |

| Lista över promptar | ⛔ | Inga promptmallar dokumenterade |

| Lista över resurser | ⛔ | Ingen uttrycklig MCP-resurslista |

| Lista över verktyg | ⛔ | Inga uttryckliga verktyg listade i tillgängliga filer |

| Säkra API-nycklar | ✅ | Använder miljövariabler, dokumenterat i installations-exempel |

| Sampling-stöd (mindre viktigt vid utvärdering) | ⛔ | Inte nämnt |

Roots-stöd: Inte nämnt

Sampling-stöd: Inte nämnt

Milvus MCP Server är en praktisk och fokuserad brygga för att koppla LLM:er med Milvus, med tydliga installationsguider för populära utvecklingsverktyg. Dock saknas detaljerad dokumentation om MCP-resurser, promptar och konkreta verktygs-API:er, vilket begränsar möjligheten till direkt upptäckt. Ändå är det en stabil grund för vektorbaserade AI-integrationer.

| Har en LICENS | ✅ (Apache-2.0) |

|---|---|

| Har minst ett verktyg | ⛔ |

| Antal forks | 32 |

| Antal stjärnor | 139 |

Totalt: 4/10

Servern är användbar inom sitt nischområde men skulle vinna mycket på mer explicit dokumentation om resurser, promptmallar och verktygs-API:er för maximal interoperabilitet och smidig användning.

Milvus MCP Server fungerar som en brygga mellan AI-assistenter och LLM-applikationer och Milvus-vektordatabasen, och möjliggör sömlös vektorsökning, kontextminne och datahantering för avancerade AI-arbetsflöden.

Viktiga användningsområden inkluderar vektorsökning, embedding-hantering, kontextminne för chattbotar, AI-drivna rekommendationer och realtidsdataanalys med Milvus i FlowHunt.

Använd miljövariabler (t.ex. MILVUS_URI) för att lagra känslig anslutningsinformation, enligt installationsguiderna för varje klient.

Inga uttryckliga promptmallar eller verktygs-API:er är dokumenterade. Servern fokuserar på att tillhandahålla en brygga för vektoroperationer och embedding-hantering.

Det är en stabil grund för att koppla LLM:er till vektordatabaser, med tydliga installationsinstruktioner, men skulle dra nytta av mer dokumentation kring promptar och verktygs-API:er för enklare upptäckbarhet och integration.

Förbättra dina AI-agenter med sömlös åtkomst till vektordatabaser för smartare sökning, rekommendationer och kontextminne. Integrera Milvus MCP Server med FlowHunt nu!

ModelContextProtocol (MCP) Server fungerar som en brygga mellan AI-agenter och externa datakällor, API:er och tjänster, vilket gör det möjligt för FlowHunt-anvä...

Litmus MCP-servern möjliggör sömlös integration mellan stora språkmodeller (LLM:er) och Litmus Edge för konfiguration, övervakning och hantering av industriella...

Patronus MCP Server förenklar LLM-utvärdering och experimentering för utvecklare och forskare, genom att erbjuda automatisering, batchbearbetning och robust upp...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.