Kubernetes MCP Server-integration

Kubernetes MCP Server fungerar som en brygga mellan AI-assistenter och Kubernetes-kluster, vilket möjliggör AI-drivna automatiseringar, resursxadhantering och D...

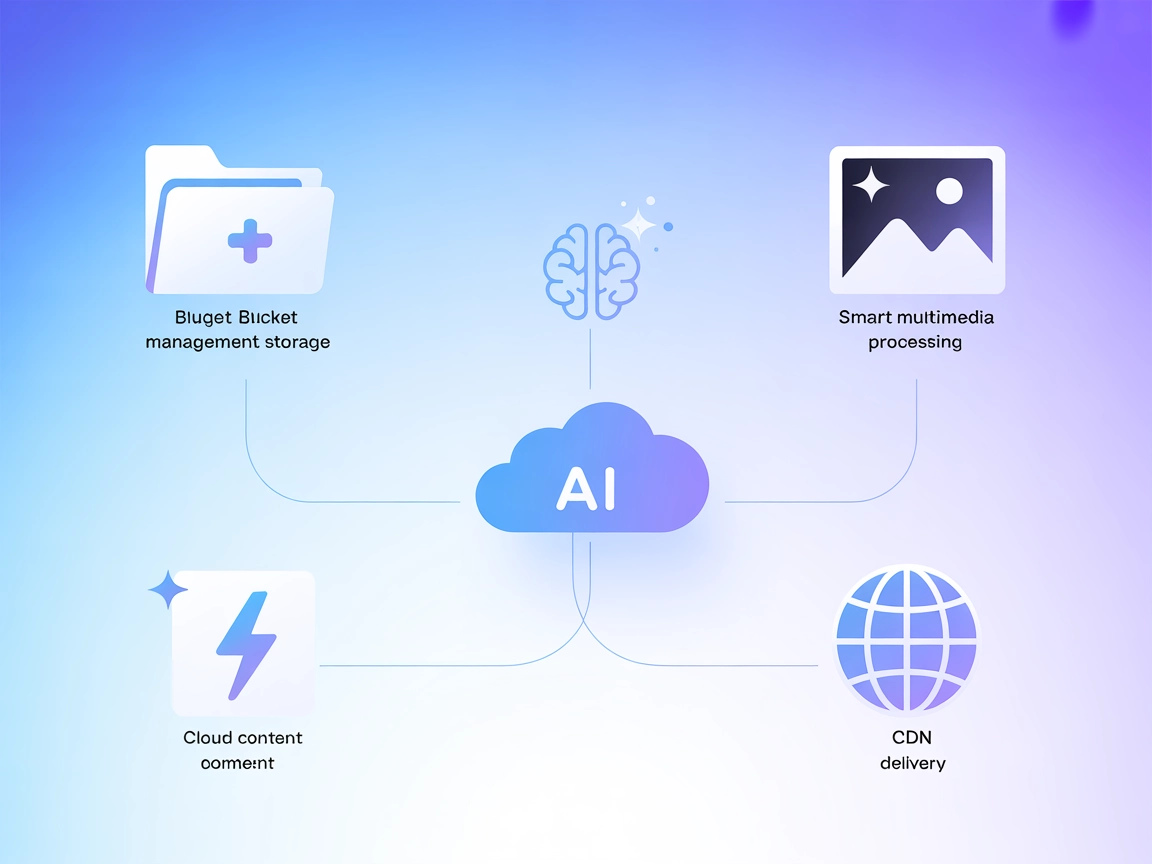

Koppla dina AI-arbetsflöden till Qiniu Cloud för automatiserad filhantering, mediakonverteringar och CDN-operationer – allt från FlowHunt och MCP-kompatibla verktyg.

FlowHunt erbjuder ett extra säkerhetslager mellan dina interna system och AI-verktyg, vilket ger dig granulär kontroll över vilka verktyg som är tillgängliga från dina MCP-servrar. MCP-servrar som hostas i vår infrastruktur kan sömlöst integreras med FlowHunts chatbot samt populära AI-plattformar som ChatGPT, Claude och olika AI-redigerare.

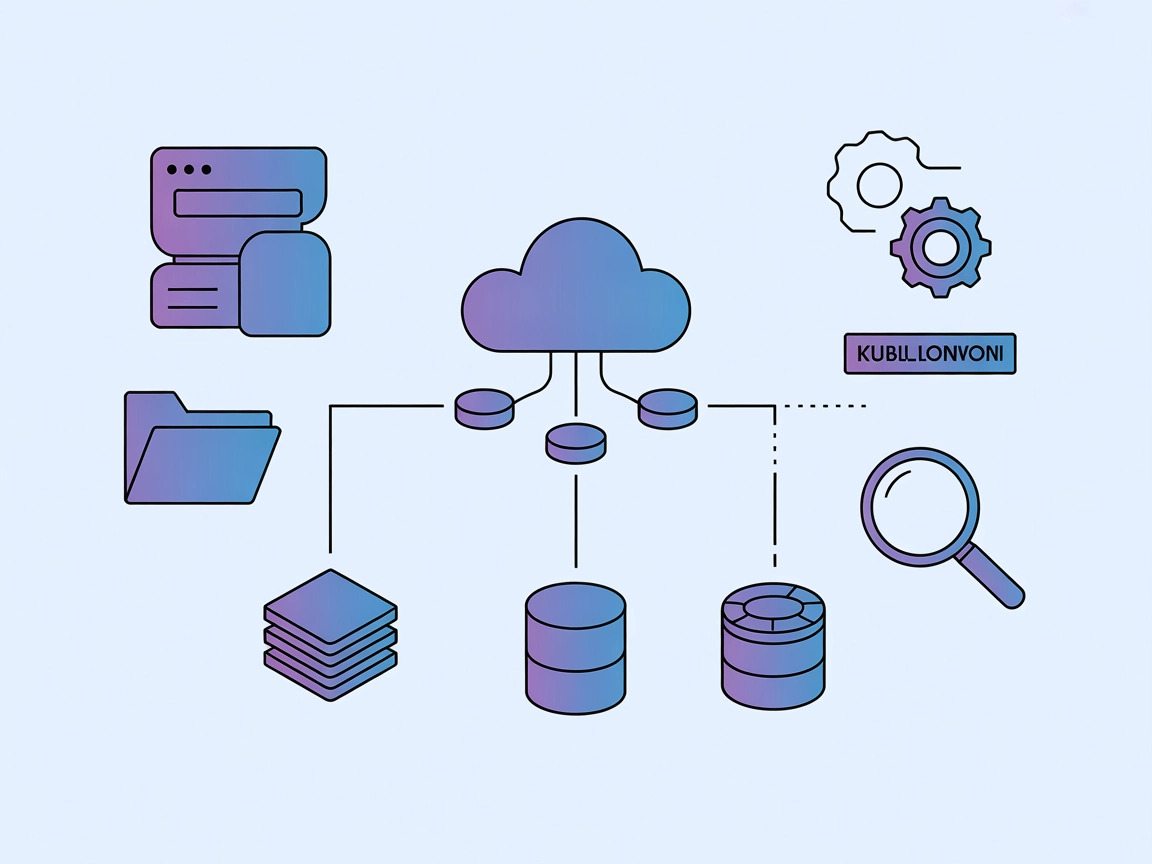

Qiniu MCP-servern är en Model Context Protocol (MCP)-server byggd ovanpå Qiniu Cloud-tjänster, designad för att koppla AI-assistenter och storklienter av språkmodeller till Qinius molnlagrings- och intelligenta multimedietjänster. Genom att exponera lagrings- och medieprocesseringsmöjligheter via MCP-gränssnittet kan utvecklare och AI-drivna arbetsflöden programmera mot Qinius buckets, filer och CDN-funktioner direkt från sina AI-verktyg. Denna integration möjliggör uppgifter som att söka och hantera molnlagring, ladda upp och ladda ner filer, utföra bildtransformationer och hantera CDN-cache. Qiniu MCP-servern förenklar processen att ansluta externa datakällor och operationella triggers till AI-agenter, förbättrar utvecklingsflöden och möjliggör sömlös datadriven automatisering.

Inga promptmallar nämns uttryckligen i förvaret eller dokumentationen.

Bucket-lista

Exponerar listan med alla tillgängliga Qiniu-lagringsbuckets som är åtkomliga med de konfigurerade uppgifterna.

Fillista i bucket

Ger åtkomst till listan på filer inom en specificerad Qiniu-bucket.

Filinnehåll

Möjliggör läsning av innehållet i filer lagrade i Qiniu-buckets för användning som LLM-kontext.

Resurs för nedladdningslänk

Genererar nedladdningslänkar för filer lagrade på Qiniu, vilket möjliggör direkt filåtkomst.

Hämta bucket-lista

Hämtar listan på alla lagringsbuckets för det autentiserade Qiniu-kontot.

Hämta fillista i bucket

Hämtar filer lagrade i en vald bucket, vilket stödjer filhantering och urval.

Ladda upp fil

Stöder uppladdning av lokala filer eller innehållssträngar till en angiven bucket.

Läs filinnehåll

Läser innehållet i en specificerad fil från en bucket för vidare bearbetning.

Generera nedladdningslänk

Skapar en publik eller signerad nedladdningslänk för en fil.

Bildförminskning

Utför bildskalningsoperationer som en del av Qinius intelligenta medietjänster.

Rundade hörn på bild

Applicerar rundade hörn på bilder lagrade i Qiniu.

CDN-cacheuppdatering via länk

Uppdaterar CDN-cachen för en given fillänk för att säkerställa uppdaterat innehåll.

CDN-förhämtning via länk

Förhämtar filer till CDN-noder via länk för snabbare åtkomst och lägre latens.

Molnlagringshantering

Möjliggör automatiserad listning, uppladdning och läsning av filer i Qiniu-buckets direkt från AI-agenter eller chatbottar, vilket effektiviserar datahantering för utvecklare.

Automatiserad medieprocessering

Underlättar bildtransformationer såsom förminskning eller rundning av hörn som en del av AI-drivna innehållsflöden, minskar manuella insatser.

CDN-operationer

Gör det möjligt för AI-arbetsflöden att trigga CDN-cacheuppdateringar eller förhämtningar, så att slutanvändare alltid får aktuellt och optimerat innehåll.

Arbetsflödesintegration

Integrerar Qinius lagrings- och medietjänster i anpassade utvecklararbetsflöden, ökar produktiviteten och möjliggör nya automationsscenarier.

Säker fildelning

Skapar säkra nedladdningslänkar för filer, vilket möjliggör kontrollerad och spårbar fildelning direkt från AI- eller utvecklingsmiljön.

Inga explicita Windsurf-instruktioner tillhandahålls i förvaret.

Inga explicita Claude-instruktioner tillhandahålls i förvaret.

Inga explicita Cursor-instruktioner tillhandahålls i förvaret.

{

"mcpServers": {

"qiniu": {

"command": "uvx",

"args": [

"qiniu-mcp-server"

],

"env": {

"QINIU_ACCESS_KEY": "YOUR_ACCESS_KEY",

"QINIU_SECRET_KEY": "YOUR_SECRET_KEY",

"QINIU_REGION_NAME": "YOUR_REGION_NAME",

"QINIU_ENDPOINT_URL": "YOUR_ENDPOINT_URL",

"QINIU_BUCKETS": "YOUR_BUCKET_A,YOUR_BUCKET_B"

},

"disabled": false

}

}

}

Spara känsliga autentiseringsuppgifter som QINIU_ACCESS_KEY och QINIU_SECRET_KEY i miljövariabler med hjälp av env-fältet i din konfiguration, som ovan.

Exempel:

"env": {

"QINIU_ACCESS_KEY": "YOUR_ACCESS_KEY",

"QINIU_SECRET_KEY": "YOUR_SECRET_KEY"

}

Använda MCP i FlowHunt

För att integrera MCP-servrar i ditt FlowHunt-arbetsflöde, börja med att lägga till MCP-komponenten i ditt flöde och koppla den till din AI-agent:

Klicka på MCP-komponenten för att öppna konfigurationspanelen. I systemets MCP-konfigurationssektion, ange dina MCP-serveruppgifter i detta JSON-format:

{

"qiniu": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

När detta är konfigurerat kan AI-agenten nu använda denna MCP som ett verktyg med tillgång till alla dess funktioner. Kom ihåg att byta ut “qiniu” mot det faktiska namnet på din MCP-server och ersätta URL:en med din egen MCP-server-URL.

| Sektion | Tillgänglighet | Detaljer/Kommentarer |

|---|---|---|

| Översikt | ✅ | Från README.md |

| Lista över promptar | ⛔ | Inga promptar/mallar nämns |

| Lista över resurser | ✅ | Från kapabilitetsbeskrivningar i README.md |

| Lista över verktyg | ✅ | Härledda från README.md och funktionslista |

| Skydda API-nycklar | ✅ | Miljövariabler visas i konfigurationen |

| Sampling-stöd (mindre viktigt för bedömning) | ⛔ | Ingen information om sampling-stöd |

Baserat på tabellerna är Qiniu MCP-servern väldokumenterad för grundläggande installation och funktionsöversikt kring Qiniu Cloud, men saknar explicit dokumentation för sampling/roots/promptmallar. Funktionsuppsättningen är stark för lagring och media, men mer avancerade MCP-primitiver beskrivs inte.

Om ditt huvudsakliga behov är att integrera Qiniu Clouds fil- och medieoperationer med AI-assistentarbetsflöden är denna MCP-server stabil och täcker alla basbehov med tydlig installation. För mer avancerade prompt-/arbetsflödes- eller agentfunktioner är dokumentationen tunn. Betyg: 7/10.

| Har en LICENSE | ✅ (MIT) |

|---|---|

| Minst ett verktyg | ✅ |

| Antal forks | 8 |

| Antal stjärnor | 17 |

Qiniu MCP-servern är en specialiserad Model Context Protocol-server som kopplar AI-verktyg till Qiniu Cloud och möjliggör programmatisk åtkomst till molnlagring, filhantering, medieprocessering och CDN-funktioner direkt från AI-arbetsflöden.

Den exponerar resurser som bucket-listor, fillistor, filinnehåll och nedladdningslänkar. Verktyg inkluderar att hämta bucket-/fillistor, ladda upp filer, läsa filinnehåll, generera nedladdningslänkar, bildförminskning, rundade hörn, CDN-cacheuppdatering och förhämtning.

Automatiserad molnlagringshantering, bild-/medieprocessering, CDN-cacheoperationer, integrering av Qiniu med utvecklararbetsflöden och säker fildelning via AI-assistenter.

Spara alltid Qiniu-uppgifter i miljövariabler i din MCP-konfiguration, inte direkt i kod eller publika filer, för att förhindra obehörig åtkomst.

Lägg till MCP-komponenten i ditt flöde, ange serveruppgifter i konfigurationspanelen och koppla din AI-agent. Använd det angivna JSON-formatet för sömlös åtkomst till Qinius verktyg och resurser i FlowHunt.

Automatisera dina Qiniu Cloud-lagrings- och mediearbetsflöden med FlowHunts sömlösa MCP-serverintegration.

Kubernetes MCP Server fungerar som en brygga mellan AI-assistenter och Kubernetes-kluster, vilket möjliggör AI-drivna automatiseringar, resursxadhantering och D...

Kubernetes MCP-server fungerar som en brygga mellan AI-assistenter och Kubernetes/OpenShift-kluster, vilket möjliggör programmatisk resursxadhantering, poddxado...

Integrera FlowHunt med Qiniu MCP Server för att koppla dina AI-drivna applikationer till Qiniu Cloud för enhetlig objektlagring, smart multimediehantering och b...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.