Mở rộng truy vấn

Diễn giải lại đầu vào của người dùng thành nhiều truy vấn thay thế để cải thiện tìm kiếm ngữ nghĩa trong kho tri thức bằng prompt LLM....

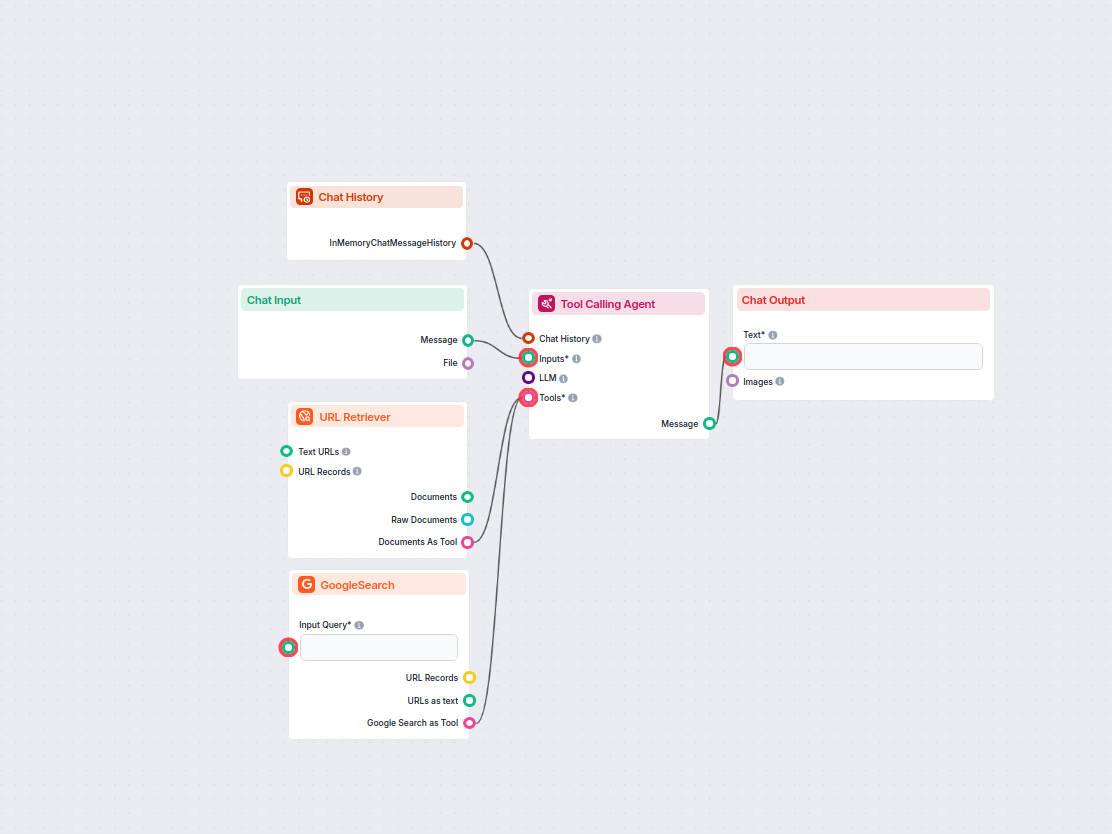

Luồng

Diễn giải lại đầu vào của người dùng thành nhiều truy vấn thay thế để cải thiện tìm kiếm ngữ nghĩa trong kho tri thức bằng prompt LLM....

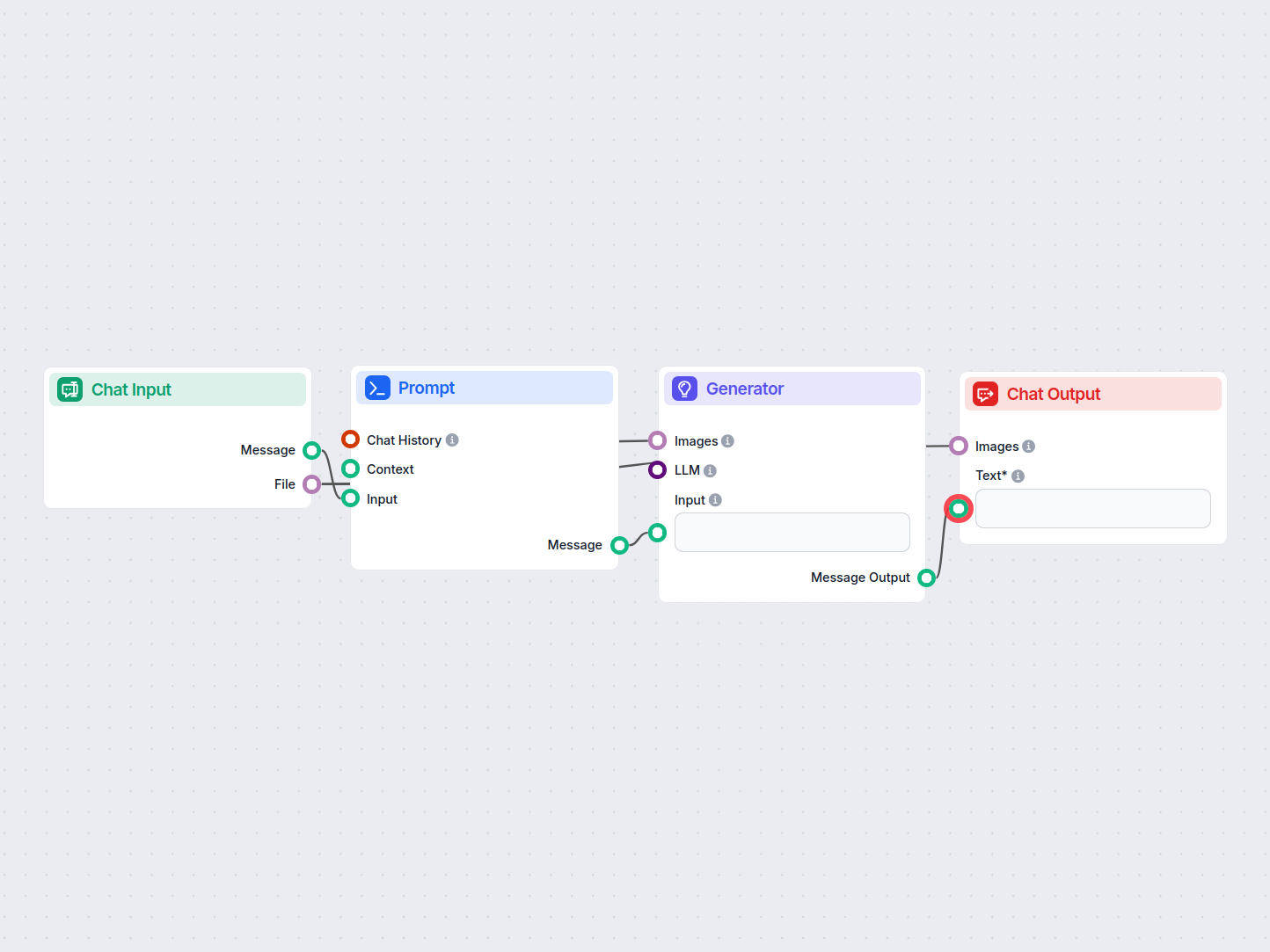

Dưới đây là danh sách đầy đủ tất cả các thành phần được sử dụng trong luồng này để đạt được chức năng của nó. Các thành phần là các khối xây dựng của mọi Luồng AI. Chúng cho phép bạn tạo ra các tương tác phức tạp và tự động hóa các tác vụ bằng cách kết nối các chức năng khác nhau. Mỗi thành phần phục vụ một mục đích cụ thể, chẳng hạn như xử lý đầu vào của người dùng, xử lý dữ liệu hoặc tích hợp với các dịch vụ bên ngoài.

Thành phần Chat Input trong FlowHunt khởi tạo tương tác với người dùng bằng cách thu thập tin nhắn từ Playground. Nó là điểm khởi đầu của các flow, cho phép quy trình xử lý cả đầu vào dạng văn bản lẫn tệp tin.

Khám phá thành phần Kết Quả Trò Chuyện trong FlowHunt—hoàn thiện phản hồi chatbot với các kết quả linh hoạt, đa phần. Thành phần thiết yếu để hoàn thành luồng trò chuyện liền mạch và tạo chatbot AI nâng cao, tương tác.

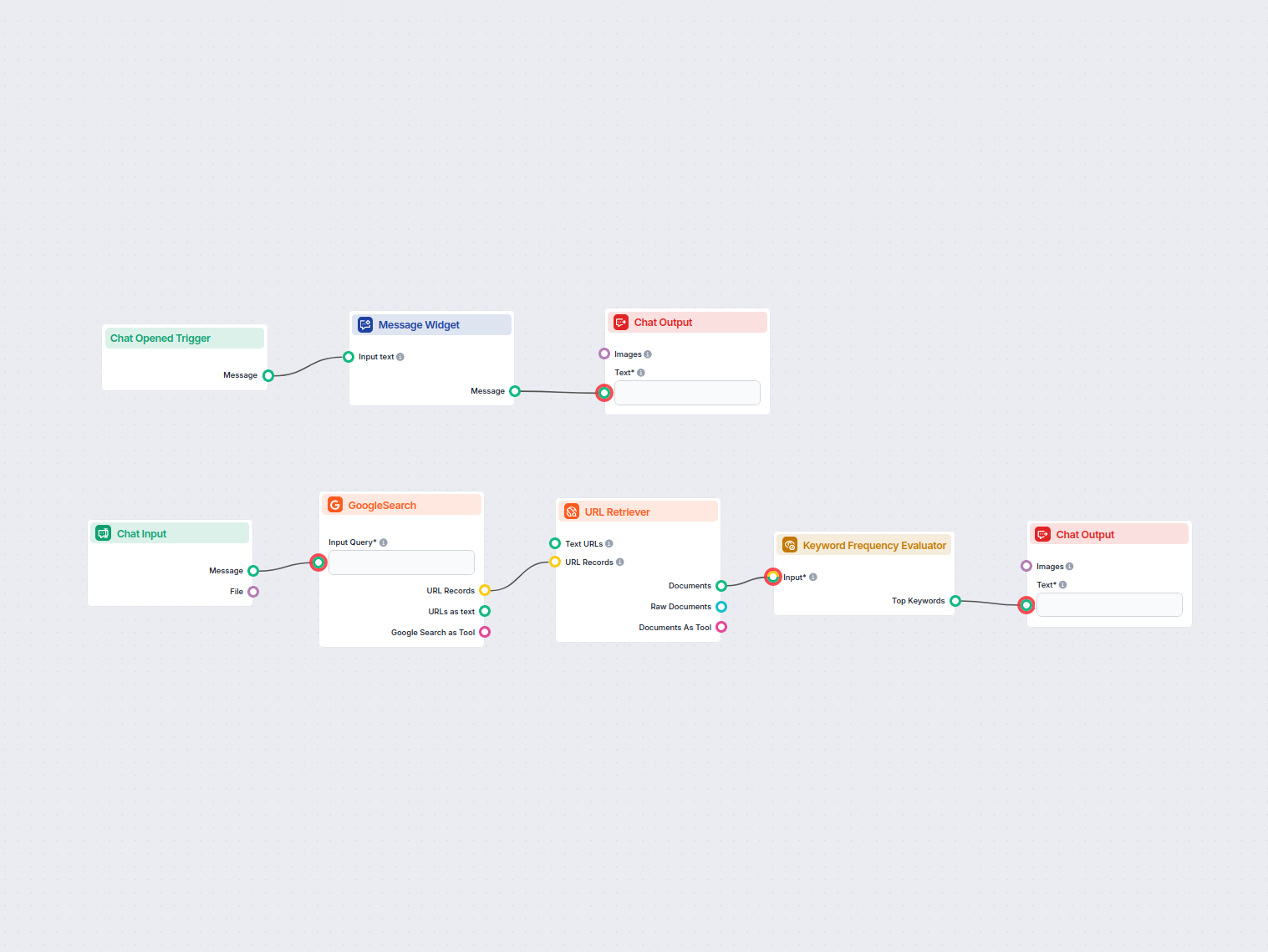

Thành phần Tiện ích Tin nhắn hiển thị các thông điệp tuỳ chỉnh trong quy trình của bạn. Lý tưởng để chào đón người dùng, cung cấp hướng dẫn hoặc hiển thị bất kỳ thông tin quan trọng nào, nó hỗ trợ định dạng Markdown và có thể được thiết lập chỉ hiển thị một lần cho mỗi phiên.

Thành phần Kích Hoạt Khi Mở Chat phát hiện khi một phiên trò chuyện bắt đầu, cho phép quy trình phản hồi ngay lập tức ngay khi người dùng mở chat. Nó khởi tạo luồng với tin nhắn chat đầu tiên, rất cần thiết để xây dựng chatbot tương tác, phản hồi nhanh.

Mở Rộng Truy Vấn trong FlowHunt giúp chatbot hiểu rõ hơn bằng cách tìm từ đồng nghĩa, sửa lỗi chính tả và đảm bảo phản hồi nhất quán, chính xác cho câu hỏi của người dùng.

Trình Tìm kiếm Tài liệu của FlowHunt nâng cao độ chính xác của AI bằng cách kết nối các mô hình tạo sinh với tài liệu và URL cập nhật của riêng bạn, đảm bảo câu trả lời đáng tin cậy và phù hợp nhờ phương pháp Tạo sinh Tăng cường Truy xuất (RAG).

Trưng bày các tài liệu liên quan trực tiếp trong phản hồi của chatbot bằng Widget Nguồn Tri Thức. Thành phần này hiển thị các tài liệu kiến thức đã chọn dưới dạng widget nổi bật, giúp người dùng dễ dàng truy cập và xem lại thông tin hỗ trợ trong quá trình trò chuyện.

FlowHunt hỗ trợ hàng chục mô hình tạo văn bản, bao gồm cả các mô hình của OpenAI. Đây là cách sử dụng ChatGPT trong các công cụ AI và chatbot của bạn.

Mô tả luồng

Quy trình này, có tên “Tìm kiếm Ngữ nghĩa”, cho phép người dùng tìm kiếm thông tin trong kho tri thức riêng tư của họ bằng cách tận dụng các mô hình ngôn ngữ tiên tiến và kỹ thuật tìm kiếm ngữ nghĩa. Nó được thiết kế để quét tất cả các miền, tài liệu và mục Hỏi & Đáp đã được lên lịch, tự động truy xuất thông tin liên quan nhất nhằm đáp ứng truy vấn của người dùng.

Khi người dùng mở giao diện chat, quy trình sẽ kích hoạt một tin nhắn chào mừng:

👋 Chào mừng đến với Công cụ Tìm kiếm Kho Tri thức Riêng tư!

Tôi ở đây để giúp bạn tìm kiếm trong các tài liệu thuộc kho tri thức riêng tư 📚. Tôi sẽ quét tất cả các miền đã lên lịch, tài liệu riêng tư và mục Hỏi & Đáp để tìm thông tin bạn cần.

Chỉ cần nhập truy vấn của bạn, và cùng bắt đầu tìm câu trả lời nhé! ✨🔍

Thông điệp thân thiện này giúp định hướng người dùng và hướng dẫn họ nhập truy vấn tìm kiếm.

Nhập liệu của người dùng:

Người dùng gửi truy vấn qua trường nhập liệu chat.

Mở rộng truy vấn:

gpt-4o-mini), thành phần này tạo ra tối đa ba truy vấn được diễn giải lại hoặc tương tự về mặt ngữ nghĩa.| Thành phần | Mục đích |

|---|---|

| Chat Input | Thu thập câu hỏi tìm kiếm của người dùng |

| OpenAI LLM (gpt-4o-mini) | Tạo ra các cách diễn đạt thay thế cho truy vấn |

| Mở rộng Truy vấn | Sinh tối đa 3 biến thể truy vấn để tìm kiếm |

<H1> để tối đa hóa mức độ liên quan theo ngữ cảnh.| Bước | Thành phần | Loại đầu ra |

|---|---|---|

| Truy xuất tài liệu | Document Retriever | Tài liệu thô |

| Định dạng kết quả | Document Widget | Tin nhắn |

| Hiển thị cho người dùng | Chat Output | Tin nhắn chat |

flowchart LR

A[Chat Opened] --> B[Welcome Message]

B --> C[User Query Input]

C --> D[Query Expansion\n(OpenAI LLM)]

D --> E[Document Retriever]

E --> F[Document Widget]

F --> G[Chat Output]

Các trường hợp sử dụng điển hình:

Bằng cách tích hợp tìm kiếm ngữ nghĩa với mở rộng truy vấn dựa trên LLM, quy trình này đảm bảo người dùng có thể truy cập hiệu quả các tri thức liên quan, gia tăng năng suất và khả năng khám phá thông tin.

Chúng tôi giúp các công ty như của bạn phát triển chatbot thông minh, Máy chủ MCP, công cụ AI hoặc các loại tự động hóa AI khác để thay thế con người trong các tác vụ lặp đi lặp lại trong tổ chức của bạn.

Khám phá những gì mọi người đang bàn luận trực tuyến xung quanh từ khóa bạn chọn. Quy trình AI này nghiên cứu các chủ đề đang thịnh hành hoặc liên quan từ các c...

Luồng này phân tích các từ khóa được sử dụng thường xuyên nhất trên các trang web xếp hạng hàng đầu cho một từ khóa mục tiêu. Lý tưởng cho các chuyên gia SEO và...

Quy trình làm việc sử dụng AI này tự động giải mã các hình ảnh CAPTCHA được người dùng tải lên. Nó hướng dẫn người dùng với các chỉ dẫn, xử lý hình ảnh được tải...

Đồng Ý Cookie

Chúng tôi sử dụng cookie để cải thiện trải nghiệm duyệt web của bạn và phân tích lưu lượng truy cập của mình. See our privacy policy.