Integrace Qiniu MCP Serveru

Qiniu MCP Server propojuje AI asistenty a LLM klienty s úložištěm a multimediálními službami Qiniu Cloud. Umožňuje automatizovanou správu souborů, mediální zpra...

Integrujte jazykový model Qwen Max do svých workflow pomocí tohoto stabilního, škálovatelného MCP serveru postaveného na Node.js/TypeScript pro Claude Desktop a další.

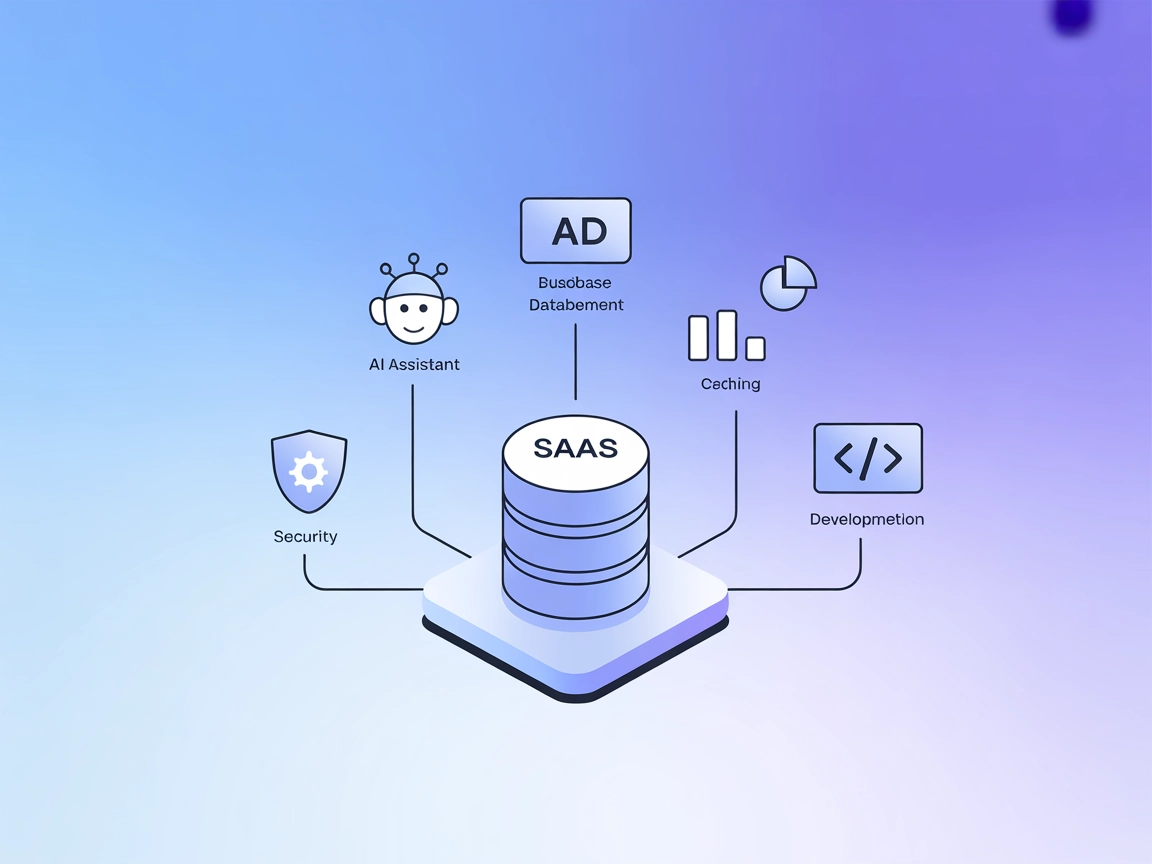

FlowHunt poskytuje dodatečnou bezpečnostní vrstvu mezi vašimi interními systémy a AI nástroji, čímž vám dává podrobnou kontrolu nad tím, které nástroje jsou přístupné z vašich MCP serverů. MCP servery hostované v naší infrastruktuře lze bezproblémově integrovat s chatbotem FlowHunt i s populárními AI platformami jako jsou ChatGPT, Claude a různé AI editory.

Qwen Max MCP Server je implementací Model Context Protocol (MCP) navrženou pro propojení jazykového modelu Qwen Max s externími klienty, jako jsou AI asistenti a vývojářské nástroje. Tím, že funguje jako most, umožňuje bezproblémovou integraci modelů řady Qwen do workflow, které vyžadují pokročilé porozumění a generování jazyka. Usnadňuje vývoj tím, že umožňuje úlohy jako inference s velkým kontextem, vícekrokové uvažování a komplexní interakce promptů. Je postaven na Node.js/TypeScript pro maximální stabilitu a kompatibilitu, server je obzvláště vhodný pro použití s Claude Desktop a podporuje bezpečná a škálovatelná nasazení. Díky podpoře několika variant modelů Qwen optimalizuje jak výkon, tak náklady, což z něj dělá univerzální řešení pro projekty vyžadující robustní jazykové modely.

V repozitáři nejsou uvedeny ani popsány žádné explicitní šablony promptů.

V repozitáři nejsou zdokumentovány žádné explicitní MCP resource primitives.

V repozitáři nejsou přítomny ani popsány žádné explicitní nástroje nebo “server.py” (či ekvivalentní soubor se seznamem spustitelných nástrojů).

npx -y @smithery/cli install @66julienmartin/mcp-server-qwen_max --client windsurf

{

"mcpServers": [

{

"command": "npx",

"args": ["@66julienmartin/mcp-server-qwen_max", "start"]

}

]

}

{

"env": {

"DASHSCOPE_API_KEY": "<your_api_key>"

}

}

npx -y @smithery/cli install @66julienmartin/mcp-server-qwen_max --client claude

{

"mcpServers": [

{

"command": "npx",

"args": ["@66julienmartin/mcp-server-qwen_max", "start"]

}

]

}

{

"env": {

"DASHSCOPE_API_KEY": "<your_api_key>"

}

}

npx -y @smithery/cli install @66julienmartin/mcp-server-qwen_max --client cursor

{

"mcpServers": [

{

"command": "npx",

"args": ["@66julienmartin/mcp-server-qwen_max", "start"]

}

]

}

{

"env": {

"DASHSCOPE_API_KEY": "<your_api_key>"

}

}

npx -y @smithery/cli install @66julienmartin/mcp-server-qwen_max --client cline

{

"mcpServers": [

{

"command": "npx",

"args": ["@66julienmartin/mcp-server-qwen_max", "start"]

}

]

}

{

"env": {

"DASHSCOPE_API_KEY": "<your_api_key>"

}

}

Použití MCP ve FlowHunt

Chcete-li integrovat MCP servery do svého workflow ve FlowHunt, začněte přidáním MCP komponenty do vašeho flow a připojte ji k AI agentovi:

Klikněte na komponentu MCP a otevřete konfigurační panel. V sekci systémové konfigurace MCP vložte detaily svého MCP serveru v tomto JSON formátu:

{

"qwen-max": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Po konfiguraci může AI agent tento MCP využívat jako nástroj se všemi jeho funkcemi a možnostmi. Nezapomeňte změnit “qwen-max” na skutečný název vašeho MCP serveru (např. “github-mcp”, “weather-api” apod.) a nahradit URL vlastní adresou MCP serveru.

| Sekce | Dostupnost | Detaily/Poznámky |

|---|---|---|

| Přehled | ✅ | Kompletní přehled a info o modelech |

| Seznam promptů | ⛔ | Žádné šablony promptů zdokumentovány |

| Seznam zdrojů | ⛔ | Žádné explicitní MCP resource primitives |

| Seznam nástrojů | ⛔ | Žádné nástroje explicitně uvedeny |

| Zabezpečení API klíčů | ✅ | Použití proměnných prostředí v nastavení popsáno |

| Podpora samplování (méně důležité v hodnocení) | ⛔ | Není zmíněno |

Na základě uvedených informací je Qwen Max MCP Server dobře zdokumentován pro instalaci a detaily modelů, ale postrádá explicitní dokumentaci nebo implementaci MCP zdrojů, nástrojů či šablon promptů ve veřejném repozitáři. To omezuje jeho rozšiřitelnost a okamžitou použitelnost pro pokročilé MCP funkce.

Tento MCP server hodnotíme na 5/10. Instalace i podpora modelu jsou jasně popsány a projekt je open source s permisivní licencí, avšak chybějící dokumentace nástrojů, zdrojů a prompt šablon snižuje jeho okamžitou hodnotu pro workflow závislé na plných možnostech MCP.

| Má LICENCI | ✅ |

|---|---|

| Má alespoň jeden nástroj | ⛔ |

| Počet Forků | 6 |

| Počet Hvězdiček | 19 |

Qwen Max MCP Server je server Model Context Protocol (MCP), který propojuje Qwen Max a související jazykové modely s externími klienty a vývojářskými nástroji. Umožňuje inferenci s velkým kontextem, vícekrokové uvažování a zpřístupňuje Qwen modely přes jednotné rozhraní.

Umožňuje chat a inferenci s velkým kontextem (až 32 768 tokenů), experimentování s modely, bezproblémovou integraci s Claude Desktop, přístup přes API pro tvorbu asistentů či automatizací a správu nákladů na tokeny při nasazení.

Ne, aktuální veřejné úložiště neobsahuje žádné explicitní šablony promptů, MCP resource primitives ani spustitelné nástroje pro tento server.

Uložte svůj DASHSCOPE_API_KEY do proměnných prostředí dle instrukcí pro každý klient. Tímto udržíte citlivé klíče mimo zdrojové kódy a konfigurační soubory.

Ano, server je open source s permisivní licencí, takže je vhodný jak pro experimenty, tak pro produkční použití.

Je dobře zdokumentovaný pro instalaci a integraci modelů, ale postrádá okamžitou podporu nástrojů, zdrojů nebo šablon promptů, což vede k celkovému hodnocení 5/10.

Odemkněte AI schopnosti s velkým kontextem a bezproblémovou integraci s Qwen Max MCP Serverem. Začněte vytvářet s pokročilými jazykovými modely již nyní.

Qiniu MCP Server propojuje AI asistenty a LLM klienty s úložištěm a multimediálními službami Qiniu Cloud. Umožňuje automatizovanou správu souborů, mediální zpra...

Quarkus MCP Server umožňuje uživatelům FlowHunt propojit AI agenty využívající LLM s externími databázemi a službami skrze Java MCP servery, což zefektivňuje au...

KWDB MCP Server propojuje AI asistenty s databází KWDB a umožňuje business intelligence, manipulaci s daty a bezproblémovou integraci s workflow FlowHunt. Nabíz...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.