AI-agenter: Sådan tænker GPT 4o

Udforsk tankeprocesserne hos AI-agenter i denne omfattende evaluering af GPT-4o. Opdag, hvordan den præsterer på opgaver som indholdsgenerering, problemløsning ...

Dyk ned i en dybdegående sammenlignende analyse af 20 førende AI-agentmodeller, hvor deres styrker, svagheder og præstationer vurderes på opgaver som indholdsgenerering, problemløsning, sammenfatning, sammenligning og kreativ skrivning.

Vi testede 20 forskellige AI-agentmodeller på fem kerneopgaver, hver designet til at udfordre forskellige evner:

Vores analyse fokuserede både på kvaliteten af outputtet og agentens tænkningsproces, hvor vi vurderede dens evne til at planlægge, ræsonnere, tilpasse sig og effektivt udnytte tilgængelige værktøjer. Vi har rangeret modellerne ud fra deres præstation som AI-agent, hvor deres tænkningsprocesser og strategier har haft størst betydning.

Alle tyve modeller viste en stærk evne til at generere artikler af høj kvalitet og informativt indhold. Den følgende rangerede liste tager dog hensyn til hver agents interne tænkningsproces og hvordan de nåede frem til deres endelige output:

Vi vurderede modellernes matematiske evner og problemløsningsstrategier:

Vi vurderede modellernes evne til at udtrække hovedinformation og producere præcise sammenfatninger:

Denne analyse vurderer 20 førende AI-agentmodeller og vurderer deres præstationer på opgaver som indholdsgenerering, problemløsning, sammenfatning, sammenligning og kreativ skrivning, med særlig vægt på hver models tænkningsproces og tilpasningsevne.

Ifølge de endelige rangeringer opnåede Claude 3.5 Sonnet den højeste samlede præstation og udmærkede sig i nøjagtighed, strategisk tænkning og konsekvent høj kvalitet i output.

Hver model blev testet på fem kerneopgaver: indholdsgenerering, problemløsning, sammenfatning, sammenligning og kreativ skrivning. Vurderingen tog ikke kun outputkvaliteten i betragtning, men også ræsonnement, planlægning, værktøjsbrug og tilpasningsevne.

Ja, FlowHunt tilbyder en platform til at bygge, vurdere og implementere brugerdefinerede AI-agenter og chatbots, så du kan automatisere opgaver, forbedre arbejdsgange og udnytte avancerede AI-muligheder til din virksomhed.

Blogindlægget giver detaljerede opgave-for-opgave-gennemgange og endelige rangeringer for hver af de 20 AI-agentmodeller, hvor deres unikke styrker og svagheder fremhæves på tværs af forskellige opgaver.

Begynd at bygge dine egne AI-løsninger med FlowHunt's kraftfulde platform. Sammenlign, vurder og implementer toppræsterende AI-agenter til dine forretningsbehov.

Udforsk tankeprocesserne hos AI-agenter i denne omfattende evaluering af GPT-4o. Opdag, hvordan den præsterer på opgaver som indholdsgenerering, problemløsning ...

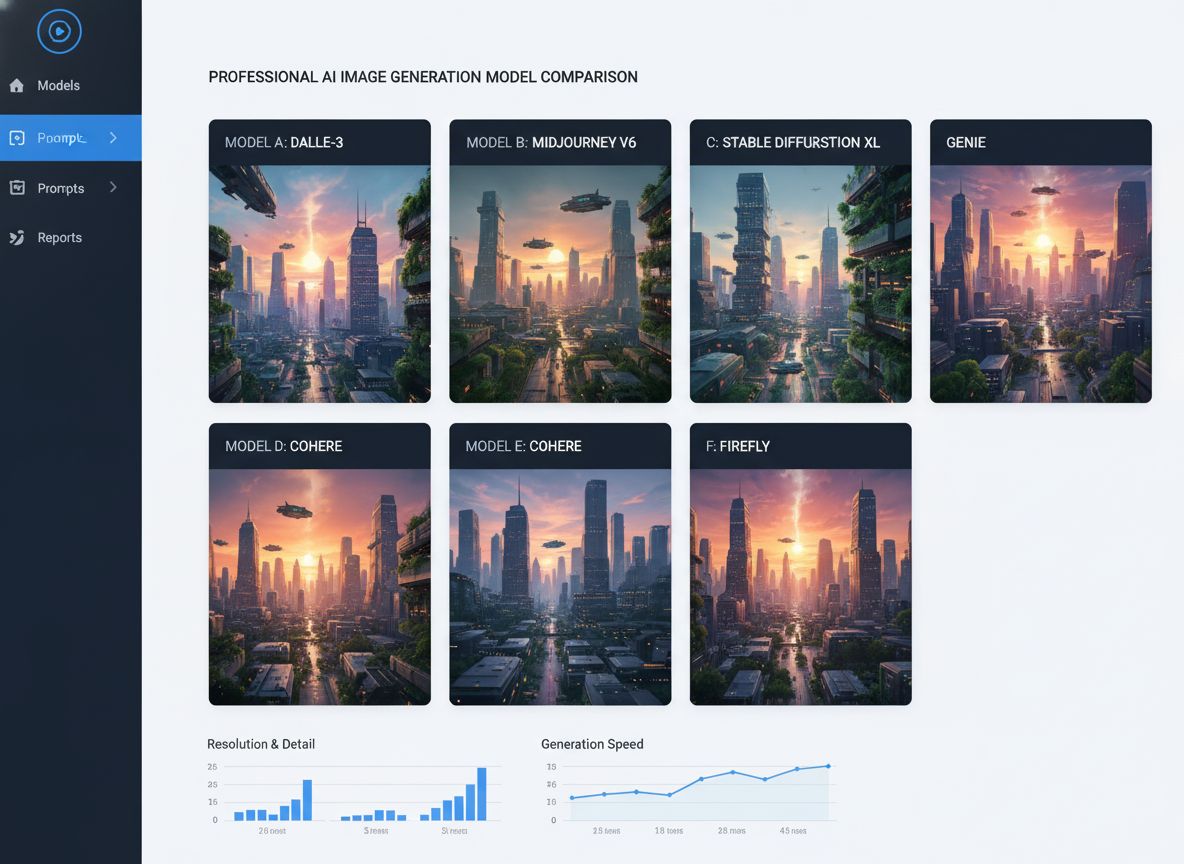

Omfattende sammenligning af førende AI-billedgenereringsmodeller, herunder Qwen ImageEdit Plus, Nano Banana, GPT Image 1 og Seadream. Find ud af, hvilken model ...

Udforsk de avancerede evner hos Llama 3.2 1B AI Agent. Dette dybdegående indblik afslører, hvordan den går ud over tekstgenerering og fremviser dens evner inden...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.