Metaprompt

Et metaprompt i kunstig intelligens er en højniveau-instruktion designet til at generere eller forbedre andre prompts for store sprogmodeller (LLM'er), hvilket ...

Bliv ekspert i promptoptimering til AI ved at udforme klare, kontekstfyldte prompts for at øge outputkvaliteten, reducere omkostninger og forkorte behandlingstiden. Udforsk teknikker til smartere AI-arbejdsgange.

Promptoptimering betyder at forfine det input, du giver til en AI-model, så den leverer de mest præcise og effektive svar muligt. Det handler ikke kun om klar kommunikation—optimerede prompts reducerer også det beregningsmæssige arbejde, hvilket giver hurtigere behandlingstider og lavere omkostninger. Uanset om du skriver forespørgsler til kundesupport-chatbots eller genererer komplekse rapporter, har det betydning, hvordan du strukturerer og formulerer dine prompts.

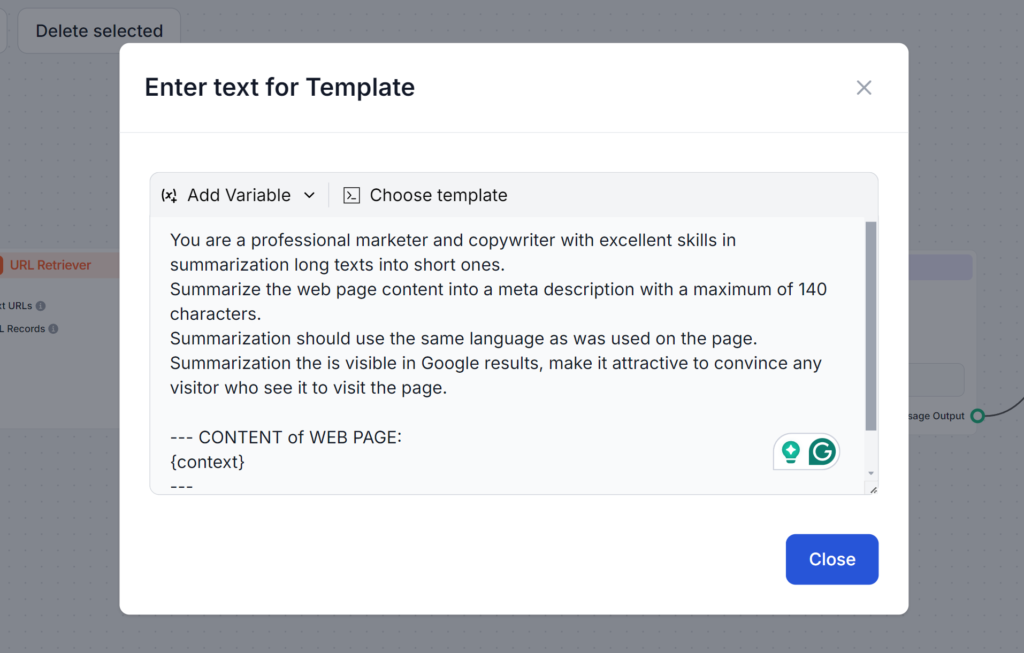

Har du nogensinde forsøgt at få AI til at skrive en meta-beskrivelse? Sandsynligvis lød din første prompt nogenlunde sådan her:

Skriv en meta-beskrivelse om emnet promptoptimering.

Denne prompt er forkert af flere årsager. Hvis du ikke specificerer den længde på 140 tegn, som Google kræver, vil AI’en gå langt over. Hvis den rammer længden, bruger den ofte en anden stil eller gør beskrivelsen for kedelig til, at nogen vil klikke på den. Endelig, uden at læse din artikel, kan den kun lave vage meta-beskrivelser.

Se prompten nedenfor. Den er længere og bruger flere teknikker, vi lærer i dette blogindlæg. Det, denne prompt gør godt, er, at den adresserer alle mulige udfordringer, så du får det nøjagtige output, du har brug for, i første forsøg:

Tokens er byggestenene i tekst, som AI-modeller behandler. Modellerne opdeler teksten i disse tokens. Et enkelt token kan være ét ord, flere ord eller endda en del af et ord. Flere tokens betyder som regel langsommere svar og højere beregningsomkostninger. Derfor er det vigtigt at forstå, hvordan tokens fungerer, for at lave bedre prompts, der er både omkostnings- og tidseffektive.

Hvorfor tokens er vigtige:

For eksempel:

I prompten med mange tokens bliver AI’en bedt om at gå i detaljer med alle muligheder, mens prompten med få tokens beder om et simpelt overblik. Når du ser overblikket, kan du udbygge det efter behov og nå dit ønskede resultat hurtigere og billigere.

At skabe effektive prompts kræver en blanding af klarhed, kontekst og kreativitet. Det anbefales at afprøve forskellige formater for at finde de mest effektive måder at spørge AI’en på. Her er nogle vigtige teknikker:

Uklare prompts kan forvirre modellen. En velstruktureret prompt sikrer, at AI’en forstår din hensigt.

Eksempel:

Relevante detaljer hjælper AI’en med at generere svar, der er tilpasset dine behov.

Eksempel:

At tilføje eksempler guider AI’en til at forstå det format eller den tone, du ønsker.

Eksempel:

At bruge standardiserede skabeloner til lignende opgaver sikrer ensartethed og sparer tid.

Eksempelskabelon til blogindlæg:

“Skriv et blogindlæg på [antal ord] om [emne], med fokus på [specifikke detaljer]. Brug en venlig tone og inkluder [nøgleord].”

Flere avancerede strategier kan hjælpe dig med at tage dine prompts til næste niveau. Disse teknikker går ud over basal klarhed og struktur og gør det muligt at håndtere mere komplekse opgaver, integrere dynamiske data og tilpasse AI-svar til specifikke domæner eller behov. Her er et kort overblik over, hvordan hver teknik fungerer, med praktiske eksempler som guide.

Few-shot learning handler om at give et lille antal eksempler i din prompt for at hjælpe AI’en med at forstå det mønster eller format, du har brug for. Det gør modellen i stand til at generalisere ud fra meget lidt data, hvilket er ideelt til nye eller ukendte opgaver.

Angiv blot nogle få eksempler i din prompt for at vise modellen dine forventninger.

Eksempel-prompt:

Oversæt følgende sætninger til fransk:

Prompt chaining er processen med at opdele komplekse opgaver i mindre, håndterbare trin, der bygger oven på hinanden. Denne metode gør det muligt for AI’en at løse flertrinsopgaver systematisk og sikrer klarhed og præcision i output.

Eksempel-prompt:

Kontekstuel hentning integrerer relevante, opdaterede informationer i prompten ved at henvise til eksterne kilder eller opsummere nøgleoplysninger. På den måde får AI adgang til præcise og aktuelle data for mere velinformerede svar.

Eksempel:

“Ved brug af data fra denne rapport [indsæt link], opsummer nøglefund om vedvarende energi [tendenser].”

Finjustering med embeddings tilpasser AI-modellen til specifikke opgaver eller domæner ved brug af specialiserede datarepræsentationer. Denne tilpasning øger relevansen og præcisionen af svar i niche- eller branchespecifikke anvendelser.

At styre tokenforbruget giver dig kontrol over, hvor hurtigt og omkostningseffektivt AI håndterer input og output. Ved at reducere antallet af behandlede tokens kan du spare penge og få hurtigere svar uden at gå på kompromis med kvaliteten. Her er teknikker til effektiv tokenstyring:

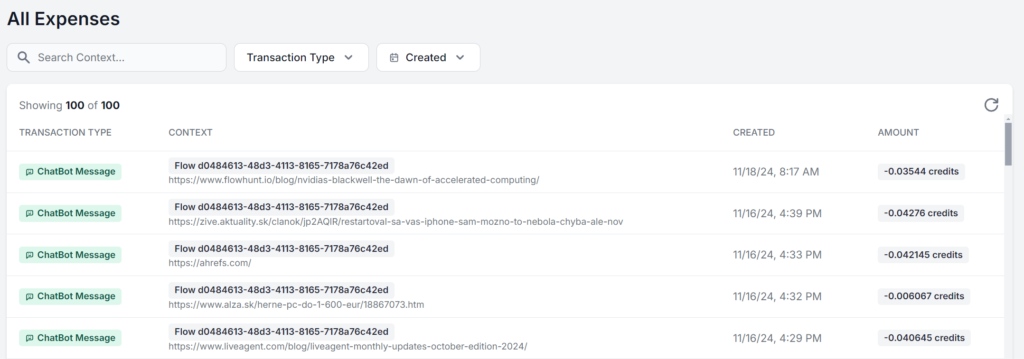

Optimering stopper ikke ved at skrive bedre prompts. Følg regelmæssigt op på ydeevnen og justér ud fra feedback. Denne løbende opfølgning giver mulighed for kontinuerlig forbedring, så du kan foretage informerede ændringer.

Fokusér på disse nøgleområder:

Den bedste tilgang er at arbejde i et interface, hvor du kan se og analysere dit præcise forbrug for hver prompt. Her ses samme FlowHunt AI-arbejdsgang kørt 5 gange, hvor kun kildematerialet ændres. Forskellen i omkostning er kun få øre, men jo flere gange det gentages, desto mere mærkbart bliver det:

Uanset om du bare vil have mest muligt ud af den gratis grænse på AI-modeller eller bygger din AI-strategi i stor skala, er promptoptimering afgørende for alle, der bruger AI. Disse teknikker gør det muligt at bruge AI effektivt, få præcise resultater og reducere omkostningerne.

Efterhånden som AI-teknologien udvikler sig, vil vigtigheden af klar og optimeret kommunikation med modellerne kun vokse. Begynd allerede i dag med at eksperimentere med disse strategier—helt gratis. FlowHunt lader dig bygge med forskellige AI-modeller og funktioner i ét samlet dashboard, så du kan optimere og effektivisere AI-arbejdsgange til enhver opgave. Prøv 14 dages gratis prøveperiode !

Promptoptimering handler om at forfine det input, du giver til en AI-model, så den leverer de mest præcise og effektive svar. Optimerede prompts reducerer det beregningsmæssige arbejde, hvilket giver hurtigere behandlingstider og lavere omkostninger.

Antallet af tokens påvirker både hastigheden og omkostningerne ved AI-output. Færre tokens giver hurtigere svar og lavere omkostninger, mens korte prompts hjælper modellerne med at fokusere på relevante detaljer.

Avancerede teknikker inkluderer few-shot learning, prompt chaining, kontekstuel hentning og finjustering med embeddings. Disse metoder hjælper med at løse komplekse opgaver, integrere dynamiske data og tilpasse svar til specifikke behov.

Overvåg svarenes nøjagtighed, tokenforbrug og behandlingstider. Løbende opfølgning og iteration baseret på feedback hjælper med at forfine prompts og bevare effektiviteten.

FlowHunt tilbyder værktøjer og et dashboard til at bygge, teste og optimere AI-prompts, så du kan eksperimentere med forskellige modeller og strategier til effektive AI-arbejdsgange.

Maria er tekstforfatter hos FlowHunt. En sprog-nørd aktiv i litterære fællesskaber, hun er fuldt ud bevidst om, at AI er ved at forandre den måde, vi skriver på. I stedet for at modstå søger hun at hjælpe med at definere den perfekte balance mellem AI-arbejdsgange og den uerstattelige værdi af menneskelig kreativitet.

Begynd at bygge optimerede AI-arbejdsgange med FlowHunt. Eksperimentér med prompt engineering og øg din produktivitet.

Et metaprompt i kunstig intelligens er en højniveau-instruktion designet til at generere eller forbedre andre prompts for store sprogmodeller (LLM'er), hvilket ...

Prompt engineering er praksissen med at designe og forfine input til generative AI-modeller for at opnå optimale resultater. Dette indebærer at udforme præcise ...

Opdag hvorfor prompt engineering hurtigt bliver en essentiel færdighed for enhver professionel, hvordan det forvandler produktiviteten på arbejdspladsen, og hvo...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.