OceanBase

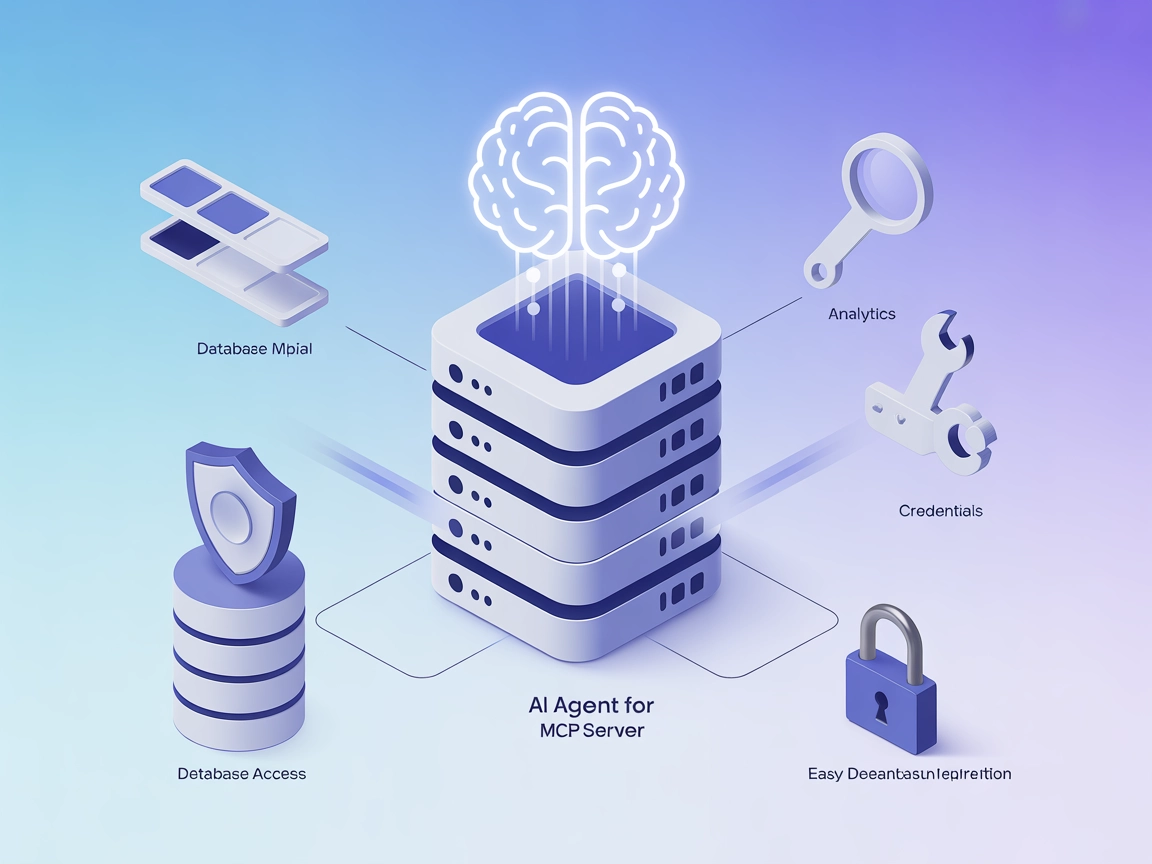

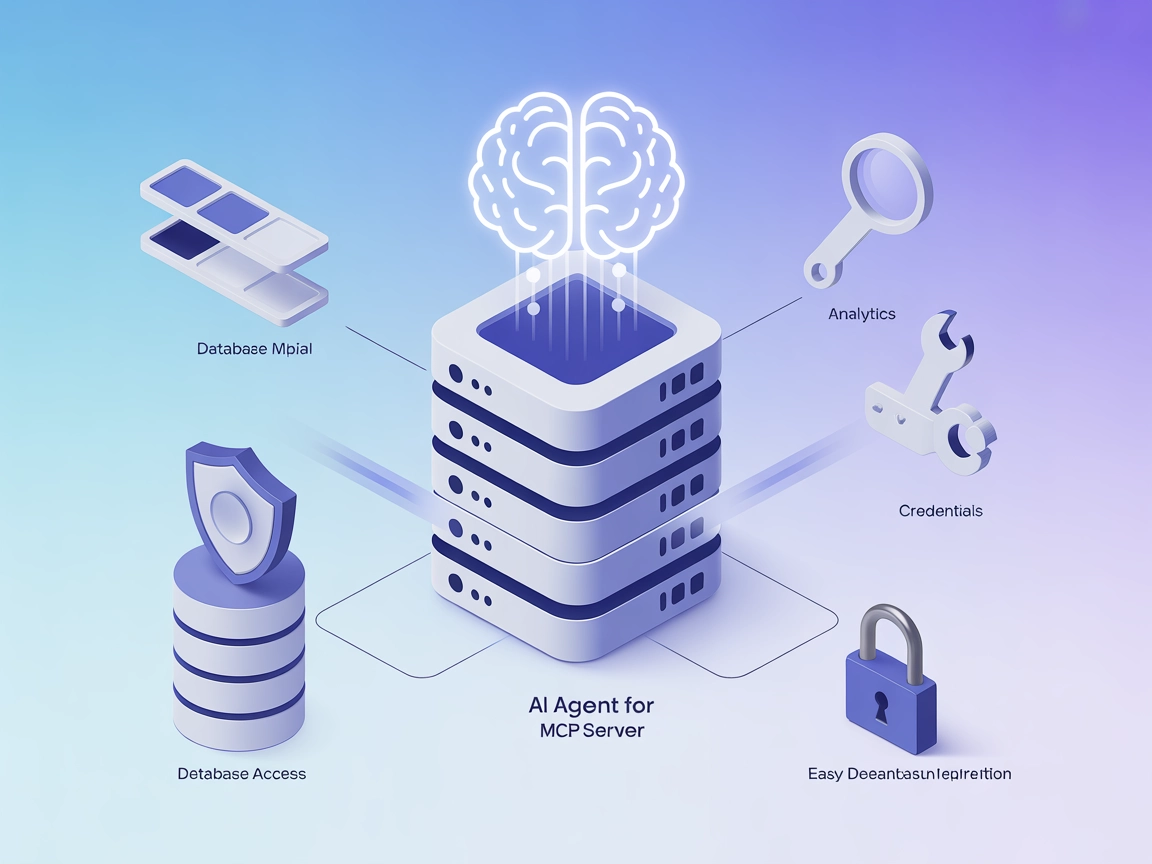

Integrer FlowHunt med OceanBase ved hjælp af OceanBase MCP Server for at muliggøre sikker, AI-drevet databaseautomatisering, analyse og udforskning. Giv trygt A...

En omfattende guide til sikker integration af AI-platforme med din database ved hjælp af API-gateways, kryptering, adgangskontrol og overvågningsstrategier.

Vigtige sikkerhedspraksisser ved eksponering af databaser for AI:

Sikker databaseeksponering betyder, at AI-systemer får adgang til de data, de har brug for, mens der opretholdes stramme kontroller over, hvilke data der tilgås, hvem (eller hvad) der tilgår dem, hvornår adgangen sker, og hvordan denne adgang overvåges og logges. Det er fundamentalt anderledes end blot at åbne din database for internettet eller give AI-platforme direkte databaseoplysninger.

Når vi taler om at eksponere en database for AI-platforme, beskriver vi en bevidst arkitekturbeslutning om at skabe et kontrolleret interface mellem dine data og eksterne AI-systemer. Dette interface fungerer som et sikkerhedstjekpunkt, der håndhæver autentificering, autorisation, kryptering og revisionslogning i alle trin. Målet er at skabe det, som sikkerhedsfolk kalder et “single choke point” – et centralt sted, hvor al adgang kan overvåges, kontrolleres og valideres.

Udfordringen er, at AI-platforme ofte kræver bred adgang til forskellige datasæt for at fungere effektivt. En maskinlæringsmodel kan for eksempel have brug for at analysere kundeadfærd, transaktionshistorik og produktinformation samtidigt. Et generativt AI-system kan skulle søge på tværs af flere tabeller for at besvare komplekse spørgsmål. At give denne adgang uden de rette sikkerhedsforanstaltninger kan dog eksponere din organisation for databrud, overtrædelse af lovgivning og interne trusler.

Den forretningsmæssige fordel ved at eksponere databaser sikkert for AI er markant. Organisationer, der med succes integrerer AI med deres datainfrastruktur, opnår betydelige konkurrencemæssige fordele: hurtigere beslutningstagning, automatiserede indsigter, forbedret kundeoplevelse og operationel effektivitet. Men risiciene er tilsvarende betydelige.

Databrud, der involverer eksponerede databaser, er blevet mere almindelige og omkostningstunge. Den gennemsnitlige pris for et databrud i 2024 oversteg $4,45 millioner, hvor database-relaterede hændelser udgør en væsentlig del af disse tab. Når bruddet involverer persondata underlagt regler som GDPR eller CCPA, mangedobles de økonomiske og omdømmemæssige konsekvenser dramatisk. Ud over de direkte omkostninger risikerer organisationer driftsforstyrrelser, tab af kundetillid og potentiel juridisk ansvar.

Udfordringen forstærkes, når AI-systemer er involveret. AI-modeller kan utilsigtet huske følsomme træningsdata, som kan genskabes via prompt injection-angreb eller modeludvinding. AI-agenter, der opererer med databaseadgang, kan manipuleres gennem nøje udformede prompts til at udføre uønskede forespørgsler eller eksponere fortrolige oplysninger. Disse nye trusselsvektorer kræver sikkerhedsforanstaltninger, der rækker ud over traditionel databasebeskyttelse.

Samtidig øges reguleringen af AI hurtigt. Datatilsynsmyndigheder verden over udsender vejledninger om, hvordan organisationer skal håndtere persondata, når de bruger AI-systemer. Overholdelse af GDPR, CCPA, HIPAA og nye AI-specifikke regler kræver, at du kan dokumentere passende sikkerhedsforanstaltninger, før data eksponeres for AI-platforme.

Før du implementerer nogen strategi for at eksponere din database for AI-platforme, skal du have et klart billede af dit nuværende sikkerhedssetup og datalandskab. Denne vurdering bør besvare flere kritiske spørgsmål:

Hvilke data har du egentlig? Udfør en grundig dataopgørelse og klassificering. Kategorisér dine data efter følsomhedsniveau: offentlige, interne, fortrolige og restriktive. Identificér, hvilke data der indeholder personhenførbare oplysninger (PII), betalingskortoplysninger (PCI), beskyttede helbredsoplysninger (PHI) eller andre regulerede datatyper. Denne klassificering danner grundlag for alle efterfølgende adgangskontrolbeslutninger.

Hvilke sikkerhedskontroller har du i dag? Dokumentér dine eksisterende database-sikkerhedsforanstaltninger: autentificeringsmekanismer, krypteringsstatus (både under overførsel og i hvile), netværkssegmentering, backup- og gendannelsesprocedurer samt muligheder for revisionslogning. Identificér huller, hvor kontroller mangler eller er forældede.

Hvilke compliance-krav har du? Gennemgå gældende regler for din branche og geografi. Håndterer du persondata, er GDPR sandsynligvis obligatorisk. Arbejder du med sundhedsdata, gælder HIPAA. Finansielle virksomheder skal tage højde for PCI-DSS. At forstå disse krav former din sikkerhedsarkitektur.

Hvad er din risikotolerance? Forskellige organisationer har forskellig risikovillighed. En sundhedsudbyder med patientdata har langt lavere risikotolerance end en SaaS-virksomhed med anonyme brugsdata. Din risikotolerance bør informere, hvor restriktive dine adgangskontroller skal være.

Den vigtigste arkitekturbeslutning, du træffer, er aldrig at eksponere din database direkte for AI-platforme. Brug i stedet en sikker API-gateway, der placeres mellem din database og eksterne systemer. Gateways fungerer som det centrale kontrolpunkt for al databaseadgang.

En API-gateway varetager flere væsentlige funktioner. Først skaber den et abstraheringslag, der afkobler AI-platformen fra din databasestruktur. Hvis din databasestruktur ændres, skal du kun opdatere API’en – ikke forhandle adgang med hver AI-platform. Dernæst kan du implementere ensartede sikkerhedspolitikker på tværs af alle adgangsforespørgsler. Endelig skaber gatewayen et centralt sted for overvågning, logging og alarmering ved mistænkelig aktivitet.

Når du vælger eller bygger en API-gateway, skal du kigge efter løsninger, der understøtter identitetsbevidst proxying (IAP). En IAP-gateway autentificerer hver forespørgsel, før den når din database, og sikrer, at kun autoriserede systemer kan tilgå data. Den bør understøtte flere autentificeringsmetoder såsom OAuth 2.0, JWT-tokens, mutual TLS (mTLS) og API-nøgler. Gatewayen skal også håndhæve ratelimitering for at forhindre misbrug og implementere forespørgselsvalidering for at blokere fejlbehæftede eller mistænkelige forespørgsler.

Populære muligheder inkluderer cloud-native løsninger som AWS API Gateway med IAM-integration, Google Clouds Identity-Aware Proxy, Azure API Management eller specialiserede databaseadgangsløsninger som Hoop eller DreamFactory. Alle har forskellige styrker, men det fælles princip er at skabe et kontrolleret adgangslag.

Når du har en API-gateway på plads, er næste kritiske lag at implementere robuste autentificerings- og autorisationsmekanismer. Disse to begreber forveksles ofte, men har forskellige formål: autentificering bekræfter, hvem (eller hvad) der anmoder, mens autorisation afgør, hvad denne enhed må gøre.

For menneskelige brugere, der tilgår AI-systemer med databaseadgang, bør du implementere multifaktorautentificering (MFA). Det kombinerer typisk noget, du ved (adgangskode), noget, du har (mobiltelefon eller hardwaretoken) og noget, du er (biometri). MFA reducerer markant risikoen for kontoovertagelse, som ofte er indgangsporten til databrud.

For AI-systemer og serviceprincipaler skal du bruge stærke, automatisk roterede legitimationsoplysninger. Hårdkod aldrig databaseoplysninger i kode eller konfigurationsfiler. Brug i stedet miljøvariabler, secrets management-systemer (som HashiCorp Vault, AWS Secrets Manager eller Azure Key Vault) eller cloud-native credential-systemer, der automatisk roterer legitimationsoplysninger efter tidsplan.

Implementér certifikatbaseret autentificering, hvor det er muligt. Mutual TLS (mTLS), hvor både klient og server autentificerer hinanden via digitale certifikater, giver stærkere sikkerhed end adgangskodebaseret autentificering. Hver AI-platform eller service får et unikt certifikat, der skal præsenteres for at tilgå API-gatewayen.

Rollebaseret adgangskontrol (RBAC) er den mest anvendte autorisationsmodel. Du definerer roller (som “AI_Analytics_Reader” eller “ML_Training_Agent”) og tildeler rettigheder til disse roller. Hvert AI-system får en eller flere roller og kan kun udføre de handlinger, rollerne tillader. RBAC er let at implementere og forstå og passer til de fleste organisationer.

Attribusbaseret adgangskontrol (ABAC) er mere avanceret og fleksibel. I stedet for at tildele roller definerer du politikker baseret på attribusser ved forespørgslen: brugerens afdeling, dataklassificering, tidspunkt på dagen, geografisk placering, adgangsformål og meget mere. ABAC muliggør finere kontrol, men kræver omhyggelig policy-design.

Anvend princippet om mindst privilegium: Giv hvert AI-system kun de minimale rettigheder, det har brug for. Skal et AI-system kun læse kundenavne og e-mailadresser, så giv det ikke adgang til betalingsoplysninger eller CPR-numre. Har det kun brug for læseadgang, skal det ikke have skrive- eller sletterettigheder.

Selv med stærk autentificering og autorisation skal du beskytte selve dataene. Det kræver to komplementære strategier: kryptering og datamaskering.

Kryptering under overførsel beskytter data, mens de bevæger sig mellem din database og AI-platformen. Brug TLS 1.2 eller højere på alle forbindelser. Selv hvis netværkstrafikken opsnappes, forbliver dataene ulæselige uden krypteringsnøglerne. De fleste moderne API-gateways og databasesystemer understøtter TLS som standard, men tjek, at det er aktiveret og korrekt konfigureret.

Kryptering i hvile beskytter data lagret i din database. Selv hvis en angriber får adgang til databasefiler eller backups, kan de ikke læse dataene uden krypteringsnøgler. De fleste moderne databaser understøtter transparent data encryption (TDE) eller lignende. Aktiver denne funktion og sørg for sikker nøglehåndtering.

Nøglehåndtering er afgørende. Opbevar aldrig krypteringsnøgler samme sted som de krypterede data. Brug en dedikeret key management service (KMS), der kontrollerer adgang til nøgler uafhængigt af databaseadgang. Rotér krypteringsnøgler regelmæssigt – mindst årligt, oftere for meget følsomme data. Brug versionsstyring, så gamle nøgler stadig kan dekryptere historiske data.

Datamaskering indebærer at erstatte følsomme værdier med maskeret eller syntetisk data. For eksempel kan et CPR-nummer maskeres som “XXX-XX-1234”, hvor kun de sidste fire cifre vises. Et kreditkortnummer kan maskeres som “--****-4567”. På den måde kan AI-systemer arbejde med data med samme struktur og fordeling som de rigtige data – uden at følsomme værdier afsløres.

Dynamisk datamaskering anvender maskeringsregler ved forespørgselstidspunktet, baseret på brugerens rolle og dataklassificering. En kundeservicemedarbejder kan se fulde navne og telefonnumre, mens et AI-analysesystem kun ser maskede versioner. Dette er mere fleksibelt end statisk maskering, da du kan anvende forskellige regler til forskellige brugere.

Implementér maskering på kolonneniveau for dine mest følsomme data. Identificér kolonner med PII, betalingsoplysninger, helbredsdata eller andet reguleret – og anvend maskeringsregler på disse. Mange databaser understøtter dette, eller det kan implementeres i API-gateway-laget.

Lad os se, hvordan RBAC virker i praksis. Forestil dig en database med kundeoplysninger, transaktionshistorik og produktdata. Du vil eksponere denne database for tre AI-systemer: en anbefalingsmotor, et svindeldetektionssystem og en kundeanalyseplatform.

| AI-system | Nødvendig adgang | Anbefalet rolle | Specifikke rettigheder |

|---|---|---|---|

| Anbefalingsmotor | Kundeprofiler, købsdata | AI_RECOMMENDATIONS_READER | SELECT på kunder, ordrer, produkter; ingen adgang til betalingsmetoder eller kontaktinfo |

| Svindeldetektion | Transaktionsdetaljer, kundehistorik | AI_FRAUD_DETECTOR | SELECT på transaktioner, kunder, konti; adgang til betalingsoplysninger, men ikke kontaktinfo |

| Analyseplatform | Aggregerede kundedata | AI_ANALYTICS_READER | SELECT på aggregerede views; ingen adgang til individuelle kundeoplysninger eller transaktioner |

Hver rolle har specifikke rettigheder, der begrænser adgang til de nødvendige data og operationer. Anbefalingsmotoren kan ikke se betalingsinfo, fordi det ikke er nødvendigt. Svindeldetektionssystemet kan se transaktioner, men ikke kundernes e-mails. Analyseplatformen ser kun aggregerede data, ikke enkeltdataposter.

Dette sikrer, at hvis ét AI-system kompromitteres, er adgangsfladen begrænset til de data, det system bruger. Skadeomfanget minimeres.

Selv med stærke forebyggende kontroller skal du kunne opdage og reagere på sikkerhedshændelser. Det kræver omfattende overvågning, detaljeret auditing og automatiseret trusselsdetektion.

Aktivér detaljeret revisionslogning for al databaseadgang. Hver forespørgsel fra et AI-system skal logges, inkl.:

Opbevar revisionslogs sikkert og uforanderligt et andet sted end din primære database. Cloud-udbydere tilbyder managed logging-tjenester (som AWS CloudTrail, Google Cloud Logging, Azure Monitor) med denne funktionalitet. Bevar logs i mindst et år – længere for følsomme data.

Implementér realtidsmonitorering, der opdager mistænkelige adgangsmønstre. Opsæt alarmer for:

Moderne databaseovervågningsværktøjer kan fingeraftrykke forespørgsler og automatisk registrere afvigelser. Værktøjer som Imperva, Satori m.fl. tilbyder AI-drevet trusselsdetektion, som lærer normale adgangsmønstre og advarer ved afvigelser.

Udarbejd en incident response-plan, der dækker database-sikkerhedshændelser med AI-systemer. Planen bør inkludere:

For organisationer med store, forskellige datasæt kan segmentering reducere eksponering. Det kan gøres på flere måder:

Netværkssegmentering: Placer databasen på et separat netværkssegment med begrænset adgang. Kun API-gatewayen må tilgå databasen direkte. AI-platforme tilgår kun via gatewayen.

Databasesegmentering: Hvis databasen indeholder både følsomme og ikke-følsomme data, kan de opbevares i separate databaser. Så kan AI-systemer, der kun skal bruge ikke-følsomme data, få adgang til netop det.

Datasharding: For meget store datasæt splittes data i mindre bidder (shards) efter et kriterium (fx kunde-ID eller geografisk område). AI-systemer får kun adgang til de shards, de har brug for.

Syntetiske data: Til udvikling og test bør du bruge syntetiske data, der efterligner struktur og fordeling fra rigtige data – men uden følsomme oplysninger. AI-systemer kan trænes og testes på syntetiske data, så rigtige data ikke eksponeres.

Eksponering af din database for AI-platforme har store compliance-konsekvenser. Forskellige regler stiller forskellige krav:

GDPR (Databeskyttelsesforordningen): Behandler du persondata om EU-borgere, gælder GDPR. Centrale krav omfatter:

CCPA (California Consumer Privacy Act): Behandler du data om borgere i Californien, gælder CCPA. Centrale krav omfatter:

HIPAA (Health Insurance Portability and Accountability Act): Håndterer du sundhedsdata, gælder HIPAA. Centrale krav omfatter:

Branchestandarder: Afhængigt af branche kan yderligere standarder gælde:

Før du eksponerer data for AI-platforme, gennemfør en compliance-vurdering for at forstå, hvilke regler der gælder, og hvilke krav de stiller.

At sikre databaseadgang til AI-platforme kræver koordinering på tværs af systemer og ensartet håndhævelse af politikker. Her bliver workflow-automatiseringsplatforme som FlowHunt uvurderlige.

FlowHunt gør det muligt at bygge automatiserede arbejdsgange, der sikkert integrerer AI-systemer med din databaseinfrastruktur. I stedet for manuel håndtering af API-nøgler, adgangsovervågning og koordinering mellem teams, tilbyder FlowHunt en samlet platform til:

Workflow-orkestrering: Definér komplekse arbejdsgange, der omfatter databaseforespørgsler, AI-behandling og datatransformation. FlowHunt håndterer orkestreringen og sikrer, at hvert trin udføres sikkert og i korrekt rækkefølge.

Adgangskontrol-integration: FlowHunt integrerer med dine identitets- og adgangssystemer og håndhæver automatisk RBAC og mindst privilegeret adgang på alle AI-arbejdsgange.

Audit og compliance: FlowHunt opretholder omfattende revisionslogs over alle workflow-kørsler, inkl. hvornår, hvem og hvilke data blev tilgået. Disse logs understøtter compliance med GDPR, CCPA, HIPAA mv.

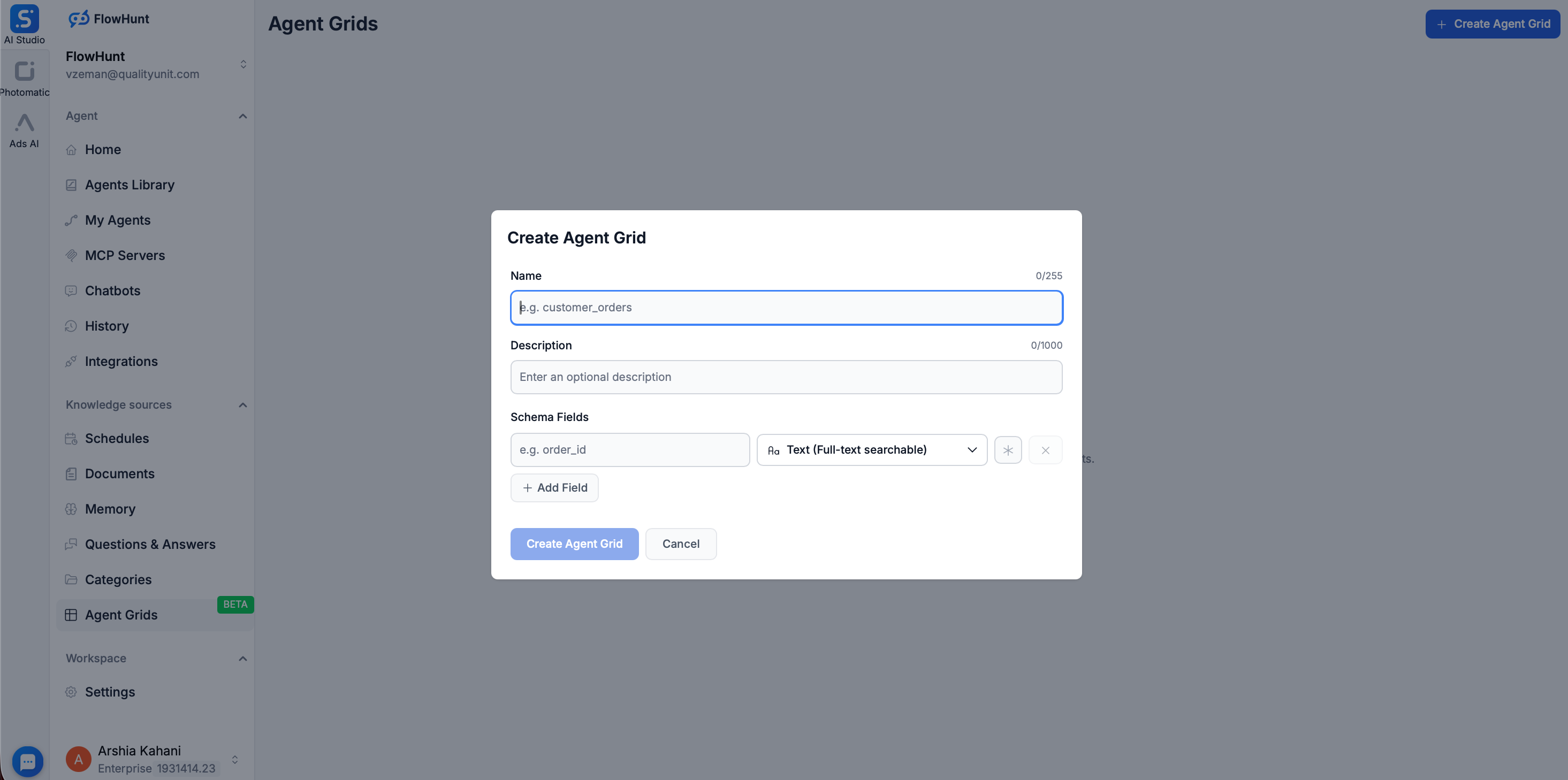

Ønsker du ekstra isolation mellem dine AI-modeller og produktionsdatabaser, tilbyder FlowHunt funktionen Grid. Her kan brugere oprette en søgbar database blot ved at uploade strukturerede filer som CSV.

Når en CSV uploades til Grid, bruger FlowHunt Elasticsearch til at indeksere dataene, så en statisk fil forvandles til en dynamisk, lynhurtig Knowledge Source. Det giver markante sikkerhedsfordele:

Med FlowHunt Grid og workflow-funktioner reduceres kompleksiteten ved at opretholde sikkerhedskontroller, og politikker håndhæves konsekvent på tværs af organisationen.

Implementering af sikker databaseeksponering for AI-platforme kræver flere trin. Her er en praktisk køreplan:

Trin 1: Vurder din nuværende situation

Trin 2: Design din arkitektur

Trin 3: Implementér kernekontroller

Trin 4: Implementér databeskyttelse

Trin 5: Udrul overvågning og auditing

Trin 6: Test og valider

Trin 7: Operationalisér og vedligehold

Vær opmærksom på disse typiske fejl under implementeringen:

Direkte databaseeksponering: Eksponér aldrig din database direkte for internettet eller AI-platforme uden API-gateway. Det er den største sikkerhedsrisiko.

For brede rettigheder: Giver du AI-systemer for mange rettigheder, bryder du princippet om mindst privilegium. Start med minimale rettigheder og udvid kun, hvis nødvendigt.

Utilstrækkelig kryptering: Kryptering kun under overførsel eller kun i hvile efterlader data sårbare. Krypter begge steder.

Svag credential management: Hårdkodede credentials, opbevaring i versionsstyring eller manglende rotation er en stor risiko.

Mangelfuld overvågning: Stærke forebyggende kontroller uden overvågning betyder, at du ikke opdager brud.

Ignorering af compliance: At ignorere regulatoriske krav indtil efter et brud er dyrt. Indbyg compliance fra starten.

Utilstrækkelig test: Sikkerhedskontroller, der ikke testes grundigt, virker måske ikke, når de skal.

Efterhånden som AI-systemer bliver mere avancerede, opstår nye angrebsvektorer. To særligt relevante trusler er prompt injection og modeludvinding.

Prompt injection: En angriber designer en prompt, der får AI’en til at udføre uønskede handlinger – fx ignorere adgangskontrol og returnere data, den ikke burde. Forsvar mod prompt injection:

Modeludvinding: En angriber interagerer med en AI-model for at udlede information om træningsdata eller modelstruktur. Forsvar mod modeludvinding:

At eksponere din database sikkert for AI-platforme er ikke bare muligt – det er i stigende grad nødvendigt for organisationer, der vil udnytte AI’s potentiale og samtidig beskytte deres mest værdifulde aktiv. Nøglen er et lagdelt setup med stærk autentificering og autorisation, kryptering, datamaskering, omfattende overvågning og regelmæssig test.

Start med det grundlæggende: eksponér aldrig din database direkte, brug altid en API-gateway, implementér stærk autentificering og autorisation, og krypter dine data. Byg videre med datamaskering, omfattende overvågning og compliance-kontroller tilpasset din organisations risikoprofil og regulatoriske krav.

Husk, at sikkerhed ikke er en engangsopgave, men en løbende proces. Gennemgå kontroller regelmæssigt, test for sårbarheder, monitorér for trusler og opdatér tilgangen, når nye risici opstår. Ved at gøre databasesikkerhed til en løbende prioritet kan du trygt udnytte AI’s muligheder og beskytte både data og omdømme.

Oplev hvordan FlowHunt automatiserer dine AI-indholds- og SEO-arbejdsgange — fra research og indholdsgenerering til publicering og analyse — alt samlet ét sted.

Ja, det er sikkert, når du implementerer de rette sikkerhedsforanstaltninger, herunder API-gateways, kryptering, rollebaseret adgangskontrol og omfattende overvågning. Nøglen er at bruge et sikkert mellemled fremfor direkte databaseeksponering.

Brug stærke, rotationsbaserede legitimationsoplysninger med multifaktorautentificering (MFA) for menneskelige brugere og serviceprincipaler. Implementér OAuth, JWT-tokens eller API-nøgler med streng ratelimitering og IP-hvidlistning for AI-agenter.

Implementér datamaskering, kolonnebaseret kryptering, rollebaseret adgangskontrol (RBAC) og adskil produktionsdata fra AI-træningsdata. Brug dynamisk datamaskering til at skjule følsomme felter i forespørgselsresultaterne og oprethold uforanderlige revisionsspor.

Afhængigt af din datatype bør du overveje GDPR, CCPA, HIPAA og andre relevante regler. Sørg for, at du har den rette dataklassificering, opbevaringspolitik og samtykkemekanismer på plads, før du eksponerer personlige eller følsomme data.

Arshia er AI Workflow Engineer hos FlowHunt. Med en baggrund inden for datalogi og en passion for AI, specialiserer han sig i at skabe effektive workflows, der integrerer AI-værktøjer i daglige opgaver og øger produktivitet og kreativitet.

Effektivisér dine AI-drevne dataarbejdsgange, mens du opretholder sikkerhed og compliance på virksomhedsniveau.

Integrer FlowHunt med OceanBase ved hjælp af OceanBase MCP Server for at muliggøre sikker, AI-drevet databaseautomatisering, analyse og udforskning. Giv trygt A...

Integrer FlowHunt med GreptimeDB’s Model Context Protocol (MCP)-server for at aktivere AI-drevet, sikker og struktureret adgang til din tidsseriedatabase. Autom...

Integrer FlowHunt med enhver JDBC-kompatibel database ved hjælp af JDBC Model Context Protocol (MCP) Serveren. Forbind nemt LLM'er til databaser som PostgreSQL,...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.