Milvus MCP Server-integration

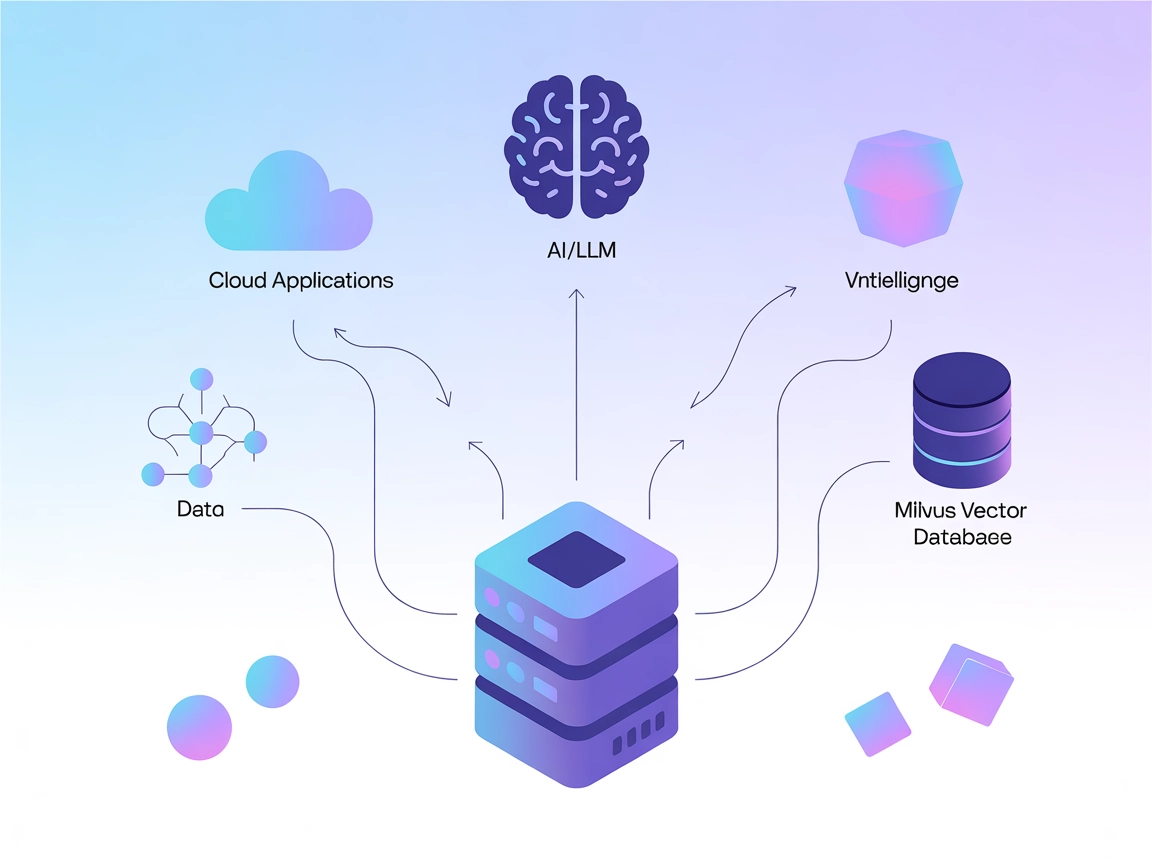

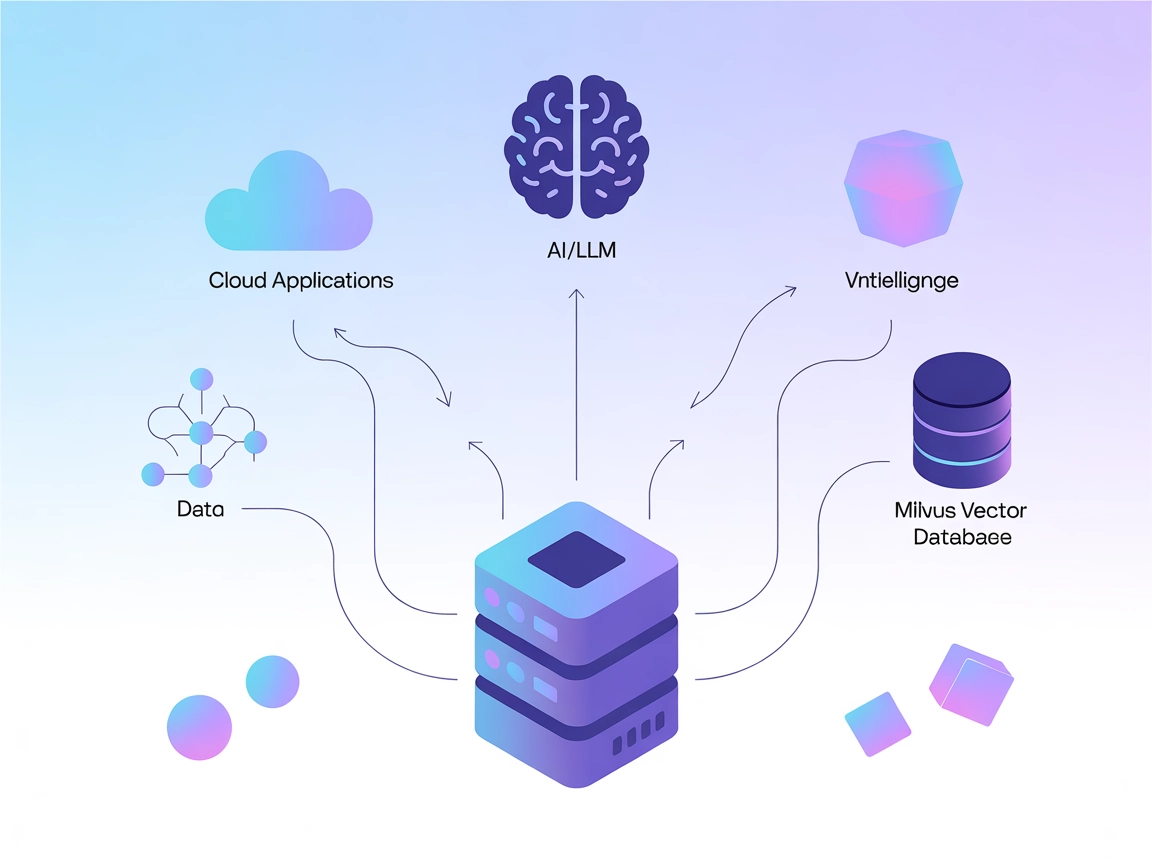

Milvus MCP Server forbinder AI-assistenter og LLM-drevne applikationer med Milvus vektordatabase, hvilket muliggør avanceret vektorsøgning, embedding-håndtering...

Patronus MCP Server automatiserer LLM-evalueringer og eksperimenter, så tekniske teams kan strømline AI-benchmarking og workflow-integration med FlowHunt.

FlowHunt giver et ekstra sikkerhedslag mellem dine interne systemer og AI-værktøjer, hvilket giver dig granulær kontrol over hvilke værktøjer der er tilgængelige fra dine MCP-servere. MCP-servere hostet i vores infrastruktur kan problemfrit integreres med FlowHunts chatbot samt populære AI-platforme som ChatGPT, Claude og forskellige AI-editorer.

Patronus MCP (Model Context Protocol) Server er en standardiseret serverimplementering bygget til Patronus SDK, designet til at lette avanceret optimering, evaluering og eksperimentering med LLM (Large Language Model) systemer. Ved at forbinde AI-assistenter til eksterne datakilder og -tjenester muliggør Patronus MCP Server strømlinede workflows for udviklere og forskere. Brugere kan køre enkelt- eller batch-evalueringer, udføre eksperimenter med datasæt og initialisere projekter med specifikke API-nøgler og indstillinger. Denne udvidelige platform hjælper med at automatisere gentagne evalueringer, understøtter integration af brugerdefinerede evaluatorer og giver et robust interface til at styre og analysere LLM-adfærd, hvilket i sidste ende styrker AI-udviklingslivscyklussen.

Ingen prompt-skabeloner er eksplicit angivet i repoet eller dokumentationen.

Ingen eksplicitte ressourcer er beskrevet i tilgængelig dokumentation eller repo-filer.

initialize

Initialiserer Patronus med API-nøgle, projekt- og applikationsindstillinger. Opsætter systemet til videre evalueringer og eksperimenter.

evaluate

Kører en enkelt evaluering med en konfigurerbar evaluator på givne opgave-inputs, outputs og kontekst.

batch_evaluate

Udfører batch-evalueringer med flere evaluatorer på de angivne opgaver og producerer samlede resultater.

run_experiment

Kører eksperimenter med datasæt og specificerede evaluatorer, nyttigt til benchmarking og sammenligning.

Automatisering af LLM-evaluering

Automatiser evalueringen af store sprogmodeller ved at batchbehandle opgaver og anvende flere evaluatorer, hvilket reducerer manuelt arbejde i kvalitetssikring og benchmarking.

Brugerdefineret eksperimentering

Kør skræddersyede eksperimenter med egne datasæt og evaluatorer for at benchmarke nye LLM-arkitekturer og sammenligne ydeevne på tværs af forskellige kriterier.

Projektinitialisering for teams

Opsæt og konfigurer hurtigt evalueringsmiljøer til flere projekter ved hjælp af API-nøgler og projektindstillinger, hvilket effektiviserer onboarding og samarbejde.

Interaktiv live-test

Brug de medfølgende scripts til interaktivt at teste evalueringsendpoints, hvilket gør det lettere for udviklere at fejlfinde og validere deres evalueringsworkflows.

.windsurf eller windsurf.json).{

"mcpServers": [

{

"command": "python",

"args": ["src/patronus_mcp/server.py"],

"env": {

"PATRONUS_API_KEY": "your_api_key_here"

}

}

]

}

{

"mcpServers": [

{

"command": "python",

"args": ["src/patronus_mcp/server.py"],

"env": {

"PATRONUS_API_KEY": "your_api_key_here"

}

}

]

}

{

"mcpServers": [

{

"command": "python",

"args": ["src/patronus_mcp/server.py"],

"env": {

"PATRONUS_API_KEY": "your_api_key_here"

}

}

]

}

{

"mcpServers": [

{

"command": "python",

"args": ["src/patronus_mcp/server.py"],

"env": {

"PATRONUS_API_KEY": "your_api_key_here"

}

}

]

}

Sikring af API-nøgler:

Placer følsomme oplysninger som PATRONUS_API_KEY i env-objektet i din konfiguration. Eksempel:

{

"command": "python",

"args": ["src/patronus_mcp/server.py"],

"env": {

"PATRONUS_API_KEY": "your_api_key_here"

},

"inputs": {}

}

Brug af MCP i FlowHunt

For at integrere MCP-servere i din FlowHunt-workflow skal du starte med at tilføje MCP-komponenten til dit flow og forbinde den til din AI-agent:

Klik på MCP-komponenten for at åbne konfigurationspanelet. I sektionen for system-MCP-konfiguration indsætter du dine MCP-serverdetaljer i dette JSON-format:

{

"patronus-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Når den er konfigureret, kan AI-agenten nu bruge denne MCP som et værktøj med adgang til alle dens funktioner og muligheder. Husk at ændre “patronus-mcp” til det faktiske navn på din MCP-server og erstatte URL’en med din egen MCP-server URL.

| Sektion | Tilgængelighed | Detaljer/Noter |

|---|---|---|

| Oversigt | ✅ | Klar beskrivelse i README |

| Liste over Prompts | ⛔ | Ingen prompt-skabeloner fundet |

| Liste over ressourcer | ⛔ | Ingen eksplicitte ressourcer angivet |

| Liste over værktøjer | ✅ | Fundet i API-brug og README |

| Sikring af API-nøgler | ✅ | Beskrevet i README og opsætningsinstruktioner |

| Sampling Support (mindre vigtigt i evaluering) | ⛔ | Ikke nævnt |

Roots Support: Ikke nævnt i dokumentationen eller koden.

Ud fra ovenstående information leverer Patronus MCP Server et solidt fundament og essentielle funktioner til LLM-evaluering og eksperimentering, men mangler dokumentation eller implementering af prompt-skabeloner, ressourcer og avancerede MCP-funktioner som Roots og Sampling.

Patronus MCP Server tilbyder robuste evalueringsværktøjer og klare opsætningsinstruktioner, men mangler standardiserede prompts, ressource-definitioner og nogle avancerede MCP-funktioner. Den egner sig bedst til tekniske brugere med fokus på LLM-evaluering og eksperimentering. Score: 6/10

| Har LICENSE | ✅ (Apache-2.0) |

|---|---|

| Har mindst ét værktøj | ✅ |

| Antal forks | 3 |

| Antal stjerner | 13 |

Patronus MCP Server er en standardiseret server til Patronus SDK med fokus på optimering, evaluering og eksperimentering af LLM-systemer. Den automatiserer LLM-evalueringer, understøtter batchbehandling og giver et robust interface til AI-udviklingsworkflows.

Den indeholder værktøjer til at initialisere projektindstillinger, køre enkelt- og batch-evalueringer samt udføre eksperimenter med datasæt og brugerdefinerede evaluatorer.

Gem dine API-nøgler i `env`-objektet i din konfigurationsfil. Undgå at hardkode følsomme oplysninger i kode-repositories.

Ja, du kan integrere Patronus MCP Server som en MCP-komponent i FlowHunt og forbinde den til din AI-agent for avanceret evaluering og eksperimentering.

Automatiseret LLM-evaluering, brugerdefinerede benchmarking-eksperimenter, projektinitialisering for teams og interaktiv live-test af evalueringsendpoints.

Integrer Patronus MCP Server i din FlowHunt-workflow for automatiserede, robuste og skalerbare AI-model evalueringer og eksperimentering.

Milvus MCP Server forbinder AI-assistenter og LLM-drevne applikationer med Milvus vektordatabase, hvilket muliggør avanceret vektorsøgning, embedding-håndtering...

ModelContextProtocol (MCP) Server fungerer som et bindeled mellem AI-agenter og eksterne datakilder, API’er og tjenester, så FlowHunt-brugere kan bygge kontekst...

lingo.dev MCP Server forbinder AI-assistenter med eksterne datakilder, API'er og tjenester, hvilket muliggør struktureret ressourceadgang, promptskabeloner og v...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.