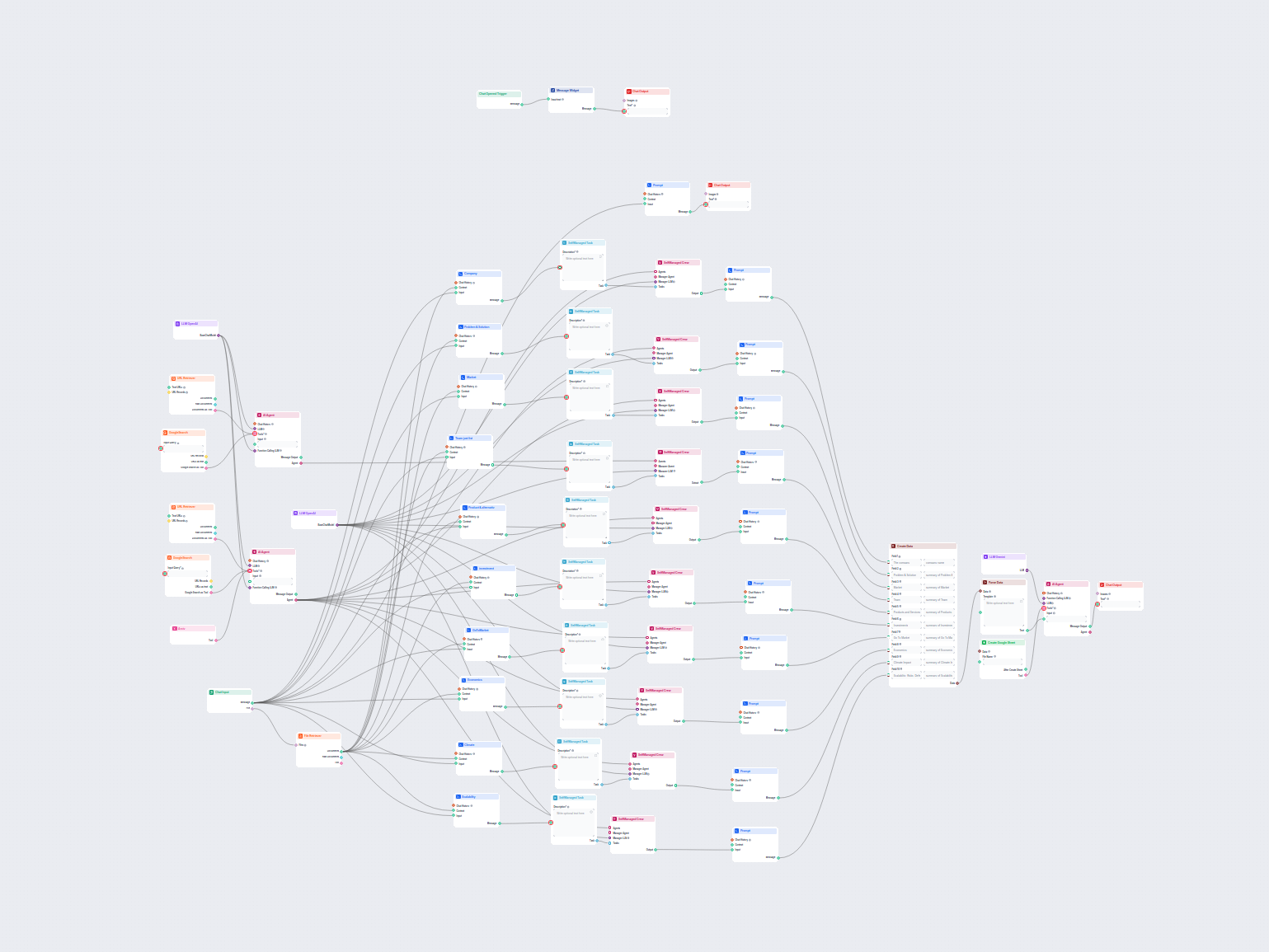

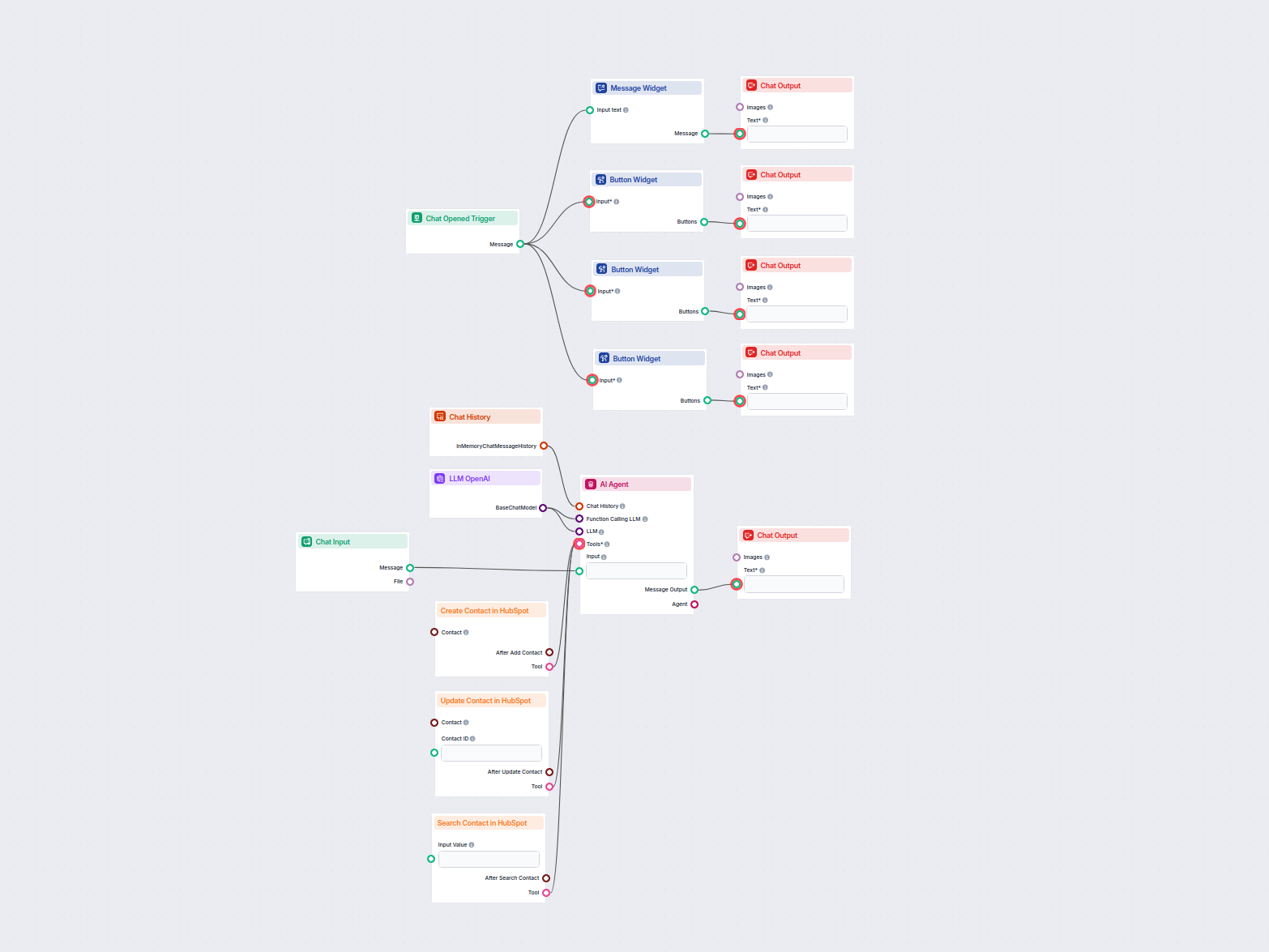

Administrador de Contactos de HubSpot con IA

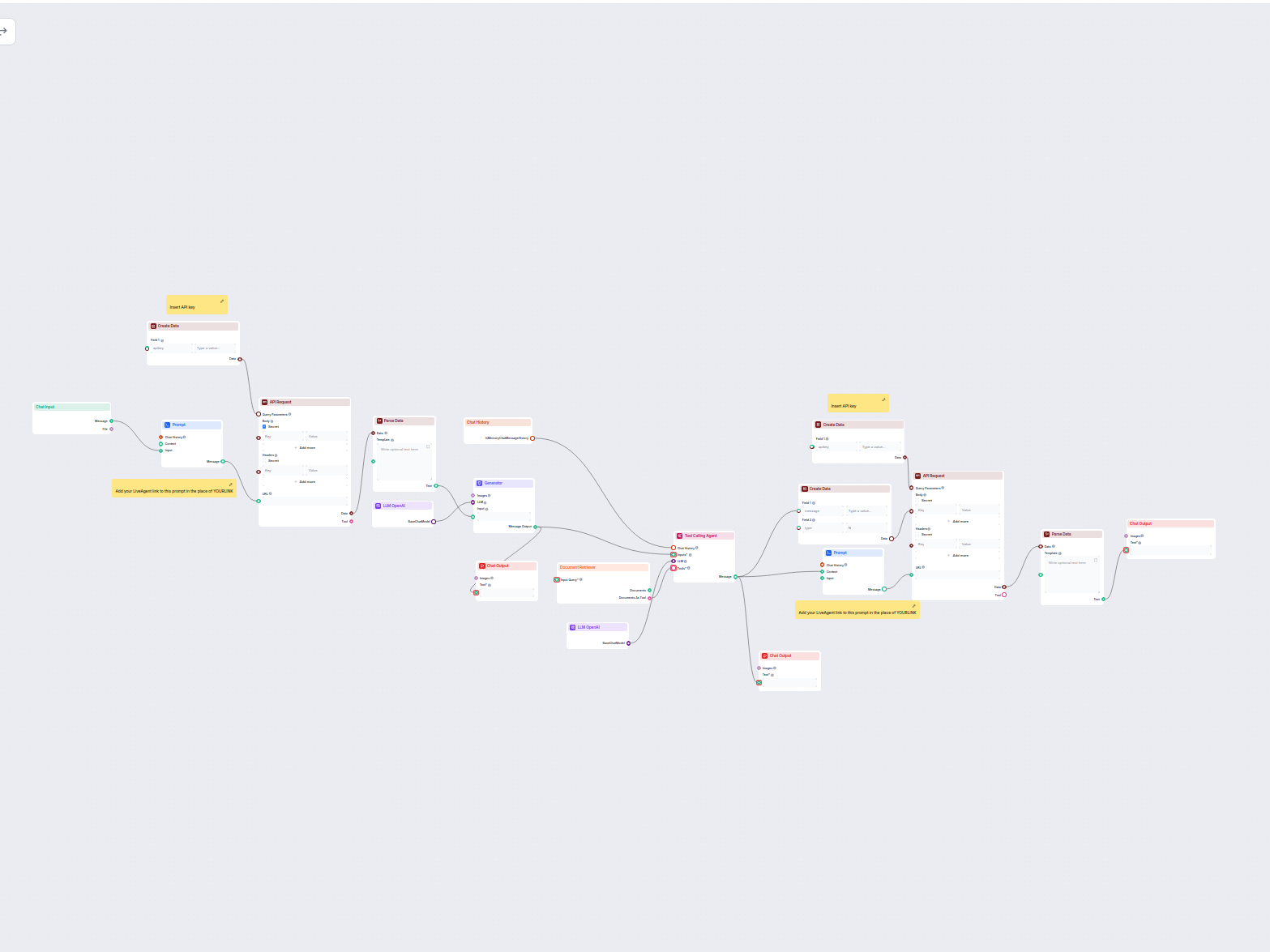

Este flujo de trabajo impulsado por IA automatiza la gestión de contactos en HubSpot CRM. Los usuarios pueden buscar, crear o actualizar contactos fácilmente a ...

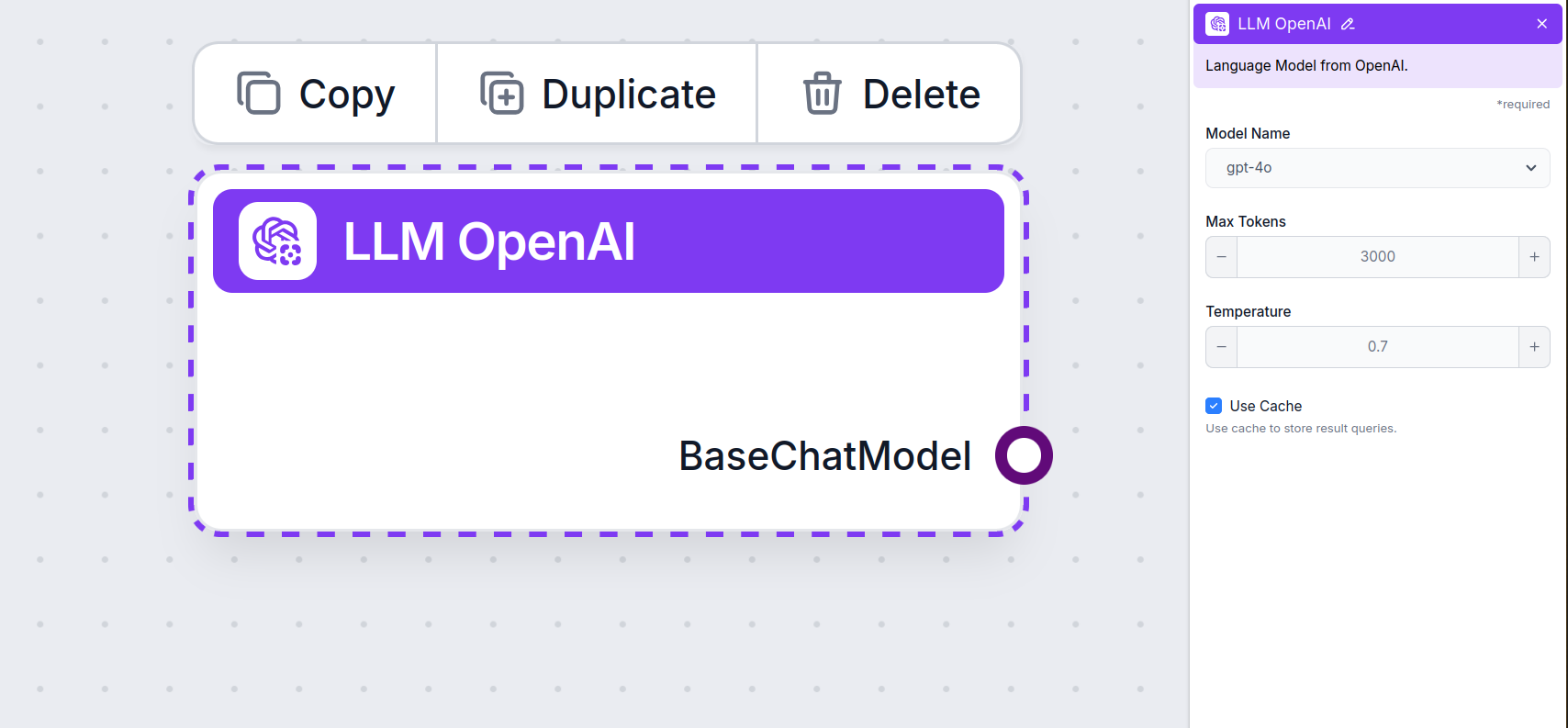

El componente LLM OpenAI en FlowHunt conecta modelos ChatGPT a tus flujos, permitiendo controlar la selección del modelo y la configuración de salida para aplicaciones versátiles de chatbots de IA.

Descripción del componente

The LLM OpenAI component connects ChatGPT models to your flow. While the Generators and Agents are where the actual magic happens, LLM components allow you to control the model used. All components come with ChatGPT-4 by default. You can connect this component if you wish to change the model or gain more control over it.

This is the model picker. Here, you’ll find all OpenAI models FlowHunt supports. ChatGPT offers a full list of differently capable and differently priced models. For example, using the less advanced and older GPT-3.5 will cost less than using the newest 4o, but the quality and speed of the output will suffer.

OpenAI models available in FlowHunt:

When choosing the right model for the task, consider the quality and speed the task requires. Older models are great for saving money on simple bulk tasks and chatting. If you’re generating content or searching the web, we suggest you opt for a newer, more refined model.

Tokens represent the individual units of text the model processes and generates. Token usage varies with models, and a single token can be anything from words or subwords to a single character. Models are usually priced in millions of tokens.

The max tokens setting limits the total number of tokens that can be processed in a single interaction or request, ensuring the responses are generated within reasonable bounds. The default limit is 4,000 tokens, which is the optimal size for summarizing documents and several sources to generate an answer.

Temperature controls the variability of answers, ranging from 0 to 1.

A temperature of 0.1 will make the responses very to the point but potentially repetitive and deficient.

A high temperature of 1 allows for maximum creativity in answers but creates the risk of irrelevant or even hallucinatory responses.

For example, the recommended temperature for a customer service bot is between 0.2 and 0.5. This level should keep the answers relevant and to the script while allowing for a natural level of variation in responses.

You’ll notice that all LLM components only have an output handle. Input doesn’t pass through the component, as it only represents the model, while the actual generation happens in AI Agents and Generators.

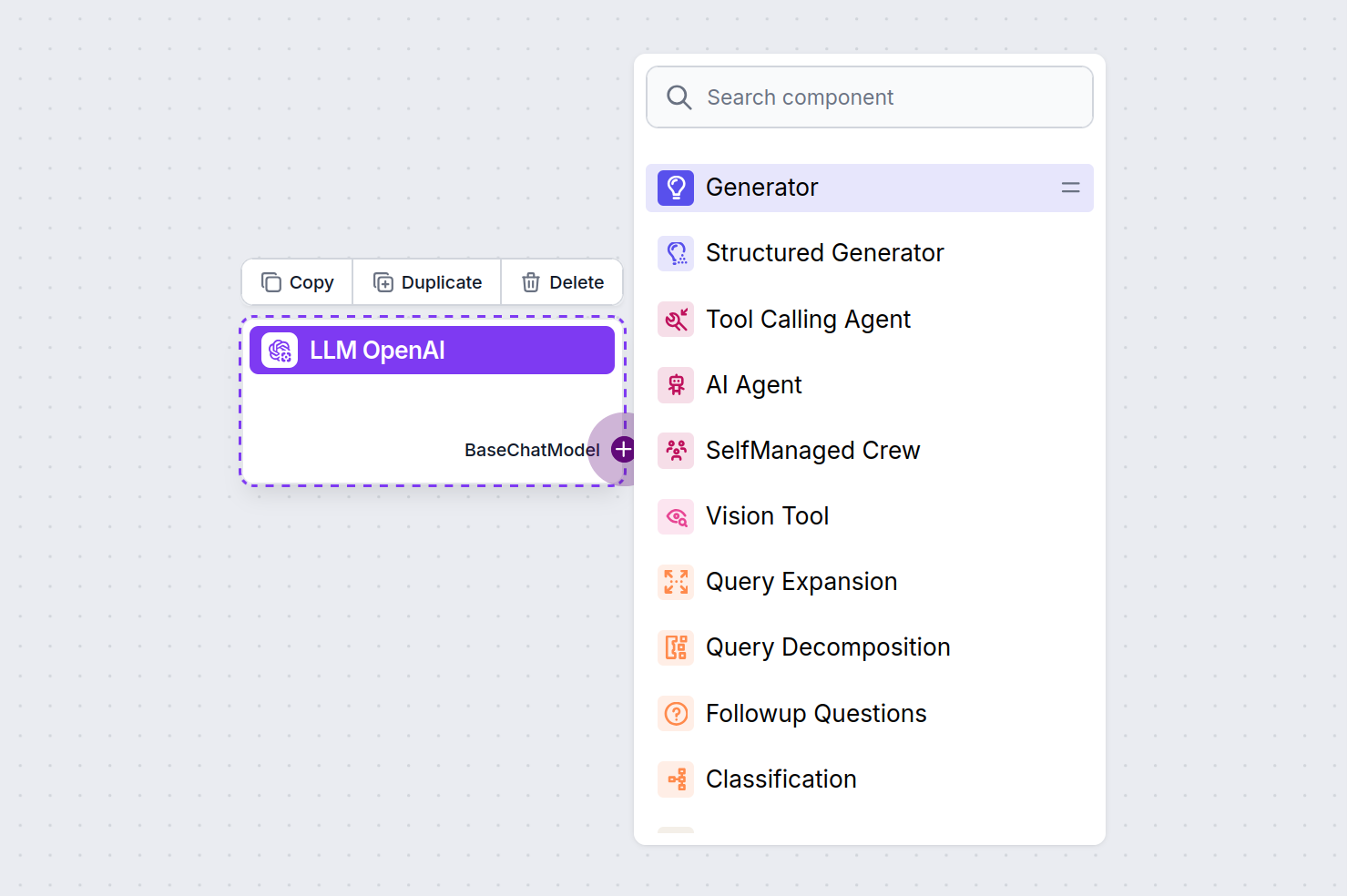

The LLM handle is always purple. The LLM input handle is found on any component that uses AI to generate text or process data. You can see the options by clicking the handle:

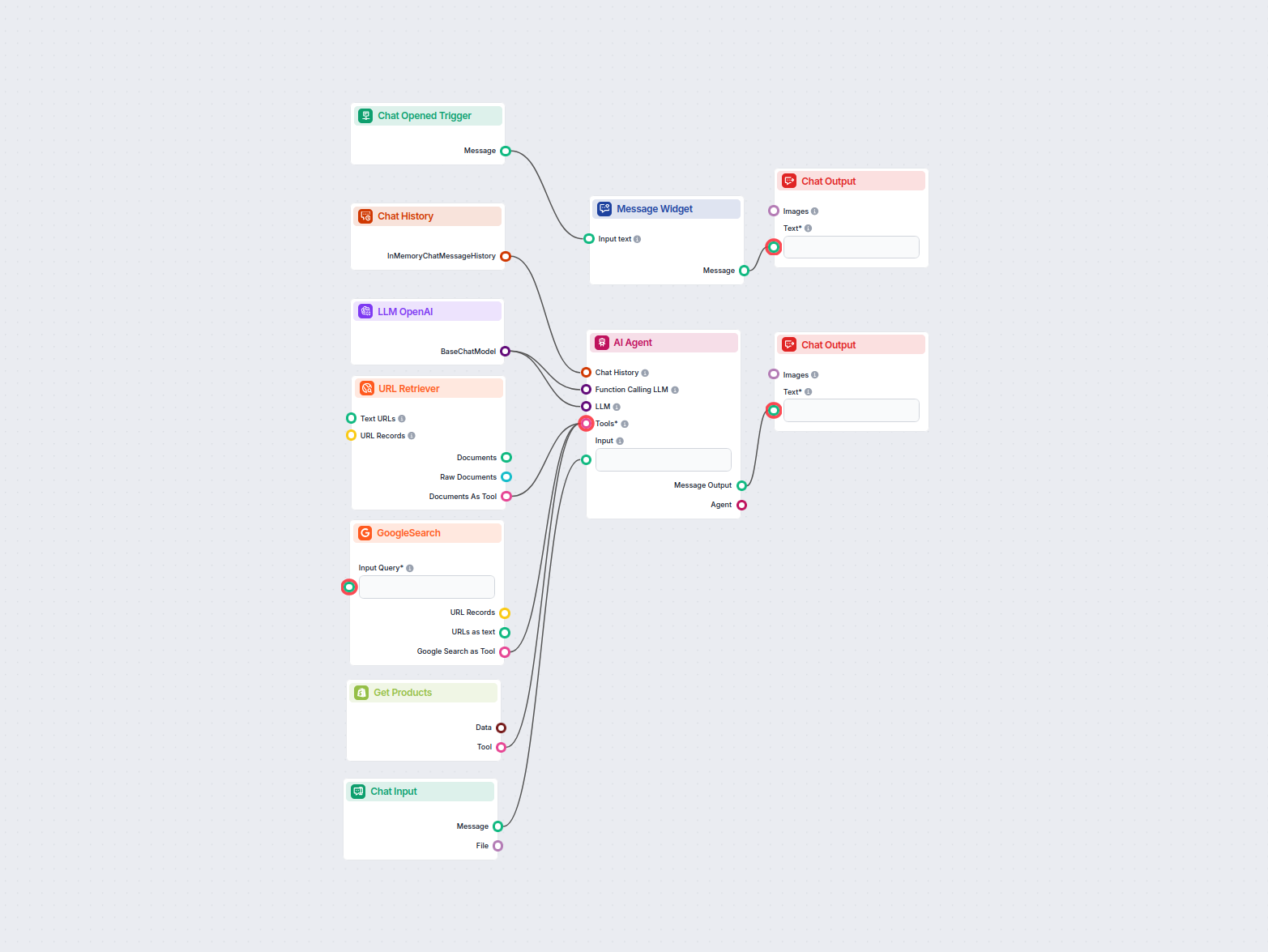

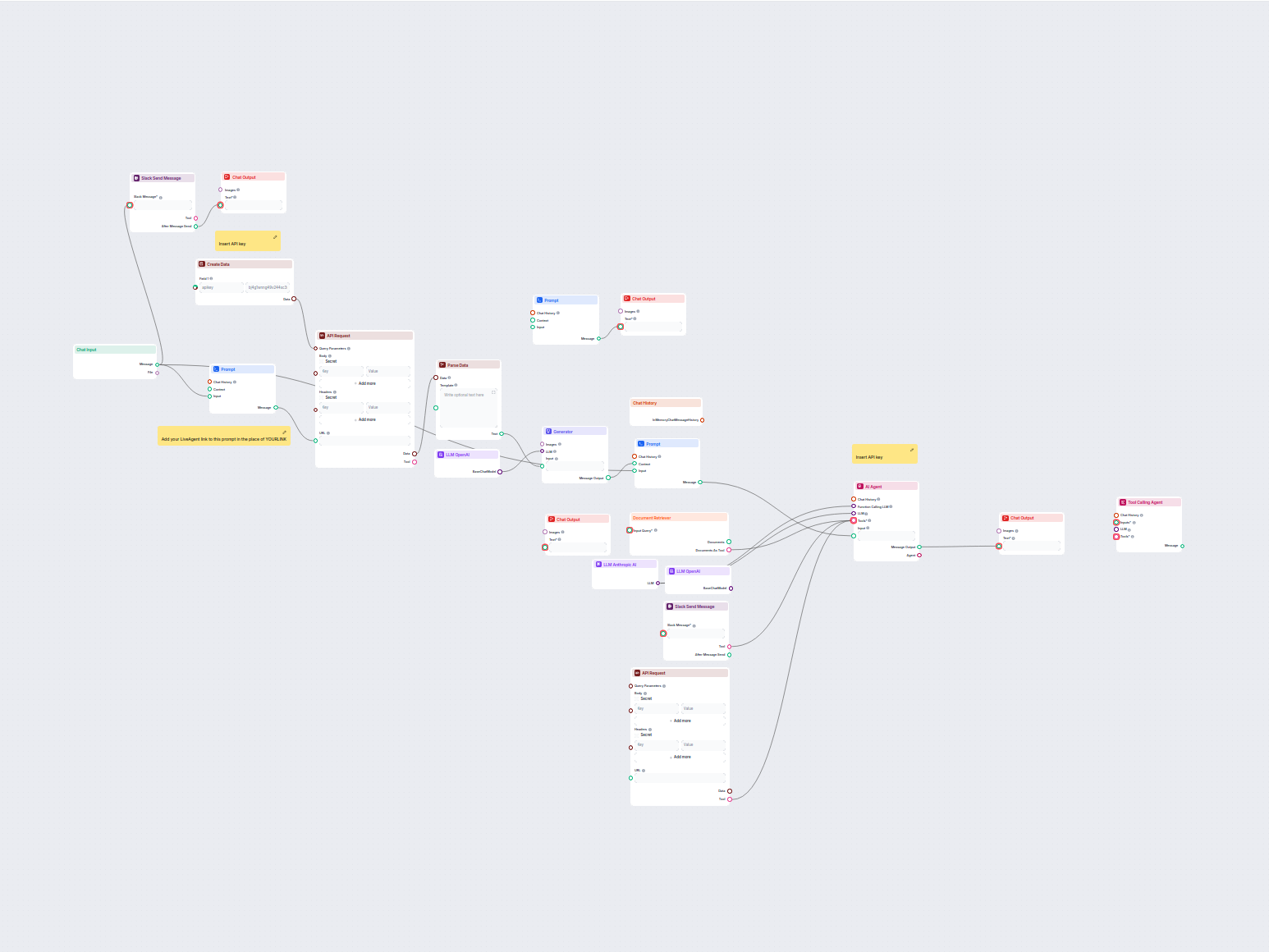

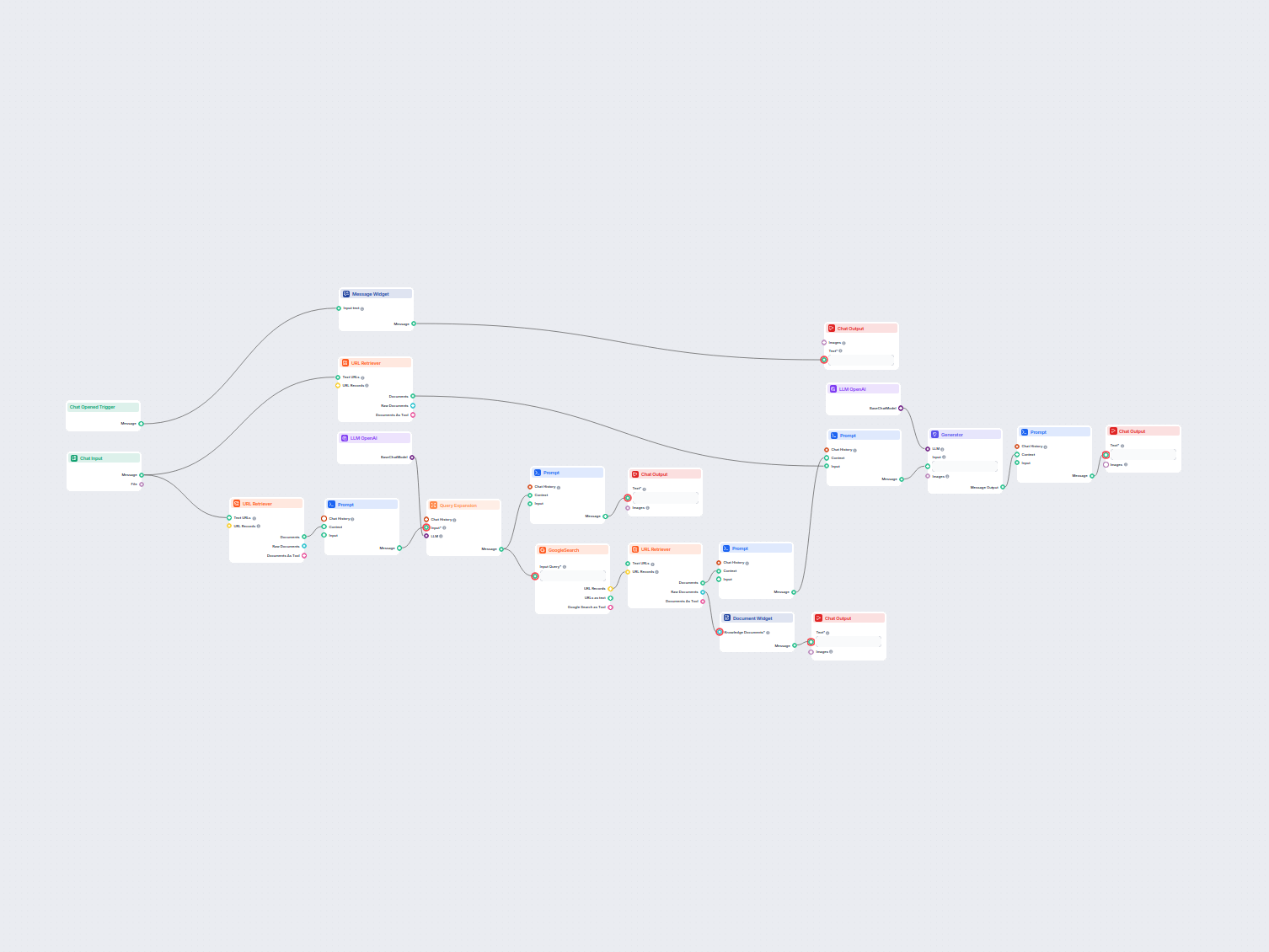

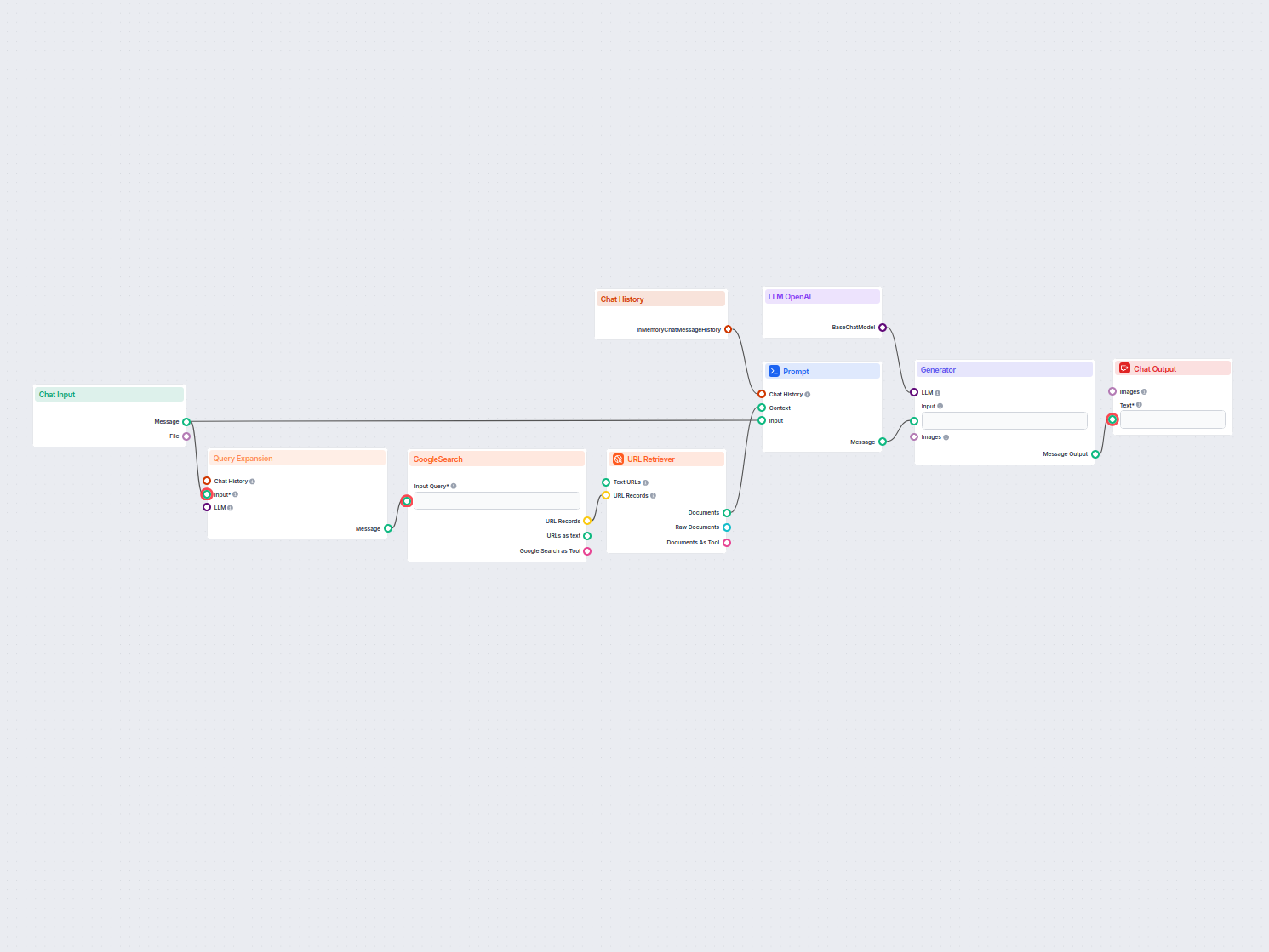

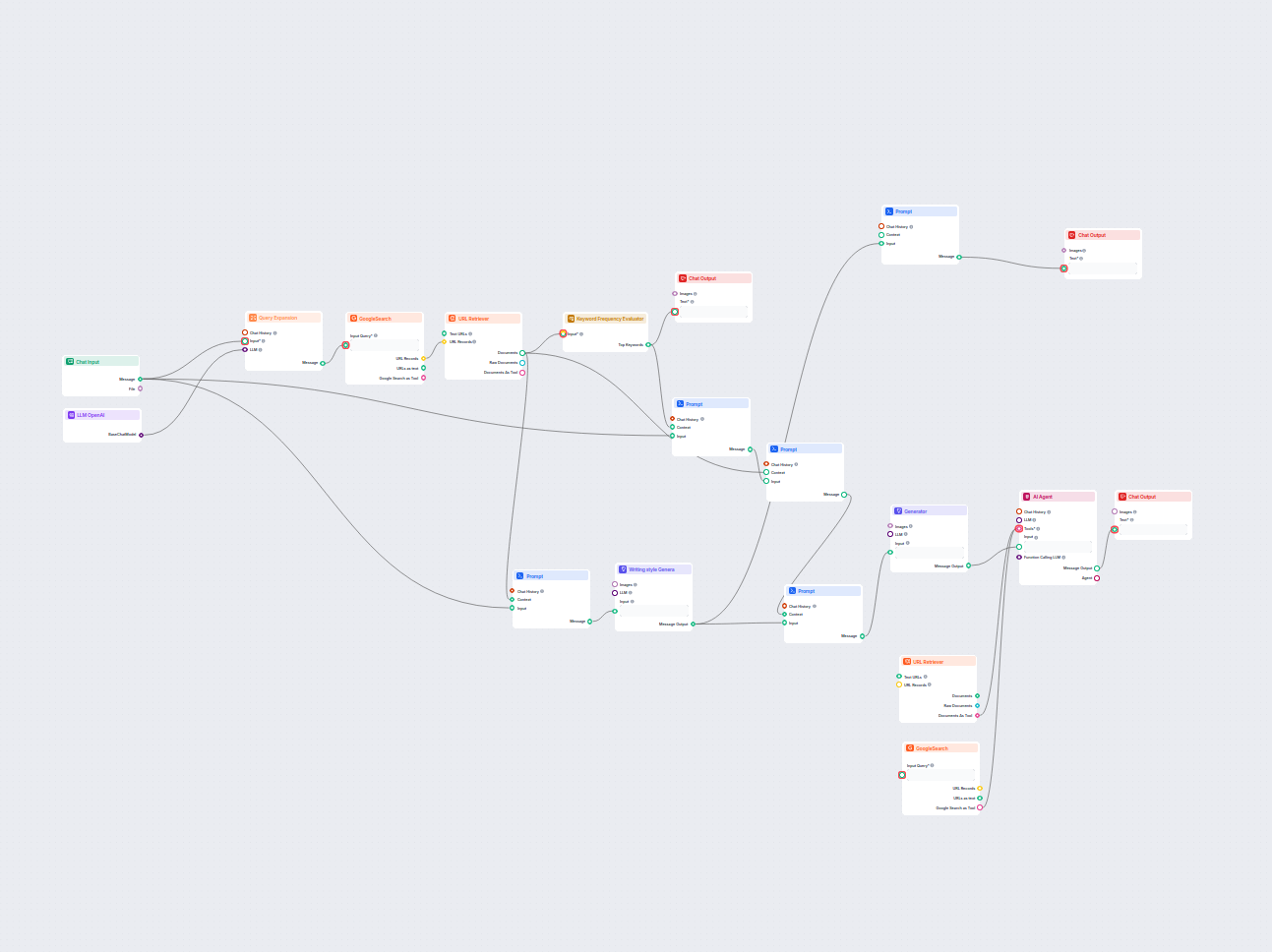

This allows you to create all sorts of tools. Let’s see the component in action. Here’s a simple Agent-powered chatbot Flow using o1 Preview to generate responses. You can think of it as a basic ChatGPT chatbot.

This simple Chatbot Flow includes:

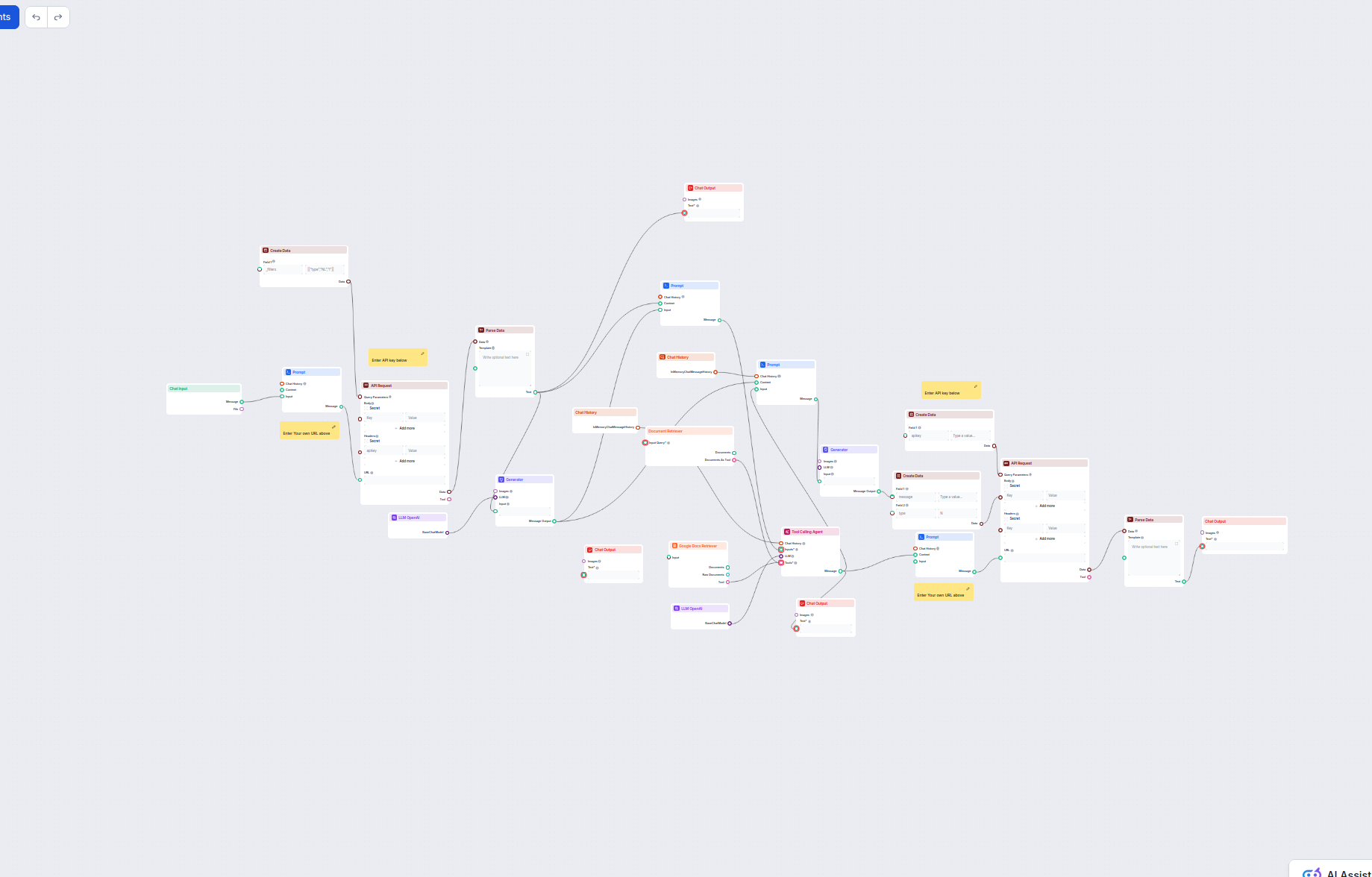

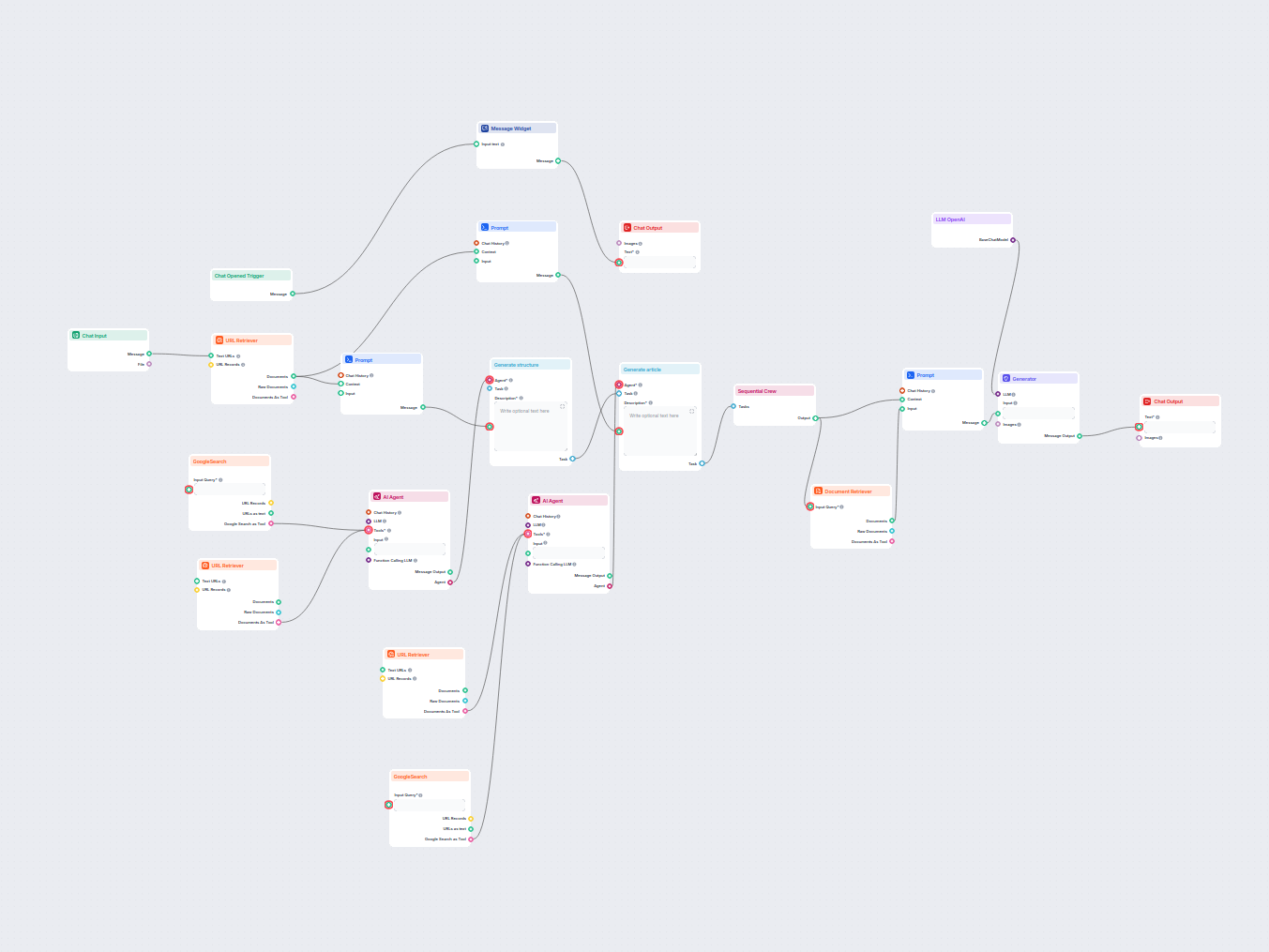

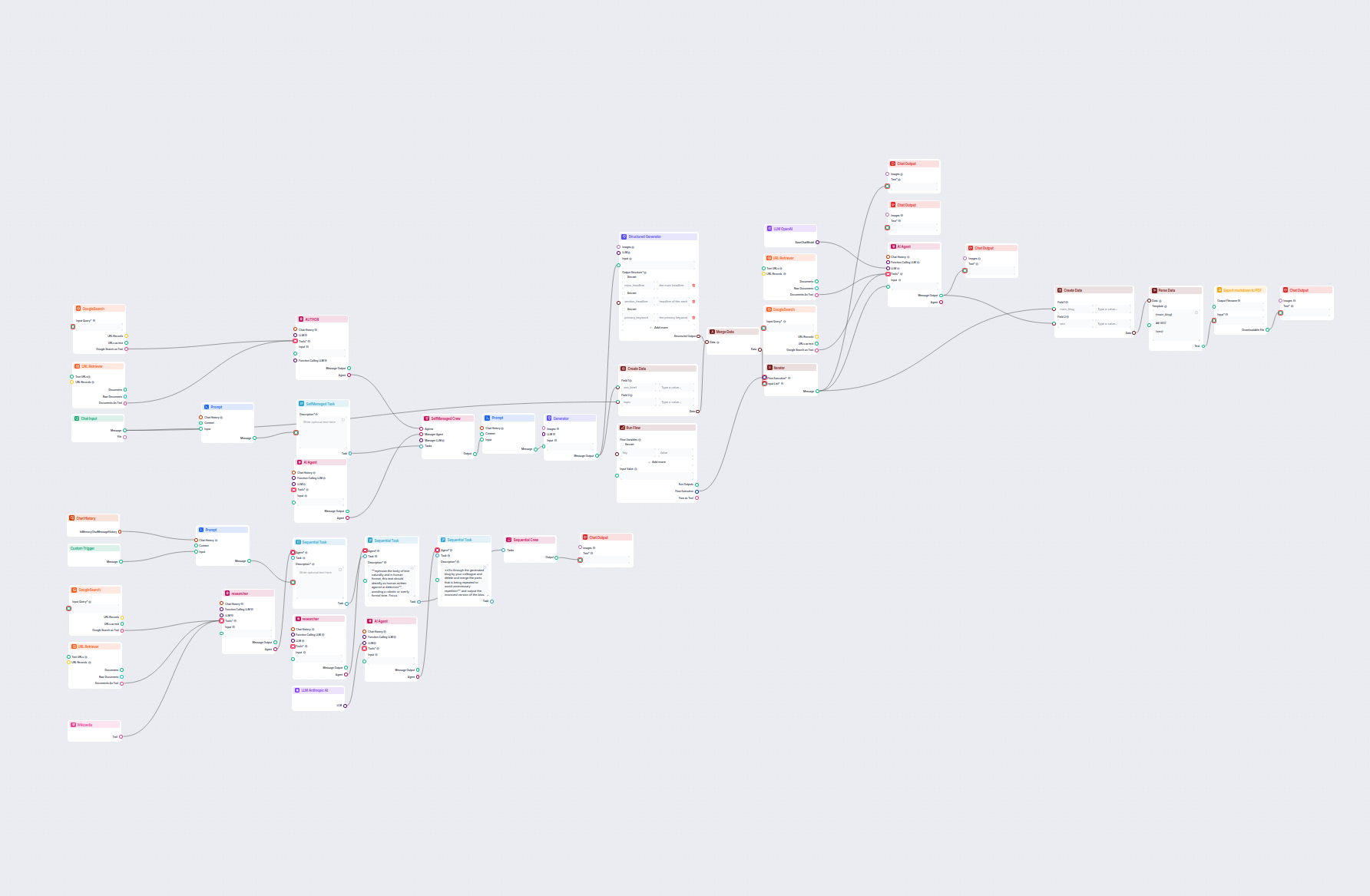

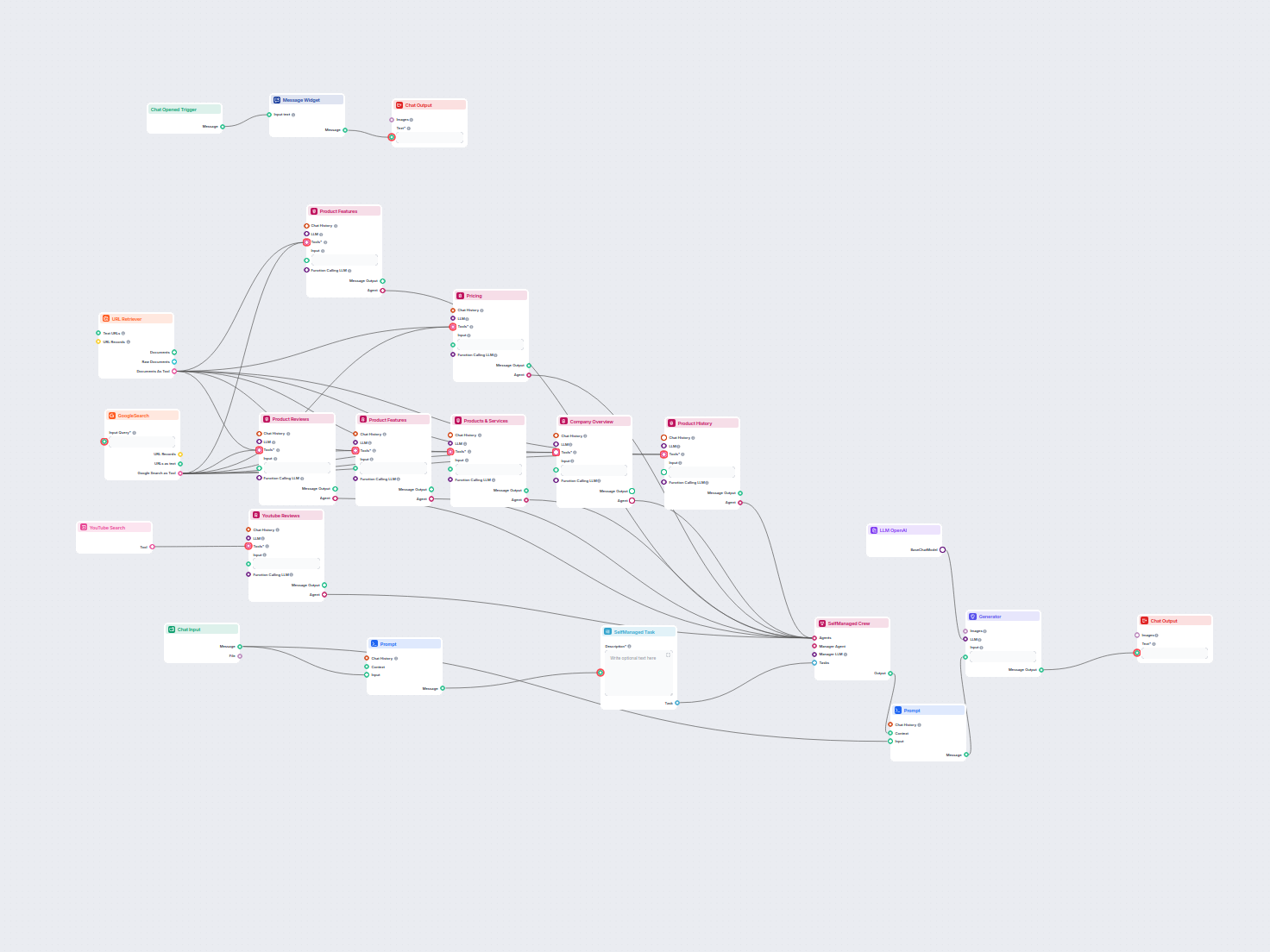

Para ayudarle a comenzar rápidamente, hemos preparado varios ejemplos de plantillas de flujo que demuestran cómo utilizar el componente LLM OpenAI de manera efectiva. Estas plantillas muestran diferentes casos de uso y mejores prácticas, facilitando la comprensión e implementación del componente en sus propios proyectos.

Este flujo de trabajo impulsado por IA automatiza la gestión de contactos en HubSpot CRM. Los usuarios pueden buscar, crear o actualizar contactos fácilmente a ...

Este flujo de trabajo potenciado por IA ayuda a los comerciantes de Shopify a analizar productos de la competencia, investigar tendencias de mercado y generar e...

Este flujo de trabajo impulsado por IA automatiza el soporte al cliente combinando la búsqueda en la base de conocimientos interna, la recuperación de informaci...

Este flujo de trabajo automatiza el soporte al cliente para tu empresa integrando conversaciones de LiveAgent, extrayendo datos relevantes de la conversación, g...

Este flujo de trabajo impulsado por IA automatiza el soporte al cliente conectando las consultas de los usuarios con fuentes de conocimiento de la empresa, APIs...

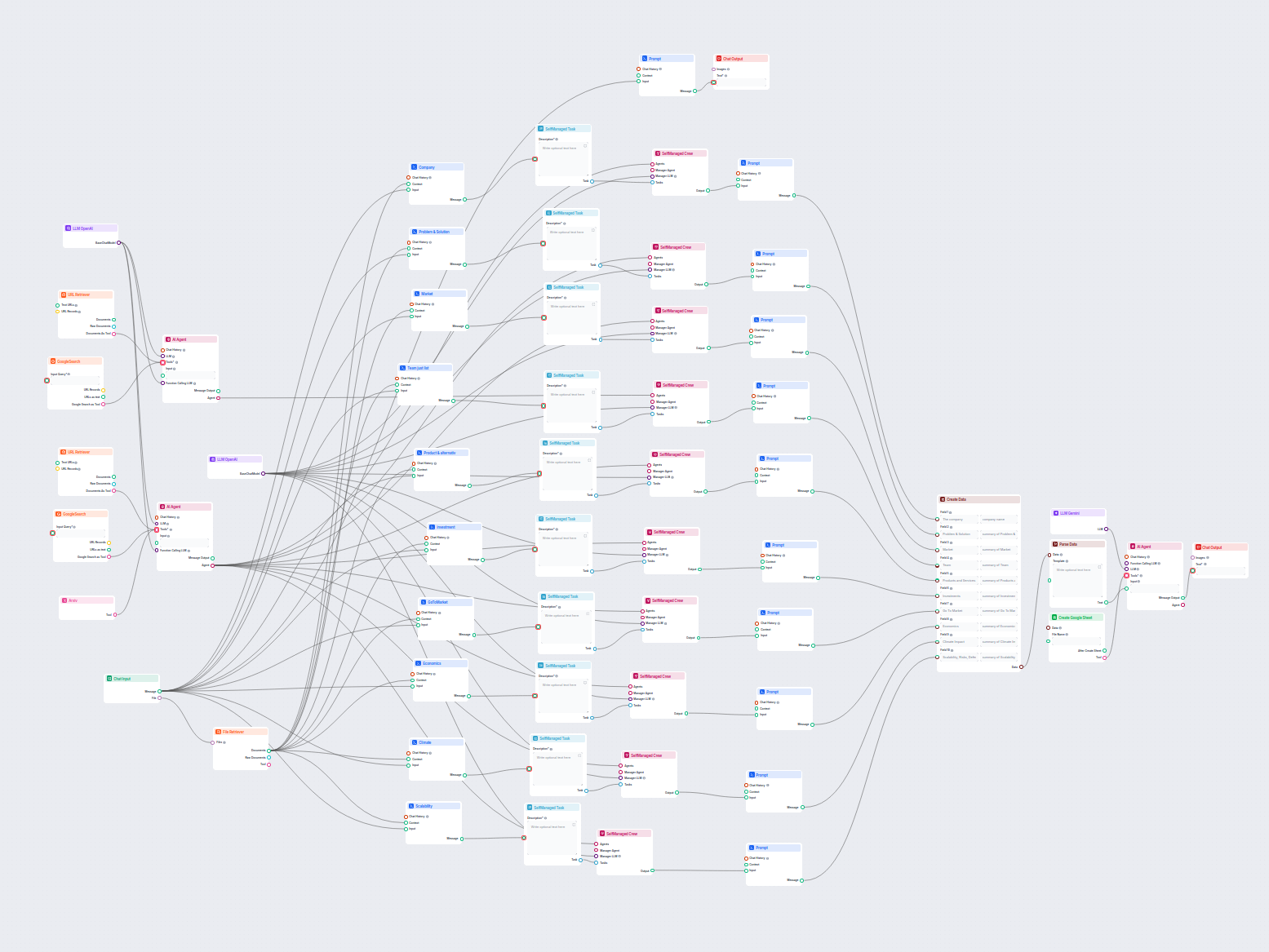

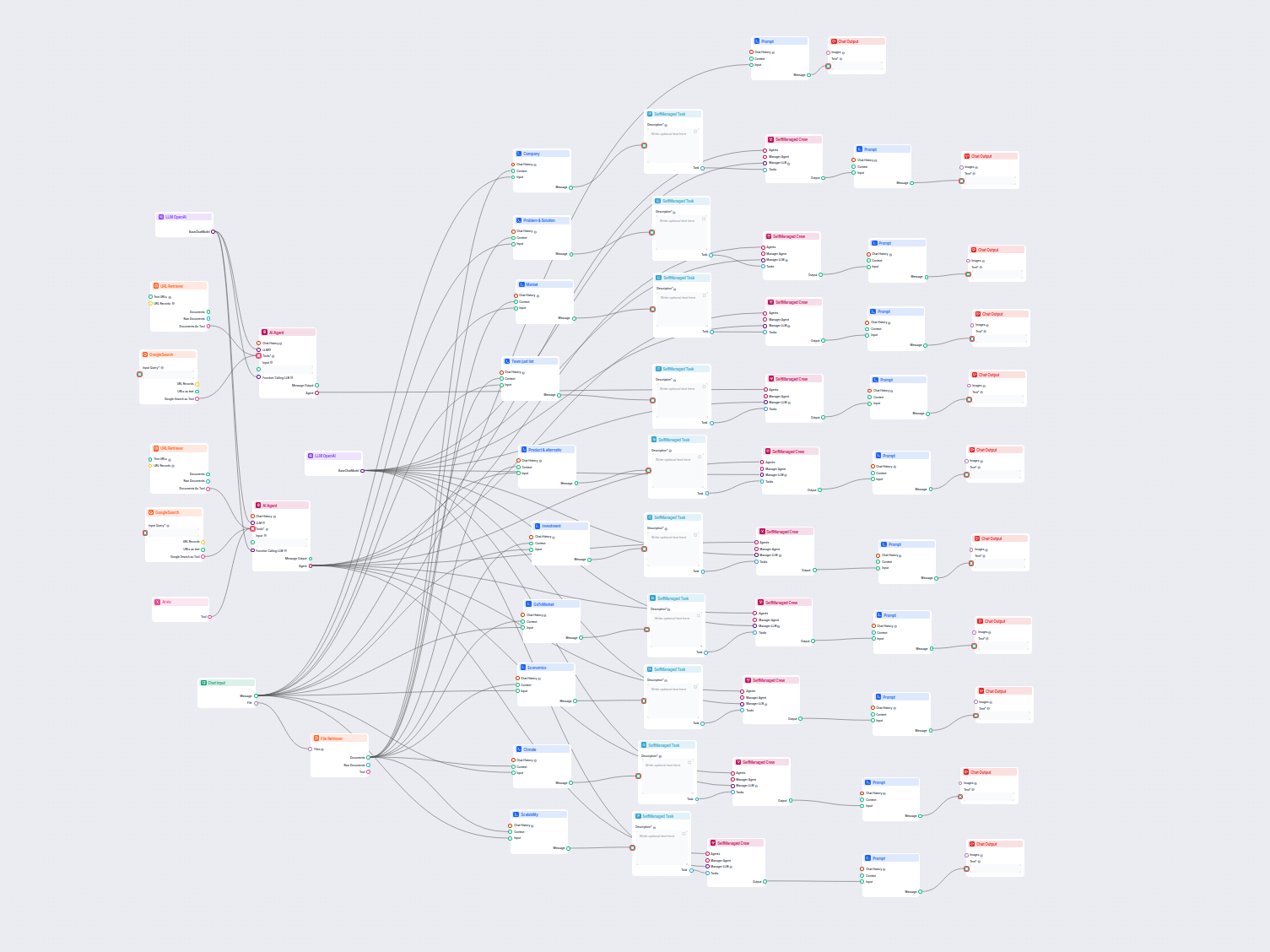

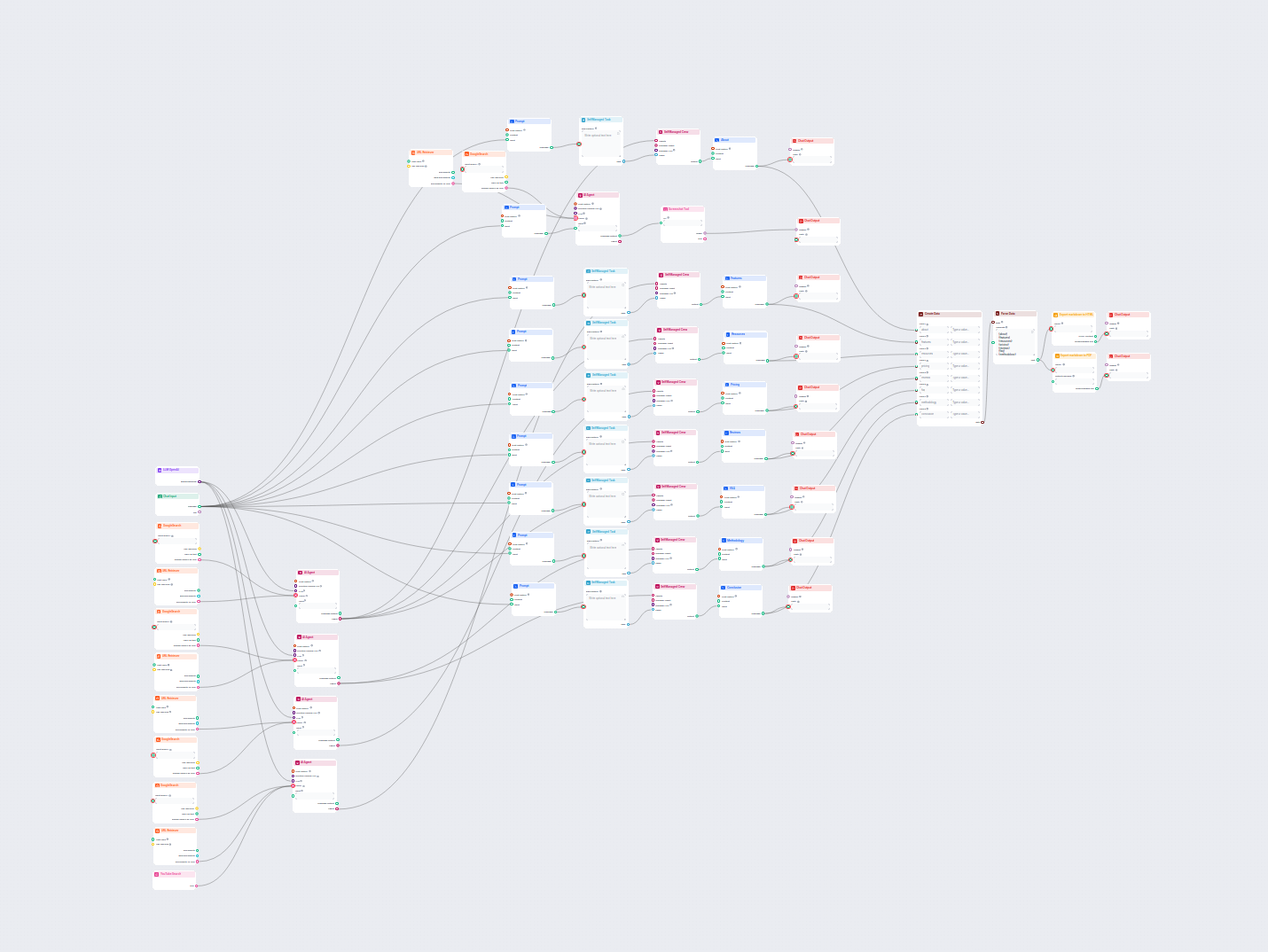

Este flujo de trabajo impulsado por IA ofrece un análisis empresarial integral y basado en datos. Recopila información sobre los antecedentes de la empresa, el ...

Flujo de trabajo integral impulsado por IA para el análisis de empresas y la investigación de mercado. Recopila y analiza automáticamente datos sobre antecedent...

Este flujo de trabajo con IA analiza en profundidad cualquier empresa investigando datos y documentos públicos, cubriendo mercado, equipo, productos, inversione...

Este flujo de trabajo impulsado por IA analiza la estructura de contenido de tu página web, la compara con las páginas de la competencia mejor posicionadas y pr...

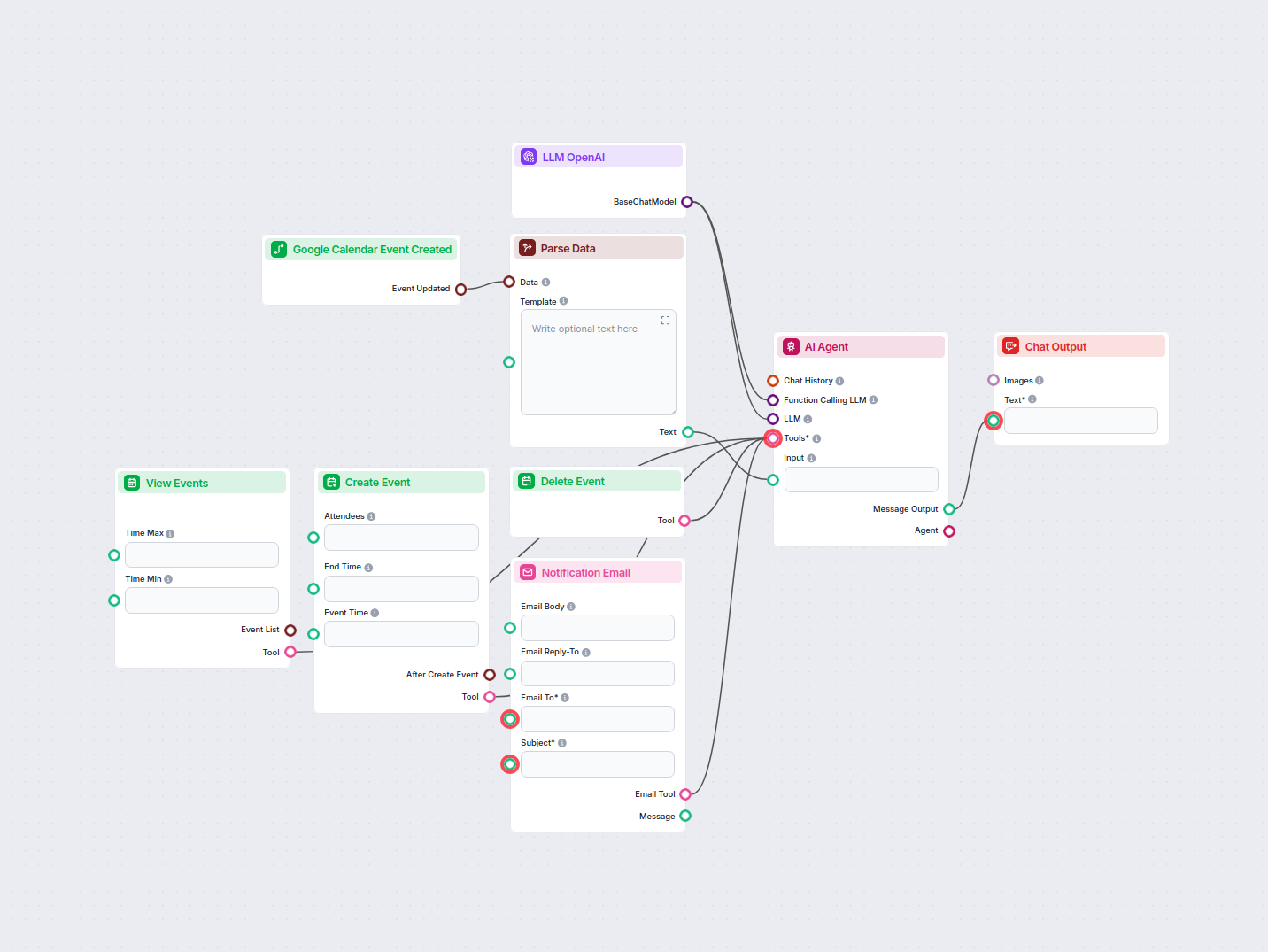

Automatiza y agiliza la aprobación de solicitudes de vacaciones en Google Calendar mediante un agente de IA. Este flujo de trabajo detecta nuevas solicitudes de...

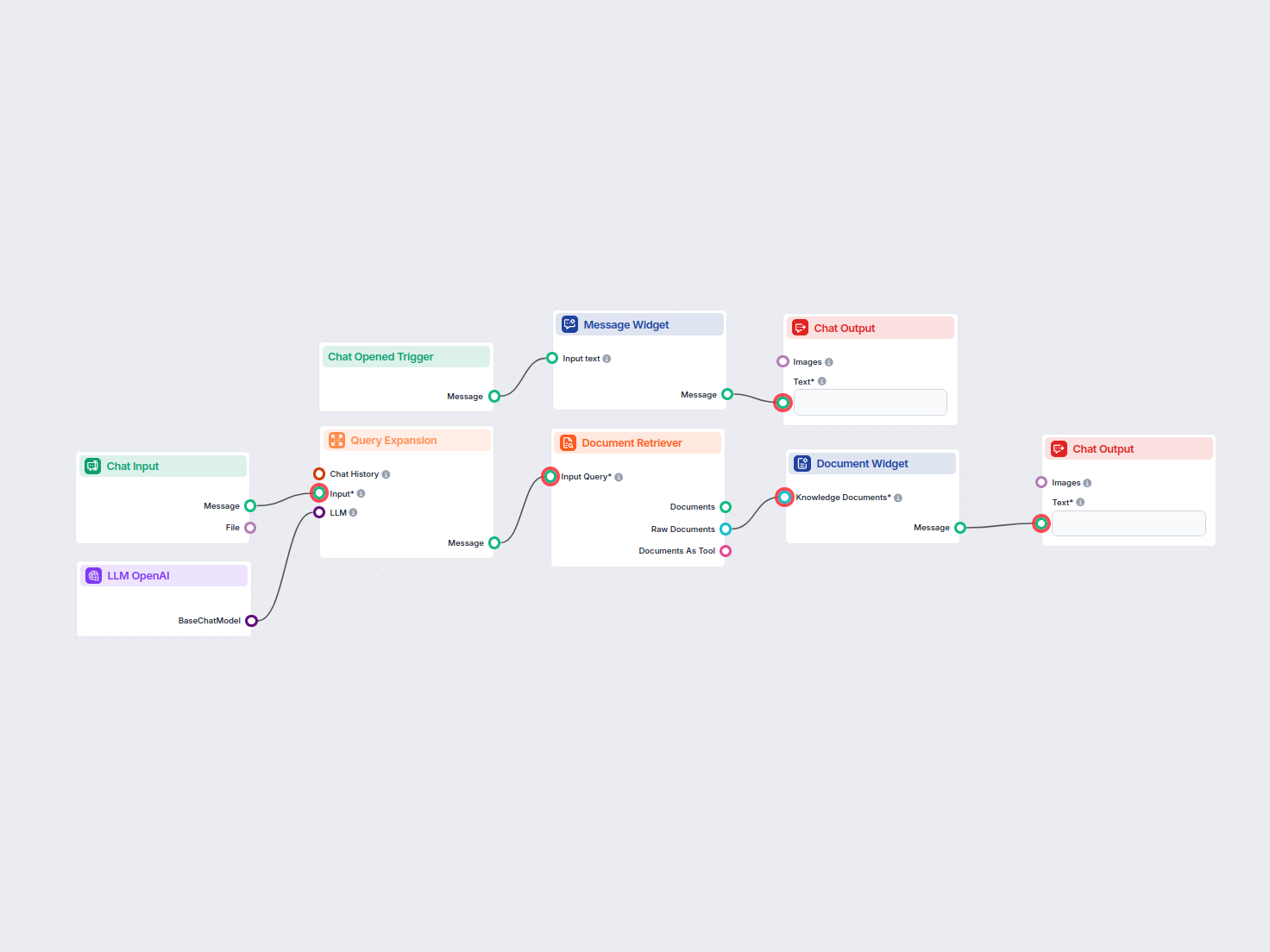

Busca y recupera fácilmente información de documentos privados de la base de conocimiento usando búsqueda semántica impulsada por IA. El flujo amplía las consul...

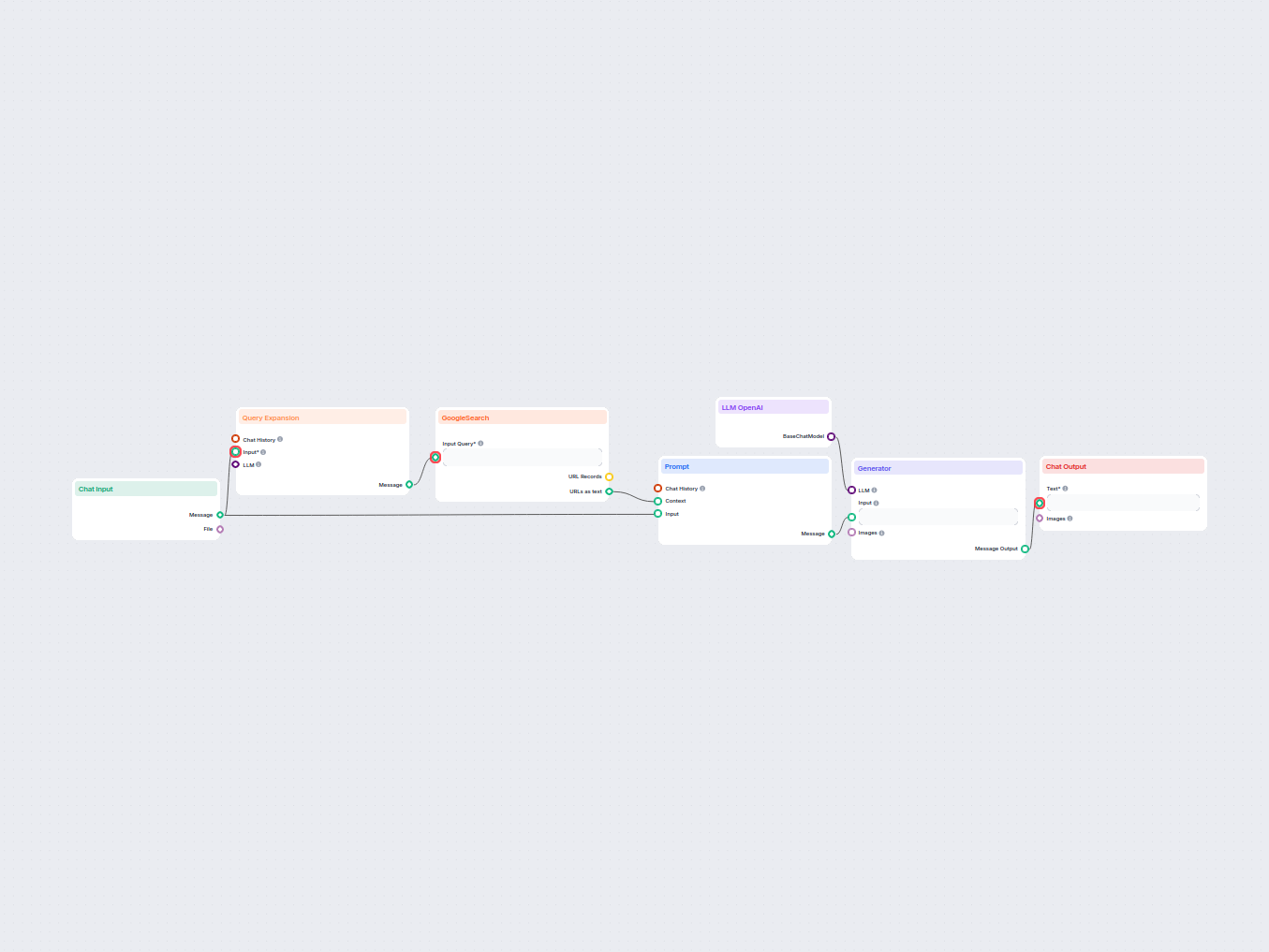

Un chatbot en tiempo real que utiliza la Búsqueda de Google restringida a tu propio dominio, recupera contenido web relevante y aprovecha el LLM de OpenAI para ...

Transforma documentación técnica de una URL en un artículo atractivo y optimizado para SEO para tu sitio web. Este flujo analiza el contenido de los principales...

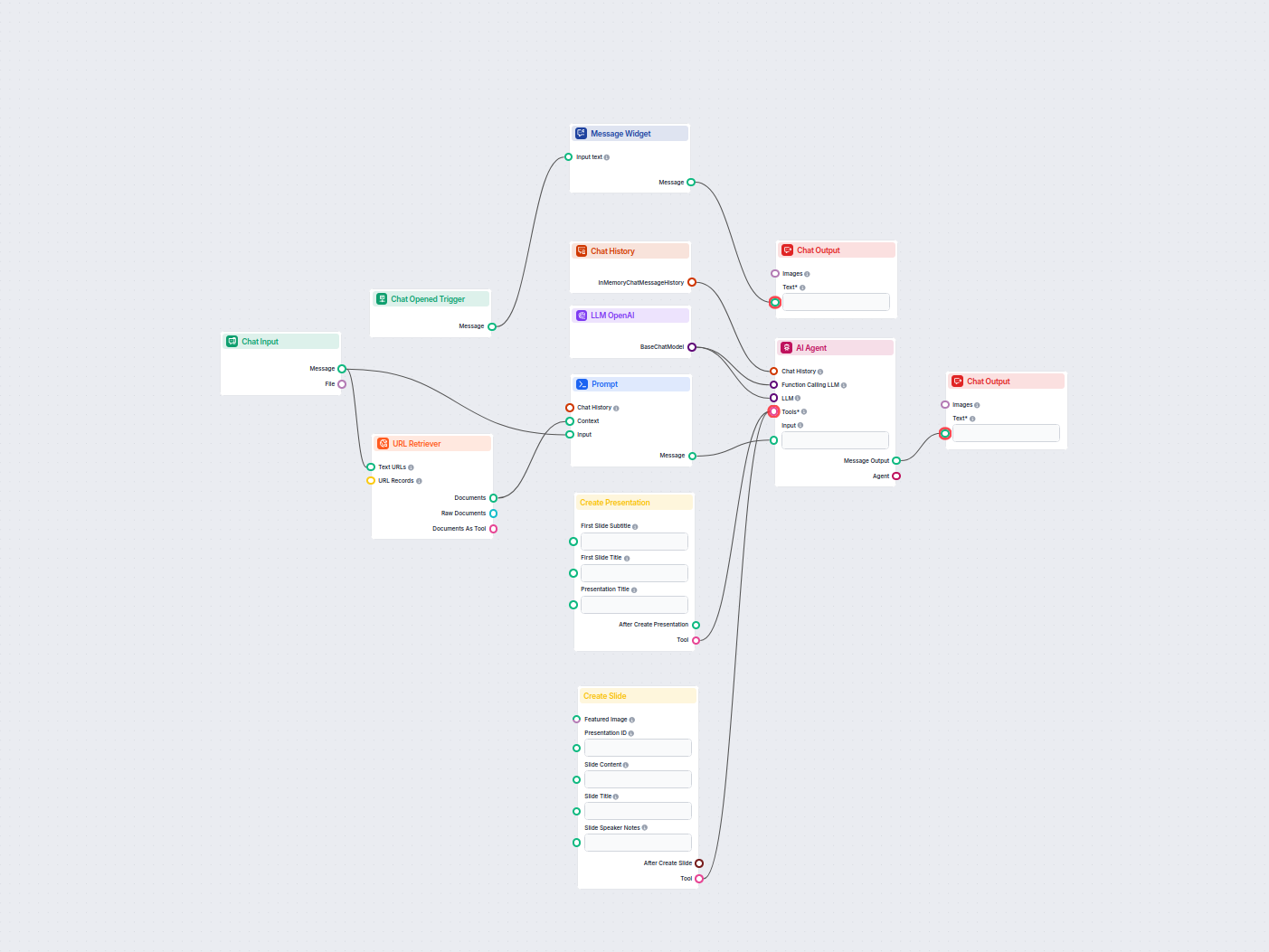

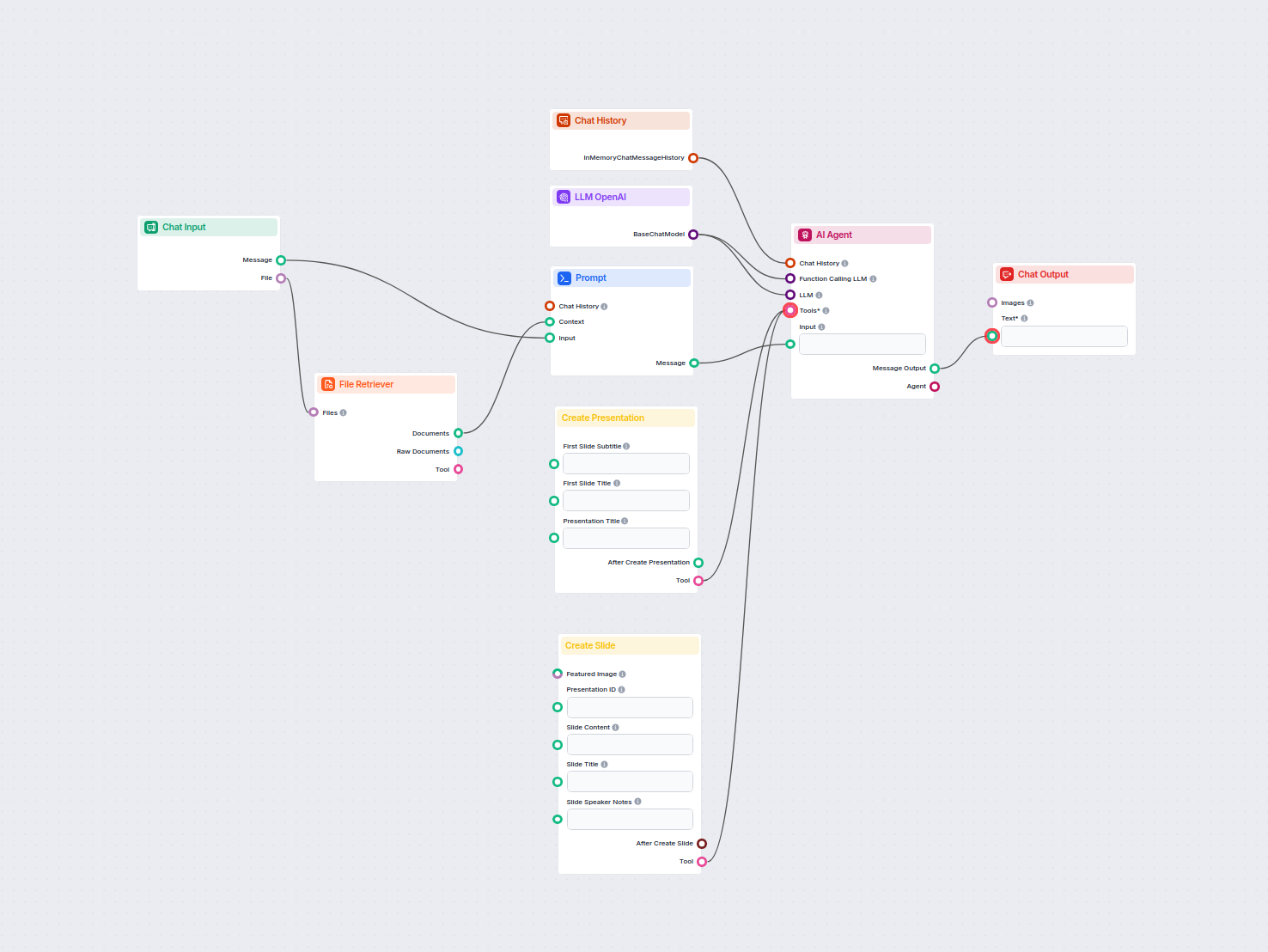

Genera automáticamente pitch decks profesionales en Google Slides utilizando IA e investigación web en tiempo real. Este flujo recopila la información del usuar...

Genera publicaciones de blog completas y optimizadas para SEO, con estructura avanzada y alto recuento de palabras utilizando múltiples agentes de IA. El flujo ...

Genera análisis de productos completos utilizando agentes de IA que recopilan y resumen información de productos, precios, características, reseñas, alternativa...

Genera artículos de glosario en profundidad y optimizados para SEO utilizando IA e investigación web en tiempo real. Este flujo analiza el contenido y estilos d...

Genera artículos de reseñas de productos de software completos y optimizados para SEO, incluyendo características detalladas, precios, opiniones de usuarios, re...

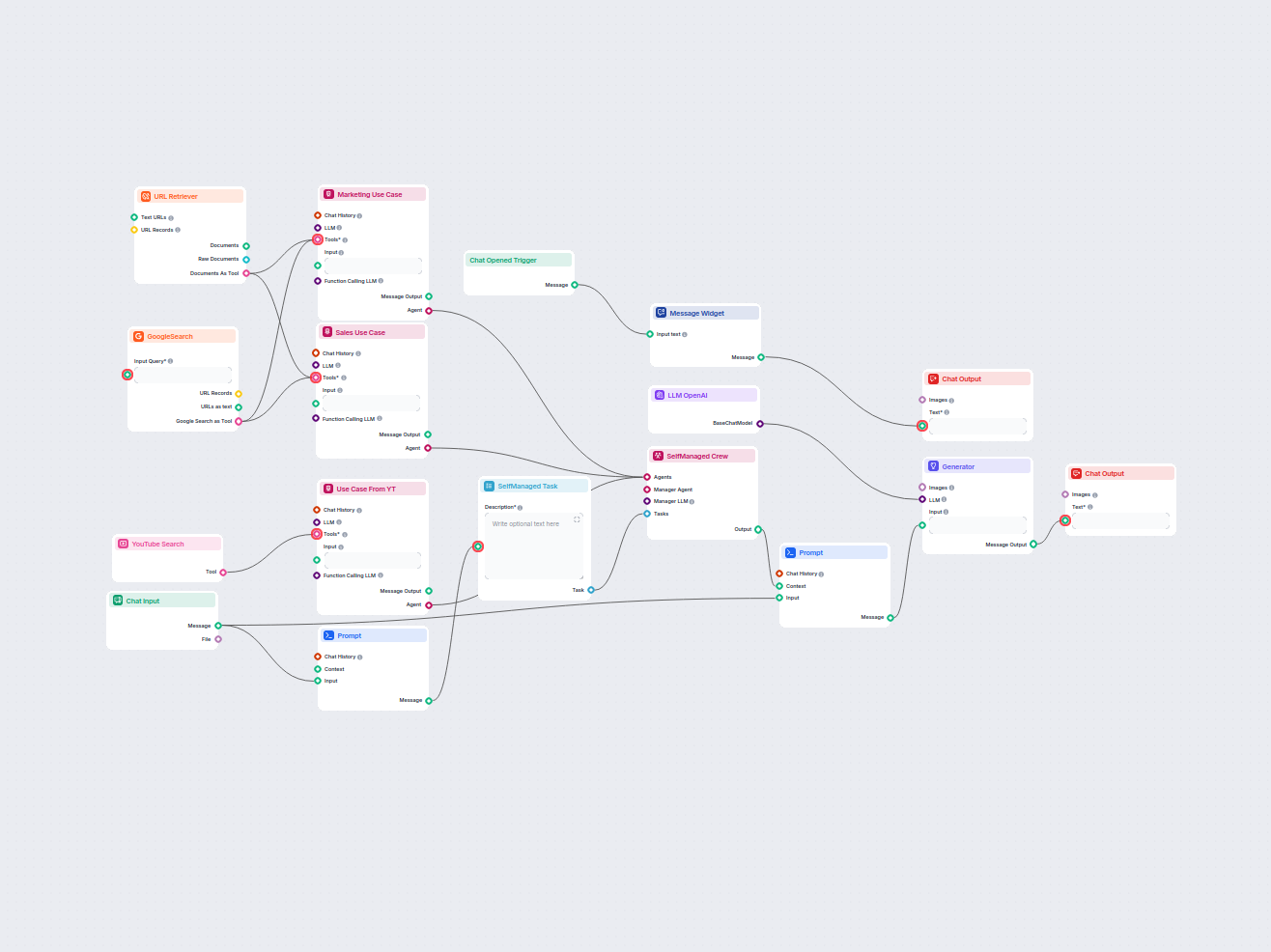

Genera informes completos e impulsados por IA sobre casos de uso de productos de software para marketing y ventas. Este flujo de trabajo investiga el producto e...

Convierte cualquier video de YouTube en una presentación profesional de Google Slides en minutos. Este flujo de trabajo impulsado por IA extrae el contenido de ...

Genera títulos únicos y optimizados para SEO utilizando IA y datos en vivo de búsquedas en Google. Ingresa tus palabras clave objetivo y recibe una sugerencia d...

Automatiza la creación de presentaciones profesionales de Google Slides a partir de cualquier documento subido utilizando IA. Este flujo extrae el contenido del...

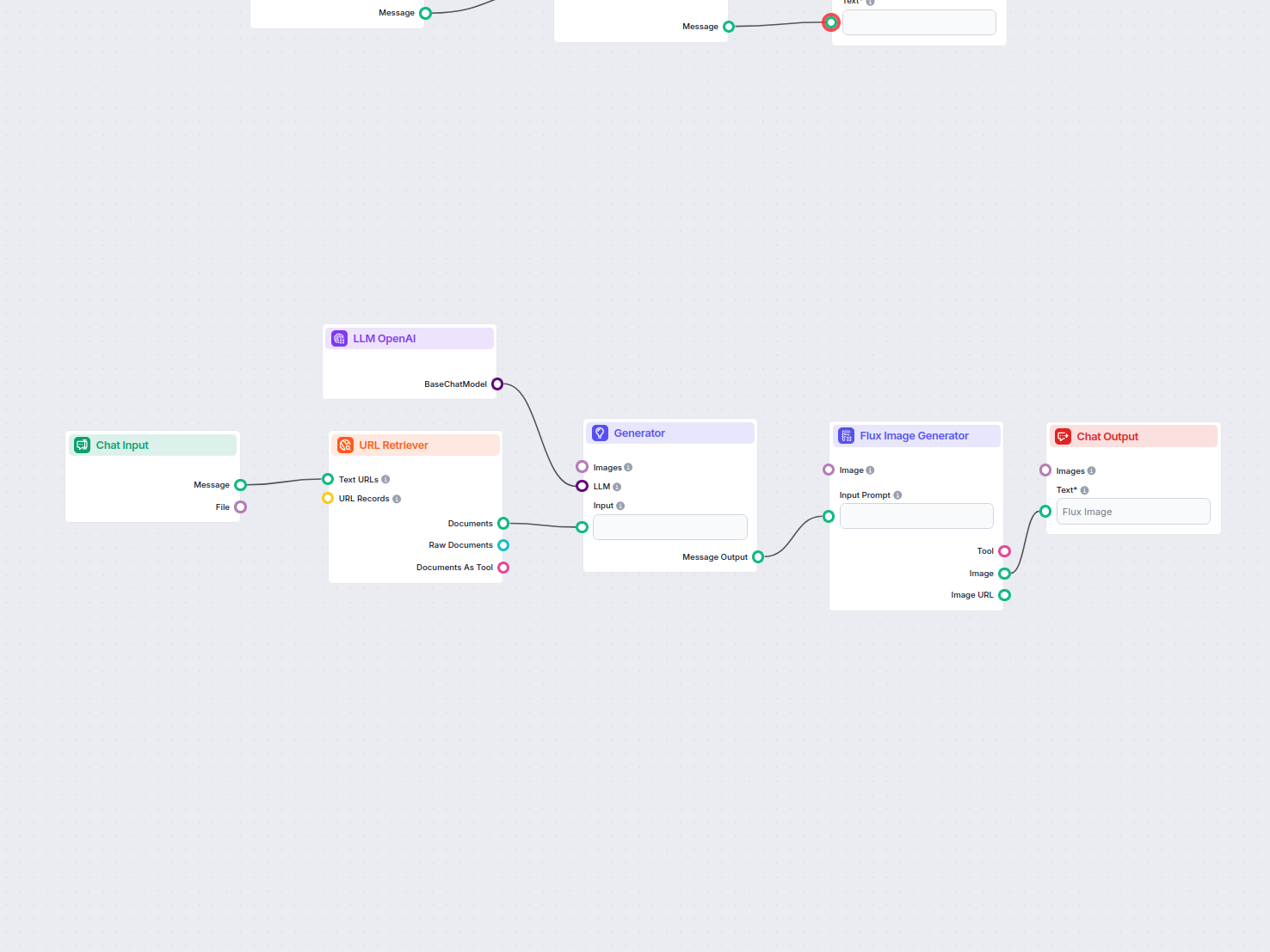

Genera automáticamente una imagen destacada atractiva para cualquier entrada de blog analizando su contenido. Solo proporciona la URL del blog y el flujo de tra...

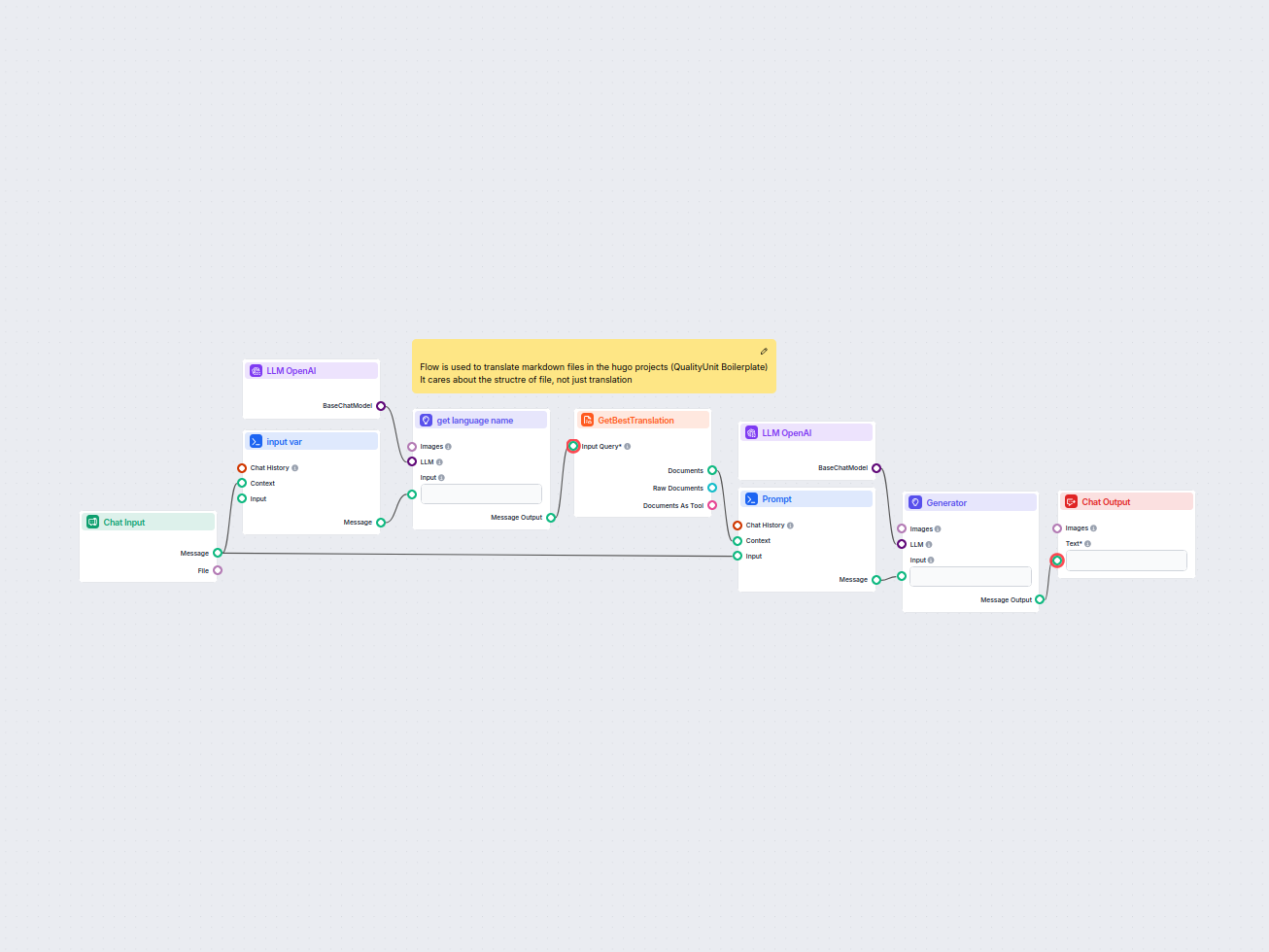

Este flujo de trabajo agiliza la traducción de archivos markdown de HUGO a idiomas de destino mientras preserva la estructura y el formato del archivo. Aprovech...

Los modelos de lenguaje grande son tipos de IA entrenados para procesar, comprender y generar texto similar al humano. Un ejemplo común es ChatGPT, que puede proporcionar respuestas elaboradas a casi cualquier consulta.

No, el componente LLM solo es una representación del modelo de IA. Cambia el modelo que usará el Generador. El LLM predeterminado en el Generador es ChatGPT-4o.

Por el momento, solo el componente OpenAI está disponible. Planeamos agregar más en el futuro.

No, los Flows son una característica versátil con muchos casos de uso sin necesidad de un LLM. Agregas un LLM si quieres crear un chatbot conversacional que genere respuestas de texto libremente.

No exactamente. El componente solo representa el modelo y crea reglas para que las siga. Es el componente generador el que lo conecta a la entrada y ejecuta la consulta a través del LLM para crear la salida.

Chatbots inteligentes y herramientas de IA en un solo lugar. Conecta bloques intuitivos para convertir tus ideas en Flujos automatizados.

FlowHunt admite docenas de modelos de IA, incluidos los modelos Claude de Anthropic. Aprende a usar Claude en tus herramientas de IA y chatbots con configuracio...

FlowHunt es compatible con docenas de modelos de generación de texto, incluidos los modelos Llama de Meta. Aprende cómo integrar Llama en tus herramientas y cha...

FlowHunt admite docenas de modelos de generación de texto, incluidos los modelos de xAI. Aquí te mostramos cómo usar los modelos de xAI en tus herramientas y ch...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.