Reordenamiento de Documentos

El reordenamiento de documentos es el proceso de reorganizar los documentos recuperados según su relevancia para la consulta de un usuario, refinando los result...

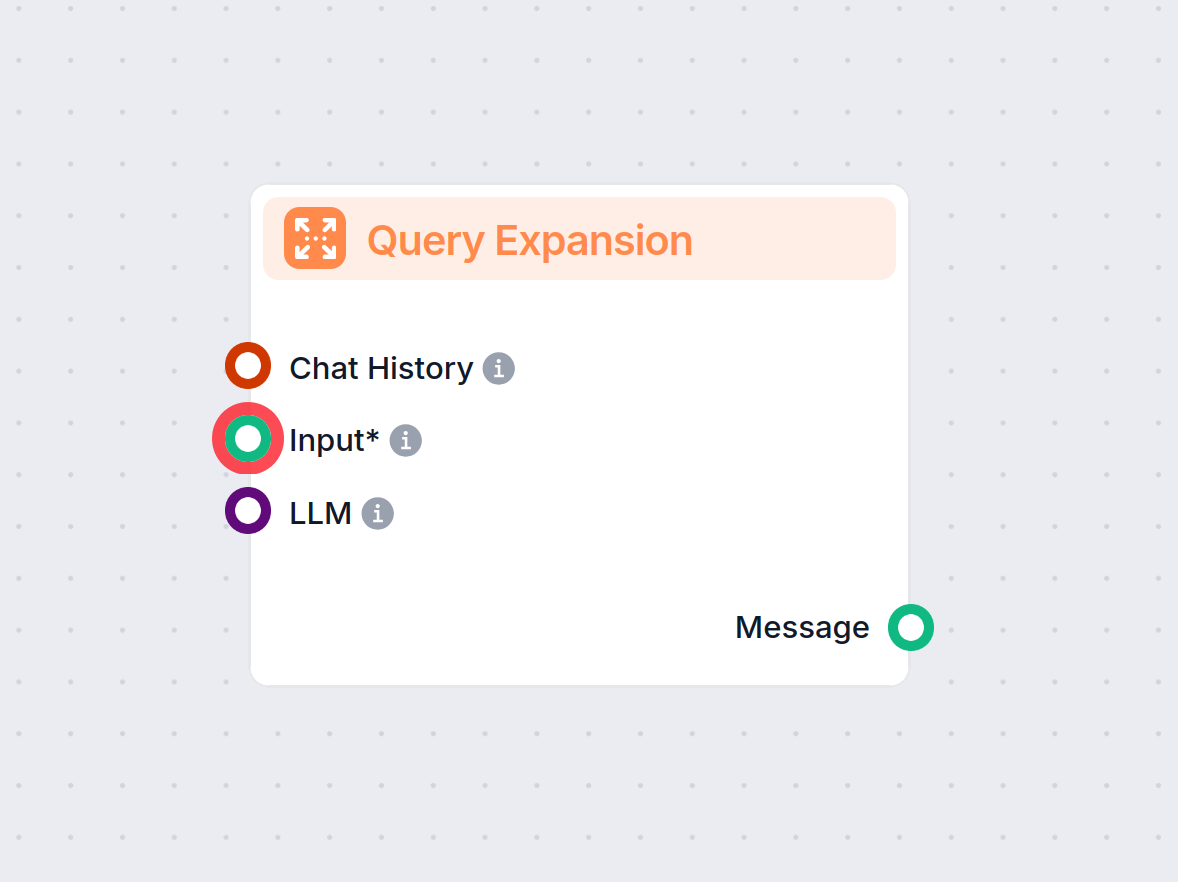

La expansión de consultas enriquece las consultas de los usuarios con contexto o términos adicionales, mejorando la precisión de la recuperación y la calidad de las respuestas en sistemas de IA como RAG y chatbots.

La expansión de consultas mejora las consultas de los usuarios añadiendo términos o contexto, optimizando la recuperación de documentos para respuestas precisas. En sistemas RAG, aumenta el recall y la relevancia, ayudando a chatbots e IA a proporcionar respuestas exactas al gestionar eficazmente consultas vagas o con sinónimos.

La expansión de consultas se refiere al proceso de mejorar la consulta original de un usuario añadiendo términos o contexto adicionales antes de enviarla al mecanismo de recuperación. Esta ampliación ayuda a recuperar documentos o piezas de información más relevantes, que luego se utilizan para generar una respuesta más precisa y adecuada al contexto. Si los documentos se buscan con consultas alternativas y luego se reordenan, el proceso RAG obtiene resultados de documentos mucho más precisos en la ventana de contexto del prompt.

La Generación Aumentada por Recuperación (RAG) es una arquitectura de IA que combina mecanismos de recuperación con modelos generativos para producir respuestas más precisas y contextualmente relevantes. En los sistemas RAG, un componente de recuperación obtiene documentos o fragmentos de datos relevantes de una base de conocimiento en función de una consulta del usuario. Luego, un modelo generativo (a menudo un modelo de lenguaje grande o LLM) utiliza esta información recuperada para generar una respuesta coherente e informativa.

En los sistemas RAG, la calidad de la respuesta generada depende en gran medida de la relevancia de los documentos recuperados. Si el componente de recuperación no obtiene la información más pertinente, el modelo generativo puede producir respuestas subóptimas o irrelevantes. La expansión de consultas aborda este desafío mejorando la consulta inicial, aumentando las posibilidades de recuperar todos los documentos relevantes.

Al ampliar la consulta original con términos relacionados, sinónimos o parafraseos, la expansión de consultas amplía el espacio de búsqueda. Esto incrementa el recall del sistema de recuperación, es decir, capta una mayor proporción de documentos relevantes de la base de conocimiento. Un mayor recall proporciona un contexto más completo para el modelo generativo, mejorando la calidad global de la salida del sistema RAG.

LLMs como GPT-4 pueden generar consultas semánticamente similares o parafraseos de la consulta original. Al comprender el contexto y los matices del lenguaje, los LLMs pueden producir expansiones de alta calidad que capturan diferentes formas de plantear la misma pregunta.

Ejemplo:

En este enfoque, el sistema genera una respuesta hipotética a la consulta del usuario utilizando un LLM. La respuesta hipotética luego se añade a la consulta original para proporcionar más contexto durante la recuperación.

Proceso:

Ejemplo:

Este método consiste en generar varias consultas alternativas que capturan diferentes formulaciones o aspectos de la consulta original. Cada consulta se utiliza de forma independiente para recuperar documentos.

Proceso:

Ejemplo:

Escenario:

Un sistema de IA está diseñado para responder preguntas basadas en el informe anual de una empresa. Un usuario pregunta: “¿Hubo una rotación significativa en el equipo ejecutivo?”

Implementación:

Beneficio:

Al proporcionar más contexto mediante la respuesta hipotética, el sistema recupera información relevante que podría haberse perdido solo con la consulta original.

Escenario:

Un chatbot de soporte al cliente ayuda a los usuarios a solucionar problemas. Un usuario escribe: “Mi internet está lento.”

Implementación:

Beneficio:

El chatbot cubre una gama más amplia de posibles problemas y soluciones, aumentando la probabilidad de resolver el problema del usuario de manera eficiente.

Escenario:

Un estudiante usa un asistente de IA para encontrar recursos sobre un tema: “Efectos de la privación del sueño en la función cognitiva.”

Implementación:

Beneficio:

El estudiante recibe información completa que cubre distintos aspectos del tema, facilitando una investigación más profunda.

Añadir demasiadas consultas expandidas puede introducir documentos irrelevantes, reduciendo la precisión de la recuperación.

Mitigación:

Las palabras con varios significados pueden llevar a expansiones irrelevantes.

Mitigación:

Generar y procesar múltiples consultas expandidas puede requerir muchos recursos.

Mitigación:

Garantizar que las consultas expandidas funcionen eficazmente con los algoritmos de recuperación existentes.

Mitigación:

Asignar pesos a los términos en las consultas expandidas para reflejar su importancia.

Después de la recuperación, reordenar los documentos para priorizar la relevancia.

Ejemplo:

Usar un Cross-Encoder después de la recuperación para puntuar y reordenar documentos según su relevancia respecto a la consulta original.

Incorporar las interacciones de los usuarios para mejorar la expansión de consultas.

El uso de IA y LLMs para la expansión de consultas aprovecha la comprensión avanzada del lenguaje para mejorar la recuperación. Esto permite que sistemas de IA, incluidos chatbots y asistentes virtuales, brinden respuestas más precisas y apropiadas al contexto.

Automatizar el proceso de expansión de consultas reduce la carga sobre los usuarios para crear consultas precisas. La automatización con IA gestiona la complejidad en segundo plano, mejorando la eficiencia de los sistemas de recuperación de información.

Los chatbots se benefician de la expansión de consultas al comprender mejor las intenciones del usuario, especialmente cuando utilizan lenguaje coloquial o frases incompletas. Esto conduce a interacciones más satisfactorias y resolución efectiva de problemas.

Ejemplo:

Un chatbot de soporte técnico puede interpretar una consulta vaga como “Mi app no funciona” expandiéndola a “fallos de la aplicación”, “el software no responde” y “mensajes de error de la app”, logrando así una resolución más rápida.

Investigación sobre Expansión de Consultas para RAG

Mejorando la recuperación para RAG basado en preguntas y respuestas en documentos financieros

Este artículo examina la eficacia de los modelos de lenguaje grandes (LLMs) potenciados por Generación Aumentada por Recuperación (RAG), especialmente en el contexto de documentos financieros. Identifica que las imprecisiones en las salidas de los LLMs suelen deberse a una recuperación de textos subóptima más que a los propios LLMs. El estudio propone mejoras en los procesos RAG, incluyendo técnicas sofisticadas de fragmentación y expansión de consultas, junto con anotaciones de metadatos y algoritmos de reordenamiento. Estas metodologías buscan refinar la recuperación de textos y así mejorar el rendimiento de los LLMs en la generación de respuestas precisas. Leer más

Mejorando la recuperación y gestión: Sinergia de cuatro módulos para mejorar la calidad y eficiencia en sistemas RAG

El artículo propone un enfoque modular para mejorar los sistemas RAG, centrándose en el módulo Query Rewriter, que crea consultas optimizadas para mejorar la recuperación de conocimiento. Aborda los problemas de Meseta de Información y Ambigüedad en consultas mediante la generación de múltiples consultas. Además, se proponen el Knowledge Filter y el Memory Knowledge Reservoir para gestionar el conocimiento irrelevante y optimizar los recursos de recuperación. Estos avances buscan aumentar la calidad y eficiencia de las respuestas en sistemas RAG, validados mediante experimentos en conjuntos de datos de QA. Accede al código y más detalles.

MultiHop-RAG: Benchmarking la Generación Aumentada por Recuperación para consultas multi-hop

Esta investigación resalta los desafíos de los sistemas RAG existentes al abordar consultas multi-hop, que requieren razonamiento sobre múltiples evidencias. Introduce un conjunto de datos novedoso diseñado específicamente para evaluar sistemas RAG en consultas multi-hop, con el objetivo de ampliar los límites de las capacidades actuales. El artículo discute los avances necesarios para que los métodos RAG gestionen eficazmente estructuras de consulta complejas y mejoren la adopción de LLMs en aplicaciones prácticas.

La expansión de consultas es el proceso de aumentar la consulta original de un usuario añadiendo términos relacionados, sinónimos o contexto, ayudando a los sistemas de recuperación a encontrar documentos más relevantes y generar respuestas precisas, especialmente en aplicaciones impulsadas por IA.

En los sistemas RAG (Generación Aumentada por Recuperación), la expansión de consultas aumenta el recall del componente de recuperación al ampliar el espacio de búsqueda, asegurando que se consideren más documentos relevantes para generar respuestas precisas.

Las técnicas incluyen el uso de modelos de lenguaje grandes para generar consultas parafraseadas, generación de respuestas hipotéticas, enfoques de consultas múltiples, ponderación de términos y aprovechamiento del feedback del usuario para una mejora continua.

La expansión de consultas mejora el recall, gestiona consultas vagas o ambiguas, reconoce sinónimos y mejora la experiencia del usuario al ofrecer respuestas más precisas e informativas sin necesidad de refinar manualmente la consulta.

Sí, los desafíos incluyen la sobreexpansión (introducción de documentos irrelevantes), ambigüedad en los términos, demanda de recursos computacionales y garantizar la compatibilidad con los algoritmos de recuperación. Estos pueden mitigarse con generación controlada, filtrado de relevancia y modelos eficientes.

Descubre cómo la expansión de consultas puede mejorar la precisión de tu chatbot de IA y optimizar la recuperación de información. Conoce las soluciones de FlowHunt para un manejo eficiente y automatizado de consultas.

El reordenamiento de documentos es el proceso de reorganizar los documentos recuperados según su relevancia para la consulta de un usuario, refinando los result...

La Respuesta a Preguntas con Generación Aumentada por Recuperación (RAG) combina la recuperación de información y la generación de lenguaje natural para mejorar...

La Expansión de Consulta en FlowHunt mejora la comprensión del chatbot al encontrar sinónimos, corregir errores ortográficos y garantizar respuestas consistente...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.