Chatbot RAG en Tiempo Real Específico de Dominio

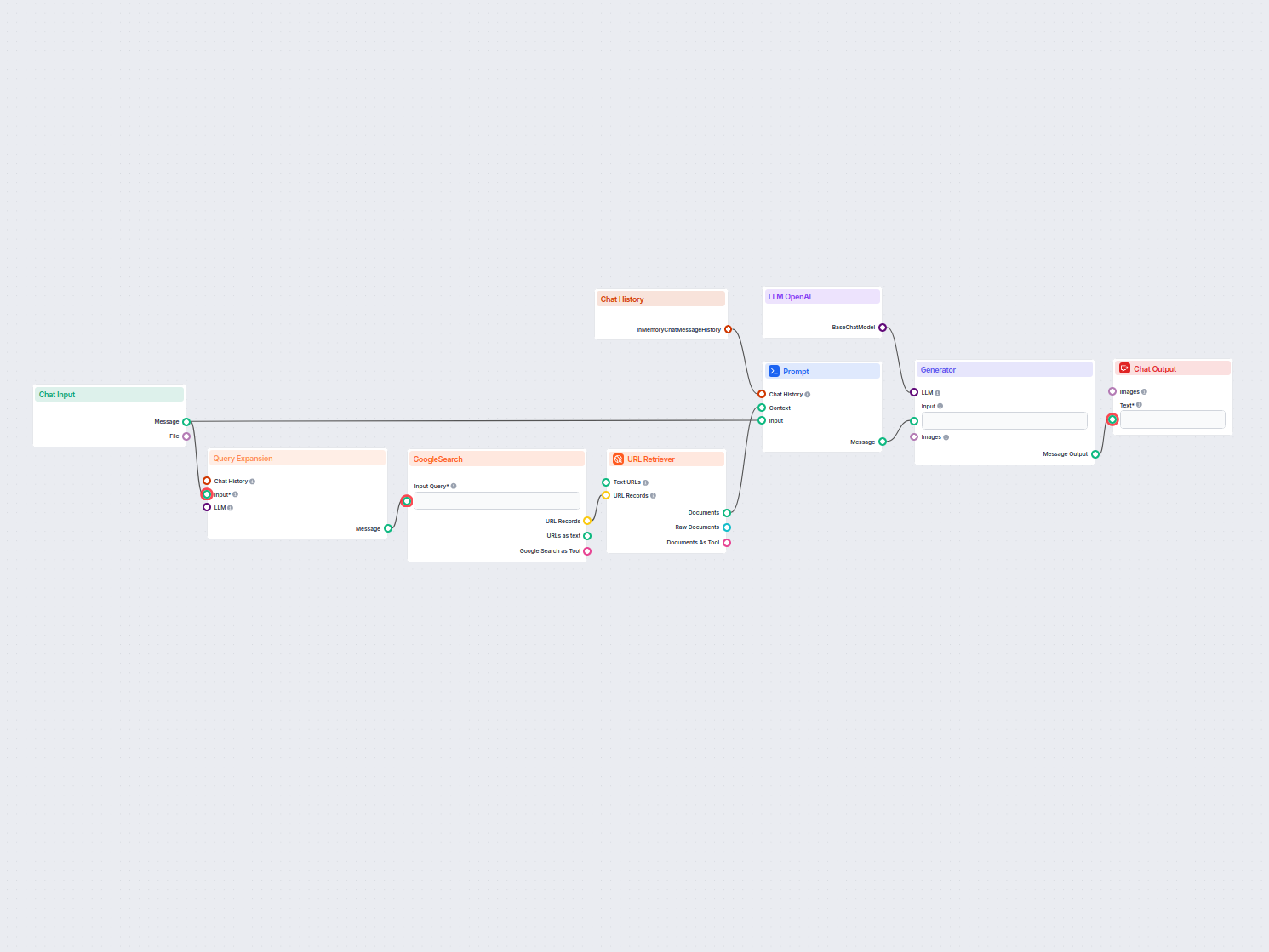

Un chatbot en tiempo real que utiliza la Búsqueda de Google restringida a tu propio dominio, recupera contenido web relevante y aprovecha el LLM de OpenAI para ...

Un pipeline de recuperación permite a los chatbots buscar y procesar conocimiento externo relevante para respuestas precisas, en tiempo real y contextuales usando RAG, embeddings y bases de datos vectoriales.

Un pipeline de recuperación para chatbots se refiere a la arquitectura técnica y el proceso que permite a los chatbots buscar, procesar y recuperar información relevante en respuesta a consultas de los usuarios. A diferencia de los sistemas simples de preguntas y respuestas que solo dependen de modelos de lenguaje preentrenados, los pipelines de recuperación incorporan bases de conocimiento o fuentes de datos externas. Esto permite que el chatbot proporcione respuestas precisas, contextualmente relevantes y actualizadas, incluso cuando los datos no son inherentes al propio modelo de lenguaje.

El pipeline de recuperación normalmente consta de varios componentes, incluyendo ingestión de datos, creación de embeddings, almacenamiento vectorial, recuperación de contexto y generación de respuestas. Su implementación a menudo aprovecha la Generación Aumentada por Recuperación (RAG), que combina las fortalezas de los sistemas de recuperación de datos y los Grandes Modelos de Lenguaje (LLM) para la generación de respuestas.

Un pipeline de recuperación se utiliza para mejorar las capacidades de un chatbot permitiéndole:

Ingesta de Documentos

Recolección y preprocesamiento de datos en bruto, que pueden incluir PDFs, archivos de texto, bases de datos o APIs. Herramientas como LangChain o LlamaIndex suelen emplearse para una ingesta de datos fluida.

Ejemplo: Cargar FAQs de servicio al cliente o especificaciones de productos en el sistema.

Preprocesamiento de Documentos

Los documentos largos se dividen en fragmentos más pequeños y semánticamente significativos. Esto es esencial para ajustar el texto a los modelos de embeddings, que suelen tener límites de tokens (por ejemplo, 512 tokens).

Ejemplo de Fragmento de Código:

from langchain.text_splitter import RecursiveCharacterTextSplitter

text_splitter = RecursiveCharacterTextSplitter(chunk_size=500, chunk_overlap=50)

chunks = text_splitter.split_documents(document_list)

Generación de Embeddings

Los datos de texto se convierten en representaciones vectoriales de alta dimensión utilizando modelos de embeddings. Estos embeddings codifican numéricamente el significado semántico de los datos.

Ejemplo de modelo de embedding: text-embedding-ada-002 de OpenAI o e5-large-v2 de Hugging Face.

Almacenamiento Vectorial

Los embeddings se almacenan en bases de datos vectoriales optimizadas para búsquedas por similitud. Herramientas como Milvus, Chroma o PGVector son comúnmente utilizadas.

Ejemplo: Almacenar descripciones de productos y sus embeddings para una recuperación eficiente.

Procesamiento de Consultas

Cuando se recibe una consulta de usuario, se transforma en un vector de consulta usando el mismo modelo de embedding. Esto permite la coincidencia semántica con los embeddings almacenados.

Ejemplo de Fragmento de Código:

query_vector = embedding_model.encode("What are the specifications of Product X?")

retrieved_docs = vector_db.similarity_search(query_vector, k=5)

Recuperación de Datos

El sistema recupera los fragmentos de datos más relevantes basados en puntajes de similitud (por ejemplo, similitud de coseno). Los sistemas de recuperación multimodal pueden combinar bases de datos SQL, grafos de conocimiento y búsquedas vectoriales para resultados más robustos.

Generación de Respuestas

Los datos recuperados se combinan con la consulta del usuario y se envían a un gran modelo de lenguaje (LLM) para generar una respuesta final en lenguaje natural. Este paso a menudo se denomina generación aumentada.

Ejemplo de Plantilla de Prompt:

prompt_template = """

Context: {context}

Question: {question}

Please provide a detailed response using the context above.

"""

Posprocesamiento y Validación

Los pipelines de recuperación avanzados incluyen detección de alucinaciones, verificaciones de relevancia o evaluación de respuestas para garantizar que la salida sea fáctica y relevante.

Soporte al Cliente

Los chatbots pueden recuperar manuales de productos, guías de solución de problemas o FAQs para proporcionar respuestas instantáneas a las consultas de los clientes.

Ejemplo: Un chatbot que ayuda a un cliente a restablecer un router recuperando la sección relevante del manual de usuario.

Gestión del Conocimiento Empresarial

Los chatbots internos pueden acceder a datos específicos de la empresa como políticas de RRHH, documentación de soporte informático o directrices de cumplimiento.

Ejemplo: Empleados consultando un chatbot interno sobre políticas de baja por enfermedad.

E-Commerce

Los chatbots asisten a los usuarios recuperando detalles de productos, reseñas o disponibilidad de inventario.

Ejemplo: “¿Cuáles son las características principales del Producto Y?”

Salud

Los chatbots recuperan literatura médica, guías o datos de pacientes para asistir a profesionales de la salud o pacientes.

Ejemplo: Un chatbot que recupera advertencias sobre interacciones de medicamentos desde una base de datos farmacéutica.

Educación e Investigación

Los chatbots académicos usan pipelines RAG para buscar artículos académicos, responder preguntas o resumir hallazgos de investigación.

Ejemplo: “¿Puedes resumir los hallazgos de este estudio de 2023 sobre cambio climático?”

Legal y Cumplimiento

Los chatbots recuperan documentos legales, jurisprudencia o requisitos de cumplimiento para asistir a profesionales legales.

Ejemplo: “¿Cuál es la última actualización sobre las regulaciones GDPR?”

Un chatbot diseñado para responder preguntas del informe financiero anual de una empresa en formato PDF.

Un chatbot que combina búsquedas SQL, vectoriales y grafos de conocimiento para responder preguntas de un empleado.

Al aprovechar los pipelines de recuperación, los chatbots ya no están limitados por los datos de entrenamiento estáticos, permitiéndoles ofrecer interacciones dinámicas, precisas y ricas en contexto.

Los pipelines de recuperación juegan un papel fundamental en los sistemas modernos de chatbots, permitiendo interacciones inteligentes y contextuales.

“Lingke: A Fine-grained Multi-turn Chatbot for Customer Service” de Pengfei Zhu et al. (2018)

Presenta Lingke, un chatbot que integra recuperación de información para manejar conversaciones de varios turnos. Aprovecha el procesamiento detallado en pipeline para destilar respuestas de documentos no estructurados y emplea coincidencia atenta contexto-respuesta para interacciones secuenciales, mejorando significativamente la capacidad del chatbot para abordar consultas complejas de usuarios.

Lee el artículo aquí.

“FACTS About Building Retrieval Augmented Generation-based Chatbots” de Rama Akkiraju et al. (2024)

Explora los desafíos y metodologías en el desarrollo de chatbots empresariales utilizando pipelines de Generación Aumentada por Recuperación (RAG) y Grandes Modelos de Lenguaje (LLM). Los autores proponen el marco FACTS, enfatizando Frescura, Arquitecturas, Costos, Pruebas y Seguridad en la ingeniería de pipelines RAG. Sus hallazgos empíricos destacan los compromisos entre precisión y latencia al escalar LLMs, ofreciendo valiosos conocimientos para construir chatbots seguros y de alto rendimiento. Lee el artículo aquí.

“From Questions to Insightful Answers: Building an Informed Chatbot for University Resources” de Subash Neupane et al. (2024)

Presenta BARKPLUG V.2, un sistema de chatbot diseñado para entornos universitarios. Utilizando pipelines RAG, el sistema proporciona respuestas precisas y específicas del dominio a los usuarios sobre recursos del campus, mejorando el acceso a la información. El estudio evalúa la efectividad del chatbot usando marcos como RAG Assessment (RAGAS) y muestra su utilidad en ambientes académicos. Lee el artículo aquí.

Un pipeline de recuperación es una arquitectura técnica que permite a los chatbots buscar, procesar y recuperar información relevante de fuentes externas en respuesta a consultas de los usuarios. Combina la ingestión de datos, generación de embeddings, almacenamiento vectorial y generación de respuestas por LLM para respuestas dinámicas y contextuales.

RAG combina las fortalezas de los sistemas de recuperación de datos y los grandes modelos de lenguaje (LLM), permitiendo a los chatbots fundamentar sus respuestas en datos externos actualizados, reduciendo alucinaciones y aumentando la precisión.

Los componentes clave incluyen ingestión de documentos, preprocesamiento, generación de embeddings, almacenamiento vectorial, procesamiento de consultas, recuperación de datos, generación de respuestas y validación posterior.

Los casos de uso incluyen soporte al cliente, gestión de conocimiento empresarial, información de productos en e-commerce, orientación en salud, educación e investigación, y asistencia en cumplimiento legal.

Los desafíos incluyen latencia debida a la recuperación en tiempo real, costos operativos, preocupaciones de privacidad de datos y requisitos de escalabilidad para manejar grandes volúmenes de datos.

Desbloquea el poder de la Generación Aumentada por Recuperación (RAG) y la integración de datos externos para ofrecer respuestas inteligentes y precisas en chatbots. Prueba hoy la plataforma sin código de FlowHunt.

Un chatbot en tiempo real que utiliza la Búsqueda de Google restringida a tu propio dominio, recupera contenido web relevante y aprovecha el LLM de OpenAI para ...

Las Fuentes de Conocimiento facilitan enseñar a la IA según tus necesidades. Descubre todas las formas de vincular el conocimiento con FlowHunt. Conecta fácilme...

La Respuesta a Preguntas con Generación Aumentada por Recuperación (RAG) combina la recuperación de información y la generación de lenguaje natural para mejorar...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.