Integración del Servidor ModelContextProtocol (MCP)

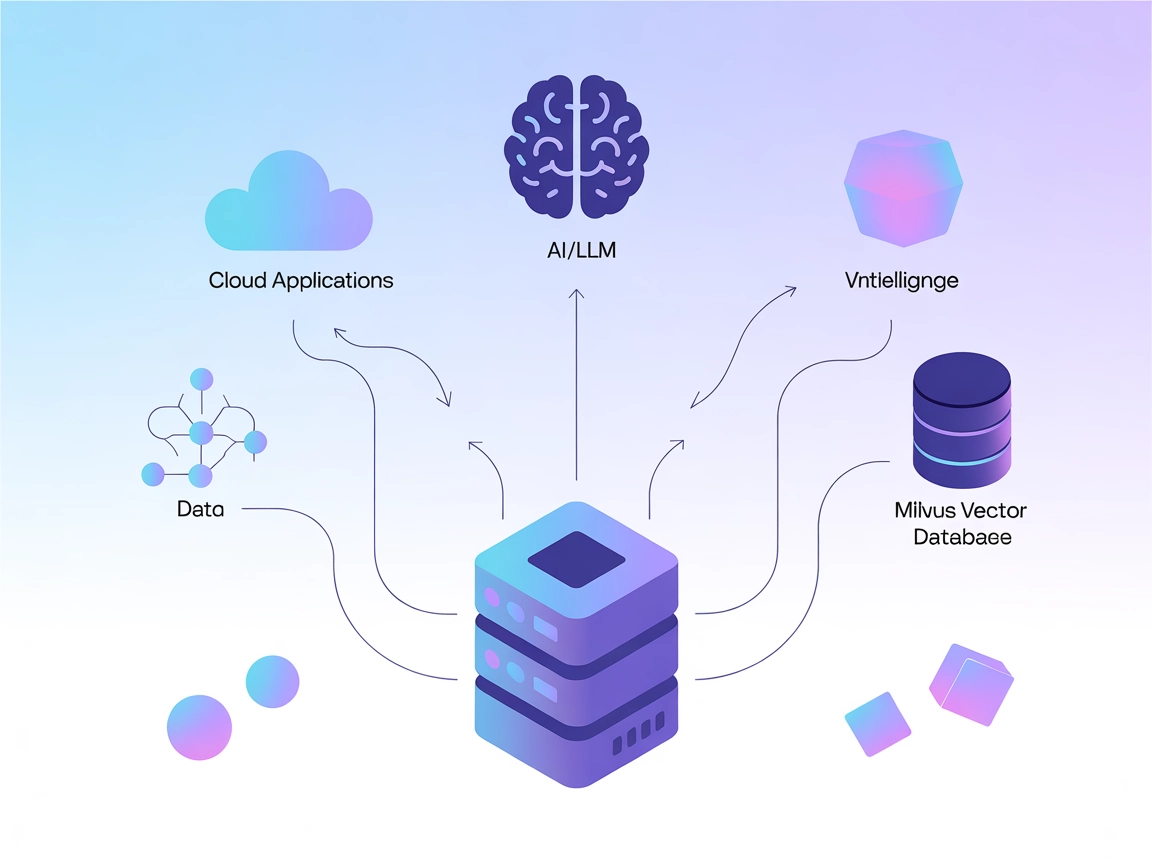

El Servidor ModelContextProtocol (MCP) actúa como un puente entre agentes de IA y fuentes de datos externas, APIs y servicios, permitiendo a los usuarios de Flo...

El Servidor Patronus MCP automatiza las evaluaciones y experimentos con LLM, permitiendo un benchmarking de IA eficiente e integración de flujos de trabajo para equipos técnicos que utilizan FlowHunt.

FlowHunt proporciona una capa de seguridad adicional entre tus sistemas internos y las herramientas de IA, dándote control granular sobre qué herramientas son accesibles desde tus servidores MCP. Los servidores MCP alojados en nuestra infraestructura pueden integrarse perfectamente con el chatbot de FlowHunt, así como con plataformas de IA populares como ChatGPT, Claude y varios editores de IA.

El Servidor Patronus MCP (Model Context Protocol) es una implementación estandarizada construida para el SDK Patronus, diseñada para facilitar la optimización avanzada de sistemas LLM (Large Language Model), evaluaciones y experimentos. Al conectar asistentes de IA a fuentes de datos y servicios externos, Patronus MCP Server permite flujos de trabajo eficientes para desarrolladores e investigadores. Permite a los usuarios ejecutar evaluaciones individuales o por lotes, realizar experimentos con conjuntos de datos e inicializar proyectos con claves API y configuraciones específicas. Esta plataforma extensible ayuda a automatizar tareas repetitivas de evaluación, admite la integración de evaluadores personalizados y proporciona una interfaz robusta para gestionar y analizar el comportamiento de los LLM, mejorando así el ciclo de desarrollo de IA.

No se listan plantillas de prompt explícitas en el repositorio o la documentación.

No se detallan recursos explícitos en la documentación o los archivos del repositorio disponibles.

initialize

Inicializa Patronus con la clave API, el proyecto y la configuración de la aplicación. Prepara el sistema para posteriores evaluaciones y experimentos.

evaluate

Ejecuta una evaluación individual usando un evaluador configurable sobre las entradas, salidas y contexto de la tarea dada.

batch_evaluate

Realiza evaluaciones por lotes con múltiples evaluadores sobre las tareas proporcionadas, produciendo resultados colectivos.

run_experiment

Ejecuta experimentos utilizando conjuntos de datos y evaluadores especificados, útil para benchmarking y comparación.

Automatización de Evaluación LLM

Automatiza la evaluación de modelos de lenguaje a gran escala agrupando tareas y aplicando múltiples evaluadores, reduciendo el esfuerzo manual en aseguramiento de calidad y benchmarking.

Experimentación Personalizada

Ejecuta experimentos adaptados con conjuntos de datos y evaluadores personalizados para comparar nuevas arquitecturas LLM y su rendimiento bajo diferentes criterios.

Inicialización de Proyectos para Equipos

Configura rápidamente entornos de evaluación para múltiples proyectos usando claves API y configuraciones de proyecto, facilitando la incorporación y colaboración.

Pruebas Interactivas en Vivo

Utiliza los scripts proporcionados para probar de forma interactiva los endpoints de evaluación, facilitando a los desarrolladores depurar y validar sus flujos de evaluación.

.windsurf o windsurf.json).{

"mcpServers": [

{

"command": "python",

"args": ["src/patronus_mcp/server.py"],

"env": {

"PATRONUS_API_KEY": "your_api_key_here"

}

}

]

}

{

"mcpServers": [

{

"command": "python",

"args": ["src/patronus_mcp/server.py"],

"env": {

"PATRONUS_API_KEY": "your_api_key_here"

}

}

]

}

{

"mcpServers": [

{

"command": "python",

"args": ["src/patronus_mcp/server.py"],

"env": {

"PATRONUS_API_KEY": "your_api_key_here"

}

}

]

}

{

"mcpServers": [

{

"command": "python",

"args": ["src/patronus_mcp/server.py"],

"env": {

"PATRONUS_API_KEY": "your_api_key_here"

}

}

]

}

Protegiendo las claves API:

Coloca credenciales sensibles como PATRONUS_API_KEY en el objeto env de tu configuración. Ejemplo:

{

"command": "python",

"args": ["src/patronus_mcp/server.py"],

"env": {

"PATRONUS_API_KEY": "your_api_key_here"

},

"inputs": {}

}

Uso de MCP en FlowHunt

Para integrar servidores MCP en tu flujo de trabajo de FlowHunt, comienza añadiendo el componente MCP a tu flujo y conéctalo a tu agente de IA:

Haz clic en el componente MCP para abrir el panel de configuración. En la sección de configuración del sistema MCP, coloca los datos de tu servidor MCP usando este formato JSON:

{

"patronus-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una vez configurado, el agente de IA podrá utilizar este MCP como herramienta, accediendo a todas sus funciones y capacidades. Recuerda cambiar “patronus-mcp” por el nombre real de tu servidor MCP y reemplazar la URL por la de tu propio servidor MCP.

| Sección | Disponibilidad | Detalles/Notas |

|---|---|---|

| Resumen | ✅ | Descripción clara en README |

| Lista de Prompts | ⛔ | No se encontraron plantillas de prompt |

| Lista de Recursos | ⛔ | No se listan recursos explícitos |

| Lista de Herramientas | ✅ | Encontradas en uso de API y README |

| Protección de claves API | ✅ | Descrito en README e instrucciones de configuración |

| Soporte de Sampling (menos relevante en evaluación) | ⛔ | No se menciona |

Soporte para Roots: No se menciona en la documentación ni en el código.

Según la información anterior, Patronus MCP Server proporciona una base sólida y las funciones esenciales para la evaluación y experimentación con LLM, pero carece de detalles de documentación o implementación para plantillas de prompt, recursos y características avanzadas de MCP como Roots y Sampling.

El Servidor Patronus MCP ofrece herramientas de evaluación robustas e instrucciones de configuración claras, pero carece de prompts estandarizados, definiciones de recursos y algunas funciones avanzadas de MCP. Es más adecuado para usuarios técnicos enfocados en la evaluación y experimentación con LLM. Puntuación: 6/10

| ¿Tiene LICENCIA? | ✅ (Apache-2.0) |

|---|---|

| ¿Tiene al menos una herramienta? | ✅ |

| Número de Forks | 3 |

| Número de Stars | 13 |

Patronus MCP Server es un servidor estandarizado para el SDK Patronus, enfocado en la optimización, evaluación y experimentación de sistemas LLM. Automatiza evaluaciones LLM, soporta procesamiento por lotes y proporciona una interfaz robusta para flujos de trabajo de desarrollo de IA.

Incluye herramientas para inicializar la configuración de proyectos, ejecutar evaluaciones individuales y por lotes, y realizar experimentos con conjuntos de datos y evaluadores personalizados.

Guarda tus claves API en el objeto `env` de tu archivo de configuración. Evita codificar información sensible directamente en los repositorios de código.

Sí, puedes integrar Patronus MCP Server como un componente MCP dentro de FlowHunt, conectándolo a tu agente de IA para evaluaciones y experimentación avanzadas.

Evaluación automatizada de LLM, experimentos de benchmarking personalizados, inicialización de proyectos para equipos y pruebas en vivo interactivas de los endpoints de evaluación.

Integra Patronus MCP Server en tu flujo de trabajo de FlowHunt para evaluaciones de modelos de IA automáticas, robustas y escalables, así como experimentación.

El Servidor ModelContextProtocol (MCP) actúa como un puente entre agentes de IA y fuentes de datos externas, APIs y servicios, permitiendo a los usuarios de Flo...

El Servidor MCP de lingo.dev conecta asistentes de IA con fuentes de datos externas, APIs y servicios, permitiendo el acceso estructurado a recursos, plantillas...

El Servidor Milvus MCP conecta asistentes de IA y aplicaciones potenciadas por LLM con la base de datos vectorial Milvus, permitiendo búsquedas vectoriales avan...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.