LLM OpenAI

Le composant LLM OpenAI dans FlowHunt connecte les modèles ChatGPT à vos flux, permettant de contrôler le choix du modèle et les paramètres de sortie pour des applications de chatbot IA polyvalentes.

Description du composant

Comment fonctionne le composant LLM OpenAI

What is the LLM Open AI component?

The LLM OpenAI component connects ChatGPT models to your flow. While the Generators and Agents are where the actual magic happens, LLM components allow you to control the model used. All components come with ChatGPT-4 by default. You can connect this component if you wish to change the model or gain more control over it.

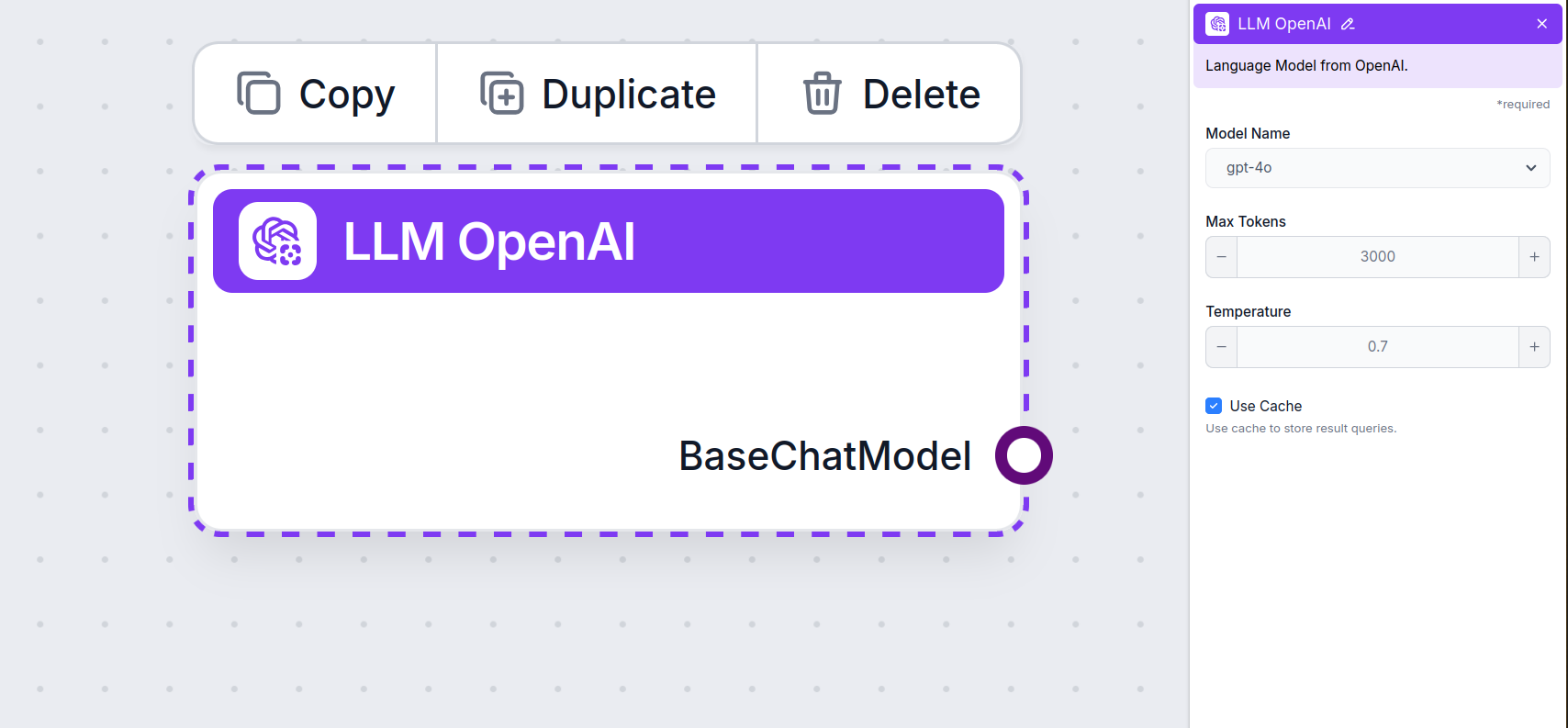

LLM OpenAI Component Settings

Model Name

This is the model picker. Here, you’ll find all OpenAI models FlowHunt supports. ChatGPT offers a full list of differently capable and differently priced models. For example, using the less advanced and older GPT-3.5 will cost less than using the newest 4o, but the quality and speed of the output will suffer.

OpenAI models available in FlowHunt:

- GPT-4o – OpenAI’s latest and most popular model. A multimodal model capable of processing text, images, and audio and searching the web. Learn more here.

- GPT-4o Mini – A smaller, cost-effective version of GPT-4o, delivering enhanced performance over GPT-3.5 Turbo, with a 128K context window and over 60% cost reduction. See how it handles tasks.

- o1 Mini – A streamlined version of the o1 model, designed for complex reasoning tasks, offering a balance between performance and efficiency. See how it fared in our testing.

- o1 Preview – An advanced model with enhanced reasoning capabilities, excelling in complex problem-solving, particularly in coding and scientific reasoning, available in preview form. See how it thinks and handles tasks.

- gpt-4-vision-preview – Preview model that accepts both text and image inputs, supporting features like JSON mode and parallel function calling, enhancing multimodal interaction capabilities. Find out more here.

- GPT-3.5 Turbo – A legacy version of GPT, great for simple tasks while not breaking the bank. See our AI Agent testing to compare it against newer models.

When choosing the right model for the task, consider the quality and speed the task requires. Older models are great for saving money on simple bulk tasks and chatting. If you’re generating content or searching the web, we suggest you opt for a newer, more refined model.

Max Tokens

Tokens represent the individual units of text the model processes and generates. Token usage varies with models, and a single token can be anything from words or subwords to a single character. Models are usually priced in millions of tokens.

The max tokens setting limits the total number of tokens that can be processed in a single interaction or request, ensuring the responses are generated within reasonable bounds. The default limit is 4,000 tokens, which is the optimal size for summarizing documents and several sources to generate an answer.

Temperature

Temperature controls the variability of answers, ranging from 0 to 1.

A temperature of 0.1 will make the responses very to the point but potentially repetitive and deficient.

A high temperature of 1 allows for maximum creativity in answers but creates the risk of irrelevant or even hallucinatory responses.

For example, the recommended temperature for a customer service bot is between 0.2 and 0.5. This level should keep the answers relevant and to the script while allowing for a natural level of variation in responses.

How To Add The LLM OpenAI To Your Flow

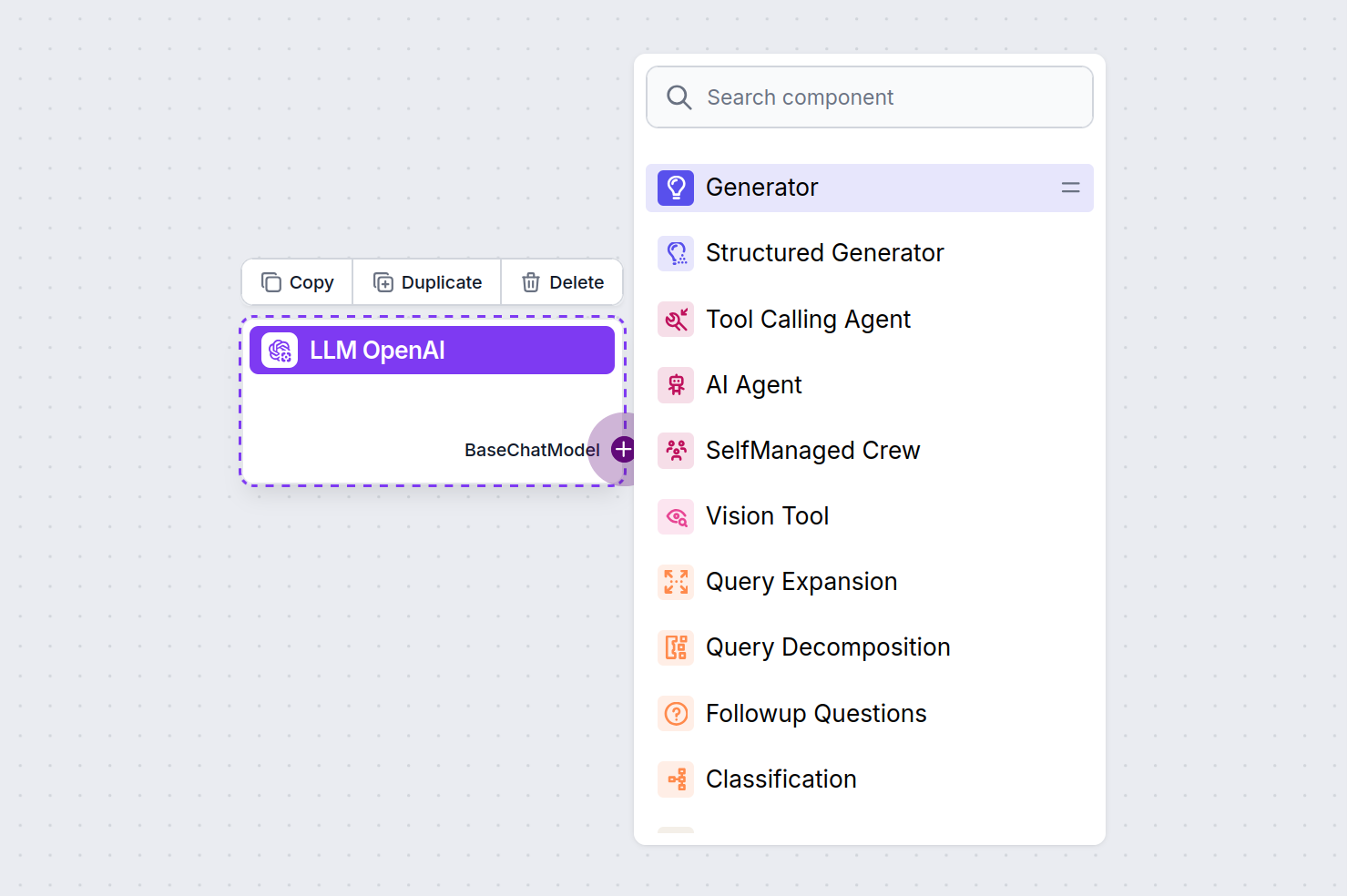

You’ll notice that all LLM components only have an output handle. Input doesn’t pass through the component, as it only represents the model, while the actual generation happens in AI Agents and Generators.

The LLM handle is always purple. The LLM input handle is found on any component that uses AI to generate text or process data. You can see the options by clicking the handle:

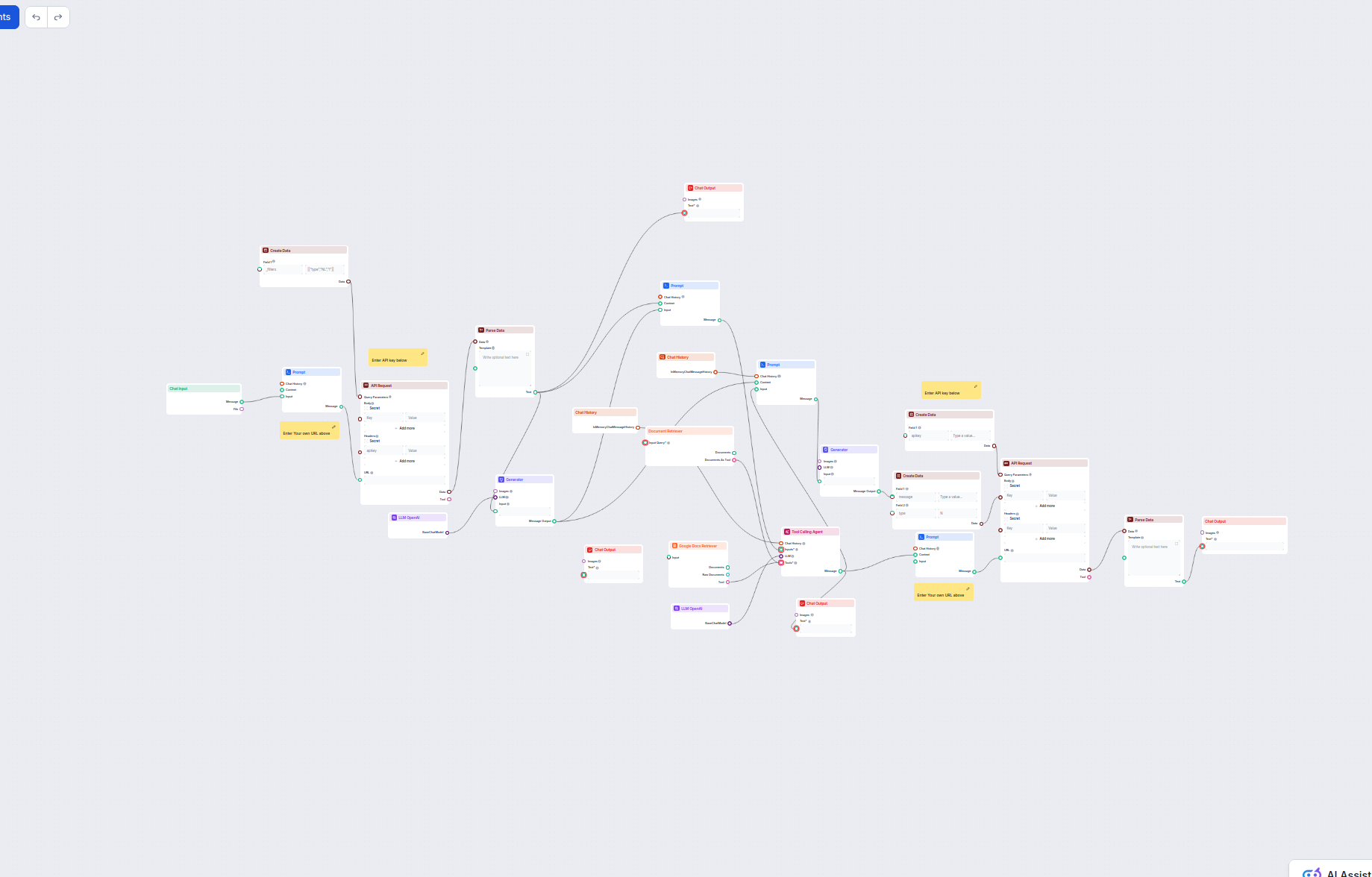

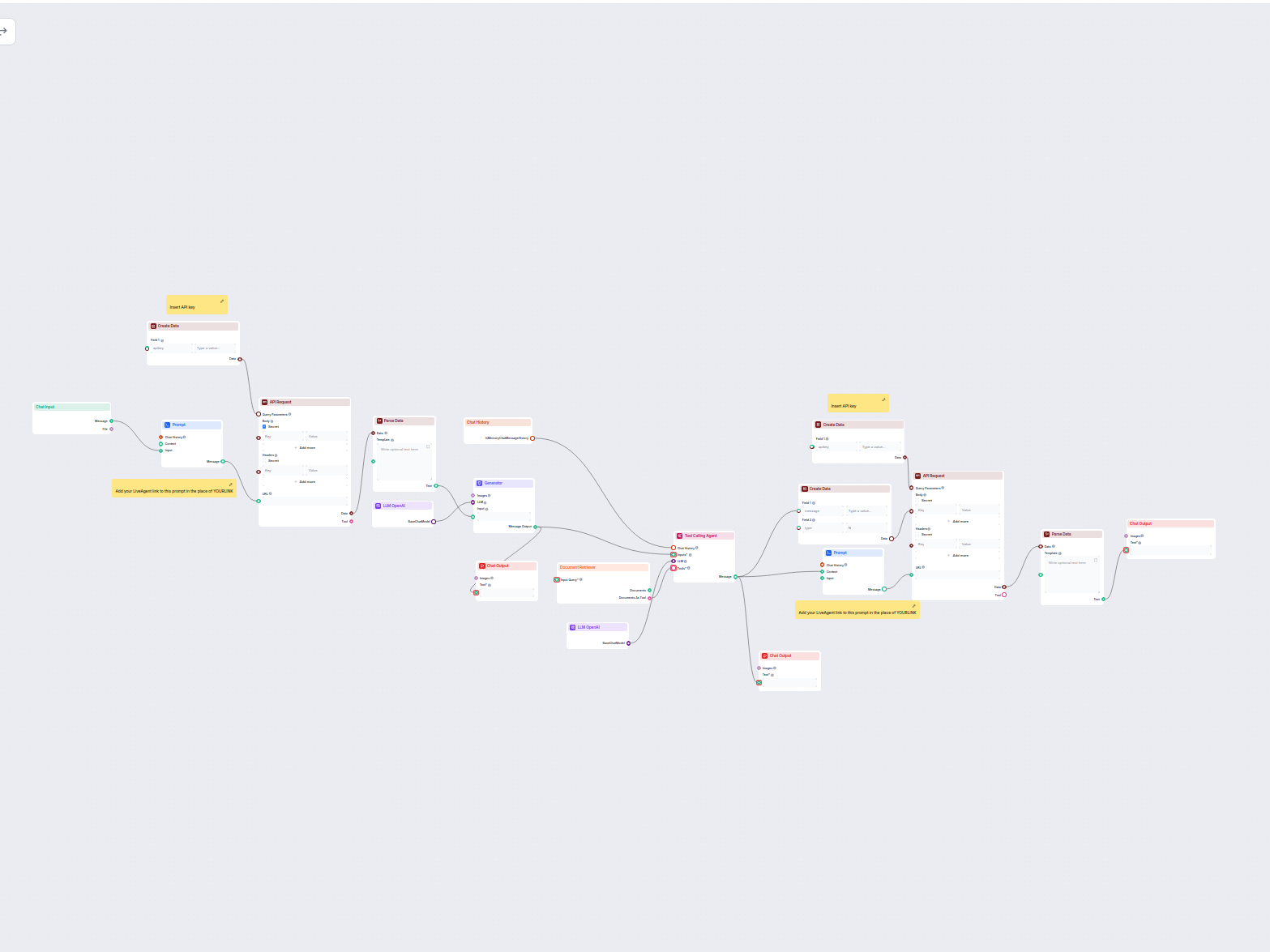

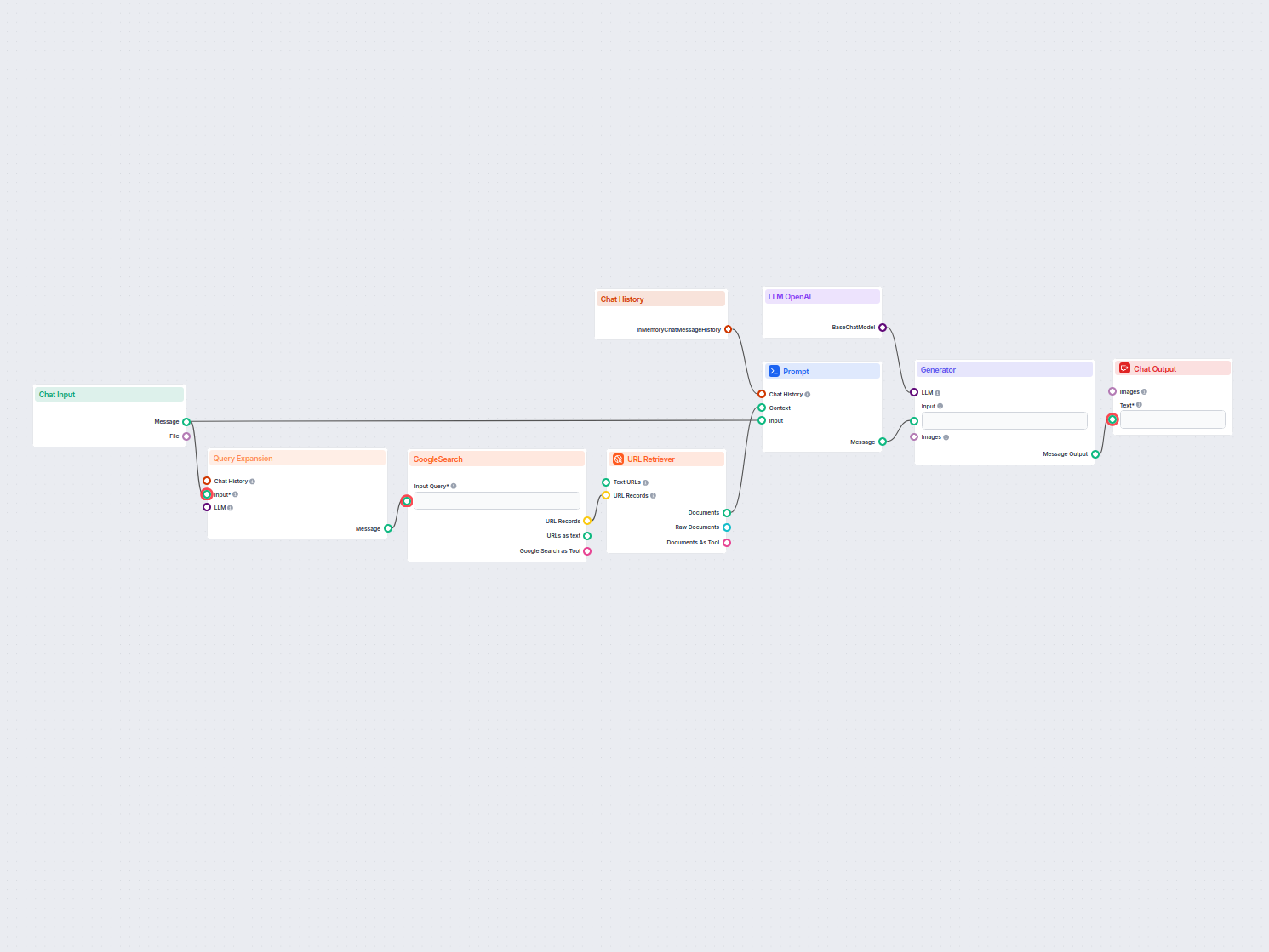

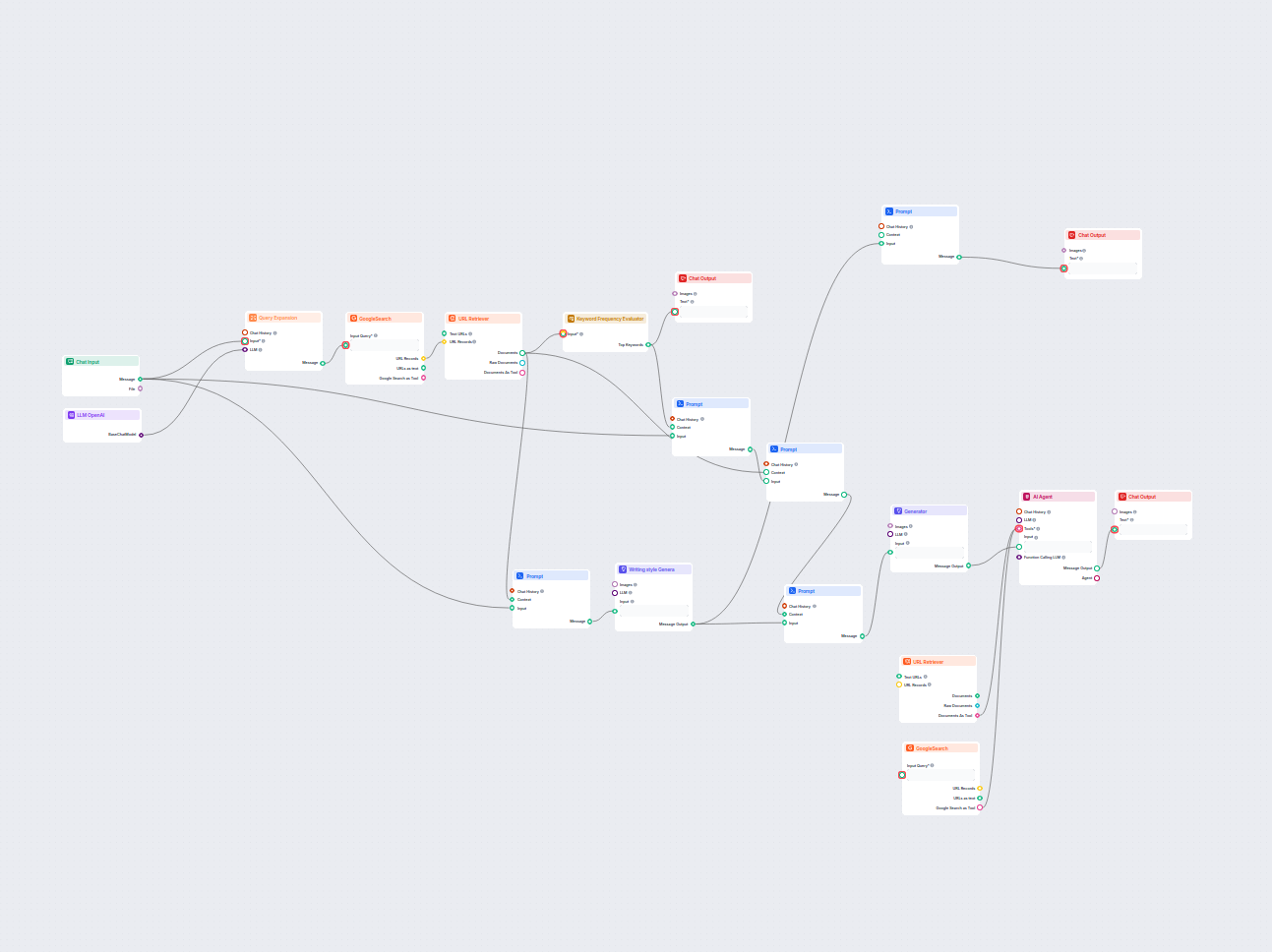

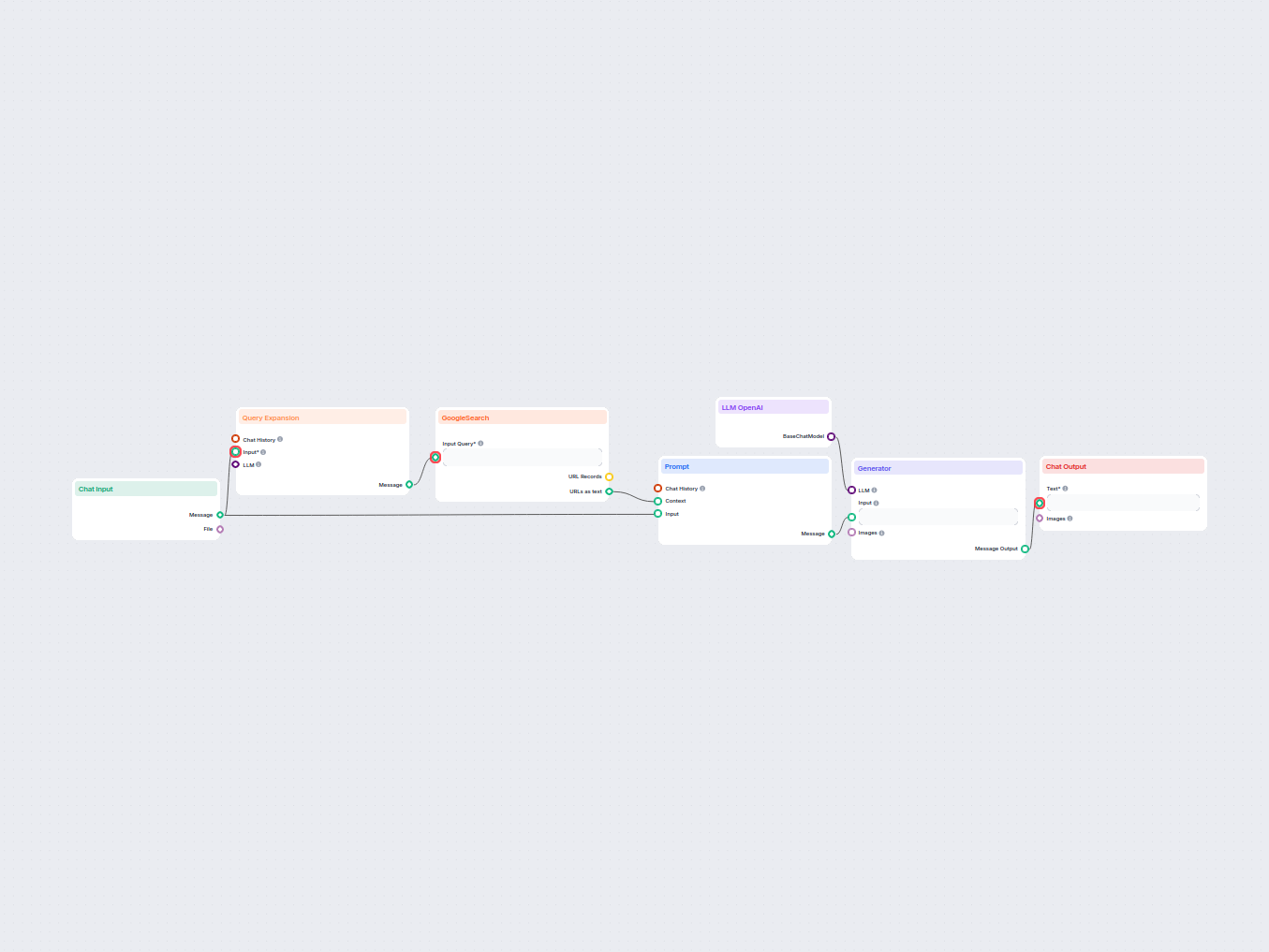

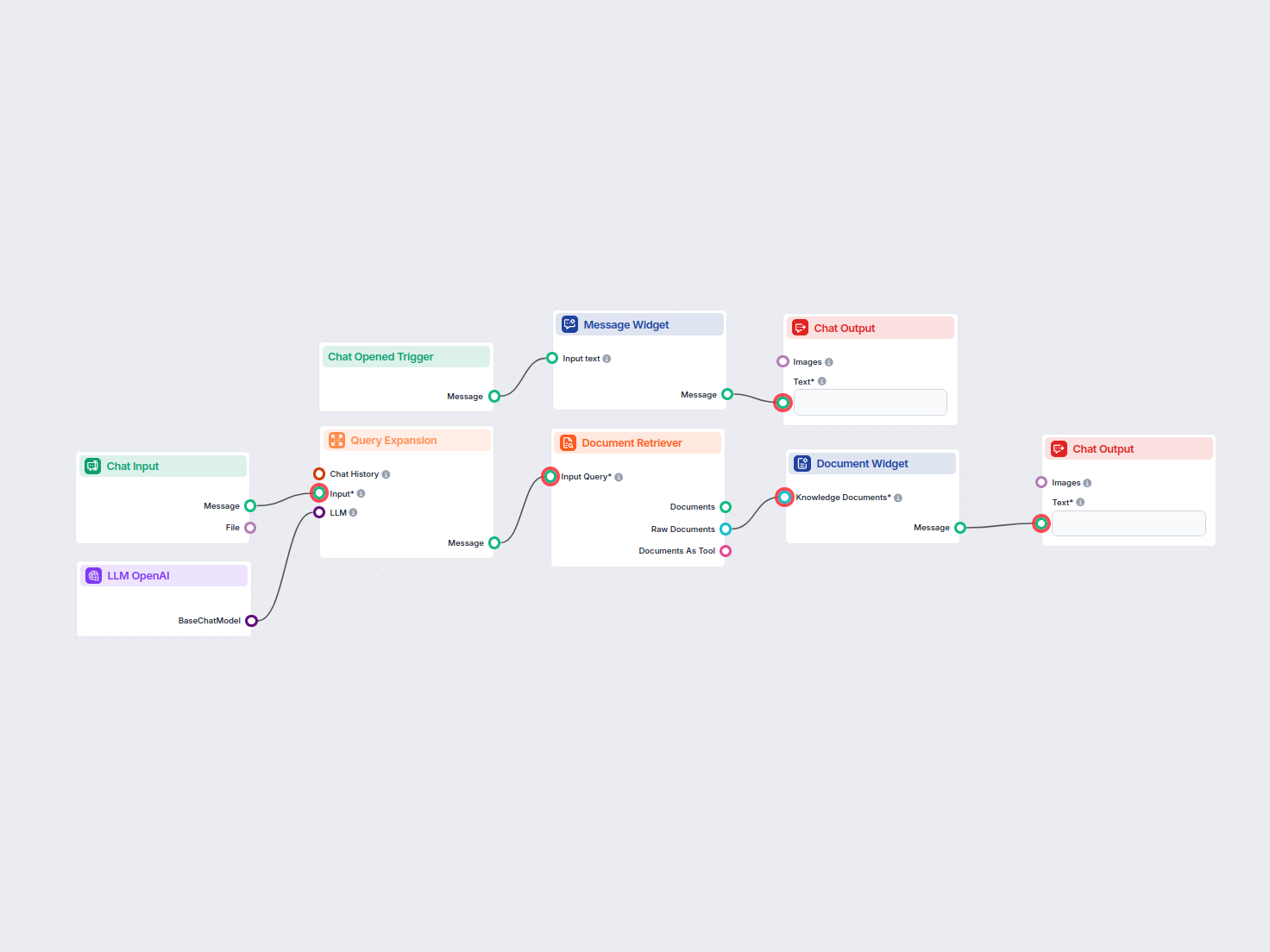

This allows you to create all sorts of tools. Let’s see the component in action. Here’s a simple Agent-powered chatbot Flow using o1 Preview to generate responses. You can think of it as a basic ChatGPT chatbot.

This simple Chatbot Flow includes:

- Chat input: Represents the message a user sends in chat.

- Chat history: Ensures the chatbot can remember and factor in past responses.

- Chat output: Represent the chatbot’s final response.

- AI Agent: An autonomous AI agent that generates responses.

- LLM OpenAI: The connection to OpenAI’s text generation models.

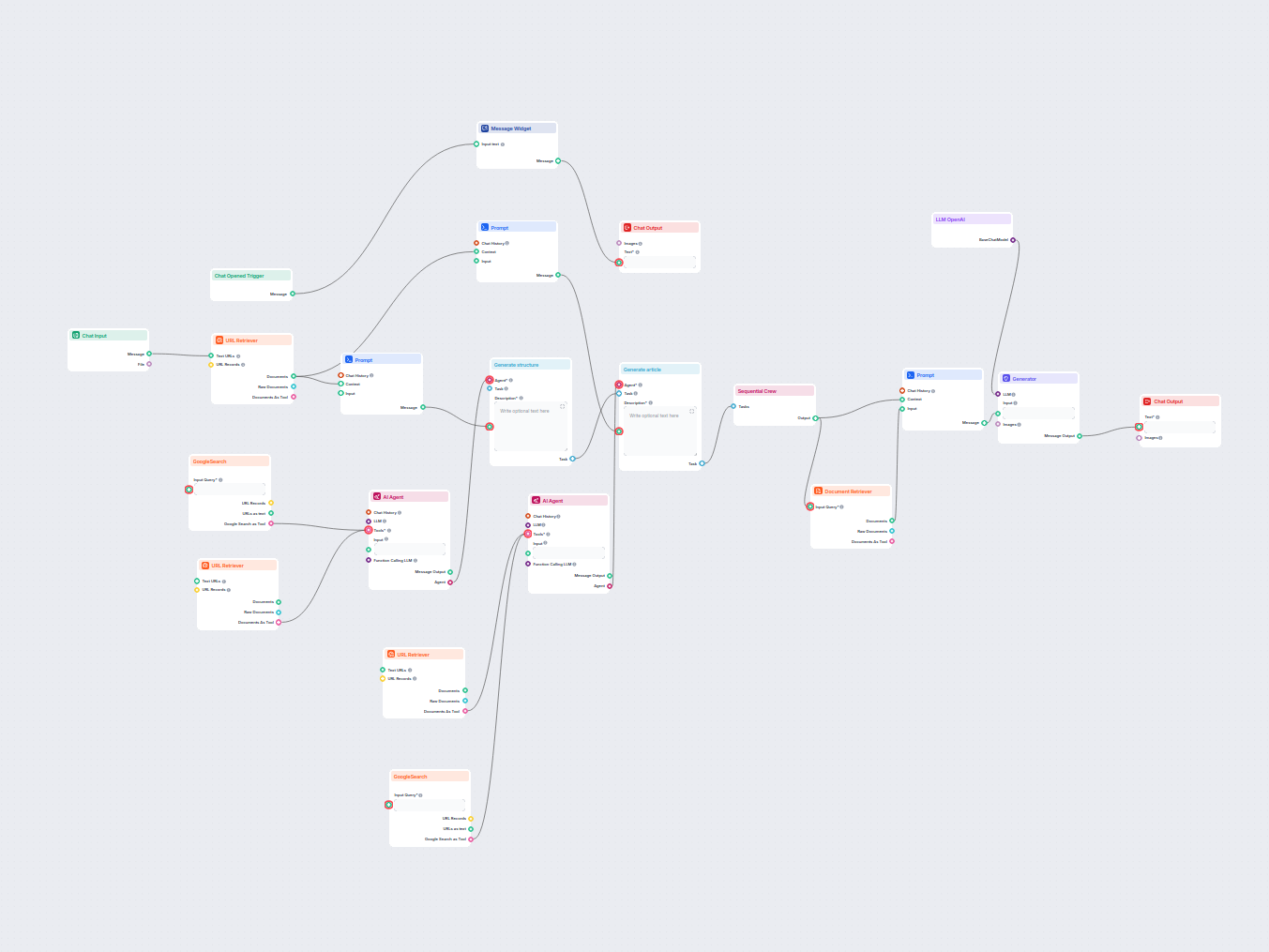

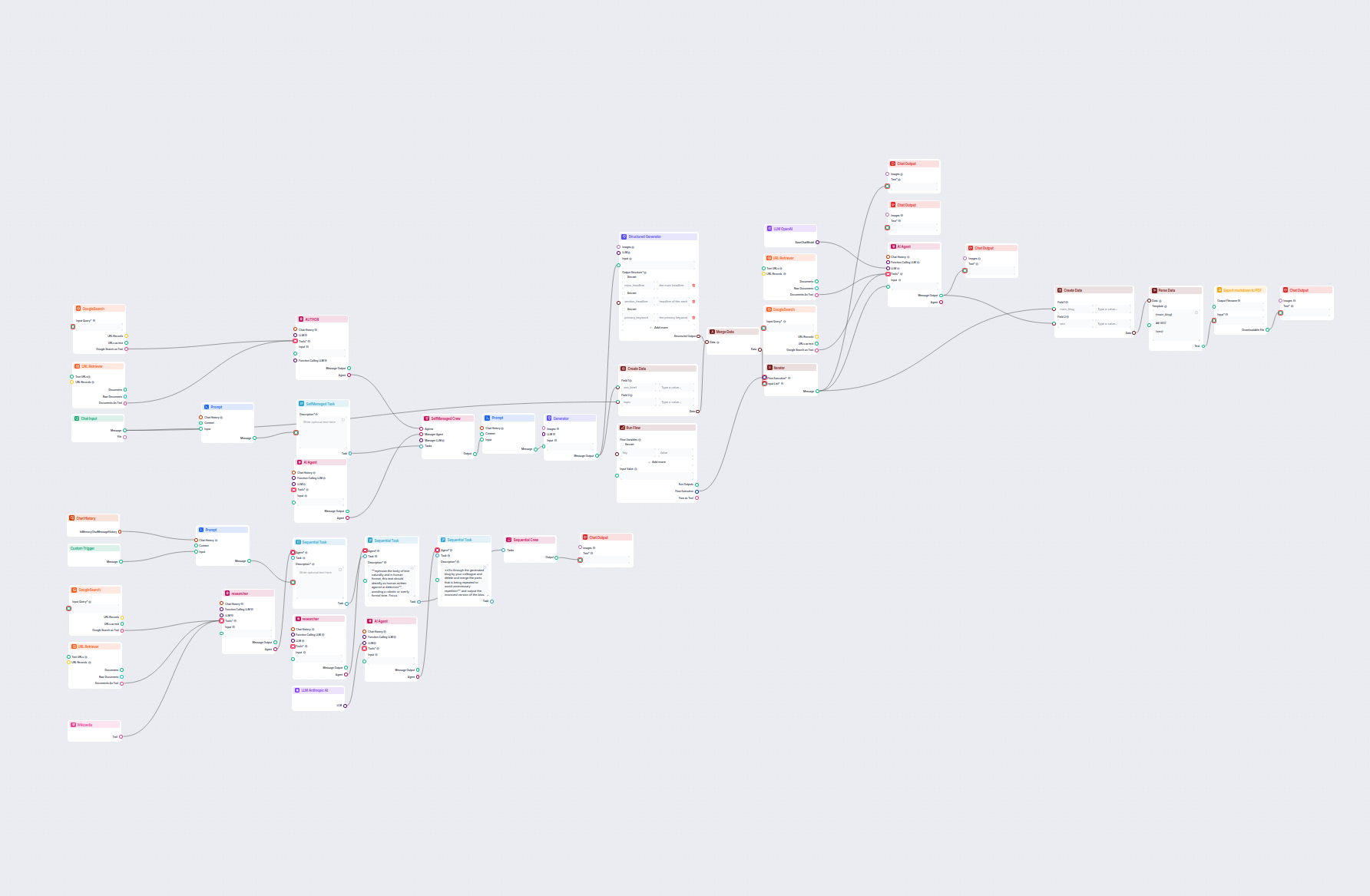

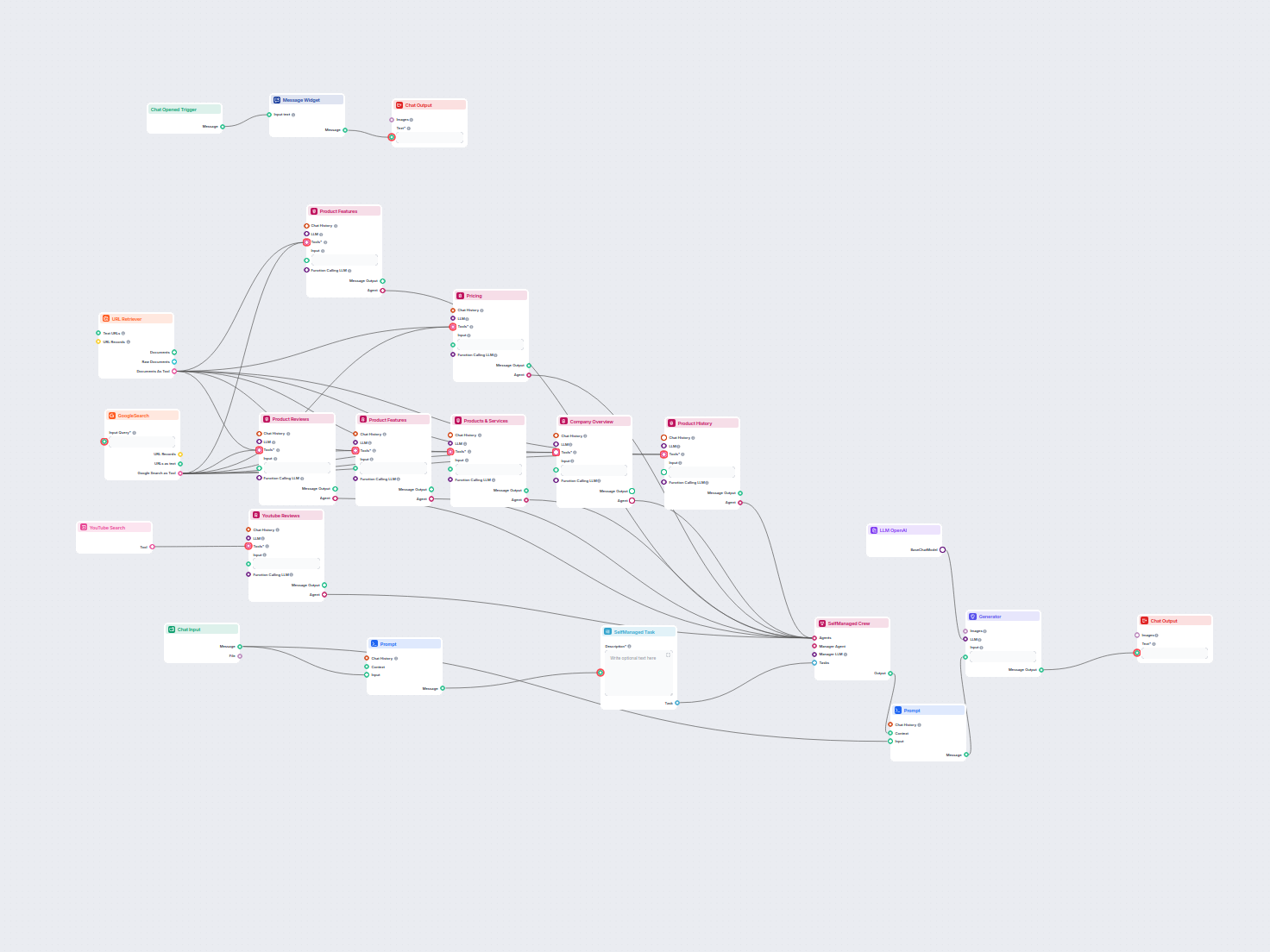

Exemples de modèles de flux utilisant le composant LLM OpenAI

Pour vous aider à démarrer rapidement, nous avons préparé plusieurs exemples de modèles de flux qui démontrent comment utiliser efficacement le composant LLM OpenAI. Ces modèles présentent différents cas d'utilisation et meilleures pratiques, facilitant votre compréhension et l'implémentation du composant dans vos propres projets.

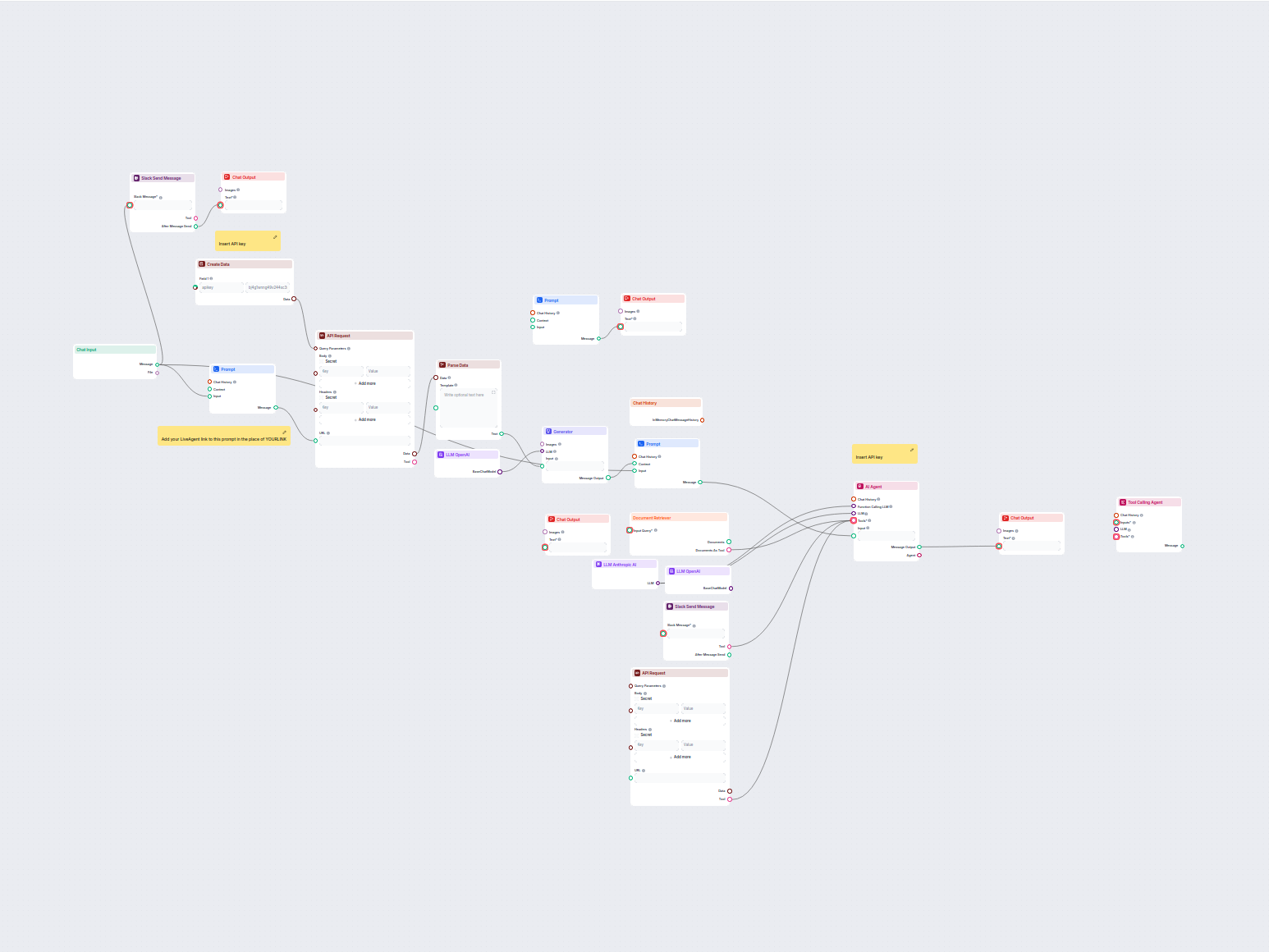

Agent de support client IA avec intégration API LiveAgent

Ce workflow alimenté par l’IA automatise le support client en connectant les demandes des utilisateurs aux sources de connaissances de l'entreprise, à des API e...

Agent de support client IA pour LiveAgent

Ce flux de travail automatise le support client pour votre entreprise en intégrant les conversations LiveAgent, en extrayant les données pertinentes des convers...

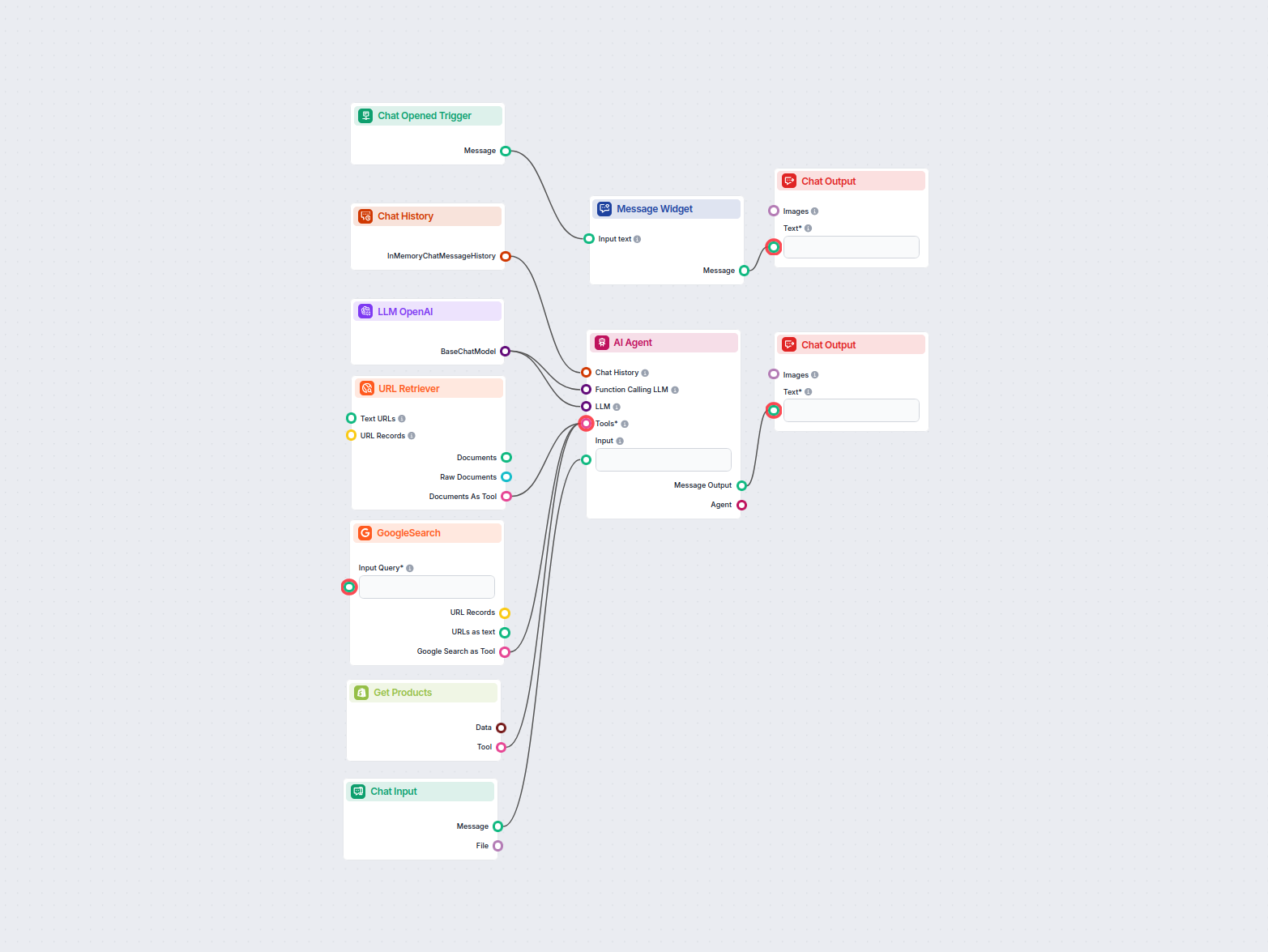

Agent IA de recherche de tarification de produits Shopify

Ce workflow alimenté par l'IA aide les commerçants Shopify à analyser les produits concurrents, rechercher les tendances du marché et générer des stratégies de ...

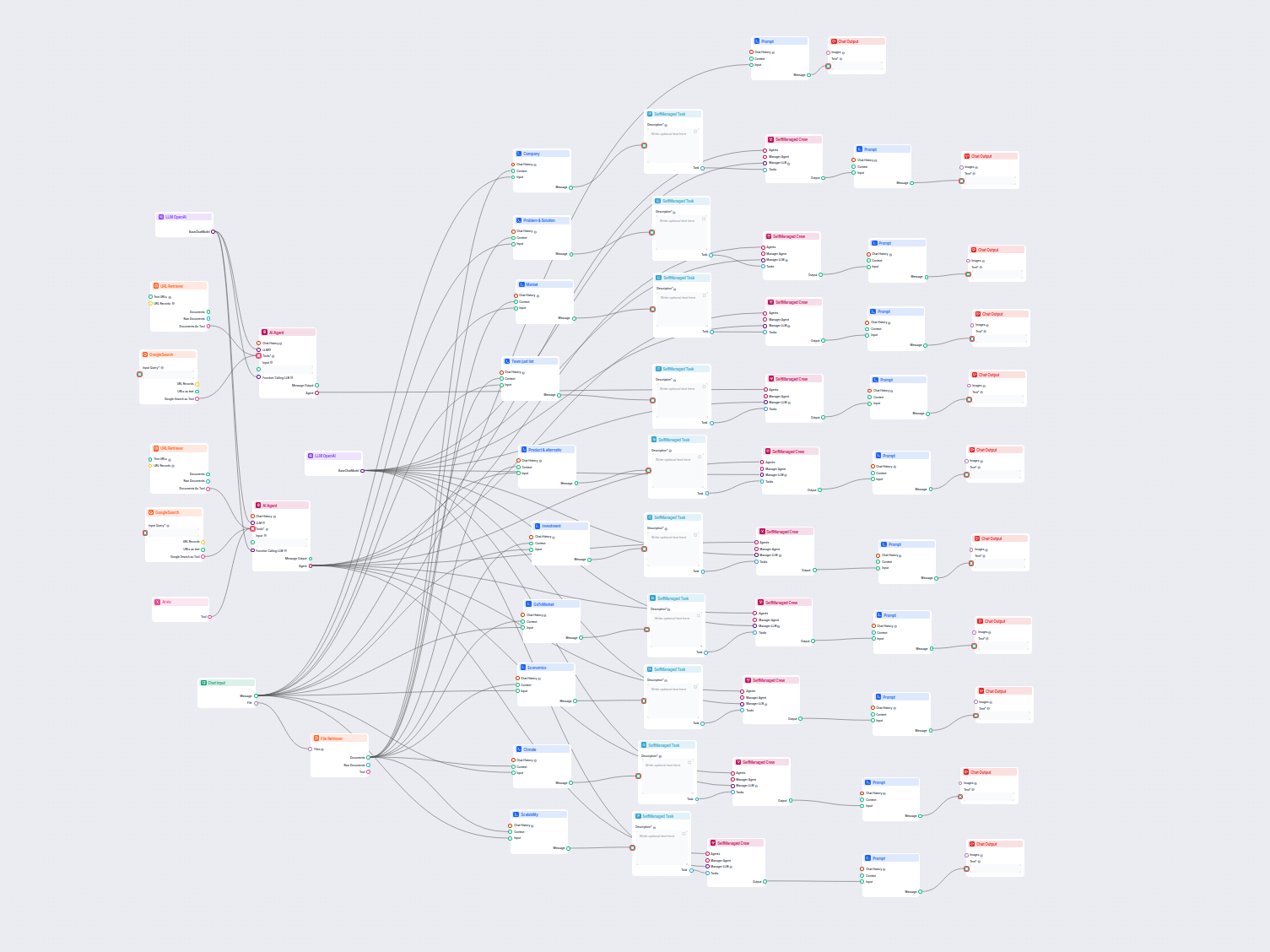

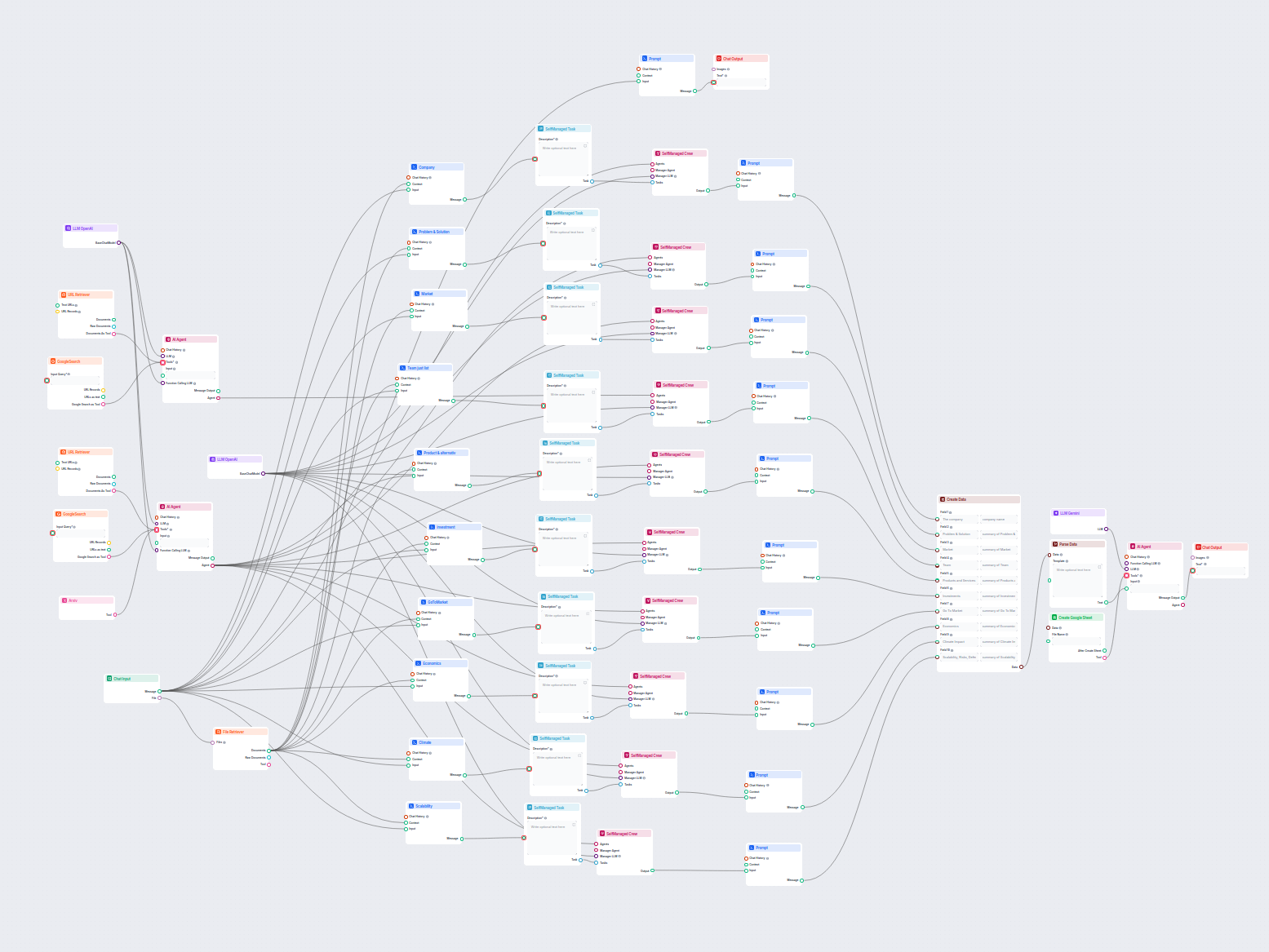

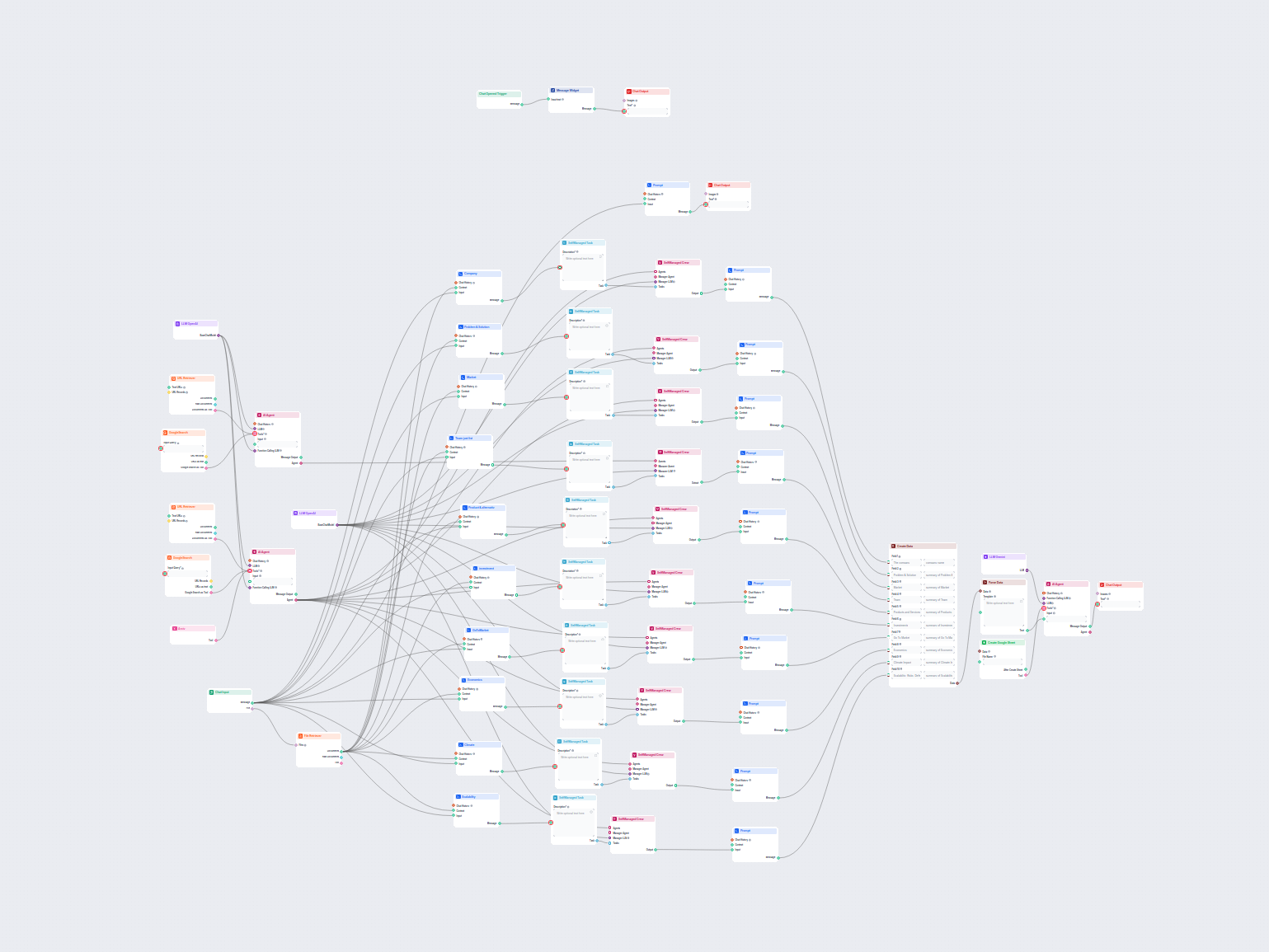

Analyse d'entreprise IA & Étude de Marché

Flux de travail complet piloté par l'IA pour l'analyse d'entreprise et l'étude de marché. Rassemble et analyse automatiquement des données sur l'historique de l...

Analyse d'entreprise par IA exportée vers Google Sheets

Ce workflow alimenté par l'IA fournit une analyse d'entreprise complète et fondée sur les données. Il rassemble des informations sur l'historique de l'entrepris...

Analyse d’entreprise alimentée par l’IA et export Google Sheets

Ce flux de travail IA analyse en profondeur toute entreprise en recherchant des données et documents publics, couvrant marché, équipe, produits, investissements...

Analyseur d'écart de contenu SEO

Ce flux de travail alimenté par l'IA analyse la structure de contenu de votre page web, la compare avec les pages concurrentes les mieux classées et fournit des...

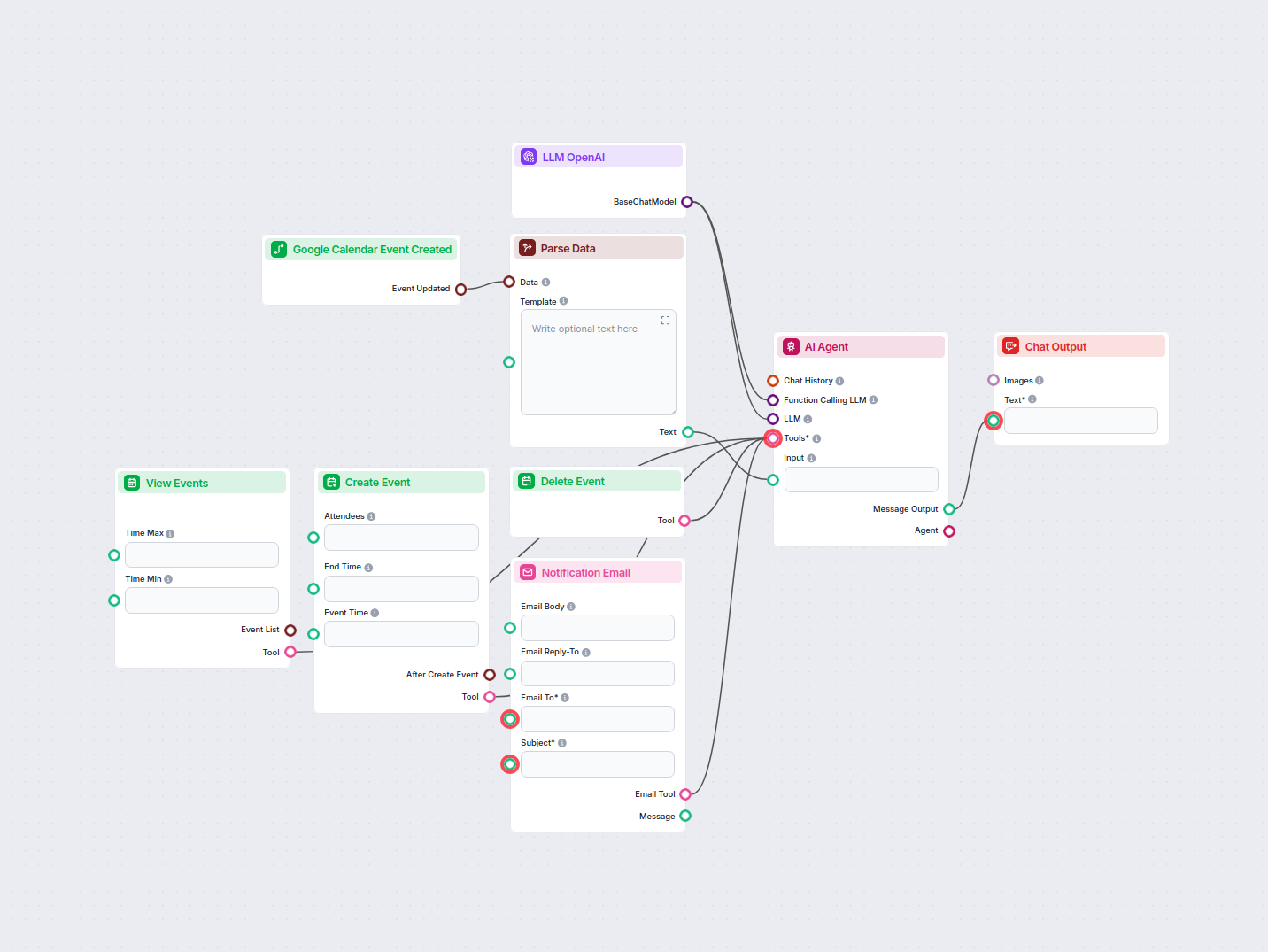

Automatisation de l'approbation des demandes de congé par l'IA

Automatisez et simplifiez l'approbation des demandes de congé dans Google Agenda à l'aide d'un agent IA. Ce workflow détecte les nouvelles demandes de congé, le...

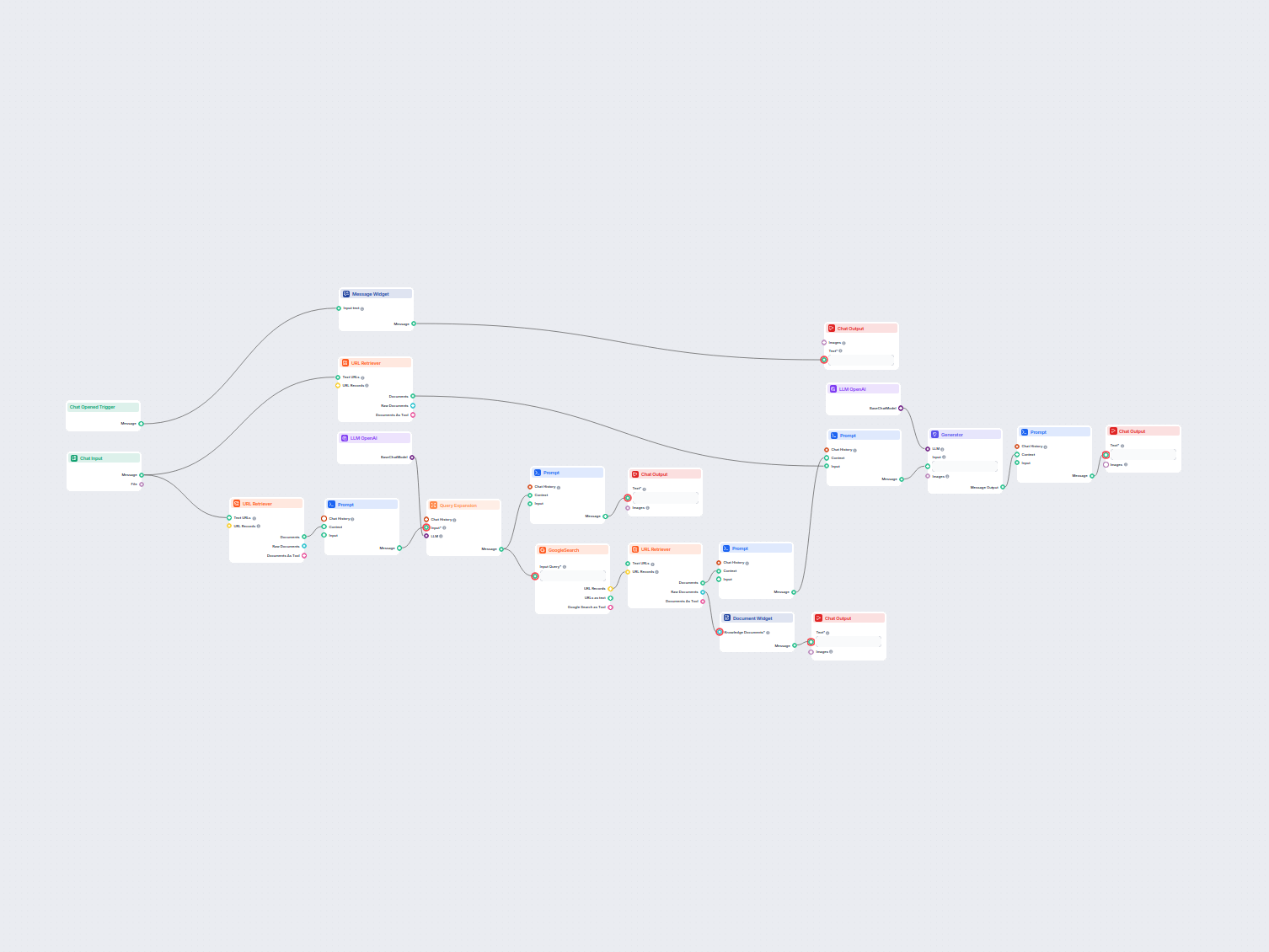

Chatbot RAG en temps réel spécifique à un domaine

Un chatbot en temps réel qui utilise la recherche Google restreinte à votre propre domaine, récupère le contenu web pertinent et exploite OpenAI LLM pour répond...

Convertir la documentation technique en article SEO

Transformez la documentation technique d'une URL en un article captivant et optimisé SEO pour votre site web. Ce flux analyse le contenu des concurrents les mie...

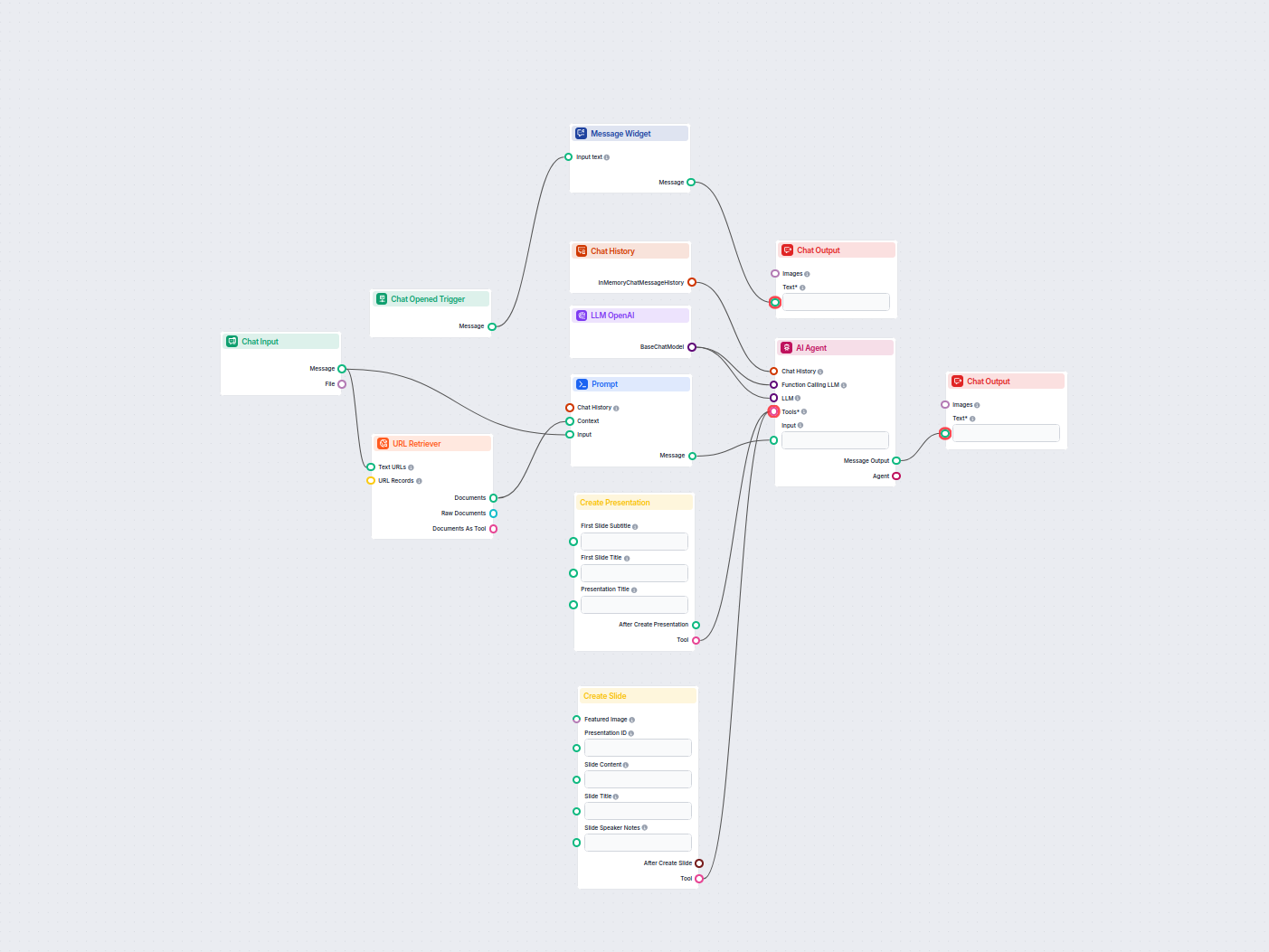

Créateur de Pitch Deck IA pour Google Slides

Générez automatiquement des pitch decks professionnels dans Google Slides grâce à l'IA et à la recherche web en direct. Ce workflow recueille les informations d...

Générateur Avancé d’Articles de Blog par IA

Générez des articles de blog complets, optimisés pour le SEO, avec une structure avancée et un nombre de mots élevé grâce à plusieurs agents IA. Le workflow inc...

Générateur d'Analyse de Produit par IA

Générez des analyses complètes de produits à l'aide d'agents IA qui collectent et résument des informations sur les produits, les prix, les fonctionnalités, les...

Générateur d'articles de glossaire IA

Générez des articles de glossaire approfondis et optimisés pour le SEO grâce à l’IA et à la recherche web en temps réel. Ce flux analyse les contenus les mieux ...

Générateur d'articles de revue de logiciels par IA

Générez des articles de revue de produits logiciels complets et optimisés SEO, incluant des descriptions détaillées des fonctionnalités, tarifs, avis d'utilisat...

Générateur de cas d'utilisation produit IA

Générez des rapports complets et pilotés par l’IA sur les cas d’utilisation d’un produit logiciel pour le marketing et la vente. Ce workflow recherche le produi...

Générateur de présentation Google Slides à partir d'une vidéo YouTube

Transformez n'importe quelle vidéo YouTube en une présentation Google Slides professionnelle en quelques minutes. Ce workflow alimenté par l'IA extrait le conte...

Générateur de titres de page IA

Générez des titres de page web uniques et optimisés pour le SEO grâce à l'IA et aux données de recherche Google en direct. Saisissez vos mots-clés cibles et rec...

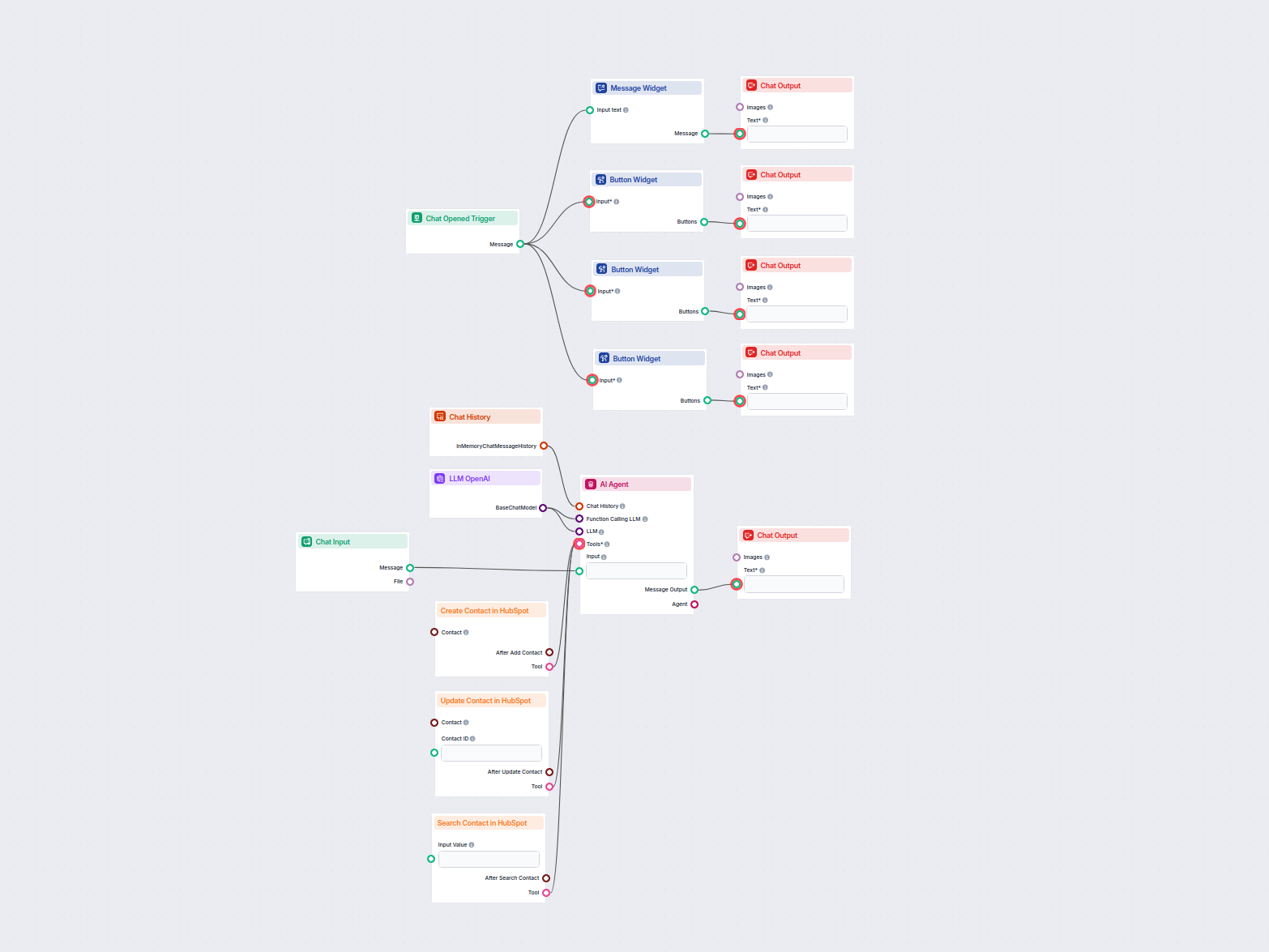

Gestionnaire de contacts HubSpot IA

Ce workflow alimenté par l’IA automatise la gestion des contacts dans HubSpot CRM. Les utilisateurs peuvent facilement rechercher, créer ou mettre à jour des co...

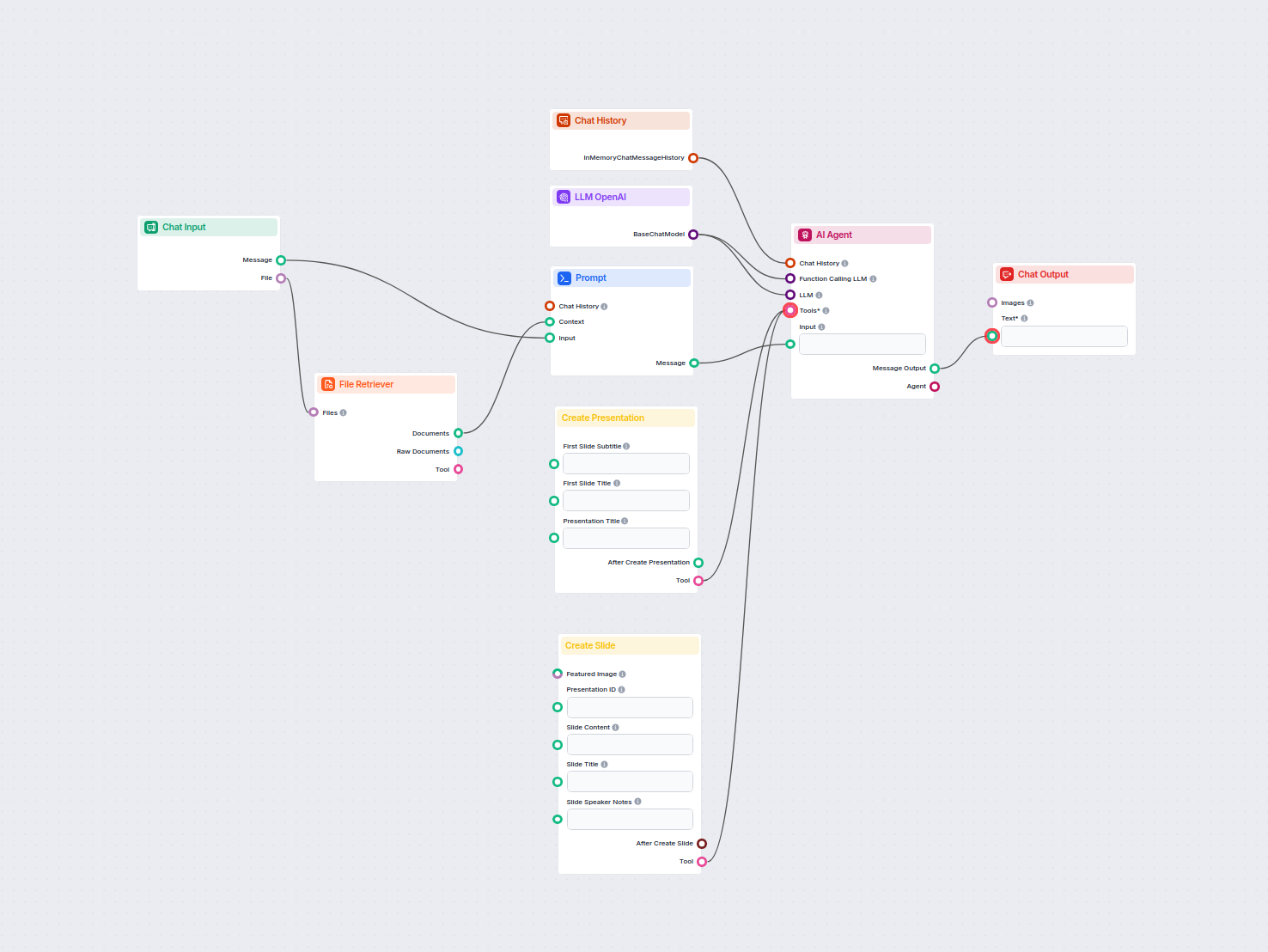

Google Slides générées par IA à partir de documents téléchargés

Automatisez la création de présentations Google Slides professionnelles à partir de n'importe quel document téléchargé grâce à l'IA. Ce workflow extrait le cont...

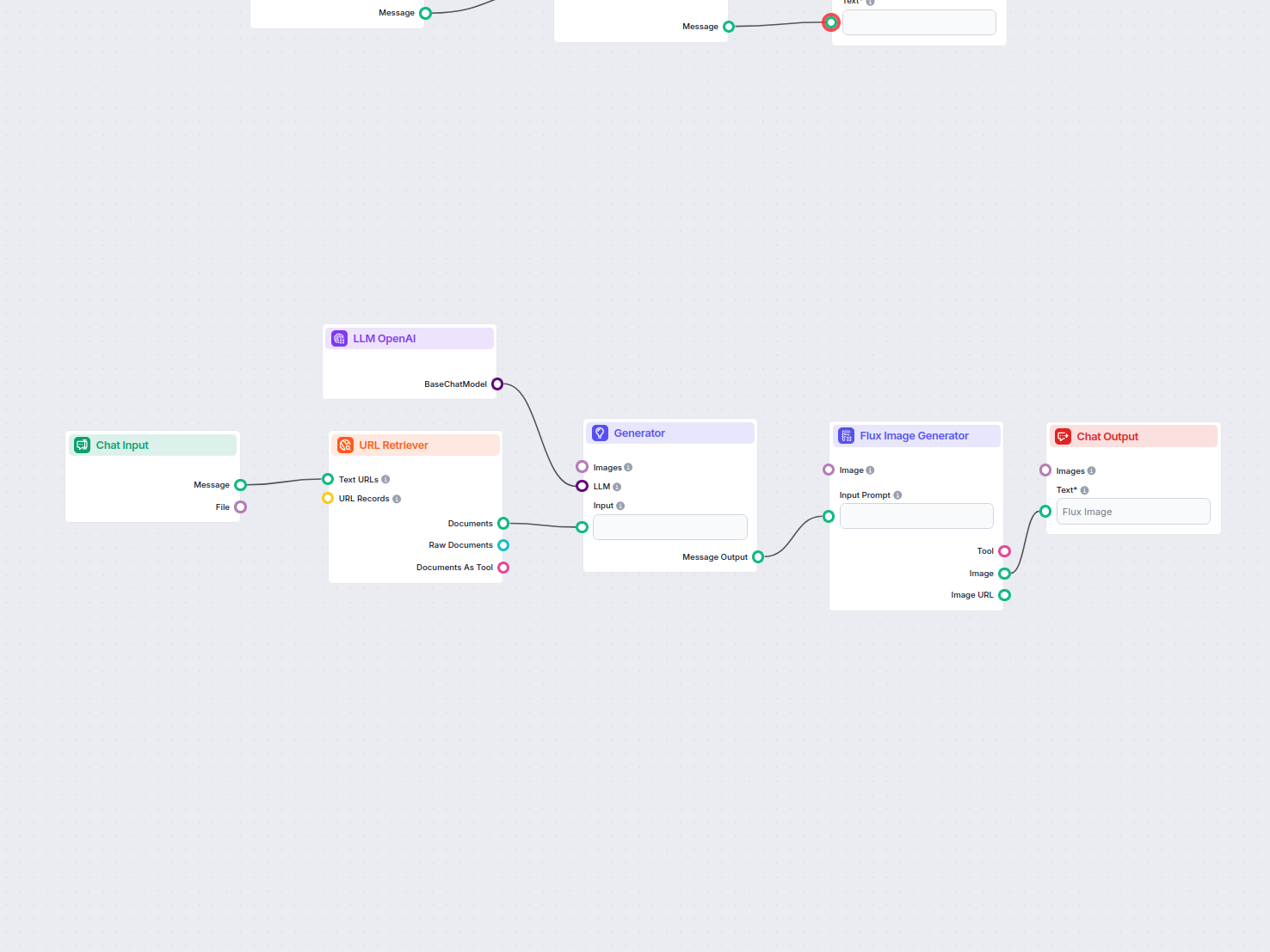

Image principale de blog à partir d'une URL

Génère automatiquement une image principale attrayante pour tout article de blog en analysant son contenu. Il suffit de fournir l’URL du blog, et le workflow ut...

Recherche sémantique dans la base de connaissances

Recherchez et récupérez facilement des informations dans des documents de base de connaissances privés grâce à la recherche sémantique alimentée par l'IA. Le fl...

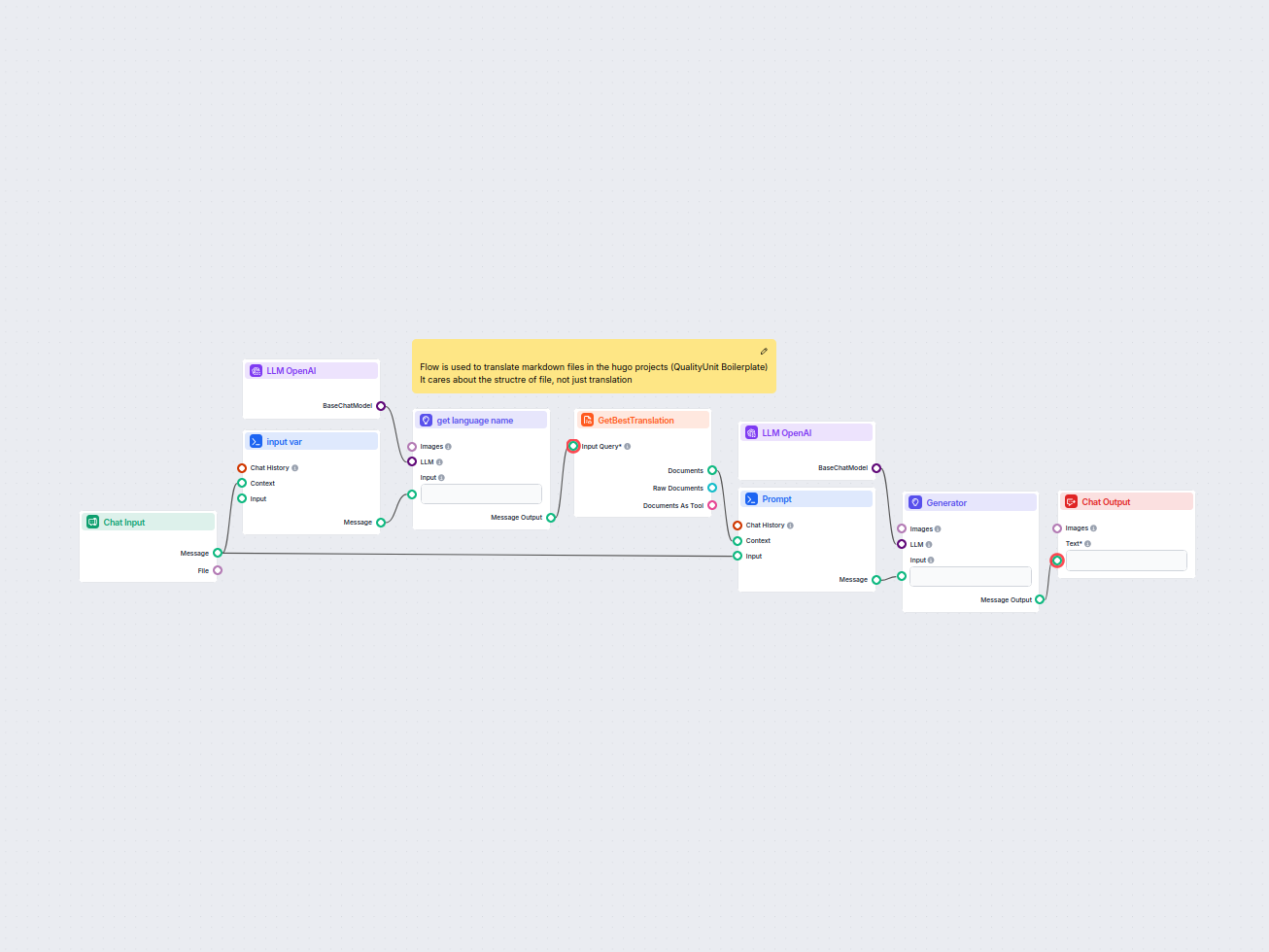

Traducteur de fichiers Markdown HUGO

Ce workflow rationalise la traduction des fichiers markdown HUGO dans les langues cibles tout en préservant la structure du fichier et sa mise en forme. Grâce à...

Questions fréquemment posées

- Qu’est-ce qu’un LLM ?

Les grands modèles de langage sont des types d’IA entraînés à traiter, comprendre et générer du texte de manière humaine. Un exemple courant est ChatGPT, qui peut fournir des réponses élaborées à presque toutes les questions.

- Puis-je connecter un LLM directement à la sortie du chat ?

Non, le composant LLM est uniquement une représentation du modèle d’IA. Il change le modèle que le Générateur utilisera. Le LLM par défaut dans le Générateur est ChatGPT-4o.

- Quels LLM sont disponibles dans Flows ?

Pour l’instant, seul le composant OpenAI est disponible. Nous prévoyons d’en ajouter d’autres à l’avenir.

- Dois-je ajouter un LLM à mon flux ?

Non, les Flows sont une fonctionnalité polyvalente avec de nombreux cas d’utilisation sans nécessiter de LLM. Vous ajoutez un LLM si vous souhaitez construire un chatbot conversationnel qui génère librement des réponses textuelles.

- Le composant LLM OpenAI génère-t-il la réponse ?

Pas vraiment. Le composant ne fait que représenter le modèle et crée des règles à suivre. C’est le composant générateur qui le connecte à l’entrée et exécute la requête via le LLM pour créer la sortie.

Prêt à créer votre propre IA ?

Chatbots intelligents et outils IA sous un même toit. Connectez des blocs intuitifs pour transformer vos idées en Flows automatisés.

En savoir plus

LLM Anthropic AI

FlowHunt prend en charge des dizaines de modèles d'IA, y compris les modèles Claude d'Anthropic. Découvrez comment utiliser Claude dans vos outils et chatbots I...

LLM Meta AI

FlowHunt prend en charge des dizaines de modèles de génération de texte, y compris les modèles Llama de Meta. Découvrez comment intégrer Llama dans vos outils e...

LLM xAI

FlowHunt prend en charge des dizaines de modèles de génération de texte, y compris ceux de xAI. Voici comment utiliser les modèles xAI dans vos outils et chatbo...