Intégration du serveur ModelContextProtocol (MCP)

Le serveur ModelContextProtocol (MCP) agit comme un pont entre les agents IA et les sources de données externes, API et services, permettant aux utilisateurs de...

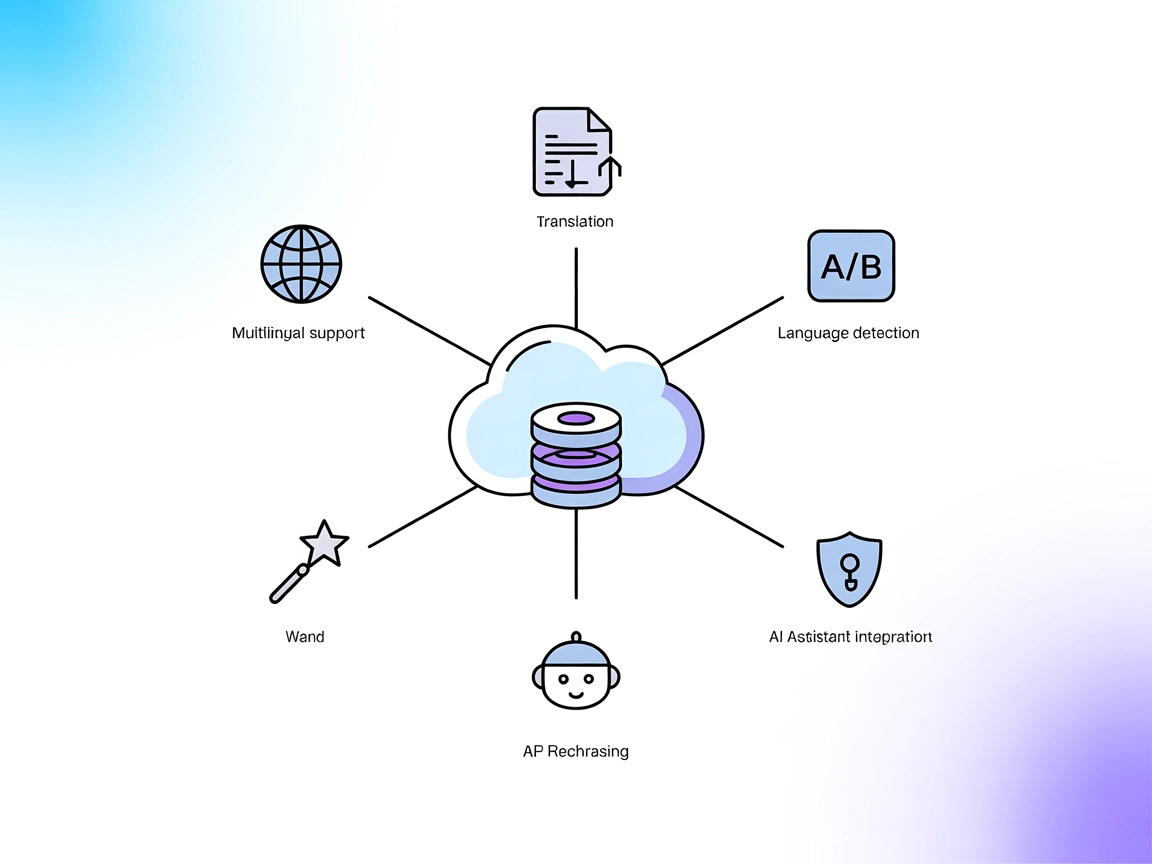

Permettez à vos assistants IA de traduire, reformuler et détecter les langues en temps réel à l’aide de l’API DeepL, le tout via une simple intégration de serveur MCP.

FlowHunt fournit une couche de sécurité supplémentaire entre vos systèmes internes et les outils d'IA, vous donnant un contrôle granulaire sur les outils accessibles depuis vos serveurs MCP. Les serveurs MCP hébergés dans notre infrastructure peuvent être intégrés de manière transparente avec le chatbot de FlowHunt ainsi qu'avec les plateformes d'IA populaires comme ChatGPT, Claude et divers éditeurs d'IA.

Le serveur DeepL MCP est un serveur Model Context Protocol (MCP) qui fournit aux assistants IA des capacités de traduction avancées en intégrant l’API DeepL. Il sert d’outil intermédiaire, permettant aux clients IA d’effectuer des traductions de texte en temps réel, de la reformulation et de la détection de langue via des interfaces MCP standardisées. Ce serveur prend en charge les flux de développement nécessitant le multilinguisme, l’identification automatique de la langue et les ajustements de ton formel/informel. En connectant les assistants IA à l’API DeepL, le serveur DeepL MCP permet des tâches telles que traduire et reformuler du contenu, détecter la langue dans les saisies utilisateurs et prendre en charge un large éventail de langues—améliorant ainsi la flexibilité et l’intelligence des applications propulsées par l’IA.

Aucun modèle de prompt n’est explicitement listé dans le dépôt ou la documentation.

Aucune ressource MCP explicite n’est détaillée dans le dépôt ou la documentation.

Aucune instruction d’installation pour Windsurf n’est présente dans le dépôt.

~/Library/Application Support/Claude/claude_desktop_config.json%AppData%\Claude\claude_desktop_config.json~/.config/Claude/claude_desktop_config.json{

"mcpServers": {

"deepl": {

"command": "npx",

"args": ["-y", "/path/to/deepl-mcp-server"],

"env": {

"DEEPL_API_KEY": "your-api-key-here"

}

}

}

}

/path/to/deepl-mcp-server par le chemin absolu vers votre dépôt local.your-api-key-here par votre véritable clé API DeepL.Sécurisation des clés API :

Utilisez le champ env pour stocker les clés API en toute sécurité. Exemple ci-dessus dans l’extrait JSON.

Aucune instruction d’installation pour Cursor n’est présente dans le dépôt.

Aucune instruction d’installation pour Cline n’est présente dans le dépôt.

Utilisation du MCP dans FlowHunt

Pour intégrer des serveurs MCP dans votre flux FlowHunt, commencez par ajouter le composant MCP à votre flux et connectez-le à votre agent IA :

Cliquez sur le composant MCP pour ouvrir le panneau de configuration. Dans la section de configuration MCP système, insérez les détails de votre serveur MCP avec ce format JSON :

{

"deepl": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Une fois configuré, l’agent IA peut désormais utiliser ce MCP comme outil avec accès à toutes ses fonctions et capacités. N’oubliez pas de remplacer “deepl” par le vrai nom de votre serveur MCP et l’URL par celle de votre propre serveur MCP.

| Section | Disponibilité | Détails/Remarques |

|---|---|---|

| Vue d’ensemble | ✅ | |

| Liste des prompts | ⛔ | |

| Liste des ressources | ⛔ | |

| Liste des outils | ✅ | |

| Sécurisation des clés API | ✅ | Utiliser "env" |

| Prise en charge de l’échantillonnage | ⛔ |

Au vu de ce qui précède, le serveur DeepL MCP est ciblé et prêt pour la production pour les tâches de traduction, mais il manque de modèles de prompts et de ressources documentés, et dispose de guides de configuration limités en dehors de Claude. Il couvre l’essentiel en matière de sécurité grâce à la gestion de la clé API et propose un ensemble robuste d’outils de traduction.

Ce serveur MCP obtient un score assez élevé pour son utilité et son applicabilité réelle grâce à ses outils de traduction robustes et son intégration simple avec Claude, mais perd des points en raison du manque de documentation sur les ressources et prompts et de guides d’installation multi-plateformes limités.

| Possède une LICENCE | ✅ (MIT) |

|---|---|

| Au moins un outil | ✅ |

| Nombre de Forks | 5 |

| Nombre d’étoiles | 19 |

Le serveur DeepL MCP est un middleware qui apporte la traduction avancée, la reformulation et la détection de langue de DeepL aux assistants IA. Il agit comme un pont entre vos flux de travail IA et l’API DeepL, prenant en charge la communication multilingue en temps réel et les ajustements de ton.

Il propose des outils pour récupérer les langues sources et cibles disponibles, traduire du texte et reformuler du contenu—permettant aux agents IA de traiter une large gamme de tâches linguistiques de manière programmatique.

Utilisez le champ `env` dans la configuration de votre serveur MCP pour stocker votre clé API. Cela maintient les données sensibles hors de votre base de code et assure une gestion sécurisée de l’accès.

Oui ! Ajoutez le composant MCP à votre flux FlowHunt, saisissez la configuration de votre serveur DeepL MCP, et votre agent IA bénéficiera instantanément de la traduction, de la reformulation et des fonctionnalités de détection de langue.

Oui, l’API DeepL et le serveur MCP gèrent les ajustements de formalité, vous permettant d’adapter les traductions à des usages professionnels ou informels.

Des instructions détaillées sont fournies pour Claude Desktop. D’autres plateformes comme Cursor et Cline ne sont pas explicitement documentées, mais le serveur MCP est compatible si correctement configuré.

Boostez votre chatbot ou votre flux de travail IA avec le serveur DeepL MCP pour une traduction, une reformulation et une détection de langue fluides et en temps réel—aucun codage manuel requis.

Le serveur ModelContextProtocol (MCP) agit comme un pont entre les agents IA et les sources de données externes, API et services, permettant aux utilisateurs de...

Le serveur MCP Deepseek Thinker intègre le raisonnement du modèle Deepseek dans les clients IA compatibles MCP comme Claude Desktop, fournissant des sorties ava...

Le serveur DeepSeek MCP intègre les modèles de langage avancés de DeepSeek avec des applications compatibles MCP, offrant un accès API sécurisé et anonymisé et ...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.