Intégration du serveur Azure MCP

Le serveur Azure MCP permet une intégration transparente entre les agents IA et l'écosystème cloud d'Azure, permettant l'automatisation pilotée par l'IA, la ges...

Optimisez vos workflows IA avec le serveur Pulumi MCP — déployez, gérez et interrogez l’infrastructure cloud de façon programmatique directement depuis vos outils et IDE pilotés par l’IA.

FlowHunt fournit une couche de sécurité supplémentaire entre vos systèmes internes et les outils d'IA, vous donnant un contrôle granulaire sur les outils accessibles depuis vos serveurs MCP. Les serveurs MCP hébergés dans notre infrastructure peuvent être intégrés de manière transparente avec le chatbot de FlowHunt ainsi qu'avec les plateformes d'IA populaires comme ChatGPT, Claude et divers éditeurs d'IA.

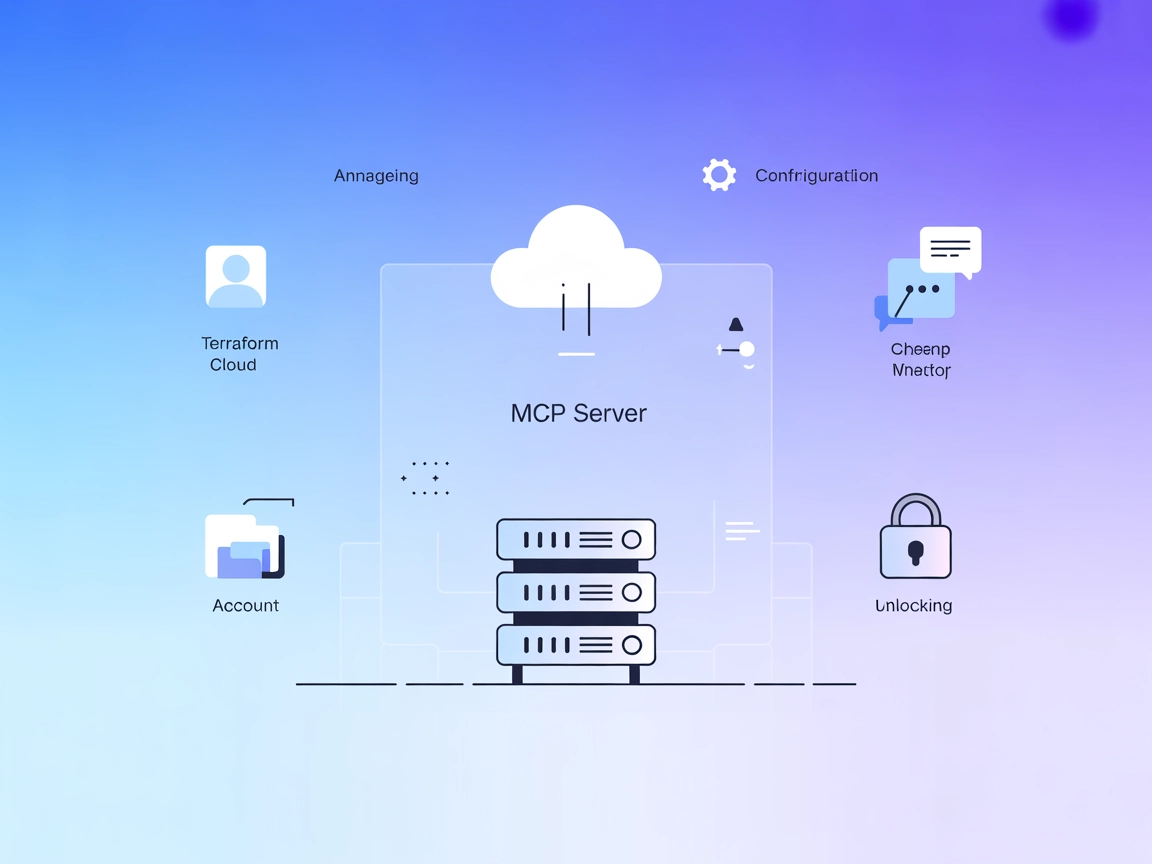

Le serveur Pulumi MCP sert de pont entre les assistants IA et la plateforme d’infrastructure-as-code Pulumi. En exposant les opérations Pulumi via le Model Context Protocol (MCP), ce serveur permet des workflows de développement pilotés par l’IA, autorisant les clients (comme Claude Desktop, VSCode et Cline) à interagir de manière programmatique avec l’infrastructure cloud. Grâce à ce serveur, les assistants IA peuvent accomplir des tâches telles que le déploiement de ressources, la gestion des stacks, la consultation d’états et l’automatisation des opérations d’infrastructure récurrentes. Cette intégration simplifie la gestion de l’infrastructure, réduit les interventions manuelles et permet aux développeurs de contrôler les environnements cloud directement depuis leurs outils enrichis par l’IA favoris.

Aucune information concernant des modèles de prompts n’a été trouvée dans le dépôt.

Aucune « ressource » MCP spécifique n’est listée ou exposée par le serveur Pulumi MCP dans le dépôt.

Aucun outil explicite n’est énuméré dans la documentation ou visible dans les fichiers principaux du dépôt. La fonctionnalité principale semble centrée sur l’exécution d’opérations Pulumi via Docker.

Aucune instruction de configuration pour Windsurf n’est fournie dans le dépôt.

PULUMI_ACCESS_TOKEN.mcpServers :{

"pulumi-mcp-server": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"--name",

"pulumi-mcp-server",

"-e",

"PULUMI_ACCESS_TOKEN",

"dogukanakkaya/pulumi-mcp-server"

],

"env": {

"PULUMI_ACCESS_TOKEN": "${YOUR_TOKEN}"

},

"transportType": "stdio"

}

}

Sécurisation des clés API :

Stockez votre jeton d’accès Pulumi dans une variable d’environnement. Dans votre configuration, utilisez :

"env": {

"PULUMI_ACCESS_TOKEN": "${YOUR_TOKEN}"

}

Aucune instruction de configuration pour Cursor n’est fournie dans le dépôt.

PULUMI_ACCESS_TOKEN.{

"pulumi-mcp-server": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"--name",

"pulumi-mcp-server",

"-e",

"PULUMI_ACCESS_TOKEN",

"dogukanakkaya/pulumi-mcp-server"

],

"env": {

"PULUMI_ACCESS_TOKEN": "${YOUR_TOKEN}"

},

"transportType": "stdio"

}

}

Sécurisation des clés API :

Voir l’exemple d’utilisation de env ci-dessus.

Utiliser MCP dans FlowHunt

Pour intégrer des serveurs MCP à votre workflow FlowHunt, commencez par ajouter le composant MCP à votre flux et reliez-le à votre agent IA :

Cliquez sur le composant MCP pour ouvrir le panneau de configuration. Dans la section de configuration système MCP, insérez les détails de votre serveur MCP en utilisant ce format JSON :

{

"pulumi-mcp-server": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Une fois configuré, l’agent IA pourra utiliser ce MCP comme un outil avec accès à toutes ses fonctions et capacités. Pensez à remplacer “pulumi-mcp-server” par le nom réel de votre serveur MCP et à renseigner l’URL de votre propre serveur MCP.

| Section | Disponibilité | Détails/Remarques |

|---|---|---|

| Vue d’ensemble | ✅ | |

| Liste des prompts | ⛔ | Aucun trouvé |

| Liste des ressources | ⛔ | Aucune trouvée |

| Liste des outils | ⛔ | Aucune trouvée |

| Sécurisation des clés API | ✅ | Fournie via env dans la config |

| Prise en charge du sampling (moins important) | ⛔ | Non mentionné |

Support ROOTS : Non documenté

Support sampling : Non documenté

D’après les informations trouvées, le dépôt du serveur Pulumi MCP est fonctionnel et permet l’intégration de Pulumi avec des clients MCP, mais il manque de documentation sur les prompts, ressources et définitions d’outils explicites. Pour un développeur recherchant un serveur MCP prêt à l’emploi et bien documenté, ce dépôt obtiendrait une note moyenne, puisqu’il fournit principalement des détails de configuration et des cas d’usage de base.

| Possède une LICENSE | ⛔ |

|---|---|

| Possède au moins un outil | ⛔ |

| Nombre de forks | 2 |

| Nombre d’étoiles | 3 |

Notre note globale : 3/10 – Le dépôt fournit un pont basique vers Pulumi via MCP mais manque de documentation, de définitions explicites de ressources/outils et de licence, ce qui le rend moins adapté à la production ou à une adoption plus large sans développements complémentaires.

Le serveur Pulumi MCP est une couche d'intégration reliant les assistants IA et les outils de développement à la plateforme d’infrastructure-as-code Pulumi via le Model Context Protocol (MCP), permettant la gestion programmatique des ressources cloud.

Vous pouvez déployer, mettre à jour ou détruire une infrastructure cloud, automatiser la gestion des stacks et interroger l’état des ressources directement depuis des environnements alimentés par l’IA ou vos flux FlowHunt, sans quitter votre IDE ou interface de chat.

Oui. Stockez toujours votre PULUMI_ACCESS_TOKEN dans des variables d’environnement et référencez-le dans votre configuration MCP. Ne placez jamais de secrets en dur dans vos flux ou configurations.

Non. Le dépôt se concentre actuellement sur l’intégration opérationnelle et ne fournit pas de modèles de prompts, de listes explicites d’outils/ressources ou de documentation avancée.

Le serveur Pulumi MCP est documenté pour une utilisation avec Claude Desktop et Cline, et peut aussi être intégré aux flux FlowHunt. L’installation pour Windsurf et Cursor n’est pas documentée.

Déploiement automatisé d’infrastructure cloud, mises à jour de routine, gestion des stacks, interrogation d’état et intégration des opérations d’infrastructure dans des workflows IA conversationnels ou centrés code.

Intégrez l’automatisation de l’infrastructure Pulumi dans vos flux FlowHunt ou vos IDEs alimentés par l’IA pour rationaliser les opérations DevOps et cloud sans intervention manuelle.

Le serveur Azure MCP permet une intégration transparente entre les agents IA et l'écosystème cloud d'Azure, permettant l'automatisation pilotée par l'IA, la ges...

Intégrez Jira et Confluence avec des assistants IA grâce au serveur MCP Atlassian. Activez une gestion de projet intelligente, automatisez les workflows et perm...

Intégrez des assistants IA à l’API Terraform Cloud grâce au serveur MCP Terraform Cloud. Gérez l’infrastructure en langage naturel, automatisez les tâches de wo...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.