Kubernetes MCP 서버 통합

Kubernetes MCP 서버는 AI 어시스턴트와 Kubernetes 클러스터를 연결하여 표준화된 MCP 명령을 통한 AI 기반 자동화, 리소스 관리 및 DevOps 워크플로우를 가능하게 합니다....

Patronus MCP 서버는 LLM 평가와 실험을 자동화하여, FlowHunt를 사용하는 기술팀의 AI 벤치마킹과 워크플로우 통합을 간소화합니다.

FlowHunt는 귀하의 내부 시스템과 AI 도구 사이에 추가 보안 계층을 제공하여 MCP 서버에서 액세스할 수 있는 도구를 세밀하게 제어할 수 있습니다. 저희 인프라에서 호스팅되는 MCP 서버는 FlowHunt의 챗봇뿐만 아니라 ChatGPT, Claude 및 다양한 AI 편집기와 같은 인기 있는 AI 플랫폼과 원활하게 통합될 수 있습니다.

Patronus MCP(모델 컨텍스트 프로토콜) 서버는 Patronus SDK를 위해 구축된 표준화된 서버 구현체로, 고급 LLM(대형 언어 모델) 시스템 최적화, 평가 및 실험을 촉진하도록 설계되었습니다. AI 어시스턴트를 외부 데이터 소스와 서비스에 연결함으로써, Patronus MCP 서버는 개발자와 연구자를 위한 효율적인 워크플로우를 가능하게 합니다. 사용자는 단일 또는 배치 평가를 실행하고, 데이터셋으로 실험을 수행하며, 특정 API 키와 설정으로 프로젝트를 초기화할 수 있습니다. 이 확장 가능한 플랫폼은 반복적인 평가 작업을 자동화하고, 사용자 정의 평가자 통합을 지원하며, LLM 동작 관리 및 분석을 위한 강력한 인터페이스를 제공하여 AI 개발 라이프사이클을 한층 향상시킵니다.

레포지토리 또는 문서에 명시적으로 기재된 프롬프트 템플릿이 없습니다.

사용 가능한 문서나 저장소 파일에 명시된 리소스가 없습니다.

initialize

API 키, 프로젝트, 애플리케이션 설정으로 Patronus를 초기화합니다. 이후 평가 및 실험을 위한 시스템을 세팅합니다.

evaluate

지정한 평가자를 사용하여 주어진 태스크 입력, 출력, 컨텍스트로 단일 평가를 실행합니다.

batch_evaluate

여러 평가자를 활용하여 제공된 태스크에 대해 배치 평가를 실행하고, 집합적인 결과를 생성합니다.

run_experiment

데이터셋과 지정 평가자를 사용해 실험을 실행하며, 벤치마크 및 비교에 유용합니다.

LLM 평가 자동화

태스크를 배치로 처리하고 여러 평가자를 적용하여 대형 언어 모델의 평가를 자동화함으로써, 품질 보증 및 벤치마킹의 수작업을 줄입니다.

맞춤형 실험

사용자 정의 데이터셋과 평가자로 새로운 LLM 아키텍처의 벤치마킹 및 다양한 기준 간 성능 비교를 위한 맞춤형 실험을 수행합니다.

팀 단위 프로젝트 초기화

API 키와 프로젝트 설정을 활용하여 여러 프로젝트의 평가 환경을 빠르게 세팅 및 구성하여 온보딩과 협업을 간소화합니다.

인터랙티브 실시간 테스트

제공된 스크립트로 평가 엔드포인트를 실시간으로 테스트할 수 있어 개발자가 평가 워크플로우를 쉽게 디버깅하고 검증할 수 있습니다.

.windsurf 또는 windsurf.json)을 찾으세요.{

"mcpServers": [

{

"command": "python",

"args": ["src/patronus_mcp/server.py"],

"env": {

"PATRONUS_API_KEY": "your_api_key_here"

}

}

]

}

{

"mcpServers": [

{

"command": "python",

"args": ["src/patronus_mcp/server.py"],

"env": {

"PATRONUS_API_KEY": "your_api_key_here"

}

}

]

}

{

"mcpServers": [

{

"command": "python",

"args": ["src/patronus_mcp/server.py"],

"env": {

"PATRONUS_API_KEY": "your_api_key_here"

}

}

]

}

{

"mcpServers": [

{

"command": "python",

"args": ["src/patronus_mcp/server.py"],

"env": {

"PATRONUS_API_KEY": "your_api_key_here"

}

}

]

}

API 키 보안:PATRONUS_API_KEY와 같은 민감한 자격증명은 구성의 env 객체에 위치시키세요. 예시:

{

"command": "python",

"args": ["src/patronus_mcp/server.py"],

"env": {

"PATRONUS_API_KEY": "your_api_key_here"

},

"inputs": {}

}

FlowHunt에서 MCP 사용

MCP 서버를 FlowHunt 워크플로우에 통합하려면, 먼저 MCP 컴포넌트를 플로우에 추가하고 이를 AI 에이전트와 연결하세요:

MCP 컴포넌트를 클릭하여 구성 패널을 여세요. 시스템 MCP 구성 섹션에서 다음 JSON 형식으로 MCP 서버 정보를 입력하면 됩니다:

{

"patronus-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

구성이 완료되면, AI 에이전트는 MCP의 모든 기능과 역량을 도구로 활용할 수 있습니다. “patronus-mcp” 부분은 실제 MCP 서버의 이름으로, URL도 본인의 MCP 서버 주소로 변경해야 합니다.

| 섹션 | 지원 여부 | 세부사항/비고 |

|---|---|---|

| 개요 | ✅ | README에 명확한 설명 있음 |

| 프롬프트 목록 | ⛔ | 프롬프트 템플릿 없음 |

| 리소스 목록 | ⛔ | 명시적 리소스 없음 |

| 도구 목록 | ✅ | API 사용법 및 README에서 확인 가능 |

| API 키 보안 | ✅ | README 및 설치 설명에 서술됨 |

| 샘플링 지원(평가에선 중요도 낮음) | ⛔ | 언급되지 않음 |

Roots 지원: 문서나 코드에 언급되지 않음.

위 정보에 근거할 때, Patronus MCP 서버는 LLM 평가와 실험에 필요한 견고한 기반과 필수 기능을 제공하지만, 프롬프트 템플릿, 리소스, Roots나 Sampling 등 고급 MCP 기능에 대한 문서 또는 구현이 부족합니다.

Patronus MCP 서버는 견고한 평가 도구와 명확한 설치 안내를 제공하지만, 표준화된 프롬프트, 리소스 정의, 일부 고급 MCP 기능이 부족합니다. LLM 평가와 실험에 집중하는 기술 사용자에게 가장 적합합니다. 점수: 6/10

| 라이선스 보유 | ✅ (Apache-2.0) |

|---|---|

| 도구 1개 이상 보유 | ✅ |

| 포크 수 | 3 |

| 별점 수 | 13 |

Patronus MCP 서버는 Patronus SDK용 표준화된 서버로, LLM 시스템 최적화, 평가 및 실험에 중점을 둡니다. LLM 평가를 자동화하고, 배치 처리를 지원하며, AI 개발 워크플로우를 위한 견고한 인터페이스를 제공합니다.

프로젝트 설정 초기화, 단일 및 배치 평가 실행, 데이터셋과 사용자 정의 평가자를 활용한 실험 도구를 포함합니다.

구성 파일의 `env` 객체에 API 키를 저장하세요. 코드 저장소에 민감한 정보를 하드코딩하지 마세요.

네, Patronus MCP 서버를 FlowHunt 내 MCP 컴포넌트로 통합하여, AI 에이전트와 연결하여 고급 평가 및 실험을 할 수 있습니다.

자동화된 LLM 평가, 맞춤형 벤치마킹 실험, 팀 단위 프로젝트 초기화, 평가 엔드포인트의 실시간 테스트 등에 사용할 수 있습니다.

Kubernetes MCP 서버는 AI 어시스턴트와 Kubernetes 클러스터를 연결하여 표준화된 MCP 명령을 통한 AI 기반 자동화, 리소스 관리 및 DevOps 워크플로우를 가능하게 합니다....

쿠버네티스 MCP 서버는 AI 어시스턴트와 쿠버네티스/오픈시프트 클러스터를 연결하여, 자연어 워크플로우를 통한 프로그래밍 가능한 리소스 관리, 파드 운영, DevOps 자동화를 가능하게 합니다....

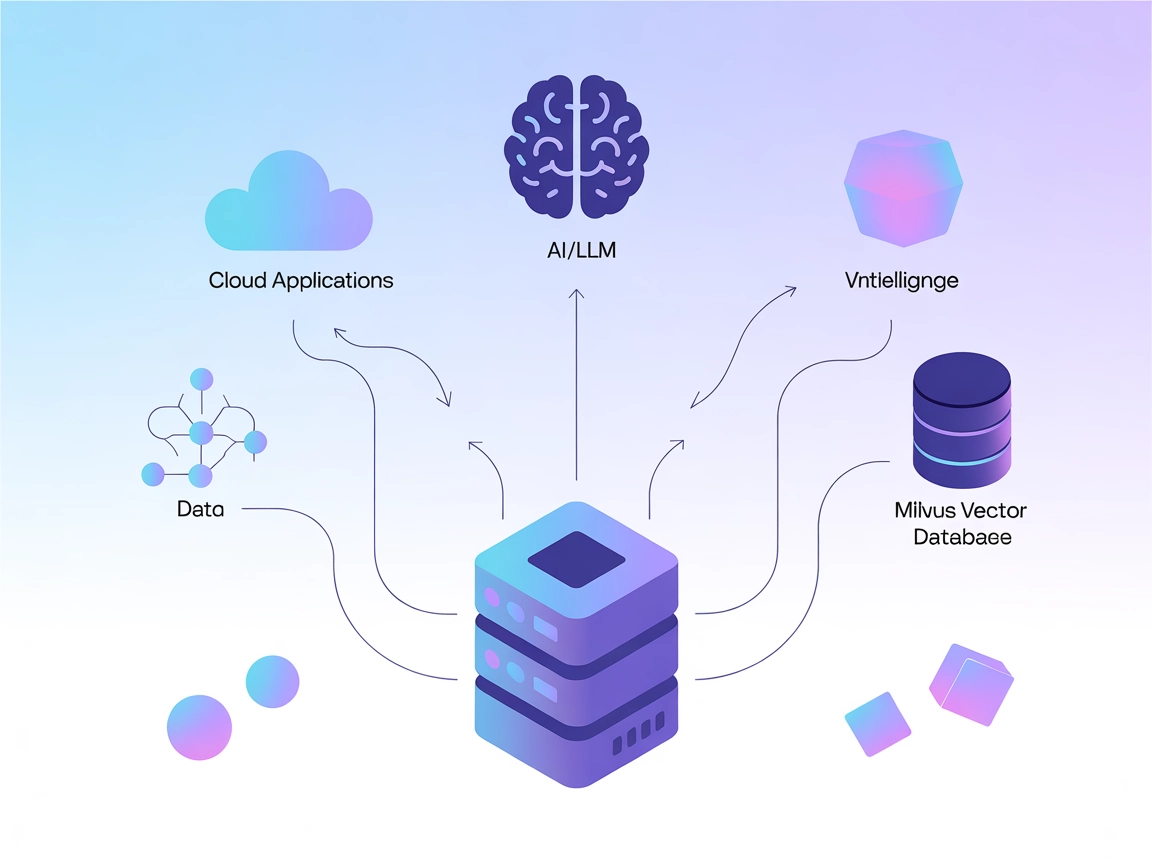

Milvus MCP 서버는 AI 어시스턴트와 LLM 기반 애플리케이션을 Milvus 벡터 데이터베이스와 연결하여, FlowHunt에서 고급 벡터 검색, 임베딩 관리, 맥락 기억 등 지능형 AI 워크플로우를 가능하게 합니다....

쿠키 동의

당사는 귀하의 브라우징 경험을 향상시키고 트래픽을 분석하기 위해 쿠키를 사용합니다. See our privacy policy.