CodeLogic MCP Server-integrasjon

CodeLogic MCP Server kobler FlowHunt og AI-programmeringsassistenter til CodeLogic sin detaljerte programvareavhengighetsdata, og muliggjør avansert kodeanalyse...

Kjør Python-kode, installer avhengigheter og administrer isolerte miljøer direkte i dine FlowHunt-flows med MCP Code Executor MCP Server.

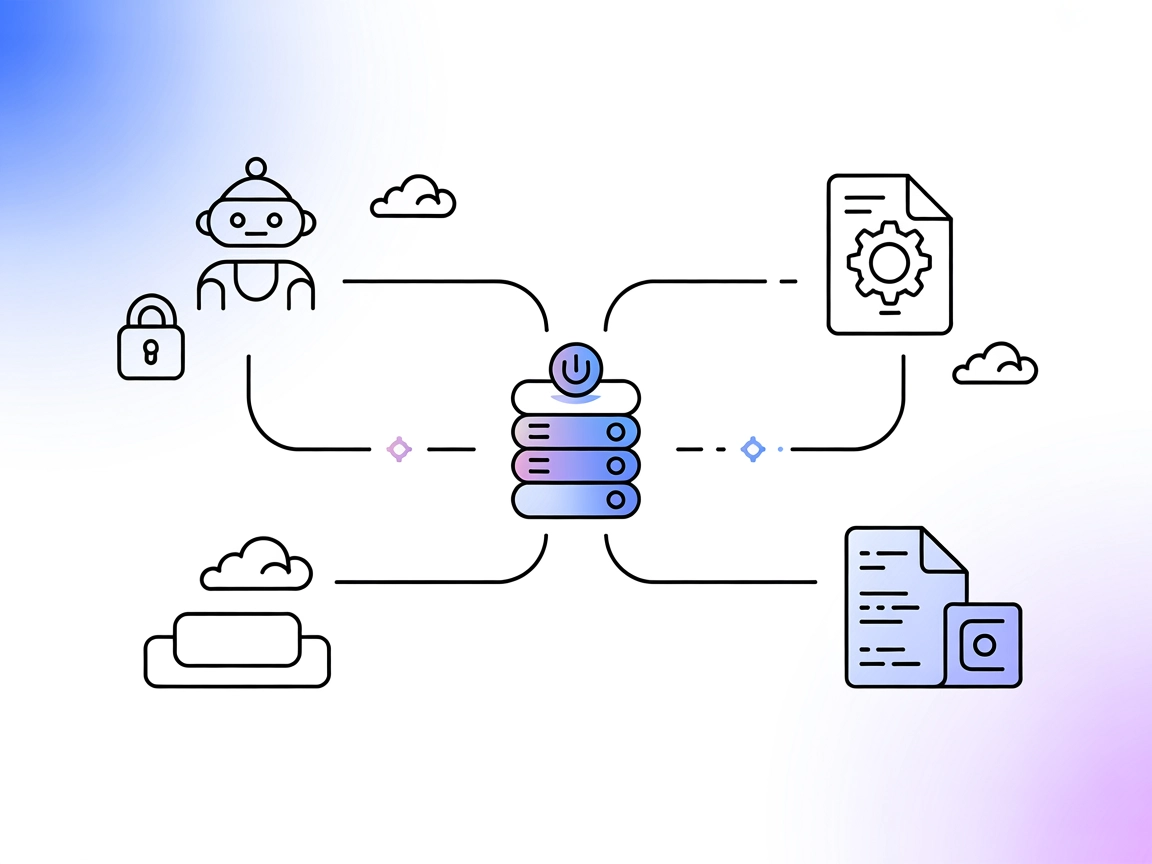

FlowHunt gir et ekstra sikkerhetslag mellom dine interne systemer og AI-verktøy, og gir deg granulær kontroll over hvilke verktøy som er tilgjengelige fra dine MCP-servere. MCP-servere som er hostet i vår infrastruktur kan sømløst integreres med FlowHunts chatbot samt populære AI-plattformer som ChatGPT, Claude og forskjellige AI-editorer.

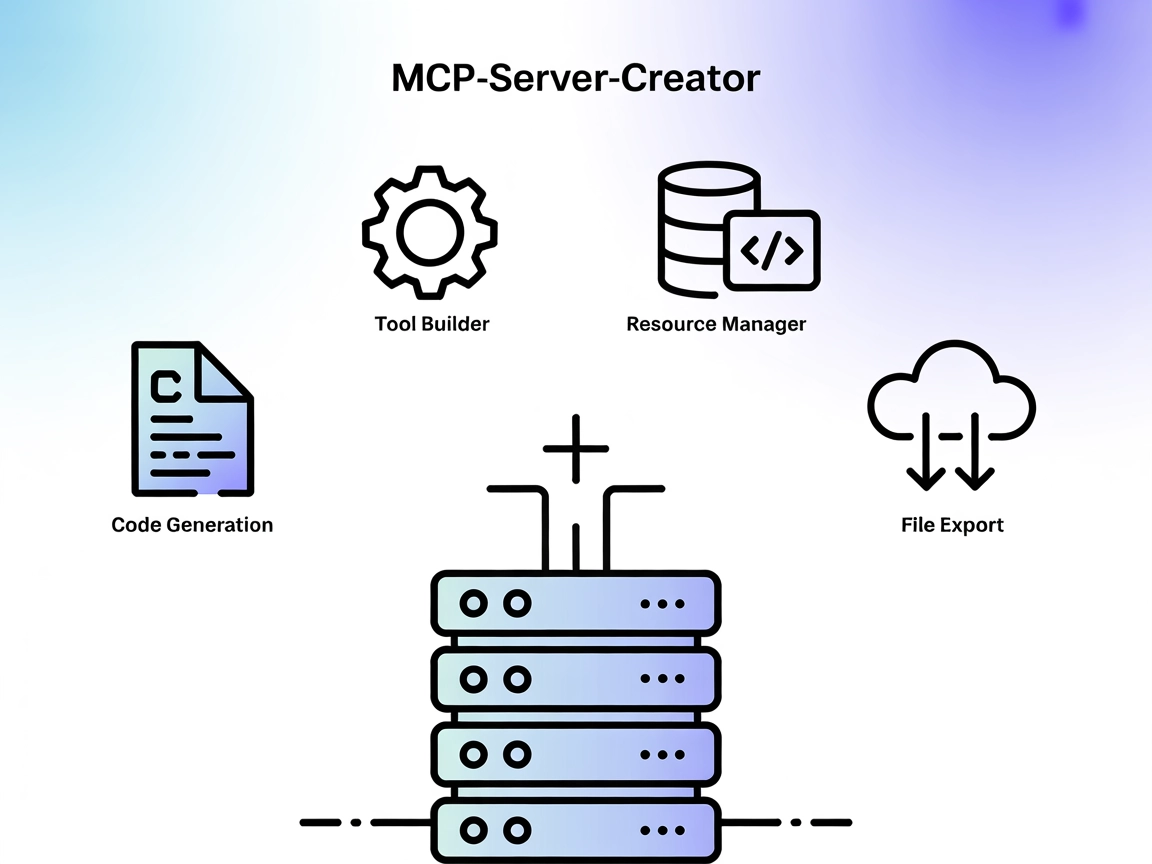

MCP Code Executor er en MCP (Model Context Protocol) server som lar språkmodeller (LLM-er) kjøre Python-kode i et angitt Python-miljø, som Conda, virtualenv eller UV virtualenv. Ved å koble AI-assistenter til ekte, kjørbare Python-miljøer, gir den dem mulighet til å utføre en rekke utviklingsoppgaver som krever kodekjøring, bibliotekadministrasjon og dynamisk miljøoppsett. Denne serveren støtter inkrementell kodegenerering for å overvinne tokenbegrensninger, muliggjør installasjon av avhengigheter underveis og forenkler kjøretidskonfigurasjon av utførelsesmiljøet. Utviklere kan dra nytte av dette verktøyet for å automatisere kodeevaluering, eksperimentere med nye pakker og styre beregninger i et kontrollert og sikkert miljø.

Ingen eksplisitte prompt-maler er oppført i repositoriet eller dokumentasjonen.

Ingen spesifikke ressurser er beskrevet i repositoriet eller dokumentasjonen.

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env",

"MY_SECRET_API_KEY": "${MY_SECRET_API_KEY}"

},

"inputs": {

"apiKey": "${MY_SECRET_API_KEY}"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

Merk: Du kan også bruke Docker. Den medfølgende Dockerfile er testet for

venv-uv-miljøtype:

{

"mcpServers": {

"mcp-code-executor": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"mcp-code-executor"

]

}

}

}

Bruke MCP i FlowHunt

For å integrere MCP-servere i din FlowHunt-arbeidsflyt, start med å legge til MCP-komponenten i flowen din og koble den til AI-agenten:

Klikk på MCP-komponenten for å åpne konfigurasjonspanelet. I systemets MCP-konfigurasjonsdel limer du inn MCP-serverdetaljene dine med dette JSON-formatet:

{

"mcp-code-executor": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Når det er konfigurert, kan AI-agenten nå bruke denne MCP-serveren som et verktøy med tilgang til alle dens funksjoner og muligheter. Husk å endre “mcp-code-executor” til det faktiske navnet på din MCP-server og erstatte URL-en med din egen MCP-server-URL.

| Seksjon | Tilgjengelig | Detaljer/Notater |

|---|---|---|

| Oversikt | ✅ | |

| Liste over prompt-maler | ⛔ | Ingen prompt-maler funnet |

| Liste over ressurser | ⛔ | Ingen eksplisitte ressurser beskrevet |

| Liste over verktøy | ✅ | execute_code, install_dependencies, check_installed_packages |

| Sikre API-nøkler | ✅ | Eksempel gitt med env-inputs |

| Sampling-støtte (mindre viktig for evaluering) | ⛔ | Ikke spesifisert |

Denne MCP-serveren gir essensiell og robust funksjonalitet for kodekjøring med LLM-integrasjon, sammen med klare oppsettinstruksjoner og verktøy. Den mangler derimot prompt-maler, eksplisitte ressurser og informasjon om røtter eller sampling-støtte. For en MCP med fokus på kodekjøring er den svært solid, scorer høyt på praktisk nytte og enkel integrering, men mister noen poeng på grunn av manglende avanserte MCP-funksjoner og dokumentasjonskompletthet.

| Har en LISENS | ✅ (MIT) |

|---|---|

| Har minst ett verktøy | ✅ |

| Antall Forks | 25 |

| Antall Stjerner | 144 |

Det er en Model Context Protocol (MCP) server som lar språkmodeller kjøre Python-kode i sikre, isolerte miljøer (som Conda eller venv), håndtere avhengigheter og konfigurere kjøremiljøer. Ideell for kodeevaluering, datavitenskap, automatiserte arbeidsflyter og dynamisk miljøoppsett med FlowHunt.

Den tilbyr verktøy for å kjøre Python-kode (`execute_code`), installere avhengigheter fortløpende (`install_dependencies`) og sjekke installerte pakker (`check_installed_packages`).

Legg til MCP Code Executor som en MCP-komponent i flowen din og konfigurer den med serverens URL og transportmetode. Dette gjør det mulig for AI-agentene dine å bruke kodeutførelses- og miljøstyringsfunksjonene inne i FlowHunt.

Ja, serveren støtter kjøring av kode i isolerte Conda- eller virtualenv-miljøer, noe som sikrer reproduserbarhet og forhindrer konflikter mellom avhengigheter.

Ja, serveren kan kjøre kode inkrementelt, noe som er nyttig for håndtering av kode som overskrider LLM-tokenbegrensninger.

Ja, du kan bruke den medfølgende Dockerfile og konfigurere MCP-serveren til å kjøre inni en Docker-container for ekstra isolasjon.

Gi dine flows mulighet til sikker, automatisert Python-kodekjøring. Integrer MCP Code Executor MCP Server og åpne for dynamiske arbeidsflyter for datavitenskap, automatisering og mer.

CodeLogic MCP Server kobler FlowHunt og AI-programmeringsassistenter til CodeLogic sin detaljerte programvareavhengighetsdata, og muliggjør avansert kodeanalyse...

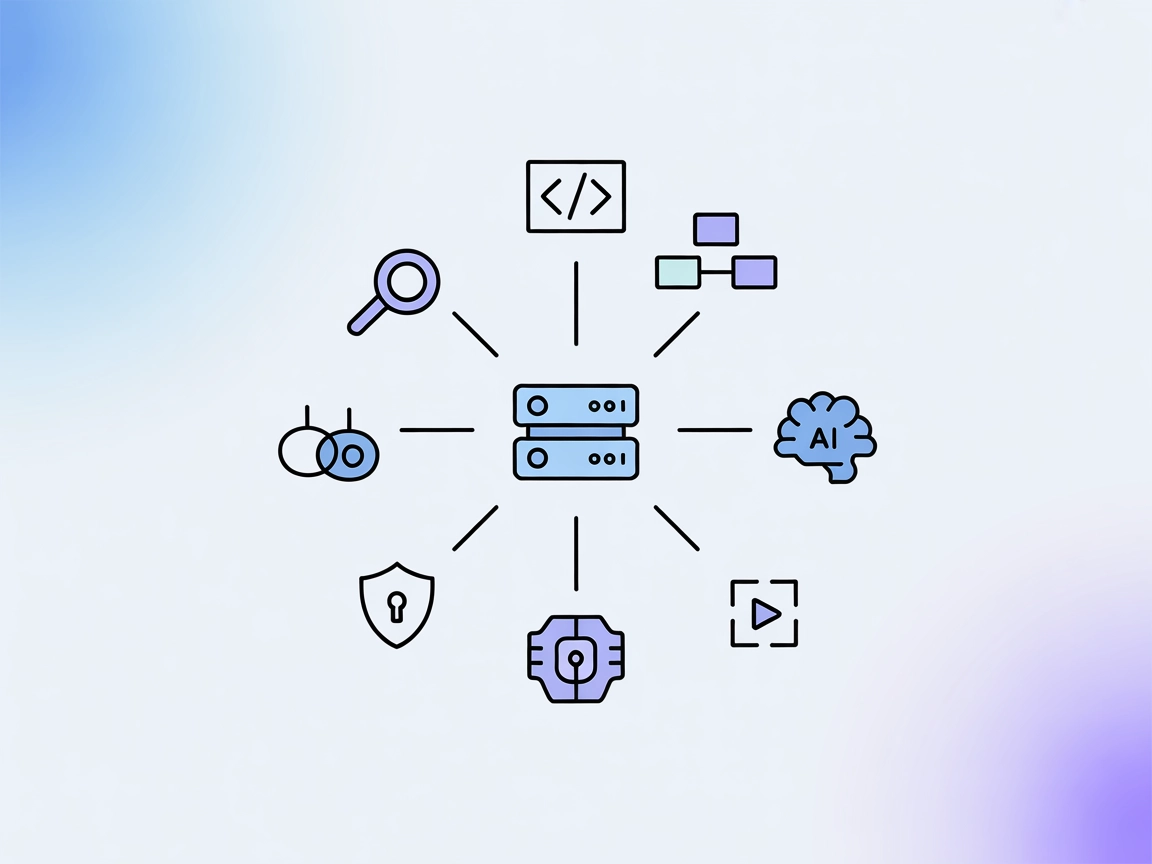

MCP-Server-Creator er en meta-server som muliggjør rask opprettelse og konfigurasjon av nye Model Context Protocol (MCP)-servere. Med dynamisk kodegenerering, v...

Coda MCP Server gir en standardisert måte for AI-assistenter å samhandle med Codas plattform, muliggjør dokumentforespørsler, arbeidsflytautomatisering og enhet...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.