DeepSeek MCP-server

DeepSeek MCP-serveren fungerer som en sikker proxy, som kobler DeepSeek sine avanserte språkmodeller til MCP-kompatible applikasjoner som Claude Desktop eller F...

Få Deepseek sin transparente resonnering og chain-of-thought AI-utdata inn i dine MCP-aktiverte assistenter med støtte for både sky- og lokal distribusjon.

FlowHunt gir et ekstra sikkerhetslag mellom dine interne systemer og AI-verktøy, og gir deg granulær kontroll over hvilke verktøy som er tilgjengelige fra dine MCP-servere. MCP-servere som er hostet i vår infrastruktur kan sømløst integreres med FlowHunts chatbot samt populære AI-plattformer som ChatGPT, Claude og forskjellige AI-editorer.

Deepseek Thinker MCP Server fungerer som en Model Context Protocol (MCP)-tilbyder som leverer Deepseek-modellens resonneringsinnhold til MCP-aktiverte AI-klienter, som Claude Desktop. Det gjør det mulig for AI-assistenter å få tilgang til Deepseek sine tankeprosesser og resonneringsutdata enten via Deepseek API-tjenesten eller fra en lokal Ollama-server. Ved å integrere med denne serveren kan utviklere forbedre sine AI-arbeidsflyter med målrettet resonnering, både gjennom sky- og lokal inferens. Denne serveren er spesielt nyttig i situasjoner hvor detaljerte resonneringskjeder eller chain-of-thought (CoT)-utdata er nødvendige for å informere nedstrøms AI-oppgaver, noe som gjør den verdifull for avansert utvikling, feilsøking og berikelse av AI-agenter.

Ingen eksplisitte prompt-maler er nevnt i depotet eller dokumentasjonen.

Ingen eksplisitte MCP-ressurser er beskrevet i dokumentasjonen eller kodebasen.

originPrompt (string) — Brukerens opprinnelige prompt.windsurf_config.json).mcpServers-objektet:{

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

claude_desktop_config.json.{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

For alle plattformer bør API-nøkler og sensitive konfigurasjonsverdier gis som miljøvariabler i env-seksjonen. Eksempel:

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

For lokal Ollama-modus, sett USE_OLLAMA til "true" i env-objektet:

"env": {

"USE_OLLAMA": "true"

}

Bruk av MCP i FlowHunt

For å integrere MCP-servere i FlowHunt-arbeidsflyten din, start med å legge til MCP-komponenten i flowen og koble den til din AI-agent:

Klikk på MCP-komponenten for å åpne konfigurasjonspanelet. I systemets MCP-konfigurasjonsseksjon legger du inn MCP-serverdetaljene med følgende JSON-format:

{

"deepseek-thinker": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Når det er konfigurert, kan AI-agenten nå bruke denne MCP-en som et verktøy med tilgang til alle dens funksjoner og egenskaper. Husk å endre “deepseek-thinker” til ditt faktiske MCP-servernavn og angi korrekt URL.

| Seksjon | Tilgjengelighet | Detaljer/Notater |

|---|---|---|

| Oversikt | ✅ | |

| Liste over prompt-maler | ⛔ | Ingen prompt-maler dokumentert |

| Liste over ressurser | ⛔ | Ingen eksplisitte MCP-ressurser funnet |

| Liste over verktøy | ✅ | get-deepseek-thinker-verktøy |

| Sikring av API-nøkler | ✅ | Miljøvariabler i konfig |

| Sampling-støtte (mindre viktig i vurdering) | ⛔ | Ikke nevnt |

Basert på de to tabellene under gir Deepseek Thinker MCP Server et fokusert verktøy for resonneringsintegrasjon, er lett å sette opp, men mangler detaljerte prompt-maler og eksplisitte ressursdefinisjoner. Prosjektet er åpen kildekode, har moderat popularitet og støtter sikker håndtering av legitimasjon. Det får en 6/10 for total fullstendighet og nytte som MCP-server.

| Har en LISENS | ⛔ (Ingen LICENSE-fil funnet) |

|---|---|

| Har minst ett verktøy | ✅ |

| Antall forks | 12 |

| Antall stjerner | 51 |

Det er en Model Context Protocol-server som bringer Deepseek-modellens resonnering til MCP-aktiverte AI-klienter, og tilbyr chain-of-thought-utdata og transparent modelltenkning for avanserte AI-arbeidsflyter og feilsøking.

Den tilbyr 'get-deepseek-thinker'-verktøyet for å utføre resonnering med Deepseek-modellen og returnere strukturerte resonneringsutdata.

Ja, Deepseek Thinker støtter både skybasert og lokal (Ollama) inferens. Sett miljøvariabelen 'USE_OLLAMA' til 'true' for lokal modus.

API-nøkler og sensitive verdier bør lagres i 'env'-delen av MCP-serverkonfigurasjonen din som miljøvariabler, ikke hardkodet i kildefiler.

Grenser bestemmes av den underliggende Deepseek-modellen eller API-et; hvis de overskrides kan svar bli avkortet eller feile, så juster konfigurasjon og inndata deretter.

Ingen eksplisitte prompt-maler eller ekstra MCP-ressurser er inkludert i den nåværende Deepseek Thinker MCP Server-dokumentasjonen.

Integrer Deepseek Thinker MCP Server for å gi dine AI-agenter detaljerte resonneringsevner og forbedre utviklingsarbeidsflyter.

DeepSeek MCP-serveren fungerer som en sikker proxy, som kobler DeepSeek sine avanserte språkmodeller til MCP-kompatible applikasjoner som Claude Desktop eller F...

DeepSeek MCP Server integrerer DeepSeek sine avanserte språkmodeller med MCP-kompatible applikasjoner, og gir sikker, anonymisert API-tilgang samt muliggjør ska...

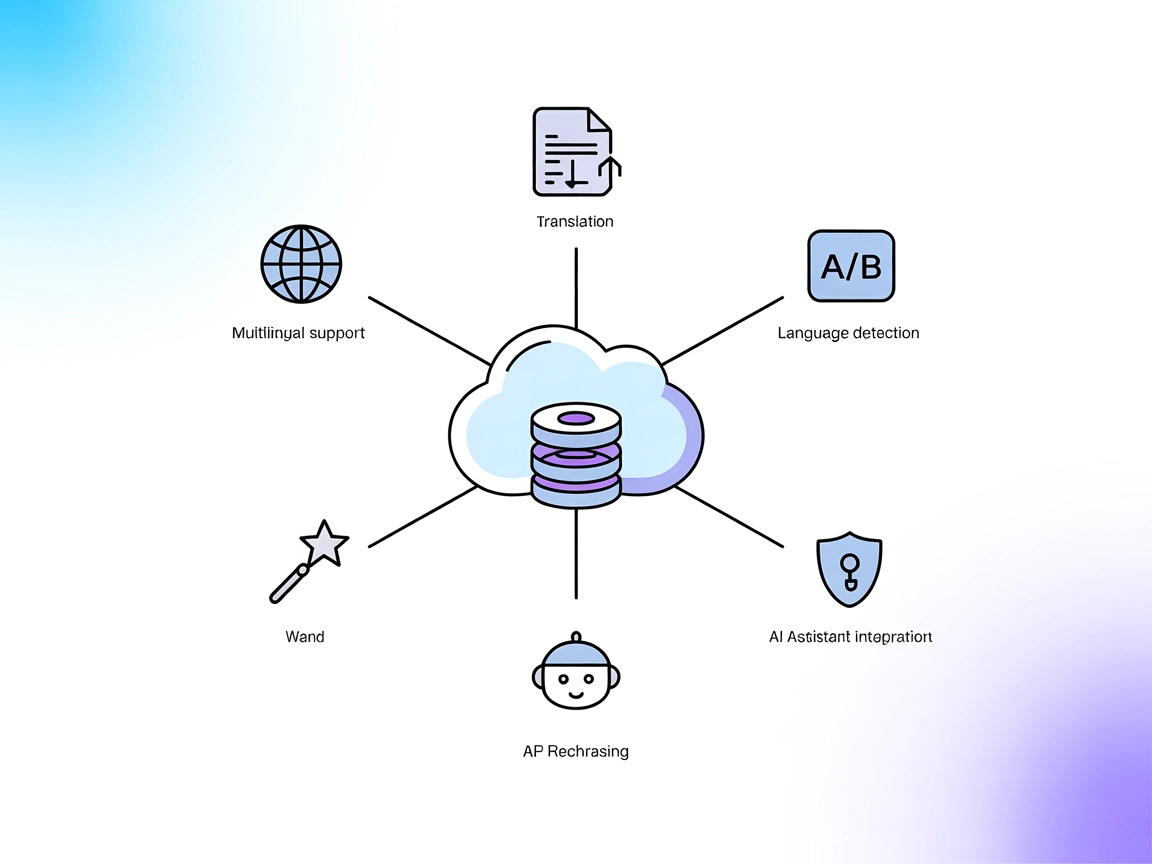

DeepL MCP Server integrerer avansert oversettelse, omformulering og språkgjenkjenning i AI-arbeidsflyter via DeepL API. Den gir FlowHunt og andre AI-assistenter...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.