Lara Translate MCP

Integrer FlowHunt med Lara Translate MCP for å levere avanserte, kontekstsensitive oversettelser i dine AI-arbeidsflyter. Automatiser flerspråklig innhold, utny...

Koble dine AI-agenter til profesjonell oversettelse med Lara Translate MCP Server—som gir sikre, høykvalitets og kontekstbevisste språktjenester i dine FlowHunt-arbeidsflyter.

FlowHunt gir et ekstra sikkerhetslag mellom dine interne systemer og AI-verktøy, og gir deg granulær kontroll over hvilke verktøy som er tilgjengelige fra dine MCP-servere. MCP-servere som er hostet i vår infrastruktur kan sømløst integreres med FlowHunts chatbot samt populære AI-plattformer som ChatGPT, Claude og forskjellige AI-editorer.

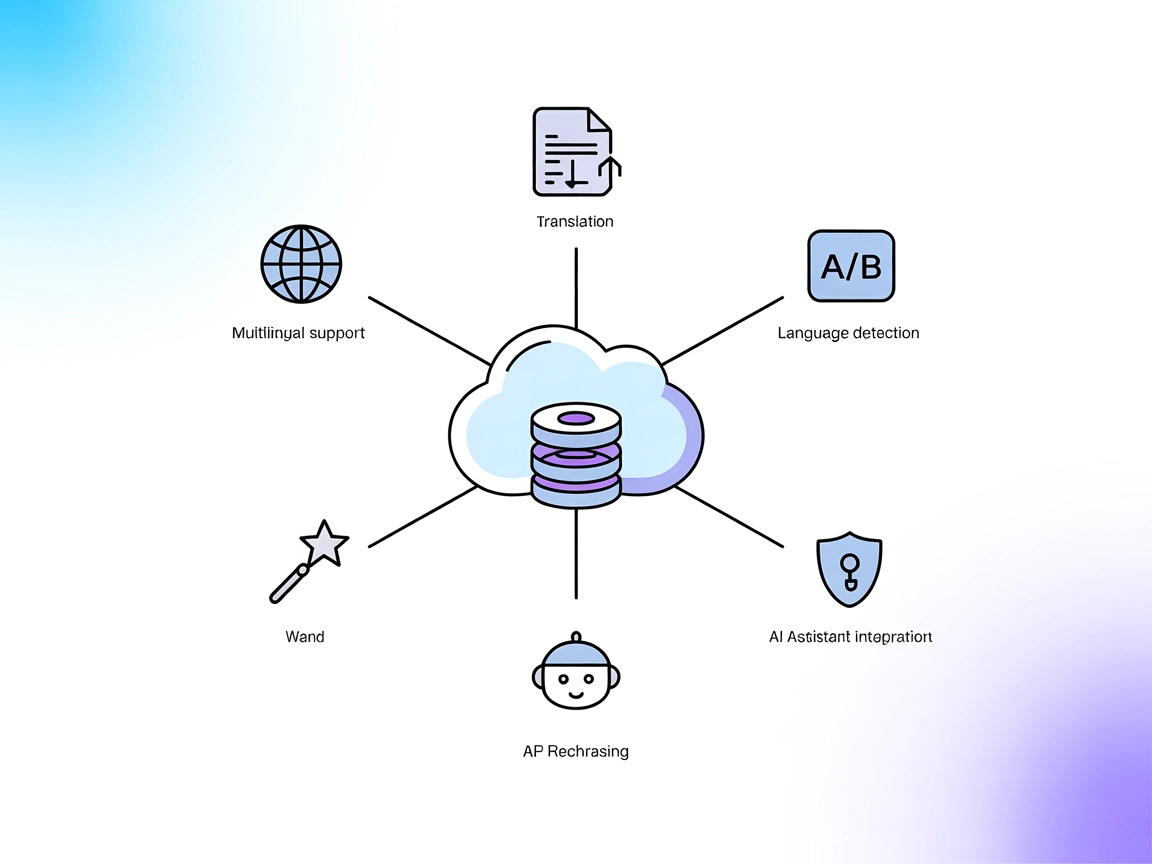

Lara Translate MCP Server er en Model Context Protocol (MCP)-server som kobler AI-assistenter og applikasjoner til Lara Translate API, og muliggjør profesjonell oversettelseskapasitet. Ved å fungere som en bro mellom AI-modeller og oversettelsestjenesten, tillater den sømløs integrasjon for oppgaver som språkdeteksjon, kontekstbevisste oversettelser og bruk av oversettelsesminner. Serveren gjør det mulig for AI-applikasjoner å utføre oversettelser sikkert og fleksibelt, oppdage tilgjengelige verktøy og ressurser, og håndtere oversettelsesforespørsler med strukturerte parametere. Denne tilnærmingen forbedrer utviklingsflyten og lar applikasjoner tilby oversettelser av høy kvalitet uten å måtte håndtere API-et direkte, samtidig som sikkerheten til API-nøkler opprettholdes og avanserte funksjoner for ikke-engelske språk støttes.

Ingen eksplisitte prompt-maler er listet opp i tilgjengelig dokumentasjon eller repository-filer.

Ingen eksplisitte MCP-ressurser er beskrevet i tilgjengelig dokumentasjon eller repository-filer.

windsurf.json eller tilsvarende konfigurasjonsfil.mcpServers-seksjonen:{

"mcpServers": {

"lara-mcp": {

"command": "npx",

"args": ["@translated/lara-mcp@latest"]

}

}

}

Sikring av API-nøkler:

{

"lara-mcp": {

"env": {

"LARA_API_KEY": "din-api-nøkkel"

},

"inputs": {

"apiKey": "${LARA_API_KEY}"

}

}

}

mcpServers-konfigurasjonen:{

"mcpServers": {

"lara-mcp": {

"command": "npx",

"args": ["@translated/lara-mcp@latest"]

}

}

}

Sikring av API-nøkler:

{

"lara-mcp": {

"env": {

"LARA_API_KEY": "din-api-nøkkel"

},

"inputs": {

"apiKey": "${LARA_API_KEY}"

}

}

}

{

"mcpServers": {

"lara-mcp": {

"command": "npx",

"args": ["@translated/lara-mcp@latest"]

}

}

}

Sikring av API-nøkler:

{

"lara-mcp": {

"env": {

"LARA_API_KEY": "din-api-nøkkel"

},

"inputs": {

"apiKey": "${LARA_API_KEY}"

}

}

}

mcpServers-seksjonen:{

"mcpServers": {

"lara-mcp": {

"command": "npx",

"args": ["@translated/lara-mcp@latest"]

}

}

}

Sikring av API-nøkler:

{

"lara-mcp": {

"env": {

"LARA_API_KEY": "din-api-nøkkel"

},

"inputs": {

"apiKey": "${LARA_API_KEY}"

}

}

}

Bruke MCP i FlowHunt

For å integrere MCP-servere i din FlowHunt-arbeidsflyt, start med å legge til MCP-komponenten i flyten og koble den til din AI-agent:

Klikk på MCP-komponenten for å åpne konfigurasjonspanelet. I systemets MCP-konfigurasjonsseksjon limer du inn MCP-serverdetaljene dine med dette JSON-formatet:

{

"lara-mcp": {

"transport": "streamable_http",

"url": "https://dinmcpserver.eksempel/stimcp/url"

}

}

Når det er konfigurert, kan AI-agenten nå bruke denne MCP-en som et verktøy med tilgang til alle dens funksjoner og egenskaper. Husk å endre “lara-mcp” til det faktiske navnet på din MCP-server og bytt ut URL-en med din egen MCP-server-URL.

| Seksjon | Tilgjengelig | Detaljer/Notater |

|---|---|---|

| Oversikt | ✅ | Detaljert introduksjon tilgjengelig |

| Liste over prompt-maler | ⛔ | Ingen eksplisitte prompt-maler listet |

| Liste over ressurser | ⛔ | Ingen MCP-ressurser beskrevet |

| Liste over verktøy | ✅ | Oversettelsesverktøy detaljert |

| Sikring av API-nøkler | ✅ | Instruksjoner for miljøvariabler gitt |

| Sampling-støtte (mindre viktig) | ⛔ | Ikke nevnt |

Basert på tilgjengelig dokumentasjon gir Lara Translate MCP et robust oversettelsesverktøy og tydelige oppsettinstruksjoner, men mangler eksplisitte prompt-maler, MCP-ressursoversikter og dokumentasjon for sampling/root-støtte. Alt i alt er det en fokusert og praktisk MCP-server for oversettelsesoppgaver.

| Har LICENSE | ✅ (MIT) |

|---|---|

| Har minst ett verktøy | ✅ |

| Antall forks | 9 |

| Antall stjerner | 57 |

Lara Translate MCP Server er en bro mellom AI-assistenter og Lara Translate API, som muliggjør sikre, kontekstbevisste oversettelser, språkdeteksjon og profesjonell flerspråklig innholdsgenerering innen AI-arbeidsflyter.

Den tilbyr et oversettelsesverktøy som gir strukturert tilgang til Lara Translates kjernefunksjoner, inkludert tekstoversettelse, språkdeteksjon og kontekstbevisst oversettelsesprosessering.

Lagre API-nøkkelen din som en miljøvariabel i MCP-serverkonfigurasjonen. Dette holder sensitiv påloggingsinformasjon sikker og ute av klientsiden.

Ja, Lara Translate MCP støtter kontekstbevisste oversettelser og kan bruke oversettelsesminner for å forbedre nøyaktigheten i domene-spesifikke scenarier.

Vanlige bruksområder inkluderer generering av flerspråklig innhold, integrering av oversettelse i AI-drevne arbeidsflyter, språkdeteksjon for AI-agenter og sikker håndtering av oversettelsespålogging.

Ingen eksplisitte prompt-maler eller samplingstøtte er nevnt i den nåværende dokumentasjonen.

Styrk dine AI-arbeidsflyter med sømløs, sikker og profesjonell oversettelse ved hjelp av Lara Translate MCP Server.

Integrer FlowHunt med Lara Translate MCP for å levere avanserte, kontekstsensitive oversettelser i dine AI-arbeidsflyter. Automatiser flerspråklig innhold, utny...

DeepL MCP Server integrerer avansert oversettelse, omformulering og språkgjenkjenning i AI-arbeidsflyter via DeepL API. Den gir FlowHunt og andre AI-assistenter...

ModelContextProtocol (MCP) Server fungerer som en bro mellom AI-agenter og eksterne datakilder, API-er og tjenester, slik at FlowHunt-brukere kan bygge kontekst...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.