MCP Proxy Server

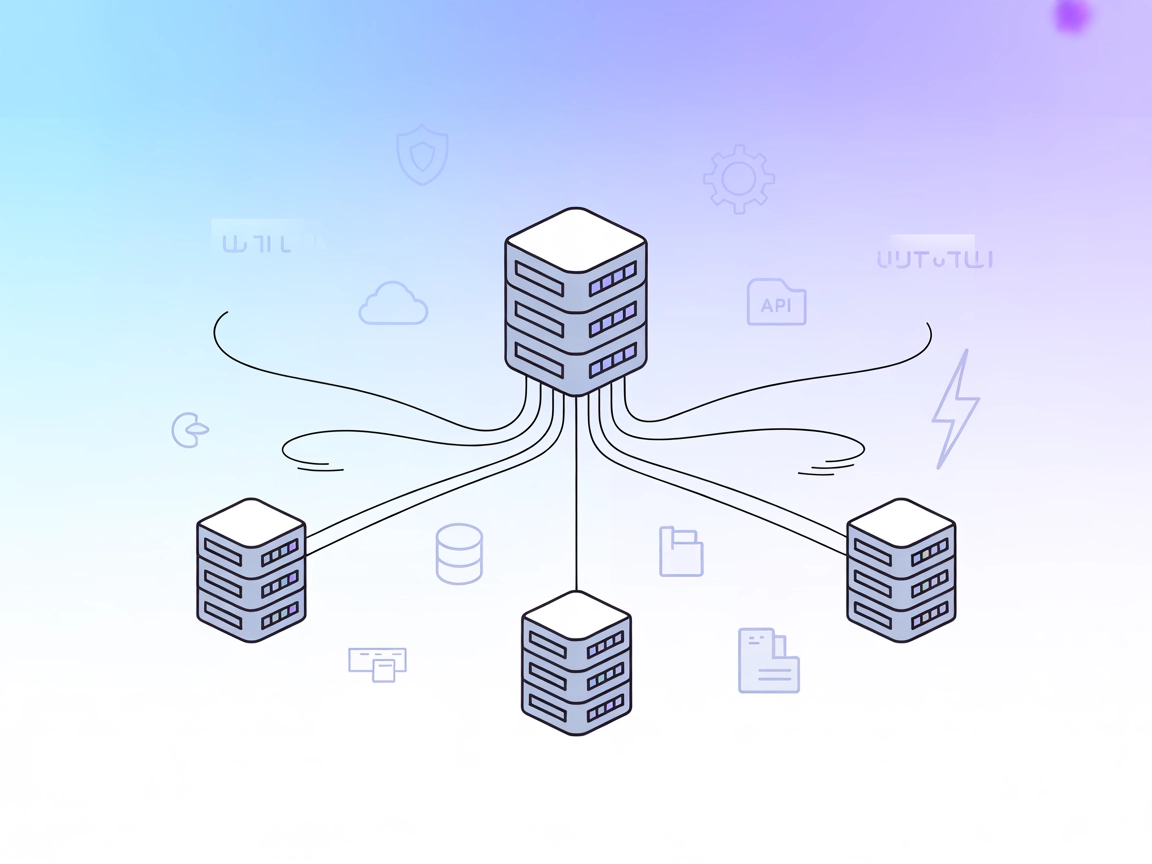

MCP Proxy Server samler flere MCP-ressursservere i én enkelt HTTP-server, og forenkler tilkoblinger for KI-assistenter og utviklere. Den muliggjør samlet tilgan...

Koble AI-assistenter til verktøy og systemer på tvers av ulike MCP-transportprotokoller ved å bruke mcp-proxy MCP-serveren for FlowHunt.

FlowHunt gir et ekstra sikkerhetslag mellom dine interne systemer og AI-verktøy, og gir deg granulær kontroll over hvilke verktøy som er tilgjengelige fra dine MCP-servere. MCP-servere som er hostet i vår infrastruktur kan sømløst integreres med FlowHunts chatbot samt populære AI-plattformer som ChatGPT, Claude og forskjellige AI-editorer.

mcp-proxy MCP-serveren fungerer som en bro mellom Streamable HTTP og stdio MCP-transporter, og muliggjør sømløs kommunikasjon mellom AI-assistenter og ulike typer Model Context Protocol (MCP)-servere eller klienter. Hovedfunksjonen er å oversette mellom disse to mye brukte transportprotokollene, slik at verktøy, ressurser og arbeidsflyter laget for én protokoll kan brukes via den andre uten endringer. Dette forbedrer utviklingsarbeidet ved å gjøre det mulig for AI-assistenter å samhandle med eksterne datakilder, API-er eller tjenester som bruker forskjellige transportmekanismer, og muliggjør dermed oppgaver som databaseforespørsler, filhåndtering eller API-interaksjon på tvers av ulike systemer.

Ingen prompt-maler er nevnt i repoet.

Ingen eksplisitte MCP-ressurser er beskrevet i dokumentasjonen eller koden til repoet.

Ingen verktøy er definert i repoets dokumentasjon eller synlig kode (f.eks. ingen eksplisitte funksjoner, verktøy eller server.py med verktøydefinisjoner tilstede).

mcp-proxy-repoet eller installer via PyPI hvis tilgjengelig.{

"mcpServers": {

"mcp-proxy": {

"command": "mcp-proxy",

"args": []

}

}

}

{

"mcpServers": {

"mcp-proxy": {

"command": "mcp-proxy",

"args": []

}

}

}

{

"mcpServers": {

"mcp-proxy": {

"command": "mcp-proxy",

"args": []

}

}

}

{

"mcpServers": {

"mcp-proxy": {

"command": "mcp-proxy",

"args": []

}

}

}

Sikre API-nøkler

Du kan sikre miljøvariabler (f.eks. API-nøkler) ved å bruke env i konfigurasjonen din:

{

"mcpServers": {

"mcp-proxy": {

"command": "mcp-proxy",

"args": [],

"env": {

"API_KEY": "${API_KEY}"

},

"inputs": {

"api_key": "${API_KEY}"

}

}

}

}

Bruke MCP i FlowHunt

For å integrere MCP-servere i FlowHunt-arbeidsflyten din, start med å legge til MCP-komponenten i flyten og koble den til AI-agenten din:

Klikk på MCP-komponenten for å åpne konfigurasjonspanelet. I seksjonen for system-MCP-konfigurasjon limer du inn detaljene til MCP-serveren din ved å bruke dette JSON-formatet:

{

"mcp-proxy": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Når dette er konfigurert, kan AI-agenten nå bruke denne MCP-en som et verktøy med tilgang til alle dens funksjoner og egenskaper. Husk å endre “mcp-proxy” til det faktiske navnet på din MCP-server og bytt ut URL-en med din egen MCP-server-URL.

| Seksjon | Tilgjengelig | Detaljer/Notater |

|---|---|---|

| Oversikt | ✅ | |

| Liste over Prompter | ⛔ | Ingen funnet |

| Liste over Ressurser | ⛔ | Ingen funnet |

| Liste over Verktøy | ⛔ | Ingen eksplisitte verktøy definert |

| Sikring av API-nøkler | ✅ | Via env i config |

| Sampling-støtte (mindre viktig for vurdering) | ⛔ | Ikke nevnt |

| Roots-støtte | ⛔ | Ikke nevnt |

Basert på ovenstående er mcp-proxy svært spesialisert for protokolloversettelse, men tilbyr ikke verktøy, prompter eller ressurser ut av boksen. Verdien ligger i integrasjon og tilkobling, ikke i å tilby direkte LLM-verktøy.

mcp-proxy er et kritisk verktøy for å bygge bro mellom MCP-transportprotokoller og gjør det svært verdifullt i miljøer hvor protokollmismatch begrenser interoperabiliteten mellom AI/LLM-verktøy. Den gir imidlertid ikke direkte LLM-forbedringer som ressurser, prompter eller verktøy. For sitt tiltenkte bruksområde er det et robust, godt støttet prosjekt. Vurdering: 6/10 for generell MCP-nytte, 9/10 hvis du spesifikt har behov for protokollbroing.

| Har en LISENS | ✅ (MIT) |

|---|---|

| Har minst ett verktøy | ⛔ |

| Antall forks | 128 |

| Antall stjerner | 1.1k |

mcp-proxy MCP-serveren bygger bro mellom Streamable HTTP og stdio MCP-transporter, og muliggjør sømløs kommunikasjon mellom AI-assistenter og ulike MCP-servere eller klienter. Dette lar arbeidsflyter og verktøy bygget for forskjellige protokoller fungere sammen uten endringer.

mcp-proxy er ideell for protokollbroing mellom ulike MCP-transporter, integrering av eldre systemer med moderne AI-plattformer, forbedring av AI-arbeidsflytens konnektivitet og støtte for plattformuavhengig utvikling og testing.

Nei, mcp-proxy fokuserer utelukkende på protokolloversettelse og tilbyr ikke innebygde verktøy, prompt-maler eller ressurser. Dens verdi ligger i å muliggjøre interoperabilitet og integrasjon.

Du kan bruke miljøvariabler i MCP-serverkonfigurasjonen for å sikre API-nøkler. Bruk for eksempel en 'env'-blokk og referer variabler i konfigurasjons-JSON-en din.

Legg til MCP-komponenten i FlowHunt-flyten din, og konfigurer deretter mcp-proxy MCP-serveren i systemets MCP-konfigurasjon ved å bruke riktig JSON-snutt. Dette lar AI-agenten din få tilgang til alle funksjoner som tilbys gjennom broede MCP-protokoller.

Bygg bro over hullene i AI-arbeidsflyten din og muliggjør sømløs protokoll-interoperabilitet med mcp-proxy. Integrer eldre systemer og utvid rekkevidden til AI-en din umiddelbart.

MCP Proxy Server samler flere MCP-ressursservere i én enkelt HTTP-server, og forenkler tilkoblinger for KI-assistenter og utviklere. Den muliggjør samlet tilgan...

ModelContextProtocol (MCP) Server fungerer som en bro mellom AI-agenter og eksterne datakilder, API-er og tjenester, slik at FlowHunt-brukere kan bygge kontekst...

JetBrains MCP Server kobler AI-agenter med JetBrains IDE-er som IntelliJ, PyCharm, WebStorm og Android Studio, og muliggjør automatiserte arbeidsflyter, kodenav...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.