LLM OpenAI

O FlowHunt suporta dezenas de modelos de geração de texto, incluindo modelos da OpenAI. Veja como utilizar o ChatGPT em suas ferramentas e chatbots de IA.

OpenAI Whisper é um sistema ASR de código aberto que converte fala em texto de forma precisa em 99 idiomas, suportando transcrição, tradução e identificação de idioma para automação robusta de IA.

O OpenAI Whisper pode ser considerado tanto um modelo quanto um sistema, dependendo do contexto.

A principal função do Whisper é transcrever fala em texto. Ele se destaca em:

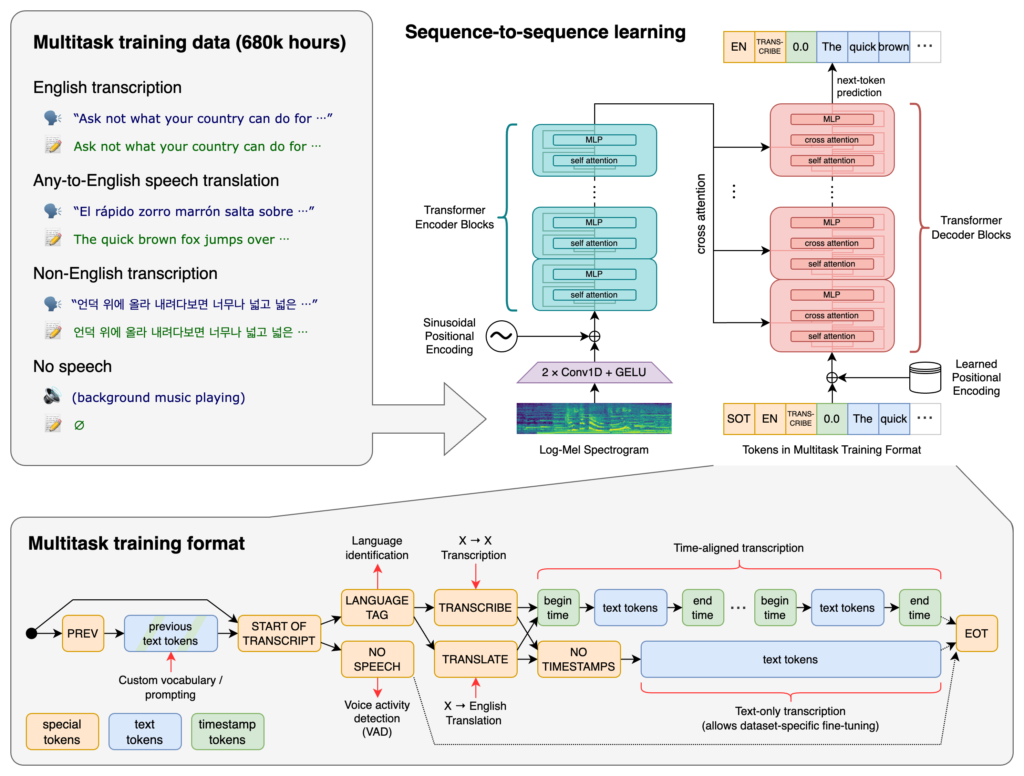

No núcleo do Whisper está a arquitetura Transformer, especificamente um modelo encoder-decoder. Transformers são redes neurais que se destacam no processamento de dados sequenciais e na compreensão de contexto em sequências longas. Introduzidos no artigo “Attention is All You Need” em 2017, os Transformers se tornaram fundamentais em muitas tarefas de PLN.

O processo do Whisper envolve:

O Whisper foi treinado em um enorme conjunto de 680.000 horas de dados supervisionados coletados da web. Isso inclui:

Com cobertura de 99 idiomas, o Whisper se destaca pela capacidade de lidar com entradas linguísticas diversas. Essa capacidade multilíngue o torna adequado para aplicações globais e serviços voltados a públicos internacionais.

Treinado em grandes volumes de dados supervisionados, o Whisper atinge altos índices de precisão em tarefas de transcrição. Sua robustez a diferentes sotaques, dialetos e ruídos de fundo o torna confiável em diversos cenários do mundo real.

Além da transcrição, o Whisper pode realizar:

Lançado como software de código aberto, o Whisper permite que desenvolvedores:

Ao integrar o Whisper em chatbots e assistentes de IA, desenvolvedores podem permitir:

O Whisper é implementado como uma biblioteca Python, permitindo integração fluida em projetos baseados em Python. Utilizar o Whisper em Python envolve configurar o ambiente, instalar as dependências necessárias e utilizar as funções da biblioteca para transcrever ou traduzir arquivos de áudio.

Antes de usar o Whisper, é necessário preparar o ambiente de desenvolvimento instalando Python, PyTorch, FFmpeg e a própria biblioteca Whisper.

Se ainda não tem o Python instalado, baixe no site oficial. Para instalar o PyTorch, utilize o pip:

pip install torch

Alternativamente, visite o site do PyTorch para instruções específicas conforme seu sistema operacional e versão do Python.

O Whisper requer o FFmpeg para processar arquivos de áudio. Instale o FFmpeg usando o gerenciador de pacotes apropriado ao seu sistema operacional.

Ubuntu/Debian:

sudo apt update && sudo apt install ffmpeg

MacOS (com Homebrew):

brew install ffmpeg

Windows (com Chocolatey):

choco install ffmpeg

Instale o pacote Whisper Python usando pip:

pip install -U openai-whisper

Para instalar a versão mais recente diretamente do repositório GitHub:

pip install git+https://github.com/openai/whisper.git

Certifique-se de que o Modo de Desenvolvedor está ativado:

O Whisper oferece vários modelos que variam em tamanho e capacidades. Os modelos vão de tiny a large, cada um equilibrando velocidade e precisão de forma diferente.

| Tamanho | Parâmetros | Modelo Somente Inglês | Modelo Multilíngue | VRAM Necessária | Velocidade Relativa |

|---|---|---|---|---|---|

| tiny | 39 M | tiny.en | tiny | ~1 GB | ~32x |

| base | 74 M | base.en | base | ~1 GB | ~16x |

| small | 244 M | small.en | small | ~2 GB | ~6x |

| medium | 769 M | medium.en | medium | ~5 GB | ~2x |

| large | 1550 M | N/A | large | ~10 GB | 1x |

.en): Otimizados para transcrição em inglês, oferecendo melhor desempenho para áudios nesse idioma.Após configurar o ambiente e instalar os componentes necessários, você pode começar a usar o Whisper em seus projetos Python.

Comece importando a biblioteca Whisper e carregando um modelo:

import whisper

# Carregue o modelo desejado

model = whisper.load_model("base")

Substitua "base" pelo nome do modelo que melhor se adapta à sua aplicação.

O Whisper fornece uma função simples transcribe para converter arquivos de áudio em texto.

Exemplo: Transcrevendo um Arquivo de Áudio em Inglês

# Transcreva o arquivo de áudio

result = model.transcribe("path/to/english_audio.mp3")

# Imprima a transcrição

print(result["text"])

model.transcribe(): Processa o arquivo de áudio e retorna um dicionário contendo a transcrição e outros metadados.result["text"]: Acessa o texto transcrito do resultado.O Whisper pode traduzir áudio de vários idiomas para o inglês.

Exemplo: Traduzindo Áudio em Espanhol para Inglês

# Transcreva e traduza áudio em espanhol para inglês

result = model.transcribe("path/to/spanish_audio.mp3", task="translate")

# Imprima o texto traduzido

print(result["text"])

task="translate": Instrui o modelo a traduzir o áudio para inglês em vez de apenas transcrever literalmente.Embora o Whisper possa detectar o idioma automaticamente, especificá-lo pode melhorar a precisão e a velocidade.

Exemplo: Transcrevendo Áudio em Francês

# Transcreva áudio em francês especificando o idioma

result = model.transcribe("path/to/french_audio.wav", language="fr")

# Imprima a transcrição

print(result["text"])

O Whisper pode identificar o idioma falado em um arquivo de áudio usando o método detect_language.

Exemplo: Detecção de Idioma

# Carregue e pré-processe o áudio

audio = whisper.load_audio("path/to/unknown_language_audio.mp3")

audio = whisper.pad_or_trim(audio)

# Converta para espectrograma log-Mel

mel = whisper.log_mel_spectrogram(audio).to(model.device)

# Detecte o idioma

_, probs = model.detect_language(mel)

language = max(probs, key=probs.get)

print(f"Idioma detectado: {language}")

whisper.load_audio(): Carrega o arquivo de áudio.whisper.pad_or_trim(): Ajusta o comprimento do áudio conforme os requisitos do modelo.whisper.log_mel_spectrogram(): Converte o áudio para o formato esperado pelo modelo.model.detect_language(): Retorna probabilidades para cada idioma, identificando o mais provável.Para maior controle sobre o processo de transcrição, é possível usar funções de baixo nível e personalizar opções de decodificação.

decodeA função decode permite especificar opções como idioma, tarefa e inclusão de marcações de tempo.

Exemplo: Opções de Decodificação Personalizadas

# Defina as opções de decodificação

options = whisper.DecodingOptions(language="de", without_timestamps=True)

# Decodifique o áudio

result = whisper.decode(model, mel, options)

# Imprima o texto reconhecido

print(result.text)

É possível integrar o Whisper para transcrever entrada de áudio ao vivo de um microfone.

Exemplo: Transcrevendo Entrada ao Vivo do Microfone

import whisper

import sounddevice as sd

# Carregue o modelo

model = whisper.load_model("base")

# Grave áudio do microfone

duration = 5 # segundos

fs = 16000 # Taxa de amostragem

print("Gravando...")

audio = sd.rec(int(duration * fs), samplerate=fs, channels=1, dtype='float32')

sd.wait

OpenAI Whisper é um avançado sistema de reconhecimento automático de fala (ASR) desenvolvido pela OpenAI, projetado para transcrever linguagem falada em texto escrito usando aprendizado profundo. Suporta 99 idiomas e se destaca em transcrição, tradução e identificação de idioma.

Whisper utiliza uma arquitetura encoder-decoder baseada em transformer, processa o áudio em espectrogramas log-Mel e produz texto via um modelo de linguagem. Foi treinado com 680.000 horas de dados multilíngues e multitarefas para alta precisão e robustez.

O Whisper suporta reconhecimento de fala multilíngue, tradução de fala, identificação automática de idioma, robustez a sotaques e ruídos, além de oferecer acesso de código aberto para personalização e integração.

Os requisitos de hardware dependem do tamanho do modelo: modelos menores como 'tiny' exigem cerca de 1GB de VRAM, enquanto o maior requer cerca de 10GB. O Whisper roda mais rápido em GPUs, mas pode funcionar em CPUs com tempos de processamento maiores.

Sim, o Whisper é implementado como uma biblioteca Python e pode ser instalado via pip. Permite fácil integração em projetos Python para transcrição de fala, tradução e aplicações de voz em tempo real.

Casos de uso comuns incluem transcrição automática de reuniões, chatbots ativados por voz, tradução ao vivo, ferramentas de acessibilidade (legendas e tecnologia assistiva), automação de call centers e sistemas de automação controlados por voz.

Sim, as alternativas incluem mecanismos de código aberto como Mozilla DeepSpeech, Kaldi, Wav2vec, e APIs comerciais como Google Cloud Speech-to-Text, Microsoft Azure AI Speech e AWS Transcribe.

Sim, o OpenAI Whisper é de código aberto, permitindo que desenvolvedores personalizem, ajustem e integrem em seus próprios produtos e serviços sem restrições de licenciamento.

Integre recursos avançados de conversão de fala em texto em suas aplicações, automatize fluxos de trabalho e melhore a experiência do usuário com OpenAI Whisper e FlowHunt.

O FlowHunt suporta dezenas de modelos de geração de texto, incluindo modelos da OpenAI. Veja como utilizar o ChatGPT em suas ferramentas e chatbots de IA.

Explore as capacidades avançadas do Llama 3.3 70B Versatile 128k como um Agente de IA. Esta análise aprofundada examina suas habilidades de raciocínio, resoluçã...

Explore como as avançadas capacidades de raciocínio do OpenAI O1 e o aprendizado por reforço superam o GPT4o em precisão de RAG, com benchmarks e análise de cus...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.