Unleash

Integre o FlowHunt com o Unleash Feature Toggle para uma gestão de feature flags perfeita em suas aplicações LLM. Verifique, crie e atualize flags instantaneame...

Automação de IA

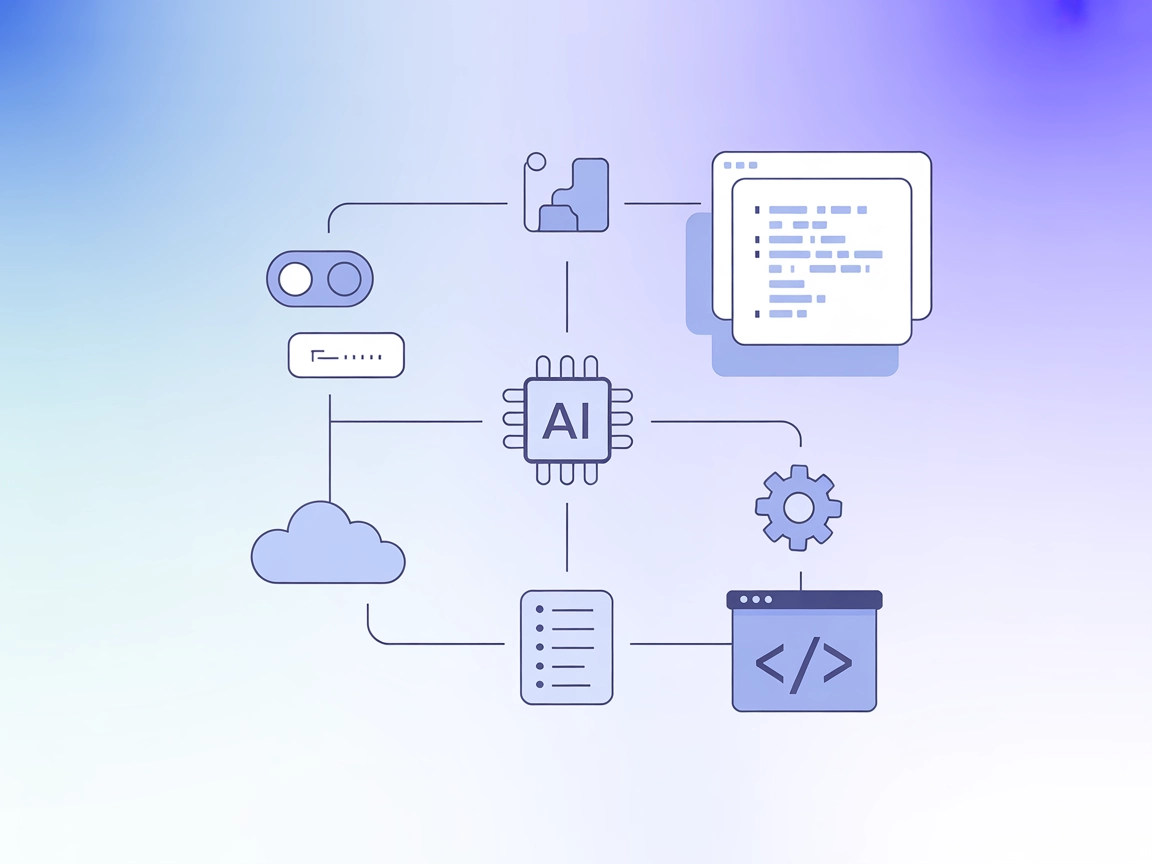

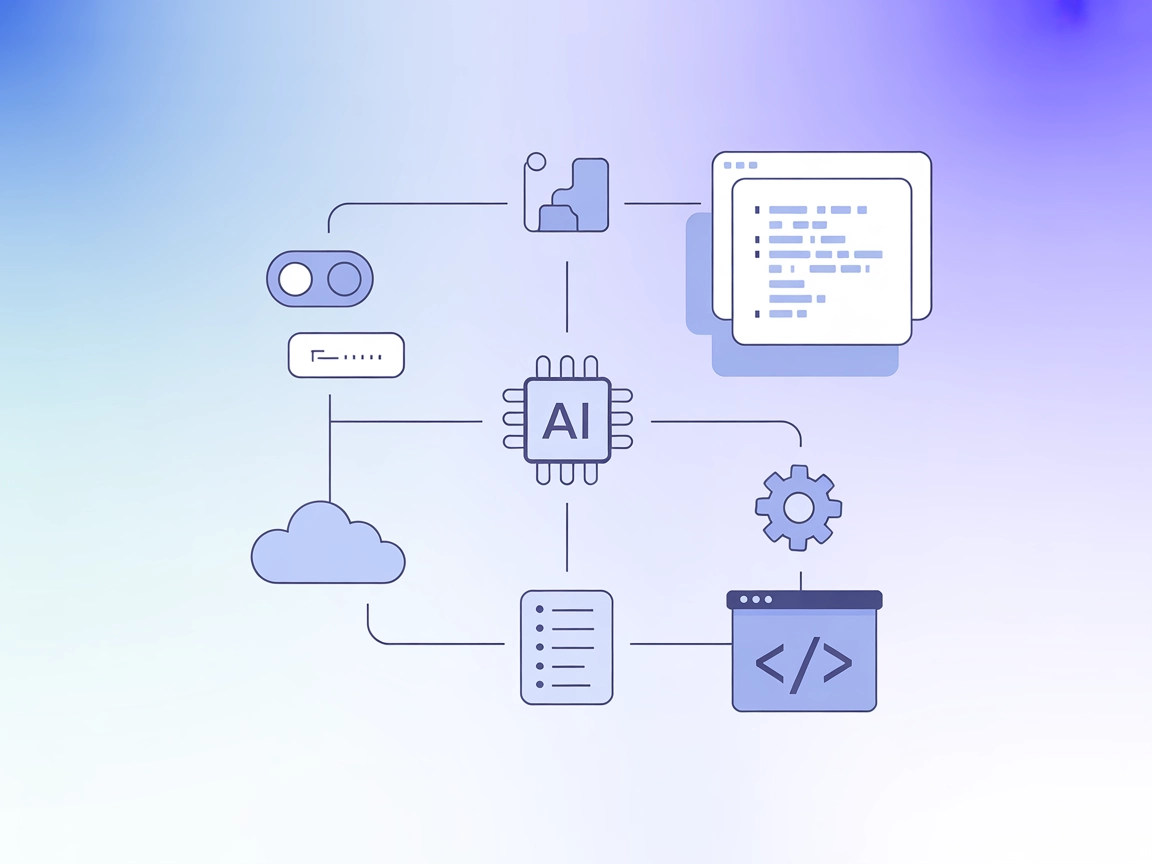

Conecte perfeitamente seus agentes de IA aos feature flags do Unleash com o Unleash MCP Server para tomada de decisão automatizada, gestão de feature flags e integração ágil de projetos.

O FlowHunt fornece uma camada de segurança adicional entre seus sistemas internos e ferramentas de IA, dando-lhe controle granular sobre quais ferramentas são acessíveis a partir de seus servidores MCP. Os servidores MCP hospedados em nossa infraestrutura podem ser perfeitamente integrados com o chatbot do FlowHunt, bem como com plataformas de IA populares como ChatGPT, Claude e vários editores de IA.

O Unleash MCP Server é uma implementação do Model Context Protocol (MCP) que conecta assistentes de IA e aplicações LLM ao sistema Unleash Feature Toggle. Ele atua como uma ponte, permitindo que clientes de IA consultem o status de feature flags, listem projetos e gerenciem feature flags diretamente do Unleash por interfaces MCP padronizadas. Essa integração permite aos desenvolvedores automatizar o gerenciamento de funcionalidades, expor dados de feature flags para agentes de IA tomarem decisões informadas, e agilizar fluxos de trabalho que dependem de alternância dinâmica de funcionalidades em sistemas de software. Fornecendo ferramentas e recursos que interagem com o Unleash, o servidor capacita aplicações orientadas por IA a aprimorar pipelines de desenvolvimento, realizar verificações automáticas e participar de operações de gestão de funcionalidades.

mcpServers usando o seguinte snippet JSON:"mcpServers": {

"unleash-mcp": {

"command": "npx",

"args": ["@cuongtl1992/unleash-mcp@latest"]

}

}

Utilize variáveis de ambiente para armazenar informações sensíveis:

{

"mcpServers": {

"unleash-mcp": {

"command": "npx",

"args": ["@cuongtl1992/unleash-mcp@latest"],

"env": {

"UNLEASH_API_KEY": "${UNLEASH_API_KEY}"

},

"inputs": {

"apiUrl": "https://unleash.example.com/api"

}

}

}

}

mcpServers:"mcpServers": {

"unleash-mcp": {

"command": "npx",

"args": ["@cuongtl1992/unleash-mcp@latest"]

}

}

"mcpServers": {

"unleash-mcp": {

"command": "npx",

"args": ["@cuongtl1992/unleash-mcp@latest"]

}

}

"mcpServers": {

"unleash-mcp": {

"command": "npx",

"args": ["@cuongtl1992/unleash-mcp@latest"]

}

}

Usando MCP no FlowHunt

Para integrar MCP servers ao seu fluxo do FlowHunt, comece adicionando o componente MCP ao seu fluxo e conectando-o ao seu agente de IA:

Clique no componente MCP para abrir o painel de configuração. Na seção de configuração do sistema MCP, insira os detalhes do seu MCP server utilizando este formato JSON:

{

"unleash-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Depois de configurado, o agente de IA estará apto a utilizar este MCP como uma ferramenta com acesso a todas as suas funções e capacidades. Lembre-se de trocar "unleash-mcp" pelo nome real do seu MCP server e ajustar a URL conforme necessário.

| Seção | Disponível | Detalhes/Notas |

|---|---|---|

| Visão Geral | ✅ | Fornece visão geral da integração com Unleash e aplicações LLM |

| Lista de Prompts | ✅ | Template de prompt flag-check |

| Lista de Recursos | ✅ | flags, projects |

| Lista de Ferramentas | ✅ | get-flag, get-projects |

| Protegendo as chaves de API | ✅ | Exemplo usando variáveis de ambiente |

| Suporte a sampling (menos relevante na análise) | ⛔ | Não mencionado |

O Unleash MCP Server oferece uma integração clara e focada para gerenciamento de feature flags em fluxos de LLM. O repositório cobre todos os primitivos MCP essenciais, traz instruções práticas de configuração e demonstra boas práticas de segurança. No entanto, funcionalidades MCP avançadas como sampling e roots não estão explicitamente documentadas. No geral, é um MCP server sólido e especializado, com valor claro para desenvolvedores.

| Possui LICENSE | ✅ (MIT) |

|---|---|

| Possui ao menos uma ferramenta | ✅ |

| Número de Forks | 0 |

| Número de Stars | 8 |

O Unleash MCP Server é uma implementação do Model Context Protocol que conecta assistentes de IA e aplicações LLM ao sistema Unleash Feature Toggle, permitindo a gestão automatizada de feature flags, descoberta de projetos e exposição dinâmica de funcionalidades.

Ele fornece um template de prompt `flag-check`, expõe `flags` e `projects` como recursos MCP e oferece as ferramentas `get-flag` e `get-projects` para interação com dados do Unleash.

Siga as instruções de configuração para sua plataforma (Windsurf, Claude, Cursor ou Cline), garantindo que o Node.js esteja instalado e as variáveis de ambiente estejam devidamente configuradas para acesso à API.

Os casos de uso incluem monitoramento de feature flags por IA, gestão automatizada de funcionalidades, descoberta de projetos, exposição contextual de flags para LLMs e integração com pipelines de deploy contínuo.

Ele permite a alternância automatizada de feature flags e gestão de projetos como parte dos pipelines de CI/CD, aumentando a agilidade do deploy e reduzindo a intervenção manual.

Dê poder aos seus agentes de IA para gerenciar e monitorar feature flags programaticamente. Otimize processos de deploy e fluxos de decisão com a integração do Unleash MCP Server.

Integre o FlowHunt com o Unleash Feature Toggle para uma gestão de feature flags perfeita em suas aplicações LLM. Verifique, crie e atualize flags instantaneame...

O Servidor Langfuse MCP conecta o FlowHunt e outros clientes de IA aos repositórios de prompts do Langfuse usando o Model Context Protocol, possibilitando a cen...

Integre o gerenciamento de projetos do ClickUp com assistentes de IA usando o ClickUp MCP Server. Esta ponte permite que agentes de IA acessem e automatizem tar...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.