Integrarea serverului ModelContextProtocol (MCP)

Serverul ModelContextProtocol (MCP) acționează ca o punte între agenții AI și sursele externe de date, API-uri și servicii, permițând utilizatorilor FlowHunt să...

Conectați-vă ușor la orice API de chat compatibil OpenAI printr-un singur server MCP, simplificând fluxurile de lucru LLM multi-provider în FlowHunt și nu numai.

FlowHunt oferă un strat suplimentar de securitate între sistemele dvs. interne și instrumentele AI, oferindu-vă control granular asupra instrumentelor care sunt accesibile de la serverele dvs. MCP. Serverele MCP găzduite în infrastructura noastră pot fi integrate fără probleme cu chatbotul FlowHunt, precum și cu platforme AI populare precum ChatGPT, Claude și diverși editori AI.

any-chat-completions-mcp Serverul MCP acționează ca o punte între asistenții AI și orice API de Chat Completion compatibil cu SDK-ul OpenAI, precum OpenAI, Perplexity, Groq, xAI și PyroPrompts. Respectând Model Context Protocol (MCP), permite integrarea fără probleme a furnizorilor LLM externi în fluxurile de lucru de dezvoltare. Funcția sa principală este de a transmite întrebări bazate pe chat către un furnizor AI de chat configurat, permițând dezvoltatorilor să utilizeze diverse LLM-uri ca unelte în mediile lor preferate. Acest lucru face ca sarcini precum schimbarea rapidă între furnizori sau scalarea utilizării LLM să fie simple, încurajând flexibilitatea și eficiența în aplicațiile cu AI.

Nu există șabloane de prompt menționate în repository sau în documentație.

Nu există resurse MCP explicite documentate în repository sau README.

Nu există instrucțiuni specifice platformei Windsurf în repository sau în documentație.

npx sunt instalate.claude_desktop_config.json (pe MacOS: ~/Library/Application Support/Claude/claude_desktop_config.json; pe Windows: %APPDATA%/Claude/claude_desktop_config.json).mcpServers.env.Exemplu JSON:

{

"mcpServers": {

"chat-openai": {

"command": "npx",

"args": [

"@pyroprompts/any-chat-completions-mcp"

],

"env": {

"AI_CHAT_KEY": "OPENAI_KEY",

"AI_CHAT_NAME": "OpenAI",

"AI_CHAT_MODEL": "gpt-4o",

"AI_CHAT_BASE_URL": "v1/chat/completions"

}

}

}

}

Securizarea cheilor API (folosind variabile de mediu):

"env": {

"AI_CHAT_KEY": "YOUR_PROVIDER_KEY"

}

Nu există instrucțiuni specifice platformei Cursor în repository sau în documentație.

Nu există instrucțiuni specifice platformei Cline în repository sau în documentație.

Utilizarea MCP în FlowHunt

Pentru a integra serverele MCP în fluxul tău FlowHunt, începe prin a adăuga componenta MCP în flow-ul tău și conecteaz-o la agentul AI:

Apasă pe componenta MCP pentru a deschide panoul de configurare. În secțiunea de configurare a sistemului MCP, introdu detaliile serverului tău MCP folosind acest format JSON:

{

"MCP-name": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

După ce ai configurat, agentul AI poate acum folosi acest MCP ca unealtă cu acces la toate funcțiile și capabilitățile sale. Nu uita să schimbi “MCP-name” cu numele efectiv al serverului tău MCP (ex: “github-mcp”, “weather-api”, etc.) și să înlocuiești URL-ul cu propriul tău URL de server MCP.

| Secțiune | Disponibilitate | Detalii/Note |

|---|---|---|

| Prezentare generală | ✅ | Acoperă scopul și funcționalitățile în README |

| Lista de Prompt-uri | ⛔ | Nu sunt menționate șabloane de prompt |

| Lista de Resurse | ⛔ | Nu sunt documentate resurse MCP explicite |

| Lista de Unelte | ✅ | Unealta “chat” descrisă în README |

| Securizarea cheilor API | ✅ | Folosește “env” în JSON pentru gestionarea cheilor |

| Suport sampling (mai puțin important la evaluare) | ⛔ | Nu se menționează funcții de sampling |

Pe baza celor de mai sus, any-chat-completions-mcp este un server MCP concentrat, optimizat pentru a adăuga API-uri de chat generice compatibile OpenAI ca unelte. Punctul său forte este simplitatea și compatibilitatea largă, deși nu oferă abstractizări de resurse sau prompt. Pentru integrarea de rutină a LLM-urilor, este robust, însă utilizatorii avansați pot dori mai multe funcții. Per ansamblu, aș evalua acest MCP la 6/10 pentru uz general.

| Are LICENȚĂ | ✅ (MIT) |

|---|---|

| Are cel puțin o unealtă | ✅ |

| Număr de Fork-uri | 17 |

| Număr de Stele | 129 |

Este un Server MCP care face legătura între FlowHunt sau orice client compatibil MCP și orice API de Chat Completion compatibil cu SDK-ul OpenAI, inclusiv furnizori precum OpenAI, Perplexity, Groq, xAI și PyroPrompts. Redirecționează interogările bazate pe chat printr-o singură unealtă și o configurație simplă.

Integrare unificată LLM, schimbare rapidă de furnizor, alimentarea agenților AI de desktop, benchmark pentru LLM-uri și acționarea ca gateway API securizat pentru interogări bazate pe chat.

Schimbarea este la fel de simplă ca actualizarea variabilelor de mediu (de exemplu, cheia API, URL-ul de bază, numele modelului) în configurația serverului MCP. Nu este nevoie de modificări de cod — doar reporniți clientul după actualizarea configurației.

Da, cheile API sunt gestionate prin variabile de mediu în configurație, păstrând credențialele în afara codului tău pentru o securitate mai bună.

O singură unealtă 'chat' care redirecționează mesajele bazate pe chat către orice endpoint API compatibil OpenAI configurat.

Nu, serverul este concentrat și optimizat pentru completări de chat. Nu oferă șabloane de prompt sau niveluri suplimentare de resurse.

Unifică-ți conexiunile AI chat API și schimbă furnizorii fără efort cu serverul MCP any-chat-completions-mcp. Perfect pentru dezvoltatorii care caută flexibilitate și simplitate.

Serverul ModelContextProtocol (MCP) acționează ca o punte între agenții AI și sursele externe de date, API-uri și servicii, permițând utilizatorilor FlowHunt să...

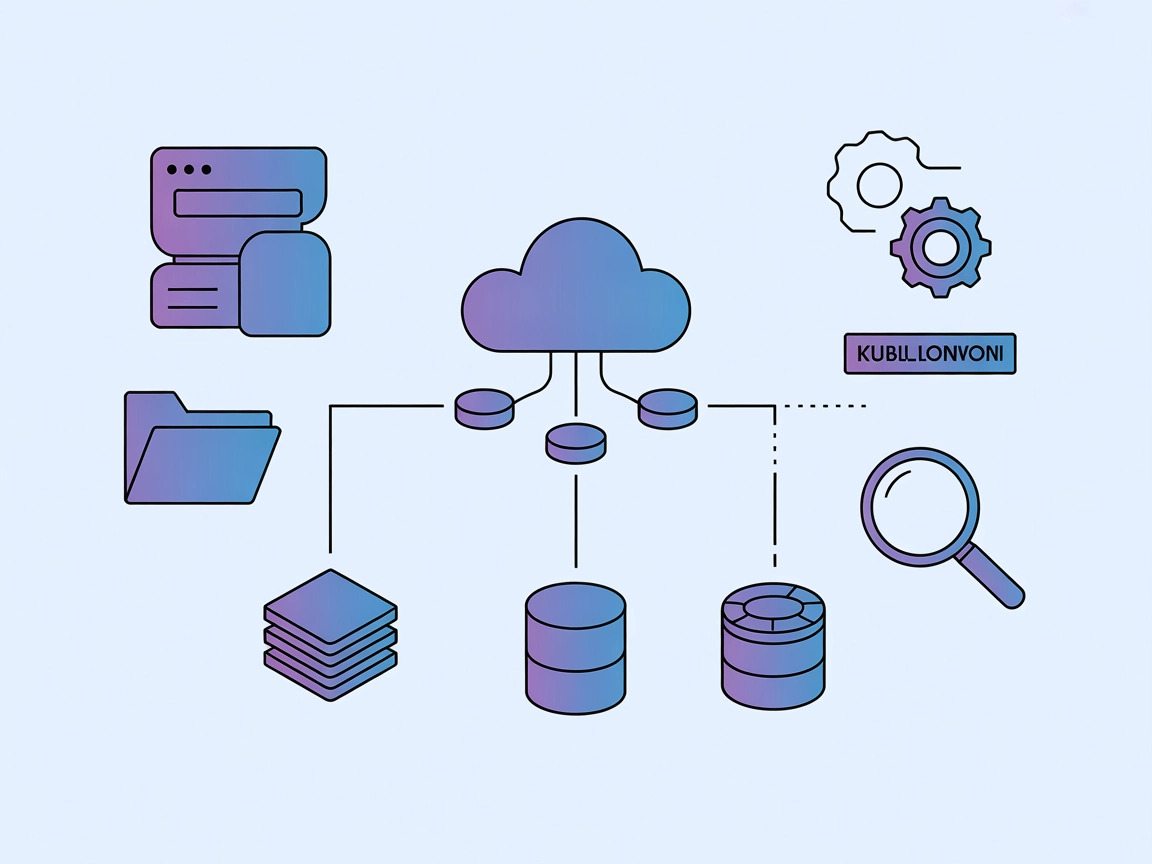

Kubernetes MCP Server creează o punte între asistenții AI și clusterele Kubernetes/OpenShift, permițând gestionarea programatică a resurselor, operarea podurilo...

Serverul Todos MCP este o aplicație open-source de tip listă de sarcini cu suport pentru Model Context Protocol (MCP), care permite asistenților AI și chatbot-u...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.