Markitdown MCP 服务器

Markitdown MCP 服务器为 AI 助手和 markdown 内容之间架起桥梁,实现自动化文档生成、内容分析以及 markdown 文件管理,从而提升开发者的工作流程。...

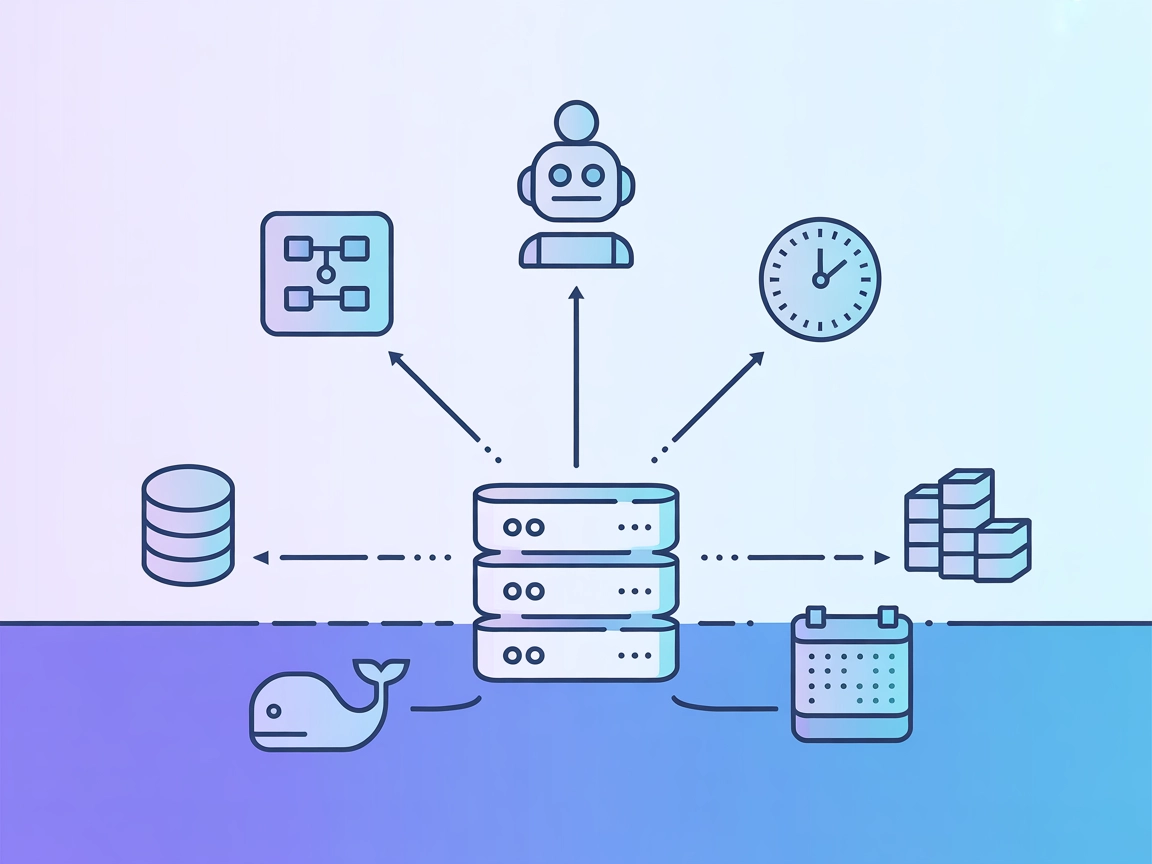

FlowHunt在您的内部系统和AI工具之间提供额外的安全层,让您能够精细控制从MCP服务器可访问哪些工具。托管在我们基础设施中的MCP服务器可以与FlowHunt的聊天机器人以及ChatGPT、Claude和各种AI编辑器等热门AI平台无缝集成。

puremd MCP(模型上下文协议)服务器是一个强大的工具,它作为解封、抓取和搜索的桥梁,将 AI 助手与代理连接到网页内容。借助 pure.md

平台,只需为任意 URL 加上 pure.md/ 前缀,脚本、API、应用和代理即可以 markdown 格式访问网页。这种方式绕过了机器人检测,渲染了大量 JavaScript 的单页应用,并将多种格式(HTML、PDF、图片)转换为 markdown。全球缓存的响应保证多次访问同一资源时的高效,减少源站压力。puremd-mcp 服务器教会 MCP 客户端(如 Cursor、Windsurf 和 Claude Desktop)如何使用这些功能,从而在 AI 开发工作流中实现内容解封和高级网页搜索。

仓库或文档未明确提及任何 prompt 模板。

仓库或文档未描述任何 MCP 定义的具体资源。

./codeium/windsurf/model_config.json。{

"mcpServers": {

"pure.md": {

"command": "npx",

"args": ["-y", "puremd-mcp"],

"env": {

"PUREMD_API_KEY": "<TOKEN>"

}

}

}

}

~/Library/Application Support/Claude/claude_desktop_config.json。{

"mcpServers": {

"pure.md": {

"command": "npx",

"args": ["-y", "puremd-mcp"],

"env": {

"PUREMD_API_KEY": "<TOKEN>"

}

}

}

}

~/.cursor/mcp.json。{

"mcpServers": {

"pure.md": {

"command": "npx",

"args": ["-y", "puremd-mcp"],

"env": {

"PUREMD_API_KEY": "<TOKEN>"

}

}

}

}

仓库或文档中未提供 Cline 专用指引。

API 密钥应通过 MCP 服务器配置中的 env 字段安全存储:

{

"mcpServers": {

"pure.md": {

"command": "npx",

"args": ["-y", "puremd-mcp"],

"env": {

"PUREMD_API_KEY": "<TOKEN>"

}

}

}

}

在 FlowHunt 中使用 MCP

要将 MCP 服务器集成到 FlowHunt 工作流中,首先添加 MCP 组件到您的流程,并将其连接到 AI 代理:

点击 MCP 组件以打开配置面板。在系统 MCP 配置部分,按如下 JSON 格式插入您的 MCP 服务器信息:

{

"MCP-name": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

配置完成后,AI 代理即可将此 MCP 作为工具,访问其全部功能。请记得将 “MCP-name” 替换为实际的 MCP 服务器名称(如 “github-mcp”、“weather-api” 等),并将 URL 替换为您自己的 MCP 服务器地址。

| 部分 | 是否可用 | 说明/备注 |

|---|---|---|

| 总览 | ✅ | |

| Prompts 列表 | ⛔ | 未发现 prompt 模板 |

| 资源列表 | ⛔ | 未描述资源 |

| 工具列表 | ✅ | unblock-url, search-web |

| API 密钥安全存储 | ✅ | 配置中通过 env 实现 |

| 支持 Sampling(评估时可不重要) | ⛔ | 未提及 |

根据现有文档,puremd-mcp 是一个专注且实用的 MCP 服务器,在网页解封和搜索方面有明确用途。但其缺少 prompt 模板和资源定义,也未提及 Roots 或 Sampling 支持。作为通用网页访问和搜索工具,它凭借简洁与实用性获得了不错的评价。

| 是否有 LICENSE | ⛔(未发现 LICENSE) |

|---|---|

| 至少有一个工具 | ✅ |

| Fork 数 | 2 |

| Star 数 | 25 |

puremd MCP 服务器通过解封网站、渲染 JavaScript 密集型页面,并将多种格式(HTML、PDF、图片)转换为 markdown,将 AI 助手与代理连接到网页内容。它为 LLM 提供了可靠的网页抓取、搜索和上下文增强能力。

通过利用 pure.md 的基础设施,puremd MCP 将请求通过自身平台进行路由,从而绕过常见的反机器人措施,允许访问通常会被自动脚本阻止的内容。

MCP 提供了 'unblock-url' 用于从网页提取 markdown 而不被封锁,以及 'search-web' 用于执行网页搜索并将结果以 markdown 形式摘要。

API 密钥为可选项,但推荐用于更高的速率限制。您可以在 pure.md 注册并生成密钥,并将其作为环境变量配置在 MCP 服务器中。

它可以将 HTML、PDF、图片等网页资源转换为标准化的 markdown,方便 LLM 或代理工作流使用。

是的,它使用类似全球 CDN 的缓存,加速重复访问并降低源站压力。

只需将 MCP 组件添加到您的流程中,打开配置,按照提供的 JSON 格式填入 puremd MCP 相关信息即可。配置完成后,您的 AI 代理即可在 FlowHunt 内访问 puremd MCP 的全部功能。

Markitdown MCP 服务器为 AI 助手和 markdown 内容之间架起桥梁,实现自动化文档生成、内容分析以及 markdown 文件管理,从而提升开发者的工作流程。...

Prefect MCP 服务器作为 AI 助手与 Prefect 工作流编排平台之间的桥梁,使得通过自然语言管理流、部署、运行等变得可能。通过 FlowHunt 或其他 AI 驱动界面,轻松实现 Prefect 资源的自动化、监控与控制。...

模型上下文协议(MCP)服务器将 AI 助手与外部数据源、API 和服务连接起来,实现复杂工作流的无缝集成,并在 FlowHunt 中安全管理开发任务。...

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.