Forespørgselsudvidelse

Omskriver brugerens input til flere alternative forespørgsler for at forbedre semantisk søgning i vidensbasen ved hjælp af en LLM-prompt.

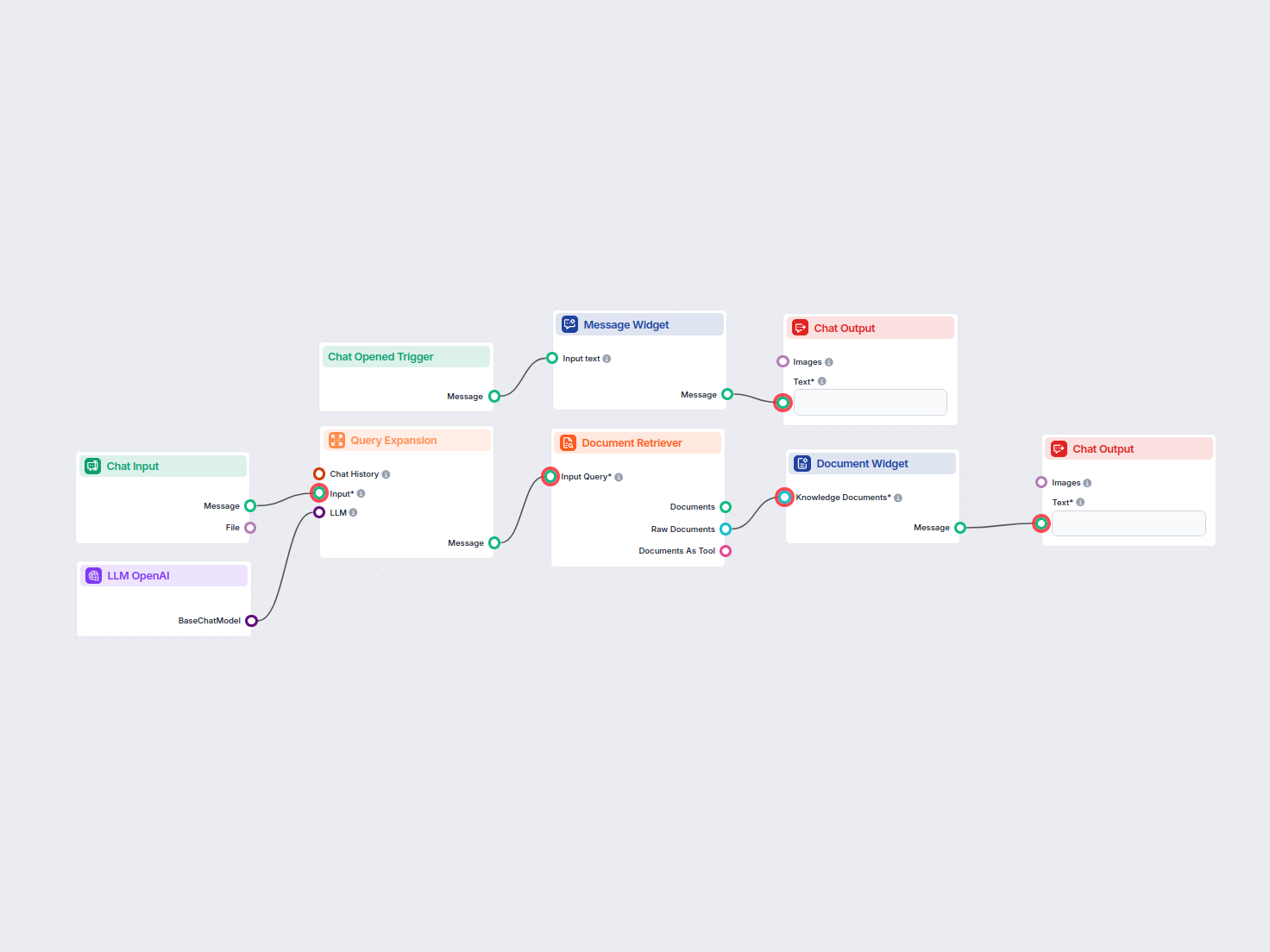

Søg nemt og hent information fra private vidensbase-dokumenter ved hjælp af semantisk søgning drevet af AI. Flowet udvider brugerforespørgsler, søger på tværs af flere videnskilder og præsenterer relevante resultater i en brugervenlig chatgrænseflade.

Flows

Omskriver brugerens input til flere alternative forespørgsler for at forbedre semantisk søgning i vidensbasen ved hjælp af en LLM-prompt.

Nedenfor er en komplet liste over alle komponenter, der bruges i dette flow for at opnå dets funktionalitet. Komponenter er byggestenene i hvert AI-flow. De giver dig mulighed for at skabe komplekse interaktioner og automatisere opgaver ved at forbinde forskellige funktioner. Hver komponent tjener et specifikt formål, såsom at håndtere brugerinput, behandle data eller integrere med eksterne tjenester.

Chat Input-komponenten i FlowHunt igangsætter brugerinteraktioner ved at indsamle beskeder fra Playground. Den fungerer som startpunktet for flows og gør det muligt for arbejdsgangen at behandle både tekst- og filbaserede input.

Opdag Chat Output-komponenten i FlowHunt—afslut chatbot-svar med fleksible, fler-delte outputs. Uundværlig for problemfri flow-afslutning og til at skabe avancerede, interaktive AI-chatbots.

Besked-widget-komponenten viser brugerdefinerede beskeder i dit workflow. Ideel til at byde brugere velkommen, give instruktioner eller vise vigtig information, den understøtter Markdown-formatering og kan indstilles til kun at blive vist én gang pr. session.

Komponenten Chat Åbnet Udløser registrerer, når en chatsession starter, og gør det muligt for workflows at reagere øjeblikkeligt, så snart en bruger åbner chatten. Den indleder flows med den indledende chatbesked, hvilket gør den essentiel til opbygning af responsive, interaktive chatbots.

Forespørgselsudvidelse i FlowHunt forbedrer chatbotforståelsen ved at finde synonymer, rette stavefejl og sikre ensartede, nøjagtige svar på brugerforespørgsler.

FlowHunt's Dokumenthenter forbedrer AI-nøjagtigheden ved at forbinde generative modeller til dine egne opdaterede dokumenter og URL'er, hvilket sikrer pålidelige og relevante svar ved hjælp af Retrieval-Augmented Generation (RAG).

Vis relevante dokumenter direkte i dine chatbot-svar ved hjælp af Videnskabskilde-widgetten. Denne komponent viser udvalgte vidensdokumenter som visuelt adskilte widgets, hvilket gør det nemt for brugerne at få adgang til og gennemgå understøttende information under en samtale.

FlowHunt understøtter dusinvis af tekstgenereringsmodeller, herunder modeller fra OpenAI. Her er, hvordan du bruger ChatGPT i dine AI-værktøjer og chatbots.

Flow-beskrivelse

Dette workflow, med titlen “Semantisk Søgning”, gør det muligt for brugere at søge efter information i deres private vidensbase ved at udnytte avancerede sprogmodeller og semantiske søgeteknikker. Det er designet til at scanne på tværs af alle planlagte domæner, dokumenter og Q&A-sektioner og automatiserer hentning af de mest relevante informationer som svar på brugerforespørgsler.

Når en bruger åbner chatgrænsefladen, udløser workflowet en velkomstbesked:

👋 Velkommen til det Private Vidensbase-søgeværktøj!

Jeg er her for at hjælpe dig med at søge i dokumenter i din private vidensbase 📚. Jeg scanner alle planlagte domæner, private dokumenter og Q&A-sektioner for at finde de informationer, du har brug for.

Indtast blot din forespørgsel, og lad os komme i gang med at finde svarene! ✨🔍

Denne venlige besked hjælper brugere med at finde sig til rette og guider dem til at indtaste deres søgeforespørgsel.

Brugerinput:

Brugeren indsender en forespørgsel via chatindgangsfeltet.

Forespørgselsudvidelse:

gpt-4o-mini) genererer denne komponent op til tre omskrevne eller semantisk lignende forespørgsler.| Komponent | Formål |

|---|---|

| Chat Input | Indsamler brugerens søgespørgsmål |

| OpenAI LLM (gpt-4o-mini) | Genererer alternative formuleringer af forespørgslen |

| Forespørgselsudvidelse | Producerer op til 3 varianter af forespørgslen til søgning |

<H1>-overskrifter for at maksimere kontekst-relevans.| Trin | Komponent | Outputtype |

|---|---|---|

| Hent dokumenter | Document Retriever | Rå dokumenter |

| Formater resultater | Document Widget | Besked |

| Vis til bruger | Chat Output | Chatbesked |

flowchart LR

A[Chat Opened] --> B[Welcome Message]

B --> C[User Query Input]

C --> D[Query Expansion\n(OpenAI LLM)]

D --> E[Document Retriever]

E --> F[Document Widget]

F --> G[Chat Output]

Typiske anvendelsestilfælde:

Ved at integrere semantisk søgning med LLM-drevet forespørgselsudvidelse sikrer dette workflow, at brugerne effektivt kan få adgang til relevant viden, hvilket øger produktivitet og informationsopdagelse.

Vi hjælper virksomheder som din med at udvikle smarte chatbots, MCP-servere, AI-værktøjer eller andre typer AI-automatisering til at erstatte mennesker i gentagne opgaver i din organisation.

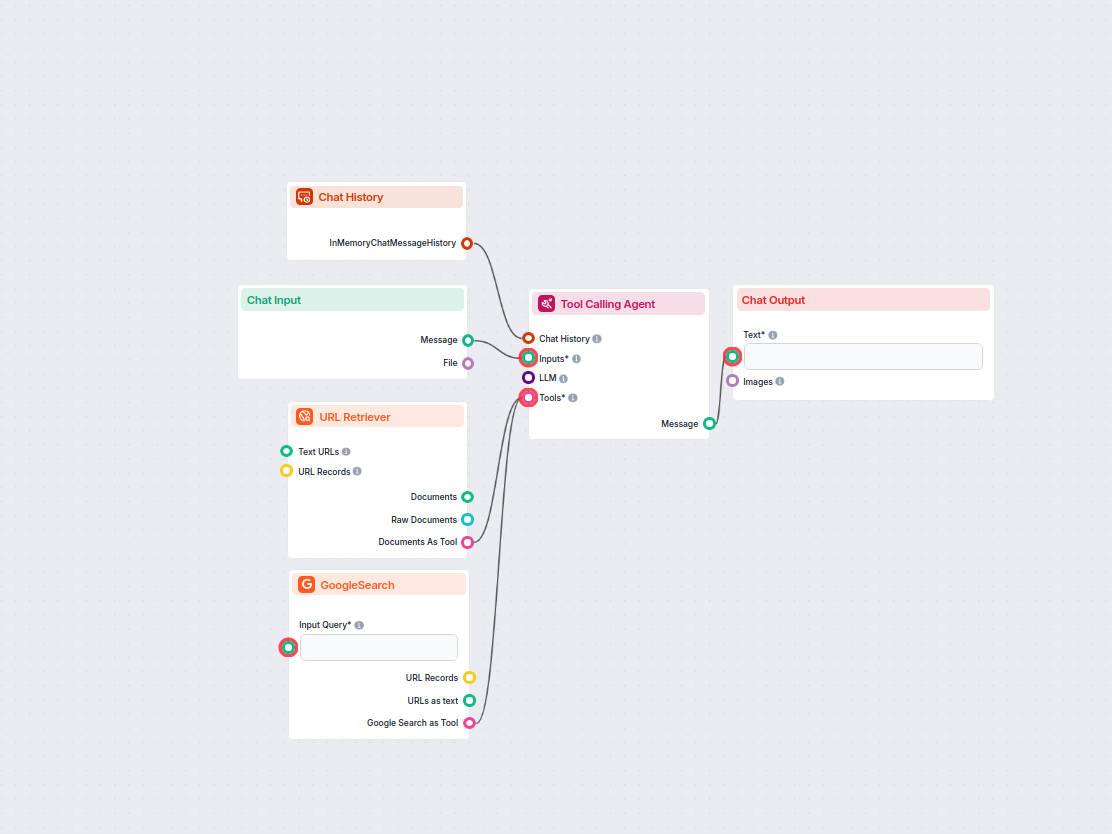

Opdag, hvad folk taler om online i forhold til dit valgte nøgleord. Dette AI-drevne workflow undersøger trendende eller relaterede emner fra nylige diskussioner...

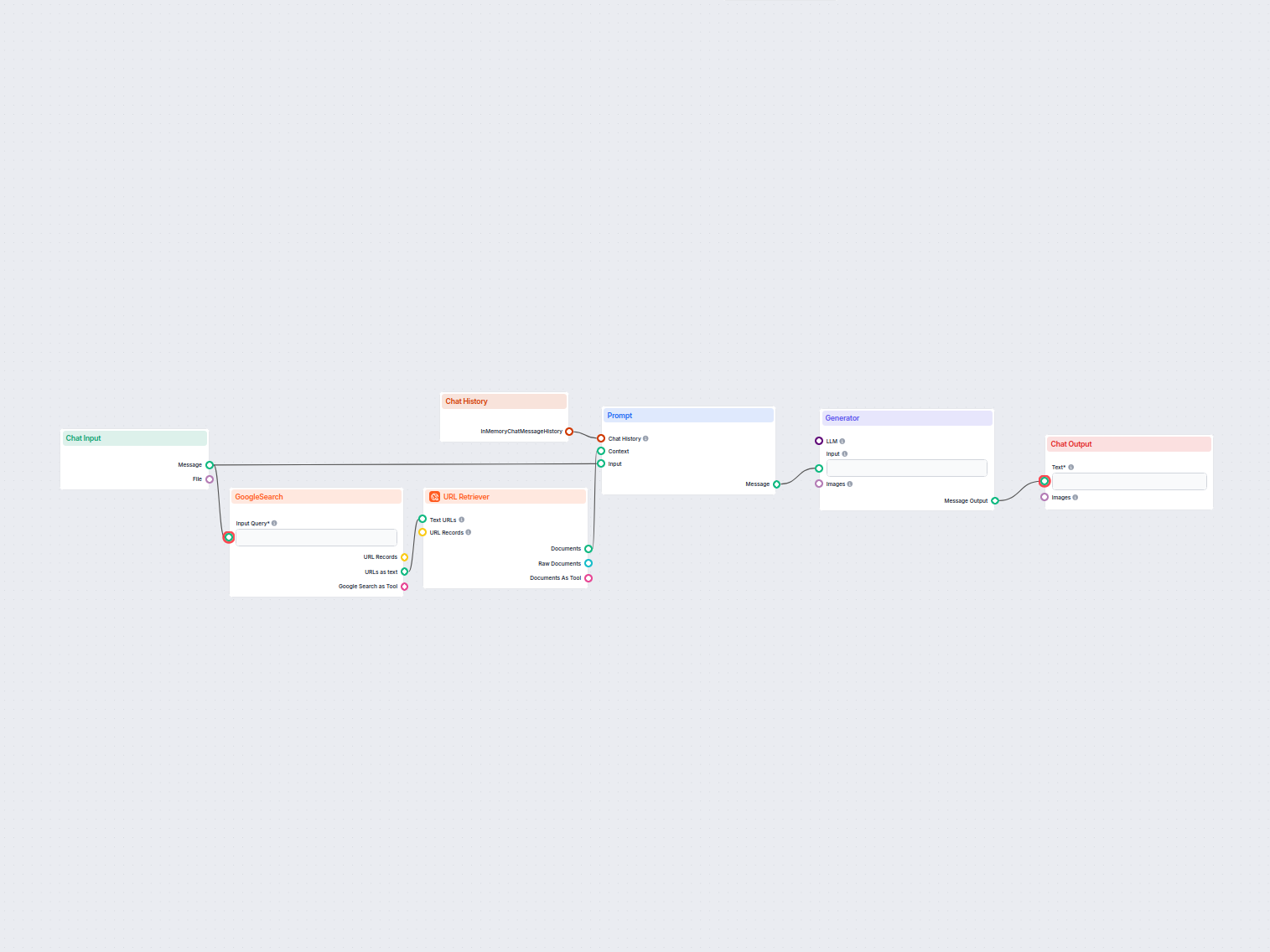

Generér unikke indholdsidéer og resuméer med AI ved at undersøge de bedste Google-resultater for ethvert nøgleord. Ideel til content marketers og indholdsskaber...

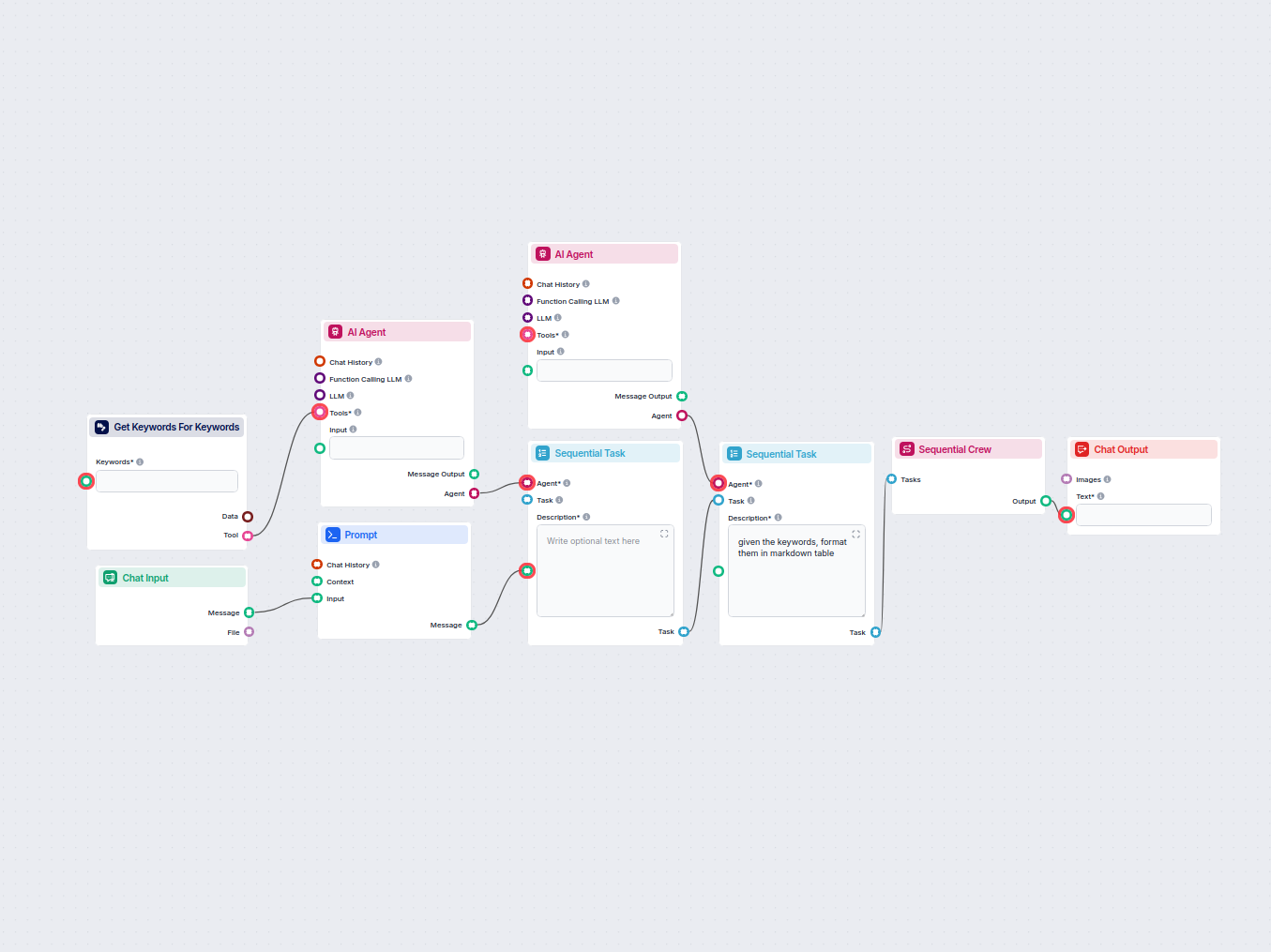

Denne arbejdsgang automatiserer søgeordsforskning ved at generere en detaljeret tabel over relaterede søgeord til din målsætning, inklusive vigtige SEO-målinger...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.