Rerangement de Documents

Le rerangement de documents est le processus de réorganisation des documents récupérés en fonction de leur pertinence par rapport à la requête d'un utilisateur,...

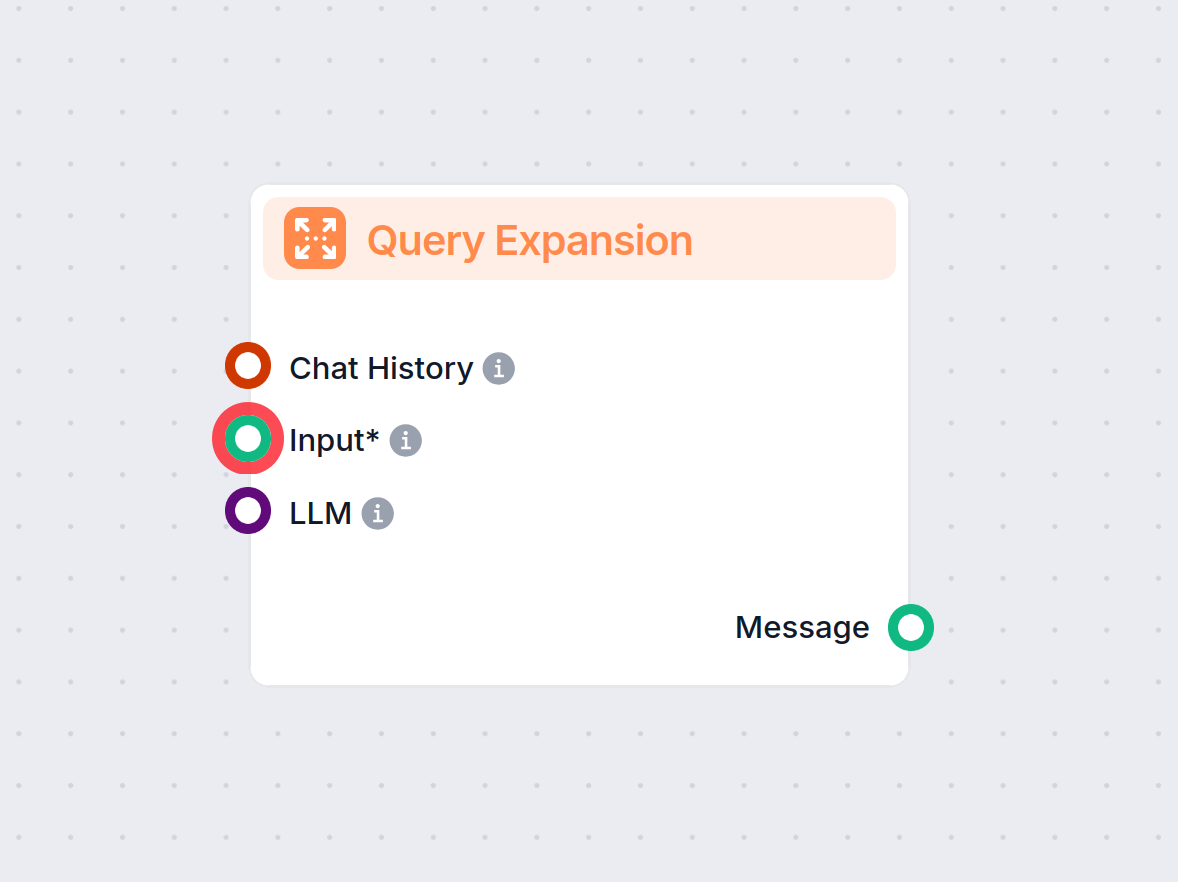

L’expansion de requête enrichit les requêtes utilisateur avec du contexte ou des termes supplémentaires, augmentant la précision de la récupération et la qualité des réponses dans les systèmes d’IA comme RAG et les chatbots.

L’expansion de requête améliore les requêtes des utilisateurs en ajoutant des termes ou du contexte, ce qui optimise la récupération de documents pour des réponses précises. Dans les systèmes RAG, elle augmente le rappel et la pertinence, aidant les chatbots et l’IA à fournir des réponses exactes en gérant efficacement les requêtes vagues ou synonymes.

L’expansion de requête désigne le processus d’enrichissement de la requête originale d’un utilisateur par l’ajout de termes ou de contexte supplémentaires avant de l’envoyer au mécanisme de recherche. Cette augmentation permet de récupérer des documents ou informations plus pertinents, qui sont ensuite utilisés pour générer une réponse plus précise et contextuellement appropriée. Si les documents sont recherchés avec des requêtes alternatives puis reclassés, le processus RAG obtient des résultats de documents bien plus précis dans la fenêtre de contexte du prompt.

La génération augmentée par récupération (RAG) est une architecture d’IA qui combine des mécanismes de recherche avec des modèles génératifs pour produire des réponses plus précises et contextuellement pertinentes. Dans les systèmes RAG, un composant de recherche récupère des documents ou des segments de données pertinents d’une base de connaissances à partir d’une requête utilisateur. Ensuite, un modèle génératif (souvent un grand modèle de langage ou LLM) utilise ces informations récupérées pour générer une réponse cohérente et informative.

Dans les systèmes RAG, la qualité de la réponse générée dépend fortement de la pertinence des documents récupérés. Si le composant de recherche n’obtient pas les informations les plus pertinentes, le modèle génératif peut produire des réponses sous-optimales ou hors sujet. L’expansion de requête relève ce défi en améliorant la requête initiale, augmentant ainsi les chances de récupérer tous les documents pertinents.

En élargissant la requête originale avec des termes associés, des synonymes ou des paraphrases, l’expansion de requête élargit l’espace de recherche. Cela augmente le rappel du système de recherche, c’est-à-dire qu’il capture une plus grande proportion de documents pertinents de la base de connaissances. Un rappel plus élevé offre un contexte plus riche au modèle génératif, améliorant la qualité globale de la sortie du système RAG.

Les LLMs comme GPT-4 peuvent générer des requêtes sémantiquement similaires ou des paraphrases de la requête originale. En comprenant le contexte et les nuances du langage, les LLMs produisent des expansions de qualité couvrant différentes façons de poser la même question.

Exemple :

Dans cette approche, le système génère une réponse hypothétique à la requête utilisateur à l’aide d’un LLM. Cette réponse hypothétique est ensuite ajoutée à la requête originale pour fournir davantage de contexte lors de la recherche.

Processus :

Exemple :

Cette méthode consiste à générer plusieurs requêtes alternatives reflétant différentes formulations ou aspects de la requête originale. Chaque requête est utilisée indépendamment pour récupérer des documents.

Processus :

Exemple :

Scénario :

Un système d’IA est conçu pour répondre à des questions sur le rapport annuel d’une entreprise. Un utilisateur demande : « Y a-t-il eu un important renouvellement dans l’équipe dirigeante ? »

Mise en œuvre :

Avantage :

En fournissant davantage de contexte via la réponse hypothétique, le système récupère des informations qui auraient pu être manquées avec la requête originale seule.

Scénario :

Un chatbot de support client aide les utilisateurs à résoudre des problèmes. Un utilisateur tape : « Mon internet est lent. »

Mise en œuvre :

Avantage :

Le chatbot couvre un éventail plus large de problèmes et de solutions, augmentant les chances de résoudre efficacement le problème de l’utilisateur.

Scénario :

Un étudiant utilise un assistant IA pour trouver des ressources sur le sujet : « Effets de la privation de sommeil sur la fonction cognitive. »

Mise en œuvre :

Avantage :

L’étudiant bénéficie d’informations complètes couvrant divers aspects du sujet, facilitant une recherche approfondie.

Ajouter trop de requêtes élargies peut introduire des documents non pertinents, ce qui réduit la précision de la recherche.

Atténuation :

Les mots à sens multiples peuvent entraîner des expansions non pertinentes.

Atténuation :

Générer et traiter plusieurs requêtes élargies peut être coûteux en ressources.

Atténuation :

S’assurer que les requêtes élargies fonctionnent efficacement avec les algorithmes de recherche existants.

Atténuation :

Attribuer des poids aux termes dans les requêtes élargies pour refléter leur importance.

Après la récupération, reclasser les documents pour prioriser la pertinence.

Exemple :

Utiliser un Cross-Encoder après la récupération pour scorer et reclasser les documents selon leur pertinence par rapport à la requête originale.

Intégrer les interactions des utilisateurs pour améliorer l’expansion de requête.

L’utilisation de l’IA et des LLMs pour l’expansion de requête exploite la compréhension avancée du langage pour améliorer la recherche. Cela permet aux systèmes d’IA, y compris les chatbots et assistants virtuels, de fournir des réponses plus précises et adaptées au contexte.

Automatiser l’expansion de requête réduit la nécessité pour les utilisateurs de formuler des requêtes précises. L’automatisation IA gère la complexité en arrière-plan, optimisant ainsi l’efficacité des systèmes de recherche d’information.

Les chatbots bénéficient de l’expansion de requête par une meilleure compréhension des intentions, notamment lorsqu’un utilisateur utilise un langage courant ou des phrases incomplètes. Cela conduit à des interactions plus satisfaisantes et à une résolution de problèmes plus efficace.

Exemple :

Un chatbot d’assistance technique peut interpréter une requête vague telle que « Mon application ne fonctionne pas » en l’élargissant à « application qui plante », « logiciel qui ne répond pas » et « messages d’erreur de l’application », ce qui accélère la résolution.

Recherche sur l’expansion de requête pour RAG

Improving Retrieval for RAG based Question Answering in question answering, enhancing accuracy with real-time data. Discover more!") Models on Financial Documents

Cet article examine l’efficacité des grands modèles de langage (LLMs) améliorés par la génération augmentée par récupération (RAG), en particulier dans le contexte des documents financiers. Il identifie que les inexactitudes des LLMs proviennent souvent d’une récupération sous-optimale des fragments de texte plutôt que des modèles eux-mêmes. L’étude propose des améliorations du processus RAG, incluant des techniques de découpage sophistiquées et l’expansion de requête, ainsi que l’annotation de métadonnées et des algorithmes de reclassement. Ces méthodologies visent à affiner la récupération de texte, améliorant ainsi la performance des LLMs pour générer des réponses précises. Lire la suite

Enhancing Retrieval and Managing Retrieval: A Four-Module Synergy for Improved Quality and Efficiency in RAG Systems

L’article présente une approche modulaire pour améliorer les systèmes RAG, mettant l’accent sur le module Query Rewriter, qui crée des requêtes adaptées à la recherche pour optimiser la récupération de connaissances. Il traite des problèmes de plateau d’information et d’ambiguïté dans les requêtes en générant des requêtes multiples. De plus, les modules Knowledge Filter et Memory Knowledge Reservoir sont proposés pour gérer les connaissances non pertinentes et optimiser les ressources de récupération. Ces avancées visent à augmenter la qualité et l’efficacité des réponses dans les systèmes RAG, validées par des expériences sur des jeux de données QA. Accédez au code et aux détails.

MultiHop-RAG: Benchmarking Retrieval-Augmented Generation for Multi-Hop Queries

Cette recherche met en lumière les défis rencontrés par les systèmes RAG actuels pour traiter des requêtes multi-hop, qui nécessitent un raisonnement sur plusieurs éléments de preuve. Elle introduit un nouveau jeu de données conçu pour évaluer les systèmes RAG sur des requêtes multi-hop, dans le but de repousser les limites des capacités actuelles. L’article discute des progrès nécessaires pour permettre aux méthodes RAG de gérer efficacement des structures de requêtes complexes et d’améliorer l’adoption des LLMs pour des applications concrètes.

L’expansion de requête est le processus d’augmentation de la requête originale d’un utilisateur en ajoutant des termes associés, des synonymes ou du contexte, aidant les systèmes de recherche à obtenir des documents plus pertinents et à générer des réponses précises, en particulier dans les applications alimentées par l’IA.

Dans les systèmes RAG (Retrieval-Augmented Generation), l’expansion de requête augmente le rappel du composant de recherche en élargissant l’espace de recherche, garantissant que davantage de documents pertinents sont pris en compte pour générer des réponses précises.

Les techniques incluent l’utilisation de grands modèles de langage pour générer des requêtes paraphrasées, la génération de réponses hypothétiques, les approches multi-requêtes, la pondération des termes et l’exploitation des retours utilisateurs pour une amélioration continue.

L’expansion de requête améliore le rappel, gère les requêtes vagues ou ambiguës, reconnaît les synonymes, et améliore l’expérience utilisateur en fournissant des réponses plus précises et informatives sans affinement manuel de la requête.

Oui, les défis incluent la sur-expansion (introduction de documents non pertinents), l’ambiguïté des termes, la demande en ressources informatiques et la compatibilité avec les algorithmes de recherche. Ceux-ci peuvent être atténués par une génération contrôlée, un filtrage de pertinence et l’utilisation de modèles efficaces.

Découvrez comment l’expansion de requête peut améliorer la précision de votre chatbot IA et optimiser la recherche d’information. Découvrez les solutions FlowHunt pour une gestion efficace et automatisée des requêtes.

Le rerangement de documents est le processus de réorganisation des documents récupérés en fonction de leur pertinence par rapport à la requête d'un utilisateur,...

Les questions-réponses avec la génération augmentée par récupération (RAG) combinent la recherche d'informations et la génération de langage naturel pour amélio...

L'expansion de requête dans FlowHunt améliore la compréhension du chatbot en trouvant des synonymes, en corrigeant les fautes d'orthographe et en assurant des r...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.