Espansione della query

Parafrasa l'input dell'utente in molteplici query alternative per migliorare la ricerca semantica nella knowledgebase utilizzando un prompt LLM.

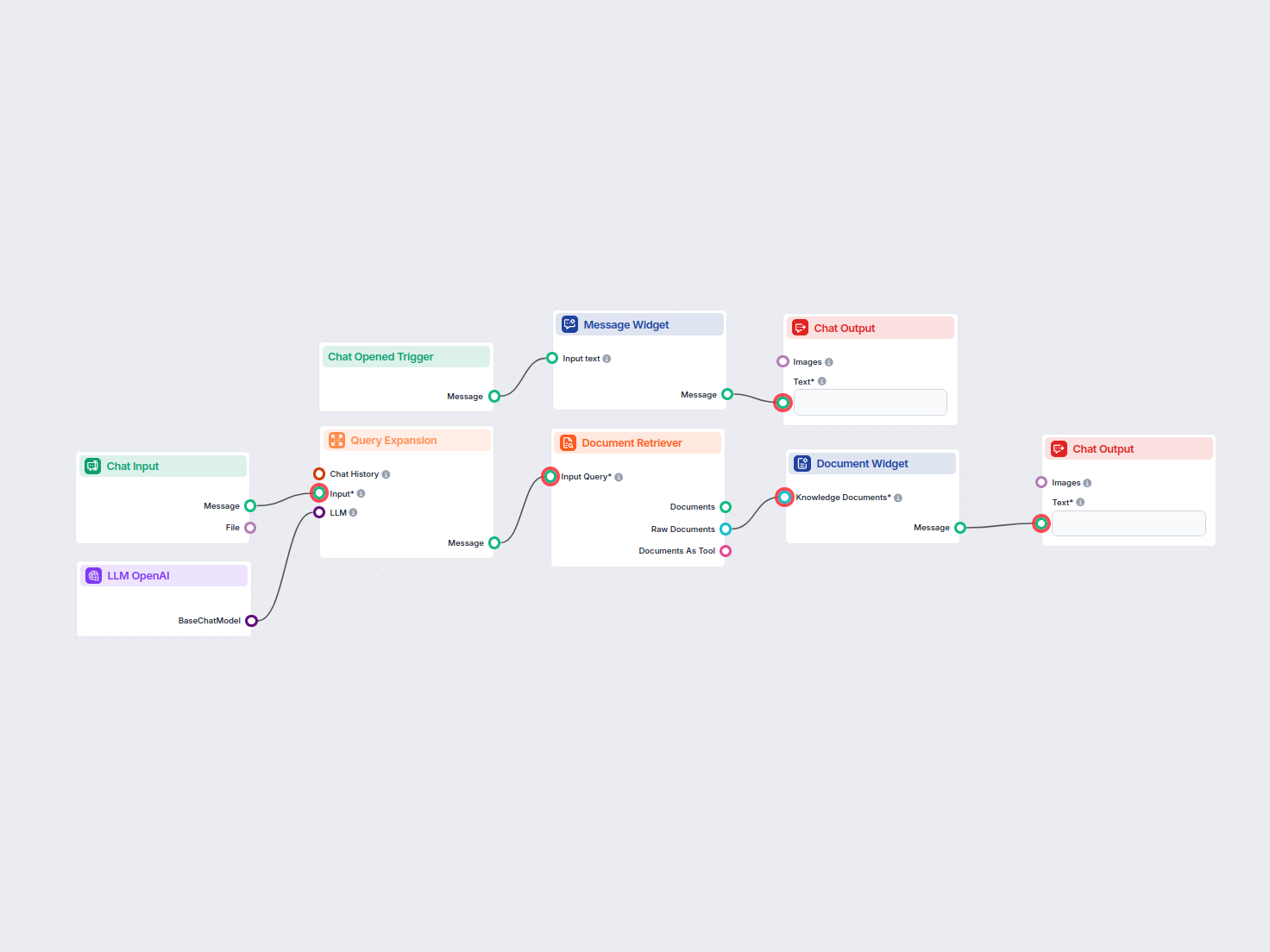

Cerca e recupera facilmente informazioni da documenti della knowledgebase privata utilizzando la ricerca semantica alimentata dall’IA. Il flow espande le query degli utenti, effettua ricerche su più fonti di conoscenza e presenta i risultati rilevanti in un’interfaccia chat intuitiva.

Flussi

Parafrasa l'input dell'utente in molteplici query alternative per migliorare la ricerca semantica nella knowledgebase utilizzando un prompt LLM.

Di seguito è riportato un elenco completo di tutti i componenti utilizzati in questo flusso per raggiungere la sua funzionalità. I componenti sono gli elementi costitutivi di ogni Flusso AI. Ti permettono di creare interazioni complesse e automatizzare attività collegando varie funzionalità. Ogni componente serve a uno scopo specifico, come la gestione dell'input dell'utente, l'elaborazione dei dati o l'integrazione con servizi esterni.

Il componente Chat Input in FlowHunt avvia le interazioni con l’utente acquisendo messaggi dal Playground. Serve come punto di partenza per i flussi, consentendo al workflow di elaborare sia input testuali che basati su file.

Scopri il componente Chat Output in FlowHunt—finalizza le risposte del chatbot con output flessibili e multipli. Essenziale per una conclusione del flusso senza interruzioni e per creare chatbot AI avanzati e interattivi.

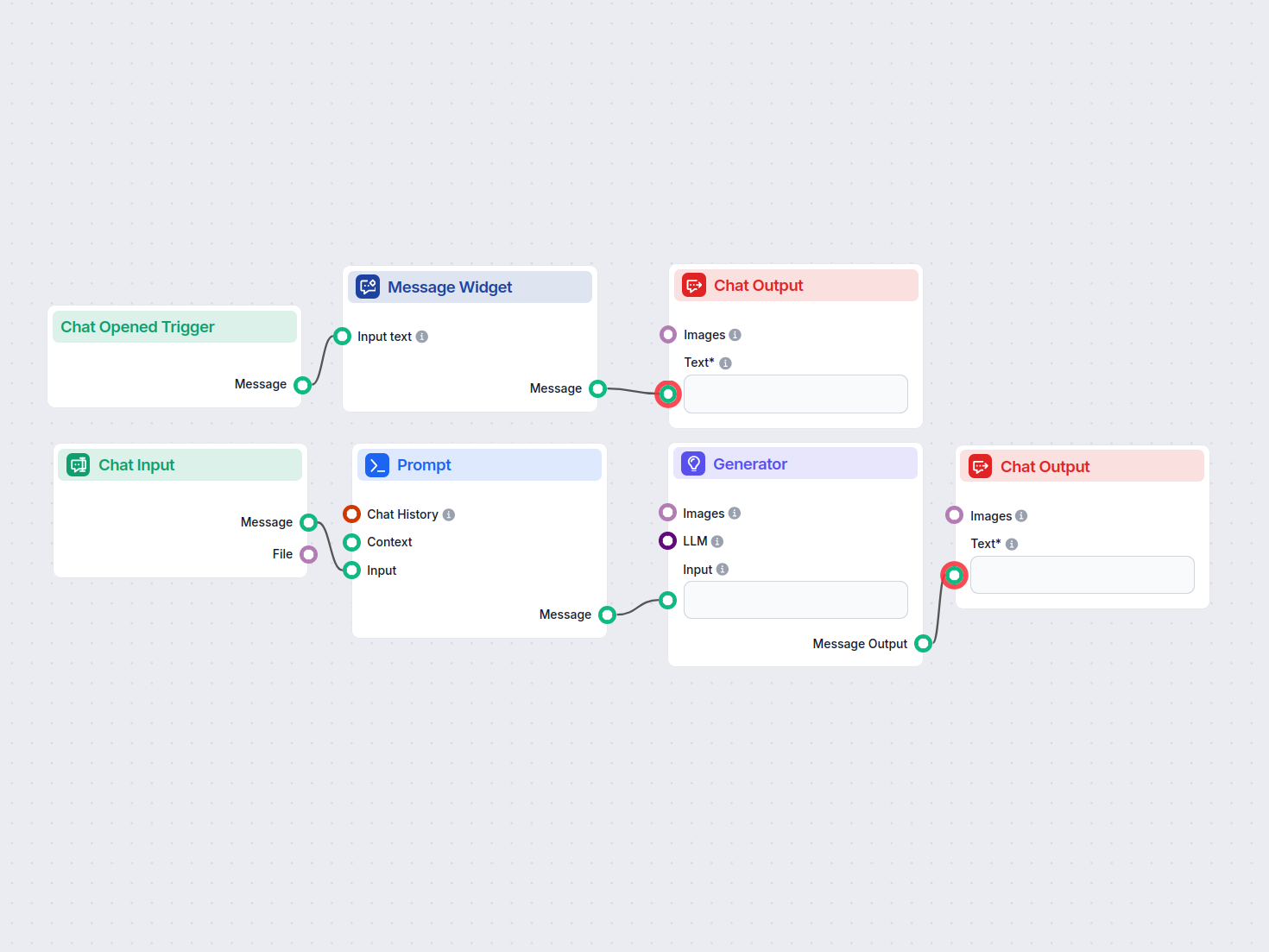

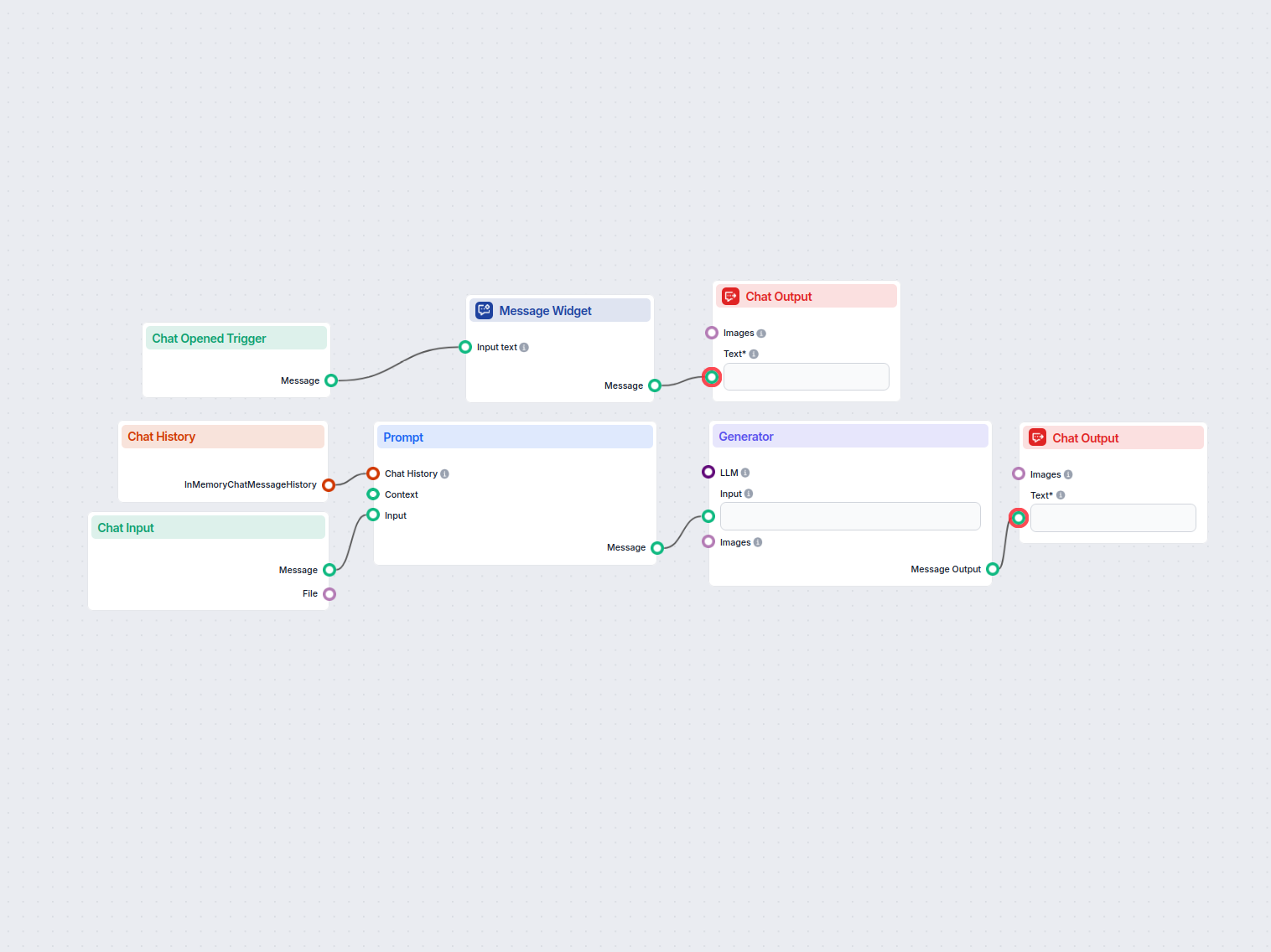

Il componente Widget Messaggio visualizza messaggi personalizzati all'interno del tuo workflow. Ideale per dare il benvenuto agli utenti, fornire istruzioni o mostrare qualsiasi informazione importante, supporta la formattazione Markdown e può essere impostato per apparire solo una volta per sessione.

Il componente Trigger Apertura Chat rileva quando inizia una sessione di chat, permettendo ai workflow di rispondere istantaneamente non appena un utente apre la chat. Avvia i flussi con il messaggio iniziale della chat, rendendolo essenziale per la creazione di chatbot reattivi e interattivi.

L'Espansione della Query in FlowHunt migliora la comprensione del chatbot trovando sinonimi, correggendo errori di ortografia e garantendo risposte coerenti e accurate alle richieste degli utenti.

Il Document Retriever di FlowHunt migliora l'accuratezza dell’AI collegando i modelli generativi ai tuoi documenti e URL aggiornati, garantendo risposte affidabili e pertinenti tramite la Retrieval-Augmented Generation (RAG).

Mostra documenti rilevanti direttamente nelle risposte del chatbot utilizzando il Widget Fonte di Conoscenza. Questo componente visualizza i documenti selezionati come widget distinti, facilitando agli utenti l’accesso e la revisione delle informazioni di supporto durante una conversazione.

FlowHunt supporta dozzine di modelli di generazione di testo, inclusi i modelli di OpenAI. Ecco come utilizzare ChatGPT nei tuoi strumenti di IA e chatbot.

Descrizione del flusso

Questo workflow, intitolato “Ricerca Semantica”, consente agli utenti di cercare informazioni all’interno della propria knowledgebase privata sfruttando modelli linguistici avanzati e tecniche di ricerca semantica. È progettato per eseguire una scansione su tutti i domini programmati, documenti e sezioni Q&A, automatizzando il recupero delle informazioni più rilevanti in risposta alle query degli utenti.

Quando un utente apre l’interfaccia chat, il workflow attiva un messaggio di benvenuto:

👋 Benvenuto nello strumento di ricerca della knowledgebase privata!

Sono qui per aiutarti a cercare tra i documenti della tua knowledgebase privata 📚. Scansionerò tutti i domini programmati, i documenti privati e le sezioni Q&A per trovare le informazioni di cui hai bisogno.

Inserisci semplicemente la tua query e iniziamo a trovare le risposte! ✨🔍

Questo messaggio amichevole aiuta gli utenti a orientarsi e li guida nell’inserimento della query di ricerca.

Input Utente:

L’utente invia una query tramite il campo di input della chat.

Espansione della Query:

gpt-4o-mini), questo componente genera fino a tre query parafrasate o semanticamente simili.| Componente | Scopo |

|---|---|

| Chat Input | Raccoglie la domanda di ricerca dell’utente |

| OpenAI LLM (gpt-4o-mini) | Genera formulazioni alternative della query |

| Espansione della Query | Produce fino a 3 varianti di query per la ricerca |

<H1> per massimizzare la rilevanza contestuale.| Fase | Componente | Tipo di Output |

|---|---|---|

| Recupero Documenti | Document Retriever | Documenti grezzi |

| Formattazione Risultati | Document Widget | Messaggio |

| Visualizzazione Utente | Chat Output | Messaggio chat |

flowchart LR

A[Chat Opened] --> B[Welcome Message]

B --> C[User Query Input]

C --> D[Query Expansion\n(OpenAI LLM)]

D --> E[Document Retriever]

E --> F[Document Widget]

F --> G[Chat Output]

Tipici casi d’uso:

Integrando la ricerca semantica con l’espansione delle query alimentata dagli LLM, questo workflow garantisce agli utenti un accesso efficiente alle conoscenze rilevanti, aumentando produttività e scoperta delle informazioni.

Aiutiamo aziende come la tua a sviluppare chatbot intelligenti, server MCP, strumenti AI o altri tipi di automazione AI per sostituire l'uomo in compiti ripetitivi nella tua organizzazione.

Questo workflow basato su AI risolve automaticamente le immagini CAPTCHA caricate dagli utenti. Guida gli utenti con istruzioni, elabora l'immagine tramite un p...

Questo workflow determina se un indirizzo email proviene da un provider email gratuito/generico o da un dominio aziendale personalizzato. È utile per la qualifi...

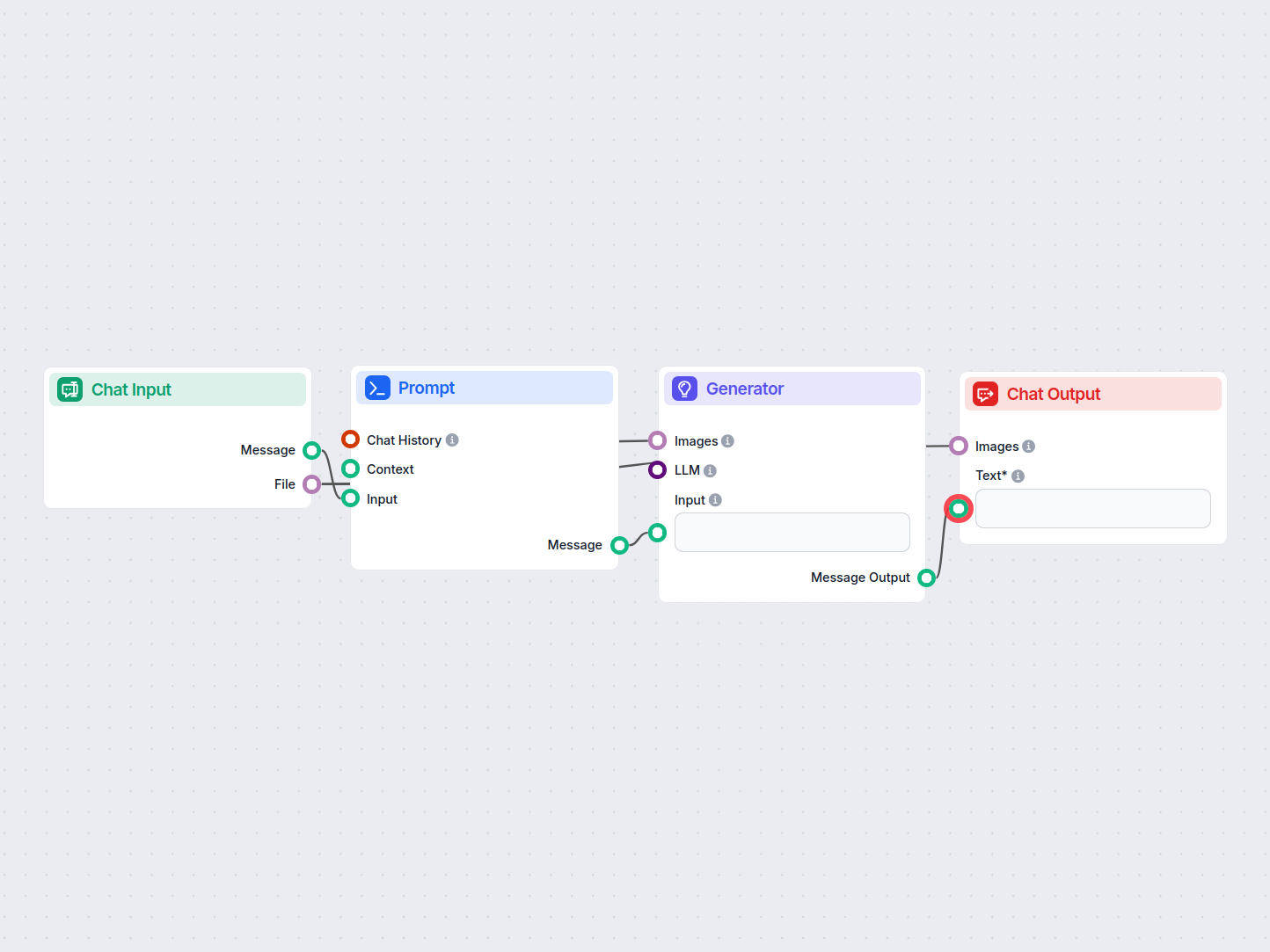

Un semplice workflow di assistente chat AI che sfrutta la cronologia delle conversazioni precedenti per generare risposte pertinenti all'input dell'utente. Incl...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.