DeepSeek MCP Server

Il DeepSeek MCP Server funge da proxy sicuro, collegando i modelli linguistici avanzati di DeepSeek ad applicazioni compatibili MCP come Claude Desktop o FlowHu...

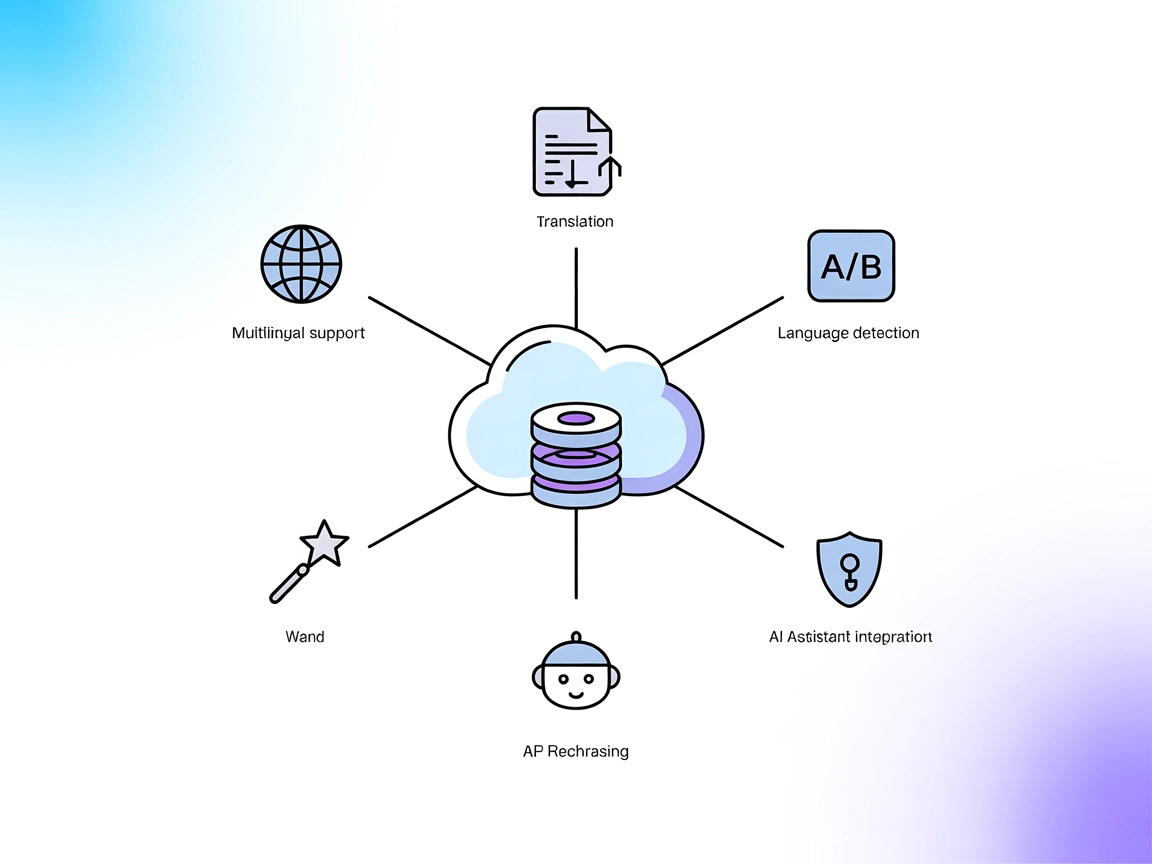

Consenti ai tuoi assistenti AI di tradurre, riformulare e rilevare lingue in tempo reale utilizzando l’API di DeepL, il tutto attraverso una semplice integrazione server MCP.

FlowHunt fornisce un livello di sicurezza aggiuntivo tra i tuoi sistemi interni e gli strumenti AI, dandoti controllo granulare su quali strumenti sono accessibili dai tuoi server MCP. I server MCP ospitati nella nostra infrastruttura possono essere integrati perfettamente con il chatbot di FlowHunt così come con le piattaforme AI popolari come ChatGPT, Claude e vari editor AI.

Il DeepL MCP Server è un server Model Context Protocol (MCP) che fornisce agli assistenti AI capacità avanzate di traduzione integrando l’API DeepL. Agisce come strumento middleware, permettendo ai client AI di effettuare traduzioni di testo in tempo reale, riformulazione e rilevamento della lingua tramite interfacce MCP standardizzate. Questo server supporta flussi di lavoro di sviluppo che richiedono supporto multilingue, identificazione automatica della lingua e regolazione del tono formale/informale. Collegando gli assistenti AI all’API DeepL, il DeepL MCP Server consente attività come tradurre e riformulare contenuti, rilevare la lingua dell’input utente e supportare un’ampia gamma di lingue—migliorando la flessibilità e l’intelligenza delle applicazioni AI.

Nessun template di prompt è esplicitamente elencato nella repository o nella documentazione.

Nessuna risorsa MCP esplicita è dettagliata nella repository o nella documentazione.

Nessuna istruzione di configurazione per Windsurf è presente nella repository.

~/Library/Application Support/Claude/claude_desktop_config.json%AppData%\Claude\claude_desktop_config.json~/.config/Claude/claude_desktop_config.json{

"mcpServers": {

"deepl": {

"command": "npx",

"args": ["-y", "/path/to/deepl-mcp-server"],

"env": {

"DEEPL_API_KEY": "your-api-key-here"

}

}

}

}

/path/to/deepl-mcp-server con il percorso assoluto della tua repository locale.your-api-key-here con la tua chiave API DeepL effettiva.Protezione delle chiavi API:

Utilizza il campo env per memorizzare in modo sicuro le chiavi API. L’esempio è mostrato sopra nello snippet JSON.

Nessuna istruzione di configurazione per Cursor è presente nella repository.

Nessuna istruzione di configurazione per Cline è presente nella repository.

Uso del MCP in FlowHunt

Per integrare server MCP nel tuo flusso FlowHunt, inizia aggiungendo il componente MCP al tuo flusso e collegandolo al tuo agente AI:

Fai clic sul componente MCP per aprire il pannello di configurazione. Nella sezione di configurazione MCP di sistema, inserisci i dettagli del tuo server MCP utilizzando questo formato JSON:

{

"deepl": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una volta configurato, l’agente AI potrà ora utilizzare questo MCP come strumento con accesso a tutte le sue funzioni e capacità. Ricorda di cambiare “deepl” con il vero nome del tuo server MCP e sostituire l’URL con quello del tuo server MCP.

| Sezione | Disponibilità | Dettagli/Note |

|---|---|---|

| Panoramica | ✅ | |

| Elenco dei Prompt | ⛔ | |

| Elenco delle Risorse | ⛔ | |

| Elenco degli Strumenti | ✅ | |

| Protezione chiavi API | ✅ | Usa "env" |

| Supporto Sampling (meno rilevante in valutazione) | ⛔ |

In base a quanto sopra, DeepL MCP Server è focalizzato e pronto per la produzione per attività di traduzione, ma manca di template di prompt e risorse documentate, e ha guide di configurazione predefinite limitate a Claude. Copre la sicurezza essenziale con la gestione delle chiavi API e offre una solida gamma di strumenti di traduzione.

Questo server MCP ottiene un punteggio moderatamente alto per utilità e applicabilità reale grazie ai suoi strumenti di traduzione e all’integrazione diretta con Claude, ma perde punti per la mancanza di documentazione su risorse e prompt e per la limitata guida all’installazione multipiattaforma.

| Ha una LICENSE | ✅ (MIT) |

|---|---|

| Ha almeno uno strumento | ✅ |

| Numero di Fork | 5 |

| Numero di Stelle | 19 |

Il DeepL MCP Server è un middleware che porta traduzione avanzata, riformulazione e rilevamento della lingua di DeepL agli assistenti AI. Agisce come ponte tra i tuoi flussi di lavoro AI e l’API DeepL, supportando comunicazione multilingue in tempo reale e regolazione del tono.

Offre strumenti per recuperare le lingue di origine e destinazione disponibili, tradurre testi e riformulare contenuti—consentendo agli agenti AI di gestire una vasta gamma di attività linguistiche in modo programmato.

Utilizza il campo `env` nella configurazione del server MCP per archiviare la tua chiave API. In questo modo i dati sensibili restano fuori dal codice ed è garantita una gestione sicura degli accessi.

Sì! Aggiungi il componente MCP al tuo flusso FlowHunt, inserisci la configurazione del tuo DeepL MCP server e il tuo agente AI avrà subito accesso a traduzione, riformulazione e rilevamento linguistico.

Sì, l’API DeepL e il server MCP supportano la regolazione della formalità, permettendoti di adattare le traduzioni a contesti professionali o informali.

Sono fornite istruzioni dettagliate per Claude Desktop. Altre piattaforme come Cursor e Cline non sono documentate esplicitamente, ma il server MCP è compatibile se configurato correttamente.

Potenzia il tuo chatbot o flusso di lavoro AI con DeepL MCP Server per traduzione, riformulazione e rilevamento linguistico in tempo reale e senza bisogno di programmazione manuale.

Il DeepSeek MCP Server funge da proxy sicuro, collegando i modelli linguistici avanzati di DeepSeek ad applicazioni compatibili MCP come Claude Desktop o FlowHu...

Il Server ModelContextProtocol (MCP) funge da ponte tra agenti AI e fonti dati esterne, API e servizi, consentendo agli utenti FlowHunt di costruire assistenti ...

Il DeepSeek MCP Server integra i modelli linguistici avanzati di DeepSeek con applicazioni compatibili MCP, fornendo accesso API sicuro e anonimizzato e abilita...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.