Rememberizer MCP Server

Il Rememberizer MCP Server fa da ponte tra assistenti AI e gestione della conoscenza, abilitando ricerca semantica, recupero unificato di documenti e collaboraz...

Abilita memoria AI sicura, persistente e multi-sessione con Membase MCP Server—un gateway di memoria decentralizzato per continuità e conformità robuste degli agenti.

FlowHunt fornisce un livello di sicurezza aggiuntivo tra i tuoi sistemi interni e gli strumenti AI, dandoti controllo granulare su quali strumenti sono accessibili dai tuoi server MCP. I server MCP ospitati nella nostra infrastruttura possono essere integrati perfettamente con il chatbot di FlowHunt così come con le piattaforme AI popolari come ChatGPT, Claude e vari editor AI.

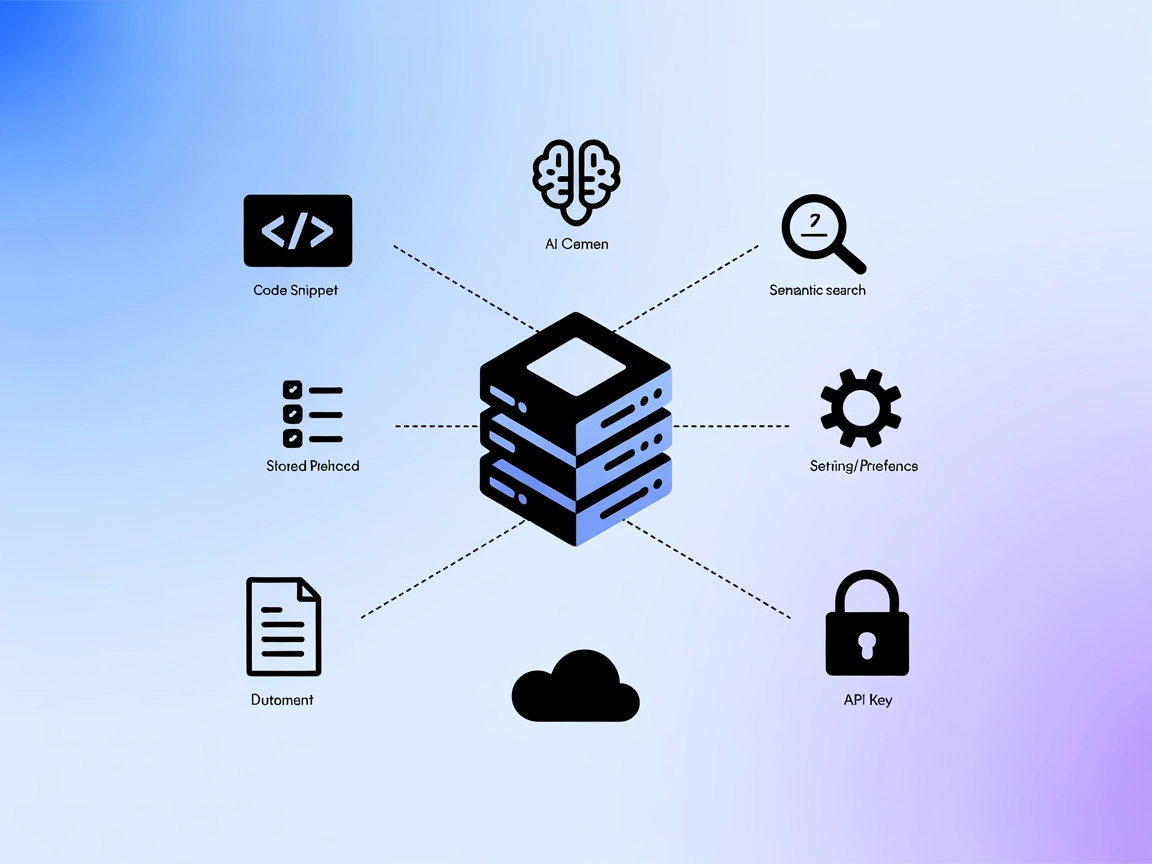

Il Membase MCP (Model Context Protocol) Server agisce come un gateway di memoria leggero e decentralizzato per agenti AI, collegandoli a Membase per una memoria sicura, persistente e verificabile multi-sessione. Alimentato da Unibase, consente agli assistenti AI di caricare e recuperare la cronologia delle conversazioni, i registri delle interazioni e la conoscenza, garantendo continuità, personalizzazione e tracciabilità degli agenti. Integrandosi con il protocollo Membase, il server abilita l’archiviazione e il recupero senza soluzione di continuità dei dati di memoria dalla rete decentralizzata Unibase, supportando casi d’uso in cui la memoria persistente e a prova di manomissione è fondamentale per i workflow guidati dall’AI.

Nessun template di prompt è menzionato nel repository.

Nessuna risorsa MCP esplicita è descritta nel repository.

uv).git clone https://github.com/unibaseio/membase-mcp.git{

"mcpServers": {

"membase": {

"command": "uv",

"args": [

"--directory",

"path/to/membase-mcp",

"run",

"src/membase_mcp/server.py"

],

"env": {

"MEMBASE_ACCOUNT": "il tuo account, 0x...",

"MEMBASE_CONVERSATION_ID": "id della conversazione, deve essere univoco",

"MEMBASE_ID": "sotto-account, qualsiasi stringa"

}

}

}

}

Protezione delle API Key:

Usa variabili d’ambiente nel blocco env per mantenere sicure le credenziali.

uv runner e Python).{

"mcpServers": {

"membase": {

"command": "uv",

"args": [

"--directory",

"path/to/membase-mcp",

"run",

"src/membase_mcp/server.py"

],

"env": {

"MEMBASE_ACCOUNT": "il tuo account, 0x...",

"MEMBASE_CONVERSATION_ID": "id della conversazione, deve essere univoco",

"MEMBASE_ID": "sotto-account, qualsiasi stringa"

}

}

}

}

Nota: Conserva le informazioni sensibili come variabili d’ambiente.

uv).{

"mcpServers": {

"membase": {

"command": "uv",

"args": [

"--directory",

"path/to/membase-mcp",

"run",

"src/membase_mcp/server.py"

],

"env": {

"MEMBASE_ACCOUNT": "il tuo account, 0x...",

"MEMBASE_CONVERSATION_ID": "id della conversazione, deve essere univoco",

"MEMBASE_ID": "sotto-account, qualsiasi stringa"

}

}

}

}

uv, Python).{

"mcpServers": {

"membase": {

"command": "uv",

"args": [

"--directory",

"path/to/membase-mcp",

"run",

"src/membase_mcp/server.py"

],

"env": {

"MEMBASE_ACCOUNT": "il tuo account, 0x...",

"MEMBASE_CONVERSATION_ID": "id della conversazione, deve essere univoco",

"MEMBASE_ID": "sotto-account, qualsiasi stringa"

}

}

}

}

Protezione delle API Key:

Tutte le credenziali sensibili dovrebbero essere passate nell’oggetto env come mostrato sopra per evitare di inserirle nel codice.

Utilizzo di MCP in FlowHunt

Per integrare i server MCP nel tuo workflow FlowHunt, inizia aggiungendo il componente MCP al tuo flow e collegandolo al tuo agente AI:

Clicca sul componente MCP per aprire il pannello di configurazione. Nella sezione di configurazione MCP di sistema, inserisci i dettagli del tuo server MCP usando questo formato JSON:

{

"MCP-name": {

"transport": "streamable_http",

"url": "https://tuomcpserver.example/pathtothemcp/url"

}

}

Una volta configurato, l’agente AI potrà utilizzare questo MCP come tool con accesso a tutte le sue funzioni e capacità. Ricorda di cambiare “MCP-name” con il vero nome del tuo server MCP (es. “github-mcp”, “weather-api”, ecc.) e sostituisci l’URL con quello del tuo MCP server.

| Sezione | Disponibilità | Dettagli/Note |

|---|---|---|

| Panoramica | ✅ | |

| Elenco dei Prompt | ⛔ | Nessun template di prompt riutilizzabile fornito |

| Elenco delle Risorse | ⛔ | Nessuna risorsa MCP esplicita elencata |

| Elenco degli Strumenti | ✅ | get_conversation_id, switch_conversation, save_message, get_messages |

| Protezione delle API Key | ✅ | Usa variabili d’ambiente in configurazione |

| Supporto Sampling (meno rilevante in valutazione) | ⛔ | Non menzionato |

Sulla base delle informazioni disponibili, Membase MCP Server fornisce strumenti di memoria fondamentali e istruzioni di setup chiare, ma manca di template di prompt, risorse MCP esplicite e menzione del supporto sampling o roots. Questo lo rende funzionale per workflow focalizzati sulla memoria ma limitato in estensibilità e funzionalità MCP avanzate. Nel complesso, è pratico ma basilare.

| Ha una LICENSE | ⛔ (Nessun file di licenza presente) |

|---|---|

| Ha almeno uno strumento | ✅ |

| Numero di Fork | 4 |

| Numero di Stelle | 4 |

Membase MCP Server è un gateway leggero e decentralizzato per la memoria degli agenti AI, che fornisce una memoria sicura, persistente e verificabile multi-sessione collegando gli agenti al protocollo Membase alimentato da Unibase.

Include strumenti per recuperare l'ID della conversazione corrente, passare tra conversazioni, salvare messaggi e recuperare la cronologia delle conversazioni, consentendo una gestione robusta della memoria e delle multi-sessioni per agenti AI.

Tutte le interazioni e i messaggi sono memorizzati su una rete decentralizzata per registri a prova di manomissione e verificabili. Le credenziali vengono passate tramite variabili d'ambiente per mantenerle sicure.

Sì. Aggiungi il componente MCP nel tuo flusso FlowHunt e configurarlo con i dettagli del tuo Membase MCP. I tuoi agenti AI potranno così accedere a tutte le funzioni di memoria fornite dal server.

Nessun file di licenza è presente nel repository. Usalo a tua discrezione.

Potenzia i tuoi workflow AI con memoria decentralizzata e a prova di manomissione. Configura Membase MCP Server in FlowHunt e sblocca avanzate capacità multi-sessione.

Il Rememberizer MCP Server fa da ponte tra assistenti AI e gestione della conoscenza, abilitando ricerca semantica, recupero unificato di documenti e collaboraz...

Il Server ModelContextProtocol (MCP) funge da ponte tra agenti AI e fonti dati esterne, API e servizi, consentendo agli utenti FlowHunt di costruire assistenti ...

Il mem0 MCP Server connette gli assistenti AI con archiviazione strutturata, recupero e ricerca semantica per snippet di codice, documentazione e best practice ...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.