ModelContextProtocol (MCP) Server-integrering

ModelContextProtocol (MCP) Server fungerer som en bro mellom AI-agenter og eksterne datakilder, API-er og tjenester, slik at FlowHunt-brukere kan bygge kontekst...

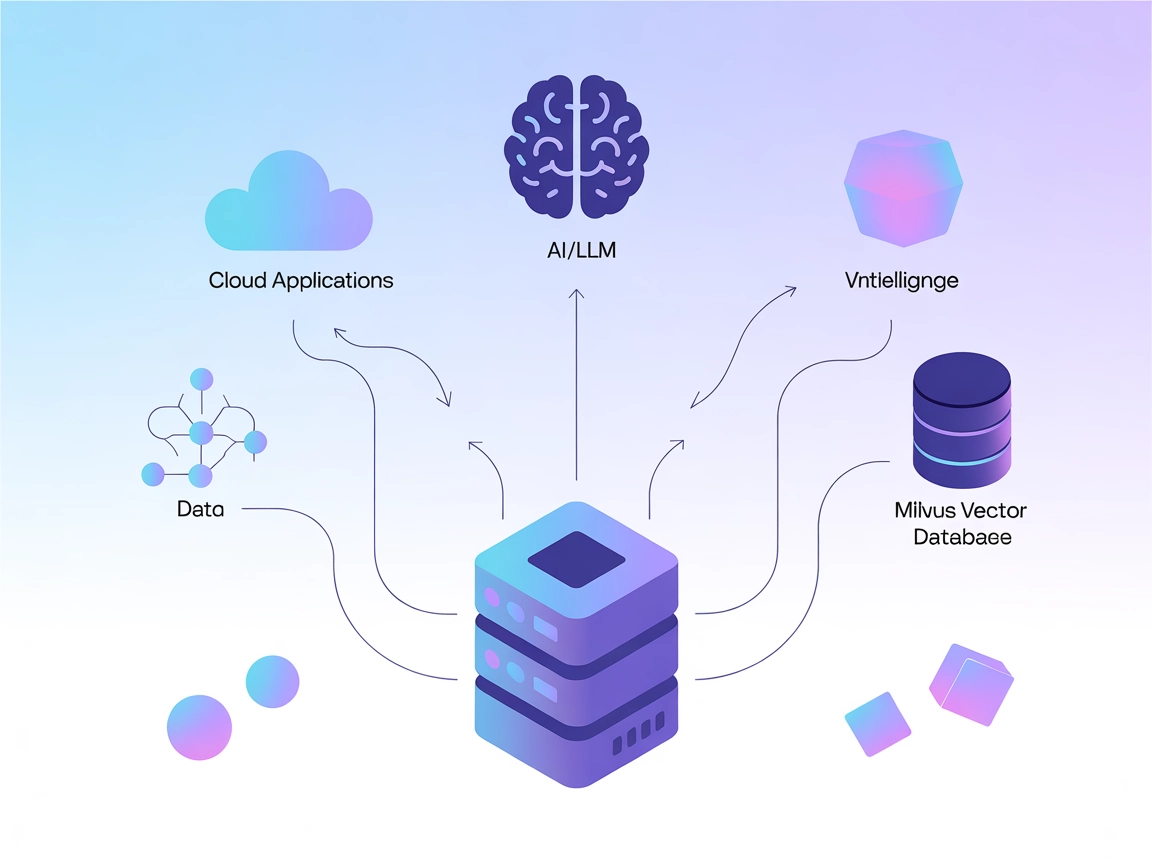

Koble LLM-er og AI-agenter til Milvus for kraftig vektorsøk, kontekstuell hukommelse og datadrevne anbefalinger direkte i dine FlowHunt-arbeidsflyter.

FlowHunt gir et ekstra sikkerhetslag mellom dine interne systemer og AI-verktøy, og gir deg granulær kontroll over hvilke verktøy som er tilgjengelige fra dine MCP-servere. MCP-servere som er hostet i vår infrastruktur kan sømløst integreres med FlowHunts chatbot samt populære AI-plattformer som ChatGPT, Claude og forskjellige AI-editorer.

Milvus MCP (Model Context Protocol) Server kobler AI-assistenter og LLM-drevne applikasjoner med Milvus vektordatabase. Dette muliggjør sømløs interaksjon mellom språkmodeller og storskala vektordata, og gir en standardisert måte å få tilgang til, forespørre og administrere Milvus fra AI-arbeidsflyter. Med Milvus MCP Server kan utviklere integrere Milvus-basert søk, uthenting og datahåndtering direkte i sine AI-agenter, IDE-er eller chatgrensesnitt. Serveren støtter flere kommunikasjonsmoduser (stdio og Server-Sent Events), slik at den kan tilpasses ulike distribusjonsscenarier og utviklingsmiljøer. Ved å bygge bro mellom LLM-er og Milvus, styrkes AI-systemers evne til å utføre kontekstbevisste operasjoner på høy-dimensjonale data, noe som åpner for rikere og mer intelligente LLM-opplevelser.

Ingen informasjon om prompt-maler er gitt i depotet.

Ingen eksplisitt liste over Model Context Protocol “ressurser” er beskrevet i tilgjengelig dokumentasjon eller kode.

Ingen eksplisitt verktøyliste eller funksjonsnavn er dokumentert i tilgjengelig dokumentasjon eller kodefiler, inkludert server.py.

git clone https://github.com/zilliztech/mcp-server-milvus.gituv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Sikring av API-nøkler:

Hvis serveren krever sensitiv informasjon, bruk miljøvariabler:

{

"env": {

"MILVUS_URI": "http://localhost:19530"

},

"inputs": {}

}

{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Sikre legitimasjon via miljøvariabler som over.

uv.uv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Sikring av API-nøkler:

Bruk miljøvariabler som vist over.

uv.{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Miljøvariabler:

{

"env": {

"MILVUS_URI": "http://localhost:19530"

}

}

Bruke MCP i FlowHunt

For å integrere MCP-servere i din FlowHunt-arbeidsflyt, start med å legge til MCP-komponenten i flyten din og koble den til din AI-agent:

Klikk på MCP-komponenten for å åpne konfigurasjonspanelet. I systemets MCP-konfigurasjonsseksjon, legg inn MCP-serverdetaljene dine med dette JSON-formatet:

{

"milvus-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Når det er konfigurert, kan AI-agenten nå bruke denne MCP-en som et verktøy med tilgang til alle dens funksjoner og muligheter. Husk å endre “milvus-mcp” til det faktiske navnet på din MCP-server og bytt ut URL-en med din egen MCP-server-URL.

| Seksjon | Tilgjengelig | Detaljer/Notater |

|---|---|---|

| Oversikt | ✅ | |

| Liste over Prompt-maler | ⛔ | Ingen prompt-maler dokumentert |

| Liste over Ressurser | ⛔ | Ingen eksplisitt MCP ressursliste |

| Liste over Verktøy | ⛔ | Ingen eksplisitte verktøy oppført i tilgjengelige filer |

| Sikring av API-nøkler | ✅ | Bruker miljøvariabler, dokumentert i oppsetteksempler |

| Sampling-støtte (mindre viktig for vurdering) | ⛔ | Ikke nevnt |

Roots-støtte: Ikke nevnt

Sampling-støtte: Ikke nevnt

Milvus MCP Server er en praktisk og fokusert bro for å koble LLM-er med Milvus, med klare oppsettsguider for populære utviklingsverktøy. Dokumentasjonen mangler imidlertid detaljer om MCP-ressurser, prompt-maler og konkrete verktøy-API-er, noe som begrenser umiddelbar oppdagbarhet. Likevel er det et solid fundament for vektorbaserte AI-integrasjoner.

| Har en LISENS | ✅ (Apache-2.0) |

|---|---|

| Har minst ett verktøy | ⛔ |

| Antall Forks | 32 |

| Antall Stjerner | 139 |

Totalt: 4/10

Serveren er nyttig for sitt nisjeområde, men ville hatt stor gevinst av mer eksplisitt dokumentasjon på ressurser, prompt-maler og verktøy-API-er for maksimal interoperabilitet og brukervennlighet.

Milvus MCP Server bygger bro mellom AI-assistenter og LLM-applikasjoner med Milvus vektordatabase, og muliggjør sømløst vektorsøk, kontekstuell hukommelse og datahåndtering for avanserte AI-arbeidsflyter.

Viktige brukstilfeller inkluderer vektorsøk, embedding-håndtering, kontekstuell chatbot-hukommelse, AI-drevne anbefalinger og sanntids dataanalyse ved bruk av Milvus i FlowHunt.

Bruk miljøvariabler (f.eks. MILVUS_URI) til å lagre sensitiv tilkoblingsinformasjon, som vist i oppsettsguidene for hver støttet klient.

Ingen eksplisitte prompt-maler eller verktøy-API-er er dokumentert. Serveren fokuserer på å tilby en bro for vektoroperasjoner og embedding-håndtering.

Den er et solid fundament for å koble LLM-er til vektordatabaser, med tydelige oppsettsinstruksjoner, men ville hatt fordel av mer dokumentasjon om prompt og verktøy-API-er for enklere oppdagbarhet og integrasjon.

Forbedre dine AI-agenter med sømløs tilgang til vektordatabaser, som gir smartere søk, anbefalinger og kontekstuell hukommelse. Integrer Milvus MCP Server med FlowHunt nå!

ModelContextProtocol (MCP) Server fungerer som en bro mellom AI-agenter og eksterne datakilder, API-er og tjenester, slik at FlowHunt-brukere kan bygge kontekst...

Litmus MCP Server muliggjør sømløs integrasjon mellom store språkmodeller (LLM-er) og Litmus Edge for konfigurasjon, overvåking og administrasjon av industriell...

Lightdash MCP-serveren kobler AI-assistenter og Lightdash, en moderne business intelligence-plattform, og muliggjør sømløs programmatisk tilgang til analysepros...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.