Integracja z serwerem CodeLogic MCP

Serwer CodeLogic MCP łączy FlowHunt i asystentów programowania AI ze szczegółowymi danymi o zależnościach oprogramowania CodeLogic, umożliwiając zaawansowaną an...

Odblokuj zaawansowaną inteligencję kodu w FlowHunt dzięki serwerowi LSP MCP — umożliwiając nawigację po kodzie z wykorzystaniem AI, diagnostykę, podpowiedzi oraz zintegrowane przepływy pracy dewelopera.

FlowHunt zapewnia dodatkową warstwę bezpieczeństwa między Twoimi systemami wewnętrznymi a narzędziami AI, dając Ci szczegółową kontrolę nad tym, które narzędzia są dostępne z Twoich serwerów MCP. Serwery MCP hostowane w naszej infrastrukturze można bezproblemowo zintegrować z chatbotem FlowHunt oraz popularnymi platformami AI, takimi jak ChatGPT, Claude i różne edytory AI.

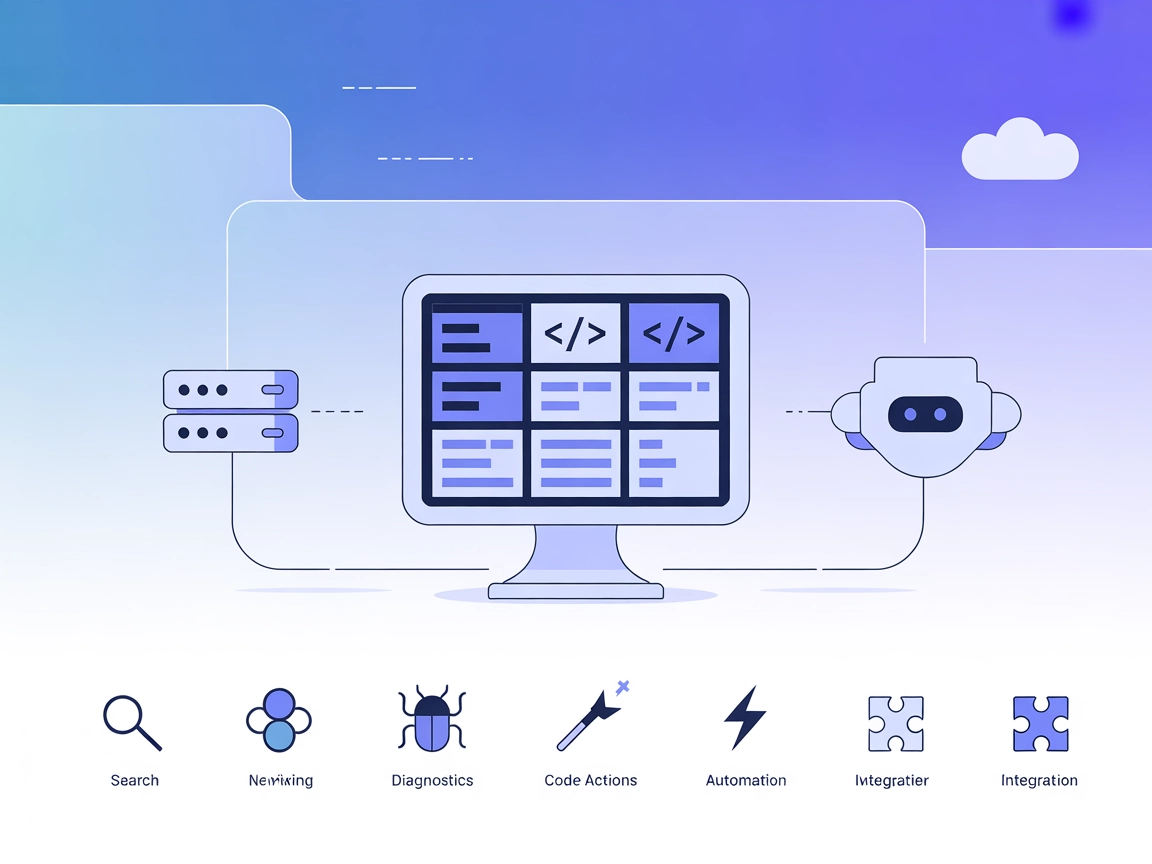

Serwer LSP MCP (Model Context Protocol) działa jako pomost pomiędzy serwerami Language Server Protocol (LSP) a asystentami AI. Po połączeniu z serwerem LSP umożliwia LLM-om i innym klientom AI interakcję z bazami kodu poprzez standaryzowane funkcje LSP. Dzięki temu narzędzia AI mogą wykonywać zaawansowaną analizę kodu, pobierać dokumentację hover, otrzymywać podpowiedzi kodu, uzyskiwać diagnostykę, a nawet stosować akcje na kodzie bezpośrednio w edytorze lub przepływie pracy. Serwer LSP MCP zwiększa produktywność programistów, umożliwiając płynną, sterowaną przez AI interakcję z kodem źródłowym, dzięki czemu takie zadania jak nawigacja po kodzie, rozwiązywanie błędów czy inteligentne uzupełnianie kodu stają się łatwiejsze i bardziej zautomatyzowane.

W repozytorium ani dokumentacji nie ma jawnie zdefiniowanych szablonów promptów.

lsp-diagnostics://lsp-hover://lsp-completions://get_info_on_locationget_completionsget_code_actionsopen_documentclose_documentget_diagnosticsstart_lsprestart_lsp_serverset_log_levelmcpServers:{

"mcpServers": {

"lsp-mcp": {

"type": "stdio",

"command": "npx",

"args": [

"tritlo/lsp-mcp",

"<language-id>",

"<path-to-lsp>",

"<lsp-args>"

]

}

}

}

mcpServers:{

"mcpServers": {

"lsp-mcp": {

"type": "stdio",

"command": "npx",

"args": [

"tritlo/lsp-mcp",

"<language-id>",

"<path-to-lsp>",

"<lsp-args>"

]

}

}

}

claude --mcp-debug w celu uzyskania logów.{

"mcpServers": {

"lsp-mcp": {

"type": "stdio",

"command": "npx",

"args": [

"tritlo/lsp-mcp",

"<language-id>",

"<path-to-lsp>",

"<lsp-args>"

]

}

}

}

{

"mcpServers": {

"lsp-mcp": {

"type": "stdio",

"command": "npx",

"args": [

"tritlo/lsp-mcp",

"<language-id>",

"<path-to-lsp>",

"<lsp-args>"

]

}

}

}

Zabezpieczanie kluczy API

Jeśli serwer LSP lub konfiguracja MCP wymaga kluczy API, użyj zmiennych środowiskowych dla bezpieczeństwa:

{

"mcpServers": {

"lsp-mcp": {

"type": "stdio",

"command": "npx",

"args": [

"tritlo/lsp-mcp",

"<language-id>",

"<path-to-lsp>",

"<lsp-args>"

],

"env": {

"API_KEY": "${LSP_API_KEY}"

},

"inputs": {

"api_key": "${LSP_API_KEY}"

}

}

}

}

Korzystanie z MCP w FlowHunt

Aby zintegrować serwery MCP ze swoim przepływem pracy w FlowHunt, rozpocznij od dodania komponentu MCP do swojego przepływu i podłączenia go do agenta AI:

Kliknij komponent MCP, aby otworzyć panel konfiguracji. W sekcji konfiguracji systemowej MCP wprowadź dane serwera MCP w tym formacie JSON:

{

"lsp-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Po skonfigurowaniu agent AI może już korzystać z tego MCP jako narzędzia z dostępem do wszystkich jego funkcji i możliwości. Pamiętaj, aby zmienić „lsp-mcp” na faktyczną nazwę swojego serwera MCP i podmień adres URL na własny.

| Sekcja | Dostępność | Szczegóły/Uwagi |

|---|---|---|

| Podsumowanie | ✅ | Opis znajduje się w README.md |

| Lista promptów | ⛔ | Brak szablonów promptów |

| Lista zasobów | ✅ | Zasoby diagnostyczne, hover, podpowiedzi udokumentowane |

| Lista narzędzi | ✅ | 8 narzędzi: get_info_on_location, get_completions itd. |

| Zabezpieczanie kluczy API | ✅ | Przykład używania zmiennych środowiskowych |

| Obsługa sampling (mniej istotne) | ⛔ | Brak informacji o wsparciu dla samplingu |

Serwer LSP MCP zapewnia kompleksową dokumentację, szeroki zestaw narzędzi i zasobów do integracji z LSP oraz jasne instrukcje konfiguracji. Brakuje jednak jawnego wsparcia dla szablonów promptów i nie ma informacji o sampling czy wsparciu dla roots. Ogólnie — solidne rozwiązanie do integracji baz kodu i LSP, które mogłoby jeszcze zyskać na bardziej zaawansowanych funkcjach MCP.

Ocena: 7/10

| Posiada LICENCJĘ | ✅ (MIT) |

|---|---|

| Posiada co najmniej jedno narzędzie | ✅ |

| Liczba forków | 4 |

| Liczba gwiazdek | 42 |

Serwer LSP MCP (Model Context Protocol) łączy asystentów AI z serwerami Language Server Protocol, umożliwiając narzędziom AI interakcję z bazami kodu poprzez standaryzowane funkcje LSP. Dzięki temu możliwa jest analiza kodu, uzupełnianie, diagnostyka oraz akcje na kodzie bezpośrednio w edytorach i przepływach pracy.

Umożliwia nawigację po kodzie, diagnostykę w czasie rzeczywistym (błędy/ostrzeżenia), uzupełnianie kodu, dokumentację podpowiedzi (hover), a także automatyczne akcje na kodzie, czyniąc pracę dewelopera bardziej produktywną i opartą na AI.

Dodaj komponent MCP do swojego przepływu w FlowHunt i skonfiguruj go, podając szczegóły dotyczące serwera LSP MCP. Dzięki temu narzędzia serwera będą dostępne jako część możliwości agenta AI.

Tak, posiada licencję MIT i jest dostępny do integracji w Twoich projektach.

Tak, możesz skonfigurować wartości wrażliwe, takie jak klucze API, używając zmiennych środowiskowych w konfiguracji serwera MCP.

Zintegruj serwer LSP MCP z FlowHunt, aby umożliwić eksplorację kodu wspieraną przez AI, wykrywanie błędów i inteligentne uzupełnianie kodu bezpośrednio w swoich przepływach pracy.

Serwer CodeLogic MCP łączy FlowHunt i asystentów programowania AI ze szczegółowymi danymi o zależnościach oprogramowania CodeLogic, umożliwiając zaawansowaną an...

Serwer Model Context Protocol (MCP) łączy asystentów AI z zewnętrznymi źródłami danych, API i usługami, umożliwiając płynną integrację złożonych przepływów prac...

Serwer ModelContextProtocol (MCP) działa jako most między agentami AI a zewnętrznymi źródłami danych, API i usługami, umożliwiając użytkownikom FlowHunt budowan...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.